wiseが制作した2種類の作品、シーンリニアワークフローを取り入れたVR作品『THE WORLD'S END』と、インタラクティブコンテンツの『Horizon』。この2作品はリアルタイムVFXという新たなステージに向かうための足がかりとなる作品と言える。挑戦的な試みを続けているwiseの尾小山氏に詳しい話を聞いた。

※本記事は、月刊「CGWORLD + digital video」vol. 210(2016年2月号)からの転載記事になります。

■リアルタイムVFXが示すこれからの可能性

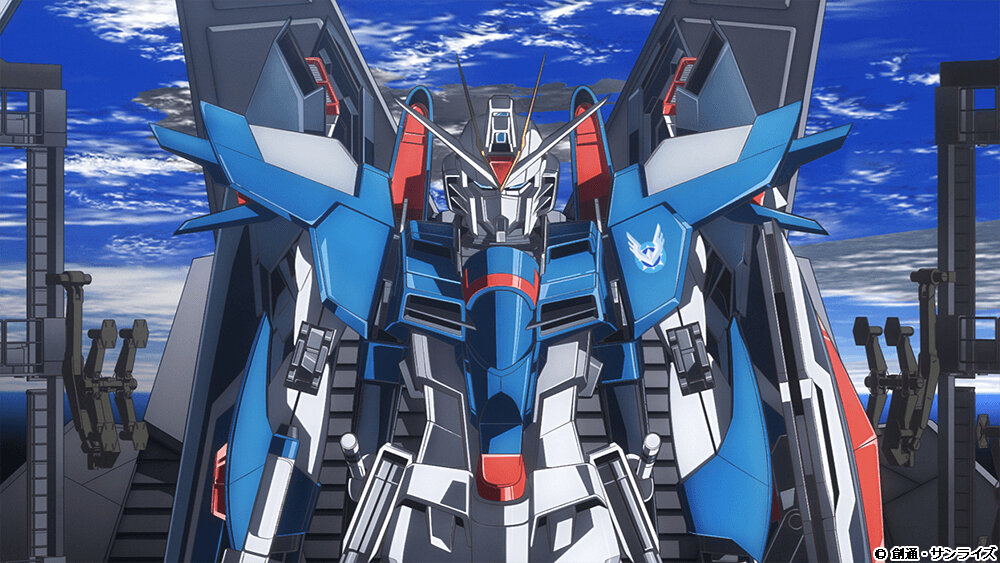

昨年11月の「CGWORLD 2015 クリエイティブカンファレンス」でも紹介されていた、wiseによるVRコンテンツ『THE WORLD'S END』とインタラクティブコンテンツ『Horizon』。これは簡単に言うとこれまでVFXで培ってきた技術、シーンリニアワークフローを取り入れたVRコンテンツと既存のゲームエンジンを用いたインタラクティブ作品なのだが、本作がCG業界に指し示すものは何なのか?今回はwiseの代表取締役、尾小山良哉氏に詳しく話を聞いた。

技術的な見どころも大いにある作品で、それに関しては後述するが、筆者としては「これは非常に大きな"コンテンツ"自体の未来を見据えてのトライアルである」という点がこれらの作品の重要なポイントだと感じている。というのも、『THE WORLD'S END』はVRコンテンツとしてヘッドマウントディスプレイ用に作成されたプリレンダーによる作品。そして、そのアセットを用いて作られた『Horizon』はボタン操作で視点を操作でき、"神獣"がインタラクティブに「振り向く」、「吠える」などの動作をするという作品だ。これは既存のゲームであれば当然できることで、それだけであればなんら新しさはない。ポイントとなるのは「背景は実写撮影された素材」ということと、物理ベースという技術によってライティングはHDRI、シェーダは物理シェーダ。そして、ここにVFXで培ったシーンリニアワークフローを導入したことによって「リアルタイムにVFX合成ができている」という点にある。もちろん課題はまだまだあるそうだが、現段階ではプリレンダーのVFX作品のレベルまであと一歩のところまできている。「リアルタイムVFXは可能である」という、ひとつの道筋が示された作品なのだ。

Unreal Engine 4によるリアルタイムVFX作品『Horizon』のデモ動画

現段階でVFXというのは映画やTV、その他の「映像作品」で使われているわけだが、今後はハードの進化に伴って、VRも含めた、「インタラクティブに動かすことができるVFX作品」が生み出されてくかもしれない。本作はその大きな足がかりになるだろう。VFXが「映像作品」という枠から飛び出して、新たなコンテンツを生み出していく可能性が見えてきた。

<1>背景の撮影とマッチムーブ

・VR作品向けに撮影を工夫

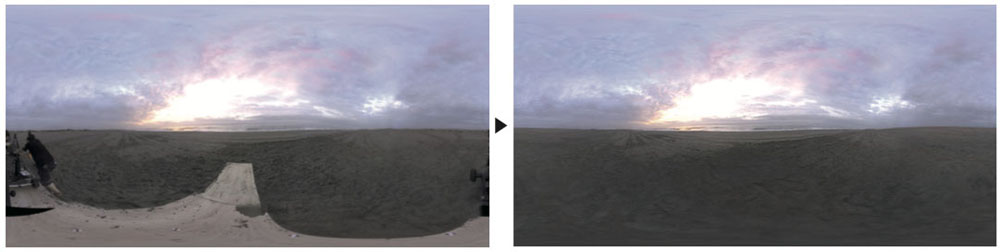

まずは素材となる背景の撮影からだが、今回の作品は撮影の段階でカメラワークが付いている。また、撮影自体は360度の天球として撮影しなければならない。具体的な機材としては、撮影リグとしてF360BroadCaster、特殊撮影機材のウルトラクレーン、カメラはGoPro HERO 4を使用して撮影されている。「バックグラウンドが遠方の風景で、パララックス(視差)による問題が起きないので、解像度を重視した複数型の素材のカメラリグを使いました」と尾小山氏。また、「マッチムーブをかけなければいけないのですが、カメラワークを付けるのにウルトラクレーンという撮影機材を使いました。というのも、なるべく遠いところで撮りたいんですね。どうしても撮影機材やその影が入り込んでしまうので、それを消さなければならない。実際の収録で言うと、カメラからリグや撮影機材の距離が遠ければ遠いほどいいわけです」と、当時の試行錯誤を語る。

通常の撮影とあまり変わらないように思えるかもしれないが、VRとして見られるようにカメラワークが付いている部分も360度で撮影されているところがポイントだ。カメラリグなど機材に関して「まだまだこういう撮影はローエンドからミドルエンドのものしかないけど、今後はハイエンドな撮影機材も増えていくと思います」と尾小山氏。リグに関しては用途に合わせたものがこれからどんどん出てくるのではないかと考えているという。現状、撮影機材は日々進歩しているが、それでもローエンドとハイエンドの開きは大きい。VFXを撮影するような、RAWデータを撮影する構造で業界が動いていないところが悩みだそうだ。「ただ、プロ仕様のVRカメラはもう1~2年で出るでしょうから、時間の問題だとは思います。スティッチに関してはハードマターの部分が非常に大きいので、今後はもっとやりやすくなると思っています」と、これからの展望も話してくれた。

・撮影ソリューション

F360 Broadcasterは天球撮影を可能にするリグで、装着したカメラはGoPro HERO 4。撮影時のコーデックはmp4で、カラースペースは sRGBだ。これを16bit EXR、カラースペースはACESに変換して、その後の作業が進められている。ウルトラクレーンは、小型のクレーンではあるが、カメラアングルを自在に決めることができる優れものだ。ウルトラクレーンを採用した理由としては「消し込み作業を軽減するために、なるべく遠方から撮りたかった」とのこと。「将来的にこういったニーズが増えれば、それに応えた新たな特殊撮影機材もどんどん生まれてくるのではないかと思います」(尾小山氏)

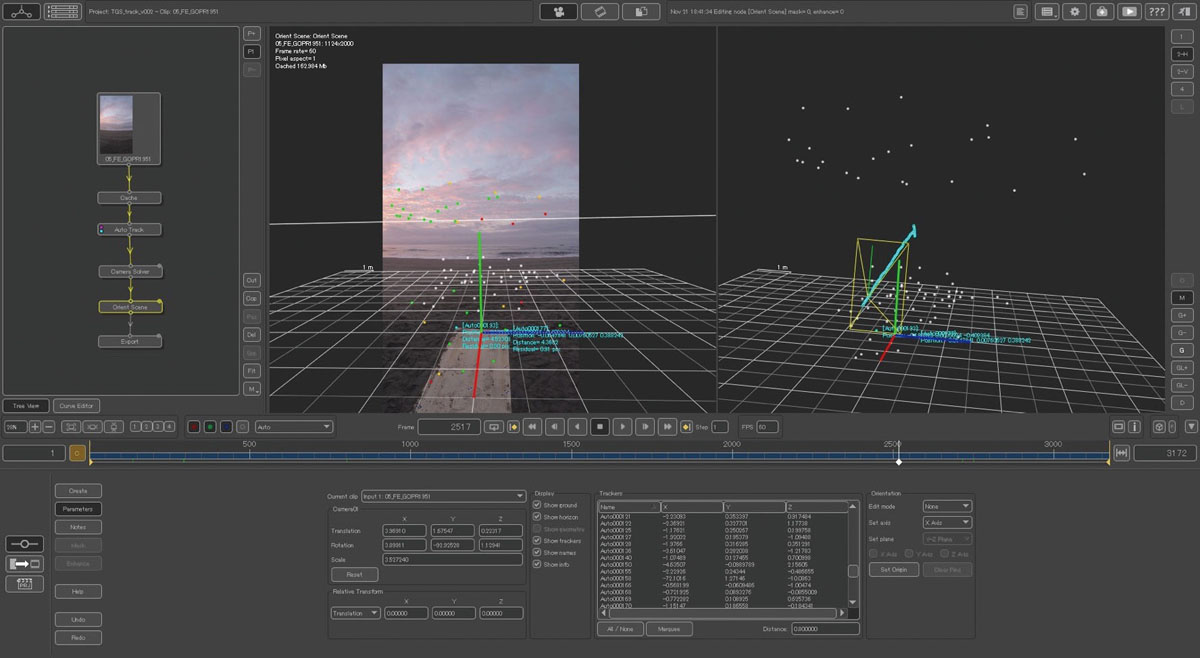

・撮影とマッチムーブ

マッチムーブに関しては今回の場合、ヒーローカメラ(メインとなるカメラ)をマッチムーブして、そのマッチムーブデータを基にNUKE上で消し込み作業を行い、最後に天球上にスティッチされている。結合させた後にマッチムーブすることもできなくはないそうだが、やや手間がかかるとのこと。

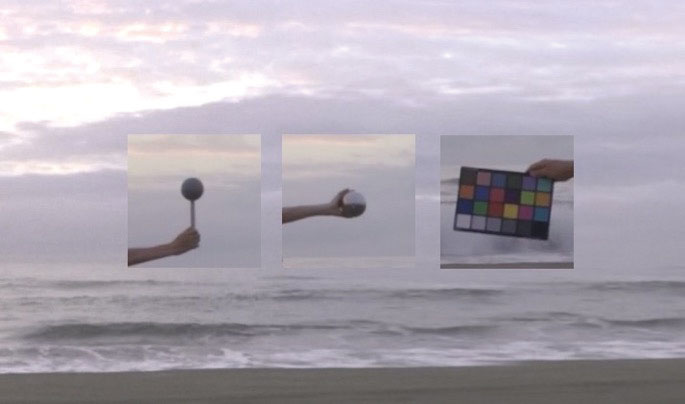

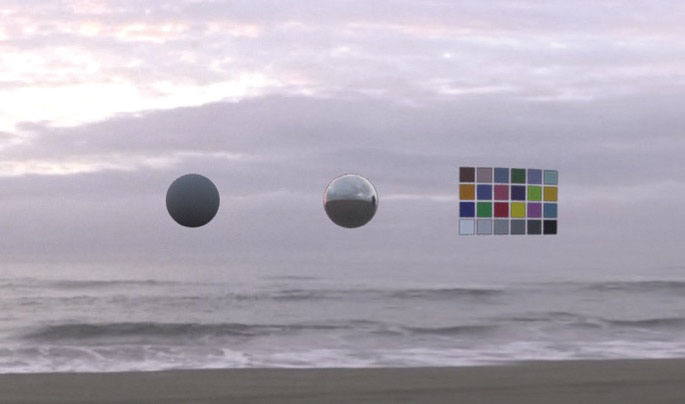

・HDRを用いたライティング

通常のVFX撮影と同様にHDR、カラーチャート、銀玉、グレーボールなどを撮影。シーンリニアのための要素を準備してある。HDRの色調整は従来のシーンリニアワークフローと同様だが、ここが上手くいかないと環境を再現することができないので重要なポイントだ。

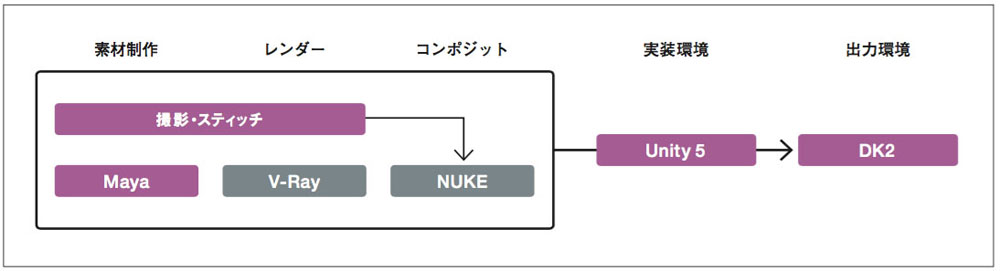

・撮影から出力までのパイプライン

VRコンテンツ『THE WORLD'S END』のパイプラインを簡単な図で表したもの。Maya+V-Ray+NUKEを用いたシーンリニアワークフローであるが、ここで作られたムービー素材を最終 的にUnityでオーサリングし、VRコンテンツとして完成させている。物理ベース環境で制作されており、このプリレンダーのアセットを同様に「物理ベースなリアルタイムコンテンツ」内に置き換えて作成すれば、リアルタイであっても同様の結果が得られるはずである。

▶次ページ:

<2>物理ベースアセットの作成とシーンリニアワークフロー

■<2>物理ベースアセットの作成とシーンリニアワークフロー

物理ベースシェーダをSubstance Designerで用意

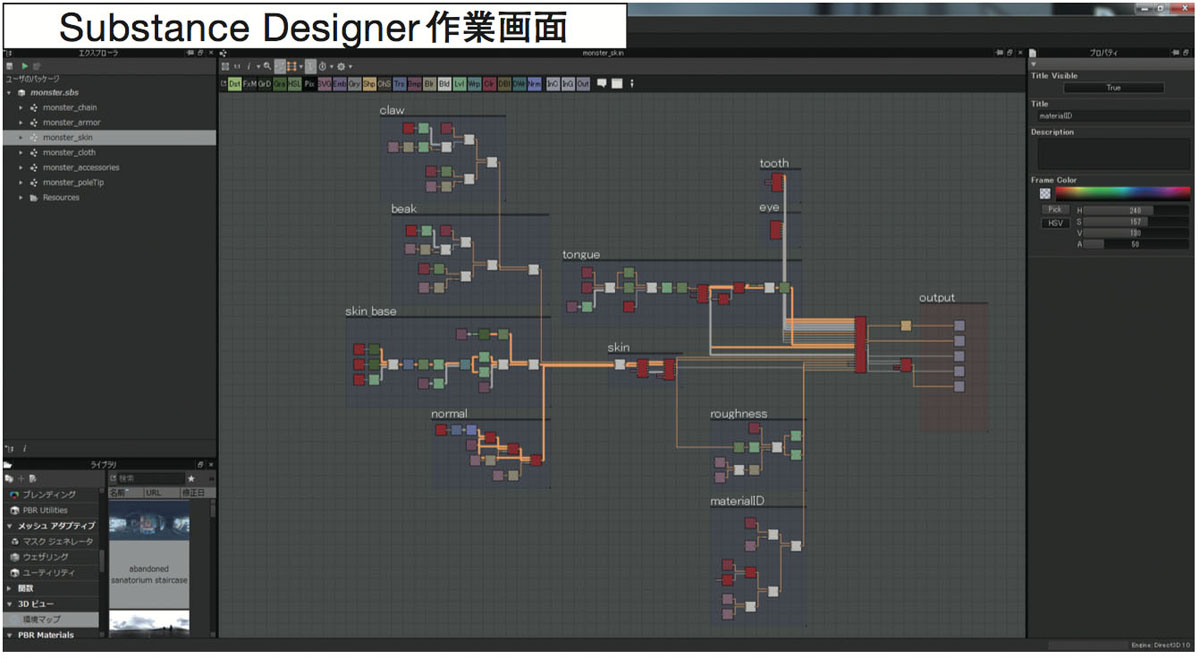

シーンリニアワークフローに関しては本誌を含め、様々なメディアで説明されているのでここでは詳しい解説は省略するが、ごく簡単に言うと「リニア環境下で作成したものを同じカラースペース内で、同じガンマ曲線を使って出力すること」となる。ここでポイントとなるのはシェーダだ。物理ベースレンダラはプリレンダーではすでにかなり普及しているのだが、ゲームエンジンではどうなのか?ここ数年リアルタイム環境下でも物理ベースシェーダは使われるようになっており、実装されているケースは多い。

今回の場合はSubstance Designerから出力したシェーダを使い、シェーダが共有されている。「基本的には物理ベースのアセットでないと正しいライティング反応をしませんよね。アルベドカラーチャートでは色、光の色をはがして、フラットライティングを入れます。その後にプロシージャルベースのものだったら理論値の、物理ベースの設定を入れたものを使ってアセットを構築します。そうすると複数のソフトを使っても、物理ベースのレンダリング上であればどれも同じルックになるはずです」と尾小山氏。今回は尾小山氏とwiseが取り組んできた検証の様子も交えながら紹介しよう。

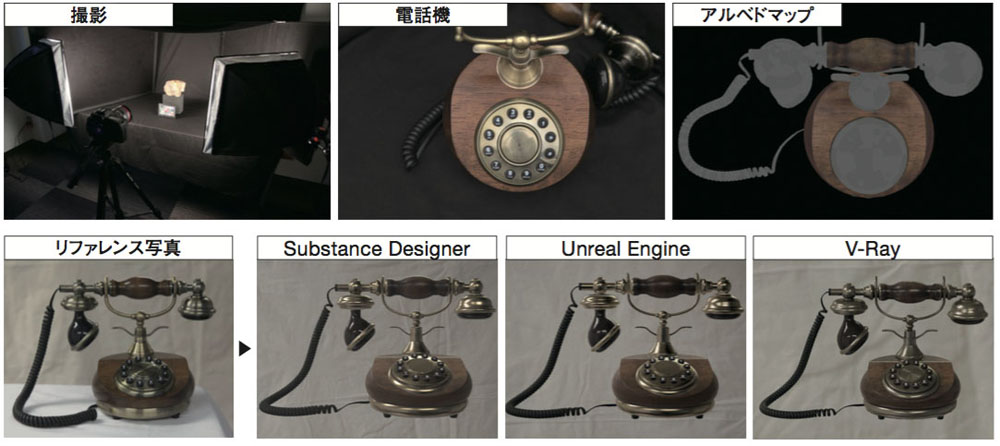

・物理ベースのアセット作成

実制作の前にwiseにて行われたテストの様子。実際に存在する電話機を写真撮影してリファレンスとし、それを今回のワークフロー上でSubstance Designer、V-Ray、Unreal Engineの3つを使って再現を試みている。「僕らが言う物理ベースというのは、光を変えたときにその光に対して正しく反応しているように見える、というのが必要十分条件です」と尾小山氏。結果としてこの4枚の画を見たとき、ほぼ同じ結果が生まれており、どのようなレンダラであっても「物理ベースであれば同様の結果が得られる」という答えが出ている。前述のようにSubstance Designerがハブとして機能しているところがポイントだ。

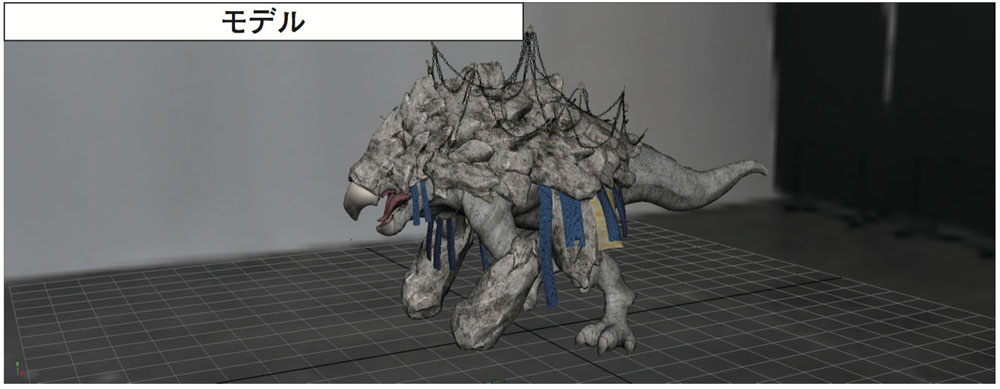

・神獣の作成

神獣はプリレンダー用とリアルタイム用のモデルはほぼ同じものを使っている。ただ、リグは直接もち込むことができないため、ボーンにアニメーションをベイクして読み込んでいる。このあたりはゲームと同様の使い方だ。このほかリアルタイム用とプリレンダーでの大きなちがいとして「シミュレーション系のデータはもっていけない」とのこと。というのもゲームエンジン自体が基本的に「シミュレーションはリアルタイムで」という前提があるためで、必要があればそれ専用に組み直さなければならない。今回の場合、神獣の背中にあるチェーンの動きは Unreal Engine内でコリジョンさせているが、布の動きはバーテックスにアニメーションをベイクした状態でUnreal Engineにもち込んでいる。

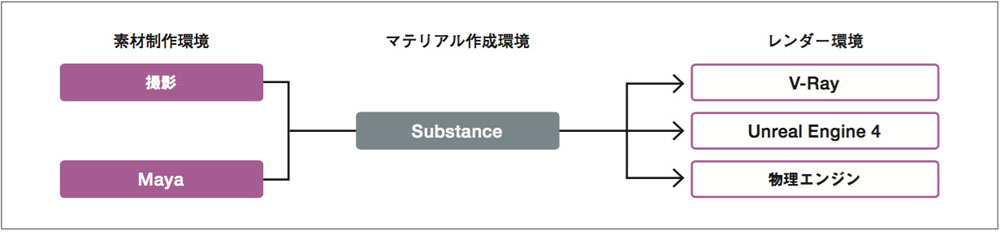

・アセット制作のパイプライン

このパイプラインが今回の作戦のキモとなっている。Substance Designerをハブとして、そこからV-Ray、Unreal Engine、その他の物理ベースのレンダラ(それがリアルタイムであれ、プリレンダーであれ)にデータが受け渡される。「複数環境の中で成立するということが重要なんです。物理ベースであれば、他のレンダラでも同じ結果になるはず。光のシミュレーションは同様のアルゴリズムで行なっているから、プリレンダーは同様の結果が得られると想定される。そのためハイブリッド化もできるんです」(尾小山氏)

▶次ページ:

<3>Unreal Engine 4 によるリアルタイム合成

■<3>Unreal Engine 4 によるリアルタイム合成

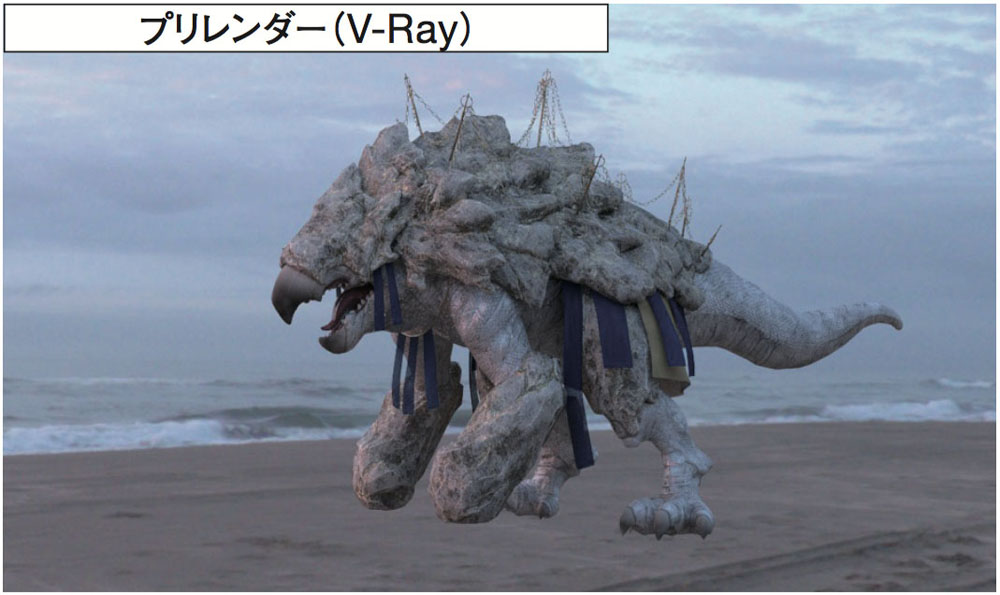

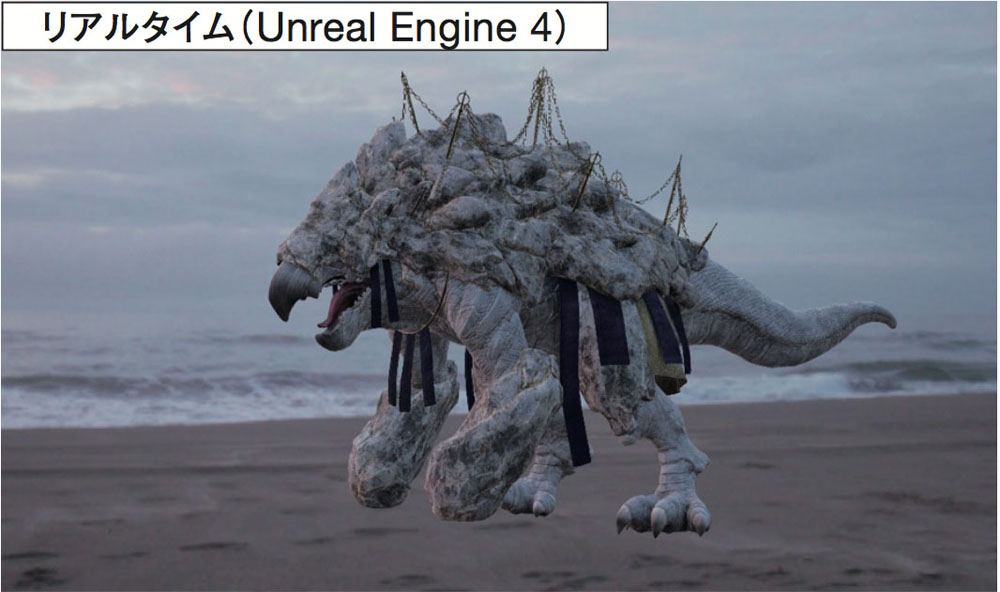

リアルタイムで実写と3DCGを馴染ませる

最終的な結果として、V-RayとUnreal Engineでほとんど同様の結果が得られている。もちろんここまで来るには様々な苦労や工夫があったのだろうが、かなり高い精度で色のマッチングが行われている。「物理ベースで各工程を統一することで、見た目ベースで合わせるのではなく、定量的に合成というものを捉えて『全て理論値で合うはずだ』というものをつくったんです。そうすることでリアルタイムに全てが馴染むという結論が出ました」と尾小山氏。ここまで来てしまえば、後はこれをブラッシュアップしていけば、今後より現実感のあるものをリアルタイムに作成することができるようになる。すなわち、リアルタイムVFXの手法が確立していくはずだ。なんといっても今回のワークフローは、既存のVFXのワークフローをそのままリアルタイムに置き換えることが可能なため、今まで培ってきたノウハウも活かせ、またインタラクティブなものをつくることが可能なので、表現の幅もかなり広がる。きわめて大きな可能性を秘めているのだ。

・UE4によるインタラクティブ化

プリレンダーであるV-Rayで作成された『THE WORLD'S END』とUnreal Engineでインタラクティブ化された作品『Horizon』とを比べると、ほぼ同じ結果が得られているのがわかる。課題としてこういったゲームエンジンは「映像素材や写真素材の扱いが苦手な部分がある」とのこと。これまでリアルタイムに動かす上で、こうした部分のニーズがあまりなかったためだろうが、今後の動向によっては変わってくる可能性もある。「インタラクティブに動かすことができる=データの効率化がキモ」という図式は当分変わらないだろうが、こちらも昨今の技術進化をみていると、筆者としてはニーズさえあれば解決は時間の問題のような気がしている。

<mini column>

リアルタイムVFXの未来とは?今回の取材では尾小山氏に様々な話を聞いたが、最後にこのリアルタイムVFXが今後どのように発展していくかについても話してもらった。「僕はこれが必ず表現の未来につながると思っています。VFXがリアルタイムで行えるということは、今までのVFXのワークフローをそのままリアルタイム化することができて、よりリアルな"体験"というものをコンテンツとして生み出すことが可能になるということです」と語る尾小山氏。現時点でのVRなどのコンテンツはひと昔前に比べれば格段に進歩してはいるが、まだまだリアルとは遠いものが多い。しかし、「物理ベース」という技術が3DCG全体に普及した結果、さらにリアルに、しかもシーンリニアワークフローが組み込まれることによって、より合成感の少ないものに仕上げることが可能というのが、今回のこの試みで確認できたわけだ。

ひとつ付け加えるとリアルタイムにVFX合成ができるというのは、決して「映像制作の効率化」を求めたものではなく、まったく新しい"体験"を提供するコンテンツを生み出す可能性がある技術だということだ。例えば、視聴者自身が映画の主人公を操作して、その操作によって状況が変化していく「疑似体験」を得られるコンテンツを生み出すことも可能になる。現時点ではシンプルなシーンで実験されているが、「これをどういった演出手法でコンテンツ化していくか」というR&Dはこれから始まる。「ヴァーチャルな体験をパッキングすることがVRの最終的なかたちであって、コンテンツを見た後にそれを体験した気持ちになるかどうかというのがすごく重要です。体験を上げるためによりインパクトのあるカットとして没入できるシーンがあるはずなんだと。その表現手法を今、模索しています」。

これは今後ハードウェアが進化し、パススルーカメラ(見たものを一度カメラで捉えて、実際見ているものに処理、合成をするハードウェア・ヘッドマウントディスプレイ)でリアルタイムに3DCGが合成できるようになったとき(いわゆるARがVFXレベルでできる!)、さらに大きな進化が起きるにちがいない。「昨今の技術進化のスピードを考えると、それはもうすぐそこまで来ている」とのことで、これからの発展が非常に興味深い。

TEXT_草皆健太郎 / Kentaro Kusakai(Z-FLAG)

EDIT_海老原朱里 / Akari Ebihara(CGWORLD)

-

-

VR+シーンリニアワークフロー発想で実現されるリアルタイムVFX

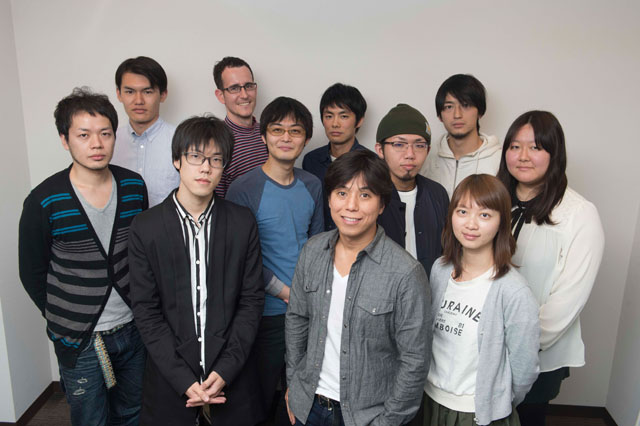

【Stuff】

前列右より、CGアーティスト:許 秋子氏、ディレクター:尾小山良哉氏、ディレクター・CGアーティスト:山田詩音氏、中列右より、テクニカルアーティスト:宮澤 舞氏、CGアーティスト:天川貴弘氏、プログラマー:神田健斗氏、スーパーバイザー:松尾 隆氏、後列右より、プロデューサー:廣羽裕紀氏、アシスタントプロデューサー:太田悠介氏、テクニカルアーティスト:ロビナ・ロケロ・トマース氏、コンポジター:安 優輔氏(以上、wise)

www.wiseinc-net.com