<2>Google「Tango」はモバイル体験を次世代へ進化させるか!?

2つ目の大きなくくりであるAR/VR活用リアルタイムは数が非常に多く、7チームがエントリーしていたが、まだまだVR/ARが立ち上がる時期ということもあってか、コンテンツそのものは、PlasticのPlayStation VR(以下、PSVR)対応ゲーム『Bound』と、同じくMotionalの『Gary the Gull』の2作品にとどまっていた。GoogleによるAndroidモバイルデバイス向けのAR技術「Tango」、ILM'のARプログラミングフレームワーク「Zeno application framework」、Oculusの「VR Drawing」の3チームは、技術デモの域を超えたアプリケーションが開発されていることもあって、応用の可能性が視覚的にわかりやすいものであったが、Meta CompanyによるARヘッドセットデバイス「Meta 2」と、NVIDIAのゲーム開発フレームワークGameworksの一部を構成する、弾性を持つ固形物のシミュレーション「Real-Time Simulation of Solids with Large Viscoplastic Deformation」の2つのプレゼンテーションは、デモアプリケーションを通じてのものではあったものの、開発環境上のデモということもあって、地味さは否めない。これらは、どちらかというとコンテンツのベースにあるテクノロジが主役であるため、このようなストイックなものになったのだろう。

PS4版ではなく、PSVRの開発機を用いて行われたPlasticによる「Bound」のデモ。プレイヤーが操作するキャラクター、プロシージャルなゲーム空間とデストラクションが幻想的だ。会場のモニタスクリーンにミラー出力された画面からは、PSVRだからといってプレイヤーの視点がゲームキャラクターの一人称視点になるわけではなく、プレイステーション4版と同一の視点で操作するように感じられた。プレイヤーのコントローラーからの入力、ゲームカメラの位置制御、PSVRのヘッドトラッキングによるカメラの回転の関係がどういったフィールに繋がるか、実際に体験してみないとちょっと想像がつかないため、今後プレイする機会が楽しみだ

上記の「Bound」以上にゲームと呼んで良いものか戸惑うのが、Motionalの「Gary the Gull」だ。ムービーとゲームの融合コンテンツに登場するカモメのGaryは、要するに日本でいうところのゆるキャラということになるのだろう。この手のキャラクターが受け入れられるかは、背景となるカルチャーにも依存する部分が大きく、コンテンツ自体の成功は未知数だ。VRやボイスに反応するといったテクノロジ云々の問題ではなく、キャラクター性に依存するコンテンツの成否は本当に分からない

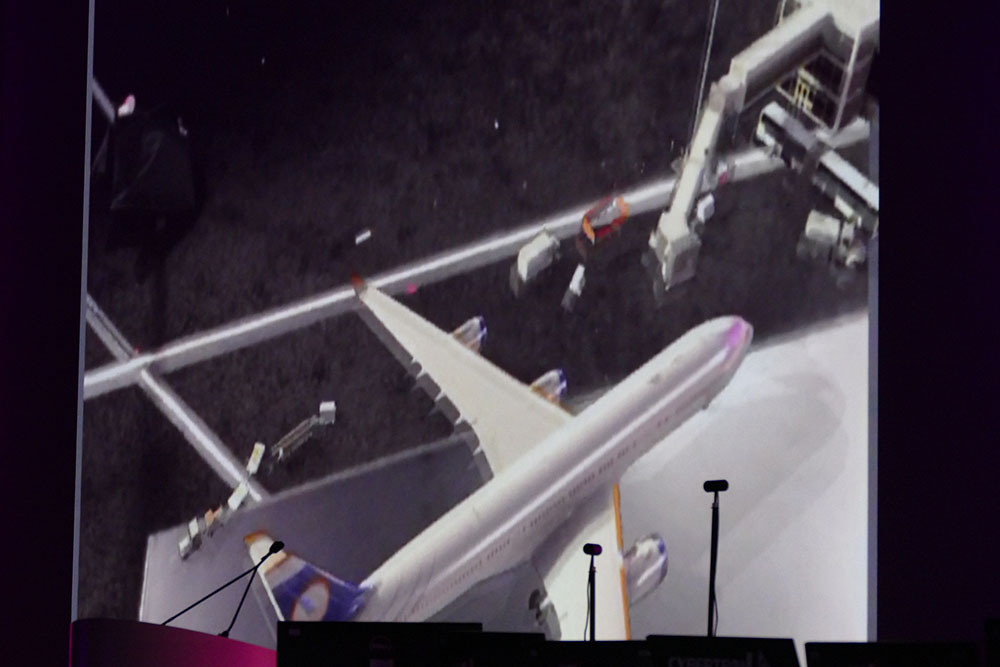

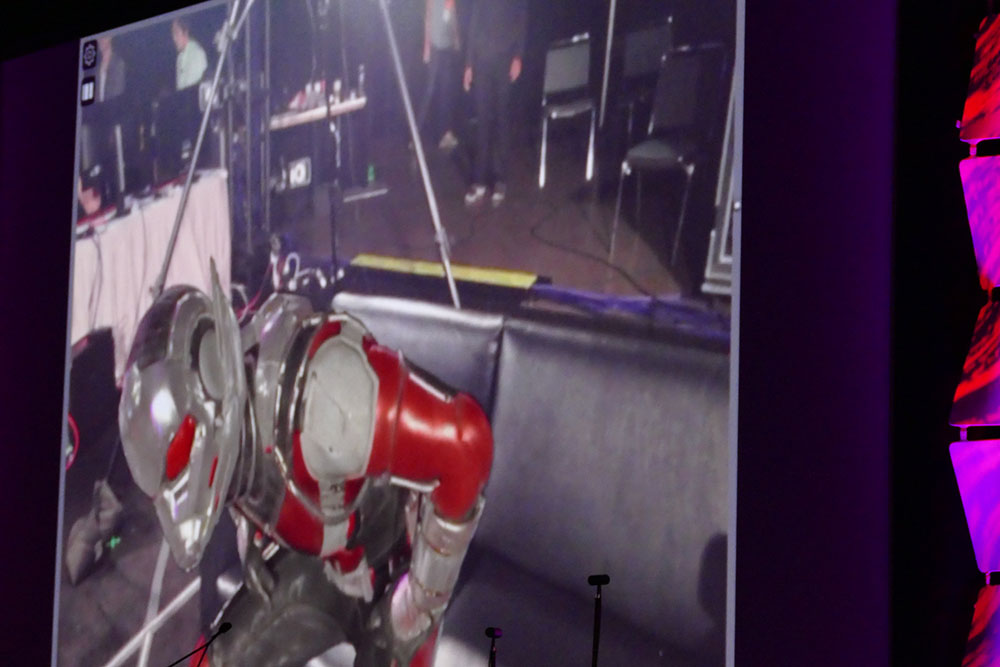

ILM'の「Zeno application framework」を活用したiPadアプリは、iPadに取り付けた位置ドラッキングデバイスで取得した情報に基づいてAR体験を実現している。デモは日常の空間にちょっとした不思議を織り交ぜるといった趣向で、テーブルの上に出現させた飛行機が飛び立ったり、ソファに座して現れたヒーローが飛翔して、突き破った天井から顔を覗かせるといったエンターテイメント性の高いものを準備していた

Oculusの「VR Drawing」は、本年下半期にリリースが予定されているOculus Touchを使って、VR空間内の平面にドローイングを行う製作環境だ。ドローイングを行うのは2D平面といっても、VR空間自体はもちろん3Dであるため、キャンバスを三次元的に移動させることもできるようになっていた。Oculus Story Studioの最新映像作品「Dear Angelica」の製作に活用されているというが、VR空間で上映する映像コンテンツをVR環境で作成したほうが直感的で良いものができるというメリットと、空間把握や新しいデバイスの操作に慣れるまでの生産性低下というデメリットのどちらが勝るのかは微妙なところではないかと感じる。また2Dでドローイングをする人の中には、3D空間での作業をどうしても越えられない壁として感じる人も出てきそうだ

Illustrative filmmaking with Oculus Story Studio

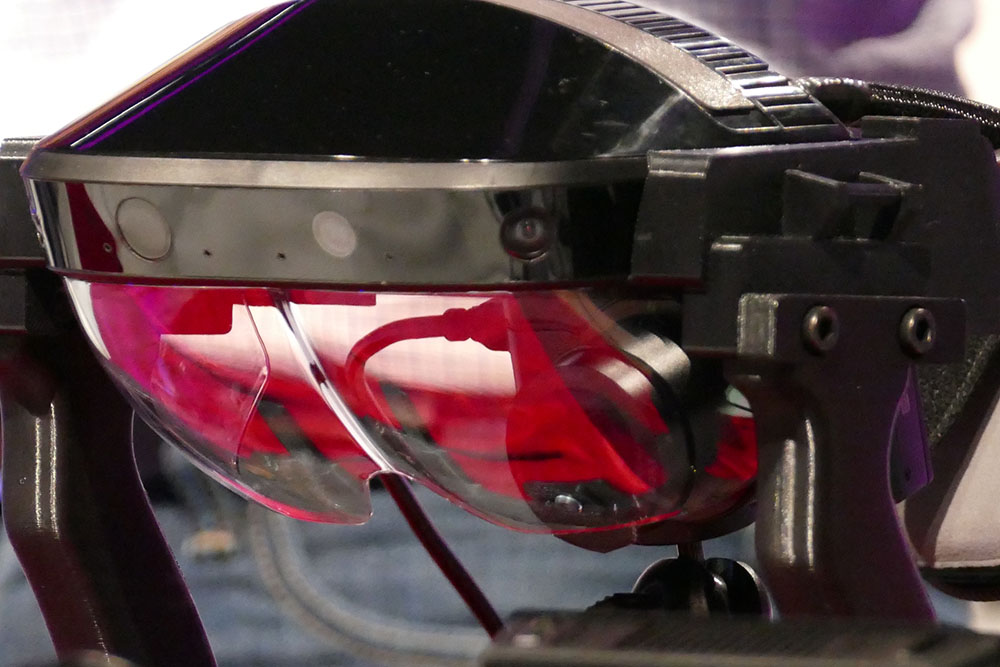

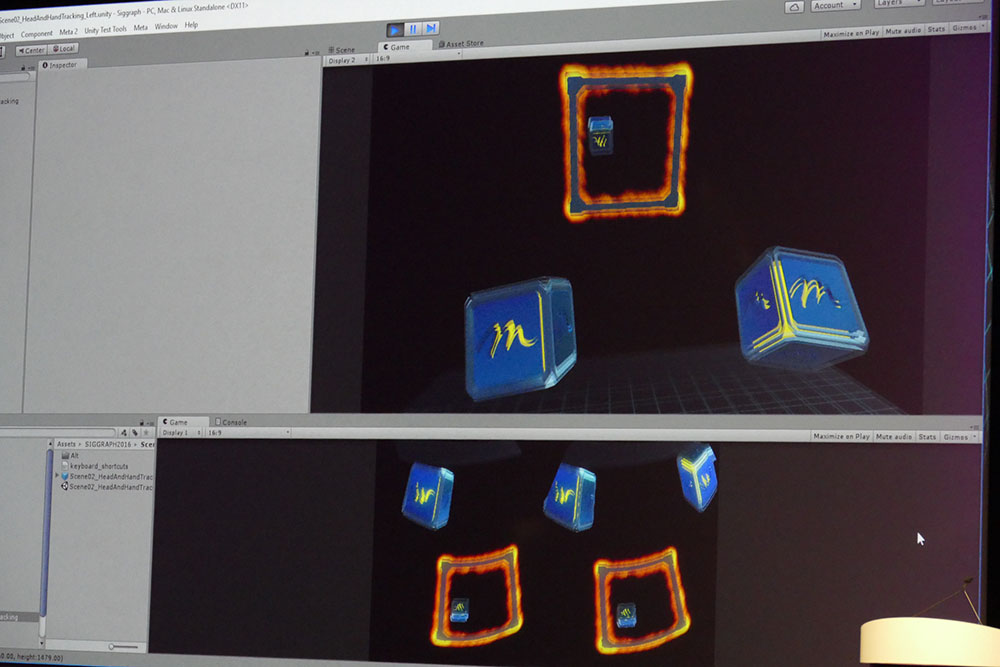

Meta CompanyのARヘッドセット「Meta 2」は、その価格が$949と、10万円を切る価格でプレオーダーが受け付けられている。廉価で現実的に手に取れる範囲のARデバイスとして、その期待感から注目を集めているが、今回のプレゼンテーションでは、「Unity」開発環境に表示させたキューブをハンドジェスチャーで動かすというビジュアル的に地味なデモであったため、会場の反応は今ひとつのように感じられた。「Meta 2」の公式サイトでは、近未来的な利用シーンが散りばめられた映像が公開されているが、実態としては、アプリケーションレベルや現実的なユースケースが追いついていない印象だ。ARを開発環境に活用する際にも、既存の入力デバイスとは異なったハンドジェスチャーにふさわしい新しい発想のメタファーが必要になるだろう

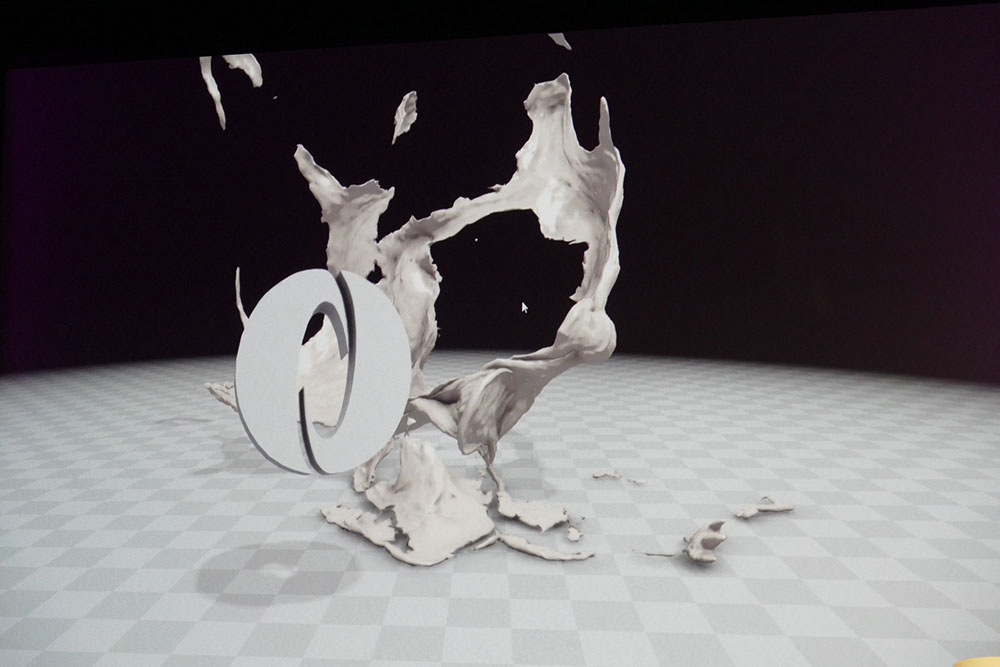

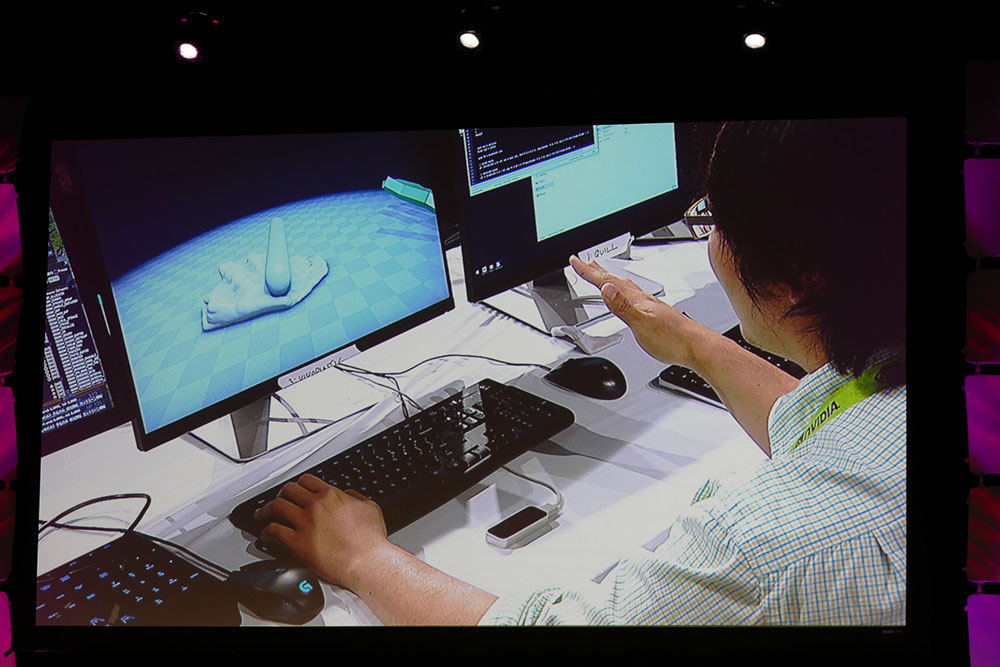

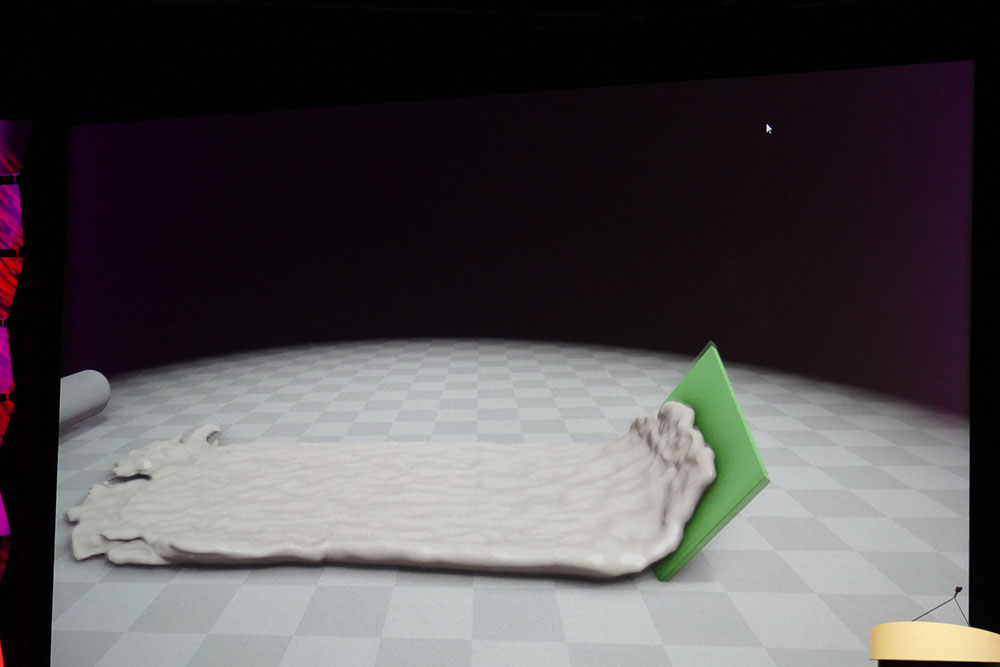

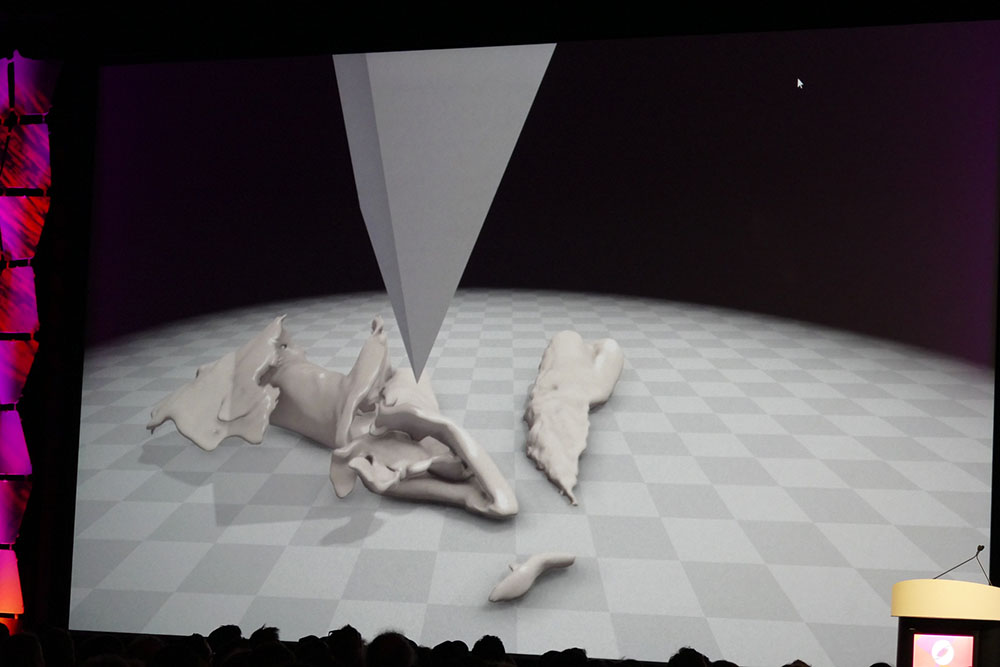

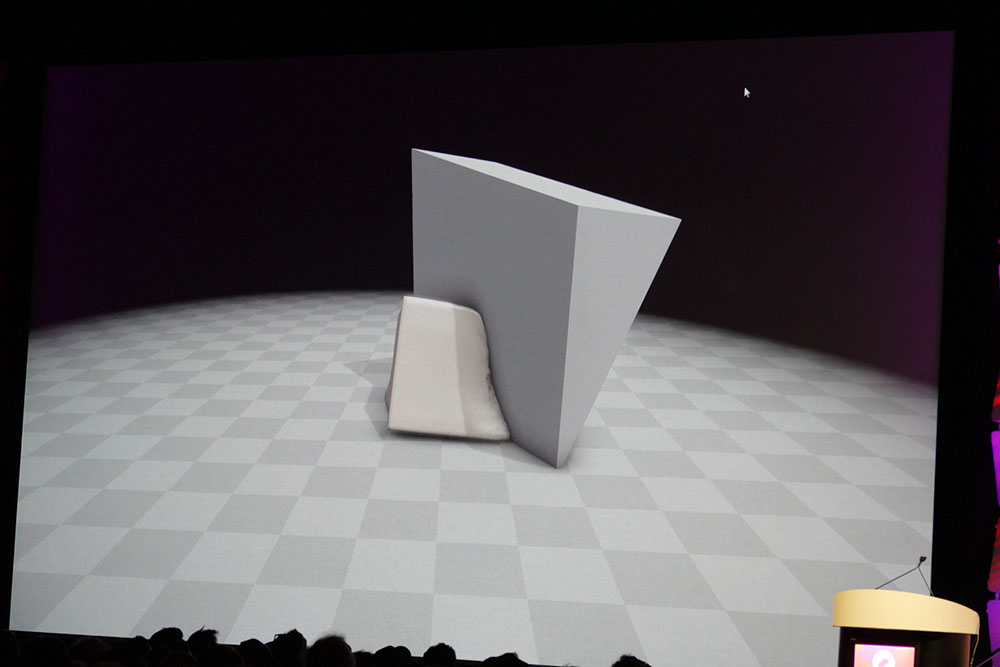

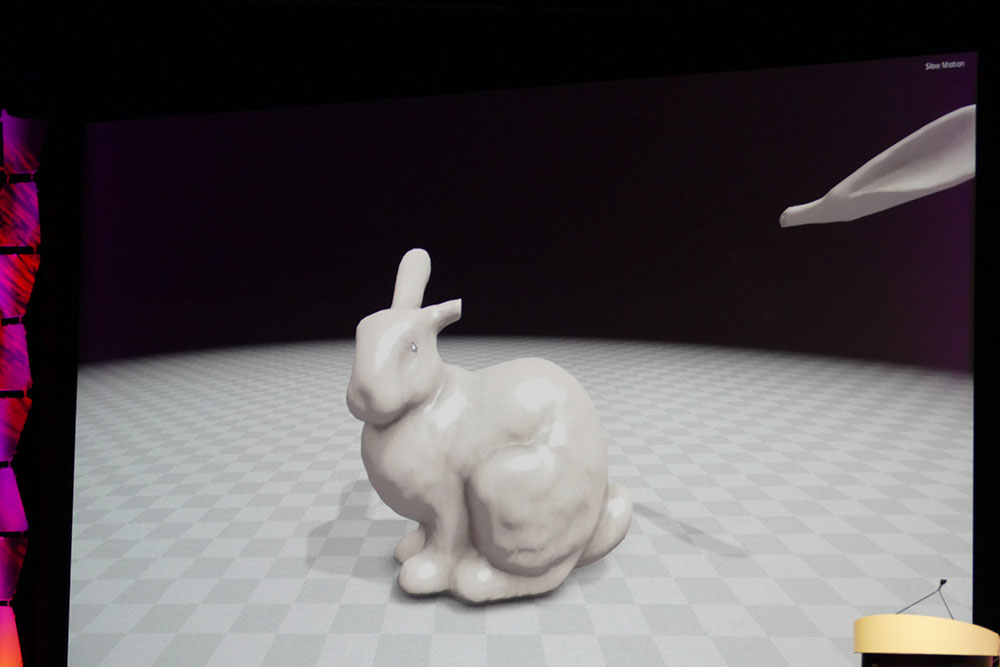

NVIDIAの弾性固体の形状変化シミュレーションそのものは、非常に価値のあるものだと言っていい。ただ、本イベントでのデモで行なったような、ハンドトラッキングによる入力で、オブジェクトを切断したり、変形や破裂させるといったAR的な操作は逆効果であったように思う。直感的なハンドジェスチャーによる入力で小気味よく軽快に操作されていれば、見ていて気にも留めないのだろうが、実際には何ともモッサリとした印象で、悪い意味で注目を集めてしまったように思う。結果的に優れたリアルタイム形状変化シミュレーションよりも、イマイチなAR操作の方に目が向いてしまった感がある

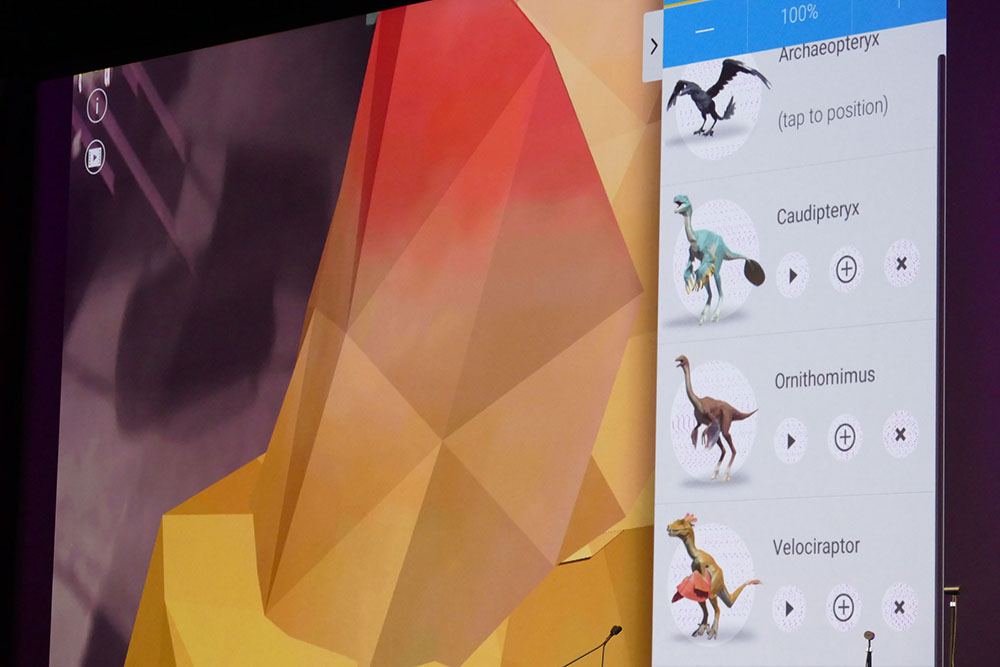

そんな中で、この分野で最も目を惹いたのは、GoogleによるARフレームワーク「Tango」だ。すでにAndroid端末を販売するベンダーからは対応デバイスがリリースされており、アメリカ自然史博物館とコラボレートした『Dinosaurs Among Us』というAR教育アプリが動作している。アプリそのものは、教育向けということで、カメラで撮影し続けている現実空間に3DCGの恐竜をリアルタイム合成して、その恐竜に親しみを持って学んでもらおうという意図で製作されている。本イベントでのプレゼンテーションでも、タブレットの画面を通して、実際にはその場にいない恐竜があたかもその場所にいるかのような、ちょっとした仕草のアニメーションを繰り返すさまが見てとれた。

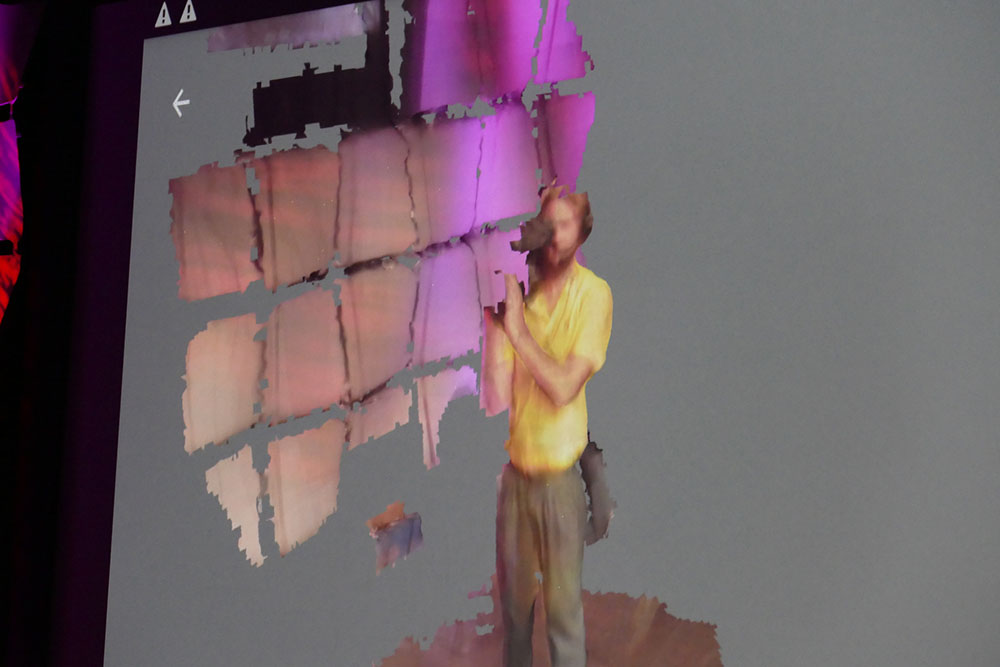

ただ、プレゼンテーションの最後にデモが行われたように、Google「Tango」のAR技術のキモは、ハードウェア的に搭載された深度センサーと、取得したデータからリアルタイムに高速にボクセル化して、センサーで取り込んだ現実空間をそのままレンダリングしてしまえる部分だ。残念ながら、レンダリングは、速度的にも品質的にも少々物足りないものだったが、処理を行なっているのがモバイルデバイスであったことを考えると、将来に期待が持てるテクノロジと言えるだろう。「Dinosaurs Among Us」のARアプリだけを見ていると、ふーん、で終わってしまいかねないが、重要なのはこちらの方だ。

ARアプリ『Dinosaurs Among Us』は、確かに博物館や科学館などの、楽しく学ぶちょっとした非日常のエンターテイメントにはちょうど良いのかも知れない。後日、エキシビジョンブースを訪ね、プレゼンテーションを行なったZack Moratto氏に質問してみたところ、現状のアプリの実装では、恐竜が歩き回ったりといった大きなアクションはなく、恐竜自体も実際の恐竜のスケールを反映させたものではないとのことだった。一方で、深度センサーで周囲の環境をスキャンして、即座に3D空間をレンダリングするデモについては、ボクセル密度のパラメータを上げて、高品質なレンダリング結果を得ることはできるとのことだった。試しにその場でやってもらったところ高負荷のためタブレットがフリーズしてしまった

Dinosaurs Among Us Google Tango demo at Google IO16

この動画は本年5月の「Google I/O 2016」時のものである