<2>リアルタイムをプリレンダーで補完する

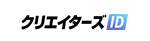

システム構成図

「動く人間の身体にリアルタイムに3Dマッピングを行うためには、演者の動きに合わせて映像が変化する必要があります。演者が横に動いたら、投影内容も横に動かなくてはいけません。このプロジェクターは演者の身体につけた光学マーカーを検出し、自動的に演者を2Dトラッキングします。これに加えて演者の身体に取り付けられた回転センサーを使うことで、体の傾きを考慮した立体的な表現を可能としています。これらのトラッキング技術は独自のプラグインによって実装されており、Unityでこれらのデータを使用できるようになっています」(吉田氏)。

こうしてリアルタイムに演者の動きを追従しライブ感を演出しているわけだが、全てをUnity上でリアルタイムに処理させるのは難しく、プリレンダー映像も使用しているという。

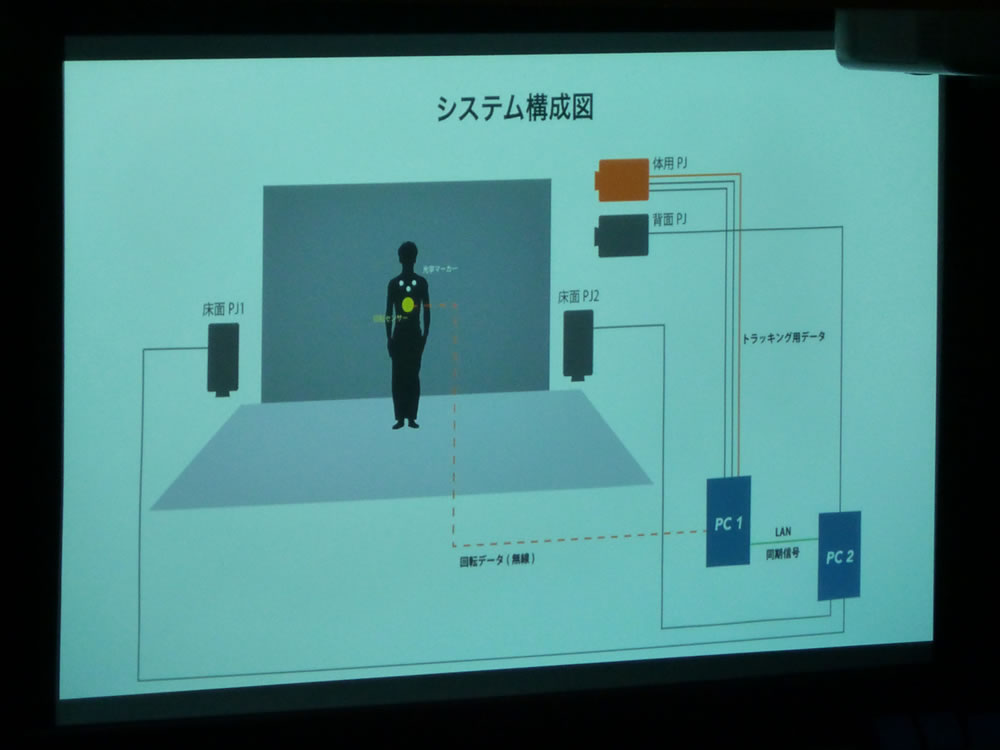

前ページで紹介した映像を見るとわかるように、『EXISDANCE』では最初に空手、次にロボット、最後にキューブというようにモチーフが次々と変わっていくのだが、この最初の空手パートにもプリレンダー映像が使われている。「空手のパートでは、体と背景に別々のプリレンダー映像を投影しています。エンコードはHAPを使っています。よくVJでも使われるんですが、デコードが速い点が特長です。再生には外部アセットとしてAV Proを使っています」(吉田氏)。

空手パートにおけるプリレンダー映像の演出

また吉田氏は、実際に演者の身体に投影する前に、演者を3DスキャンしてつくったCGモデルに映像をマッピングしてみることも重要と話した。「『EXISDANCE』では演者のCGモデルにUV展開して、そのUVに合うように映像を配置しました。このテスト工程があるのとないのとではクオリティの差が歴然でしたね」(坂本氏)。

「ちなみに演者の回転情報は先ほど述べたようにセンサーで取得しているのですが、これはモーションキャプチャデータではありません。演者の姿勢がどのようになるのかを推測するシステムをつくり、回転情報を元に演者の姿勢を推定して、ジオメトリをデフォームさせています」(吉田氏)。

ロボットパートに登場するロボットスーツの映像はCINEMA 4Dで作成

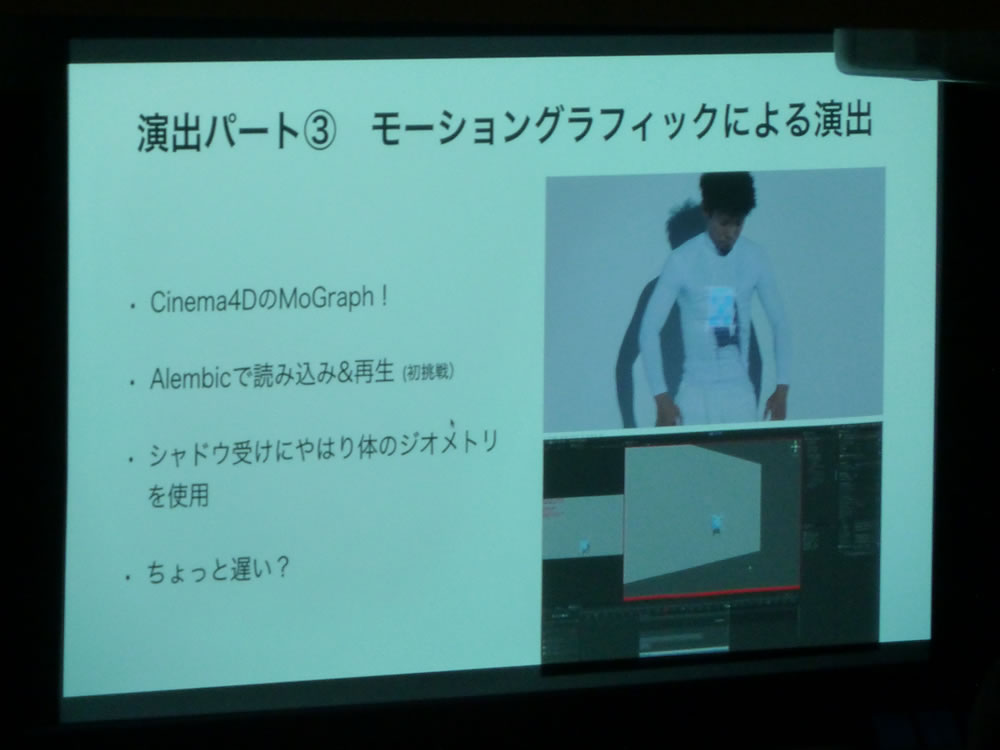

キューブパートでは、モーショングラフィックによる演出も

最先端の技術により演者と映像を融合させ、SF映画やアニメーションの世界が現実に飛び出してきたかのような演出を実現した『EXISDANCE』。今後もさらに進化を遂げ、私達に新しい驚きを与えてくれそうだ。

-

-

「CGWORLD 2017 クリエイティブカンファレンス」

参加費:無料 ※事前登録制

開催日:2017年11月5日(日)

場所:文京学院大学 本郷キャンパス(東京都文京区向丘1-19-1)

主催:ボーンデジタル、文京学院大学 コンテンツ多言語知財化センター

機材協力:マウスコンピューター、TSUKUMO(ツクモ)

cgworld.jp/special/cgwcc2017