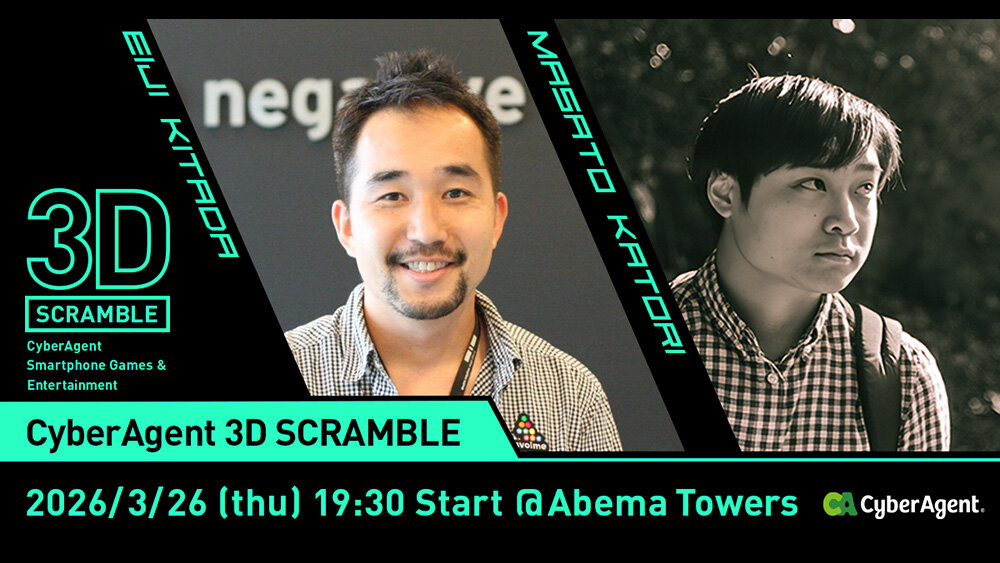

フォトグラメトリとゲームエンジンで変わる映像制作

それでは、この映像はどのようにつくられたのだろうか。メイキング動画を基に、具体的な制作工程についてふり返っていこう。

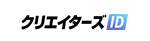

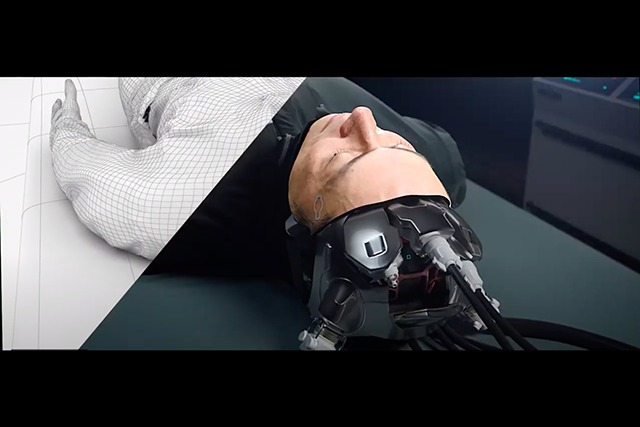

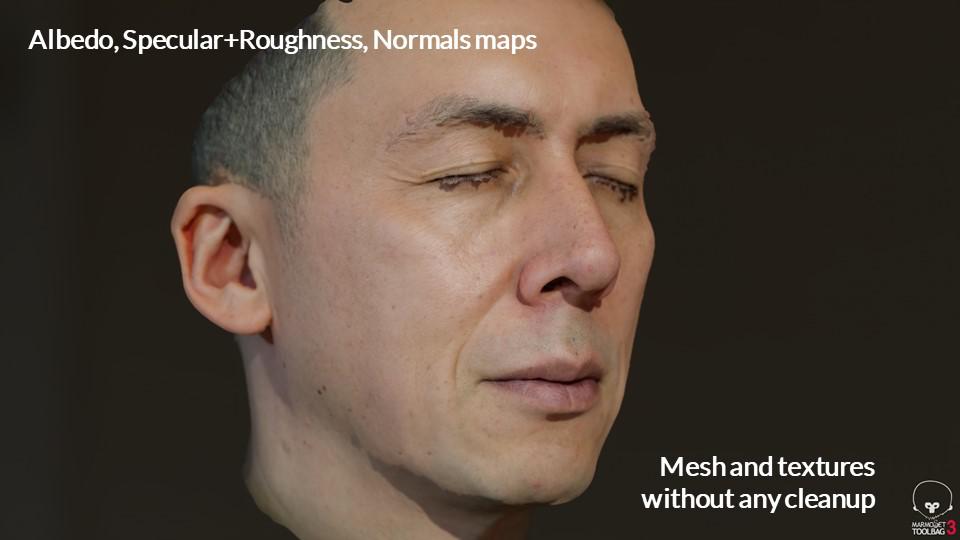

映像のキモはローランド氏そっくりの「2号」が「CG」で登場することだ。もっとも制作期間の都合上、CG部分は頭部や表情など、一部に限定されている。こちらは撮影に先行して、「THE AVATAR TRUCK」と同等のシステムで撮影。データのクリーンアップが行われた。

ラボで横たわったり、スタジオでモデルを撮影したりしている「2号」の頭部や顔のデータも、このスキャンデータを基に制作されたものだ。実際に演技しているローランド氏を実写で撮影し、頭部や表情だけがマッチムーブで合成されているのだ。

余談だが、このとき本人と似た体型のモデルを使用すれば、一度本人の頭部データをスキャンするだけで、タレントなどを映像内に「出演」させられることは、言うまでもない。もっとも制作時間の関係上、今回は胴体もローランド氏のものになっている。

【5】完成した顔の3DCGデータを実写撮影された人体とマッチムーブして合成

ローランド氏は「国内では随一、世界的に見ても3本の指に入るシステムができた。しかも、このシステムをどこにでも『出張』させられるメリットが大きい」と胸を張る。

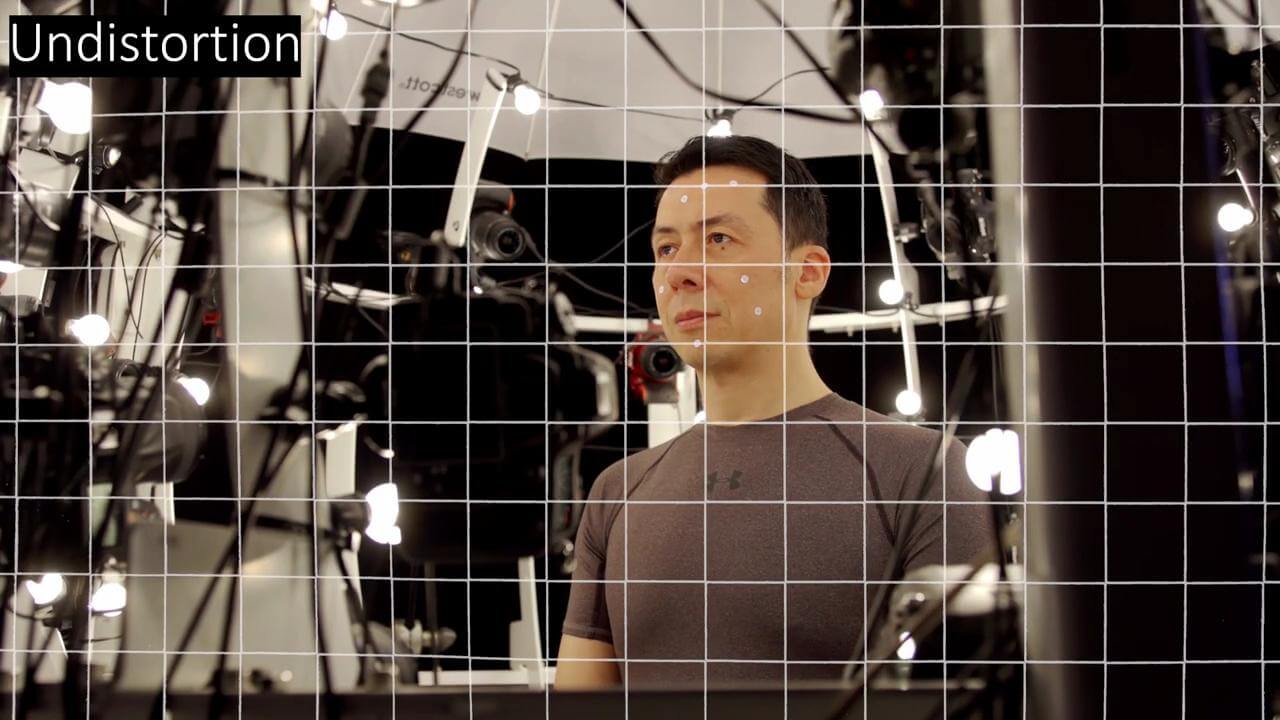

ポイントはライトシステムが刷新され、デジタルカメラで連写しながらPL(偏光)フィルタの有無を切り替えられるようになったことだ。これにより両者の差分からスペキュラマップとラフネスマップを自動生成できる。これにより一気に作業時間が短縮できたという。

もっとも課題も残っている。髪の毛の表現、レンダリング、そしてフェイシャルアニメーションだ。

ショートカットなら容易な髪の毛も、ロングヘアだと手作業に負う部分が増加し、格段に日数がかかる。レンダリング時間の短縮では、同社の主力レンダラであるArnoldのアップデートが鍵を握っている。フェイシャルアニメーションについても、表情とまとめてスキャンできるシステムを研究開発中だという。

「それでも以前に比べれば、ずいぶん時間が短縮できるようになりました。我々の目標はCMの話が来てから、90日以内で完成データをクライアントに納品すること。これまでは半年後納品でも難しかったのですが、今ではかなり現実的になっています」(ローランド氏)。

THE AVATAR TRUCKで撮影されたノーマルマップ・スペキュラマップ・ディフューズマップ

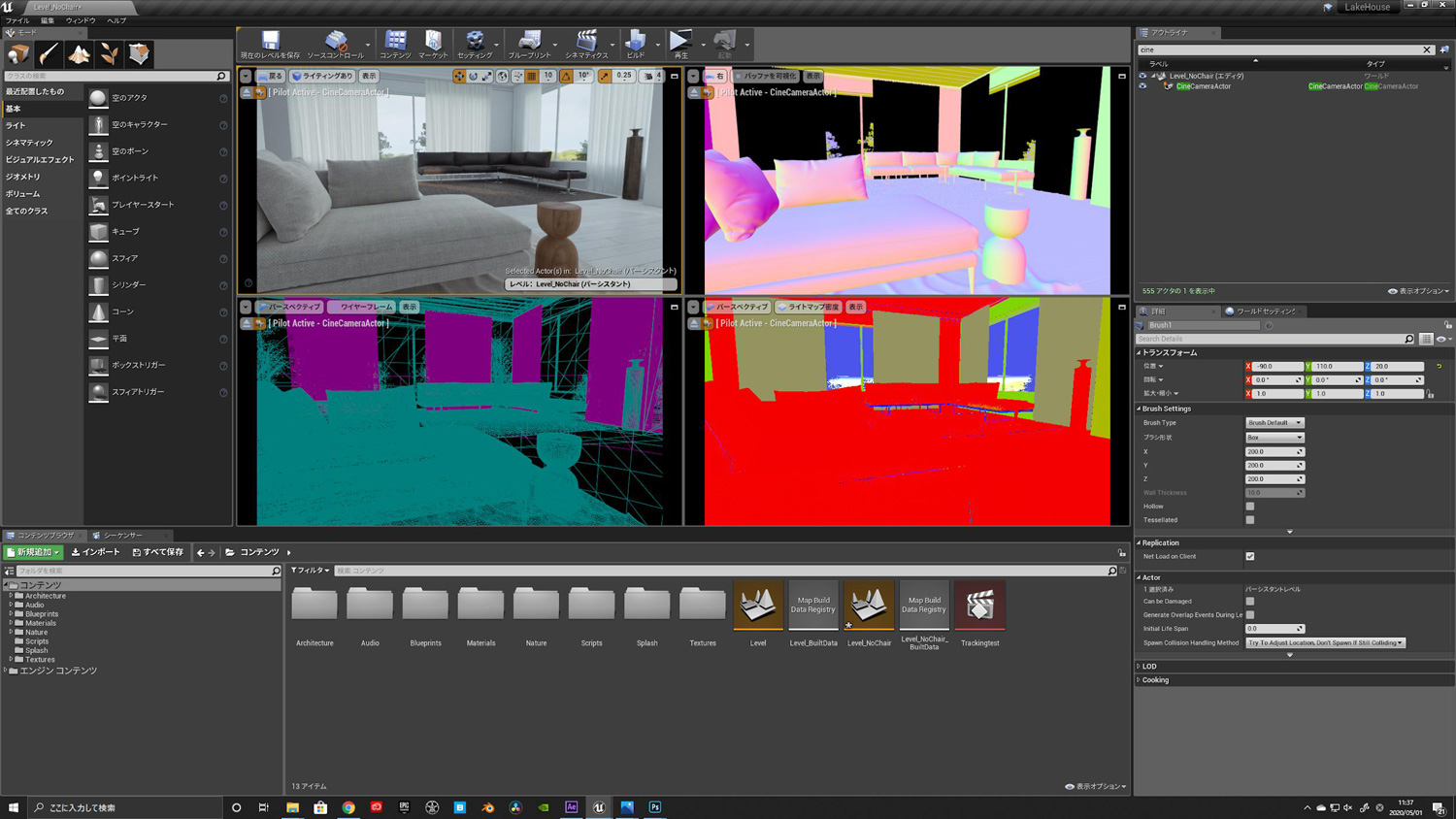

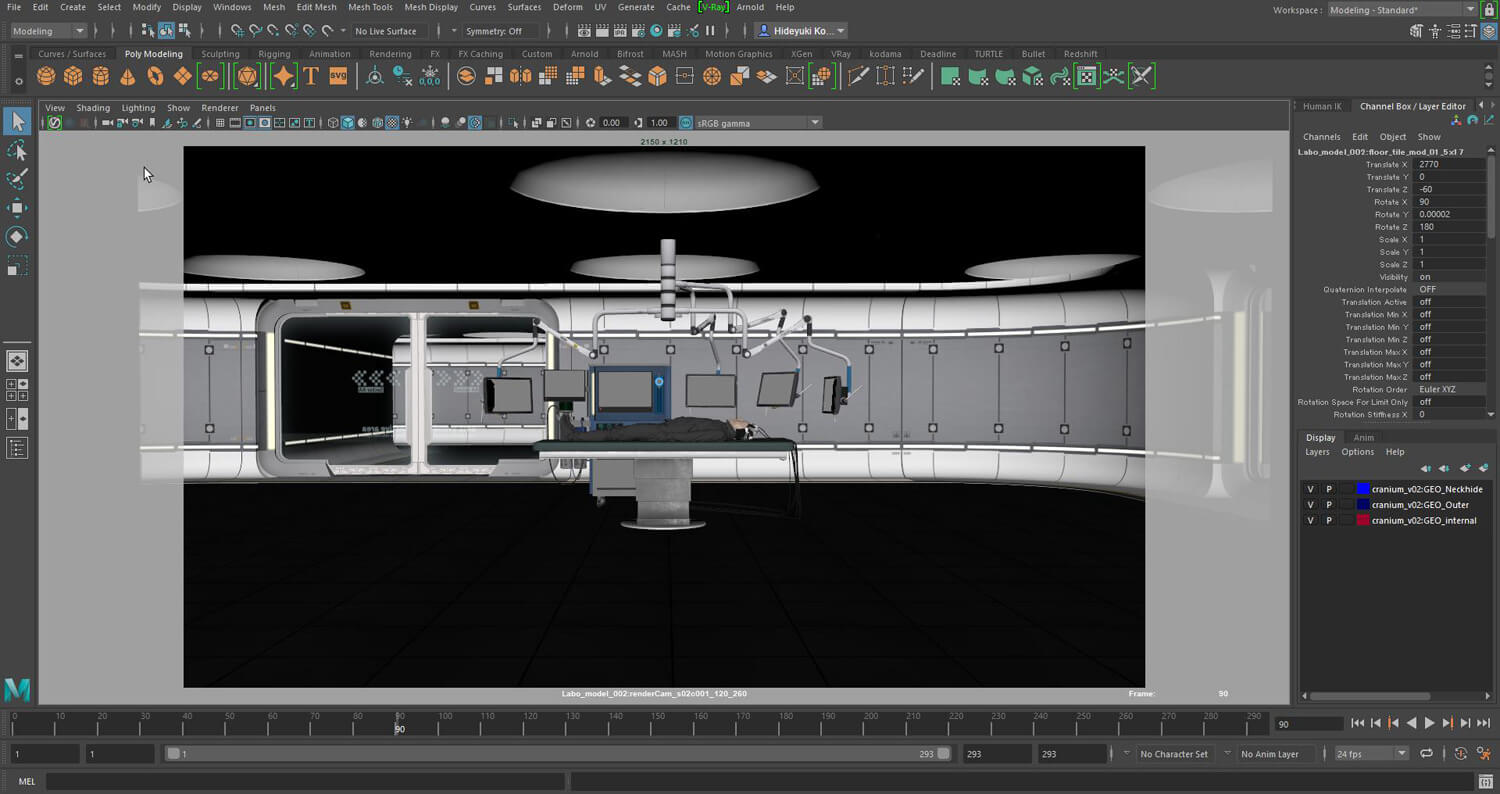

もうひとつのポイントは、主要な背景が全てCGで制作され、ゲームエンジン上で実写の撮影素材とリアルタイムで合成されている点だ。ラボとプライベートルーム風の背景がそれで、それぞれゲームエンジンのUnreal Engine(UE4)向けのアセットをカスタマイズしたものを、事前に用意して使用している。リアルタイムキャプチャにはZero DensityのReality Engine、カメラトラッキングにはRedSpyを使用。これにより合成の様子をリアルタイムに確認しながら撮影ができる。

「がっちりと事前に準備しておくのではなくて、ここから、こうやって撮ろうとか。その都度現場で思いついたアイデアをリアルタイムで確認しながら撮れたのが、クオリティが上がった要因のひとつかなと思います」(児玉氏)。

「従来のグリーンバックだと、どういう空間内で演じているのか、出演者からもわかりにくいと言われていたんですよ。それがモニタ上でリアルタイムに確認できるので、今こんな風に自分が映っているんだとわかるようになりました。これから、すごく役に立つんじゃないかな」(桐島氏)。

このようにして撮影された映像素材をNUKEに書き出し、ポストエフェクトなどが行われた。ラボのシーンではUE4からMayaにデータを書き出し、細かい修正も追加されている。こうして作成された映像素材に、サウンドやコピー(テロップ)などを追加して、最終映像が完成した。

【5】完成した顔の3DCGデータを実写撮影された人体とマッチムーブして合成

撮影を担当したムービーモンスターの跡地淳太朗氏は「前職では撮影パートと合成パートが完全に分かれていて、自分が撮影した素材がどんなふうに合成されるのか、実際に見ることはありませんでした。しかし、今回のワークフローではその場で合成された画が見られるようになり、仕事の幅が広がりました」と語る。

またロケ地、天候、スケジュールなど、現実世界に紐付く制約がなくなるため、プロダクションのスケジュール感覚が大きく変わるとも感じたという。「マジックアワーなどの再現が難しい時間帯や、ゲームやアニメのように現実では不可能な世界でも、現場でテストしながら撮影できます」。これらはゲームエンジンを中核に据えたワークフローならではだろう。

-

-

跡地淳太朗/Juntaro Atochi

ムービーモンスター

撮影

www.movie-monster.jp

もっともローランド氏は、地味ながら大きな役割を果たした要素に、照明があったと指摘する。CGのバーチャルセットと同じ光源や色空間で出演者をライティングしなければ、画に違和感が発生するからだ。そのため今回の撮影でも、プロの照明技師が参加してクオリティを引き上げている。

「CGではなく、実写のスチル写真やムービーを背景に活用することもできます」(ローランド氏)。同社には世界中の風景をHDR情報つきで撮影した、膨大なストックがある。これを活用しながらゲームエンジン上で背景とモデルを合成し、撮影できるというわけだ。コロナ禍で海外ロケが困難な中、このメリットは大きい。

また、現在のワークフローも完全ではない。跡地氏は「リアルタイムの合成はかなり癖があるので。はじめは万能だと思っていたんですが、相性というか、特性も見えてきました。逆にそのことで、これが得意なんだとか、ここを掘っていくといいとか、撮影部から提案ができるなと思いました」と指摘する。

田森氏もReality Engineによるキャプチャについて、「リアルタイムなぶん、こういうアングルになると苦手だねとか、レンズボケが入ると、うまくヌケにくいだとか、若干の制約があります。もっとも、だから格好良い画が撮れないかというと、そういうわけでもない。むしろ、現場でリアルタイムに判断できる点が大きいですね」とコメントした。

このように本ワークフローには様々な可能性があり、今後も研究開発を進めていくという。また同社では、今回の撮影ワークフローをベースに、次世代CG制作ソリューション「バーチャルプロダクション」パッケージの提供も、4月28日(火)から開始している。コロナ禍のおり、「合成された画像を観ながら、リアルタイムで人物、背景とのバランス(カメラワークの詳細)などをリモートでディレクションできる」メリットも挙げられた。

ラボのワイヤーフレーム【上】、完成映像とバーチャルスタジオ【中】、ワイヤーフレームと完成映像【下】

今回のプロジェクトが映像制作の未来にもたらす可能性

このようにクライアントワークではなく、「April Dream」企画としてつくられたことで、研究開発プロジェクトとしての性格ももつことになった本案件。それをアシストしたのが、サイバーエージェントグループの横の繋がりだ。田森氏は「このシステムをノリで使えるのが大きい」と指摘する。

芦田氏も「エイプリルフールでもハロウィーンでも良いんですが、みんなが自由に挑戦できる機会を活かして、こうしたプロジェクトができれば、それが次のクライアントワークでも活かせると思います」とコメントした。

実際、世界の映像制作はフォトグラメトリとバーチャル撮影を活用する方向に急速にシフトしている。映画『スター・ウォーズ』シリーズの外伝として、ルーカスフィルムが制作するインターネットテレビシリーズ『マンダロリアン』は、その最右翼だ。

『マンダロリアン』ではスタジオの壁面を巨大なスクリーンに活用し、UE4で表示したCGアセットを背景とした撮影が行われている。ライティングもリアルタイムに調節されるなど、究極のバーチャル撮影だ。ローランド氏は「いずれCHPでも、ああいった撮影システムを構築したい」と抱負を語る。

もっとも、こうした機材はツールに過ぎない。そのために必要なことは、企画・撮影・CG制作のチームが密接に連携して制作を進める体制を整えることだ。これは従来のウォーターフォール型で確立した映像製作のワークフローを根底から揺さぶることになる。近年、ソフトウェア開発で用いられるようになった、アジャイル型のしくみを採り入れていく必要もあるだろう。

芦田氏はこうした体制を整えやすいのが、サイバーエージェントグループの強みだとも指摘する。

「ハリウッドでは撮影プロダクションとCGプロダクションが密接に連携していますよね。それができると、照明パートなども連携できるようになる。我々もグループ会社をどんどん作っているので、予算感や規模感は格段に違うとしても、アビリティとしてはハリウッドに近しいことができると思います。特にリアルタイム合成はそうした成果が出やすい部分ですので、今後も挑戦を進めていきたいですね」。

CyberHuman Productionsでは、今回のような企画や、新しい表現に一緒に挑戦できる3DCGアーティストを探しているという。興味のある方はぜひ公式サイトをチェックしてみてほしい。