いまさら聞けない、バーチャルプロダクションの基本・求められるスキル

続いて登壇したのはsync.devの岡田太一氏だ。バーチャルイベント系の案件でテクニカルディレクターとして関わることが多いという岡田氏は、近年急速に聞かれるようになった「バーチャルプロダクション」の概念整理とそこで用いられる機材、そして期待される人物像について話した。

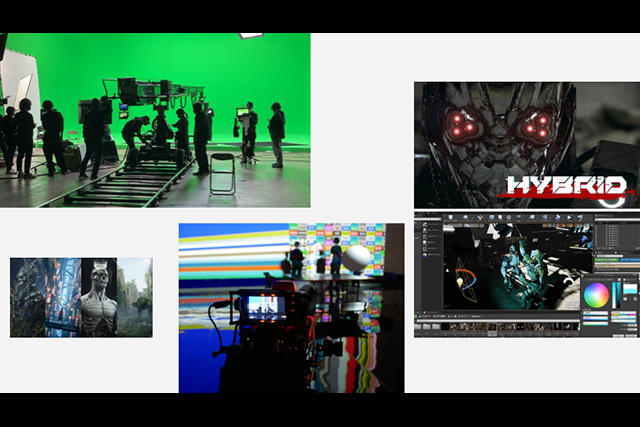

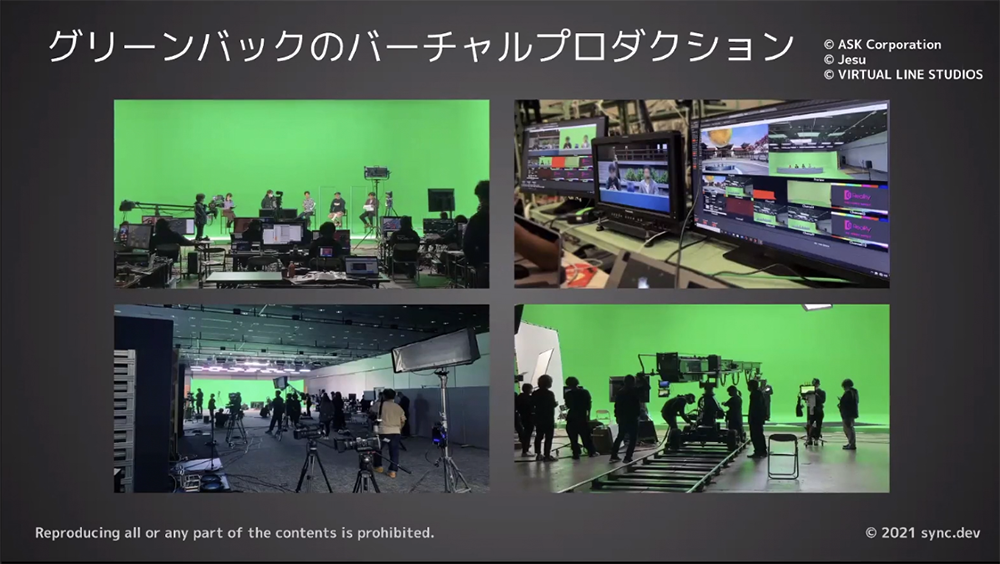

はじめに岡田氏は、本講演におけるバーチャルプロダクションについて「プロダクション工程の現場にポストプロダクションの要素を取り込み、完成系に近い品質のアウトプットを確認しながら作業を行うためのしくみ」と定義した。その上でバーチャルプロダクションの種類を「グリーンバック」、「LED WALL」、「VR(フルCG)」に分類。これらはそれぞれ異なる概念であり、メリットとデメリットが存在するという。

グリーンバックのメリットは「技術的に成熟していること」だ。既存のCG合成の知見を活かすことができ、生放送やLIVE配信にも耐え得る安定性がある。これまで難しかった反射や屈折表現もこなせるようになってきた。撮影後にCGをつくり直して再合成することもできる。撮影対象の足下までCG化できるのも本手法ならではだ。その一方で「準備が大変」「合成結果からグリーンバック感を消すのが大変」などの欠点があるのも否めない。その他、照明がグリーンバック優先になるため演出的な照明ワークがしにくい問題もある。モニターを通さずに見たとき、現場で何が起きているか、わかりにくい点もデメリットだ。

これに対してLED WALLの特性は、「合成の工程が不要で撮影するだけで最終アウトプットになる」、「現場で何が起きているか、その場にいる全員が瞬時に理解することができる」、「LED WALL自体が照明代わりになるため、演出的な照明の自由度が高い」など、グリーンバックとネガポジの関係だ。岡田氏は「ときには天井までLED WALLを貼ることもあります」と話す。その場合はトップライトの役割も果たすことになる。

他にレンズディストーション(レンズの歪み)について考慮しなくて済む点も強みだという。カメラで撮影する以上、映像には必ずディストーションが発生する。グリーンバックでは別途用意したCG映像と合成する際、ディストーションを解消するための後処理が必要になる。LED WALLではこの手間が不要になる点が大きい。

もっとも、デメリットも少なくない。今、まさに世界中で研究開発が進んでいる分野で、技術が確立していない点が第一に挙げられる。PCのマシンパワーを要求しがち、LED WALLごとの境界を消すために信号同期をとるのが大変、人物など撮影側の要素をCG内に映り込ませるのが難しい、などの問題もある。足元は美術で作り込む必要がある点も重要なポイントだ。

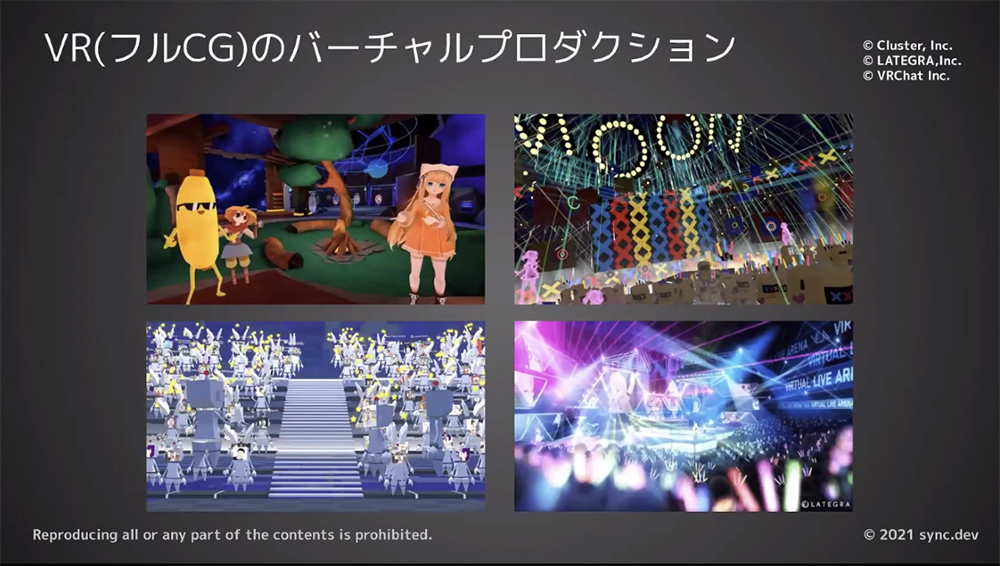

この他、ニッチ分野で急速に盛り上がりをみせているのがVR(フルCG)方式だ。3DCGのバーチャル世界内で撮影(キャプチャ)を行う方式で、ゲームキャラクターやVTuberのコンテンツ制作に向いている。実際のカメラが不要で、マシンパワーが許す限り、いくらでもカメラ数が増やせる。リアルタイムCGとして視聴者に配信できるため、インタラクティブ要素が入れやすいのも本方式ならではだ。視点を視聴者に任せることができ、VR HMD対応コンテンツにしやすい点もメリットとなる。

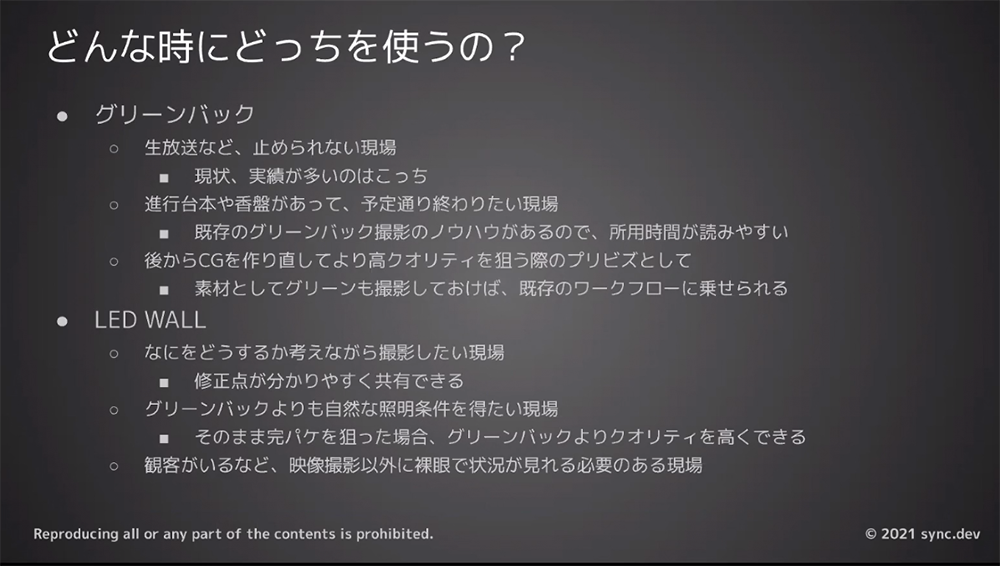

デメリットはモニタを通さないと完成系がイメージしづらい点だ。他に実写要素を入れられない、または入れるのが大変な点も挙げられる。このように、三者三様の特徴があるため用途に合わせて選択することが重要だ。岡田氏は、時間の関係からグリーンバックとLED WALLに限定して話を進めるとして、「グリーンバックは生放送など途中で撮影を止められない現場」、「LED WALLは何をどうするかを考えながら撮影したい現場」に向いているとまとめた。

続いてトピックはソフトウェアと機材の話に移った。バーチャルプロダクションは発展途上の技術であり、「これ1つでまかなえる」というオールインワンのソリューションは存在しない。複数のソフトウェアと機材を用途に応じて組み合わせて使用するのが一般的で、大きく下記のジャンルがあるという。

・エンジンソフトウェア(UE4など)

・バージョン管理システム(ローカル環境で動作するものが使いやすい)

・トラッカー(カメラ専用と多目的なものがある)

・PC本体

・GPU(現状ではNVIDIA Quadro RTX 6000/8000が鉄板)

・NAS(10Gbps対応が望ましい)

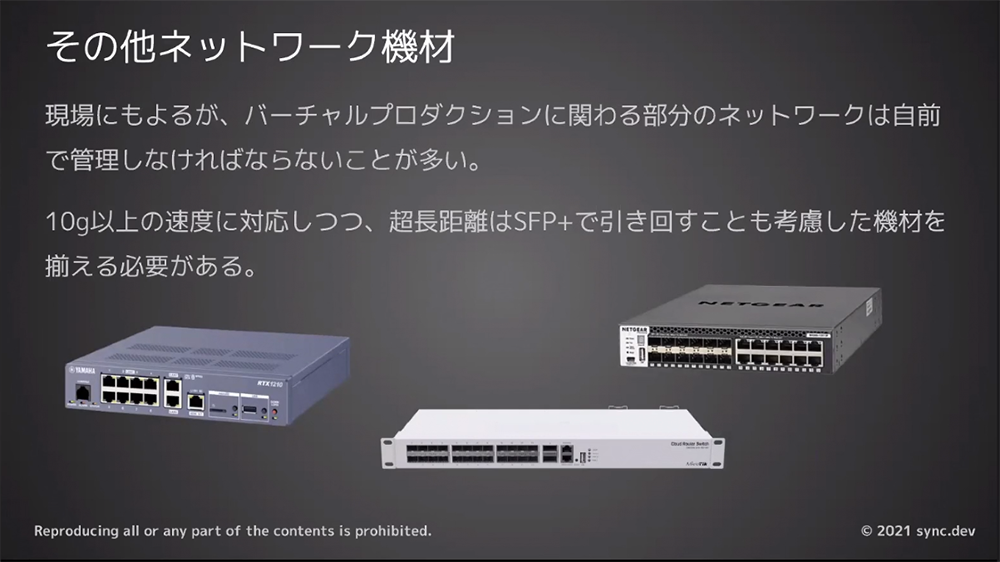

・その他ネットワーク機材(自前で用意することが多い)

・Genlock(LED WALLの場合は必須)

・撮影用カメラ(Genlock入力可能なものが望ましい)

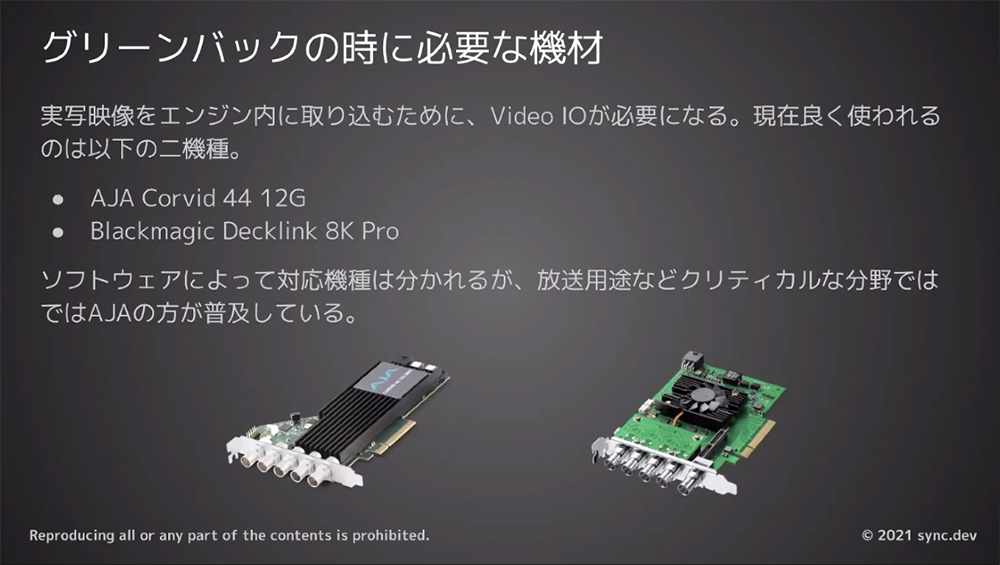

・Video I/O(グリーンバックの場合)

・LED WALLとNVIDIA Quadro Sync(LED WALLの場合)

中でも注意したいのがGenlockだ。カメラ、カメラトラッカー、PC、Video I/O、GPU、LED WALLなどで動作クロックの同期を取るもので、LED WALL方式では必須となる。これに伴いGPUもNVIDIA Quadro Syncが必要となり、いきおいQuadro RTX 6000/8000シリーズが求められることになる。コンテンツ制作ではGeForceシリーズが主流だが、バーチャルプロダクションでは事情が異なるので注意が必要だとした。

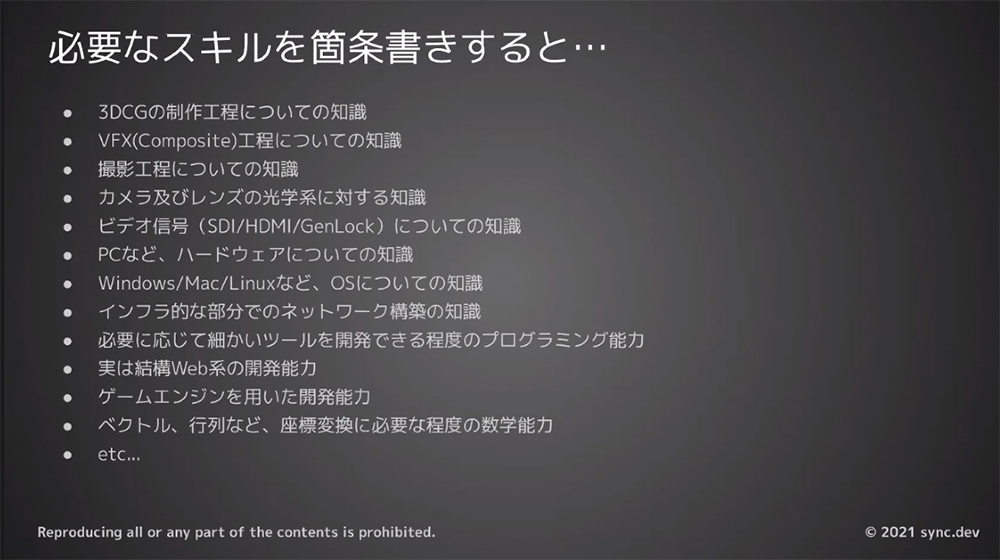

このように、バーチャルプロダクションには多種多様なソフトウェアや機材が必要だ。これはすなわち、運用するために多種多様な知識とスキルをもつ人材が求められるということでもある。ソフトウェアや機材の知識に留まらず、3DCGやVFXの制作工程、カメラやレンズの光学的な知識、ビデオ信号に関する知識、OSやネットワークに関する知識、ゲームエンジンやWeb系の開発能力、ベクトルや行列などの数学能力と幅広い知識が求められる。現状、「そんな人材はいない」という結論に陥りがちだ。

そのため岡田氏は「何か1つの分野について専門的に学んだ経験があり、専門外の分野に越境できる人材」が望ましいとした。1人で全ての分野を賄うのではなく、1つの専門分野をベースに他の分野と会話ができるだけの知識があれば良い。バーチャルプロダクションエンジニアは(そんな職種は現在は存在していないが、だからこそ現状は)究極のジェネラリストというわけだ。岡田氏は、本分野は産業として若く確立された手法がないからこそ、新しいものをつくる喜びとチャンスがあると話す。一緒に新しいものをつくろうと呼びかけ、講演を締めくくった。

オリジナル短編作品『HYBRID』の制作過程

最後に登壇したのが、東映デジタルセンター ツークン研究所でディレクターとして働く市田俊介氏だ。ツークン研究所は東映デジタルセンターの研究機関としての役割を担い、映像制作の未来をデザインすることをミッションに掲げて、様々な研究開発を進めている。

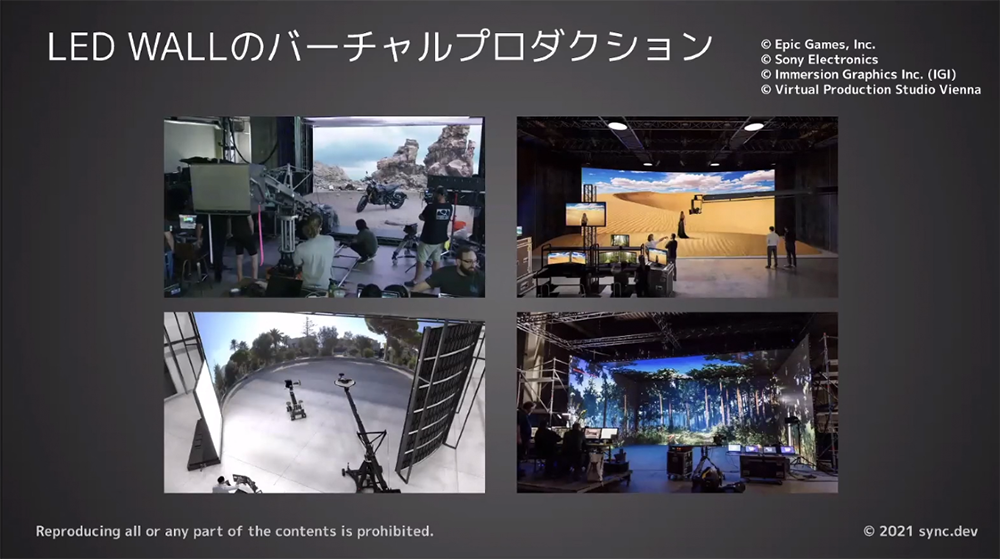

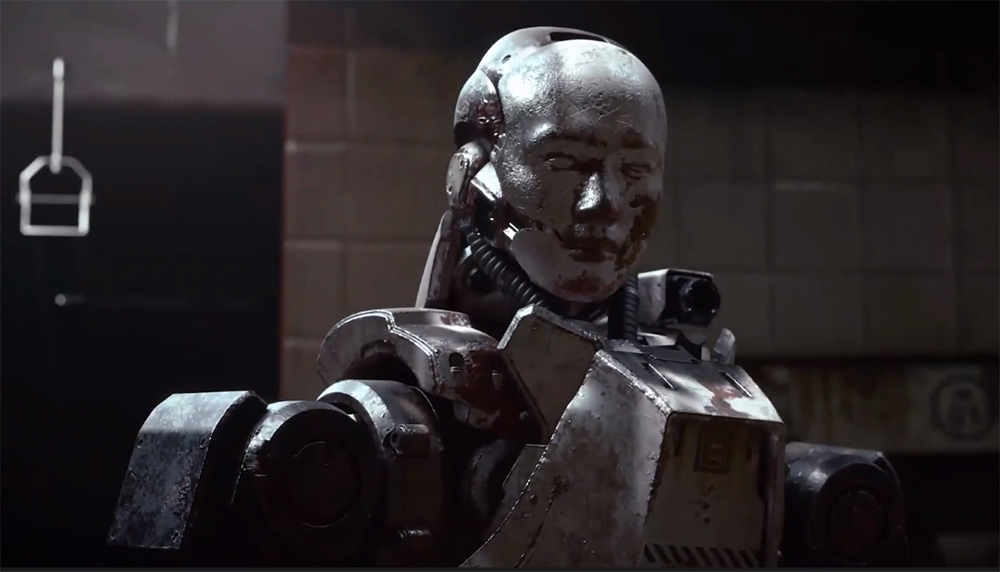

その一環として制作され、2020年12月にWeb上で公開されたショートムービーが『HYBRID』だ。タイトル通り実写俳優と3DCGキャラクターのリアルタイム共演をテーマに制作されたアクション作品で、3DCG映像はUE4によって制作され、内製のリアルタイム合成システム「LiveZ studio」で2つの素材を融合させている。

●関連記事

「UE4を活用することで生身の役者とCGキャラの即興的な芝居を実現! オリジナル短編作品『HYBRID』」

同社では、これまでもLiveZ studioを使用して実写背景と3DCGのキャラクターの合成を行なってきた。もっとも、動きの少ない背景を3DCGキャラクターとリアルタイム合成させても、費用対効果が少ないのではないか。であれば、動き回る上に実写俳優とコミュニケーションをとるような3DCGキャラクターをリアルタイム合成した方が、メリットが大きいのではないか......。そのような意図で本企画がスタートしたという。

ポイントは合成処理をリアルタイムで行なっている点だ。これによりグリーンバックを用いたバーチャルプロダクション、しかも実写キャラクターと3DCGキャラクターが入り交じる複雑な撮影であっても、現場で何が起きているかがモニター越しにわかり撮影の効率化が図れた。演者間で立ち位置や目線の位置が瞬時に把握でき、撮影段階で様々な問題点が潰すことができたという。

「リアルタイム合成をすることで、俳優とモーションアクターが現場でコミュニケーションを取りつつ、実写と3DCGの双方で演技を修正することができたので、楽しく撮影ができました。次回は実写と3DCGキャラクターの双方で、アドリブの掛け合いなども試してみたいですね。モーションアクターに『こういった動きをすると、CGがめり込みやすいので避けてください』といった具体的な演技指導ができるのも、本方式のメリットだと思います」(市田氏)。

またLiveZ studioには、グリーンバックを使用せずAIによって演者の輪郭を切り抜き、マスクを自動生成してリアルタイム合成する「AIマスク」機能がある。本作でもカメラが演者を回り込んで撮影するシーンなどで、このAIマスクが使用されている。現段階では発展途上の技術だが(市田氏いわく『プレビュー品質』とのこと)、今後も改良を続けていくことで、撮影の自由度向上が期待できるとした。

もっとも、課題もあった。本方式ではモーションキャプチャシステムにVICONを使用したところ、実写撮影に用いる照明機材などによってMoCapデータのノイズが増加したのだ。「撮影方式の改良や他のセンサを使用するなど、さらなる検証が必要だと感じました」(市田氏)。またリアルタイム合成の仕様上、撮影に数フレームの遅延が発生する。そのため、激しいアクションシーンではこの遅延が気になることがあった。本作では撮影カメラマンの練度でカバーしたものの、同社では『仮面ライダー』シリーズや『スーパー戦隊』シリーズといったアクションシーンの多い作品があるため、地味ながらも重要な課題だという。

もう1つの課題が、UE4を用いたフォトリアルな映像制作だ。レイトレーシングを使用することで、間接照明やリフレクションなどをリアルに表現できた。もっとも薄暗いシーンが多かったためノイズが大量に発生してしまい、制作終盤はノイズの削減が大変だったという。「当初からノイズ問題は想定されたため、最終的なアウトプットはプリレンダームービーにすると決めていました。それでも処理が重く、作業中はレイトレーシングを切るかノイズが多い状態で作業を進めて、最後に最高品質でレンダリングするようにしました」(市田氏)。

ちなみに、本作で使用されたレンダリング用PCのスペックは下記の通りだ。後述するフォトグラメトリで作成された3DCG素材の活用も含めて、データの最適化については制作時間などの問題もあり、あまり考慮せずに進められた。それにも関わらず、撮影ワークフローの改善などもあり、トータルで見るとある程度の成果が出せたのではないかと話している。その上で、今回得られた課題を基に今後も改善を続けていきたいとした。

・GPU:Nvidia GeForce RTX 3090

・CPU:Intel Core i7

・メモリ:32GB

・解像度:4K

・レンダリング時間:約30秒/フレーム

最後に市田氏は、本作で使用したフォトグラメトリについて触れた。制作速度を上げるため、背景は約8割がアセットストアの素材を組み合わせたり改造したりして制作されている。残り2割のオリジナル素材のうち市田氏がこだわったのが、骸骨のフォトグラメトリだ。同社の美術スタッフが制作し市田氏が自ら撮影した。「制作する手間とコストは必要ですが、3DCG化は非常に楽です。弊社のように美術スタッフが常駐する現場では、有効な手段だと感じました」(市田氏)。

実際、今年3月にUE4を開発するEpic Gamesが、フォトグラメトリツール大手のCaptureing Realityを買収している。この例に限らず、3Dスキャン技術をゲームエンジン上で用いたワークフローの改善はホットトピックの1つだ。市田氏は「実写映画が得意な東映の強みとデジタルを組み合わせて、様々な意味で『HYBRID』な作品制作を今後も追求したい」と抱負を語った。