エピック ゲームズ ジャパンは2025年12月10日(水)、映像制作に焦点をあてたUnreal Engine 5(以下、UE5)の勉強会「Cinematic Deep Dive’25」を開催した。2025年はオフラインでの開催となり、映画やドラマ、CGアニメーションにいたるまで、多彩な映像制作分野におけるUE5の最新ワークフローや表現技術について講演が行われた。

本稿ではこれらの講演のうち、エピック ゲームズ ジャパンの向井秀哉氏による「MRQ から Movie Render Graph への移行ガイド」、NHK 井藤良幸氏による「NHK大河ドラマICVFXにおけるバージョン管理システムの活用」、M2 AnimationのFilip Stanfeld氏による「From Unreal to Screen: M2 Pipeline」、元ピクサー・アニメーション・スタジオのシニアアニメーター・原島朋幸氏による「Animating in Unreal Engine」の4つの講演を紹介する。

ノードベースでより便利に。「Movie Render Graph」を解説

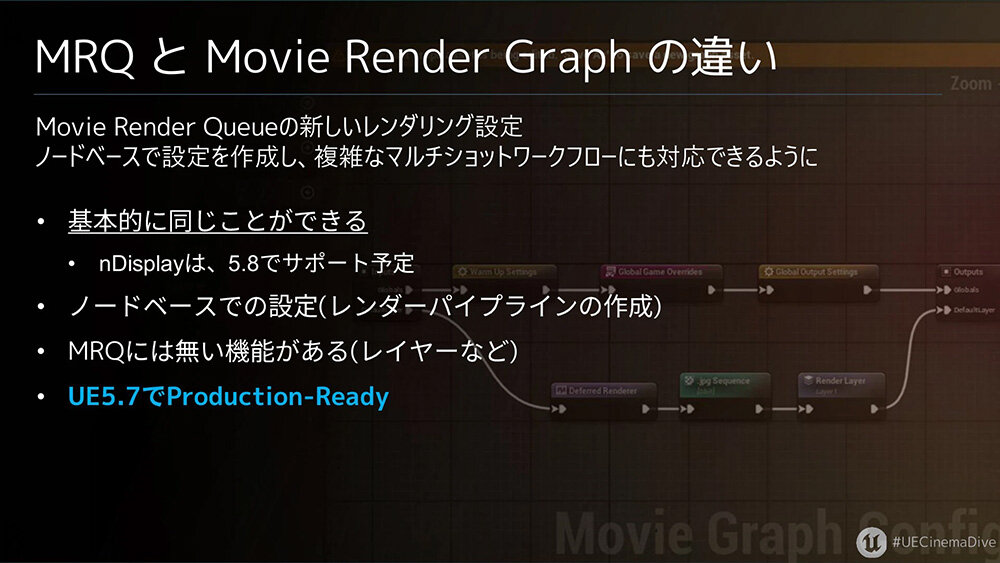

イベントは、まずエピックゲームズジャパンSenior Solutions Architectの向井秀哉氏より開会のあいさつと、「MRQからMovie Render Graphへの移行ガイド」として、UE5.4より新たに登場した機能「Movie Render Graph(MRG)」についての解説が行われた。「Movie Render Graph」は、UE4より実装されている「Movie Render Queue(MRQ)」の新しいレンダリング設定で、ノードベースによってレンダーパイプラインなどの作成が可能となる。UE5.7よりプロダクションレディとなっている。

MRGは、MRQで可能だった機能を全て内包している一方で、設定や操作の考え方がワークフロー単位に再設計されている。そのため、MRQから移行する際には、従来の設定項目を探して迷ってしまう場面も少なくない。そこで向井氏は、MRGで変化した点や新機能について解説していった。

向井氏はまず、MRG使用のながれを見ていきながら、機能の中身を紹介した。MRGの基本構造は大きく分けて2つ。ひとつはGlobalで、解像度やファイルの保存先など、レンダリング全体の設定をするもの。もうひとつがLayerで、どのようにレイヤーを分けるか、レンダーパスや出力する拡張子などを設定する。

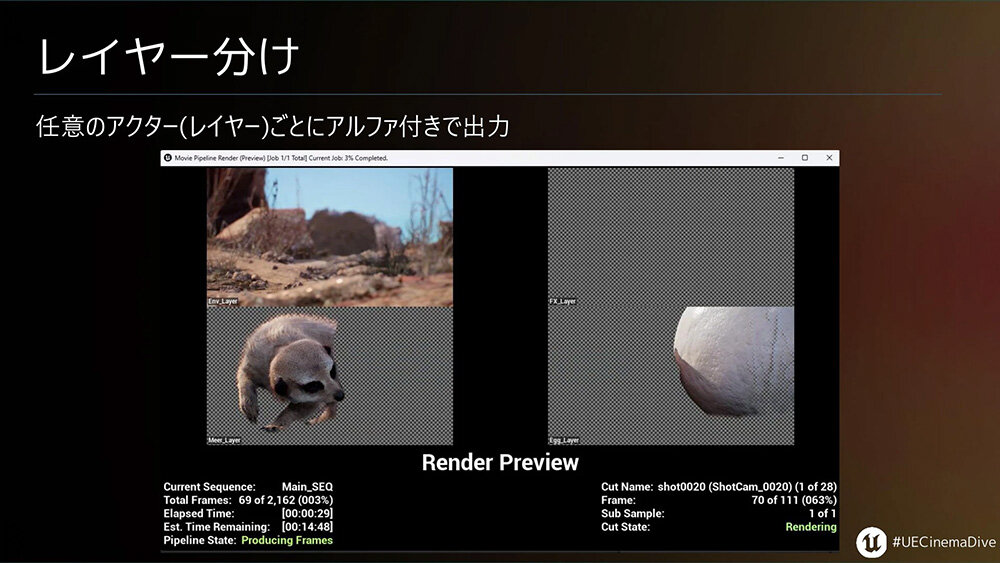

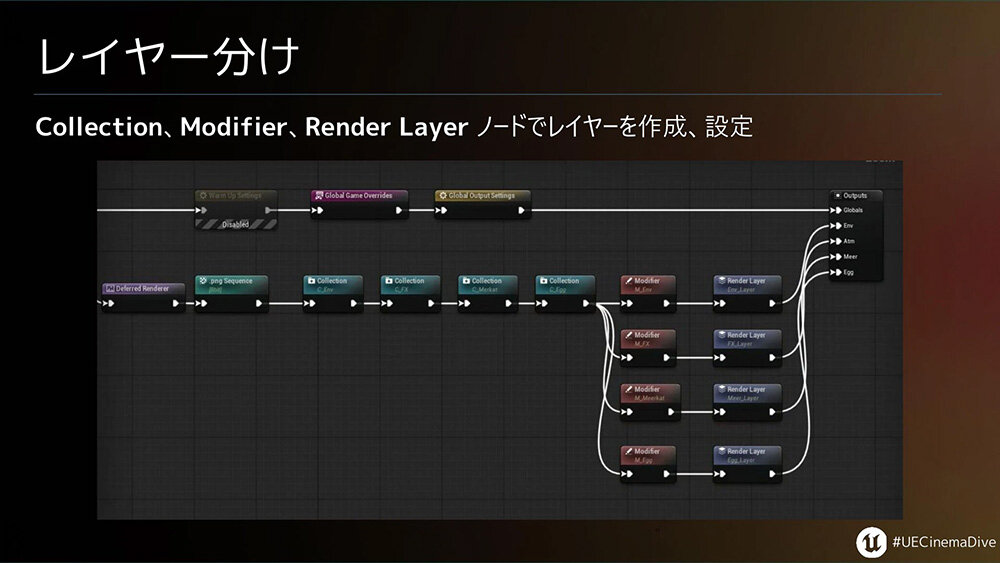

MRGで大きく変わった点として、より柔軟に各アクターのレイヤー分けが可能になったことが挙げられる。レイヤー分けに使用するのは、「Colleciton」「Modifier」「Render Layer」のノード。このノードを順番につなぐことで、レイヤーで分けた状態で書き出すことができる。

「Colleciton」は、レイヤーで分けたいアクターごとにグループ(コレクション)を作成できるノードとなる。「Modifier」は、指定したコレクション内のアクターについて、表示/非表示や影を落とすかどうかなどを指定できる。

[Colleciton→Modifier]とつないでコレクションと設定を完了したら、最後に「Render Layer」へとつなぎ、ここでレイヤーの名前をつける。名前をつけるのみの機能だが、これがないとレンダリングされないので注意が必要だ。

このほか向井氏は、デフォルト設定やAnti-Aliansing、別途Ambient Occulusionを出力したい場合など、MRQとの使用方法のちがいを説明していった。

向井氏はMRGについて、「ノードでレンダーパイプラインの構築が可能になったため、例えばアーティストが変更する設定は最低限にしておくことでヒューマンエラーを減らせます。大規模なプロジェクトになるほど、変数や分岐が使用できるノードベースの機能は活きてくると思います。ぜひ、お試しください」と締めくくった。

講演スライド

MRQ から Movie Render Graph への移行ガイドコロナ禍の影響化、VP主体で作り上げたNHK大河『どうする家康』

NHKメディア技術局コンテンツテクノロジーセンターCG/VFXの井藤良幸氏からは、「NHK大河ドラマICVFXにおけるバージョン管理システムの活用」と題し、大河ドラマ『どうする家康』で使用したインカメラVFXとバージョン管理の事例を紹介していった。

NHKでは、2017年にUEが無料化したことに伴ってUEによるコンテンツ開発がはじまり、2021年からバーチャルプロダクション制作が本格化している。2023年に放送された『どうする家康』はNHK最大のバーチャルプロダクションプロジェクトで、その後のバーチャルプロダクションの全ての基本となった。

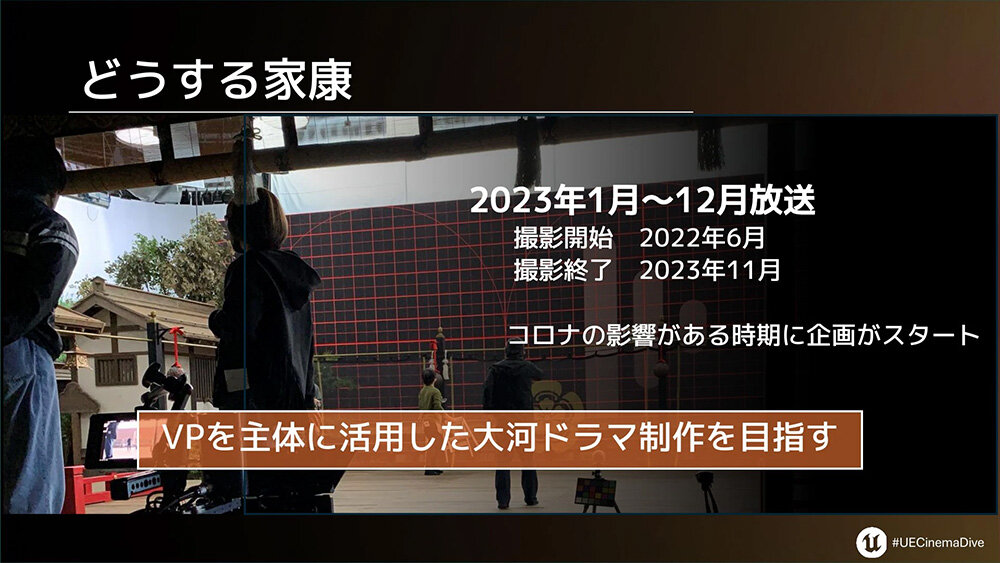

『どうする家康』が放送されたのは2023年1月から12月。撮影は2022年6月から2023年11月までで、まだコロナ禍の影響が強い時期に企画がスタートしている。そのため最初から、「バーチャルプロダクションを主体とした大河ドラマ制作」を目指すプロジェクトとなった。

最大横27m縦6mのLEDスクリーンの前に実際のセットを配したICVFX撮影を年間を通して実施し、このプロジェクトで得た知見が、その後のNHKのバーチャルプロダクションの基本形となっている。『どうする家康』では、1年半の撮影の80%以上でバーチャルプロダクションを使用し、UE上のプロジェクト数は119になった。

撮影は週単位で、1コンテンツ30〜60分程度を最大5コンテンツ程度作成する。1コンテンツは30〜50GBあり、撮影は切れ目なく毎週くり返されるため、データの転送ネットワークをどう構築するかがポイントになった。

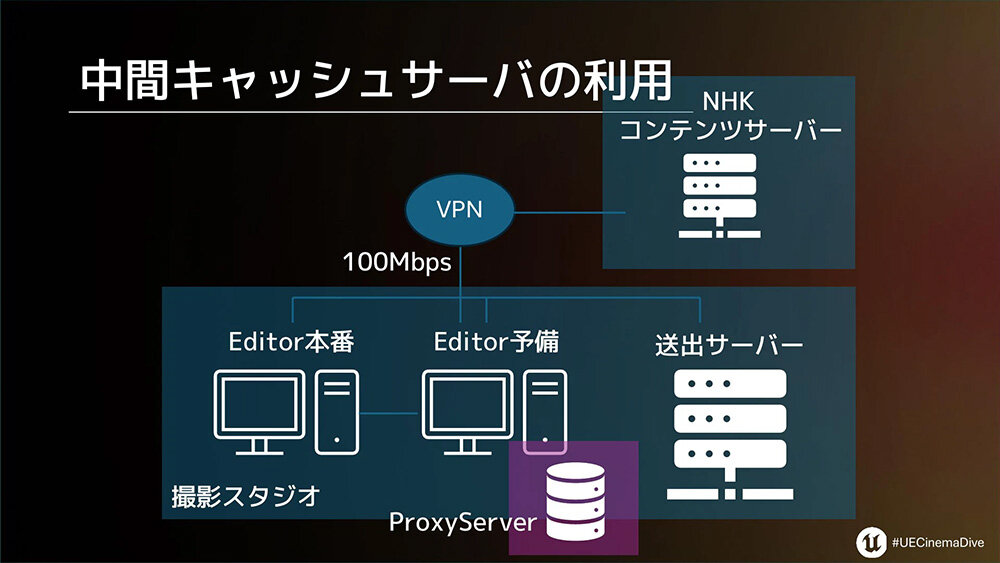

NHKでは、バイナリデータが多いUEと相性が良いということで、UEを使うプロジェクトではバージョン管理ソフトにPerforceが使用されている。PerforceサーバをNHKに構築し、プロダクションだけでなく、撮影スタジオともVPNでつなぎ、コンテンツ制作と運用を一体化してバージョン管理していった。

ここで問題になったのは、データの転送には一般のインターネット回線を使用していたため、各スタジオの実測値で100Mbps程度だったこと。30〜50GBある1コンテンツあたりで1時間、5コンテンツとなると5時間弱かかってしまう。編集用のPCは予備機を含め2台あるため、そのままだと単純に2倍の時間がさらにかかることとになる。

この点は、予備機に中間キャッシュサーバを構築することで解決した。全てのデータは中間キャッシュサーバを介することで効率化できたほか、PerforceにはProxyサーバ機能があり、一度ダウンロードしたものはキャッシュに溜めることができる。これにより、新規ファイル以外は本番サーバにアクセスせずにワークスペースをつくることができた。

講演ではこのほか、各プロダクションも含めたバージョン管理のコツや実際の運用方法、バーチャルプロダクションでの撮影を選択する場合の条件、連続テレビ小説「あんぱん」での撮影事例などが紹介された。

講演スライド

NHK大河ドラマICVFXにおけるバージョン管理システムの活用アニメシリーズにUEを採用。高品質な画づくりのコツとは

「ウォーハンマー」などのシネマティック映像やアニメシリーズなどを制作するM2 AnimationのFilip Stanfeld氏は、「From Unreal to Screen: M2 Pipeline」と題した講演にて、ゲームエンジンの使用経験ゼロだったところからいかにUEを活用したアニメーション制作体制を構築したかを語った。

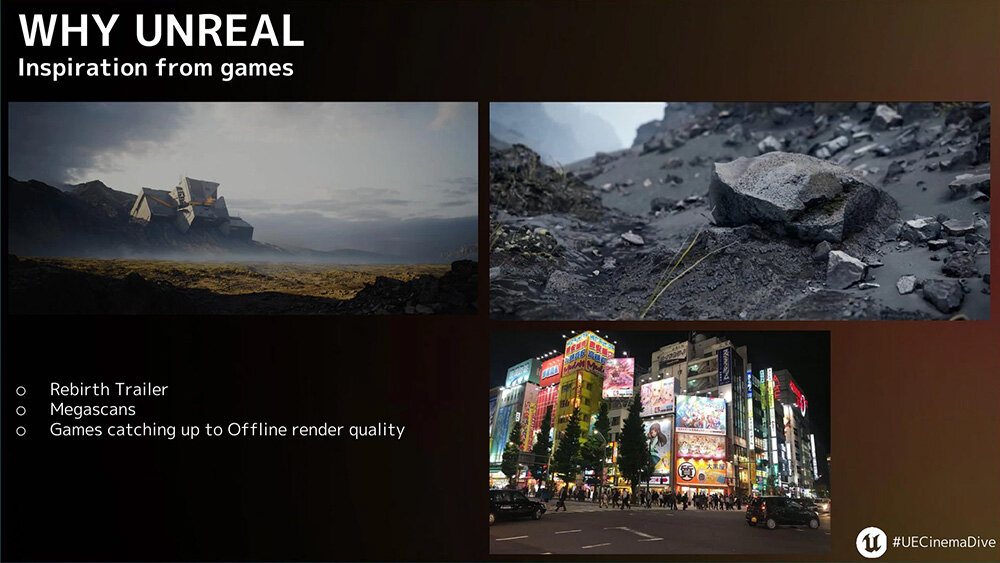

M2 AnimationとUEの出会いは2020年。それ以前から長いレンダリング時間は課題となっており、リアルタイムレンダリングが可能なゲームエンジンが活用できないかという議論は度々上がっていたが、見た目が「ゲームっぽくなる」という理由で避けられていたという。

しかし2019年にQuixelが公開したトレーラー「Rebirth」とそのアセット「Megascans」が話題になり、また同時期にStanfeld氏が見かけた、巨大モニターに映し出されたFPSゲームの映像クオリティが高く、自身が長時間かけてレンダリングしていた映像とほぼ遜色なかったことに衝撃を受け、UE4を用いて小規模な実験を始めたという。

最初はキャラクターをインポートして、カメラやライトを触ってみる程度だったそうだが、すぐに「これはいける」と可能性を感じたそうだ。その時点で実践投入の予定はなかったものの、偶然にもクライアントの要求やスケジュールが変わったことで、M2 Animationのレンダーファームが数ヶ月にわたって完全に埋まってしまう事態が起こる。

それでもシネマティックトレーラーを納品しなくてはならなかったため、当時としては相当なチャレンジであったものの、最初から最後までUEを使用する決断をしたという。努力の結果このチャレンジは無事成功し、さらに長尺のシリーズもUEを使用するきっかけとなった。

最初の一歩から5年が経ち、今ではUEはM2 Animationの制作パイプラインの根幹となっている。これまでに放送された「ウォーハンマー」のアニメーションは300分を超え、さらにその先のエピソードの制作予定も組まれている。

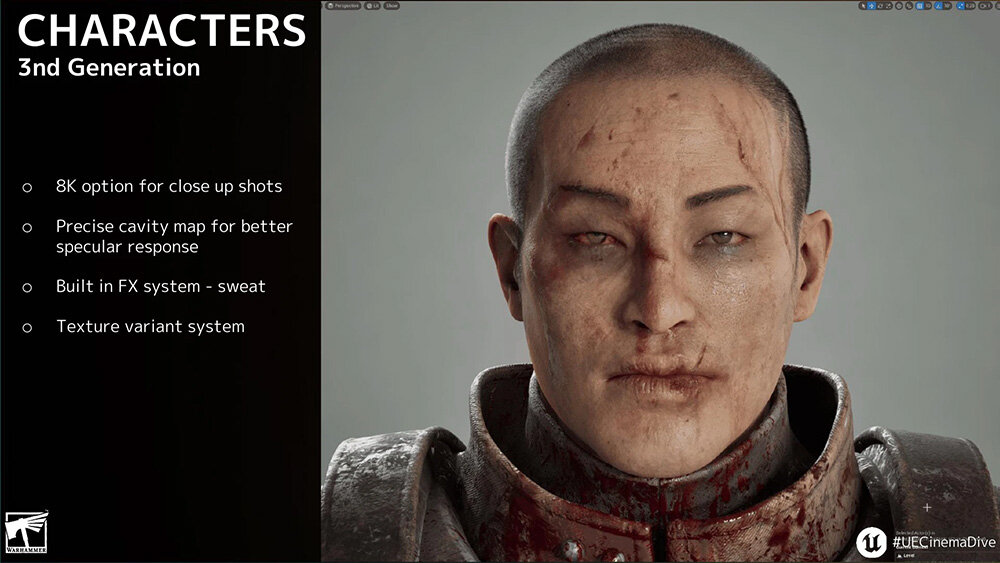

現在は最新のキャラクター制作として、ヒーローキャラクターの改良に取り組んでいる。テクスチャ解像度を8Kまで引き上げ、クローズアップでも妥協の少ない表現が可能となった。またキャラクターのマテリアルのなかにFXレイヤーシステムを構築し、汗などの要素をショット内で直接制御し、熱や緊張といったより人間的な表現のコントロールが可能となった。

さらに講演では、リアルタイムレンダリングならではの問題点である、チラつきや、オブジェクトが急に切り替わる、挙動がおかしくなるといった現象への対処法が語られた。

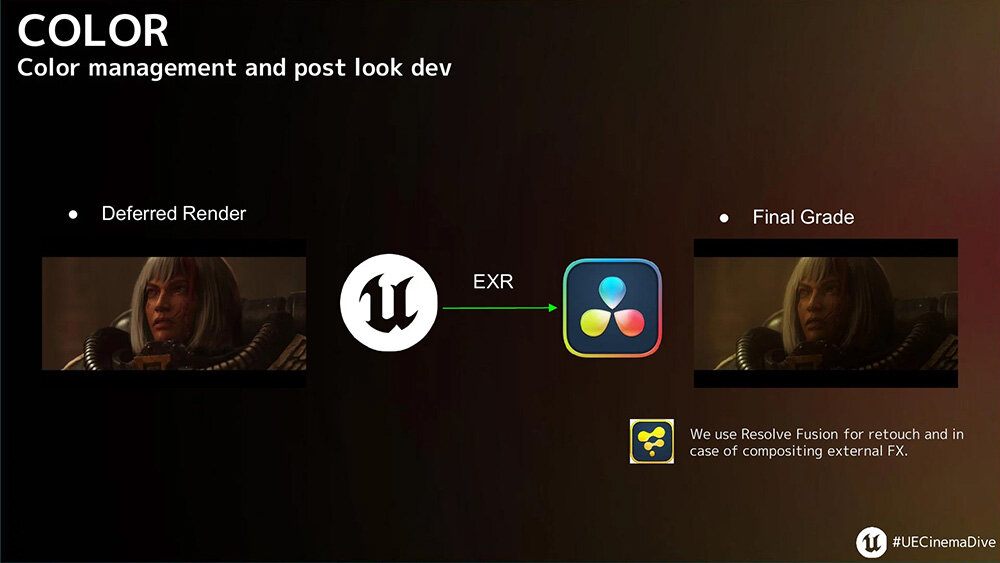

こうした問題の原因は様々で、完全な対応策を見つけることはかなり難しい一方、長編シリーズの制作現場では解決に時間をかけることはできない。M2 AnimationではUEからEXRファイルを書き出してDaVinci Resolveに移し、最終的な処理を行うが、そこで古いフィルムの特性を利用することで、リアルタイムレンダリングの欠点に対処しているという。

まず、DaVinci Resolveのノイズ除去、フリッカー除去ツールを使う。高速かつ簡単にできるため、この時点でスケジュール面に大きなメリットがある。

次に、ぼかす。リアルタイムレンダリングは実際のシネマレンズに比べてシャープすぎるため、ディフュージョンやソフトニングフィルタ、ノイズリダクションを適用して全体を馴染ませる。これにより、より心地よい映像になり、ノイズも効果的に破壊できるという。

また実際のレンズのような、若干の歪みやフレア、エッジのソフトさといった特性を加える。視聴者が気づくほどではないが、これによって人工的に見えにくくなり、さらにノイズやチラつきを押さえて画像全体を上手く馴染ませてくれるという。

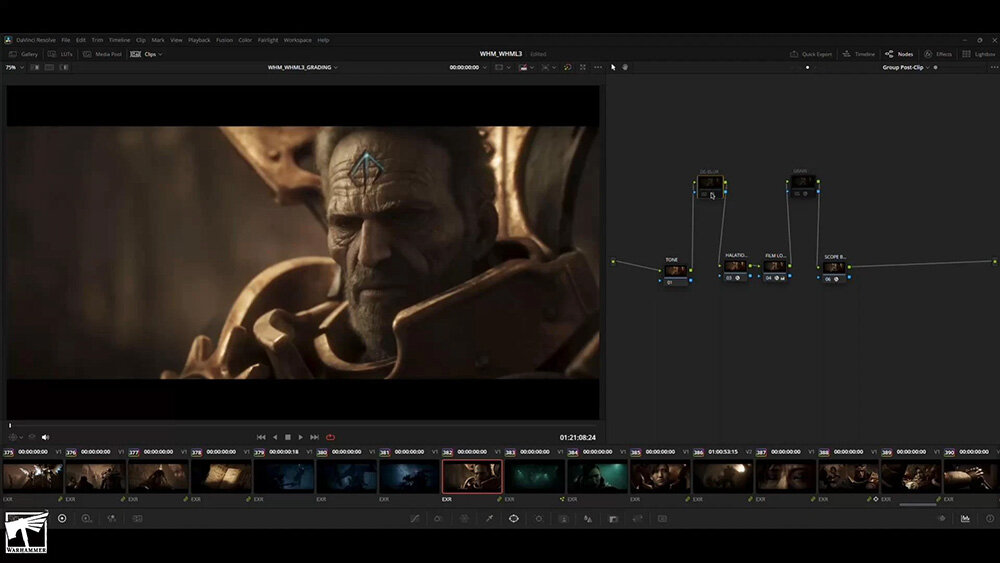

ほかにもハイライト部分にビネット処理やドッジ&バーンを加えたり、DaVinci Resolveのグループノードを使って一気に全体をグレーディングするなどの処理を行なった後、少しだけシャープネスを加える。

これらは映像を馴染ませたあとに行うため、ノイズやチラつきをなくしたままシャープさを戻すことができる。そして最後にフィルムグレインを大量に加えて、さらに映像を馴染ませ、残りのわずかなノイズとチラつきを抑える。こうして、M2 Animationらしい映像が完成すると語った。

講演スライド

From Unreal to Screen: M2 PipelineUEアニメーションの基礎知識&TIPSを原島朋幸氏が解説

ピクサー作品をはじめとした長編映画制作に20年携わったシニアアニメーターの原島朋幸氏は、「Animating in Unreal Engine」と題した講演にて、UE5.6内でアニメーションするための基礎知識やTIPSをアニメーターならではの視点で紐解いた。

原島氏は現在でこそアニメーションツールとしてUEを採り入れているが、UEではそもそもアニメーションに関する情報が少なかったり、MayaなどのDCCツールとの使い勝手が異なるため、移行するハードルが高いと感じているという。

特にハードルとなっているのが、UEはゲームエンジンであるため各DCCツールとはコンセプトが異なること。そのため構造や、似た機能であってもネーミングが異なっているなど、紛らわしいことが多々ある。

一例として、Mayaにおける「シーンファイル」は、UEでは「Level」との名前になり、さらに下に「Level Sequence」がある2段階の構成となる。原島氏は、Levelは背景やプロップなどのアセットを保持するもので、Level Sequenceはタイムラインに関連するようなアニメーションデータを保持するもの、と説明。Level Sequenceの中にさらにライティングやエフェクトなどのLevel Sequenceを入れることも可能となる。

またUE独自の用語にも触れ、ActorはLevelに配置できるオブジェクト、Static Meshは通常のオブジェクト(ジオメトリ)、Skeletonはボーン情報、Skeletal Meshはバインド情報、Control Rigはリギング情報と、混乱しやすいポイントを整理していった。このほか、Mayaと同じような挙動や操作方法になる事前設定なども紹介された。

続いて原島氏は、実際にUE上でアニメーションを付けるながれを動画で見せていった。ひとつは球体のオブジェクトを用いたもので、Transformトラックのシーケンサー上でキーフレームを打ち、カーブエディタで動き方を調整してバウンスボールのアニメーションを作成してみせた。

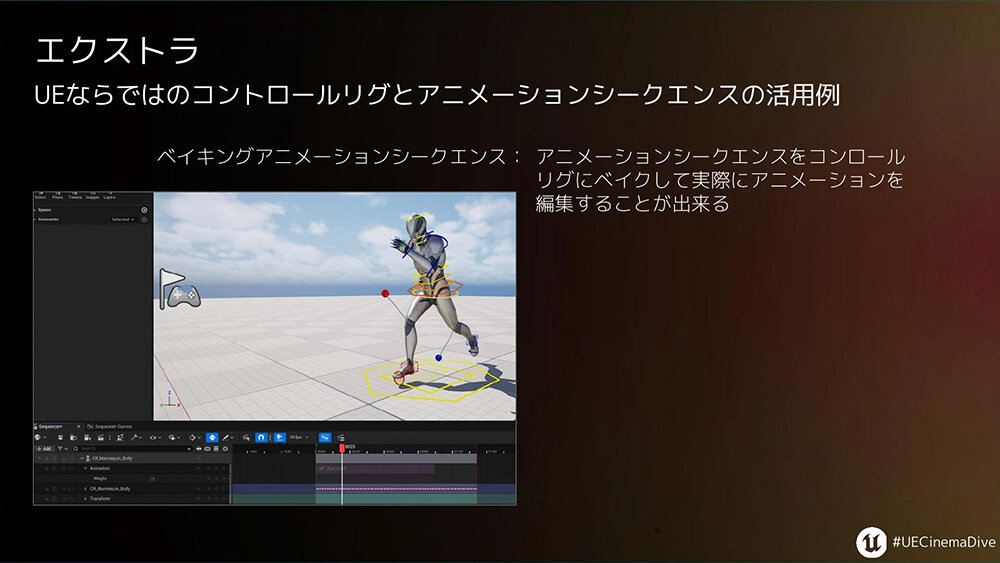

また人型のマネキンを動かす例では、オートキーやフレームレート設定など、シーケンサーのなかの機能をひとつずつ紹介。ミラー機能などのTIPSを交えたり、アニメーションシークエンス同士を重ねると簡易的にブレンドし、そこからさらにリグを調整できるUEならではの機能など、より実践的にUEでアニメーションする方法が紹介された。

講演スライド

Animating in Unreal Engine過去のCinematic Diveが、Unreal Engineの機能紹介や技術解説を中心とした内容だったのに対し、Cinematic Deep Dive’25では、映画、ドラマ、ライブ、MVなど複数ジャンルの実制作事例が並列的に紹介された点が印象的だった。各事例を通じて、Unreal Engineを活用したリアルタイム3D表現は、ゲーム以外の映像制作の現場においても、実践的な選択肢として広がりつつある。今後のUnreal Engineの動向にも目が離せない。

TEXT_谷原象牙/Zouge Tanihara

EDIT_藤井紀明/Noriaki Fujii(CGWORLD)