本連載では、ロボットや自動システムと融合するAI「フィジカルAI」がもたらす産業分野の変革の行方を追う。

初回となる今回のテーマは、「デジタルツインとフィジカルAIの可能性」。

ChatGPTはAIが社会全体に大きな変化を及ぼすことを明らかにした。それに匹敵する次の衝撃として注目の技術が「フィジカルAI」だ。そもそもフィジカルAIとは何か? 3DCGデザイナーはどのような役割を担えるのか? NVIDIAのシニア・ビジネスデベロップメント・マネージャーの中嶋雅浩氏とソリューションアーキテクトの加瀬敬唯氏に話を聞いた。

プロフィール

中嶋雅浩氏

エヌビディア

シニア・ビジネスデベロップメント・マネージャー(RTX/Omniverse)

加瀬敬唯氏

エヌビディア

ソリューションアーキテクト(Robotics)

「フィジカルAI」によって、人間とロボットが同じ空間で協業できる

「フィジカルAI」とは、現実世界で物理的な相互作用を伴うロボットや自動システムに搭載されるAIである。NVIDIAではフィジカルAIは50兆ドル(約7,500兆円)規模の市場を創出し、製造や物流など基幹産業の姿を根底から覆すと予測している。フィジカルAIは世界基盤モデル(後述)を認識・理解して世界を予測するモデル。LLM(大規模言語モデル)がテキスト入力に対してテキストを出力するように、自分自身に搭載されたカメラやセンサーからの入力に対してアクチュエータ(※電気や空気圧、油圧などのエネルギーを受け取り、それを物理的な運動に変換して機械や装置の一部を実際に動かす装置)の制御信号を出力する。

フィジカルAIによって、何ができるようになるのか。「従来の産業用ロボットは、定められた範囲内で作業する専用機が中心で人間とは分離されており、生産効率の改善には限界がありました。フィジカルAIによりヒューマノイドのような汎用ロボットや自律走行搬送ロボットが、人間と同じ空間で、柔軟に判断しながらダイナミックなタスクをこなせるようになります。つまり多品種少量生産への対応など従来の技術では難しかった課題に対応できるようになるのです」(中嶋氏)。

フィジカルAIを実現するためには、AIモデルが不特定・不確定な要素に満ちた現実世界を正しく認識し、次に行うべき行動を自律的に判断できるようになる必要がある。人とぶつからずに作業したり、目的の作業対象を正確に見分け、絶妙な力加減で操作する――こうした高度な判断能力の実現がフィジカルAIの核心となる。

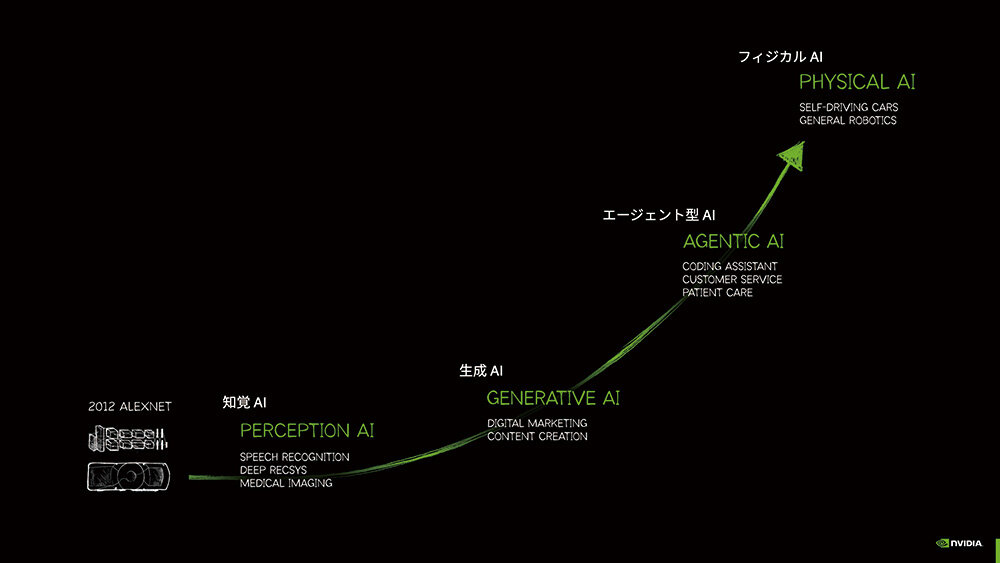

AIテクノロジー進化の過程

フィジカルAI実現に不可欠な「3つのコンピュータ」

フィジカルAI開発のためにNVIDIAは「3つのコンピュータ」が必要だとしている。

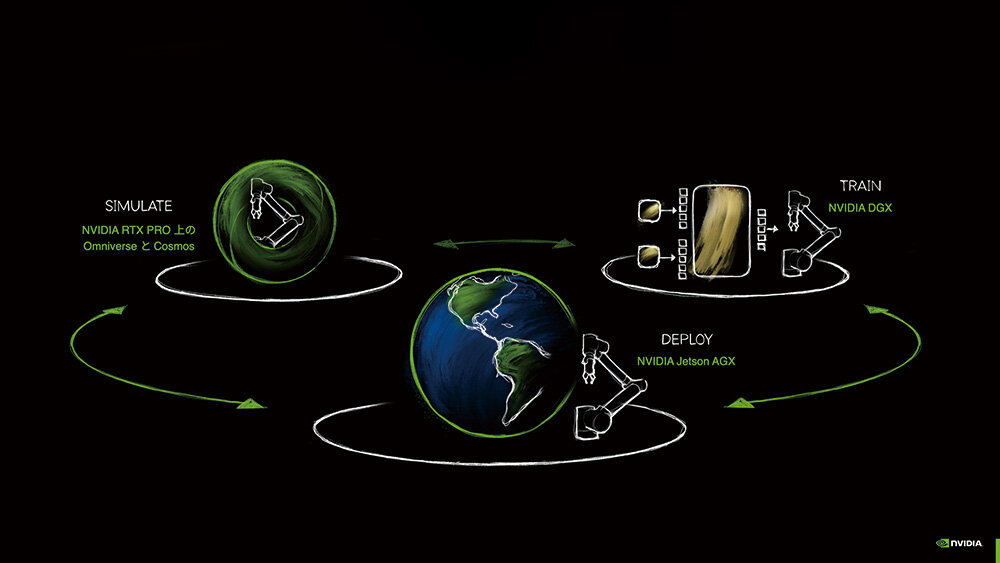

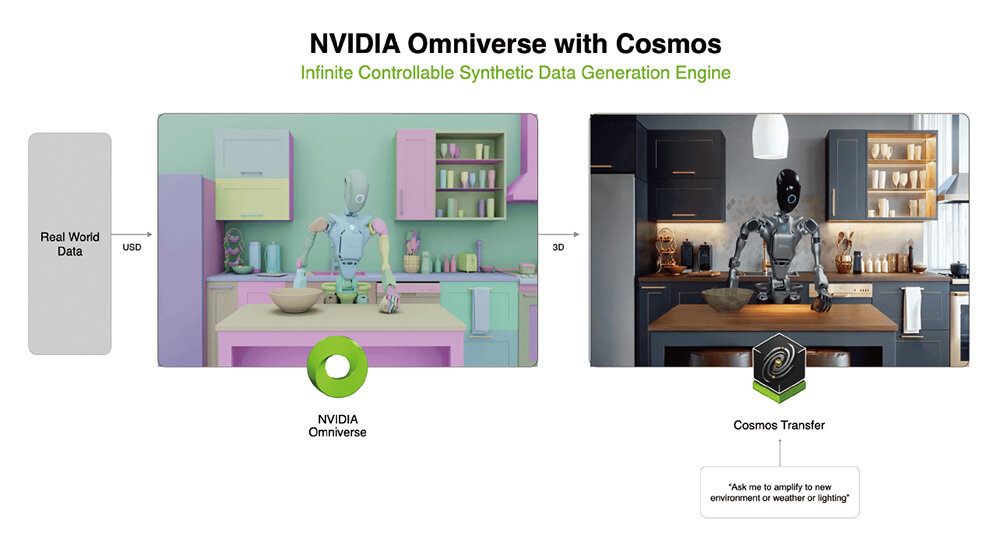

1つ目は、AI開発のためのトレーニング用コンピュータである。「NVIDIA DGX」などに膨大なデータを処理させてAIに物理世界を学習させるための計算機だ。2つ目は「NVIDIA Omniverse」や「NVIDIA Cosmos」から成るシミュレータである。AIをトレーニングするためには大量のデータが必要だが、現実では再現や収集が困難な状況も多い。それらの状況を仮想空間を使って大量に生成して収集できるようにする。そのためのデジタルツインをつくるプラットフォームがOmniverseであり、学習データと物理シミュレーションを組み合わせて合成ビデオデータを生成する世界基盤モデルがCosmosである(後述)。そして3つ目が、トレーニング済みのAIをロボットや自動運転車などのエッジデバイスに実装し、高速で推論・実行を行うためのコンピュータだ。「NVIDIA Jetson」などの組み込みコンピューティングボードである。コンパクトながら強力な性能で、現場でのリアルタイムな実行を可能にする。

これら3つのコンピュータは、密接に連携している。Omniverseで生成された学習データを使ってDGXなどがAIをトレーニングする。そしてトレーニング済みのモデルはJetsonなどに実装されて現場で活用される。そして現場で収集されたデータは再びシミュレータへとフィードバックされて、AIはさらに賢くアップデートされていく。この改善サイクルを高速に回すことが、フィジカルAI開発の鍵となる。

フィジカルAIを構築する3つのコンピュータ

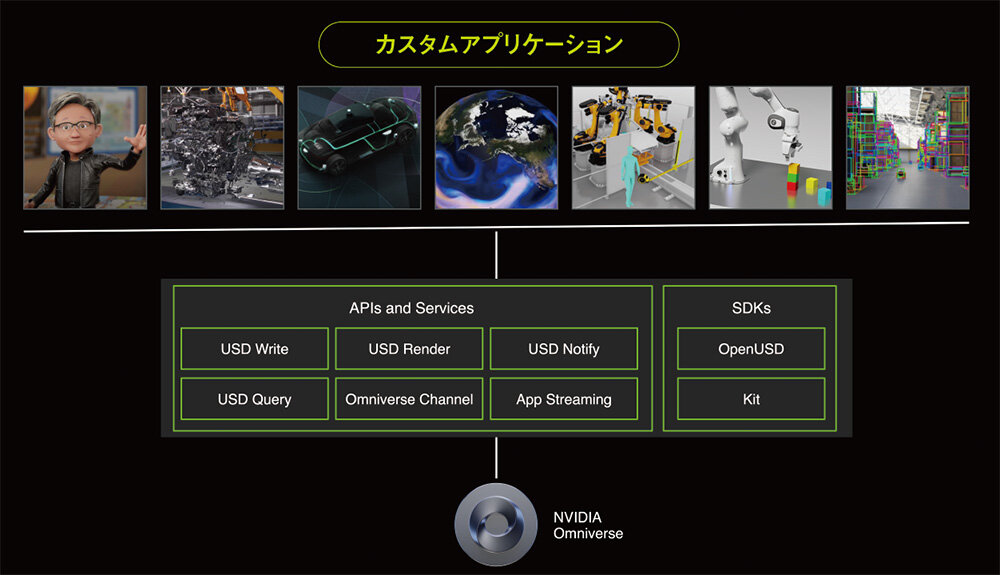

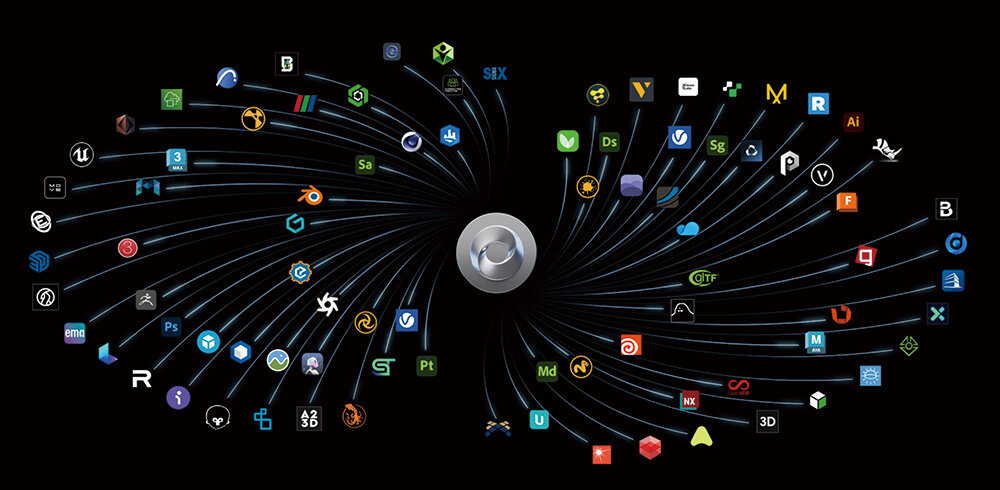

デジタルツインの構築基盤「Omniverse」が架け橋となる

3つのコンピュータにおいて、特に3DCGデザイナーにとって関わりがあるのはシミュレーションプラットフォームであるOmniverseだ。Omniverseはレンダリングだけでなく、物理シミュレーションも含めて現実世界を忠実に再現して、デジタルツインを実現するOmniverseはOpenUSD(Universal Scene Description)を中核としている。OpenUSDは単なる3Dファイルフォーマットではない。3Dワールド内でシーンを記述、構成、シミュレーション、コラボレーションするための拡張可能なオープンエコシステムとなっており、産業向けの3Dデータも物理的に忠実に扱える。「例えば、ある工場をデジタルツイン化する際、建屋の設計データはA社のCADソフト、生産ラインの設備はB社のソフト、ロボットのデータはC社のソフトといった具合に、仕様が異なる様々なソフトが用いられています。Omniverse上では、それらをあたかも1つのデータのようにシームレスに扱うことができるのです」(中嶋氏)。

OpenUSDを共通言語とし、物理シミュレーションを統合したOmniverseによる仮想空間でのシミュレーションを用いることで、製造業では「現場に行かなくても設計レビューができる」、「複数のサプライヤーが同一環境で同時編集できる」といった相互運用の効率化や拡張性、コスト削減が期待できる。

また、産業用ロボットフリートのデジタルツインを構築するための「Mega」というリファレンスアーキテクチャも発表されている。デジタルツインで人間の動きを含めて、大規模なフィジカルAIのフリートを最適化するためのBlueprintだ。OpenUSDは元々、大規模なCG映画制作の複雑なワークフローを管理するために生まれた記述フォーマットである。それが製造業のプロセスを変革しようとしているわけだ。

3Dプラットフォーム「Omniverse」とは

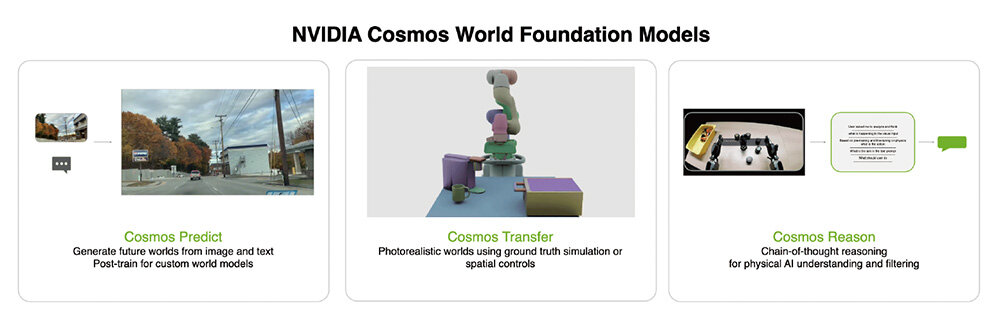

世界基盤モデル「Cosmos」が物理データの不足を補う

NVIDIAのフィジカルAIを支えるもう1つの要が、物理現象をデータ駆動で理解する世界基盤モデル(WFM:World Foundation Model)のCosmosである。人間は物理学を学ばなくてもボールを投げれば放物線を描いて飛ぶことを経験的に知っている。同様に、Cosmosは世界の在り方を膨大な映像データから学習する生成AIである。このCosmosこそ、多くの3DCGデザイナーにとって衝撃的かもしれない。例えば、ラフなグレーモデルのロボットが動く映像をCosmosに入力して「フォトリアルな背景で、このロボットを動かしてください」と指示するだけで、テクスチャやマテリアル、ライティングが自動で追加されたリアルな映像が出力される。つまり、3DCGデザイナーが膨大な時間を費やしていた作業をAIが肩代わりしてしまうのだ。「CGの知識がある人ほど、Cosmosのデモは理解できないかもしれません。Cosmosは3Dデータを扱ったり、物理ソルバーを解いたりしているわけではありません。入力された動画をAIが理解し、プロンプトに従って、まったく新しい映像を生成しているのです」(中嶋氏)。

Cosmosは1X Technologies、Agility Robotics、Figure AI、Skild AIなどのヒューマノイド開発企業に採用されている。この技術は、フィジカルAI開発における最大のボトルネックである学習データの不足を解決する手段となり得る。現実世界で起こりうる全ての状況を実写で撮影するのは不可能だ。しかしCosmosを使うことで、例えば1つの運転風景映像から「晴れの日」、「雨の日」、「夜」、「雪景色」といったバリエーションを瞬時に大量に生成できる。いわゆるデータ拡張(水増し)ができるのだ。

なおCosmosでの映像生成には高性能GPUが必要である。「NVIDIA H100」を使っても5秒の映像生成に1枚で5~10分程度かかるという。今後「NVIDIA Blackwell」のような新しいGPUを並列で使うことで高速化は可能だと考えられている。NVIDIA自体もCosmosを開発するためにH100 GPUを1万台、2,000時間かけて学習させたという。モデル自体はオープンソース、無料で提供している。ただしその動作のためにはNVIDIAのハイエンドGPUが必要となる。フィジカルAI開発が活発になればなるほどNVIDIAのGPUが必要になるというわけだ。このフルスタックのエコシステム戦略が、NVIDIAの強さの源泉だ。

世界基盤モデル「Cosmos」とは

「Blackwell」が拓くAI開発の新境地

これらの計算ニーズに応えるNVIDIAの最新GPUアーキテクチャがBlackwellである。「NVIDIA RTX 6000 Ada」の後継となる「NVIDIA RTX PRO 6000 Blackwellシリーズ」は、AI開発のボトルネックを解消するという。フィジカルAIや生成AIのパイプラインを前提に設計されており、VRAMはAda世代の48GBから倍増し、96GBとなった。これによりCosmosのような巨大なAIモデルをロードする際のメモリ不足や、データのオフロード/リロードによる速度低下を解消できる。「80GB程度のVRAMがあれば、Cosmosの関連モデルを一度にロードでき、快適に動作します」(加瀬氏)。

また第5世代Tensorコアでは、FP4(4ビット浮動小数点)精度のサポートが追加された。FP16比で約10倍のスループットを実現することで推論性能が飛躍的に向上し、画像や動画の生成時間の短縮が期待される。PCIe Gen5対応によるI/O帯域の向上、最大4枚構成による512GB超のGPUメモリ環境などの恩恵も大きい。

なお4枚構成の場合、総額は500万~600万円程度となる。Blackwellは、これまでデータセンター級の設備でしか不可能だった大規模なロボットやAIの開発を、ワークステーションレベルでも実現可能にする。高価な投資ではあるが、これまで何人ものチームが何週間もかけて行なっていたデータ生成作業をAIが代替できると考えれば「比較にならないほどリーズナブルだ」と中嶋氏は自信を見せる。RTX PRO 6000 Blackwellシリーズは、2025年8月から出荷開始されており、納期を待たずに注文可能とのことだ。

NVIDIA RTX PRO 6000 Blackwellシリーズ

現実とのギャップを克服するために

フィジカルAI実現における大きな壁の1つが、シミュレーションと現実の間に存在する「シミュレーションと現実のギャップ(Sim-to-Real)」である。

NVIDIAは「映像的なギャップ」と「物理的な現象のギャップ」という2つの側面から改善に取り組んでいる。前者はCosmosの活用であり、後者は、物理エンジンのさらなる高度化だ。ロボットでよく用いられている「MuJoCo」のような物理エンジンの場合、剛体シミュレーションは得意だが、布やケーブル、砂のような不定形物や柔軟物を扱うことは苦手だった。そこでNVIDIAは、GPUアクセラレーションを前提とした物理ライブラリ「NVIDIA Warp」や、Warpを基盤としてGoogle DeepMindやディズニー・リサーチと共同開発中の次世代物理エンジン「Newton」を通じて、柔軟物シミュレーションに取り組んでいる。開発途上だが、衣類を畳んだり、ケーブルを扱うなど、現実に近いタスクのシミュレーションが可能になろうとしているという。

3DCGデザイナーは、AI時代にも不可欠

生成AIの登場によりテクスチャリングやライティングといった一部の作業は自動化が進むだろう。しかし一方で、専門的なスキルを持つCG人材の価値は確実に高まっているのだと中嶋氏は語る。「フィジカルAI開発では、戦略的なデータマネジメントが極めて重要です。どのようなデータを、どのように作成して、どのように管理するのが最も効率的に賢いAIを育てられるのか。データの管理やプロセスの最適化、OpenUSDフォーマットを含めたデータパイプライン全体を設計・管理できるテクニカルアーティストのような人材は、産業に関わる情報ビジネスでも引く手あまたです」。そして加瀬氏も「AIとビジュアル、両方の知識を持つ人材は様々な分野で活躍できます。短期間でサクッとツールをつくって現場の課題を解決するような動きが、これから増えていくはず」と語ってくれた。

3DCGデザイナーにとってフィジカルAIは、自らのスキルセットを再定義しフィールドを大きく広げる絶好の機会だ。「これまでエンターテインメントや映像制作で培ってきたスキルが産業分野で求められる時代が来ています。デジタルツインという新しい活躍の場に、ぜひ挑戦してください」(中嶋氏)。

お問い合わせ

エヌビディア合同会社

www.nvidia.com/ja-jp/contact

TEXT_森山和道

EDIT_NUMAKURA Arihito、池永 都 / Miyako Ikenaga

PHOTO_弘田 充 / Mitsuru Hirota