『ULTRAMAN』『攻殻機動隊 SAC_2045』『Blade Runner: Black Lotus』など、注目作を次々と送り出してきたCGプロダクション SOLA DIGITAL ARTS。2010年の設立以来、日本のCGアニメーションの先端を走ってきた彼らが、AIスタートアップ企業ラブマシーンと共に生成AIを長編アニメ制作に導入する手法とその成果について講演を行った。実際の長編アニメ制作を想定し、『ULTRAMAN』の素材を使用してAIの導入を検証。その結果、ワークフローにどのような影響があったのかが明らかになった。

本記事では、AIをどのように長編アニメ制作に取り入れたのか、そしてその成果について詳しく紹介する。

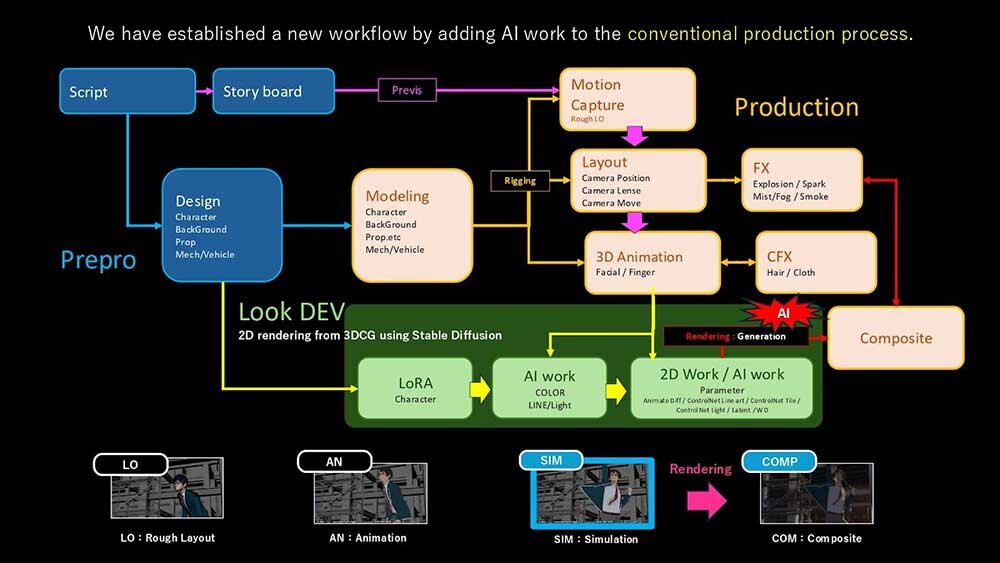

CFX工程以降のルックデヴ、レンダリング工程にAIを導入

――まずは、自己紹介をお願いします。

荒牧伸志(以下、荒牧):SOLA DIGITAL ARTSの荒牧伸志と申します。今回のプロジェクトで素材を使用した『ULTRAMAN』では神山健治さんと共に監督を務めました。

笹倉逸郎(以下、笹倉):SOLA DIGITAL ARTS CTOの笹倉と申します。

齋藤雄一(以下、齋藤):ラブマシーン代表の齋藤です。

高安優多(以下、高安):ラブマシーンの高安です。

――既存の長編アニメ制作のワークフローにAIをどのように導入したのでしょうか?

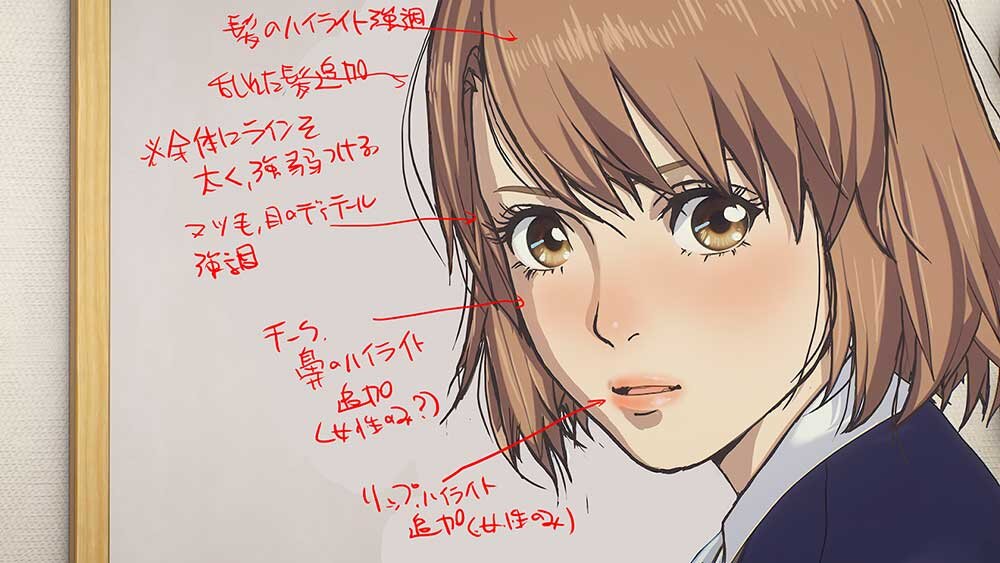

笹倉:CFX以降のレンダリング工程にAIを導入しました。荒牧監督が理想とするタッチの絵をAIに学習させ、そのスタイルをCFX工程まで処理した映像に適用する形で活用しました。

――具体的にどのようなプロセスを経てAIを活用するのでしょうか?

高安:基本的に、CFXの段階までは従来のワークフローを踏襲し、その後AIを活用する流れになっています。まず監督が目指すスタイルの参考画像を用意し、それを LoRA(Low-Rank Adaptation) という技術を使ってAIにファインチューニングします。

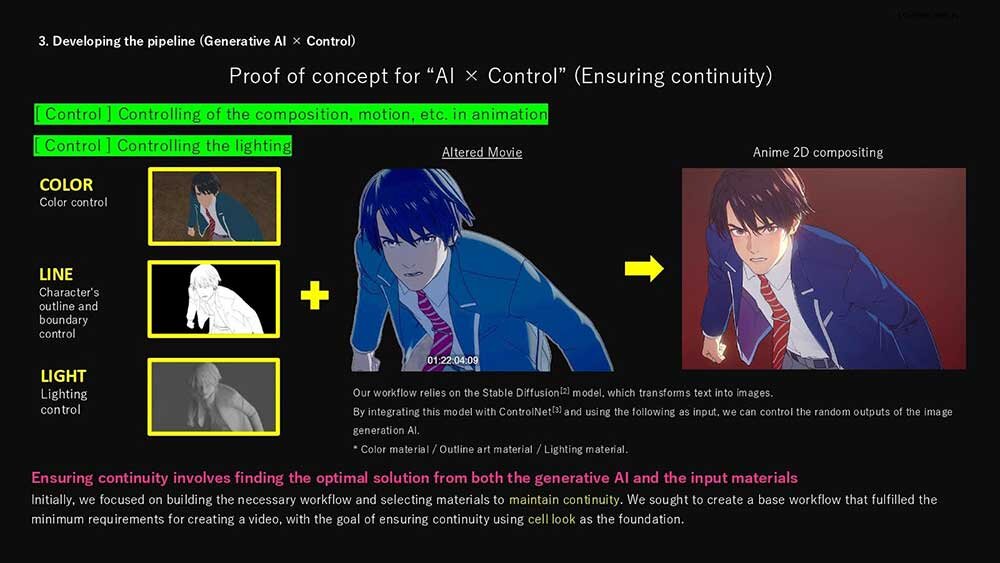

高安:次に、映像から映像を生成する工程へと進みます。色情報を持つ映像、線画の映像、ライティング情報を示すグレースケールの映像の3つのマルチモーダル入力を組み合わせ、AIが最終的な映像を生成します。

高安:さらに、ControlNetを活用して、生成される画像の一貫性を確保しました。具体的には、制御用の色情報や輪郭情報、ライティング情報をAIに与えることで、安定した連番画像を生成し、それらをつなぎ合わせて映像として完成させています。

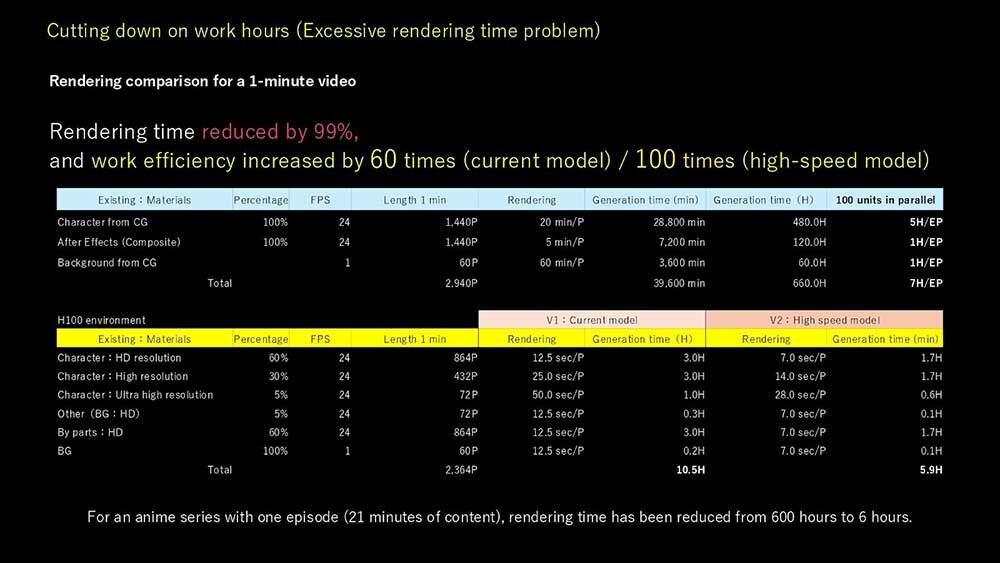

レンダリング効率は60倍

――そうしたAIによる出力作業にかかる時間はどれくらいのものなのでしょうか?

齋藤:通常のレンダリングに比べて遥かに速いですよ。理論的には60倍くらい速いです。レンダリングなら1フレームで1時間くらいかかっていたのが、1ショットが数時間で終わるようになったと思います。

荒牧:パラメーターの調整作業も数時間あれば終わりますし、一度パラメーターを固めてしまえば結構な数のショットがそれで処理できてしまうんですよ。

笹倉:それだけ速いので、もっと良いルックが見つかった際には全部やり直しすることだってできるし、それも朝やれば夕方には全部出来上がるくらいの速度でできてしまう。一週間あるだけでも相当なブラッシュアップができるんですよね。

――となると、AIの導入により試行錯誤の回数が増やせる、と考えればよいでしょうか。

笹倉:そうですね。パラメーターを調節することで違うルックの映像を1/60の時間で制作することが可能になったということです。

ただ、CGによるレンダリングとはまるで仕組みが違うので、AIによる生成をやったことがない人にとってはイメージの足掛かりがない分、初めは時間がかかるかもしれません。

齋藤:AIの扱うパラメータの感覚を掴みつつ、AIの認識や出力をコントロールをしていくという、これまでに存在しなかった仕事が求められるんだと思います。

荒牧:AIが進歩するたびにやり方が変わってしまうところもありますしね。CG制作ツールでも特定のバージョンでないと同じ結果が出ないようなことはよくありますが、AI生成はそういった変化が特に激しいので。

目指すは「Beyond Quality」

――なぜAIをCFX以降のレンダリング工程で導入したのですか?

荒牧:CGは非常に正確な表現ができる一方で、手描きのアニメーションに比べると表現の自由度が低く、自然な表現が難しいという課題があります。そこで、ラブマシーンさんと協力し、この問題をAIで解決できないかという試みを始めました。

特に、AIは「勝手につくる」ことが得意ですが、アニメ制作においては「お手本通りにつくる」ことが求められます。そのため、AIのランダム性を制御しつつ、レイアウト、アニメーション、CFXまでは従来のCGのつくり方を踏襲することで、演出は従来のまま一貫した品質を保てるかどうかを検討しました。結果として、AIをレンダリング工程に組み込むことで、人間の制作した映像のベースを活かしながら、キャラクター表現の拡張が可能になると考えました。

高安:また、AIをワークフローに組み込む際に、2Dアニメと3Dアニメでは「その時点で作品としてどこまで出来上がっているのか」というラインが異なります。2Dでは原画に対して人間が個々の判断で動きをつけていくのに対し、3Dではある程度動きの指針が提示された状態で作業が進みます。そのため、当時の技術水準では、3Dアニメのレンダリング工程にAIを導入する方が着手しやすいという判断になりました。

単に省力化やコストダウンを目的にするのではなく、AIをクオリティアップのために活用できないかという視点で進めました。AIのできることをレイヤーごとに分け、「スタイル変換は可能か」「キャラクターを静止画から動かせるか」といった点を1つずつ検証しながら開発を進めました。その結果、レンダリング工程にAIを組み込むことで、一貫したルックを保ちつつ、表現の幅を広げることができると判断しました。

実験的な試みではありましたが、最終的な目標としては、従来のワークフローにAIを組み込んだ新しい制作フローを確立することでした。特に長編アニメや配信シリーズなど、大量のカットを効率よく処理しつつクオリティを維持するために、レンダリング工程でのAI活用が最適だと結論付けました。

ハイエンドGPUへの投資、クラウドの活用が必要

――ここまでワークフローの話を伺ってきましたが、機材スペックや環境の方はどうでしょう? 生成AIといえば、ハイスペックなGPUを必要とするイメージの方も多いと思いますが……。

高安:そこはやっぱり、必要になってきますね。圧倒的にGPU依存の技術なので、GPU性能とVRAMの量で勝負が決まってしまうんですよ。A100やH100のようなサーバー向けのハイエンドGPUを使わないといけないんですが、これが本当に高くて、買うと1,000〜2,000万円とかしてしまう。

齋藤:いまはレンタルサーバーで、クラウドにあるGPUを持ったインスタンスでレンダリングしていますが、世界的にGPUが不足しているのもあり、環境を獲得するのがボトムネックになってくることはあるんじゃないかとは思います。かといって、こんなものをローカルに置いていたら電気代だけでも洒落にならないんですけども。

高安:内部的な簡単なテストならなんとかなるのですが、超解像度が使えなかったり、条件にやや制約が出てくるんですよね。

笹倉:なので、テストはローカル環境でやり、本番だけはクラウドで回すといったことはありかもしれませんね。

2年後にテレビシリーズでの導入を展望

――講演にて「今後2年以内にAIを活用したワークフローで新しい作品をつくりたい」というお話がありましたが、今後の展望を聞かせてください。

荒牧:可能性が高いのはテレビシリーズかなと思います。全12、13話ぐらいの1クールを、AIを活用したワークフローの方式でやってみる、というのが一番あり得るんじゃないかと。仕上げのルックの調整を、とんでもないスピードで何回も試行錯誤してチェックできるというのはやってみて面白いとも思いましたね。この部分がこれだけできるのであれば、アニメーションシリーズを作る際のクオリティの統一は格段にやりやすくなるかもしれないと期待しています。

斎藤:逆に、監督が画の判断を求められる回数が増えるという話でもありますが(笑)。

荒牧:たしかに(笑)。選択肢が増える分、ディレクションの精度を問われる場合が増えそうです。人間とAIの融合によって「Beyond quolity」を実現できるよう引き続き検証、制作に邁進したいですね。

――ありがとうございました。

TEXT_稲庭淳

INTERVIEW&EDIT_中川裕介(CGWORLD)