国立陽明交通大学(台湾)、イリノイ大学アーバナ・シャンペーン校(UIUC)、サラゴサ大学、カリフォルニア大学マーセド校(UC Merced)からなる研究チームは10月20日(月)、オープンソース(Apache-2.0ライセンス)の大規模3D都市モデル生成技術「Skyfall-GS: Synthesizing Immersive 3D Urban Scenes from Satellite Imagery」を発表した。GitHubではコードが公開されているほか、データセットや3DGSのPLYファイルも公開されている。

Skyfall-GSは、衛星写真から3DGSで3Dモデルを構築し、拡散モデルによって建物の側面や地上レベルのディテールなどの不可視部分を「修復」する。この修復(デノイズ)工程では、1つの視点に対して複数の異なる修復サンプルを生成し、3DGSの最適化プロセスにおいて複数サンプル間のコンセンサスを見つけるよう調整。これにより、ジオメトリ一貫性のある3D形状の復元が可能となる。Skyfall-GSでは、このプロセスを高い高度から地上レベルへと降下(Skyfall)しながら反復的に行う(カリキュラム学習)ことで、地上レベルのディテールは反復ごとに洗練される。

Ever noticed satellites images don't shoot straight down? They capture at angles, revealing building sides.

— Jie-Ying Lee 李杰穎 @ ICCV 2025 (@jayinnn) October 20, 2025

With satellites constantly imaging Earth, we asked: Can we reconstruct high-quality 3D cities from these images alone?

That's exactly what Skyfall-GS does!

2/5 pic.twitter.com/kiNkUiVzct

衛星画像が真下(nadir)だけを撮影しているわけではないことに気づいていましたか? 衛星は角度をつけて撮影することもあり、それによって建物の側面も捉えているのです。地球は衛星によって常時撮影されています。そこで私たちは考えました。「これらの(角度のついた)衛星画像だけを使って、高品質な3D都市を再構築できないだろうか?」それをまさに実現するのがSkyfall-GSです!

Key Contributions:

— Jie-Ying Lee 李杰穎 @ ICCV 2025 (@jayinnn) October 20, 2025

First satellite-only approach for immersive 3D urban scene synthesis

Leverages pretrained diffusion models - NO domain-specific training or 3D data needed

Curriculum learning strategy that progressively refines from high→low viewpoints

3/5 pic.twitter.com/gcfuwnCJIl

主なコントリビューション:

1)没入型3D都市シーンを合成するための、初の「衛星オンリー」のアプローチ

2)事前学習済みの拡散モデル(Diffusion Model)を活用 — 分野特化の追加学習や3Dデータは一切不要

3)高高度から低高度の視点へと、段階的に詳細化していくカリキュラム学習戦略

Why this matters:

— Jie-Ying Lee 李杰穎 @ ICCV 2025 (@jayinnn) October 20, 2025

Skyfall-GS enables SCALABLE 3D city generation with applications in:

- AR/VR experiences

- Autonomous driving simulation

- Robotics training

- Virtual entertainment

Real-time rendering makes it practical for deployment!

4/5

この技術の意義:Skyfall-GSはスケーラブルな3D都市生成を可能にし、以下のような分野に応用できます。

・AR/VR体験

・自動運転シミュレーション

・ロボティクストレーニング

・バーチャルエンターテイメント

リアルタイムレンダリングに対応しているため、実用的なデプロイが可能です!

■Skyfall-GS: Synthesizing Immersive 3D Urban Scenes from Satellite Imagery(プロジェクトページ、英語)

https://skyfall-gs.jayinnn.dev/

■Skyfall-GS: Synthesizing Immersive 3D Urban Scenes from Satellite Imagery(GitHub)

https://github.com/jayin92/skyfall-gs

CGWORLD関連情報

●Blenderで3DGSがレンダリングできるオープンソースのアドオン「3DGS Render Blender Addon by KIRI Engine」v4.0リリース! ビューポートのリアルタイムレンダリングを活用しながら編集が可能に

KIRI InnovationがBlender内で3D Gaussian Splatting(3DGS)データを扱える無料アドオン「3DGS Render 4.0」をSuperhiveとGitHub(オープンソース:Apache-2.0ライセンス)でリリース。EditモードとRenderモードからなる新しいワークフローが導入され、リアルタイムレンダリングを活用しながら3DGSデータの編集が可能になった。

https://cgworld.jp/flashnews/01-202510-3DGS-Blender-KIRI-v4.html

●NVIDIAが3DGS技術「LongSplat」発表! スマホで撮影したカジュアルな動画から空間の3DGSモデルを生成し、自由な視点の映像をつくり出す

国立陽明交通大学とNVIDIAの研究チームが、スマートフォンなどで気軽に撮影した長尺かつ複雑な動きを含む動画から3D Gaussian Splattingモデルを生成し、新しい視点の画像を生成するフレームワーク「LongSplat」を発表。GitHubではNVIDIAライセンスでコードが公開されている。

https://cgworld.jp/flashnews/01-202509-LongSplat.html

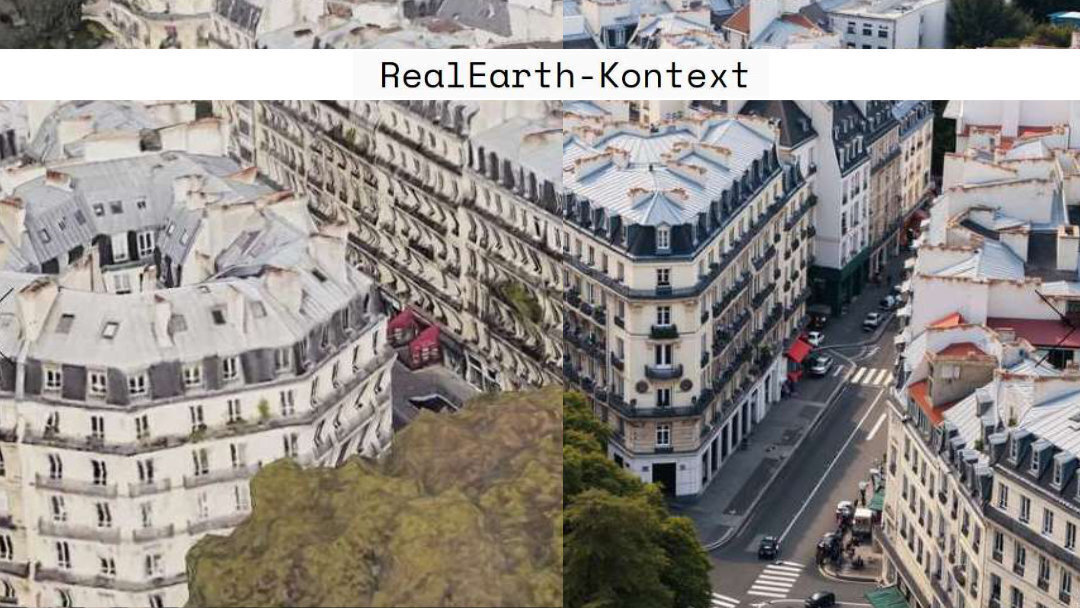

●低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換! Ismail Seleit氏がFLUX Kontext LoRAのトレーニングで実現、無料ダウンロード可能

Ismail Seleit氏が自身のLinkedInで「RealEarth-Kontext LoRA」のリリースを発表。低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換できる無料のモデルで、同氏が運営する建築デザイン向け画像生成AIワークフロー支援サイト「form-finder」からダウンロードできる。

https://cgworld.jp/flashnews/01-202507-RealEarth-Kontext.html