「NVIDIA Omniverse」へようこそ! 場所やツールを超え協業できる仮想プラットフォームの基本を解説

メタバースをはじめとした先端のリアルタイム3Dグラフィックス開発現場では、扱うデータや制作体制の高度化・多様化・大規模化が余儀なくされている。それに対してNVIDIAが提示するソリューションが、場所やツールを問わずに複数人で協業できる仮想プラットフォーム「Omniverse」だ。ここでは、新技術の導入に積極的でOmniverseに興味のあるオーソリティを招き、NVIDIAによるOmniverseがどういったサービスなのかというガイダンスをベースに、現状の課題解決や将来的な活用方法について話してもらった。

使い慣れたDCCツール同士でコラボレーション可能な「Omniverse」の魅力

CGW:本日はよろしくお願いいたします。参加者の皆様のプロフィールを教えてください。

田中:NVIDIAでOmniverseのマーケティングを担当しております、田中秀明と申します。今日はビジネス開発の高橋想 と、Developer Relationの梅澤孝司の3名で、「Omniverse」についてご説明いたします。よろしくお願いいたします。

吉阪:フリーランスで3DCG開発を行なっている吉阪 豊です。20年ほどCGツールの開発に関わっており、Omniverseはオープンベータ版を触っております。非常にツールとして興味深いと感じておりますので、本日は実際に使ってみた感想などもお伝えできたらと思っています。

吉阪 豊氏

(フリーランス ツール開発者)

岸本:Aww 取締役の岸本浩一です。当社はバーチャルヒューマンのプロデュース会社として2019年にスタートしました。全てのSNSを合わせると100万人以上のフォロワーがいる「imma」というキャラクターの制作・プロデュースを行うほか、様々なグローバル企業とコラボレーションさせていただいています。静止画だけでなく、Unreal Engine 4(以下、UE4)などを用いてリアルタイムで動くようなしくみを開発しており、メタバース時代においてVRを含めたバーチャルワールドで活動の幅を広げていくつもりです。Omniverseにはキャラクター作成が可能なツールが搭載されていると聞いており、そちらに興味があります。

Aww 岸本浩一氏

(取締役)

横原:KhakiのCGディレクター・ゼネラリストの横原大和です。当社はゼネラリスト集団を謳っておりますが、世界観構築や背景制作などを得意としております。個人的にもOmniverseには興味がありまして、発表当時から動向を追っていました。ただ、規模が大きく、機能も多いために全容がまだ見えていない状況で、どこまでできて、今後なにができるのかのイメージを掴めていませんでした。音声データによるフェイシャルアニメーション生成機能Audio2FaceやOmniverse Createなど各機能は優れていると感じておりましたので、今日は全体的なながれやビジョンがお伺いできたらと思っています。

Khaki 横原大和氏

(Co-Founder | CG Director / Art Director)

若杉:CGアニメーター、レイアウトアーティストの若杉 遼です。映画の制作に関わることが多く、日常的に大規模開発に触れていることからOmniverseには非常に興味があります。映画制作におけるレイアウトの仕事は物量が非常に多く、プリビズにも関わるため「なるべく早く、最終的な画づくりを行う」ということが求められます。普段はMayaをメインにして制作を進めていますが、リアルタイムで最終的な画づくりに近い表現ができるのであれば、社内でも運用が考えられるかもしれません。そのあたりの実用性について特に興味があります。

Sony Pictures Imageworks/CGWORLD

若杉 遼 (CGアニメーター/編集長)

田中:ではまず、Omniverse の概要をご説明します。Omniverseは仮想コラボレーションとリアルタイムシミュレーションのために開発されたオープンプラットフォームです。従来はデザイナー同士で協業を行う際、データを適切な形式でエクスポートして、それをインポートして作業を継続するといった橋渡しが必要でした。一方、Omniverseは「ひとつのデータに対し、異なるアプリケーションからコネクトする」というのがコンセプトにあります。つまり、同期されたデータを同時に編集できるというのが基本的な考え方になります。

田中:3Dアプリケーションの種類は増えていますし、ツール同士の連携も必須です。最近では離れた地域やグローバルでの協業・コラボレーション需要も増えています。実は、OmniverseはもともとNVIDIAが社内で使うためのツールだったんですね。アメリカのシリコンバレーと、イギリスやインドなどの開発拠点を同時につなぎたい……という思いが始まりで、2017年に発表した「Holodeck」から徐々に進化して、今年の1月5日に行われたCES 2022では、個人向けの無償版Omniverseもリリースしました。

岸本:国を越えてコラボレーションを行えるというコンセプトはすごく良いですね。当社ではグローバルな企業と協業する必要が増えてきておりますし、人材面においてもバーチャルヒューマンは高度な3DCG技術が求められるため、なかなか国内だけでは難しいのも現状です。いろいろな選択肢が広がる感覚はあります。

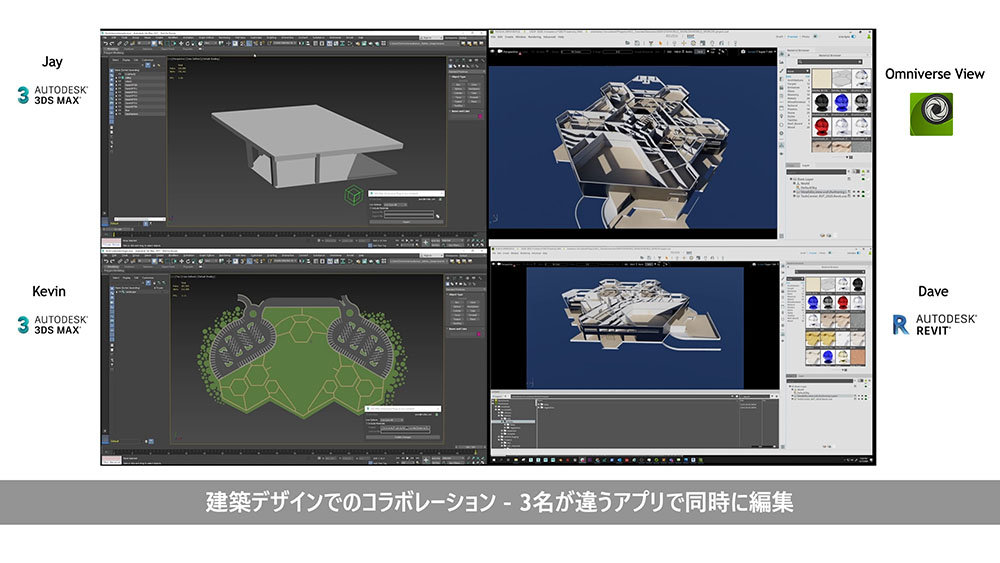

田中:そうですね。例えば、建築業界の事例では、3ds Max作業者2名とRevit作業者1名が、同じプロジェクトを同時に操作しています。1名はライティングを操作して、1名は天蓋を作って、もう1名は内装をエディットしています。これらは全て同期されていて、Omniverse Viewアプリを介してリアルタイムにプレビューができています。つまり、最終形をリアルタイムでプレビューしながら、それぞれMayaや3ds Maxなどの使い慣れたツールを使って作業ができています。

横原:面白いですね。Omniverseで使用可能なDCCツールに制限はありますか? 私はCinema 4Dを使うのですが、対応しているかが気になります。

田中:そのお答えをするために、まずOmniverseのしくみを説明します。キーワードは「USD: ピクサーが開発した3Dシーン記述フォーマット Universal Scene Description」というファイルフォーマットと、「Nucleus(ニュークリアス)」というサーバです。USDはピクサーが開発した、DCCツール間でシーンをやり取りするためのフォーマットです。非破壊編集による共同作業を行うための共通フォーマットのような認識で、現在は主要なDCCツールからUSDエクスポートが可能なほか、各種ゲームエンジンでもそのままインポート可能になっています。このファイルのハブとなるのが、「Nucleus」です。

CGW:USDフォーマットについては徐々に浸透しつつあるかと思いますが、皆様はすでにお使いになったことはありますか?

岸本:私はまだないですが、USD自体は話題には上がりますね。現状では、活用に至っている国内スタジオは少ないとは思います。

横原:MayaやHoudiniでもエクスポートが可能なことは把握していますが、実務でワークフローに組み込んだことはないですね。気軽に使えるものではないという認識なので、普通にFBXやAlembicで書き出すことが多いです。

梅澤:その意味では、Omniverseは「USDの良いところだけ」、つまりコラボレーションツールとしてわかりやすく恩恵を享受できるような設計になっていると思います。

横原:単にコラボレーションツールとして使うだけなら、例えばMayaと3ds Maxでレイアウトを調整し合うなどの作業は、Omniverse固有の専門的な知識がなくても可能という認識でよいですか?

吉阪:その認識で間違いないです。USDについて補足すると、昨年11月に行われたNVIDIA GTC 基調講演では「USDとOmniverseは、HTMLとWebサイトのようなもの」というお話がありました。これは結構面白くて、USD自体は参照構造で、USDから他のUSDを参照することもできるし、入れ子状態でも問題ないんですね。その状態でリアルタイムにプレビューできる、というのはWebブラウザに近いと感じます。さらに、Webブラウザは閲覧専用ですが、NucleusのおかげでOmniverseは読み書きができる。これが良いところです。

CGW:FBX形式は一方通行ですが、USD形式であれば双方向で皆が扱えるということですね。これらの間を取り持つ「Nucleus」について、より詳しくお話を聞かせてください。

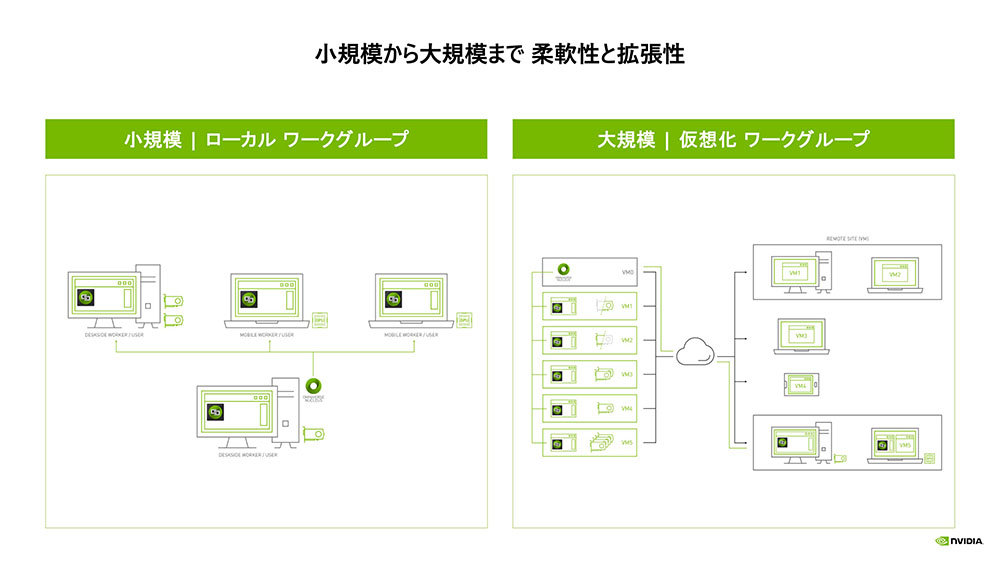

田中:ひと言で言えば「あらゆるファイルタイプのアセットを格納できるデータベースサーバ」です。Mayaや3ds MaxなどをNucleusに接続して、専用ストレージを介してUSD変換されたデータを相互にやり取りします。編集差分のみを送るため、速度的な心配もありません。先ほどの横原さんのご質問ですが、各DCCツールがNucleusにコネクトするためには、その名の通り「Omniverse Connector」を使います。

横原:つまり、専用のコネクタが用意されていれば、Omniverseで双方向エディットができるようになるということですね。

田中:はい。現在はMaya、3ds Max、UE4などに向けたコネクタを用意しています。Cinema 4Dは2021年12月現在でコネクタが用意されていませんが、USD対応をしているため、Cinema 4DからUSDを「Omniverse Drive」に書き出して使えば接続可能になります(※この場合、双方向ではなく一方向のみ)。コネクタはソフトウェアベンダーの協力のもと、NVIDIAで開発していますが、Bentley社のiTwinのように、将来的には他ベンダーからの提供もあるでしょう。

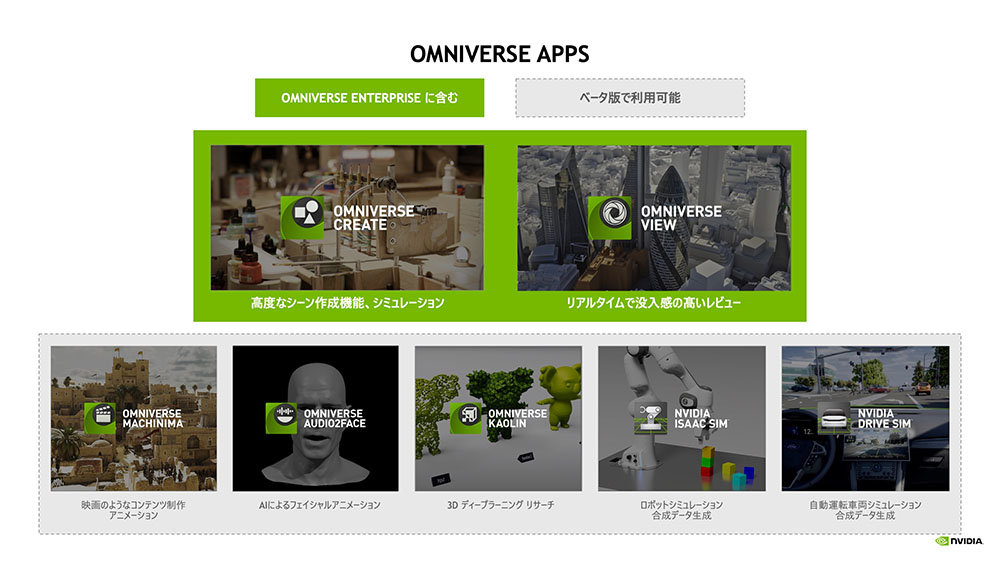

CGW:そして、各自が作業した内容は、Nucleusの先にある「Omniverse Create」「Omniverse View」で確認できるというながれですね。

田中:はい。GPU機能と、最新のAI機能を組み合わせたリアルタイムレンダリングが可能であり、その結果をどこででも、例えばディスプレイでもAR/VRでも、タブレットでも、ストリーミングによるプレビューを行えます。すでに自動車業界や一部のゲーム会社では導入が始まっており、OmniverseとNucleusを中核にしたワークフローが実用化しています。

実際に触ってわかった「Omniverse」の面白さとワークフローへの恩恵

CGW:Omniverseの概要がわかってきたところで、「実際にOmniverseでシーンをつくってみた」という吉阪さんからお話を伺いたいと思います。

吉阪:Omniverse内部でシーン構築が可能になる「Omniverse Create」を使用してレトロな風景を制作する「Retroverse コンテスト」に参加しました。自分たちがゲームに熱狂していた頃の部屋をつくってね、というコンセプトで、私もファミコン少年だった当時を思い出しながら和室の風景を制作しました。

横原:これは、DCCツールで制作したアセットをOmniverse Create上で配置したという理解で合っていますか? シーン構築は全てOmniverseということですよね?

吉阪:その通りです。ファミコンや畳などをDCCツールで制作し、それをOmniverse内で並べています。Omniverse Createではパフォーマンスを重視した「Real-Time」、ガラスや屈折などを綺麗に再現する「Path-Traced」、オフラインモードのみ使用可能な「Iray」の3種類のレンダリング方式が選べますが、今回は「Path-Traced」を選択しています。

若杉:Omniverse Createでは、「Path-Traced」モードでもリアルタイムレンダリングが可能なんでしょうか? 先ほどから、カメラを動かしたときも正常に描画できているような気がしています。

吉阪:パストレースの描画が完全に固まるまでは、このシーンだと4.11秒ほどかかっていますが、動かすこと自体は完全にリアルタイムですね。自由自在です。「Real-Time」モードでは、例えばライティングの反映だったり、麦茶のコップの透過表現などが上手く再現できなかったので。今回はNVIDIA RTX A4000 (6,144CUDAコア/192Tensorコア/48RTコ

若杉:リアルタイムレンダリングでシーン構築というと、真っ先にUE4が頭に浮かびます。コラボレーションツールとして独特なのはわかりますが、Omniverse Createで編集する利点はどういったところにあるのでしょうか?

梅澤:レンダリングのクオリティとコラボレーションツールとしての利便性は別々の特徴として挙げられると思います。Omniverseのレンダラはラスタライズの必要がないので、UE4では大きすぎてリアルタイムでの表示が難しい大容量のデータであっても、高速なレイトレース・パストレースのレンダリングが可能です。Mayaや3ds Maxから出力したアセットをUE4にインポートする手段もありますが、Omniverse の場合はUSDがハブの役割を果たすので、どこからでもDCCツールでの作業に戻れたりするわけです。また、出力先も任意に選択できます。

吉阪:コラボレーションツールとしては言わずもがなですが、画づくりの品質という意味ではNVIDIAのマテリアル定義言語 「MDL(Material Definition Language)」も紹介したいです。MDLはプログラム言語のようなものであり、ノードベースでマテリアルを設計可能なしくみで、幅広い表現を行うための規格となっています。Substance DesignerでもMDL用のノードを組むことが可能で、物理ベースのマテリアルや光源を、サポートするアプリケーション間で自由に共有できます。

CGW:USD標準のシェーダ言語ではなく、MDLを用いることでさらに高度な表現ができると。さらに、MDLマテリアルのライブラリを一度構築しておけば、ワークフロー内のどのアプリケーションに移動しても、同じ外観を保持できるということですね。

吉阪:また、MDLを使えば、例えばテレビ液晶の表現で「接近したときだけ細かいドットが見える」というような特殊な表現も可能です。出てくる画のクオリティは高いと思いますよ。ちなみに、iPadでAR表示を行うテストもしてみました。これらのシーンは800万ポリゴンほどで、本来ならiPadでの再現は不可能ですが、Omniverse Portalを使ってストリーミングすることでストレスなく確認することができています。

CGW:CG制作だけでなく、様々なDCCツールの開発を行なってきた吉阪さんから見て、Omniverseでコンテンツをつくる魅力はどこにありますか?

吉阪:開発者目線で見ると、「Omniverse KIT」を用いることでOmniverse内でアプリ開発ができることが嬉しいです。コネクタを使わなくてもOmniverseのマテリアルパラメータさえわかればUSD形式でコンテンツはすぐもってこれますし、拡張性の高さが開発者としての優れた点だと感じています。一方、くり返しにはなりますが、最も優れているのは「レンダリングコストなく高品位なルックをリアルタイムで確認できることと、慣れ親しんだDCCツールとコネクタ経由で連携できるところ」です。Omniverseを意識的に考えなかったとしても、単純にコネクタ経由でMaya同士をつなぐということ自体に価値が大きいと感じますね。

若杉:Omniverse Kitを使いこなすには、今のところはエンジニアが社内にいることが必須ですが、特別な開発技術がなくともコラボレーションツールとしては実用性十分だと。これは非常に面白いと思います。

横原:可能性を感じますね。このところは使用するツールも増え、当社のような小中規模のスタジオにおいても複数社と協業することが増えています。メインツールもMayaや3ds MaxやCinema 4Dなどたくさん選択肢がある上、UE4などのゲームエンジンまで実用化されていますよね。出力先やフォーマットも増えていますので、MDLなどマテリアルの統合を含めてしっかりと自動化されるといいなと思っています。小規模開発においてもデータベースサーバの必要性は感じているので、USD形式による運用を見据える必要があるとも感じています。Omniverseを取っかかりとして、これらの活用の道筋をしっかり考えていきたいですね。

田中:ある意味では、「USDの勉強のきっかけにOmniverseを使ってね」くらいでもよいわけですよね。USDを使ったコラボレーションというのが入り口としてはふさわしいと思います。無償版を触ってみて、USDのレイヤーやリファレンスなどの概念を押さえておくと。

横原:そうですね。周りから「これからはUSDだ!」と言われても、クリエイター自身がついていけるかというと、そこはまだわかりません。Omniverseを使っていろいろ試せることは、これからCGを学ぶ人にとっても嬉しいことなんじゃないかと思います。自分もかなり興味をもちましたね。

CGW:皆様から、Omniverseに望むことなどがあれば教えてください。

吉阪:私が作業していて思ったのは、リグシステムがまだOmniverse上にないことです。今はまだUSD形式に変換するときにアニメーションベイクをする必要があります。今後、リグ周りのアップデートもあるかと思いますので、そちらを楽しみにしています。

横原:Maya上でリグ付きでアニメーションを編集していて、それがそのままOmniverse Createにながれるわけではないんですね。USDの段階でベイクされるという。この部分がOmniverse Createで触れるようになったら、もっとできることが増えますね。

岸本:まずは今日、Omniverseの全貌が知れたのが良かったです。個人的にすごく期待するのは、AIを活用した機能の数々です。例えばAudio2Faceによるフェイシャルアニメーションや、動画ベースのモーションキャプチャをリアルタイムで適用する技術などが高次元で実用化できれば、それはすごくありがたいなと。バーチャルヒューマン領域は日々技術が進歩しているので、「自社で何をどこまで開発するか?」を取捨選択するシーンが増えてきました。自分たちがフォーカスする部分にだけ開発を集中でき、あとはOmniverseのプラットフォーム側の機能でTensorコアを用いて上手く自動化ができたら、それはすごくありがたいことです。

田中:皆さん、ありがとうございます。Omniverseは使う人によっていかようにでも対応できる柔軟性をもつからこそ、捉えどころのないものと思われがちです。とはいえ、一番大きい恩恵はOmniverseとNucleusを用いたデザインコラボレーションだと思いますので、まずは気軽に触っていただきたいです。今後の展望について、Speech AIを活用した会話インターフェイスやバーチャルプロダクションなどの実用事例をNVIDIAの日本語ブログに掲載していますので、興味のある方はぜひご確認ください。

CGW:本日はありがとうございました。

TEXT_神山大輝

EDIT_藤井紀明(CGWORLD)