2022年08月23日から25日にかけて、コンピュータエンターテインメントデベロッパーズカンファレンス2022(以下、CEDEC2022)が開催された。同イベントでは、コンピュータエンターテインメント開発に携わる人々を対象に行われ、業界トップランナーたちが登壇し、数々の取り組み事例が紹介された。今回はその中から、23日(火)に発表が行われた「『プロジェクトセカイ カラフルステージ! feat. 初音ミク』リアルタイム配信型バーチャルライブの開発事例」の内容をレポートする。

Information

「初音ミク Project DIVA」シリーズを手掛ける株式会社セガと株式会社Colorful PaletteによるiOS/Android向けリズム&アドベンチャーゲーム。3DCGによるMVが流れるリズムゲームや、全国のプレイヤーと一緒にリアルタイムにバーチャルライブを体感できる「コネクトライブ」を楽しむことができる。

pjsekai.sega.jp

© SEGA / © Colorful Palette Inc. / © Crypton Future Media, INC. www.piapro.net piapro All rights reserved.

360度ステージにあわせた演出を模索

スマートフォンゲーム『プロジェクトセカイ カラフルステージ! feat. 初音ミク』には、3Dキャラクターがステージ上でリアルタイムに動いて会話するバーチャルライブ機能、「コネクトライブ」が実装されている。

Colorful Paletteによるセッションでは、ゲーム内でこのリアルタイム配信型バーチャルライブ「コネクトライブ」を実現するための手法や技術、ユーザーにライブ感のある体験を提供するための工夫が紹介された。

登壇者は、株式会社Colorful Paletteのエンジニア山口智也氏、サウンドディレクターの磯田泰寛氏、アニメーターの藤本誠人氏。

まずはライブのコンセプトデザイン・演出制作について、藤本氏から説明がなされた。

藤本誠人氏/アニメーター

Live2D、バーチャルライブ演出制作などを手掛ける

ライブ演出に関するアセットの制作環境はUnity Timeline、制作チームは同社のアニメーション演出班4名の体制で進められた。

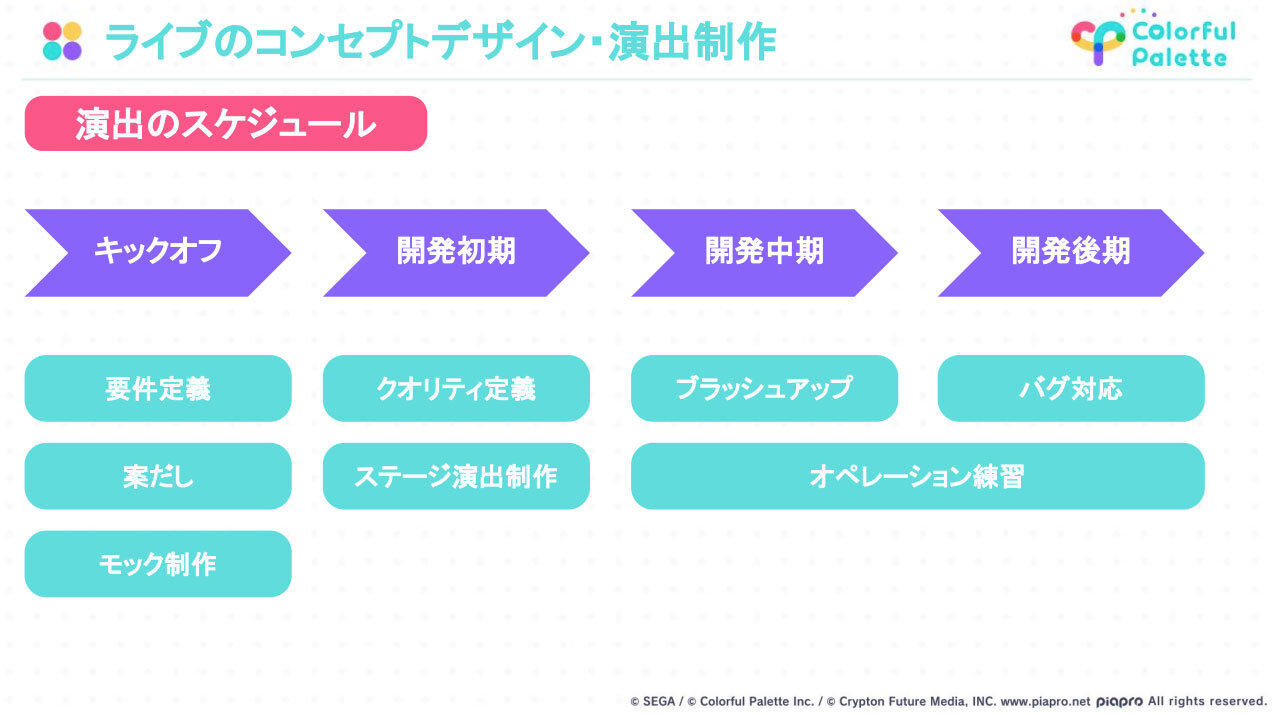

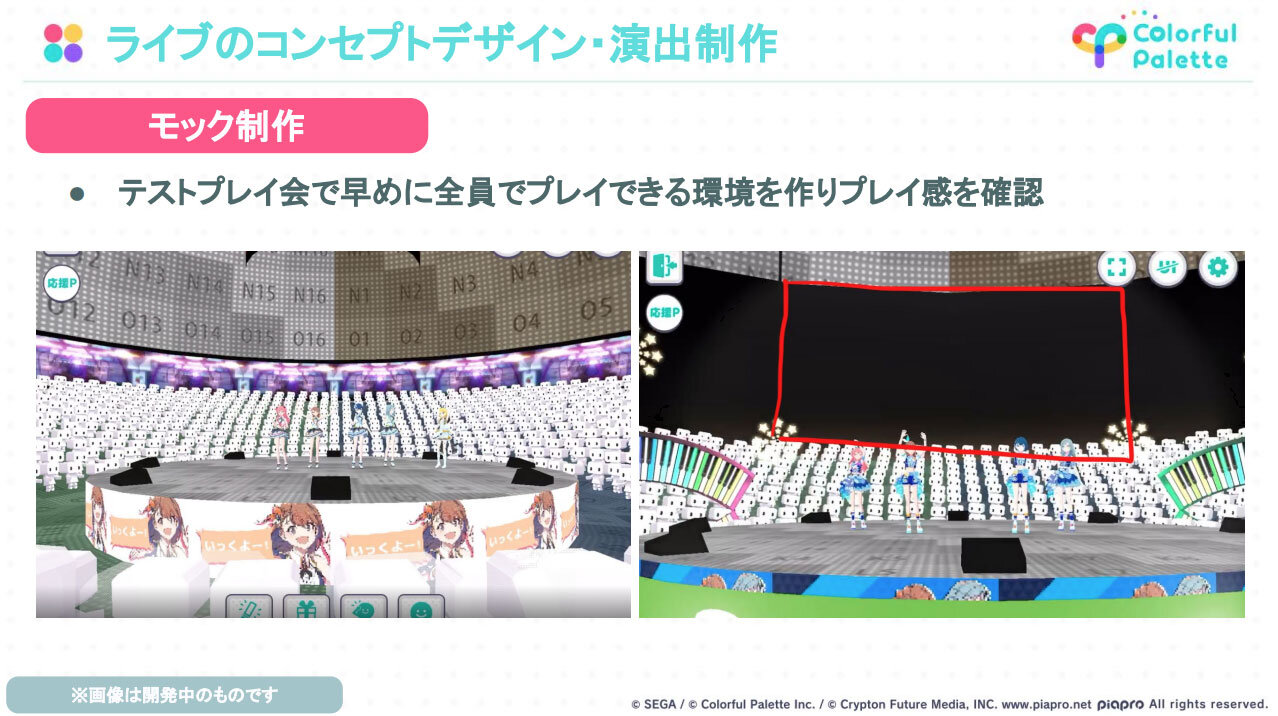

演出のスケジュールでは、キックオフ段階で要件定義や案出し、モック制作を行い、開発初期ではクオリティ定義やステージ演出の制作、そこからブラッシュアップなどをしながらオペレーション練習に取り掛かり、最後にはバグへの対応を行なった。

要件定義の段階では、ゲーム内でリアルタイムにライブ配信を行うこと、通常のバーチャルライブ機能と差別化すること、ユーザーが360度ステージで自由に動けることを決定した。

次に会場の見た目づくりに入ると、制作したステージをもとに、静止画の上に直接レタッチを行い、実際に演出をつけた際にどのような見た目になるかを確認する作業が行われた。

「楽曲のながれに応じて、ポイントを決めて見た目を描き起こしていきました。暗転時、通常時、間奏時、転調して会場全体がハレーションしたときなど、それぞれのシーンでどれだけ演出が盛られるかを静止画で定義することで、クオリティラインを定める作業となりました」(藤本氏)。

演出作業では、まずはじめにベンチマークを行うため、1曲分の演出を制作。クオリティラインがある程度定まった段階で、ベンチマークをもとに他の楽曲の制作に進んだ。

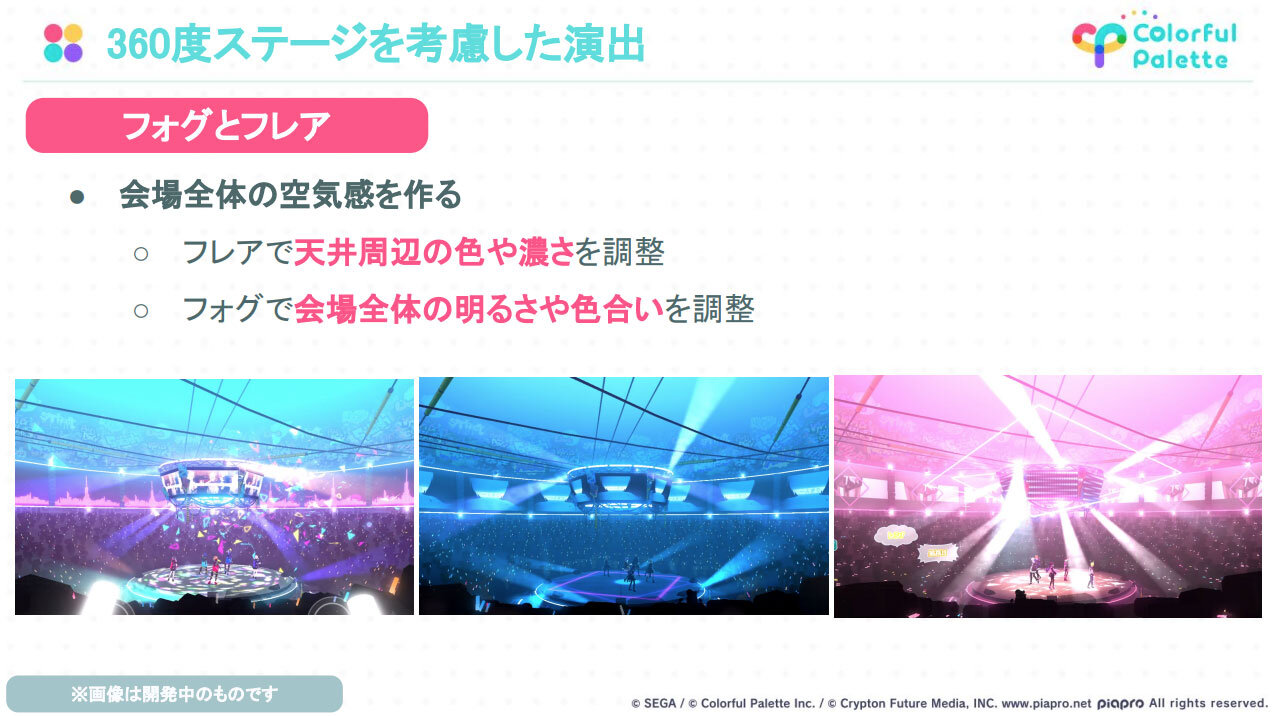

演出の調整では、ユーザーの位置による見え方のちがいや360度ステージを考慮した演出方法が模索された。

表情やリップシンクでアドリブにも対応、よりリアルなライブ演出へ

続いて、配信スタジオのオペレーションについて、磯田氏による解説が行われた。

磯田泰寛氏/サウンドディレクター

ゲーム内のサウンドのディレクション、ADX2を用いたサウンド演出、コネクトライブ進行監督など

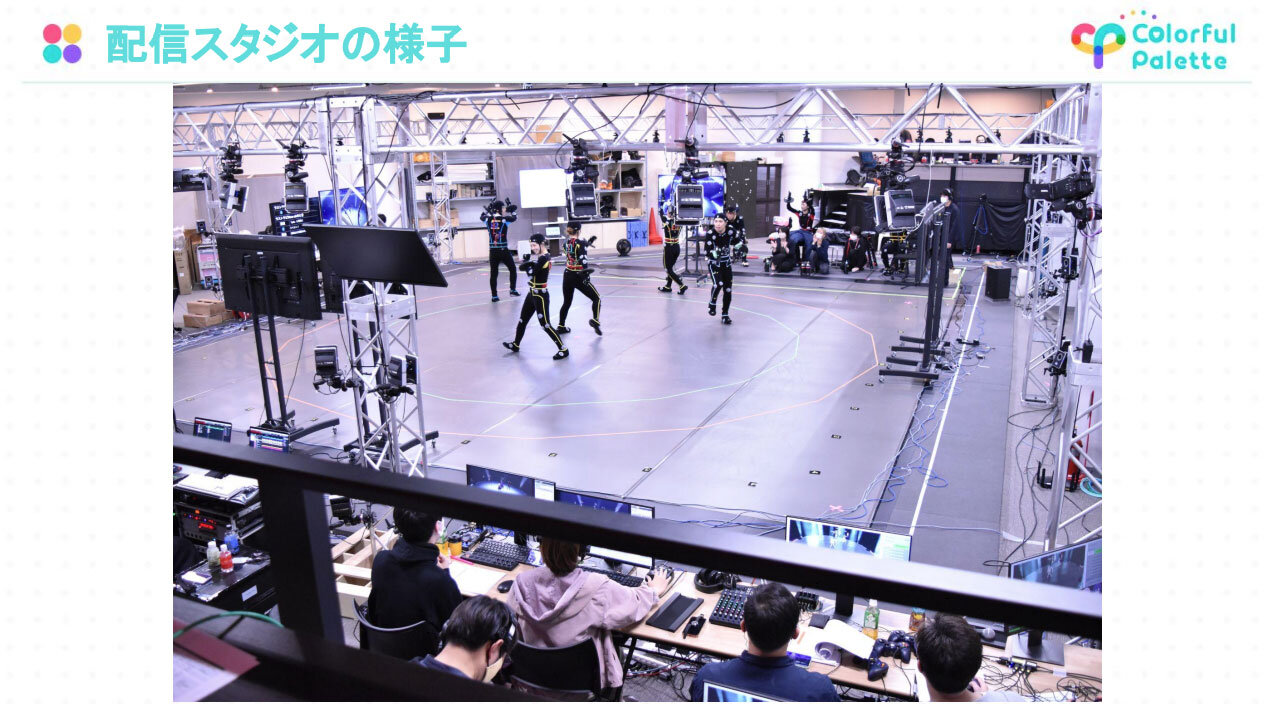

配信スタジオには、360度に対応した円形のスペースを用意。スタジオの四方に置かれたモニターには配信映像と台本が表示され、イヤモニでモーションアクターやキャストに動きを指示できる仕様となっている。

さらに、キャストにはアドリブを豊富に入れるよう指示していたため、キャラクターボイスのアドリブに合わせたモーションも用意された。

また、キャラクターの表情は、リアルタイムで操作を行なっている。キャラクターごとにコントローラーを使い表情操作を行い、キャラクター音声の入力により自動でリップシンクがされるため、自然な表情の変化が演出できる。

配信環境としては、LTC(Linear timecode)による楽曲のステージ演出全般、楽曲中の歓声などの制御。コントローラー操作によるキャラクターの表情の切り替え、会場照明の制御、MCパートの音響演出などがある。

「コネクトライブは、同じくプロジェクトセカイで配信しているバーチャルライブがよりリアル感のあるものとして進化したものです。そのリアル感を生み出しているものは、ひとえにアドリブです。講演ごとに異なるモーションがあり、アドリブなど自由度の高いキャラクターMCがあり、それらにあわせたキャラクター表情の微細な表現の変化があります。これらのアドリブの総合的な重ね合わせによって、まるでキャラクターたちが目の前でライブをしているようなリアル感のある演出をつくることができました」(磯田氏)。

独自の基盤を構築し、リアル感のあるライブを下支え

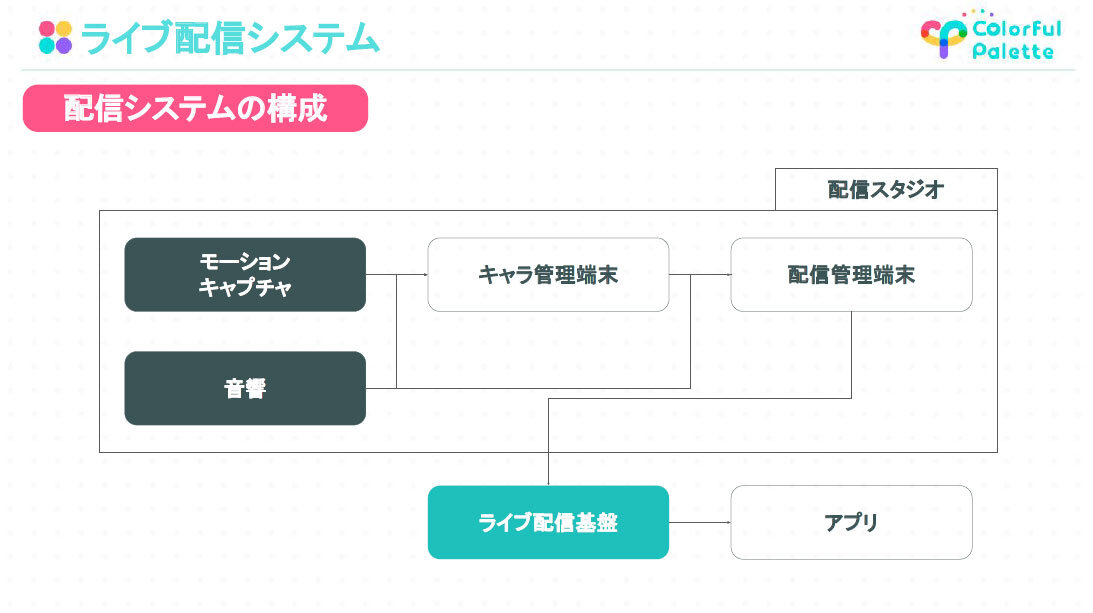

最後に、エンジニアの山口氏により、ライブ配信システムの全体構成について説明がなされた。

山口智也氏/エンジニア

3D描画、バーチャルライブ関連の実装など

今回のライブ配信システムでは、協力会社やスタジオと連携しながら、開発チームが専用のライブ配信・視聴システムを構築している。

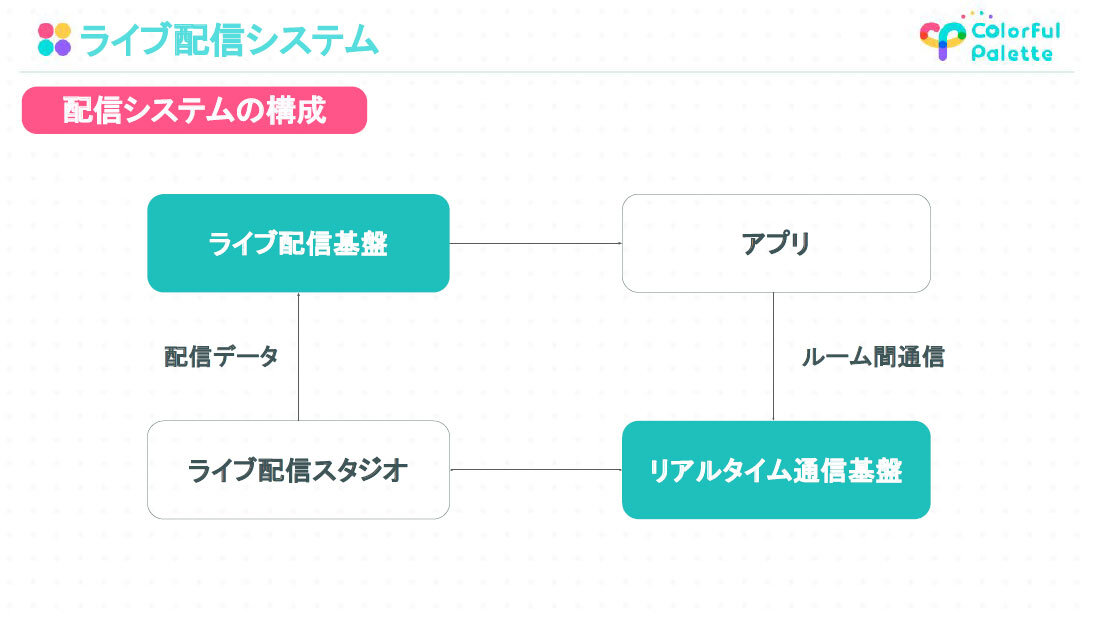

配信システムの構成は、サーバー上にあるライブ配信基盤とリアルタイム通信基盤の2つに基盤から成り立っており、それぞれで配信データ、ルーム間通信のやりとりを行う。

このライブ配信システムをより詳細に見ると、配信スタジオに構築されたモーションキャプチャシステムと音響システムをキャラ管理端末・配信管理端末に接続し、ライブ配信基盤を通してアプリにライブの情報がリアルタイムで配信されるようになっている。

キャラクターの管理端末は、モーションキャプチャと音響システムからキャラクターの表情、声の情報を個別に受け取っており、リアルタイムかつ自動のリップシンク、コントローラーを通した手動での表情の操作などを配信管理端末に送信している。

「ボイス、モーション、表情、音響のアドリブ演出には、データサイズなどを最適化した独自の配信基盤を開発する必要がありました。また、リアルタイム通信基盤によってユーザーのアクションにリアルタイムで反応できるバーチャルライブを実現させるなど、多くの工夫を行なっています。コネクトライブの開発チームは、今後もユーザーの皆さんに多くの感動と驚きを与えられるように、鋭意開発を進めていきます」(山口氏)。

『プロジェクトセカイ カラフルステージ! feat. 初音ミク』は現在も絶賛配信中であり、10月9日には「コネクトライブ 2nd ANNIVERSARY SPECIAL STAGE」が開催されたばかり。今後の展開にも期待が高まる。

TEXT_江連良介 / Ryosuke Edure

EDIT_海老原朱里 / Akari Ebihara(CGWORLD)、山田桃子 / Momoko Yamada