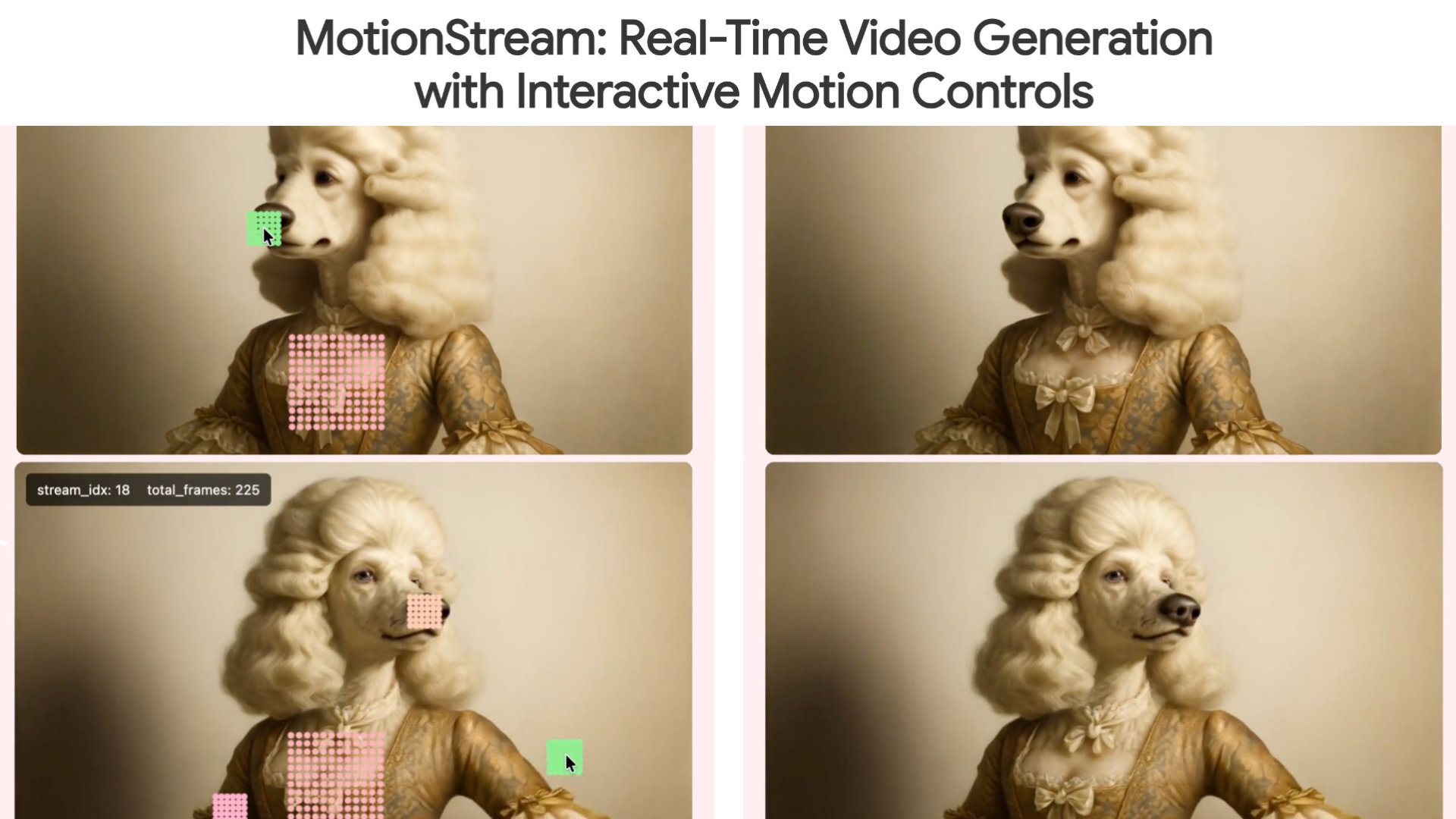

Adobe Research、カーネギーメロン大学(CMU)、ソウル大学校(SNU)の研究者らは11月5日(水)、リアルタイムかつインタラクティブな制御が可能な動画生成技術「MotionStream」を発表した。単一のNVIDIA H100 GPU上で最大29fpsの生成速度と0.4秒以下の低遅延を実現し、無限長のストリーミングを可能にしたという。執筆現在でGitHubリポジトリは存在するが、コードやモデルは公開されていない。

We present MotionStream — real-time, long-duration video generation that you can interactively control just by dragging your mouse.

— Xun Huang (@xxunhuang) November 4, 2025

All videos here are raw, real-time screen captures without any post-processing. Model runs on a single H100 at 29 FPS and 0.4s latency. pic.twitter.com/ghs1ar14f1

「MotionStream」はユーザーの操作に反応してリアルタイムに動画を生成し、ストリーミングする技術。従来、モーションの制御が可能な動画生成手法には2つの課題があった。ひとつは生成まで数分を要する遅延があること、ふたつめは動画を最後まで計算して完成させてからその内容を修正する非因果的(non-causal)処理であることから、リアルタイム生成が困難であるということだ。

It feels totally different when video models actually become real-time interactive. Drag the mouse, and the cup instantly moves with it, and the water follows. You’re not just watching a video anymore, you’re playing with it. pic.twitter.com/r85fRpMkol

— Xun Huang (@xxunhuang) November 4, 2025

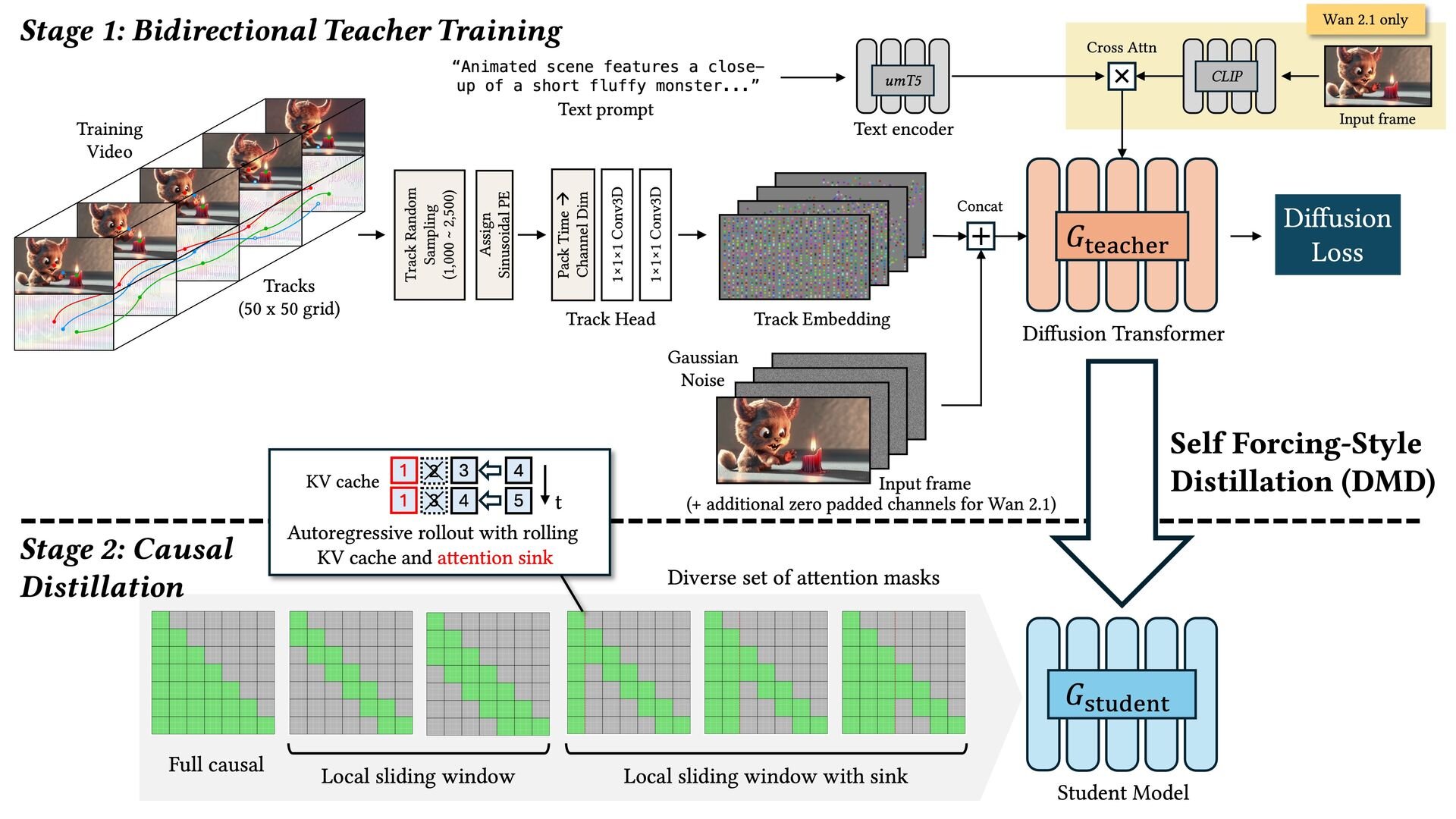

本技術は、MotionStreamは、まずひとつめの課題に対して、単一のNVIDIA H100 GPU上で最大29fpsの生成速度と0.4秒以下の低遅延を実現し、事実上、無限尺のストリーミング動画生成を可能にするという。そして、ふたつめの課題に対しては、高品質だが低速な「双方向教師モデル(Bidirectional Teacher)」から、高速な「因果的生徒モデルへの蒸留(Causal Student via Self-Forcing)」へ知識を蒸留するアプローチを採用することで、リアルタイム推論を可能とした。

また、長尺動画の生成において、品質の一貫性を保ちつつ計算コストの増大を防ぐために、最初の設定である「Attention Sinks」と古い情報の削除を行う「KV Cache Rolling」を組み合わせ、直近の出来事のみを参考にする「スライディングウィンドウ注意機構(sliding window causal attention)」を導入している。学習時には、この推論時の外挿(extrapolation)状況をシミュレーションすることで、コンテキストウィンドウを固定したまま、品質劣化なく定速で動画を生成し続けることができるという。

Using point tracks as a unified motion representation allows us to control not only the object motion but also the camera, all in real time.

— Xun Huang (@xxunhuang) November 4, 2025

We use monocular depth estimation to lift the input image into 3D and uniformly sample 3D points. Then, as the virtual camera moves, we… pic.twitter.com/Xbka8TQrcW

ユーザーは軌跡の描写(paint trajectories)やカメラワークの制御、別の動画の動きの転送といった操作をリアルタイムに行い、その結果を即座に画面上で確認できる。なお、現段階では極端に速い動きや複雑なシーンではアーティファクトが発生する場合があり、ストリーミングの性質上ネットワーク遅延の影響を受けやすいという欠点も報告されている。

It supports real-time video editing.

— Xun Huang (@xxunhuang) November 4, 2025

Given an input video stream, we first edit the initial frame. We can estimates point tracks from the incoming video in real time. MotionStream then generates the output on the fly, conditioned on the edited initial frame and tracked points. pic.twitter.com/EnLoYIMYzC

■MotionStream: Real-Time Video Generation with Interactive Motion Controls(プロジェクトページ、英語)

https://joonghyuk.com/motionstream-web/

■MotionStream: Real-Time Video Generation with Interactive Motion Controls(GitHub)

https://github.com/alex4727/motionstream

CGWORLD関連情報

●動画生成AIモデル「Hailuo 2.3」リリース! 物理動作・スタイライズ・キャラクターの表情描写などが改善、高速・低価格モデル「Hailuo 2.3 Fast」も提供

MiniMaxが動画生成AIモデル「Hailuo 2.3」をリリース。Hailuo AIのWebサイト、モバイルアプリ、Open Platform APIで利用可能にした。Hailuo 2.3はHailuo 2.0モデルを基盤とし、よりリアルで安定したビジュアルとダイナミックな表現力を備えたモデル。提供されるのは「Hailuo 2.3」と高速・低価格な「Hailuo 2.3 Fast」の2種類。

https://cgworld.jp/flashnews/01-202511-Hailuo23.html

●AIアバター用動画モデル「Argil Atom」リリース! 1枚の写真とプロンプトから一貫性あるアバターを生成して長尺のAIアバター動画を作成、API経由で利用可能

Argilが「AIクローン」や「AIアバター」を中心とする動画生成プラットフォーム「Argil」における、中核技術の新AI動画モデル「Argil Atom」をリリース。現在はAPI経由で提供され、今後メインプラットフォームでも利用可能となる。

https://cgworld.jp/flashnews/01-202511-ArgilAtom.html

●オープンソースの動画生成AIエンジン「LTX-2」リリース! ネイティブ4K対応、50fps・20秒の音声付きシーンを生成

LightricksがオープンソースのAIクリエイティブエンジン「LTX-2」をリリース。プロダクション向けに設計され、音声と同期したネイティブ4K・50fps、20秒の連続的なシーンの生成を可能とする。公式ワークスペースのLTX Studio API Playground、ComfyUIなどサードパーティ製ツールとの統合を通じて利用できる。コードとウェイトは11月下旬にGitHubで公開予定。

https://cgworld.jp/flashnews/01-202511-LTX-2.html