ユニティ・テクノロジーズ・ジャパンによるオンラインカンファレンス「SYNC 2022」が、10月25日(火)と26日(水)の2日間行われた。Unityの開発事例や最新技術情報などをテーマにした全67セッションを配信し、その分野はゲーム、映像・アニメ、自動車・輸送、建築・建設、ロボティクスなど多岐に渡った。

本記事では株式会社stuによるセッション「ライブエンタメ産業におけるUnityの活用と未来」の模様を一部レポートする。

関連記事

『Enemies』メイキング&スマホゲーム『プリコネ!』におけるURP導入事例~SYNC 2022(1)

プリレンダを得意としてきたCompositionによるバーチャルスタジオ開発&実写ノウハウを活かすStory EffectのUnityアニメ制作事例~SYNC 2022(2)

イベント概要

SYNC 2022

開催日時:2022年10月25日(火)~26日(水)10:00~22:00(予定)

開催形式:オンライン(事前登録制)

events.unity3d.jp/sync

バーチャル空間でリハーサル可能なプレビズソフトウェア開発

以上、株式会社stu

セッション「ライブエンタメ産業におけるUnityの活用と未来」には株式会社stuからテクニカルプロデューサーの高尾航大氏と、システムエンジニアの青木雄斗氏が登壇。ライブエンターテイメント業界のDX化に向けて、現在開発中のプレビズソフトウェアと、メタバースライブを同期制御するための伝送プロトコルのMSSPを紹介した。

まずは高尾氏が「ライブ制作を支えるプレビズ技術」という題目でセッションを始めた。映像産業ではプレビズを使って最終イメージを共有し、クオリティの向上を図ることが一般的だが、高尾氏によるとライブ産業ではいまだにプレビズのワークフローが存在しないという。全体リハーサルをしている現場は稀で、多くの場合は予算やチーム組成の問題からぶっつけ本番で演出をしている現状を明かした。

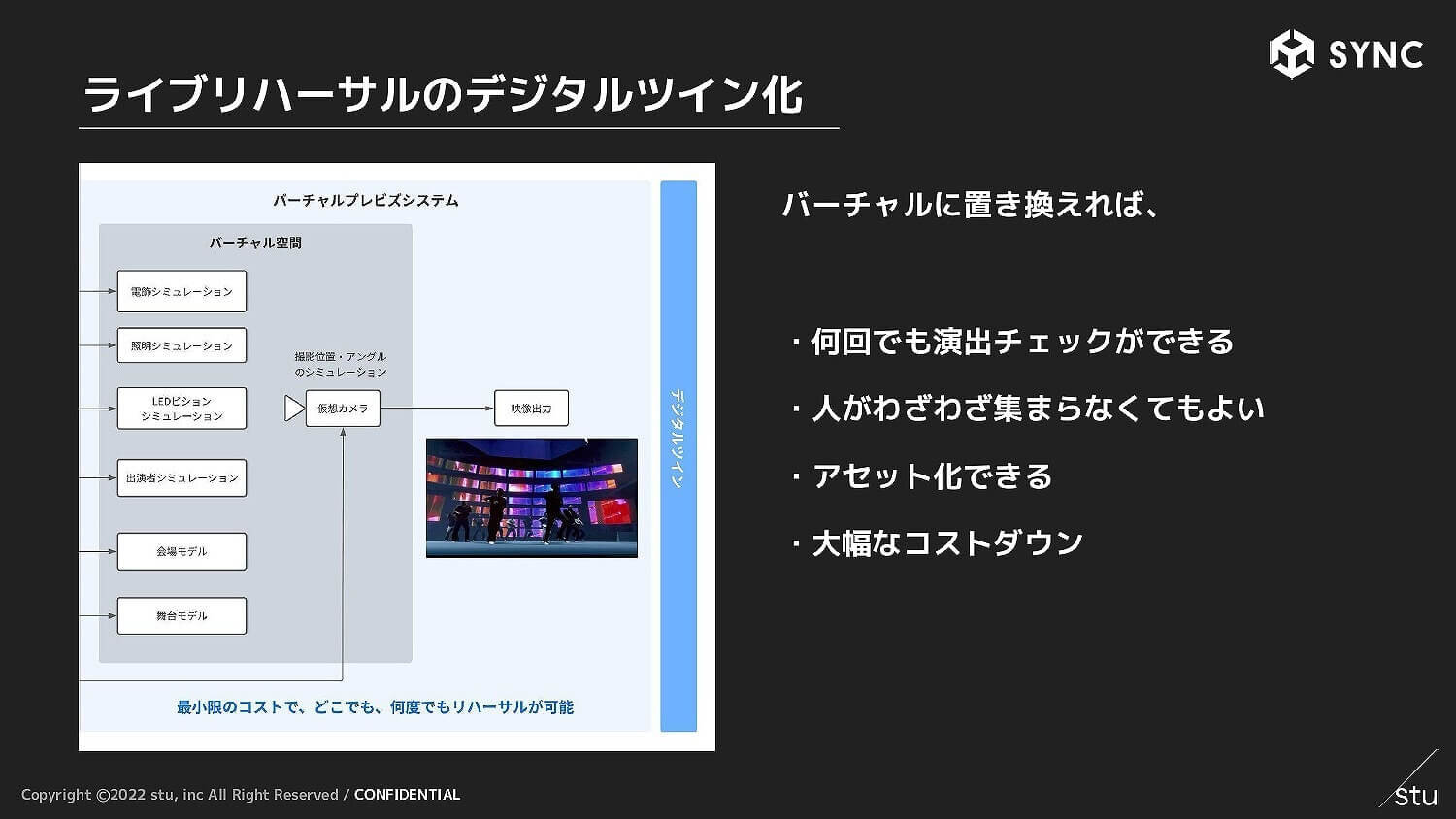

この問題を解決するため、stuではリハーサルをバーチャル空間に置き換えるプロジェクトを立ち上げた。物理会場での技術リハーサルは1回1,000万円近くかかるが、もしバーチャルで代用できれば現地に人を集める必要がなくなり、演出チェックが何度も可能になるなど、大幅なコストダウンが見込める。

そこで経済産業省の「コンテンツ海外展開促進・基盤強化事業費補助金(J-LOD)」に応募、採択事業者に選出された。現在、ライブ制作においてデジタルツインプレビズワークフローを導入するためのソフトウェアを開発中だ。

開発にあたっては「どんなに優れたツールでも導入してもらえなければ意味がない」という考えから、マネジメントサイドが導入しやすい「操作が簡単でPCスペックが不要」という条件と、現場のスタッフの要求に耐える「高機能・ハイエンドグラフィック」という仕様、両方を備えることを目標に掲げた。そのため現場のオペレーションは既存のものを踏襲した上で、マネジメントサイドへの理解を深めるようなツールを目指している。

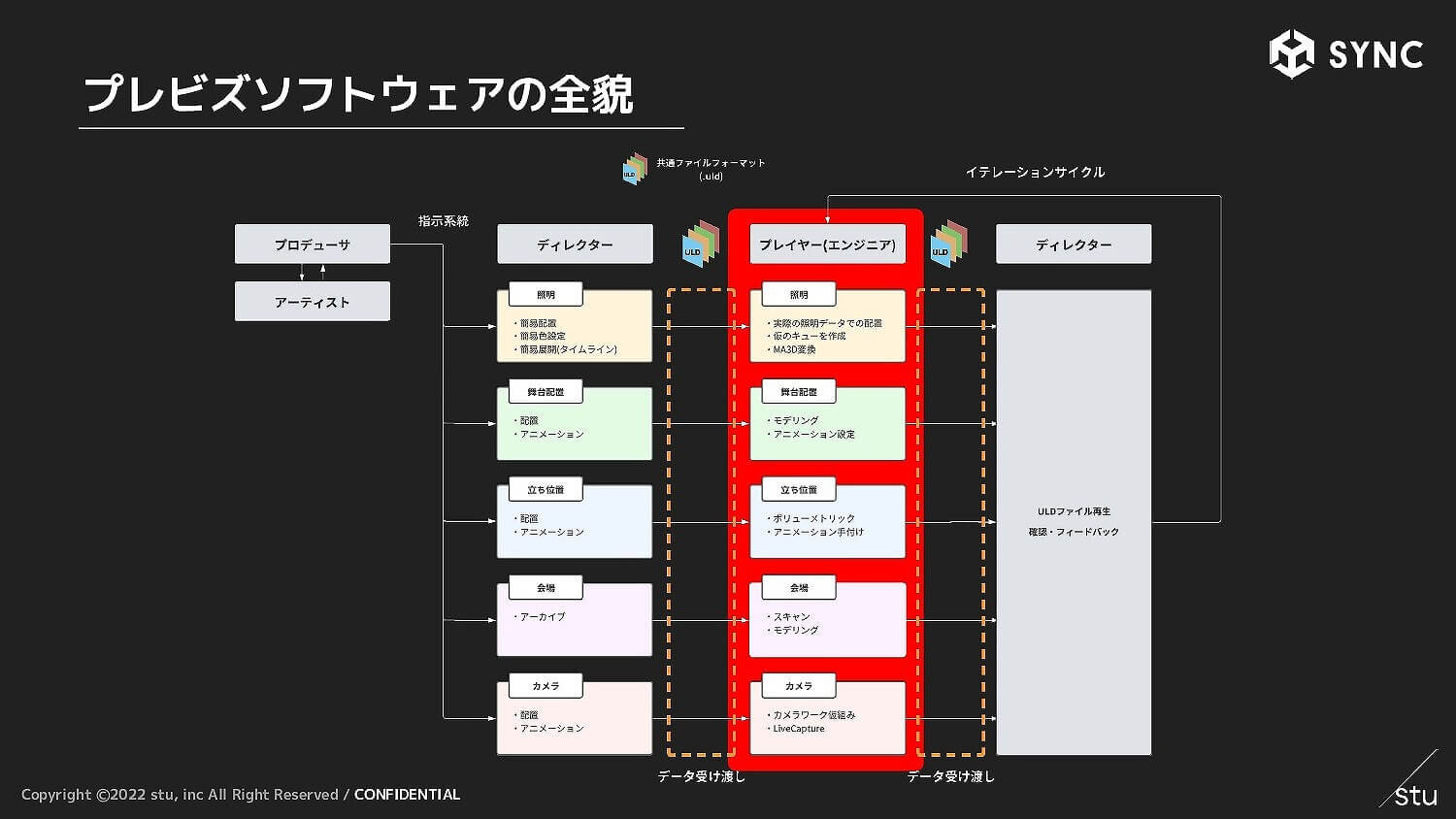

プレビズソフトウェアでは、セクションを「照明」、「舞台配置」、「立ち位置」、「会場」、「カメラ」の5つに分け、プロデューサーの指揮の下、各ディレクターがエンジニア(プレイヤー)に指示を出すトップダウン形式を採用。これまではエンジニアの成果物にディレクターがフィードバックする機会はリハーサルしかなかったが、ソフトによって両者の間にイテレーションサイクルが生まれ、クオリティの向上が望めるようになる。

続いては各セクションの実装解説に移った。「照明」はUnity上で動作する照明シミュレーション LightVizを開発しており、本番環境の照明演出を抽出してシミュレーションができる。「舞台配置」にはCADを使用しているため、本セッションでは割愛された。「立ち位置」はアーティストをボリュメトリックキャプチャでデジタル化し、それをライブ会場のバーチャルデータに置いて再現した。

「会場」の3DCG化にはレーザースキャナRTC360を使用した。ゼロからモデリングをするのではなく、会場全体をスキャンして点群データに直すというアプローチによって、データは2分ほどで完成。点群データをVFX Graphの立方体表示することで十分実用に耐えるグラフィックになった。

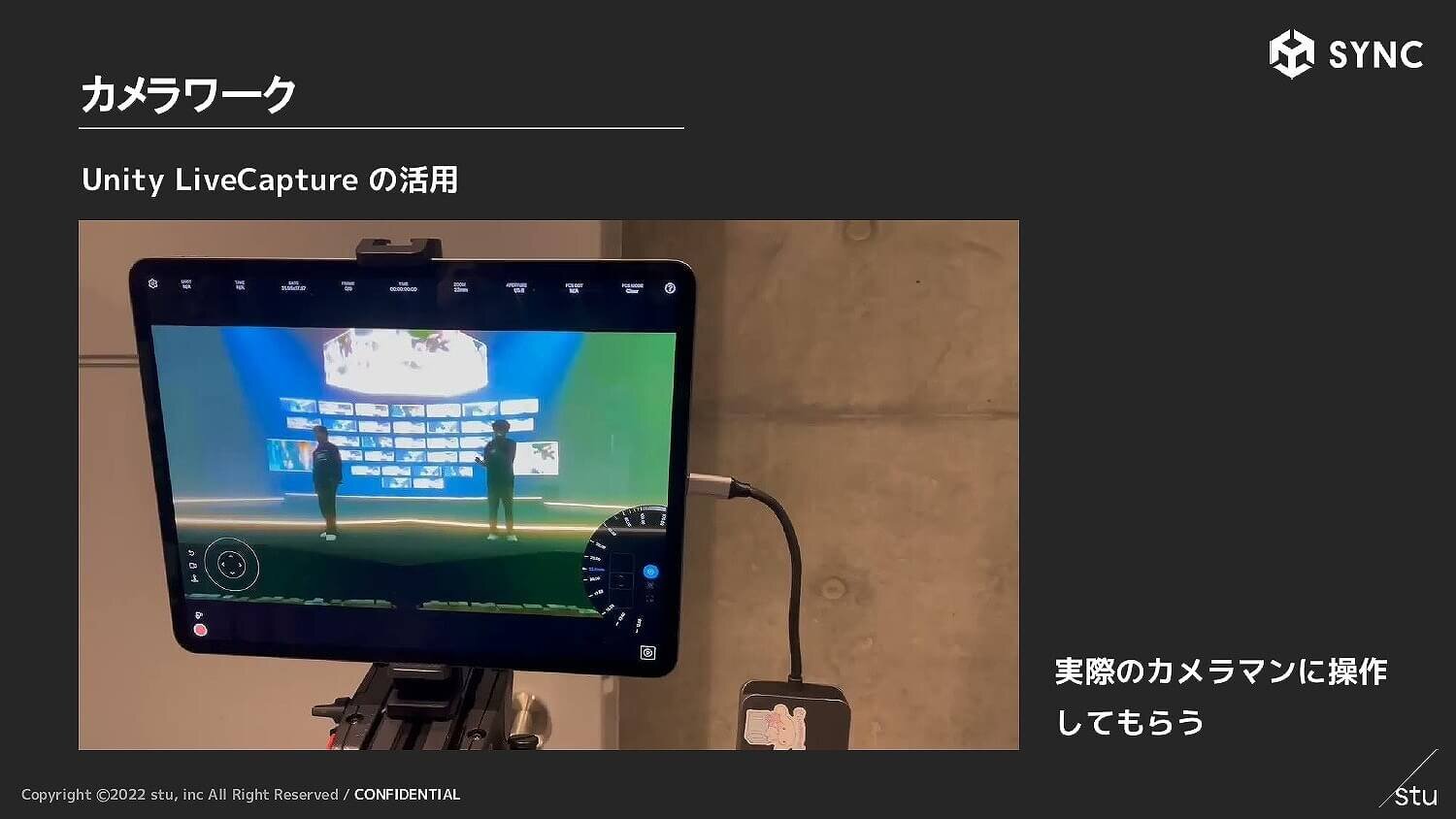

「カメラ」に関してはUnity Live Captureを活用。実際のカメラマンも操作しやすいパラメータで、ズームやパン、ティルトなどのカメラワークの制御も容易だ。

Live Captureを使用しない実際のカメラのトラッキングにも対応した。mo-sysのStarTrackerによる光学式トラッキングシステムやSHOTOKUの機械式トラッキングシステムによって、カメラの位置や角度を検出してシューティングをチェックできる。

エンジニアから上がってきた映像をチェックする際に最も重要視したのが手軽さである。stuではクラウドレンダリング技術を開発しており、URLによるクイックアクセスを用いて、HDレンダーパイプライン(HDRP)のグラフィックが動作可能。チェックバックに高性能なPCは必要なく、タブレットなどの低スペック端末でも自由に扱える。そのためディレクターがソフトウェアを開くことに心理的な障壁を感じずに、フィードバックを送れるシステムとなった。

セッションの後半では青木氏が「メタバースライブの技術的課題と解決」について解説した。

最初に「メタバースライブ」の定義について「明確なものはない」としながらも、バーチャルタレントのアバターが歌ったり踊ったり、ユーザーがアバターでログインしてアクターと同じ空間で楽しんだりという要素を含むことが多いと実感を話す。以前はバーチャルライブと呼ばれていたが、近年ではメタバースライブと呼ばれる比率が上がっているそうだ。

ただ「バーチャルキャラクターのライブ」としては物理会場のスクリーンに投影する形式もあるため、本セッションにおけるメタバースライブはユーザーがアバターでログインする形態を指すことにした。

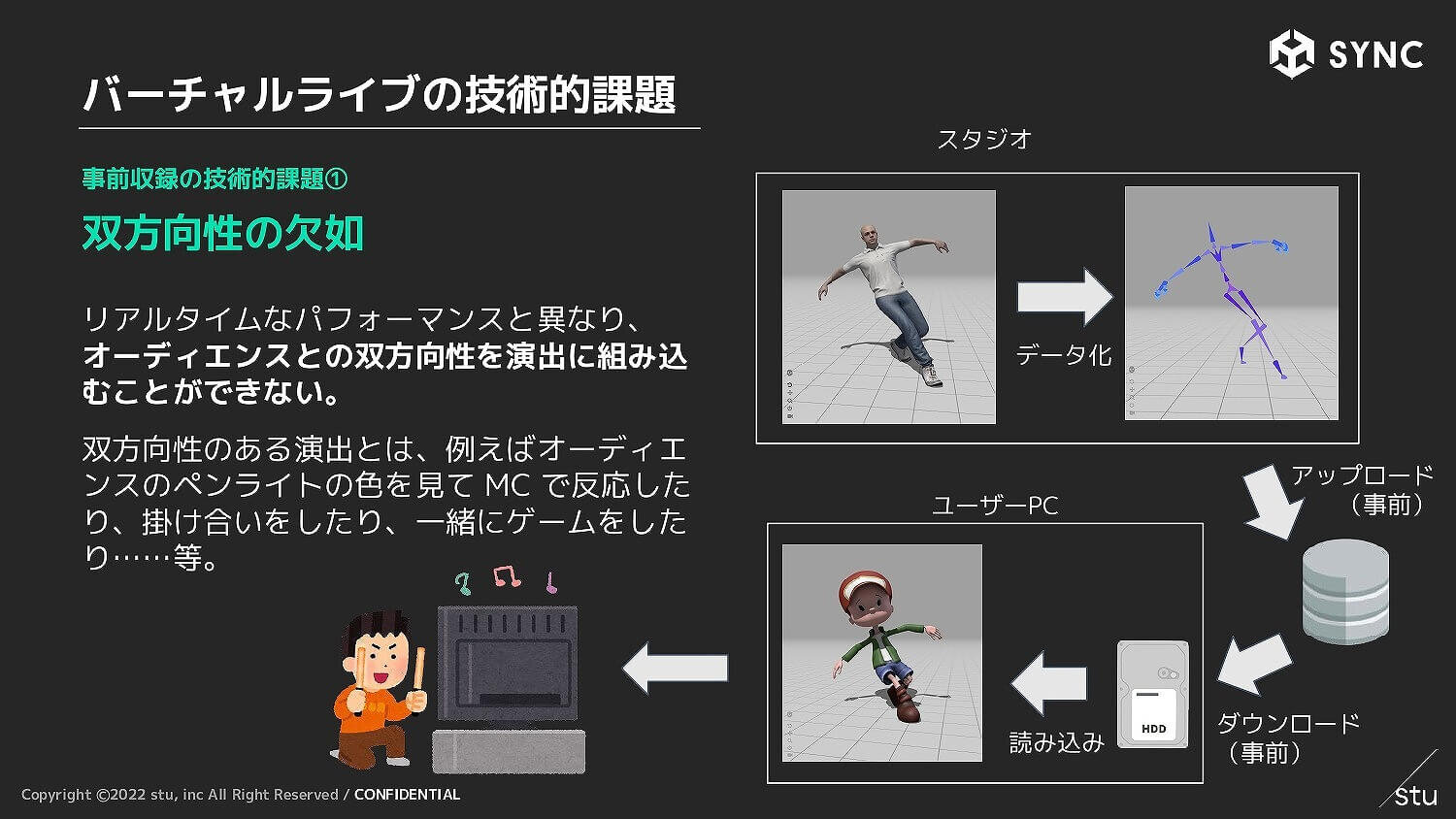

バーチャルライブは事前収録方式とリアルタイム方式の2つに分けられるが、それぞれに技術的課題が存在する。事前収録方式はユーザーがライブ開始前に音声、楽曲、モーションなどのデータを、ネット経由で事前にダウンロードするという方法だ。ダウンロードさえ済んでいればライブ中に事故が起こりにくい点がメリットであり、今あるメタバースライブの多くもこの方式を採用している。

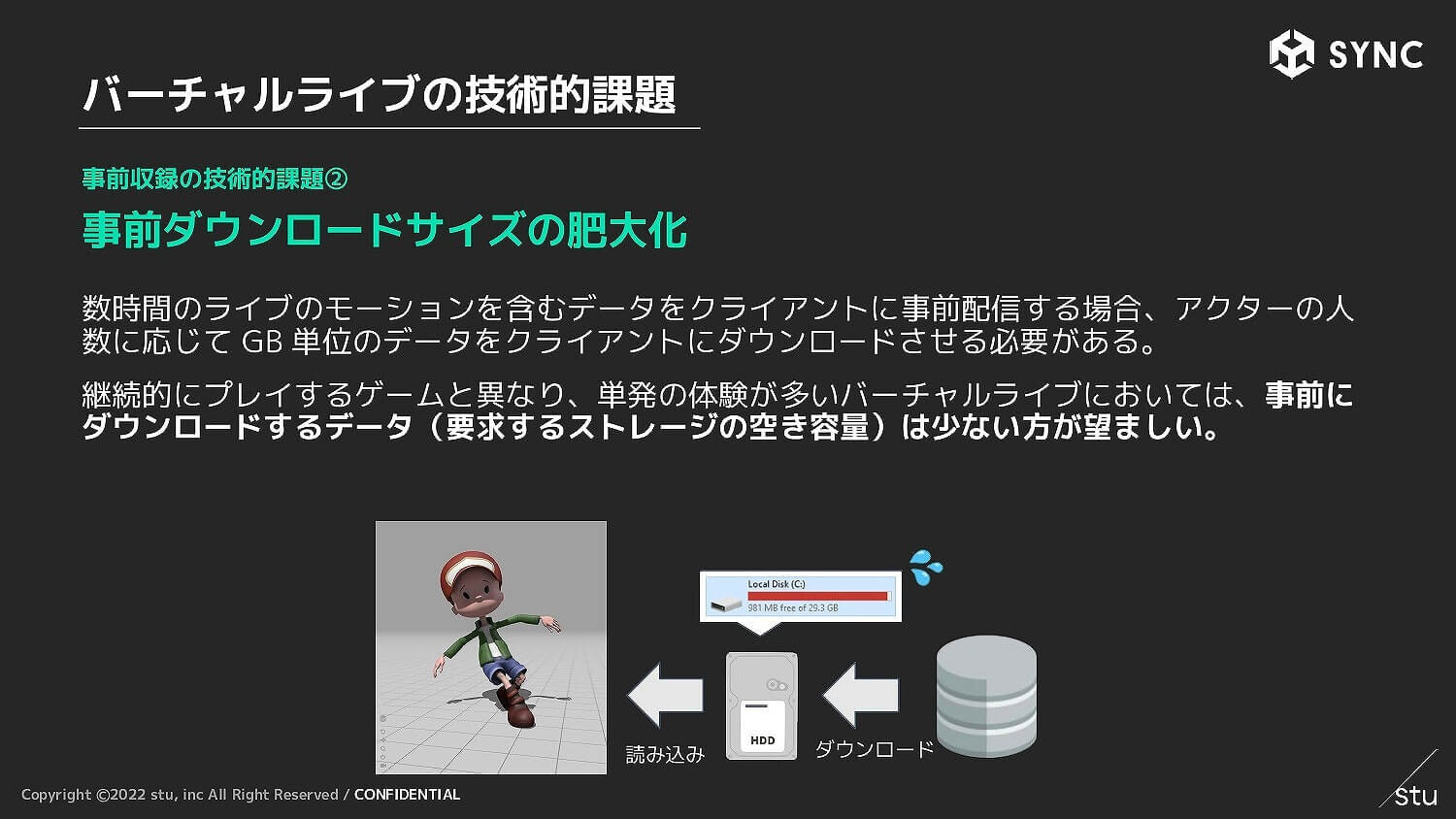

しかしライブの魅力である双方向性を演出に組み込めない点が短所で、ユーザーの反応にアクターがレスポンスを返すのは不可能である。またライブの長さやアクターの数に応じてダウンロードサイズが肥大化してしまうという問題もある。継続的にプレイするゲームとは異なり、単発の体験が多いバーチャルライブでは、要求するストレージの空き容量は少ない方が望ましい。

リアルタイム方式はキャプチャしたデータをインターネット経由でストリーミング伝送する方法。この場合は音声やモーションをストリーミングし、楽曲などは事前収録方式との組み合わせになることが多い。こちらならユーザーとコミュニケーションを取りながらライブができる。

ただリアルタイム方式は、音声、モーション、口パクなど複数種類のデータを同時伝送しなければならず、相互にタイミングずれが発生するリスクがある。さらに音声や映像以外のデータをリアルタイム送信するための独自プロトコルは大量接続が難しく、サーバのスケールアウトで対応しなければならず、非常にお金がかかってしまう。

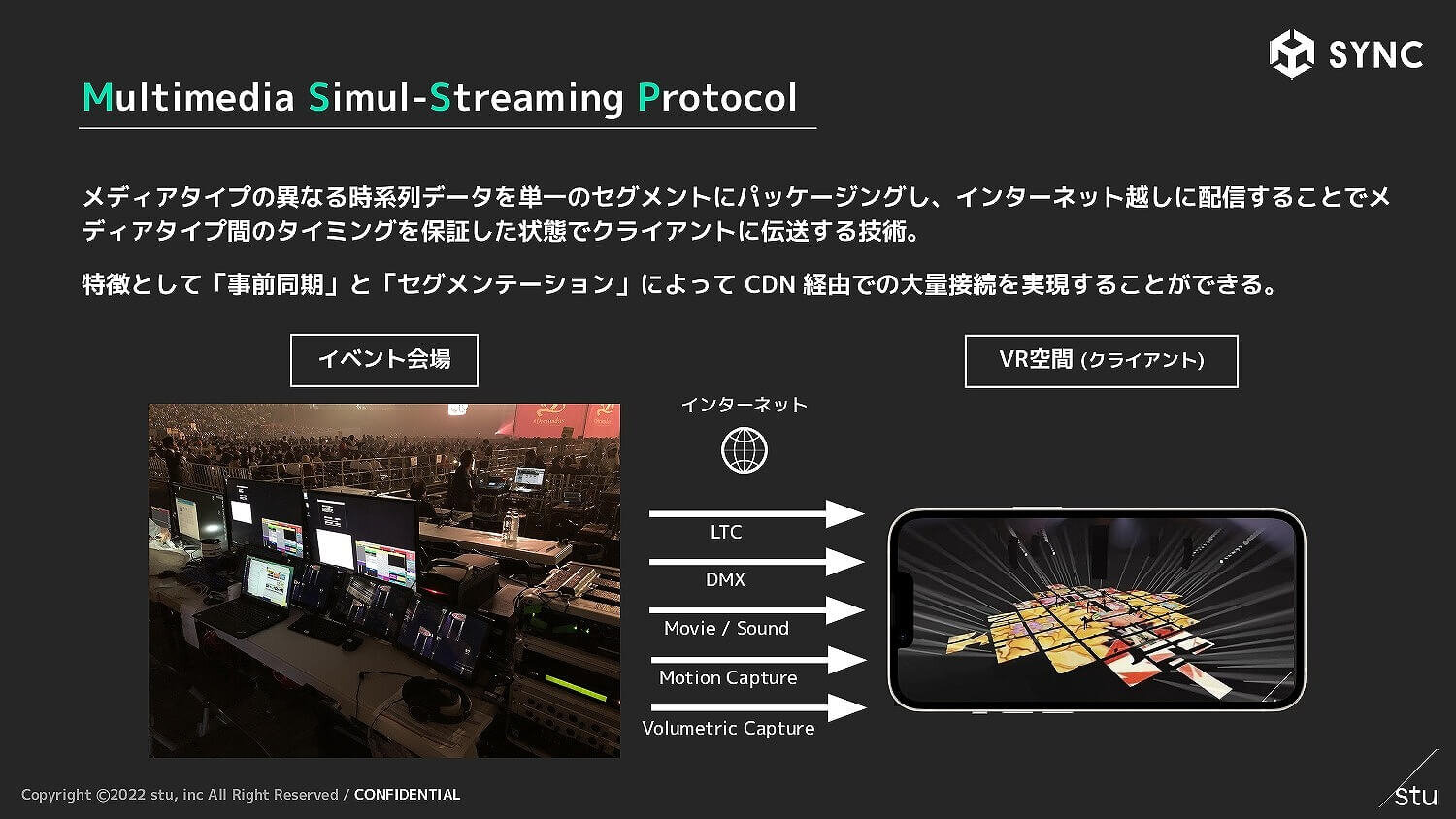

その問題を解決するため、stuはマルチメディア同時伝送プロトコルのMSSP(Multimedia Simul-Streaming Protocol)を開発。メディアタイプ間のタイミングを保証した状態で、イベント会場からUnityでつくられたVR空間に向けてのデータ転送が可能になった。

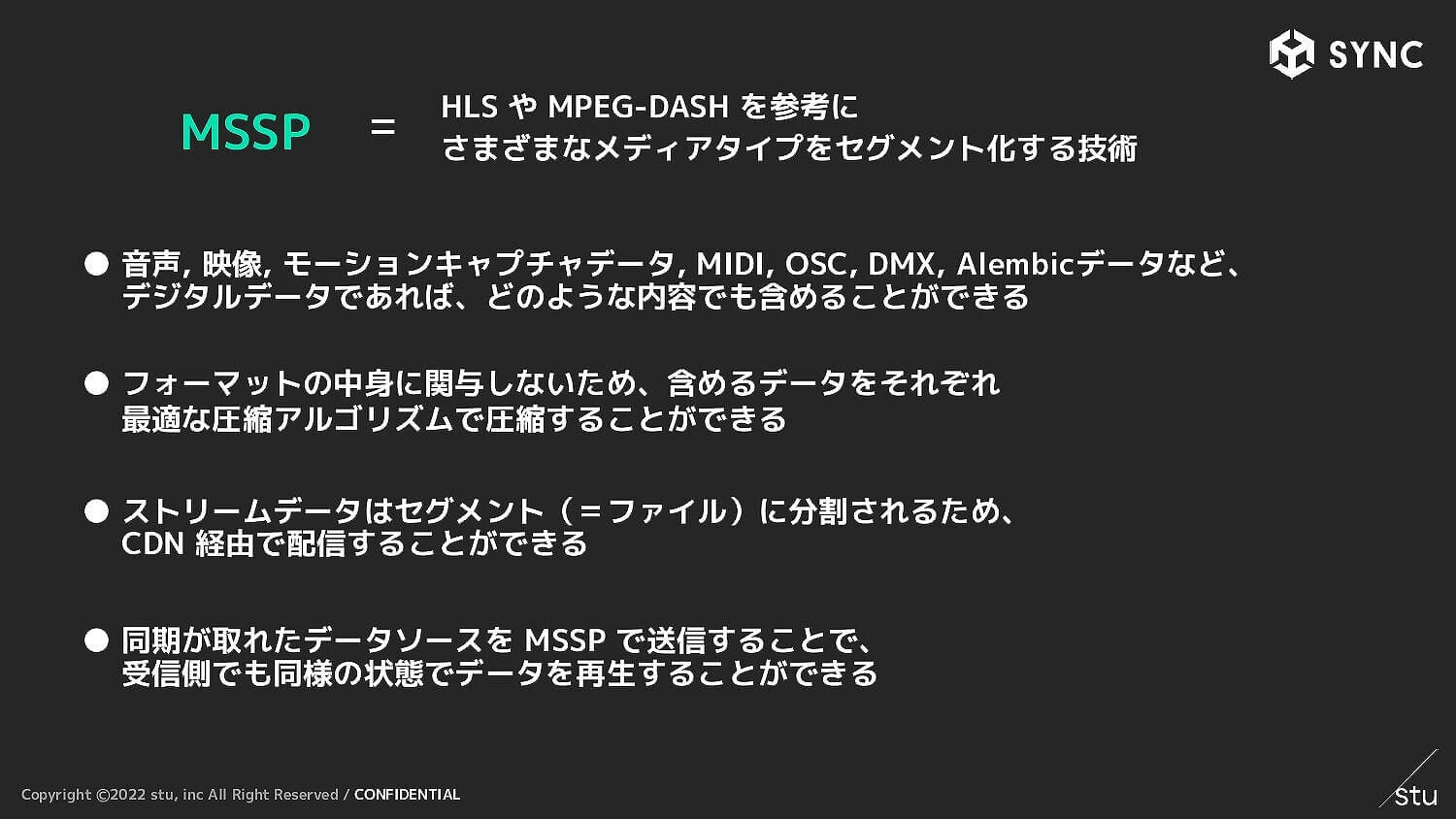

「MSSP」はHLSやMPEG-DASHから影響を受けており、それらがもつCDN経由での配信に対応することで大量接続を担保している。セッションでは、CDNを利用したデータ送信構造や、データ長ではなく時間の長さで区切るという特徴をもったデータセグメントの構造、個別に異なるアルゴリズムを使える通信データ圧縮などを紹介した。

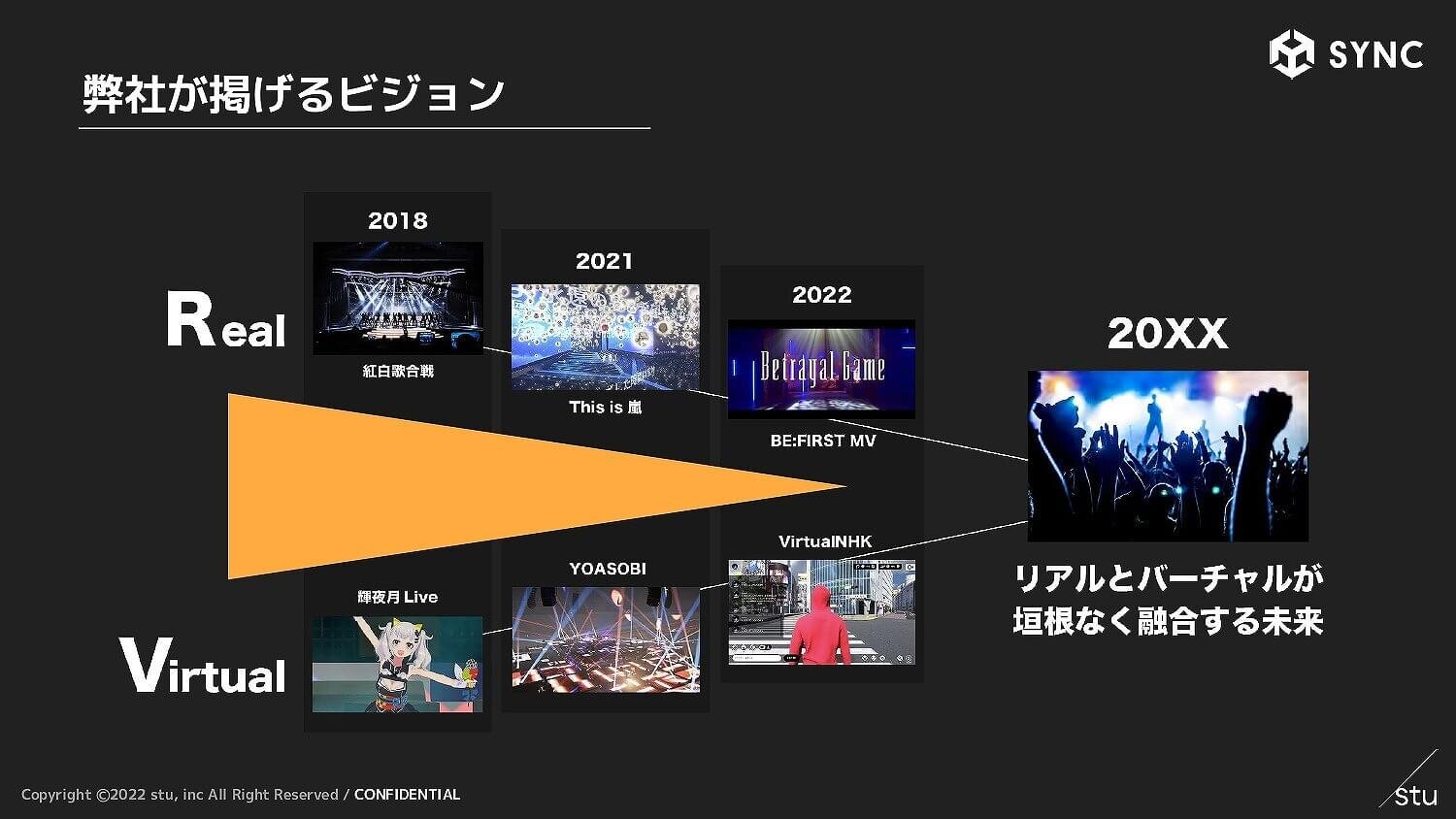

最後に青木氏が再び登壇。現在開発中のプレビズシステムとMSSPを組み合わせることによって、現実のライブをそのままリアルタイムでバーチャル空間にもっていくことを目指しているとコメント。「現場でのクリエイティブ制作やソフトウェア開発のノウハウを織り交ぜながら、バーチャルとリアルが融合する未来を実現していきます」と展望を語り、セッションは幕を閉じた。

TEXT_高橋克則 / Katsunori Takahashi

EDIT_山田桃子 / Momoko Yamada