2024年8月9日(金)、清澄白河にあるGUNCY'S TECH FORTにて「モーキャプフェス2024~MotionBuilderでクオリティアップ~」(主催:GUNCY'S、オートデスク/協賛:アキュイティー、HELTEC/協力:日本HP)が開催された。3つの技術セッションとモーションキャプチャ関連企業3社の製品セッションについてレポートする。

なお、本イベントのアーカイブ配信は、オートデスクのメディア&エンターテインメント業界向け情報サイト「AREA JAPAN」で視聴可能だ。

アーカイブ配信の視聴はこちら。

キャラクターを魅力的に動かすために ~MotionBuilderのリターゲットとコンストレイントを紹介~

GUNCY'Sの大畑滋氏による技術セッション。初心者向けにMotionBuilderの基本的な最初に使うべき機能の説明があった。大畑氏は2000年からIMAGICAでモーションキャプチャを担当した後、大手ゲームメーカーでAAAタイトルにも参加するなど演出の手法やモーション指導を経験。現在はGUNCY'Sで企業や学生を対象に、さまざまな分野でデジタルコンテンツ開発のコンサルティングを行なっている。その豊富な経験によって培われた技術が紹介された。

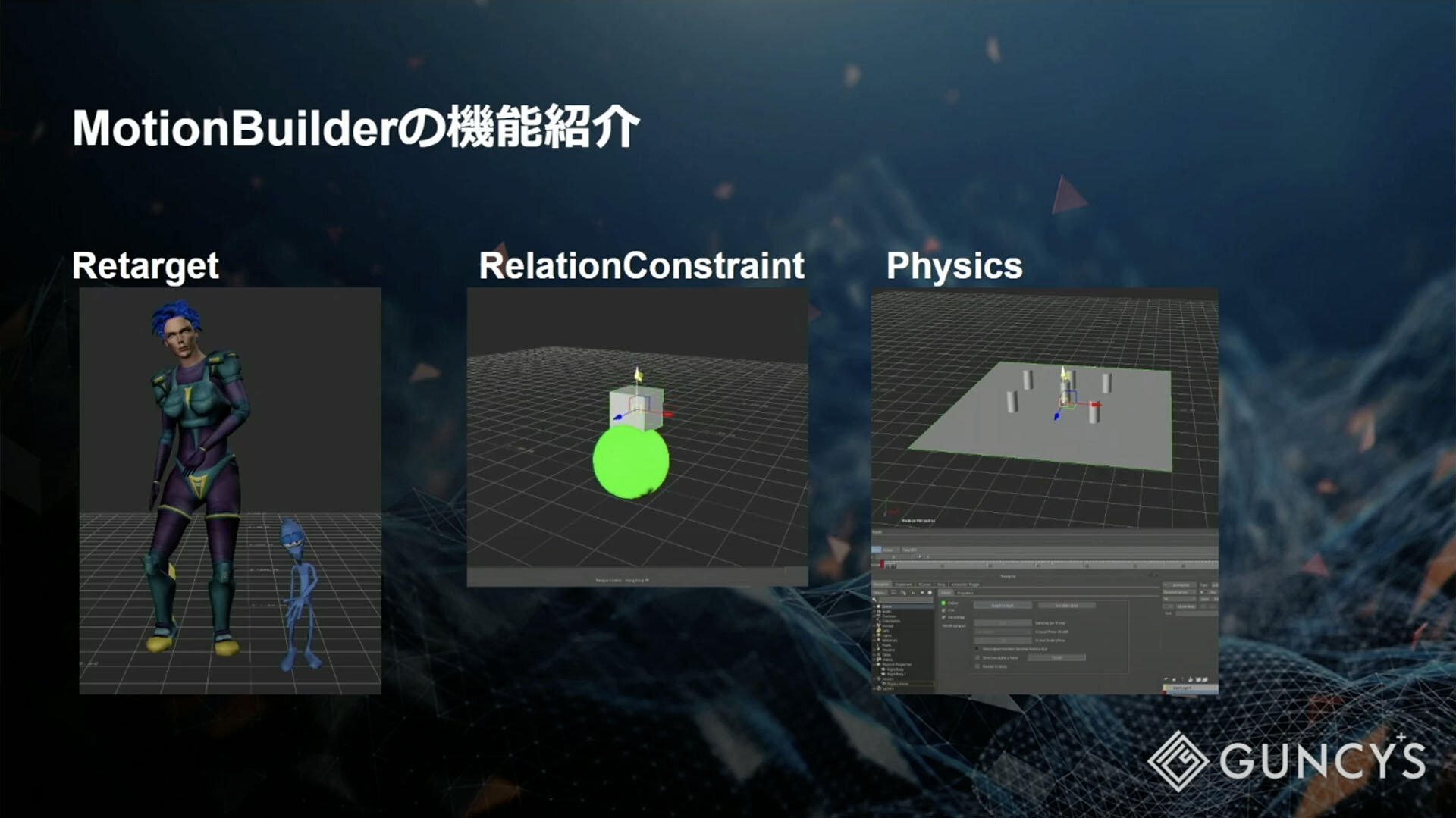

本セッションで紹介されたのは以下の3つの機能。

・Retarget

・RelationConstraint

・Physics

まずはRetargetから。MotionBuilderの標準機能であるが、分からない人が多い。それぞれのCGキャラクターによってパラメータが変わってくることから、大畑氏も「細かい設定はたくさんありますが、具体的な数値はお伝えできません」と説明しているとのこと。そのため、本セッションでは「この部分を触ったら変化がある」というポイントを理解してもらうことが目的となった。

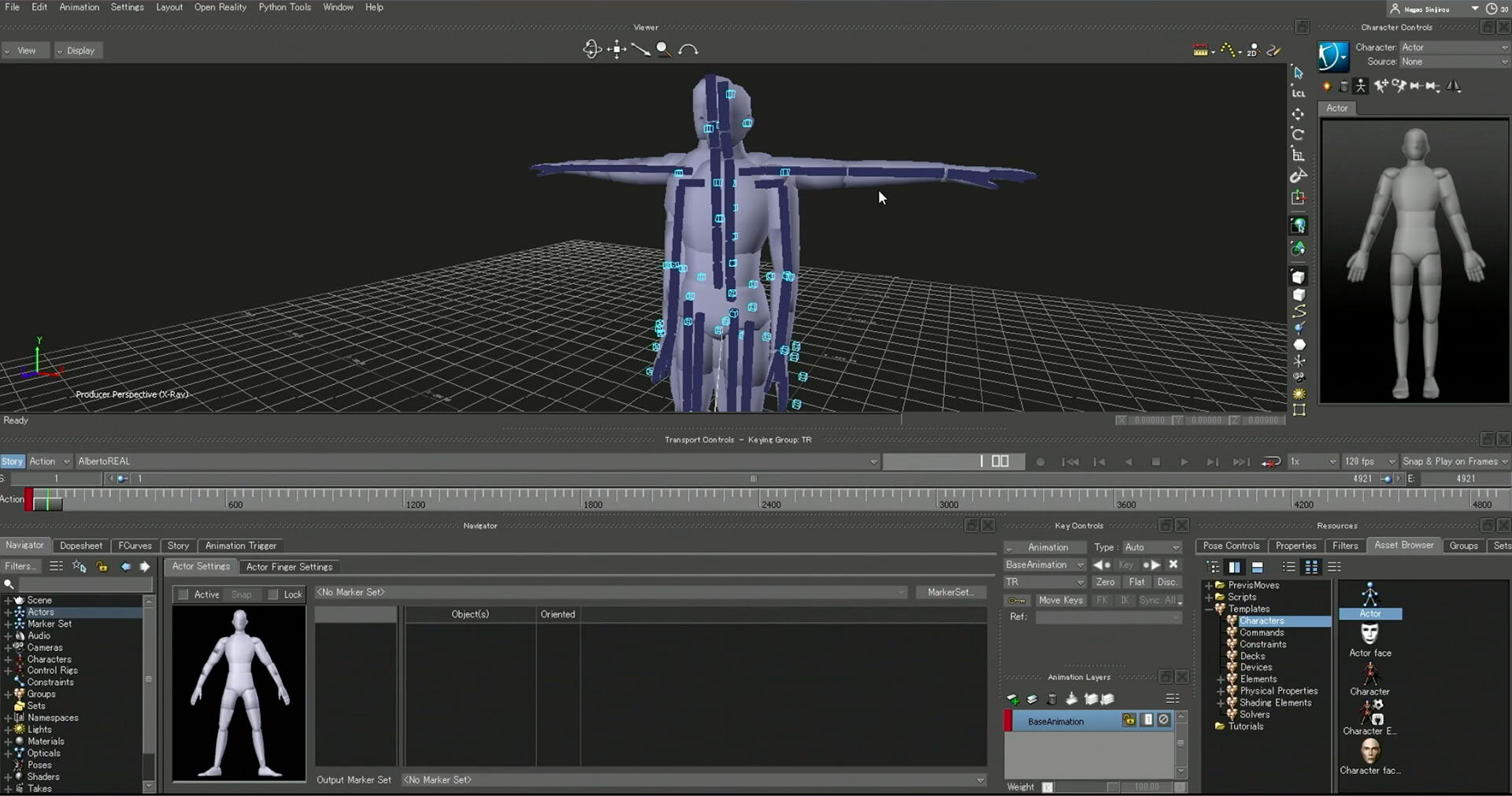

Retargetは、キャラクターの身長差や体重差を吸収して調整し、足の設置のところから再計算して、キャラクターの大小に関わらず同じ動きをさせる機能だ。登録方法も簡単で、マッピングリストに部位の関連付けをするキャラクタライズをするだけで良い。その際、Character Controlsのパラメータを少し調整するだけで姿勢などを正すことができる。

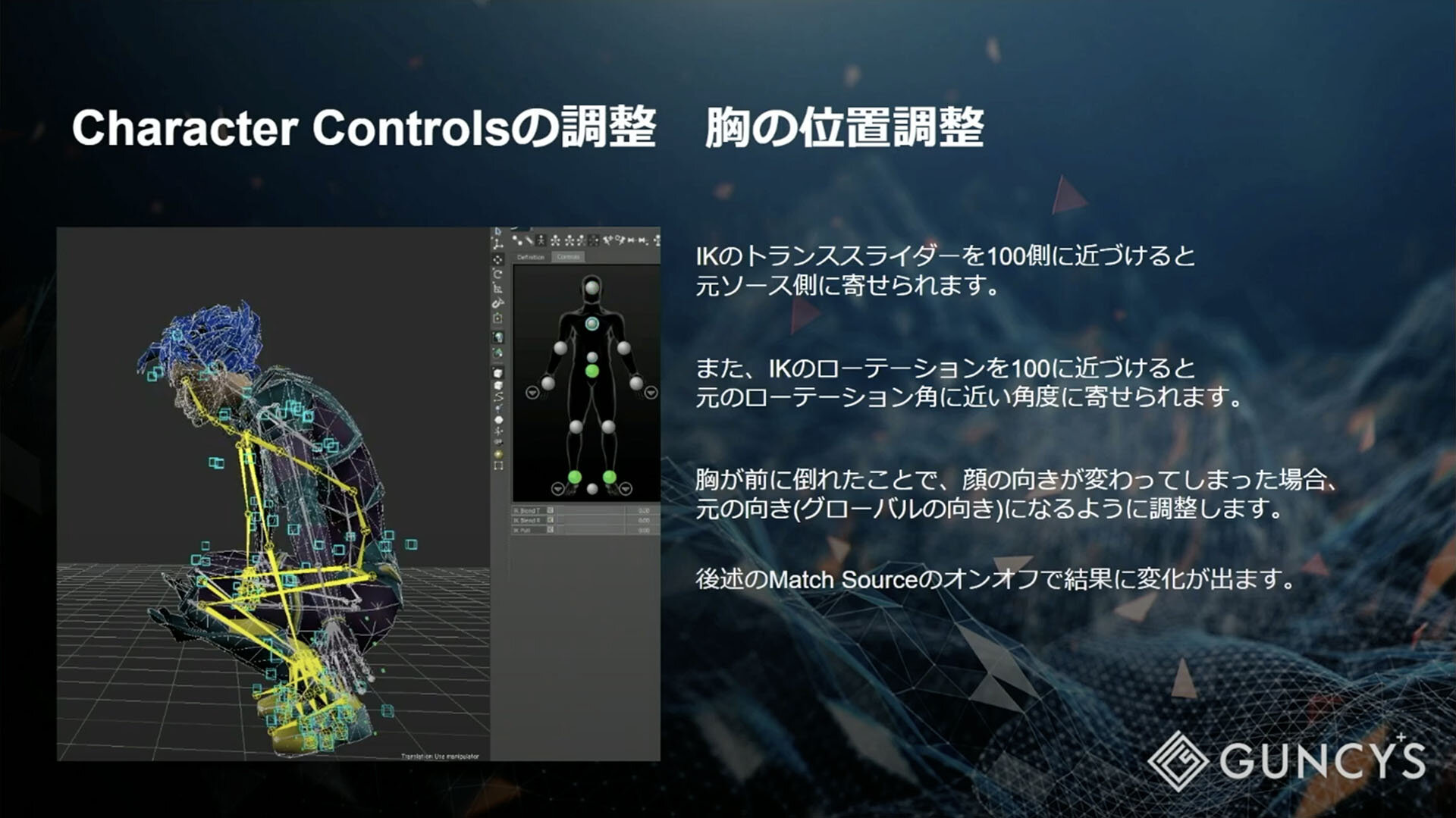

セッションでは、役者とキャラクターで胸の位置がずれる、歩幅の位置がずれる、膝が曲がる、肩の可動域の不具合、地面より手や足がめり込んだ場合について、おすすめの設定が紹介された。それぞれキャラクターによって向き不向きがあり、うまくいかない場合もあるので、ボーンを選択しながらスライダーを動かし、ワイヤーフレームで変化の様子を見ながらパラメータを調整していくことが重要だという。

▲役者とキャラクターで胸の位置がずれた場合の位置調整

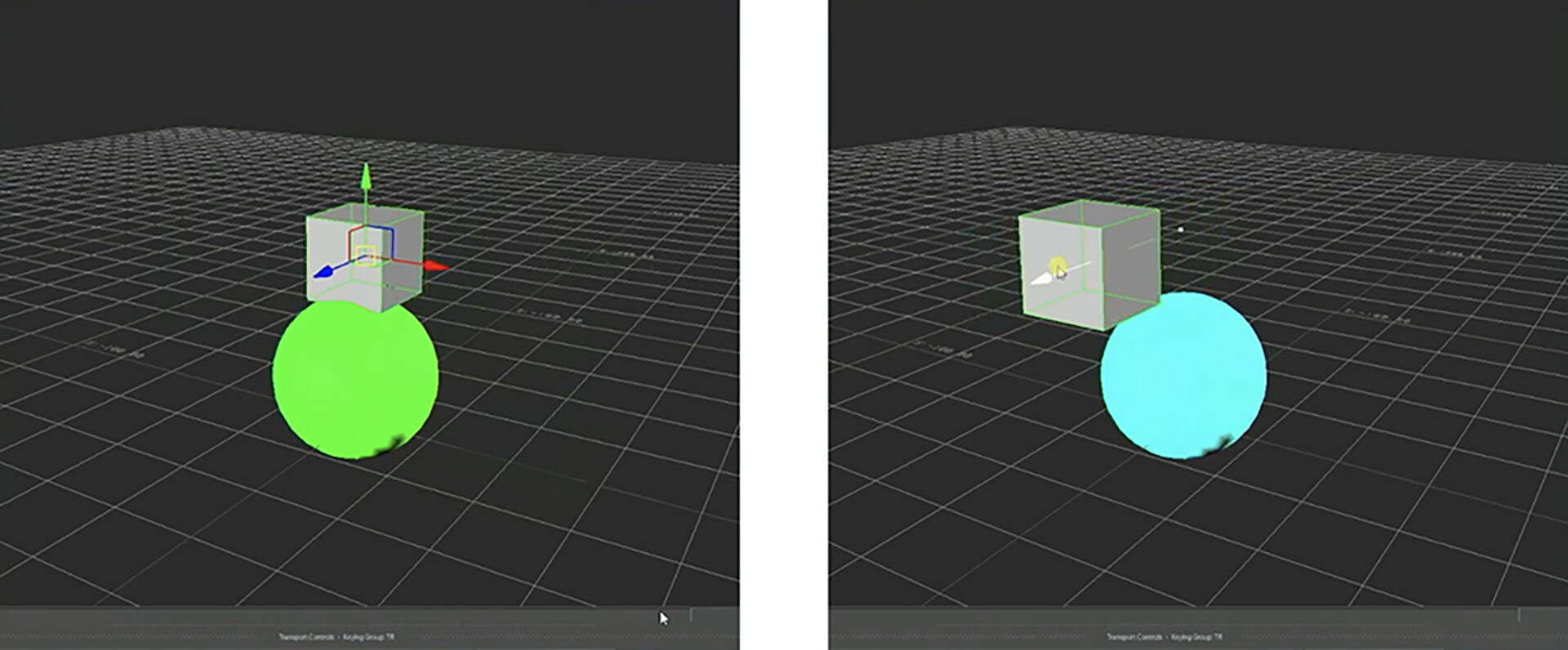

2番目のRelationConstraintについては、距離によってカラーが「変わる」というデモが紹介された。MotionBuilderの中でもRelationConstraintが一番分かりにくく、ハードルが高いという声を聞くが、この「変わる」ということが重要で、このデモをきっかけに興味をもってもらいたいとのこと。

RelationConstraintはSender、Receiver、Operatorで構成されており、それぞれを繋ぐことでさまざまな結果をもたらすものだ。今回はMaterialを適用したSphereとCubeを用意し、SphereのDiffuseColorをCubeとSphereの距離によって変化するように設定した。

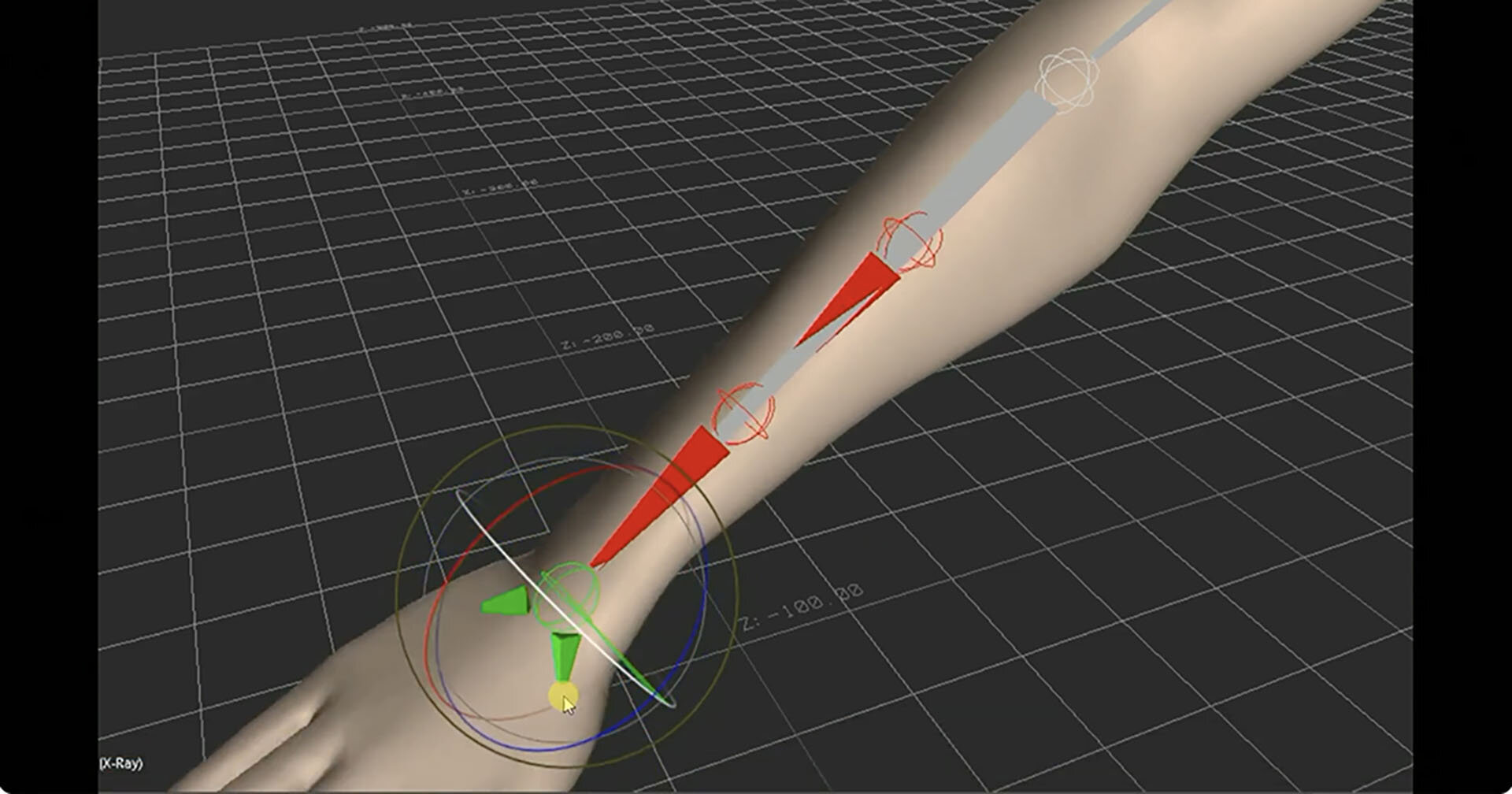

このRelationConstraintの仕組みがわかれば、補助骨の動かし方にも応用できる。例えば、手首しか回らなかったところ、RelationConstraintで計算することで補助骨に作用させてスキンも動かすこともできるようになる。

▲Cubeとの距離によってSphereのDiffuseColorが変化する

▲RelationConstraintの応用例。手首を回すのに合わせて補助骨も動くようになる

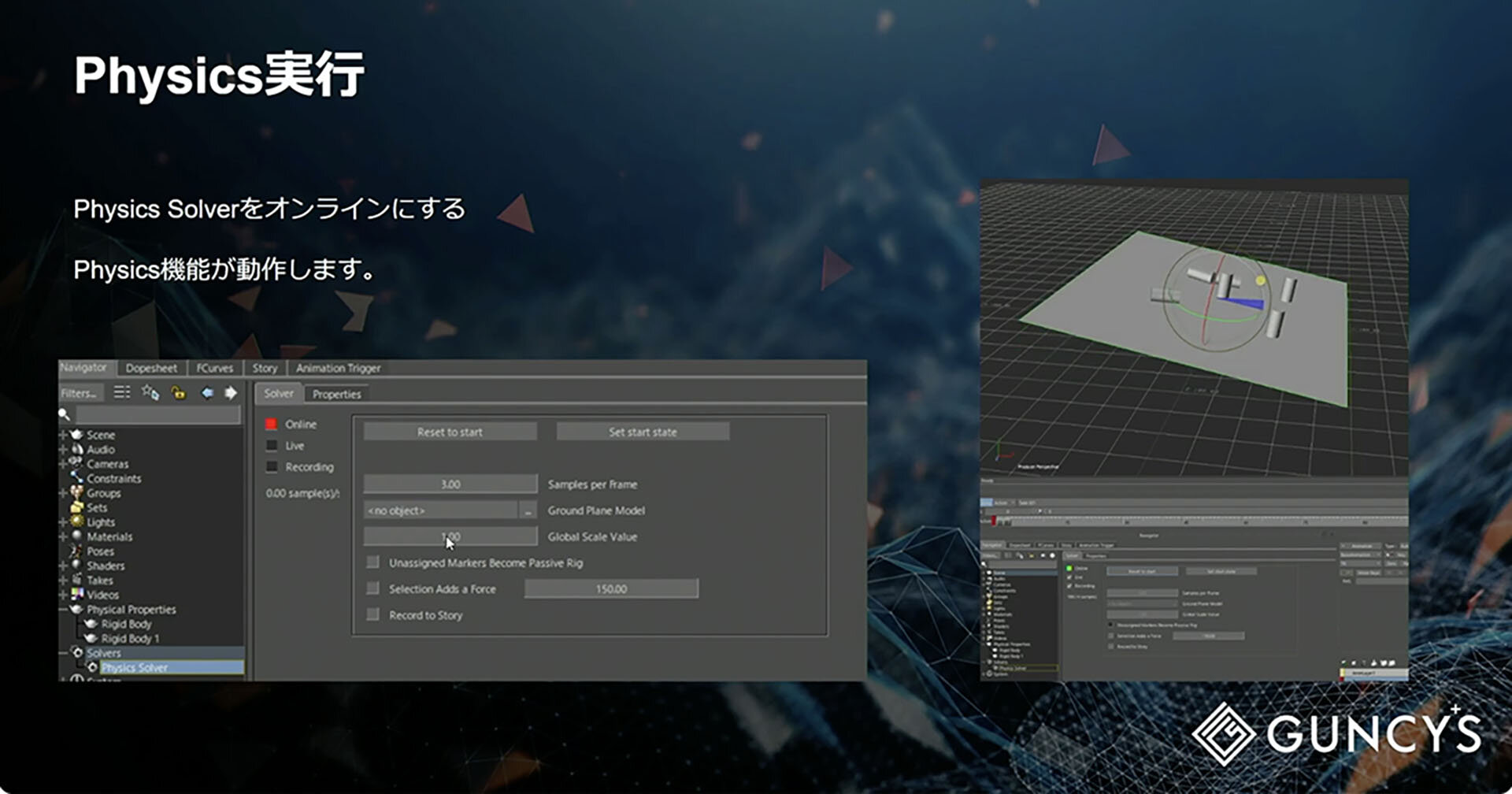

3つ目のPhysicsは簡単なシミュレーションができる機能である。デモでは床となるPlaneの上に置かれた複数のCylinderが、床を傾けることで崩れるシーンを紹介した。PhysicsのRigidBodyという機能を使ってPhysics Solverで計算を行う。Navigatorからオブジェクトにドロップすると設定できるので、PlaneはPassive、CylinderはActive at Collisionと設定する。Physics SolverをOnlineにすると計算が始まり、Liveにするとリアルタイムに計算結果が表示されるという仕組みだ。

▲Physicsの画面と実行結果

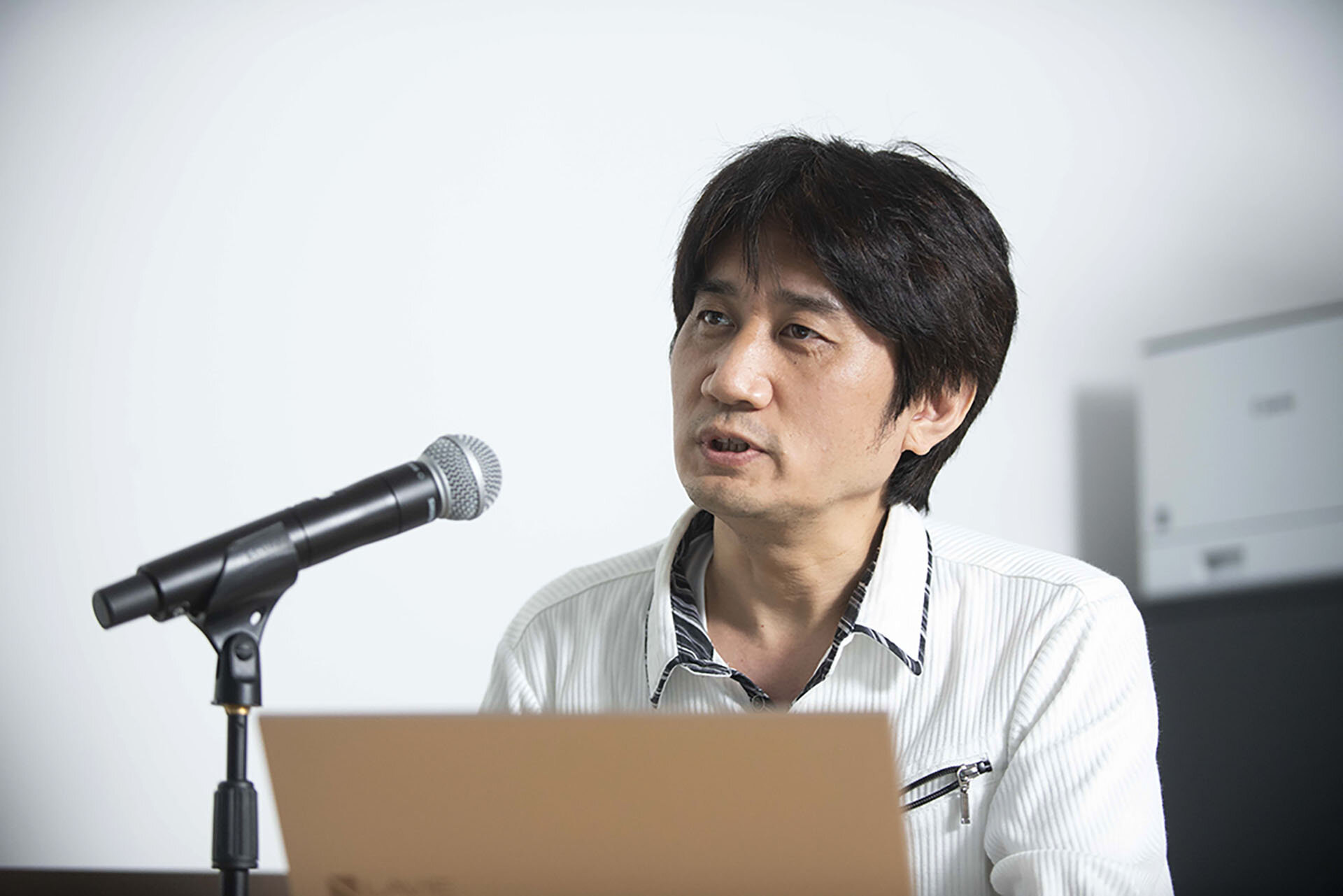

MotionBuilderスタートガイド~機能紹介/活用テクニック~

シネマティックデザイナーの長尾慎二郎氏によるセッションでは、MotionBuilderを導入していない方や、導入を検討している方向けにMotionBuilderの特徴と、代表する機能を4つのトピックとしてデータを交えた紹介があった。

MotionBuilderの特徴として、アニメーション専用のソフトであること、ハイポリゴンでもリアルタイム再生が可能なこと、モーションキャプチャデータの取り扱いについて柔軟な対応ができることの3つが挙げられた。MotionBuilderは元々Filmboxという名前で2002年に改名されたのだが、現在の拡張子.fbxは「Filmbox」の名前が由来になっているとのこと。

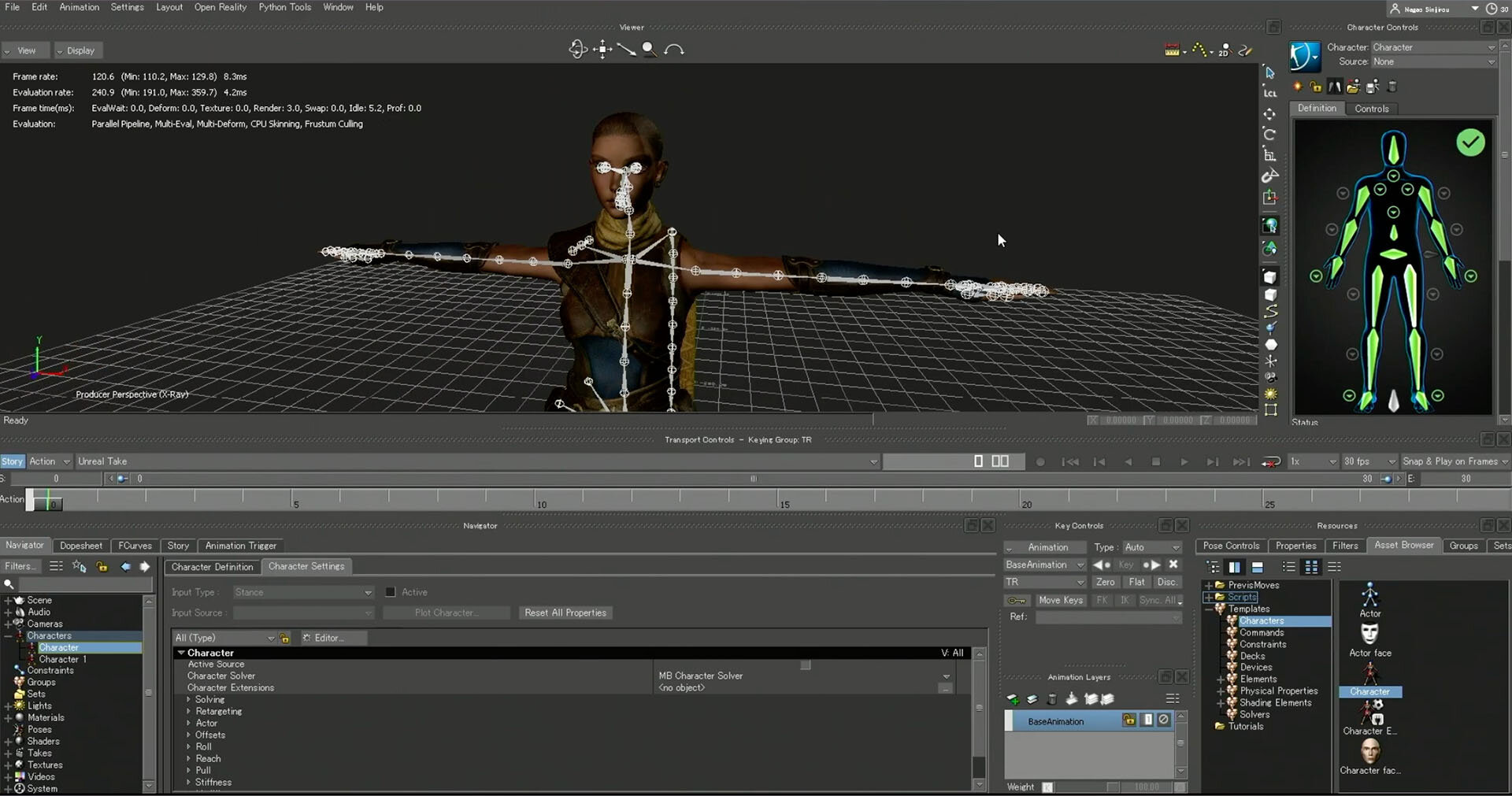

▲MotionBuilderの基本操作。ActorをドロップしてTポーズを表示したところ

次にFullBodyIKリグの機能について説明があった。FullBodyIKリグは文字通り全身のリグであること、骨をマッピングしてキャラクタライズすることで使えるようになること、リターゲットやアニメーションのミラーリングが簡単に行えること、スケルトンとリグの行き来やリグのカスタマイズも簡単に行えることが主な機能として挙げられた。

▲キャラクタライズで骨を登録しているところ

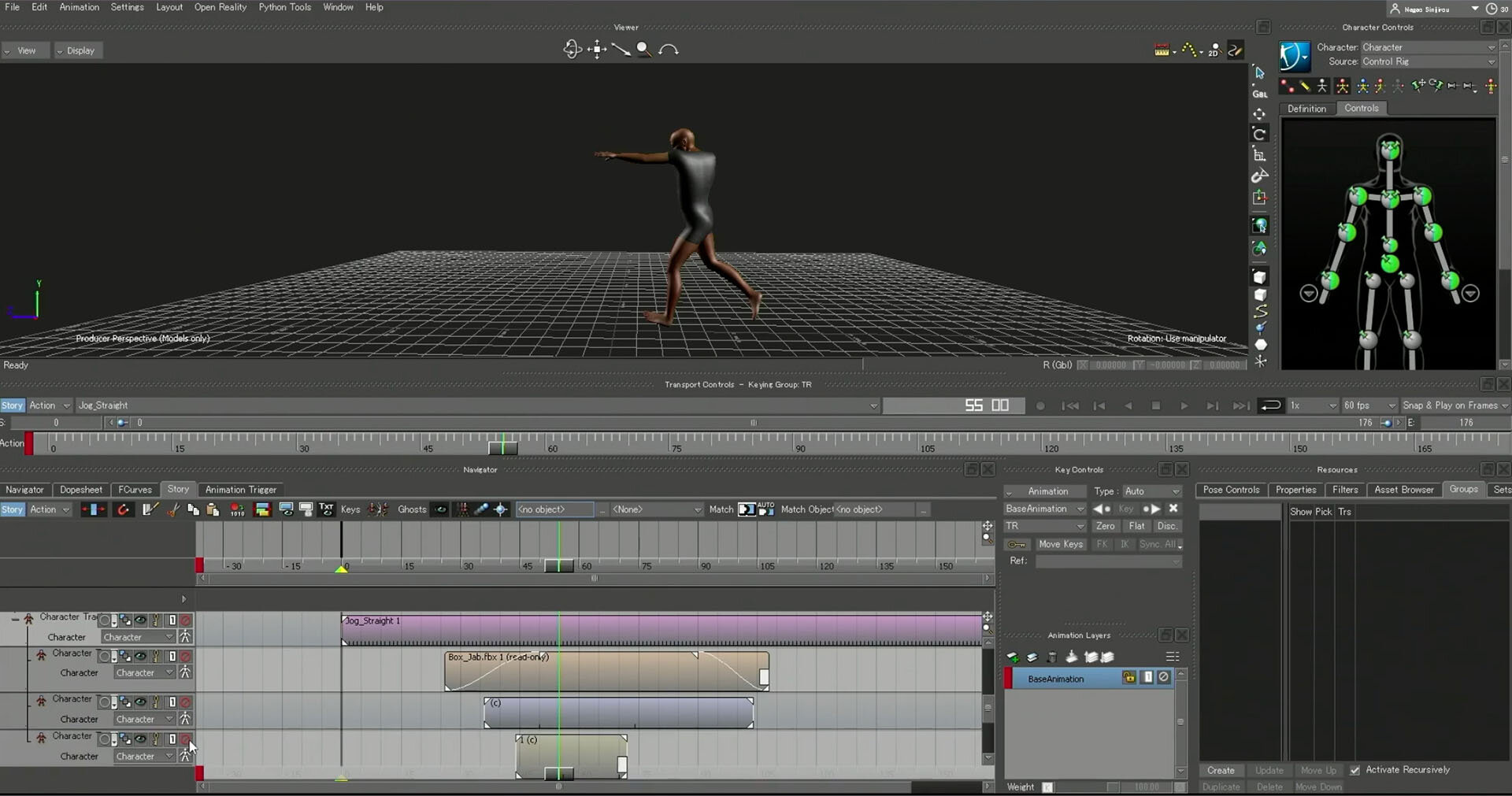

3点目にStory機能の説明があった。Storyとは簡単に言えばアセットをクリップとして扱って、ノンリニア編集できる機能だ。キャラクタライズされていればアニメーションを部位ごとにブレンドでき、アニメーションクリップの切り貼りやスピードの伸縮も簡単にできる。また、カメラを登録してモーションキャプチャのデータを読み込めば、ゲームのカットシーンのようにカメラスイッチングしてのレイアウト制作が可能になる。

▲気になる部分(ここでは腕の角度)があったとき、クリップとしてオフセットもできる

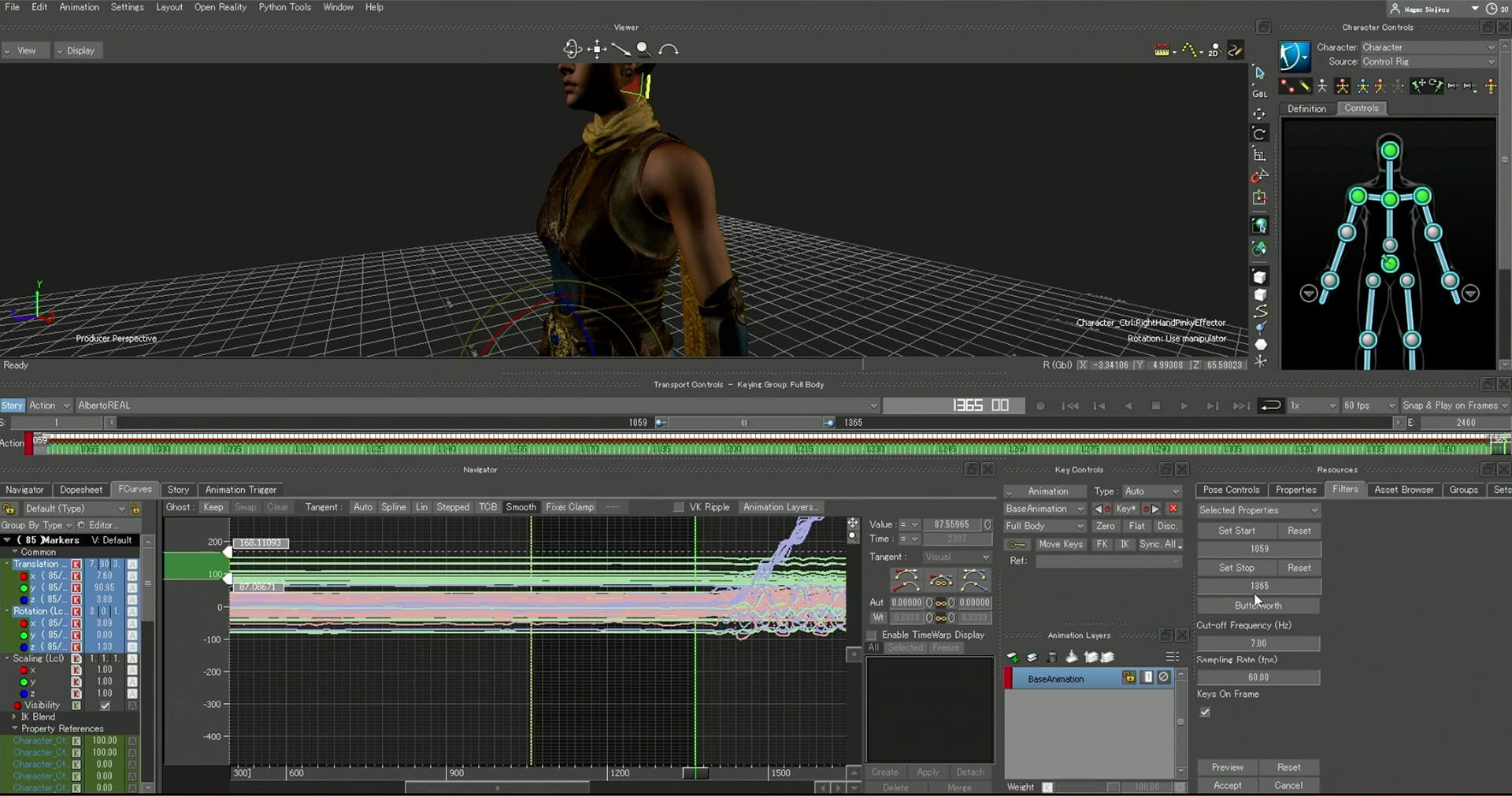

4点目はFilter機能の説明があった。Filterとはキーフレームを処理する機能だ。主にモーションキャプチャデータのノイズ除去に特化している。自作にはなってしまうが、さまざまなFカーブに対してキーを処理するようなプラグインをつくることもできる。

▲FilterのButterworthを使って、人間の動きには無いようなノイズを除去しているところ

最後に応用編としてアプリを交えた使い方が紹介された。紹介されたのはCamTrackARアプリとScaniverseアプリの2つ。CamTrackARはiPhoneでカメラワークをモーションキャプチャでき、有償バージョンであればfbxで出力が可能。またusdz形式のファイルをiOS用に直すと背景データなどスタティックなものをCamTrackAR内で表示できるようになる。ScaniverseはLiDARを搭載したiPhoneで背景などを3Dスキャンできるので、背景のアタリとして利用するアプリだ。こちらは無料でfbxの出力ができる。

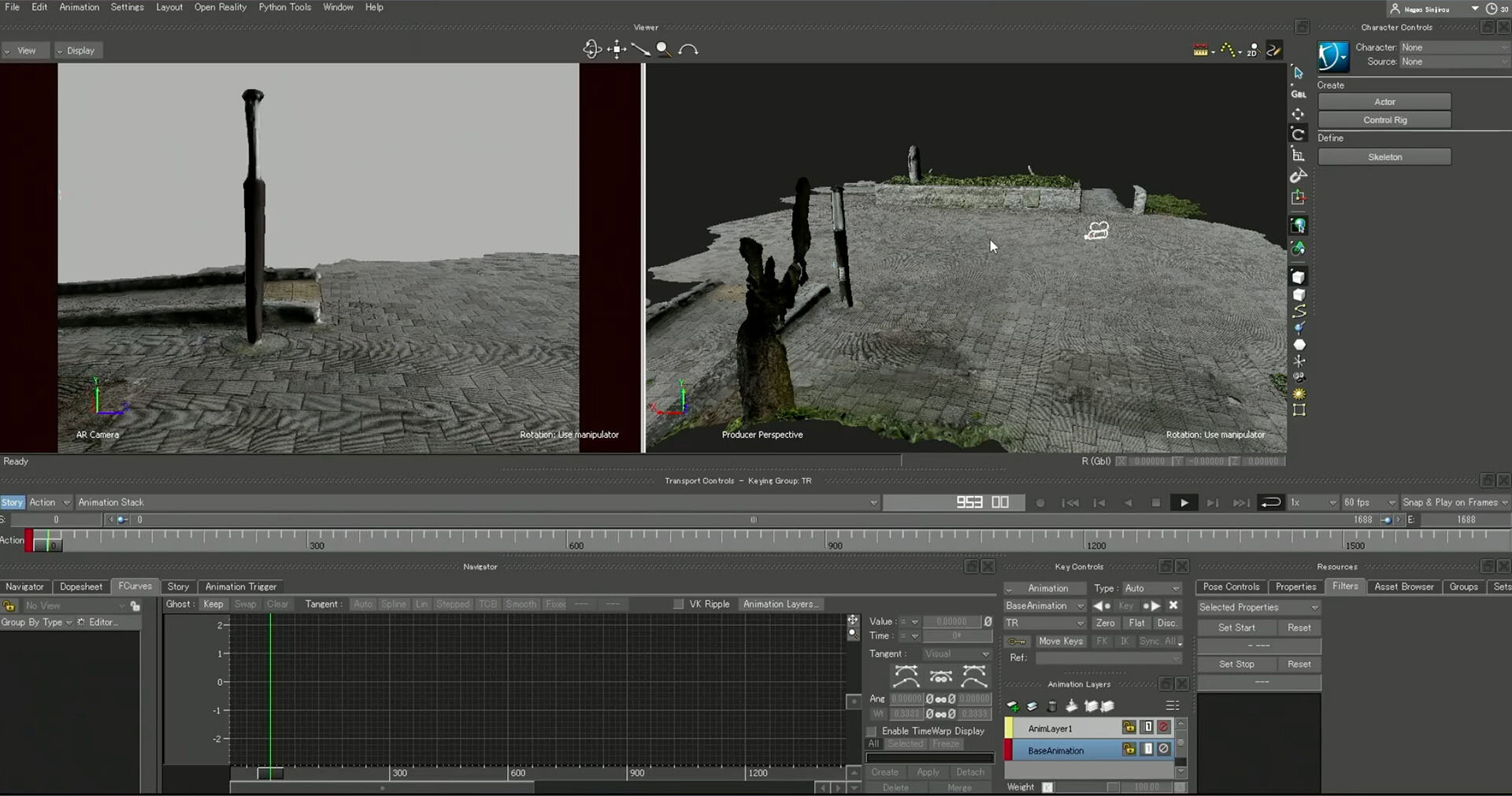

▲Scaniverseでスキャンした背景とCamTrackARでキャプチャしたカメラのデータをマージしたところ

キャラクターとアクターのスケール差を吸収するオリジナルシステムを使用したモーションキャプチャ事例の紹介

gNuuwの布川茂明氏は、1997年から3社でモーションキャプチャの研鑽を積み、2021年に独立。2022年にgNuuwを設立した。モーションキャプチャの参加タイトルとしては『モンスターハンター』シリーズをはじめとする多数のゲームカットシーン、テレビ番組、キャラクターライブの制作に参加。事例として完全リアルタイムによるバンド系キャラクターMVの『ポラポリポスポ』、TV番組の『22/7計算中』が紹介された。

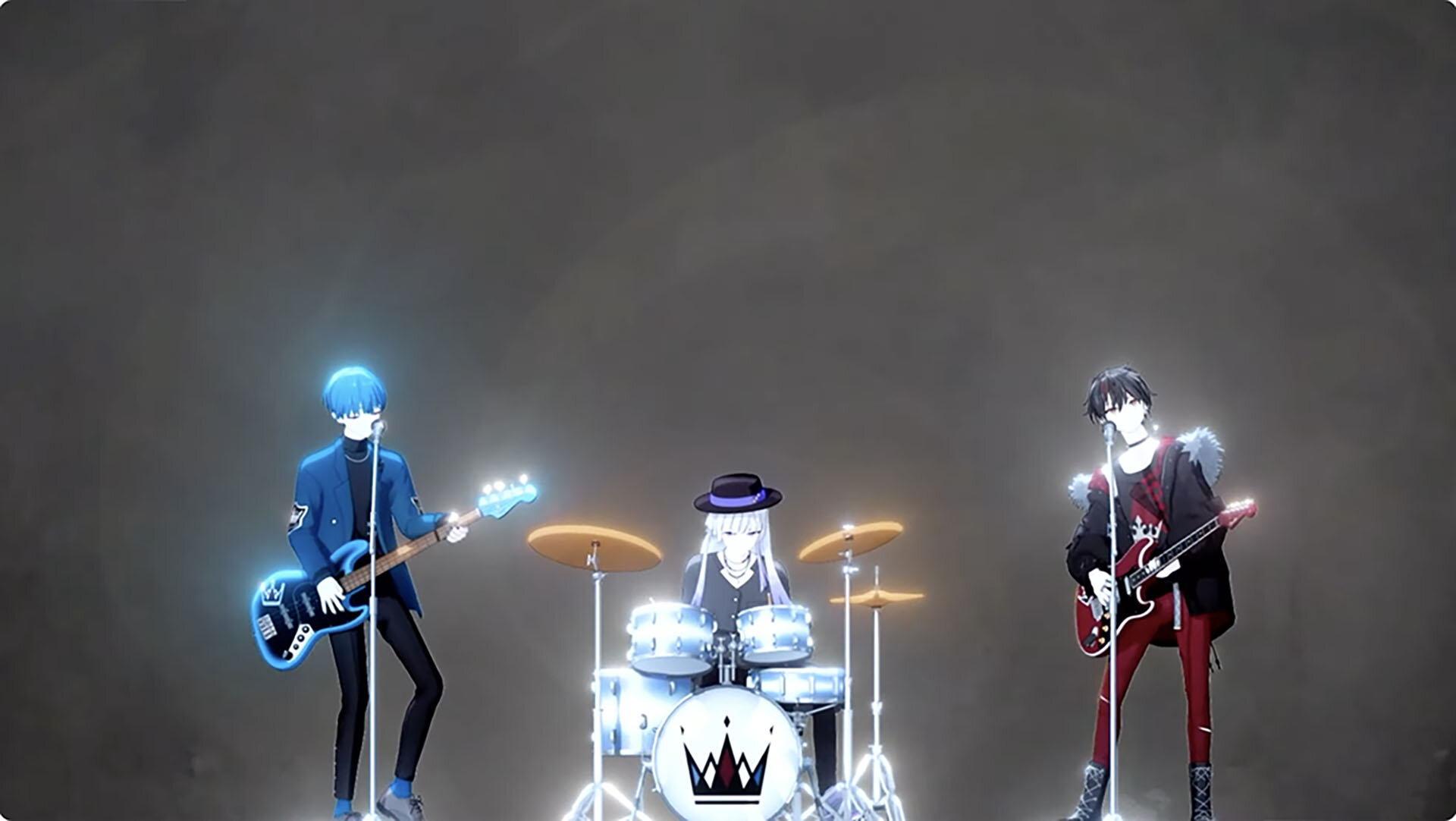

『ポラポリポスポ』は、バンドをモチーフとしたバンダイナムコアミューズメントのオリジナルキャラクタープロジェクト。WAKAZOという3人組(ギター、ベース、ドラム)と、chirp×chirpという5人組(ギター、ベース、ドラム、キーボード、ボーカル)の2つのバンドがYouTubeやラジオドラマ、トーク番組などを中心に展開している。

バンドのキャプチャは増えているが、制作するには工夫すべき点が多いという。ギターやベースの指の部分の処理の難しさや、楽器に塗装材を塗って光っている部分を消したり、ドラムは光る箇所が多い上にバスドラの足が見えないところにあったりするので、ダンスなどのゲームモーションと比べると難易度が高くなるという。

『ポラポリポスポ』は、リアルタイムでの収録のため、収録当日にすべてがきれいに動くように仕込んだ上で、終日完成形のクオリティで撮り続ける必要があった。同時にスタジオ内でフェイシャルとカメラも付けた上で、リアルタイムレンダリングして映像化するという流れになるため、収録と言ってもリアルタイムのキャラクターライブに近い作業だった。そのため、緊張感が高い収録だったという。

完全リアルタイム収録による映像化のことを、布川氏は「ゼロエディットモーションキャプチャ」と呼んでいる。すべてリアルタイムで、処理無しということだ。WAKAZOは3曲を1日で、chirp×chirpも同様に3曲を1日で収録したが、準備は収録当日のみ。キャラクターを壊さない、ノイズを出さない、楽器に手を合わせることに加え、ギター、ベース、シンバル、ハイハット、スティックなど動くものはすべて動かすことを心がけたという。

収録時にこだわったポイントは3つ。技術制限を一切与えない自由演奏、演奏者(アクター)の人選の自由化、可能な限りモーションを自然にしてクオリティを高くする、ということだった。特に自由演奏については、演奏時のパッションを感じられるような、ありのままを撮りたいという思いから演奏者の移動も制限せず、途中から2人で1本のマイクで歌う、観客への煽りや拍手というような演出もテンションを損ねないようにすべて自由に演奏してもらった。それを布川氏側で準備して可能にしたという。

▲『ポラポリポスポ』からWAKAZOの演奏シーン。リアルタイムレンダリングはユークスのALiS ZERO、モーションキャプチャが布川氏。流れ的にはShogun→MotionBuilder→ALiS ZEROとなる

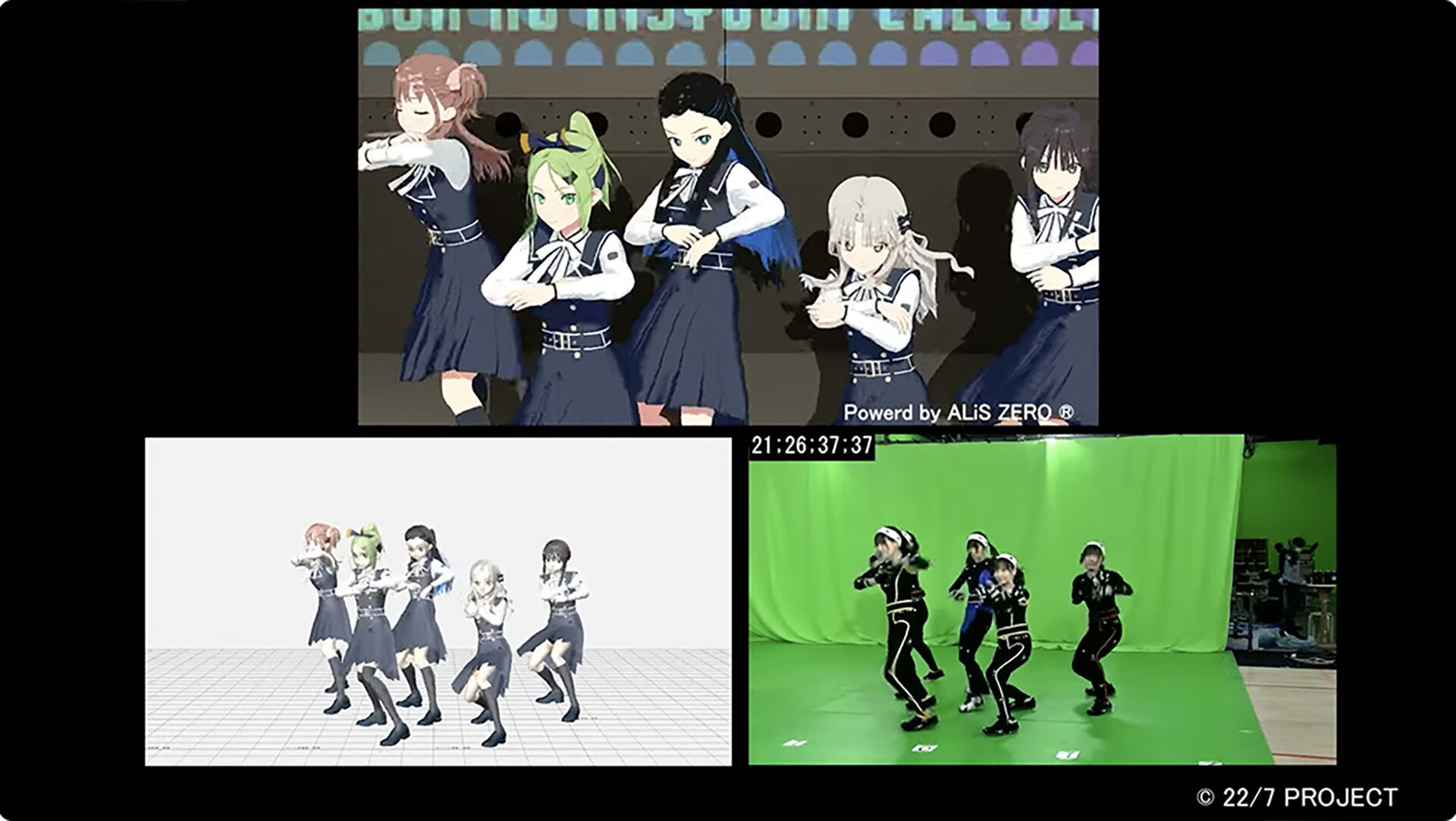

続いて、2つ目の事例として『22/7計算中』が紹介された。2018年7月~2024年3月にTOKYO MXとBS11で放送されていた30分のTV番組で、お笑い芸人の三四郎とアイドルグループのナナブンノニジュウニが、CGキャラクターとなってフリートークやコントをしたり、歌やダンスをしたりする、実写とCGキャラクターが融合するバラエティ番組だ。

TV番組ならではの独特の収録環境やデータ量の多さ、作業期間の短さなど通常のモーションキャプチャとは違った難しさがあったという。小道具も料理で使うクローシュや巨大な風船など、光が反射するものもあった。モーションキャプチャ的には不利な環境でありながらTV番組なので収録を止めることが難しいので、事前準備を入念に行なったという。

収録後の取り組みポイントとしては、実写の芸人が隣に並んでも違和感がないような高いクオリティをゴールとした。その上で、限られた期間内に限られた作業スタッフで対応するため、ポスト処理とMotionBuilderでの調整作業に最大限の工夫をした。収録時もポスト処理のことを考え、企画によって出演者の動きの癖を想定してマーカー数や位置を調整した。

▲『22/7計算中』の収録シーンと放送シーン。モーションキャプチャをダイレクトに使用しているTV番組は放送開始の2018年当時は少なかったため、収録風景が放送される可能性もあった。そのためアイドルとして少しでもかわいく、個性が見えるようにヘッドギアではなく白いヘアバンドを着けている

最後に布川氏から「弊社は、モーションキャプチャでたくさんの人を笑顔にしたり、楽しませたりしたいということを一番のモットーにしています。常にリアルタイムの概念を取り入れつつ、難しいことにもチャレンジしながらモーションキャプチャで人を魅了する部分を形にしながら、少しでも多くの人にモーションキャプチャを知ってもらえたらな、という思いで今後も活動していきます」という言葉があり、セッションは終了した。

モーションキャプチャ関連企業3社の製品セッション

オートデスクからのテクノロジーアップデート

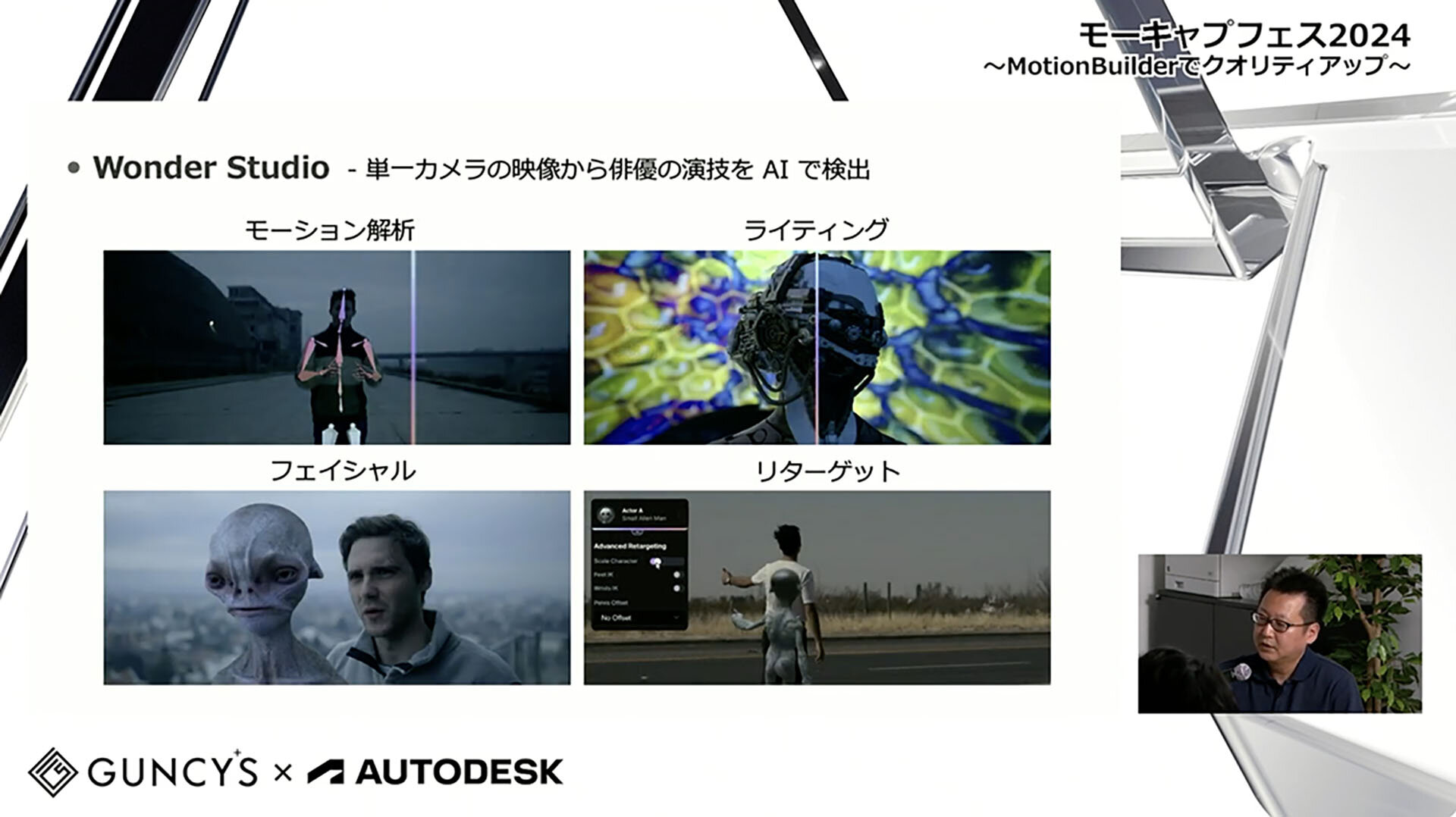

オートデスクの渡辺揮之氏からは、「オートデスクからのテクノロジーアップデート」と題してMotionBuilder2025のUSD対応に関する情報のほか、新たにオートデスク製品の仲間入りをした「Wonder Studio」が紹介された。Wonder StudioはCGキャラクターを実写映像に統合するためのクラウドベースVFX AIソリューションだ。そして、オートデスクの製品ではないが、テクノロジーへの投資を行なっている「RADiCAL」についても紹介があった。RADiCALは、AIとクラウドを活用して映像からモーションキャプチャデータを解析するツールだ。

▲Wonder Studioはモーション解析のほか、実写に合わせて自動でCGキャラクターのライティングを変える機能、フェイシャルアニメーションの対応、縮尺が異なっても読み込めるリターゲット機能などがある

マーカーレスリアルタイムモーションキャプチャシステム Capturyの紹介

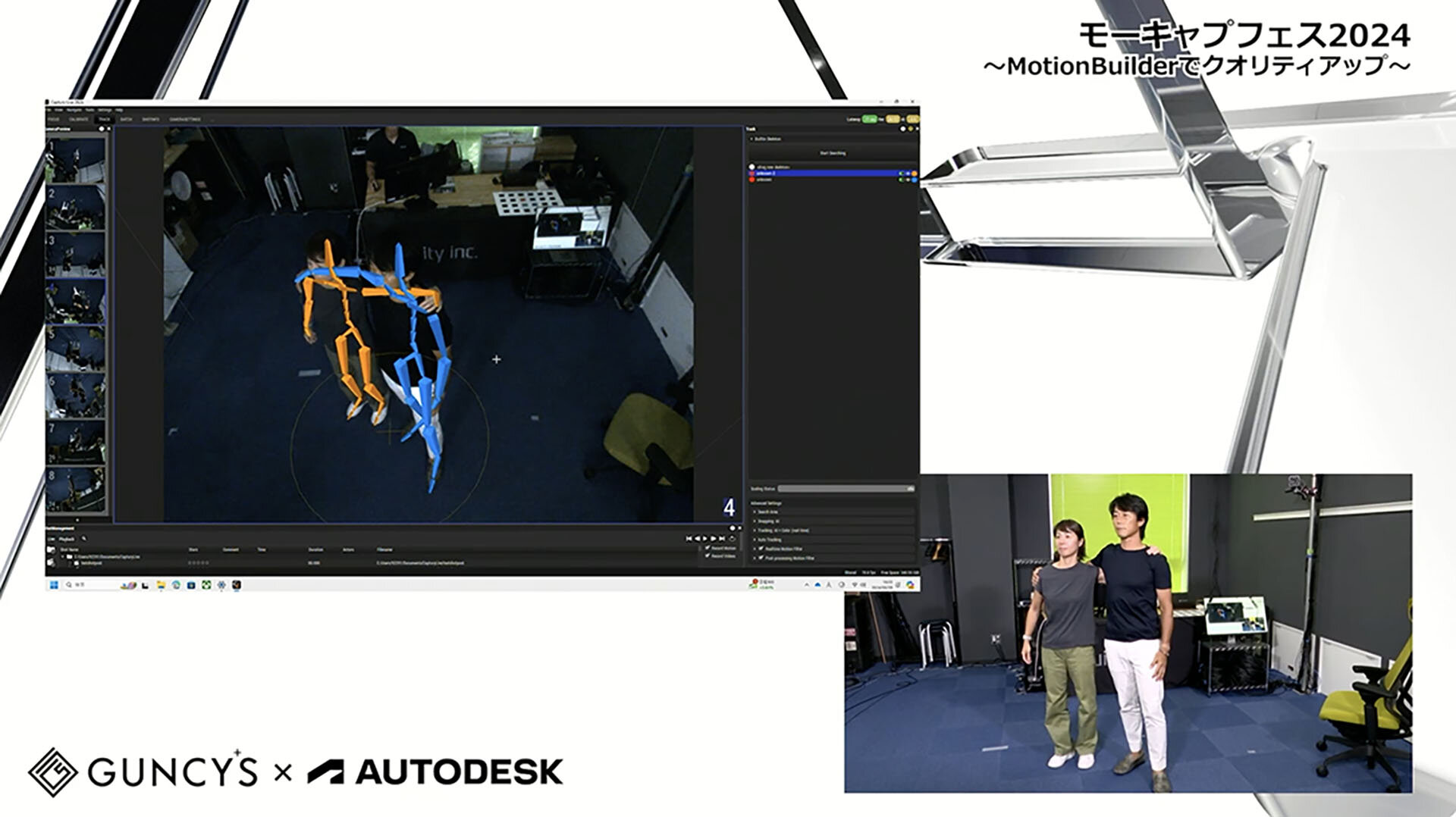

アキュイティーからは、「マーカーレスリアルタイムモーションキャプチャシステム Capturyの紹介」と題して、マーカーを貼付せず、そのままの衣装でリアルタイムにモーションキャプチャを可能とした「Captury」のライブデモが行われた。映像から画像認識で骨格推定してスケルトンを作成するため、体の半面が映らない状態でもキャプチャが可能だ。オプションでフィンガートラッキングやフェイシャルキャプチャを行うことも可能。セッションの後半では、クラブのDJをトラッキングして背景映像にアバターをストリーミングさせるというCapturyの事例が紹介された。

▲Capturyのデモ。2人が肩を組んでも個別にキャプチャされている

15分でわかるXsens MVN

HELTECからは、「15分でわかるXsens MVN」と題して「Xsens MVN」の基本性能紹介と、収録データのMotionBuilderでのポスト処理についてのライブデモが行われた。Xsens MVNは慣性センサー式のソフトウェアで、センサーとノートパソコンだけで収録が可能となる。垂れ幕の下など、物陰に隠れても収録できるなど、特徴を理解しやすいデモとなっていた。慣性センサー式の弱みとしては地場の影響を受けることが挙げられるが、Xsens MVN独自のアルゴリズムで磁場をキャンセリングしているという。

▲Xsens MVNのデモ。垂れ幕の下に隠れても動きを正確にキャプチャしている

モーキャプフェス2024は、モーションキャプチャに特化したイベントだったため、参加者はとても熱心にセミナーやデモンストレーションに見入っていた。会場は多くの人でにぎわっていたので、モーションキャプチャの今後の可能性を高く感じるイベントであった。

TEXT_園田省吾 / Shogo Sonoda(AIRE Design)