AIは、人間の創作活動にとって善か悪か?

過渡期の中、 確かな技量をもったクリエイターたちが全面的に生成AIを取り入れたMV制作にチャレンジ。その舞台裏に迫る。

生成AIをただ使うのではなく、アートとして成立させる

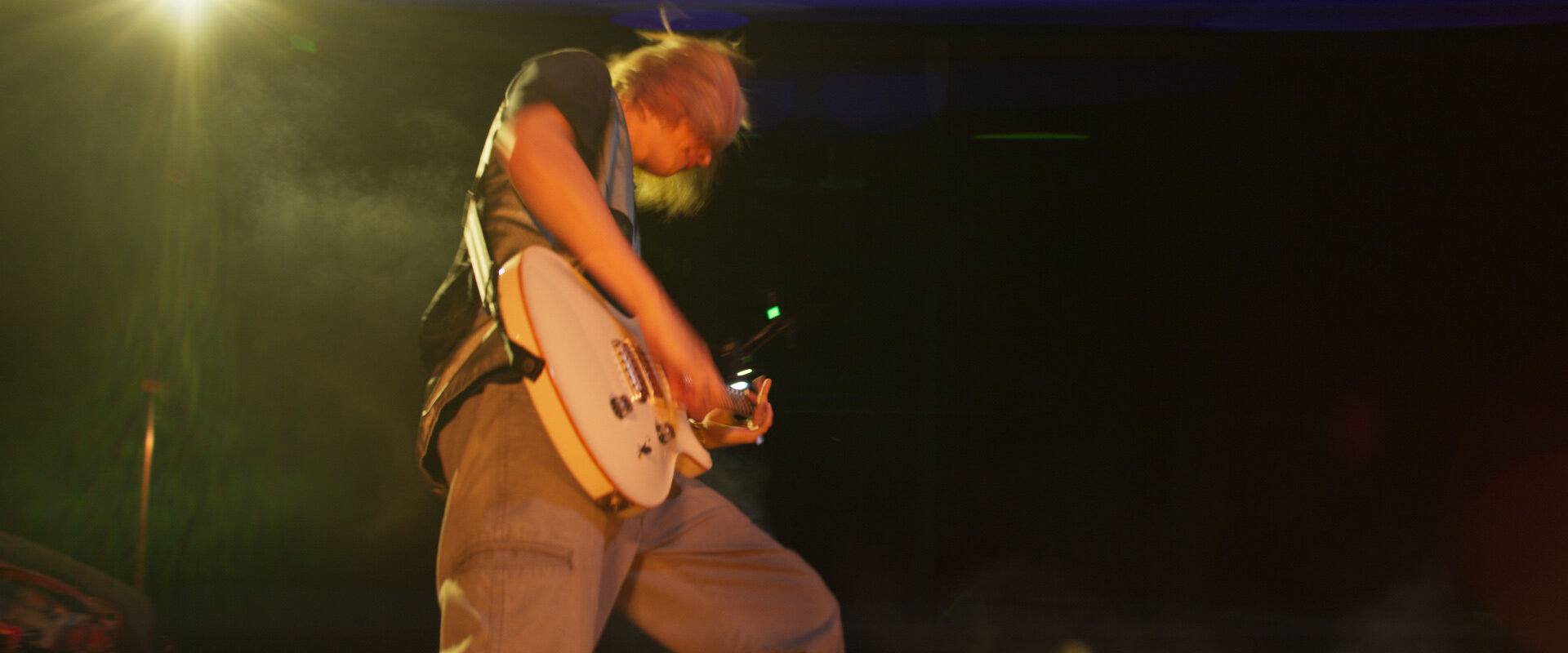

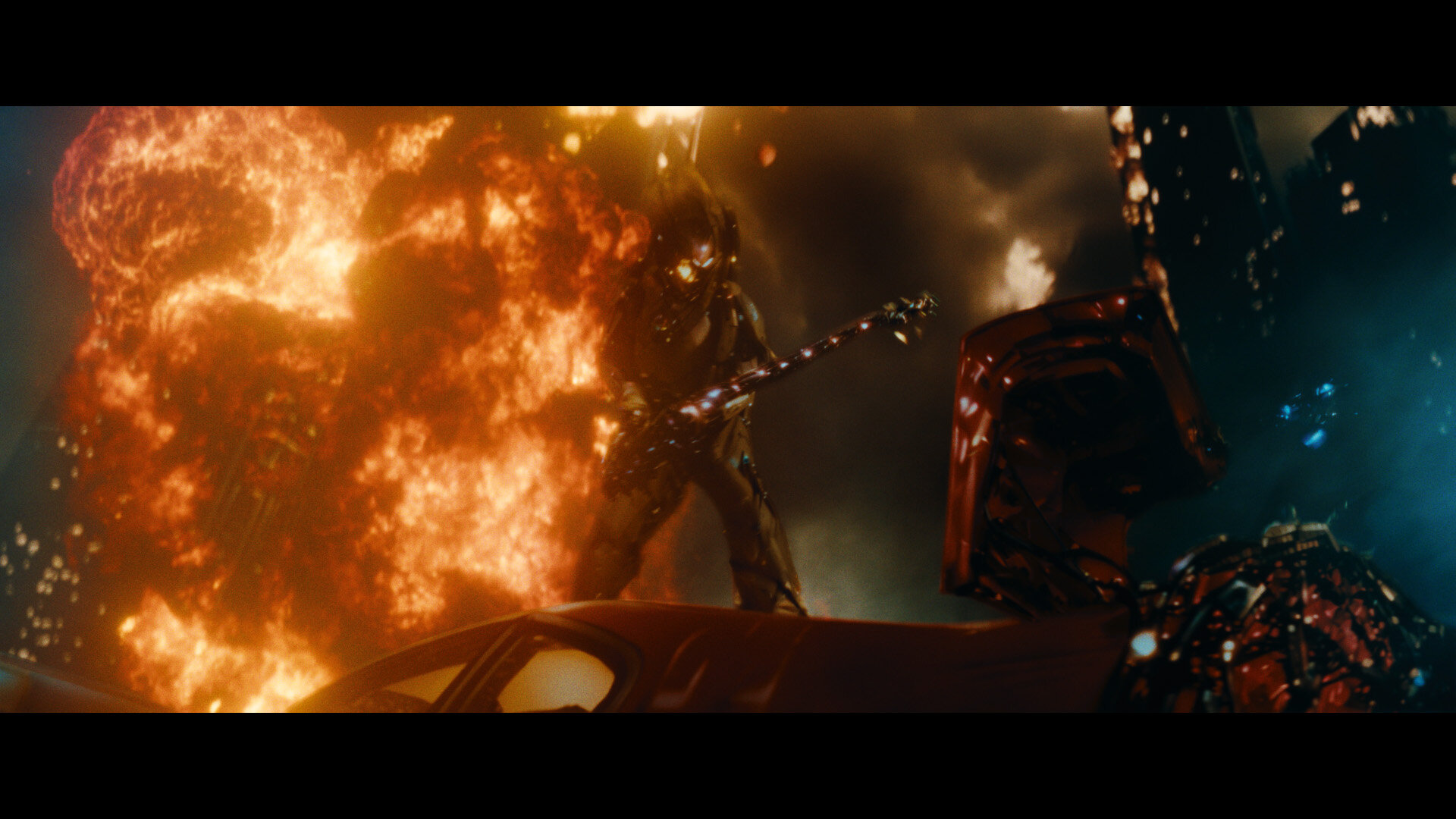

2024年11月14日にYouTubeプレミア公開されて以降、370万回以上視聴されている(※2025年3月6日時点)ONE OK ROCK『Dystopia』MV。

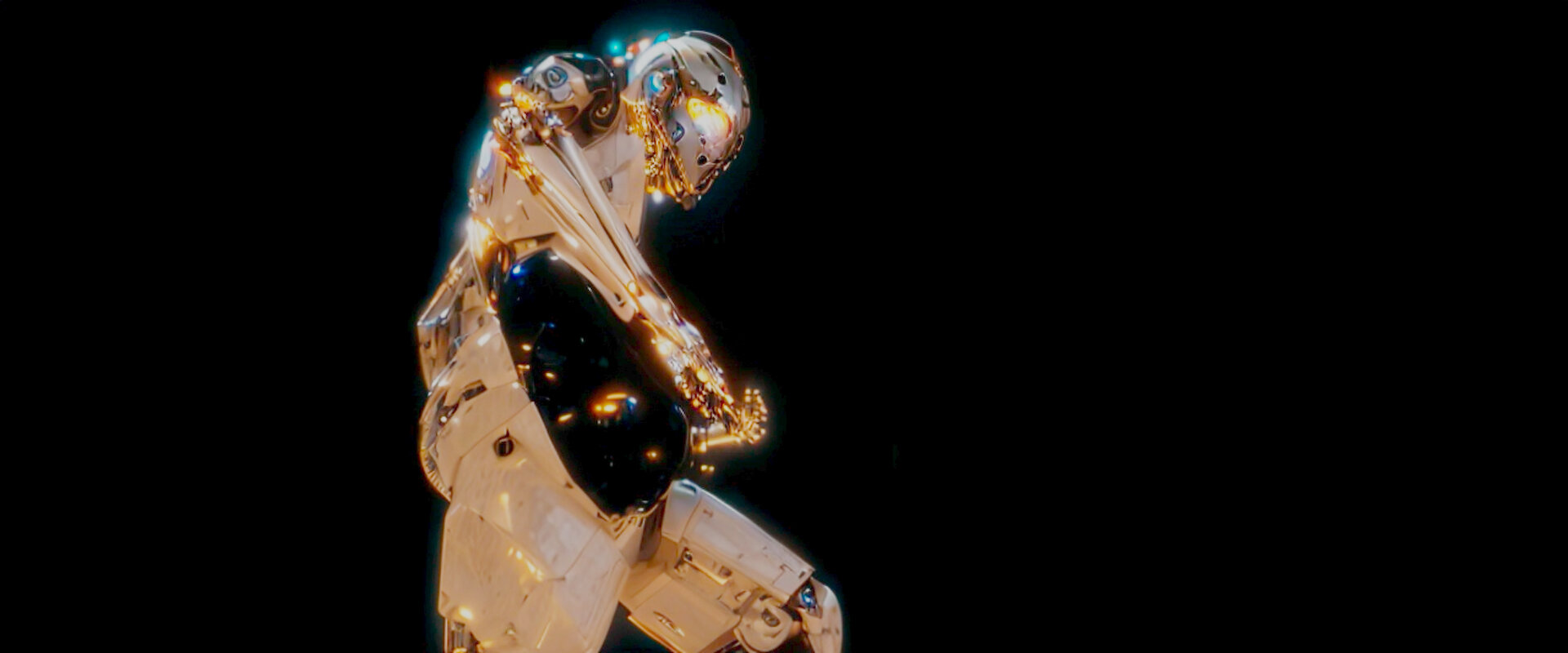

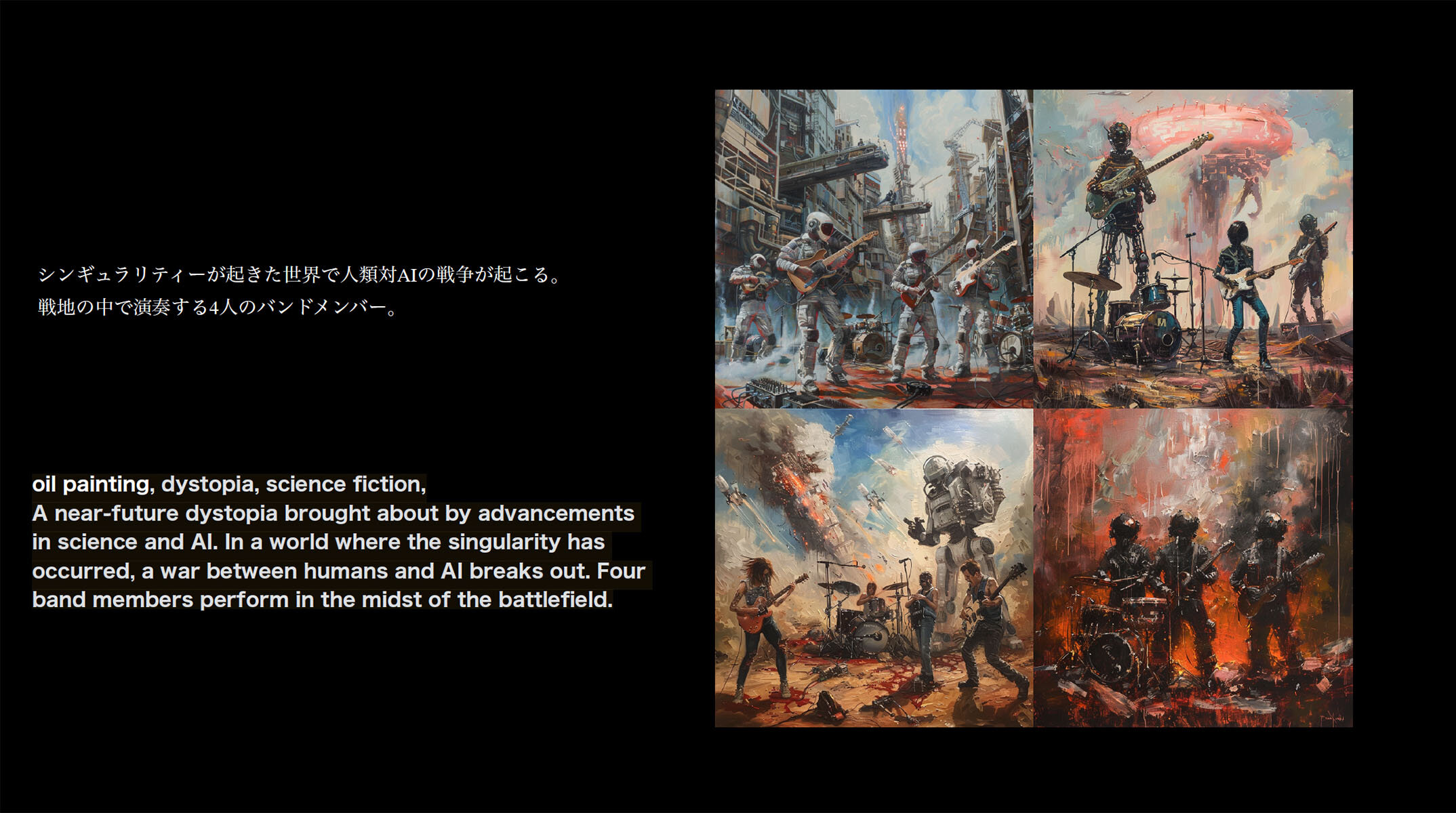

「AIによる未来のディストピアを、AIと共に創造する」というテーマの下、ほぼ全カットの画づくりに画像・動画生成AIが用いられているのだが、アーティストの身体の一部だけをAIで生成したロボットのデザインに置き換えるなど、実写とAI素材とを巧みに組み合わせたコンポジットワークが施されている。

本作の監督を務めた北田一真氏は、企画の経緯を次のようにふり返る。

『Dystopia』MV監督・北田一真(以下、北田):

楽曲のタイトル、歌詞に込められた意味を受けて、AIによってシンギュラリティが起きた後のディストピアを描こうと考えました。この2~3年で、ChatGPTをはじめとするAIを使った新しいサービスや製品が出てきて、急速に進化しています。AIと対立するのか、共生するの か。このMVを観てくれた人たちがそんなことを考えて、さらなる議論が生まれてほしいというアーティストの想いを込めて映像化しました。

-

ディレクター 北田一真氏 -

エグゼクティブPr. 谷ヶ崎深志氏(Stink Films)

——昨年から生成AIを用いた様々なコンテンツが話題をあつめているが、ある程度まとまった長さの映像を商業クオリティで仕上げた作品となると、非常に限られるだろう。主な理由は、フレーム間はもちろんカット間での一貫性 (Consistency)を保つことが困難だからだ。さらに、そこへ実写を組み合わせるとなると難度はさらに高まる。

北田監督:

生成 AIをただ使えばいいわけではない。観た人を感動させる熱量を込める必要がありました。そこで撮影時は、ポスプ ロ工程の都合よりも画としてのカッコ 良さを最優先に、実写だけでも成り立つクオリティを追求しました。

VFXスーパーバイザー 水野正毅氏 (Khaki):

今回は生成AIを必ず使う必要があったので、北田監督の意向を聞いた上でビジネスではなく、アートとして生成AIで画づくりができるクリエイターとして、ダニエルさんをご紹介しました。

-

VFXスーパーバイザー 水野正毅氏(Khaki) -

オンラインエディター 川﨑琴美氏(Khaki)

ダニエルさんとは、本作のAIスーパーバイザーを務めたダニエル・ペレス・フェレイラ氏のこと。 これまでにソニー・ピクチャーズ・イメージワークスやILMなど、世界トップレベルのVFXスタジ オで20年以上にわたってキャリアを重ねてきた同氏は、近年、日本を拠点に活動中である。2017年にMegalis VFXを創業。さらに昨夏には、AI×CGをコンセプトにした新スタジオ「Black Relic」を設立しており、本作にとって最適任者と言えよう。

AIスーパーバイザー ダニエル・ペレス・ フェレイラ氏(以下、フェレイラ氏):

最初に相談を受けたときに描きたいビジュアルが明確だと感じました。そこで「実写素材を提供してくれる際は、どんなエフェクトをかけたい、どんなルックに仕上げたいといったディレクションを具体的に提示してほしい」とお願いしました。生成AIは様々な表現が可能なので、そこが曖昧だとひとつの映像作品として一貫性をもたせるのが難しくなるからです。

ーー画づくりの方向性を提示する上では、北田監督自身が以前から生成AIを用いた映像制作の検証に取り組んでいたことも寄与した。さらに、北田監督がこだわった「観る人を感動させる熱量を込める」という点では、実写素材と北田監督自ら生成したAI素材を巧みに繋ぎ合わせた、オフラインエディター 脇田祐介氏の存在も大きかったという。

北田監督:

オフラインの段階から、僕が仮で生成したAI動画もインサートしていきました。そのクリップをダニエルさんに共有して『この方向でブラッシュアップしてください』とお願いしていまし た。その後、ダニエルさんから上がってきたAI素材に差し替えた上で、さらにカット割りや画づくりを詰めていくという、ある意味ではオンライン編集的な作業もオフラインの段階から行なっていました。

ーーそれだけ前代未聞の画づくりにチャレンジしていたというわけだ。

-

AIスーパーバイザー ダニエル・ペレス・フェレイラ氏(Black Relic) -

デジタルアーティスト 大橋侑來氏(Black Relic)

生成AIを活かせるかどうかは、アーティストの“審美眼”次第

毎日のように新たなAIツールが登場しているが、本作では他者の著作権を侵害するリスクのない手法を用いることが必須条件になったことは言うまでもない。

フェレイラ氏:

コマーシャルな作品なので、今回はローカル環境でオープンソースのソフトウェアに限定しました。Web上で動くサービスはいっさい使っていません。主にはカスタマイ ズしたStable Diffusion 1.5モデルを搭載したComfyUIを使用しました。

ーーワークフローとしては、オフライン編集までは通常の手順で進められたが、ポストプロダクショ ンでも試行錯誤を重ねながら確実にクオリティを高める上では、コンポジターとオンラインエディターを兼務した川﨑琴美氏(Khaki)が重責を担った。

オンラインエディター 川﨑琴美氏(以下、川﨑氏):

オフラインを観て、とにかく迫力を感じました。通常のVFXを考慮した撮影の場合、 CG・VFXチームが現場に立ち会って環境などのリファレンスを収集するものですが、今回の撮影は1日で撮りきったこともあり、映像に込められた強いモーションブラーやストロボライトによる明滅などには恐れがないというか(笑)、素直にカッコ良さを感じました。

当然、合成作業は難しくなるのですが、ダニエルさんから提供されたAI素材の中には実写背景に合成された状態で生成されたものもありました。そのおかげでロボットに置き換わる人物の消しや、フリッカーを細かく合わせる作業が削減され、画面全体に迫力を出す画づくりに工数をかけることができました。

当初の演出プランは、前半を実写主体で描き、後半にいくほどAI素材の割合を増やしていくというものだったが「この作品で問題を提起したい。そのためにも全編に生成AIを取り入れてほしい」というアーティストサイドの強い要望を受けて、ポスプロ作業を進めていく中でAI素材が介在するカットが増えていったという。

フェレイラ氏:

北田監督やカメラマン(越後祐太氏)をはじめ、チームのセンスありきで制作したことが良かったのだと思います。最近では見られないつくり方で新鮮でした。もし私が現場に立ち会っていたら『この撮り方だと、合成作業が難しくなるからやめてください』とか言っていたと思う(笑)。

このつくり方ができたのは、みんなが“良い目”をもっていたから。細かいことは抜きにして、みんなの力がどうすればカッコ良くなるかというクリエイティブに向けられたことが良い結果につながりました。

当然ながら、本作のワークフローは生成AIを用いた映像制作としては決してモデルケースとは言えない。しかし、映像表現がもっている本来の魅力を引き出した上で生成AIを利用するという意味では、正しい使い方と言えるのではないだろうか。

フェレイラ氏:

AIについては、まだいろいろなことが未知数だからアーティストも恐がっている人が多い。自動化されてしまうことに寂しさを感じることもわかります。だけど、クリエイティブの全てが自動化されるわけではない。

今までとつくり方が変わったとしても、必ず新しいクリエイティブのつくり方が生まれてくるから、そういう考え方でアーティストとしての活動を続ければ良いと思う。

北田監督:

クリエイティブの民主化などと言うつもりはありませんが、生成AIを使うことで誰にでもチャンスは与えられるようになるのかもしれません。

未知のものには恐ろしさも感じるけれど、ダニエルさんみたいに恐れずに使ってみる。使わなくても知ろうとすることが大切なんじゃないかと思いますね。

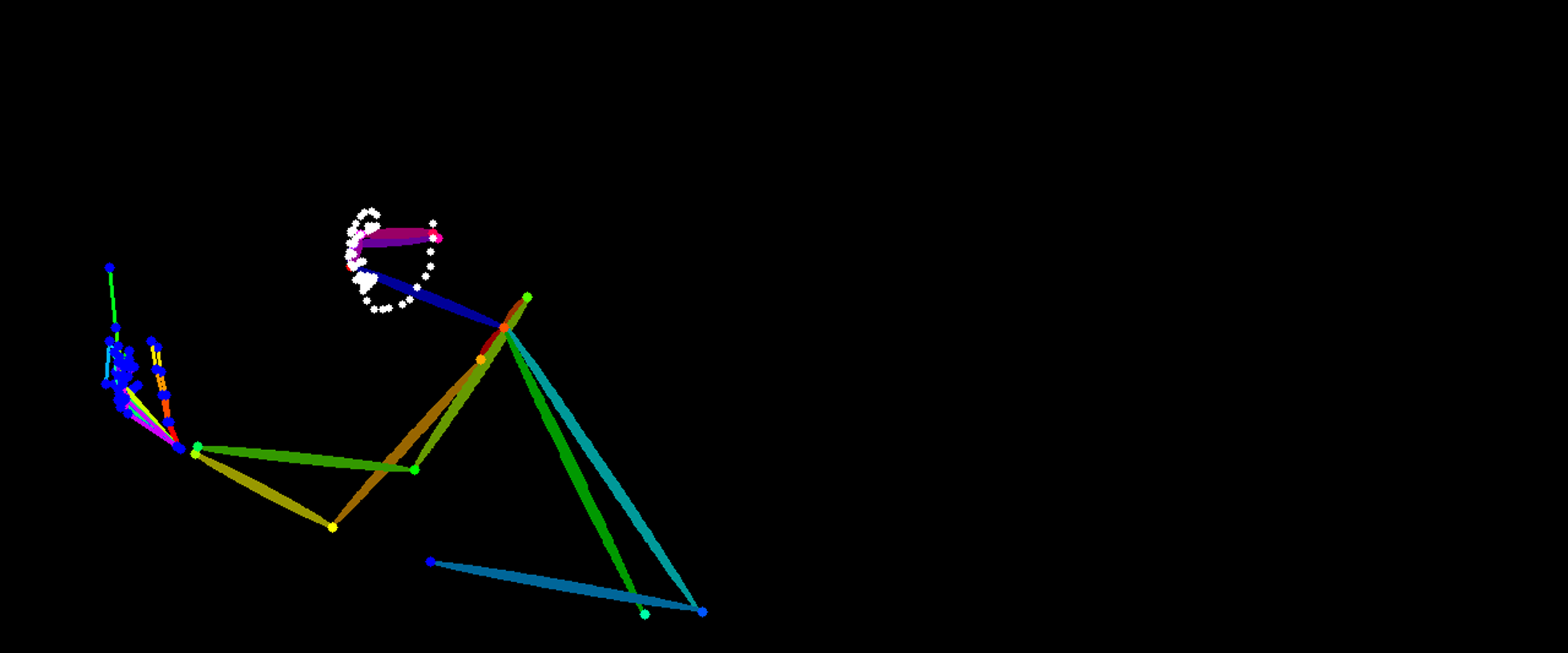

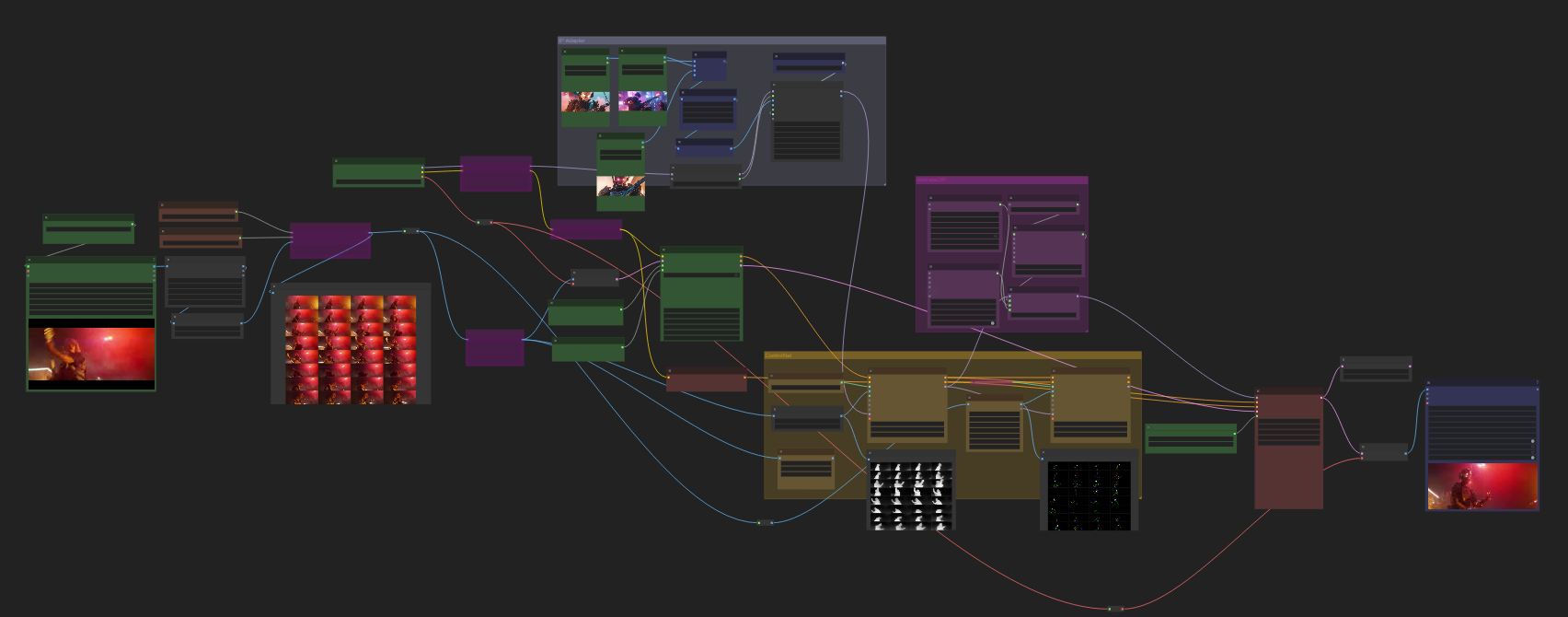

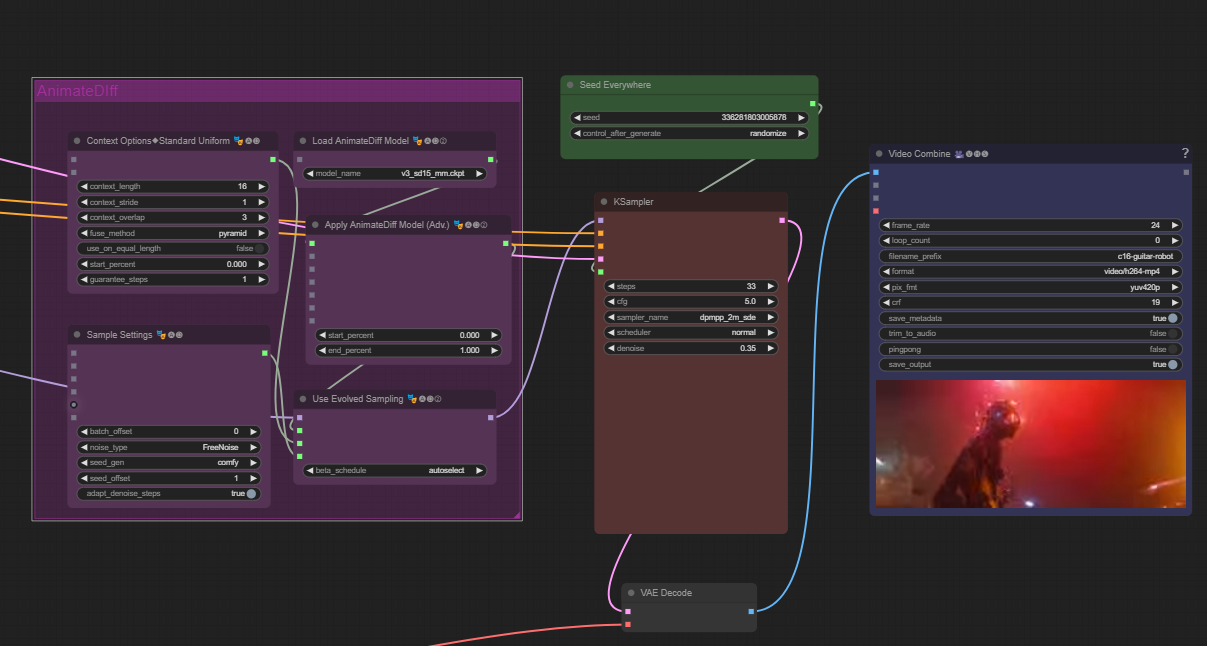

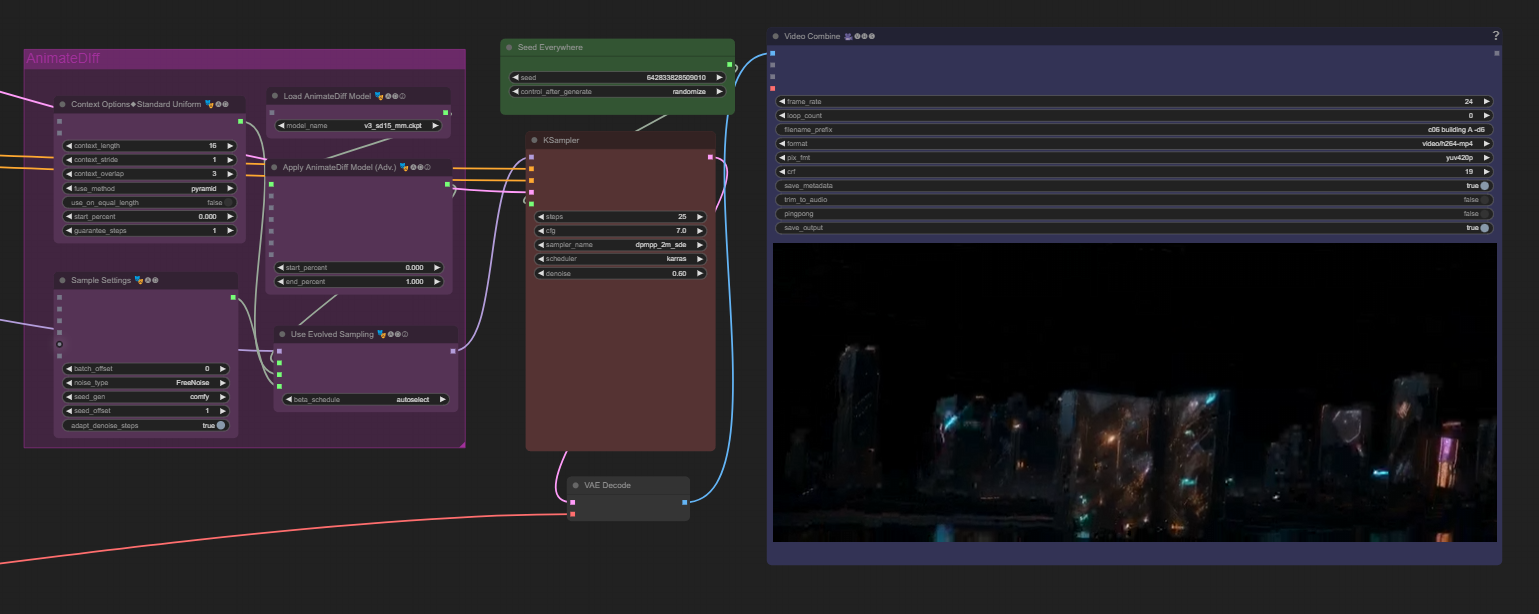

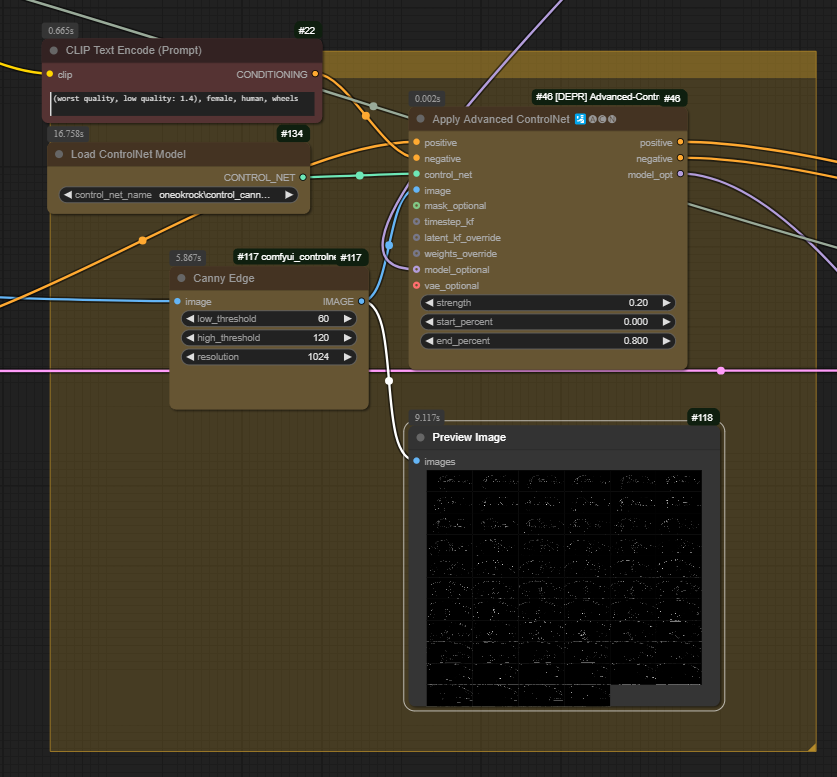

基本的な動画生成AIワークフロー

映像制作の確かな知見の下、様々なパターンを試す

先述した通り、本作では著作権侵害などのリスクを考慮して、ローカルな環境でオープンソースソフトウェアとサービスに限定した上でAIによる動画生成が行われた。

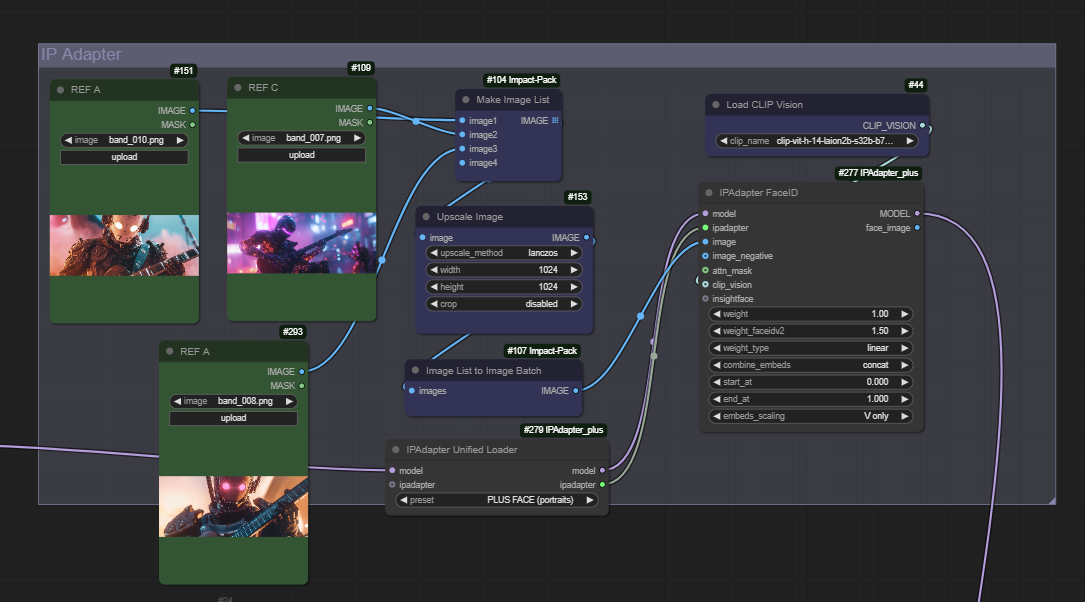

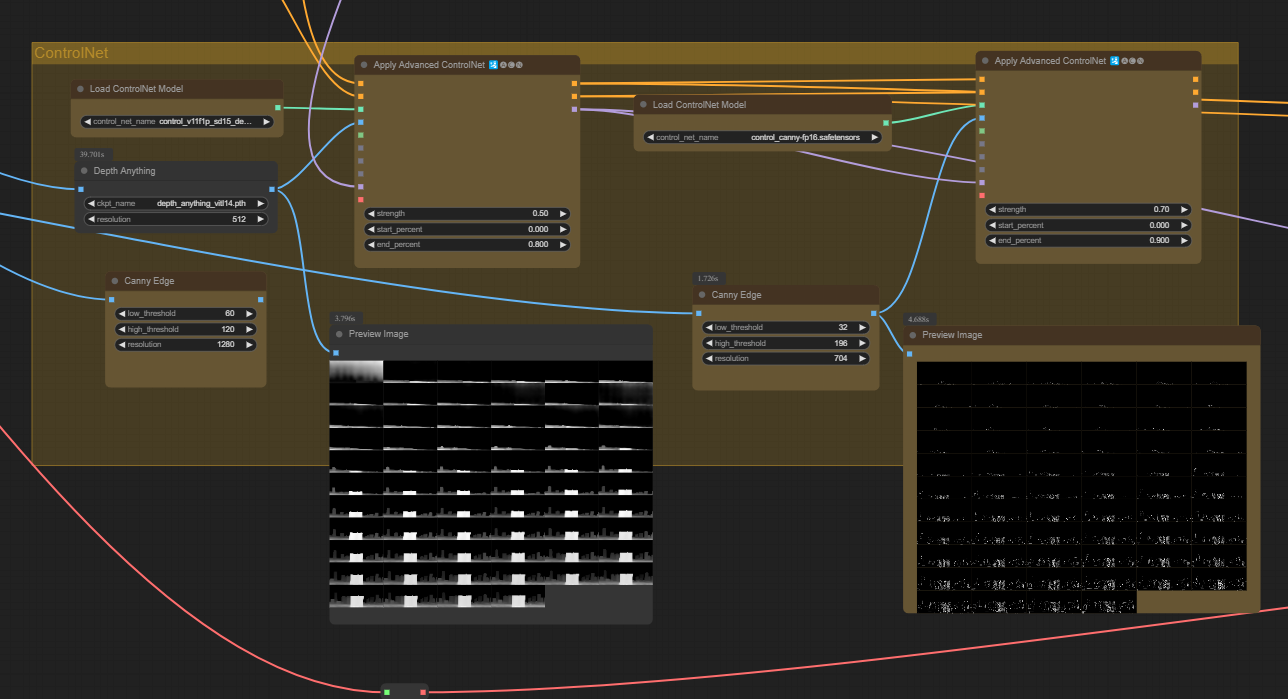

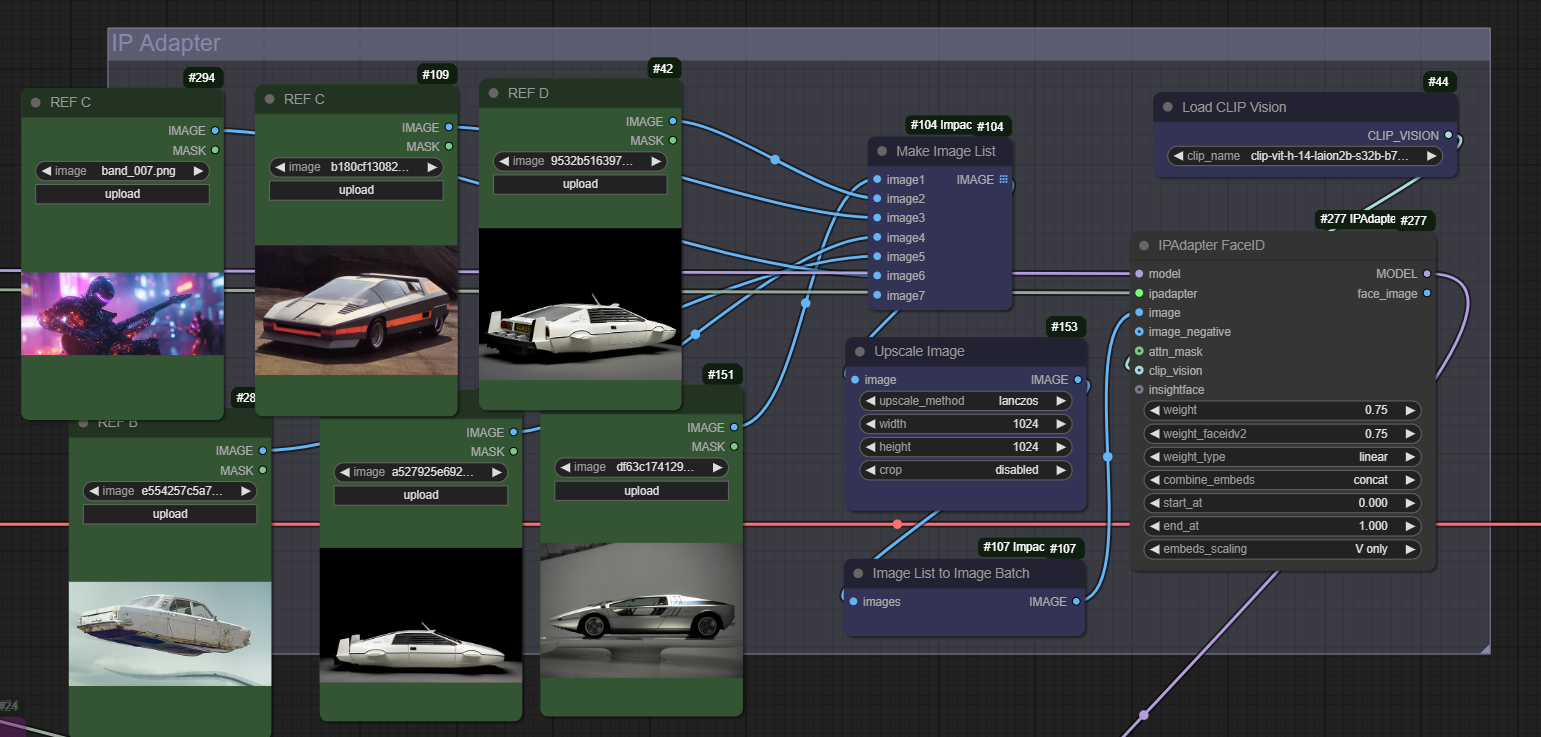

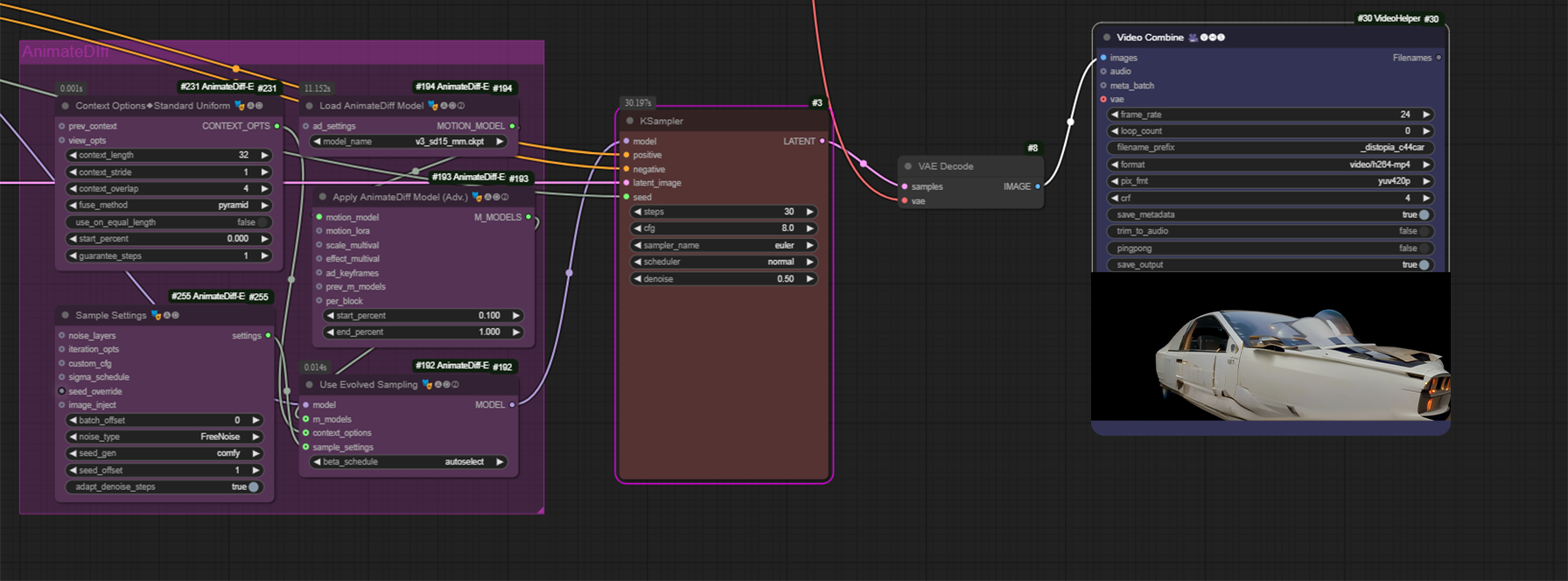

具体的には、Stable Diffusionを操作するためのノードベースインターフェイスComfyUIを使い、モデルにはStable Diffusion 1.5が用いられた。そして一貫性を保つためにIPAdapterをワークフローに取り入れて、全体的なスタイルの統一が図られた。

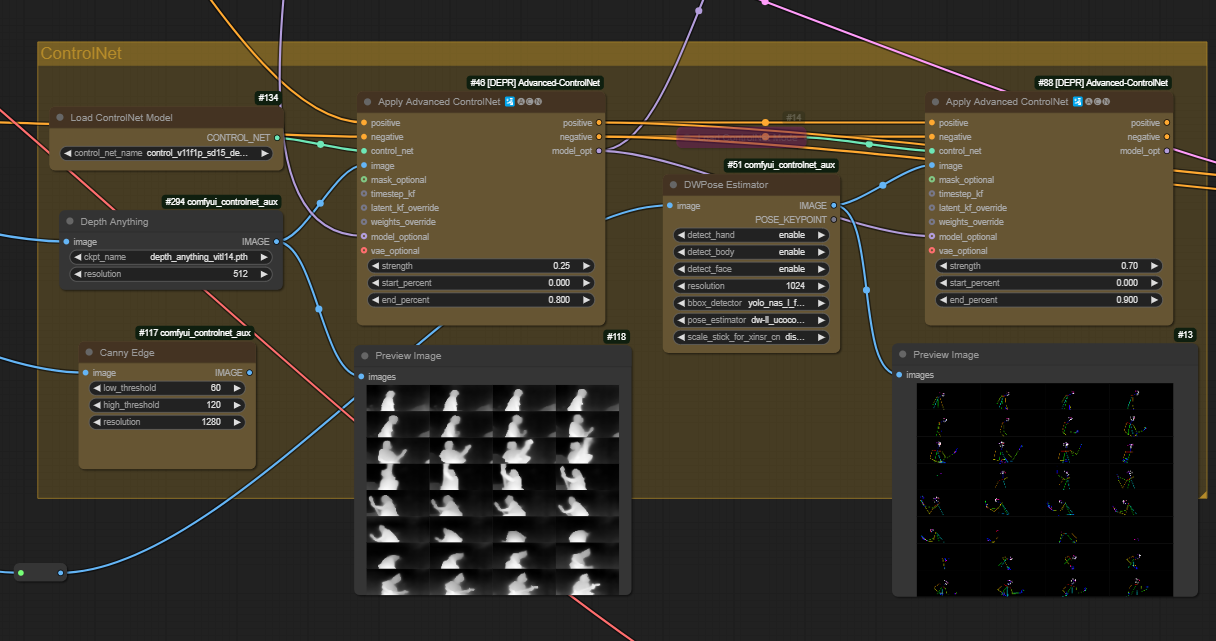

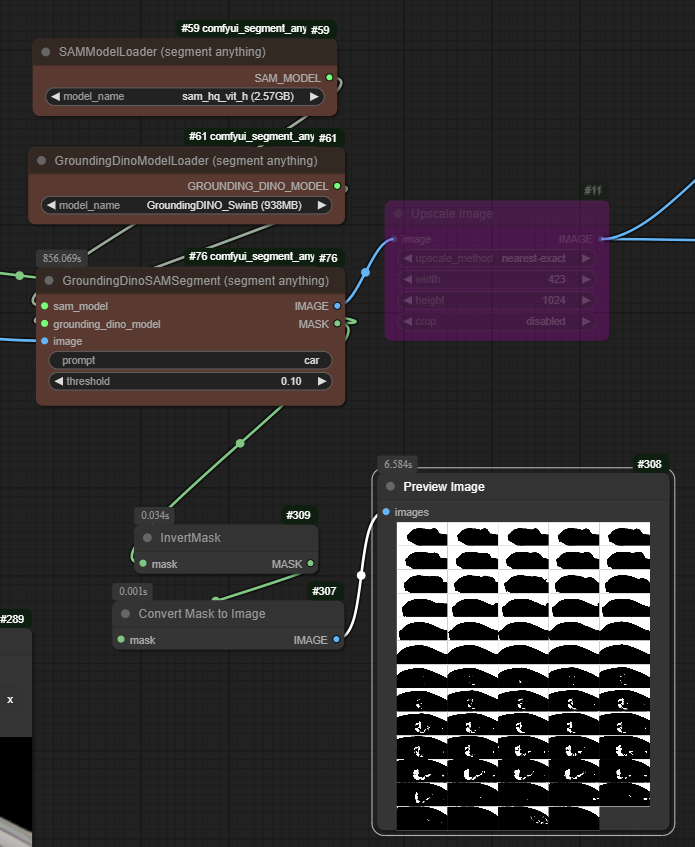

さらにその上で、 実写プレートに映っているアーティストの動き(ポーズ)やシェイプを抽出するために、「OpenPose(棒人間)」「Canny(線画)」、 「Depth(被写界深度)」などのControlNetが使用された。「アーティストやクルマ と背景を分離するための自動マスク生成には、Metaの『Segment Anything Model 2(SAM2)』も使いました」(フェレイラ氏)。

生成結果の一貫性を高めるために、同一のプロンプトを使用すること、さらにIPAdapterに食わせるインプットのリファレンス画像を同じにすることでスタイルの統一を目指した。その上で、ControlNetとサンプリングノイズの調整を行うことで、最も良い結果を引き出すことを目指したという。

また、 アーティストにロボットの要素を合成するためには、OpenPoseでアーティストの体と顔を推定した上で、一貫性を高めるためにサンプラーのピクセルにバイアスをかけることで一体感を高めたそうだ。「OpenPoseはフレームごとに推定するため、動きが速いカメラワークのショットや、アーティストの演技が速いショットでは良い結果を得るまでに何十回も生成することもありました。特に苦労したのが、ドラム演奏の生成でしたね。腕や頭の動きが速く、アーティスト(Tomoya)が長髪で、そこへさらにモーションブラーが加 わると大変でした」(フェレイラ氏)。

なお生成結果について、デプスは実写プレートに合わされている一方、モーションブラーはかかっていない状態だったそうだが、 ダニエル氏いわく今回利用したLLMがオー プンソースのため、モーションブラーがかかった教師データがまだ少ないことに起因したようだ。「モーションブラーが強くかかっ ているトレーニングには、より多くのデータが必要になるはず。現在のテクノロジーを考慮すると、メモリなどのシステム側が追いついていないと思います。現状では、モーションブラーのクオリティを高めたい場合、ポスト処理で3Dモーションブラーをかけるのが最も良い結果が出せると思います」(フェレイラ氏)。

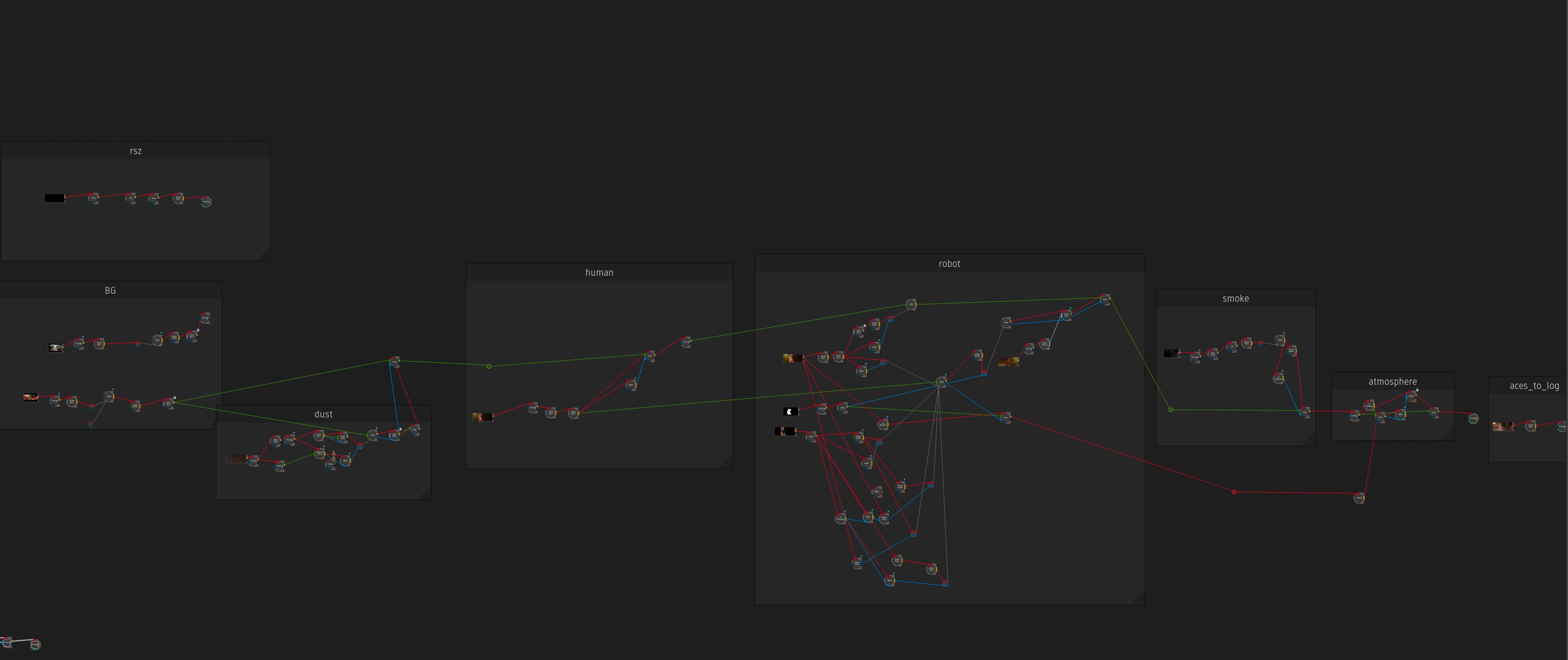

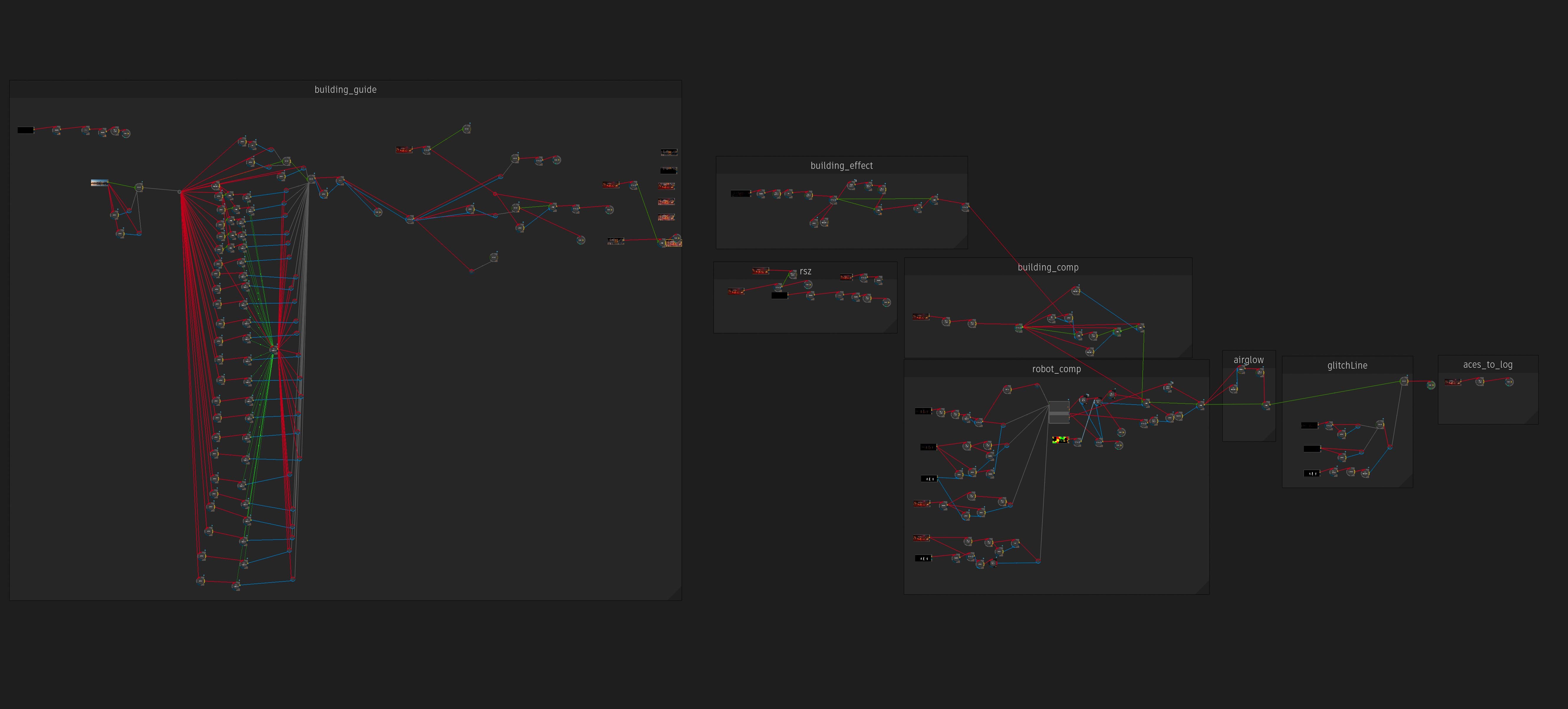

実写プレートを読み込み、ロボットが生成されるまでのAIワークフロー

CUT92ブレイクダウン

オンラインエディターがハブとなる

生成AIは、決して万能ではない。

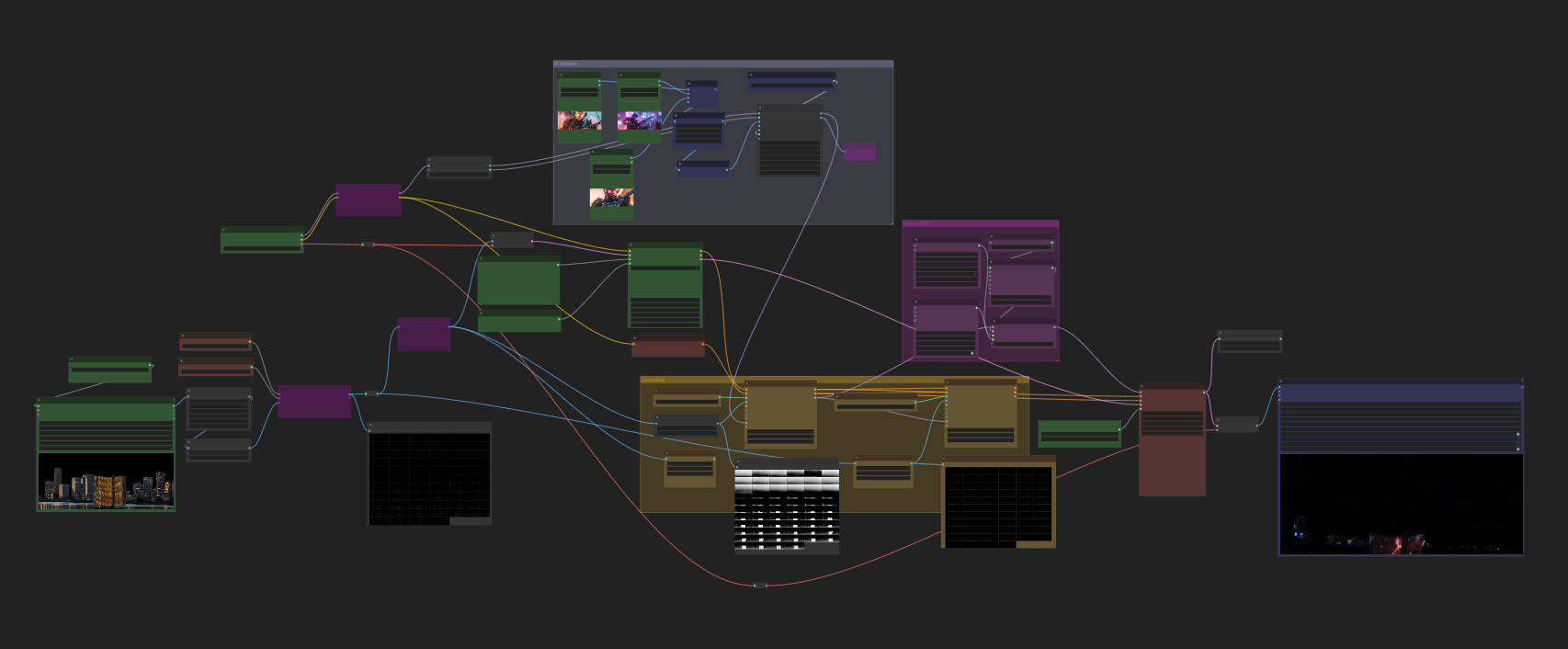

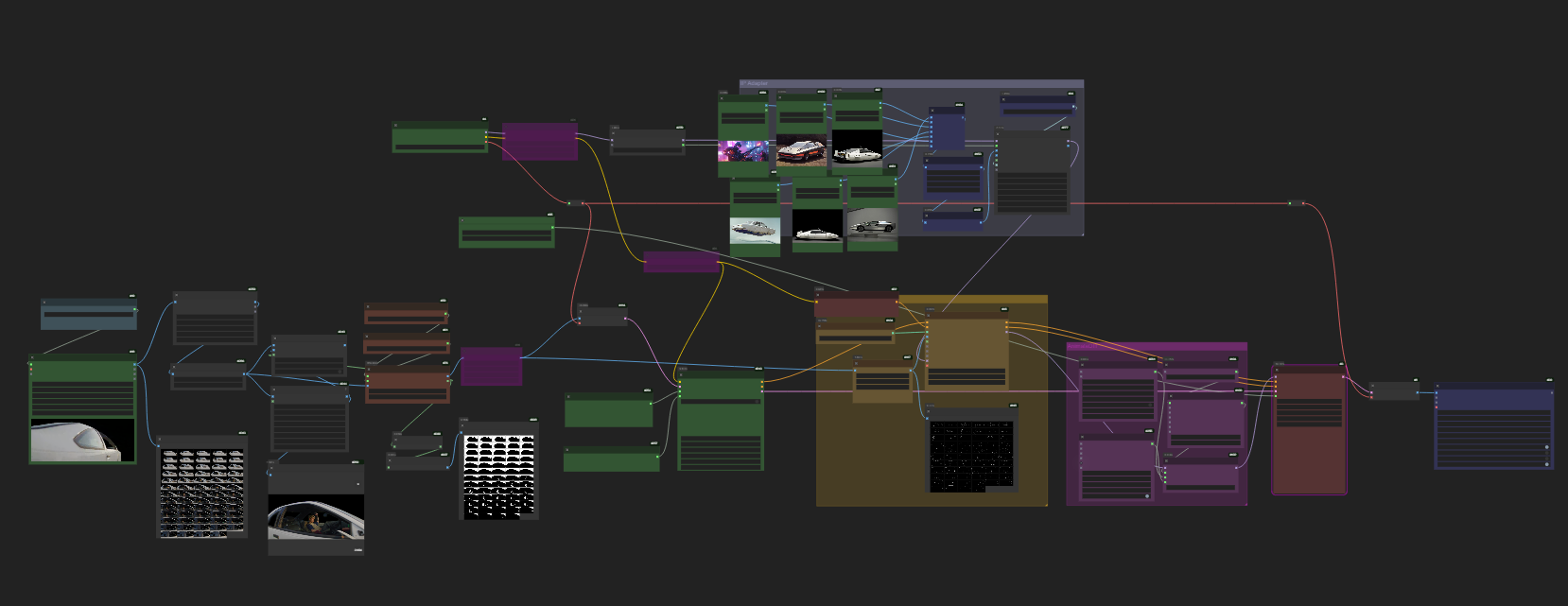

現状の生成AIサービスの特性をふまえ、本作では「ビデオ・トゥ・ビデオ」のワークフ ローが採用された。「今回はオフラインの段階から、AIチームには現場LUTを使用した実写素材が共有されていました。Stable Diffusionは仕様上、H.264コーデックのMP4形式のファイルしか読み書きできないので、オンライン編集では実写プレートをLogデータからACESに変換して作業を行い、AI素材は現場LUTを反転してLogに近づけた上で、ACESに変換し直すという手順をふむことにしました」(川﨑氏)。

またオンライン編集でもカット割りを変更することがあったため、素材の管理もより複雑になったという。「AI素材は、どのバージョンが使えるのかが手探り状態だったため、タイムコードとカットナンバーを利用できない状況でした。そこでオフラインで大元の素材の管理してもらった上で編集データを共有してもらい、川﨑がショット単位で管理をしながら、AI素材に更新があったら川﨑がそのクリップを更新するというかたちで対応しました。オンライン編集でこうした素材の管理を行う上では、Flameの強みが活かせたと思います」(水野氏)。

ロボットのAI素材を部分的にアーティストに合成するといった表現には大量のマスクワークも求められたが、川﨑氏たちオンライン編集チームがDaVinci ResolveのMagic Maskで作業したほか、KhakiのVFXチームと、Annex Digitalにも協力を求めたという。

また通常とは異なるワークフローという意味では、実写プレートとは別にオンライン編集で作成した素材を基に動画生成を行なったショットもあった。「背景にビル群がせり上がってくる表現と、Takaさん(ボーカル)が白いクルマに乗ったシーンの背景については、私がFlameで作成した素材からダニエルさんにAI素材をつくっていただきました。AIを使う前に一段階ふむことで、こんな画づくりもできるんだと発見でしたね」(川﨑氏)。

ある意味では、生成AIによってバーチャルで追撮した素材をオンライン編集の段階でアドオンできたと言えるが、生成AIは決して万能ではないと水野氏は補足する。「今回は、いろいろと手探りをしながら制作する必要がありました。グリッチエフェクトが介在するショットや真っ暗のシーンは本来、ビデオ・トゥ・ビデオには不向きです。北田監督が目指したイメージを実現させるという意味ではベストを尽くせたと思っています。ですが、生成AIを用いる場合でも事前に適切なワークフローを考える必要があります」(水野氏)。

Flameで作成した動画素材(ビル群)を基に、ロボットが生成されるまでのAIワークフロー

CUT「sc12」ブレイクダウン

-

▲ 実写プレート -

▲ ビル群の写真(※最終的な画に含まれないがストックフォトのため、掲載画像にはぼかしを加えている)を使い、Flameで伸びていくアニメーションを作成。実写プレートのカメラトラッキングデータを適用してカメラワークも付けておく。これを生成AIの素材として、Black Relicに出荷

Flameで作成した動画素材(クルマの背景)を基に、ロボットが生成されるまでのAIワークフロー

CUT「44」ブレイクダウン

INTERVIEW & TEXT_NUMAKURA Arihito