中国・アリババグループは7月28日(月)、世界初のオープンソースMoE(Mixture-of-Experts)動画生成AIモデル「Wan 2.2」をGitHubとHugging Face、同社運営の機械学習モデルプラットフォーム「ModelScope」でそれぞれ公開した。テキストまたは画像からの動画生成と、両者のハイブリッドモデルを合わせた3種類のモデルがフルオープンソース(Apache-2.0ライセンス)で提供される。

Ready to be amazed?

— Wan (@Alibaba_Wan) July 28, 2025

Our new concept film is out! See how Wan2.2 makes life bloom in every frame.

See it for yourself! pic.twitter.com/RnDAVld5Z1

Wan 2.2は、複数のエキスパート(専門家)モデルを協調させて特定のタスクを処理するMoE(Mixture-of-Experts)アーキテクチャを動画生成に採用することにより、計算コストを抑えながらモデルのパラメータ数を大幅に増加させた。

モデルは、140億パラメータを持ち、480Pまたは720P出力が可能な「Wan2.2-T2V-A14B(Text-to-Video)」と「Wan2.2-I2V-A14B(Image-to-Video)」、そして50億パラメータを持ち720P出力が可能な統合型モデル「Wan2.2-TI2V-5B(Unified Video Generation)」の3種類がそれぞれオープンソースで提供される。統合型モデルはテキストと画像のハイブリッドで、モデルサイズを小さくすることで計算リソースの消費を抑えた、高速生成に対応するモデルとなる。

また、意図通りのクリエイティブ表現を可能にするため、Wan 2.2にはライティングや色、カメラワーク、構図などを直接操作できる「シネマティックコントロールシステム」が搭載されている。

Day 1Say hello to the incredible dynamic lighting in Wan2.2! Master any mood with different lighting type. We've got: Sunny, Overcast, Moonlight, Fluorescent, Firelight, Mixed, Soft, Hard, Top, Side, Back, Under, Edge, Silhouette... Which light will you try first? Explore… pic.twitter.com/SX1Hp4wxFC

— Wan (@Alibaba_Wan) July 29, 2025

Day 2 let's talk about setting the scene!

— Wan (@Alibaba_Wan) July 30, 2025

Whether you're going for a dramatic Extreme Close-up or a stunning Wide Shot, Wan2.2 has the tools you need. From Ultra Wide-angle to a classic Long Lens, what's your go-to shot to tell a story? Drop your faves below! pic.twitter.com/NyoV2kh5ou

Day 3let's get cinematic! From a dramatic Low Angle shot to a sweeping Aerial Shot, let's capture the world from every perspective.

— Wan (@Alibaba_Wan) July 31, 2025

Try an Over-the-Shoulder shot, a High Angle shot, or a funky Dutch Angle shot with Wan2.2 right now! pic.twitter.com/pjhArn9lza

Day 4let's talk camera movement!

— Wan (@Alibaba_Wan) August 1, 2025

Master the basics: Dolly In to heighten emotion & Dolly Out to reveal the scene. Move with a Dolly Left or Dolly Right. Add drama with a Tilt Up.

Ready to level up? Try a smooth Tracking Shot, a dynamic Circling Shot, a raw Handheld Shot, or… pic.twitter.com/5UIKeCjHzz

Day 5let's frame it up!

— Wan (@Alibaba_Wan) August 2, 2025

Wan2.2 just leveled up with new composition & shot controls. Need a perfect Two Shot with Balanced Composition? Or a dramatic Right-weighted Clean Single?

You got it! Which combo are you trying first? pic.twitter.com/rT654PKqE6

Day 6let's get Subject Movement!

— Wan (@Alibaba_Wan) August 3, 2025

Wan2.2 is bringing the action, supporting a huge range of activities. From the grace of Figure Skating and the unique Bowl-balancing Dance to the energy of Soccer and Skateboarding, what will you create? Show us your dynamic scenes! pic.twitter.com/k5ETdXsCyC

Day 7let's talk about expressions!

— Wan (@Alibaba_Wan) August 4, 2025

Wan2.2 can now capture every feeling. From Joy and Anger to complex states like mixed-emotion or a cheeky "Blow a kiss".

What emotion will you bring to life first? pic.twitter.com/o5xD8qVhMH

モデルはGitHubとHugging Face、そしてModelScopeで公開されているが、ModelScopeではモデルの探索や、Web上での推論とトレーニングが行える。

■Wan(公式ページ)

https://wan.video/welcome

■Easy Creation with One Click - AI Videos(公式ユーザーガイド、英語)

https://alidocs.dingtalk.com/i/nodes/EpGBa2Lm8aZxe5myC99MelA2WgN7R35y

■Wan2.2(GitHub)

https://github.com/Wan-Video/Wan2.2

■Wan-AI(Hugging Face)

https://huggingface.co/Wan-AI

CGWORLD関連情報

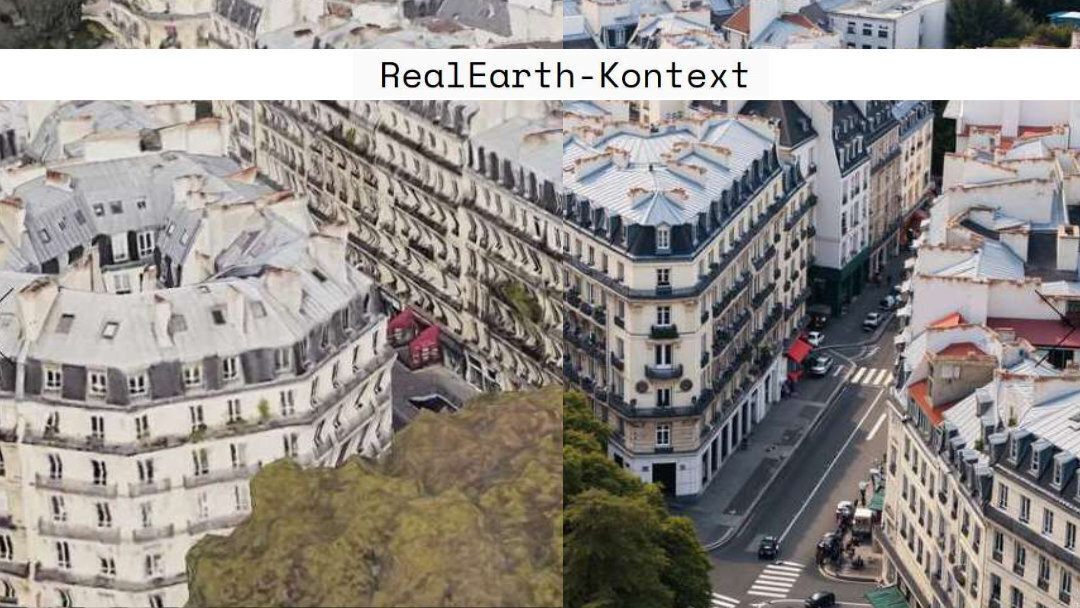

●低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換! Ismail Seleit氏がFLUX Kontext LoRAのトレーニングで実現、無料ダウンロード可能

Ismail Seleit氏が自身のLinkedInで「RealEarth-Kontext LoRA」のリリースを発表。低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換できる無料のモデルで、同氏が運営する建築デザイン向け画像生成AIワークフロー支援サイト「form-finder」からダウンロードできる。

https://cgworld.jp/flashnews/01-202507-RealEarth-Kontext.html

●画像生成AI「Akuma.ai」の新機能「リアルタイム生成 v2」リリース! 大ざっぱな描画や画像からリアルタイムでイラストを生成

Kinkakuが画像生成AIサービス「Akuma.ai」に「リアルタイム生成 v2」機能を追加、公開。2024年3月にリリースしたリアルタイム画像生成機能「AIキャンバス」の後継機能で、同社によるとクオリティは4倍になったという。

https://cgworld.jp/flashnews/01-202507-Akuma-ai.html

●動画生成AI「Niji Video」リリース! アニメスタイルに強いMidjourney×Spellbrushの生成AI「にじジャーニー(niji・journey)」新機能

画像生成AIのMidjourneyとSpellbrush(Sizigi社)は、両者が共同開発した生成AIサービス「にじジャーニー(niji・journey)」の新機能として、動画生成機能「Niji Video」をリリース。利用には有料サブスクリプションへの加入が必要。

https://cgworld.jp/flashnews/01-202507-niji-journey-Video.html