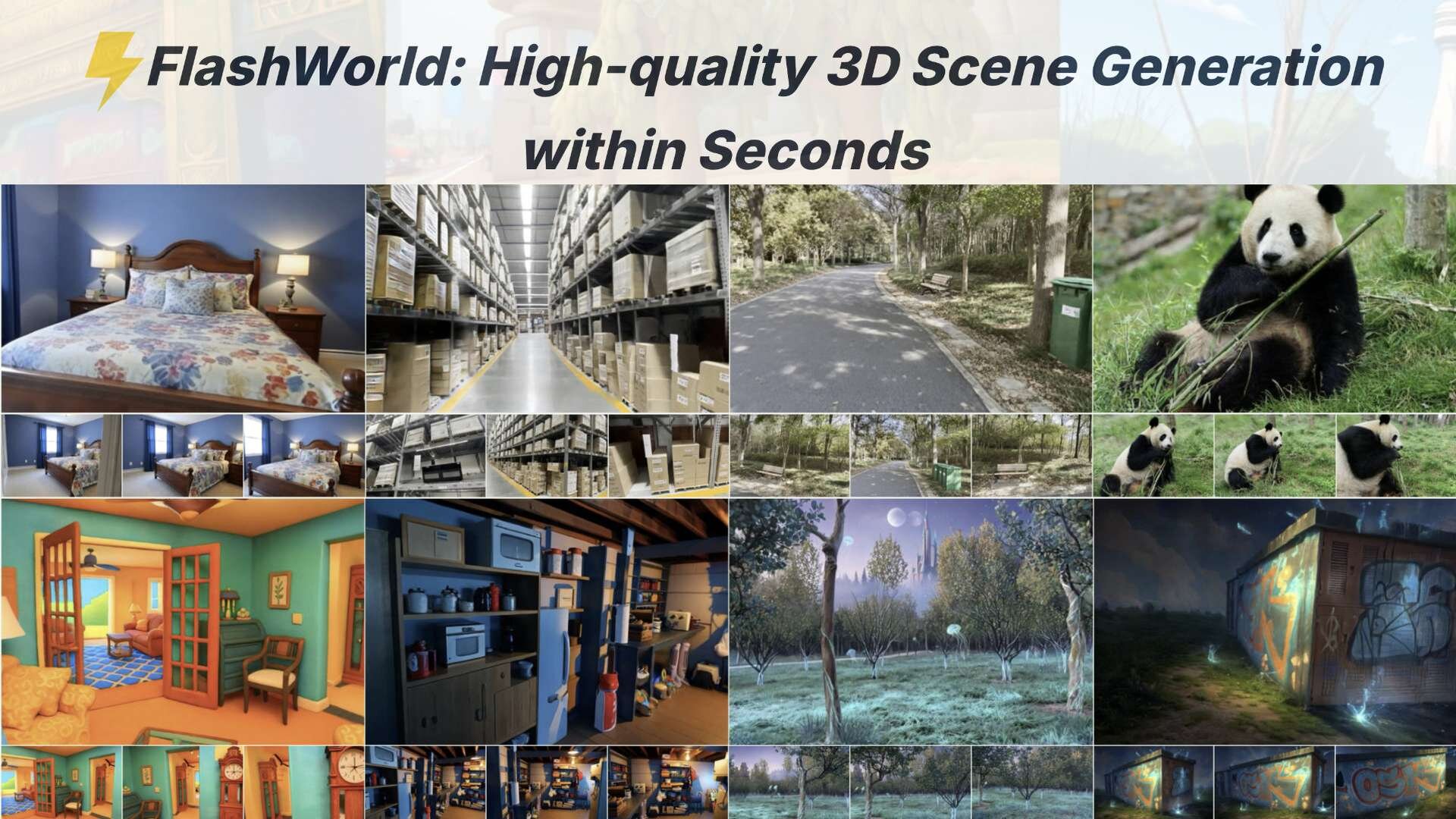

廈門大学MAC Lab、テンセント、復旦大学Yes Labからなる研究チームは10月16日(木)、単一の画像またはテキストプロンプトから高品質な3Dシーンを、単一GPUを用いて5〜10秒程度で生成する「FlashWorld: High-quality 3D Scene Generation within Seconds」を発表した。ライセンスは現在、学術研究目的でのみ利用可能なCC BY-NC-SA 4.0。

Generating 3DGS scenes in 5 seconds on a single GPU#FlashWorld enables*fast* (10~100x faster than previous methods) and*high-quality* 3D world generation, from a single image or text prompt.

— Tengfei Wang (@DylanTFWang) October 16, 2025

Code: https://t.co/VH9IyfFx63

Page: https://t.co/CildGfyJck pic.twitter.com/rqyKsisLRF

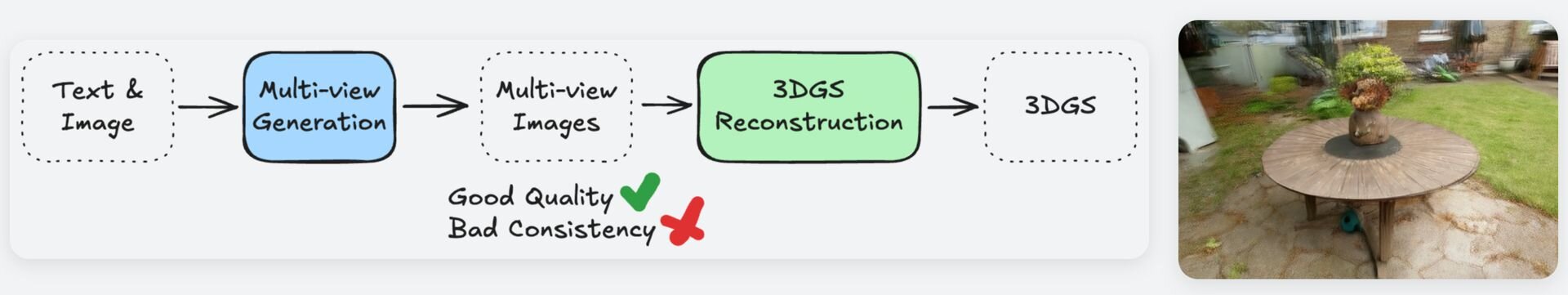

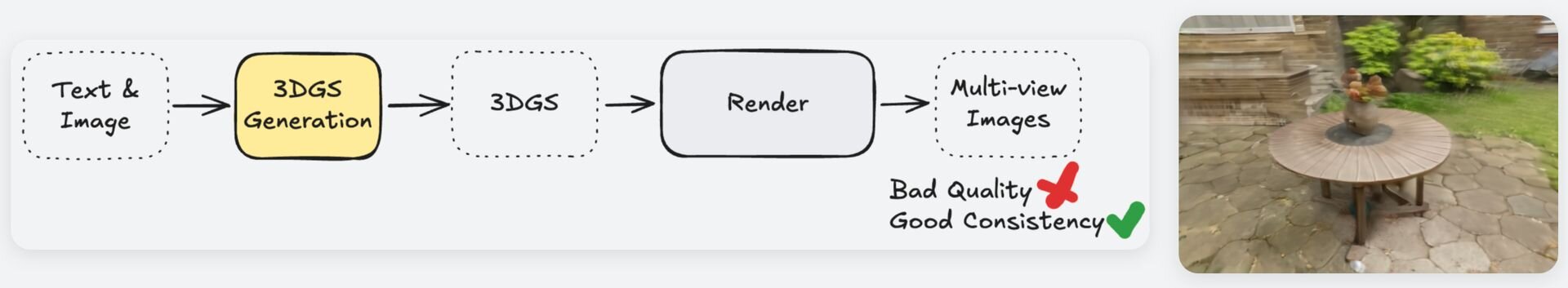

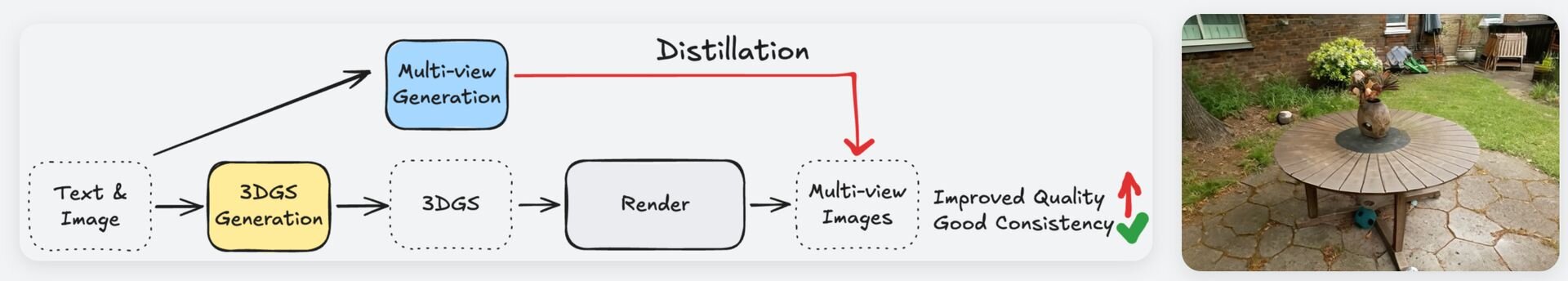

「FlashWorld」は、従来の3Dシーン生成技術の主要アプローチである「多視点指向(Multi-view-oriented、MV-oriented)パイプライン」(一貫性に問題あり)と「3D指向(3D-oriented)パイプライン」(ビジュアル品質が低い)という問題を解決するため、独自の学習戦略を採用した3Dシーン生成AIモデル。

まず、デュアルモード事前学習(Dual-mode Pre-training)として、動画拡散モデルの事前知識を活用して前述の多視点指向と3D指向 の両モードを同時にサポートする拡散モデルを事前学習する。そして、クロスモード事後学習(Cross-mode Post-training)による蒸留(Distillation)によって3D指向モードの品質の低さを克服する。

この蒸留プロセスにより、推論に必要なノイズ除去ステップが削減され、NVIDIA A100/A800 GPU1基で5〜10秒という高速生成が可能になり、従来の課題であった高品質と一貫性を両立させているという。

■FlashWorld: High-quality 3D Scene Generation within Seconds(プロジェクトページ、英語)

https://imlixinyang.github.io/FlashWorld-Project-Page/

■FlashWorld: High-quality 3D Scene Generation within Seconds(GitHub)

https://github.com/imlixinyang/FlashWorld

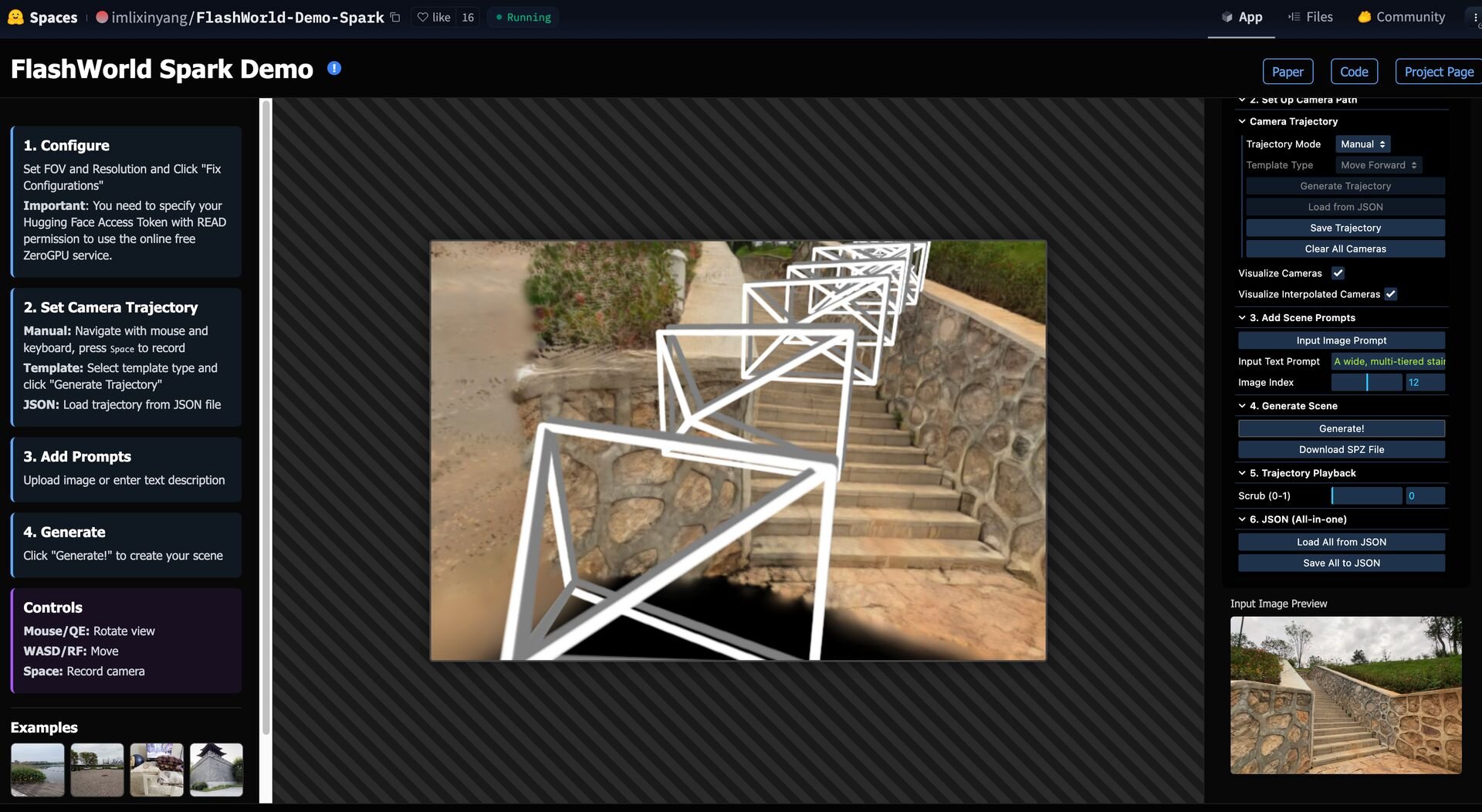

Hugging Faceにはデモも用意されている。

■FlashWorld Spark Demo(Hugging Face)

https://huggingface.co/spaces/imlixinyang/FlashWorld-Demo-Spark

CGWORLD関連情報

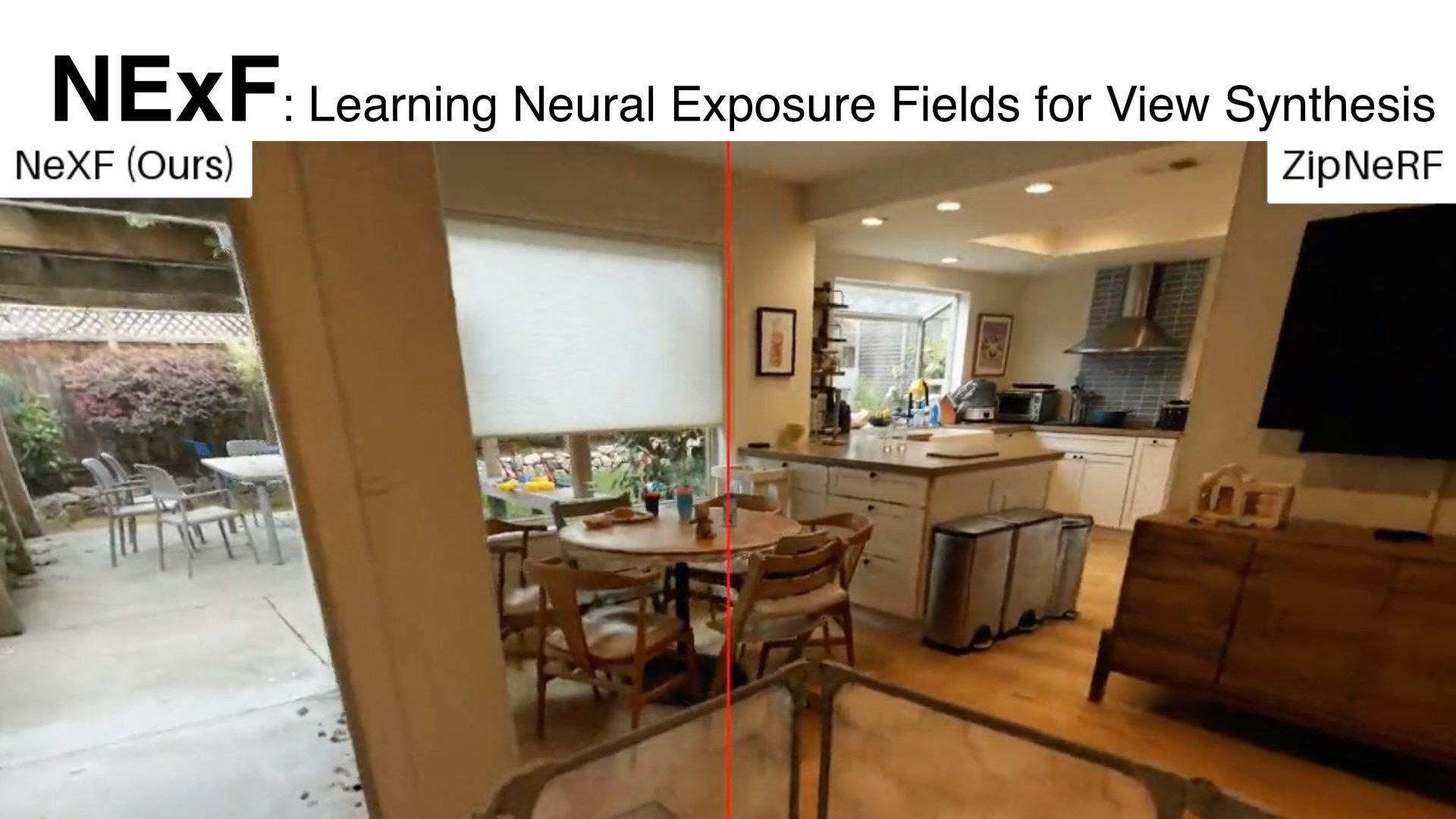

●Google、3Dシーン再構築技術「Neural Exposure Fields(NExF)」発表! 照明条件が厳しい現実の撮影データからでも高品質かつ一貫性のある3Dシーンを再構築

Googleが新しい視点からの画像を生成する3Dシーン再構築技術「NExF: Learning Neural Exposure Fields for View Synthesis」を発表。AI・機械学習・計算論的神経科学分野の国際会議「NeurIPS 2025」に採択されている。

https://cgworld.jp/flashnews/01-202510-NExF.html

●NVIDIAら、接触しても貫通しない新しいコンタクトモデル「Offset Geometric Contact」発表! 布や糸の接触シミュレーションを貫通なし、アーティファクトなしで高速処理

NVIDIAとユタ大学からなる研究チームが、新しいコンタクトモデルに関する論文「Offset Geometric Contact(OGC)」を発表。布や髪の毛のシミュレーションにおいて、オブジェクト同士が貫通しないことを保証しつつ、計算のオーバーヘッドを最小限に抑えることを目的とする。ソースコードはNewtonとGaiaの2種が公開され、どちらもオープンソース(Apache-2.0ライセンス)。

https://cgworld.jp/flashnews/01-202510-OffsetGeometricContact.html

●NVIDIAら、モーキャプデータのアーティファクトを自動修正する新手法「StableMotion」をオープンソースで公開!

サイモンフレーザー大学、エレクトロニック・アーツ、カナダ国立研究機構、NVIDIAからなる研究チームが、モーションキャプチャデータに含まれるアーティファクト(不自然な動き)を自動で修正する新しい手法「StableMotion」を発表。オープンソース(MITライセンス)で公開した。

https://cgworld.jp/flashnews/01-202509-StableMotion.html