Googleの研究チームは10月10日(金)、新しい視点からの画像を生成する3Dシーン再構築技術「NExF: Learning Neural Exposure Fields for View Synthesis」を発表した。AI・機械学習・計算論的神経科学分野の国際会議「NeurIPS 2025」に採択されている。

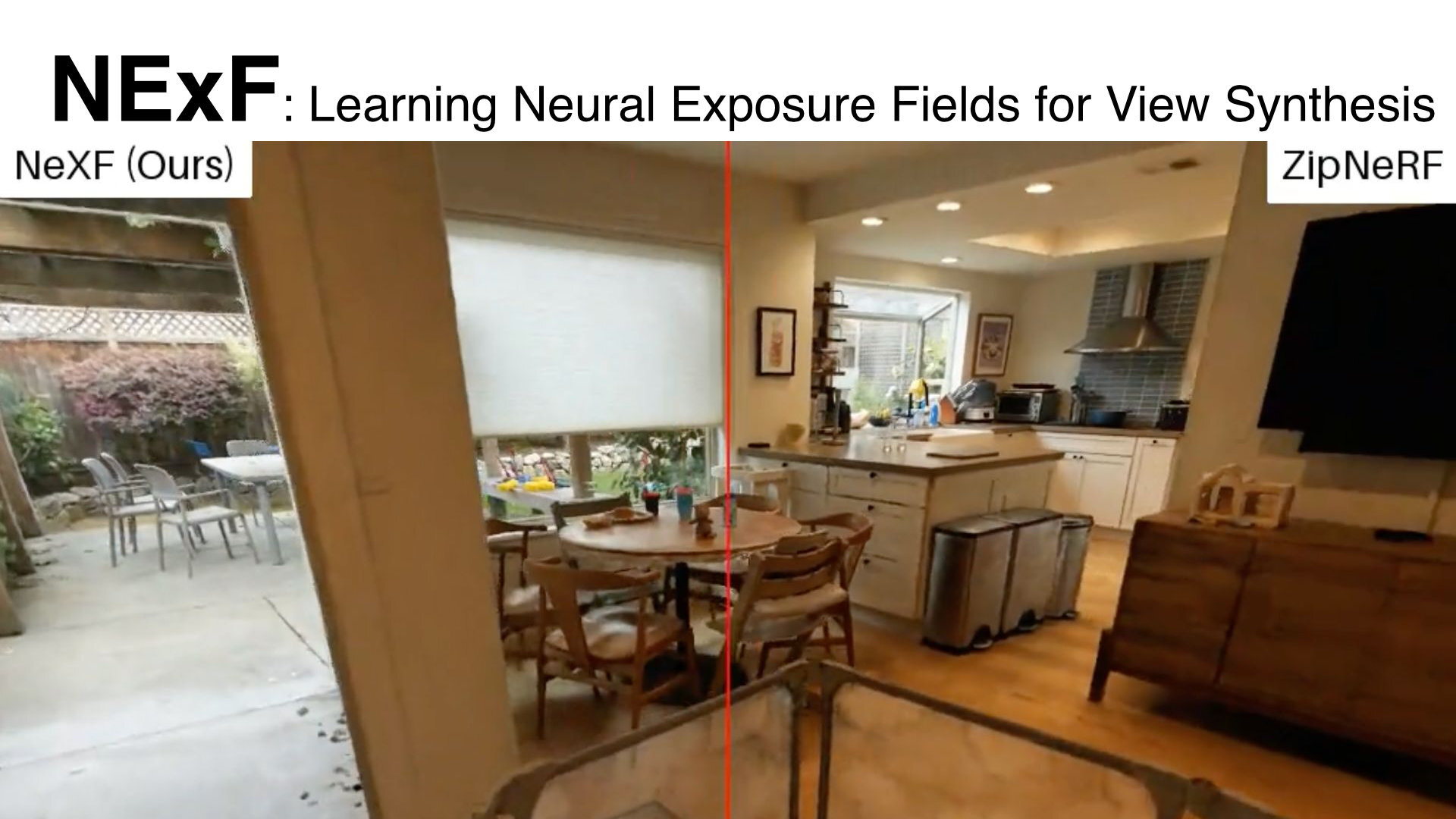

How do we reconstruct a 3D scene from photos with varying exposures? Standard methods often fail, leaving you with blown-out colors or disturbing shadows.

— Michael Niemeyer (@Mi_Niemeyer) October 9, 2025

We're excited to introduce Neural Exposure Fields (NExF), our new work accepted at #NeurIPS2025! pic.twitter.com/Wzsnf9jBHW

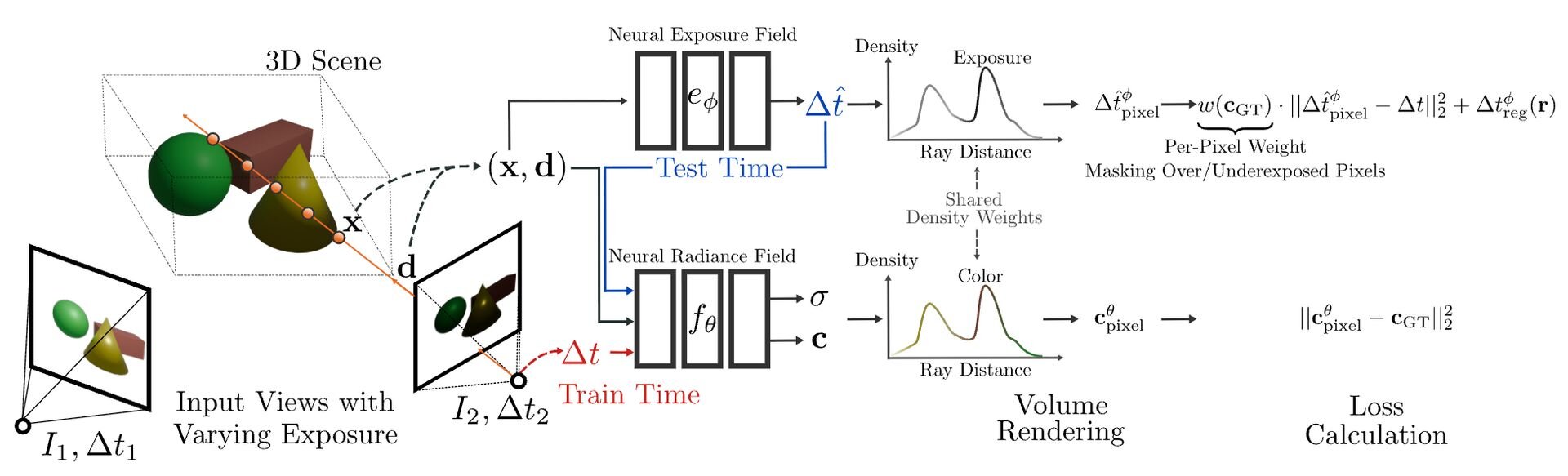

「Neural Exposure Fields(NExF)」は明るい屋外と暗い室内が混在するシーンのような、露出が大きく異なる画像からでも、高品質で見た目が一貫した3Dシーンをロバストに再構築できる技術。従来のカメラが画像単位・ピクセル単位で最適な露出を決めるのに対して、NExFは3D空間の点単位(per 3D point)で最適な露出値を予測する「神経フィールド(Neural Field)」を学習する。

NExFが学習した、シーン全体の理想的な露出の3Dマップは、画像生成(レンダリング)時に、オリジナルのカメラ設定の代わりに用いられる。その結果、白飛びや黒つぶれのない、シーン全体が適切に露出された画像を、あらゆる視点から一貫して生成できるという。ハイダイナミックレンジで撮影された実写データからも、高品質なビュー合成を実現し、従来必要とされてきたポストプロセスや、露出を変えた複数枚撮影(マルチエクスポージャキャプチャ)を用いる必要がなくなるとのこと。

なお、既存の最先端技術(HDR-NeRFなど)との比較では、トレーニングの高速化と精度の55%以上の向上が見られるという。

■NExF: Learning Neural Exposure Fields for View Synthesis(プロジェクトページ、英語)

https://m-niemeyer.github.io/nexf/index.html

CGWORLD関連情報

●NVIDIAら、接触しても貫通しない新しいコンタクトモデル「Offset Geometric Contact」発表! 布や糸の接触シミュレーションを貫通なし、アーティファクトなしで高速処理

NVIDIAとユタ大学からなる研究チームが、新しいコンタクトモデルに関する論文「Offset Geometric Contact(OGC)」を発表。布や髪の毛のシミュレーションにおいて、オブジェクト同士が貫通しないことを保証しつつ、計算のオーバーヘッドを最小限に抑えることを目的とする。ソースコードはNewtonとGaiaの2種が公開され、どちらもオープンソース(Apache-2.0ライセンス)。

https://cgworld.jp/flashnews/01-202510-OffsetGeometricContact.html

●NVIDIAら、モーキャプデータのアーティファクトを自動修正する新手法「StableMotion」をオープンソースで公開!

サイモンフレーザー大学、エレクトロニック・アーツ、カナダ国立研究機構、NVIDIAからなる研究チームが、モーションキャプチャデータに含まれるアーティファクト(不自然な動き)を自動で修正する新しい手法「StableMotion」を発表。オープンソース(MITライセンス)で公開した。

https://cgworld.jp/flashnews/01-202509-StableMotion.html

●NVIDIAの新AIモデル「LuxDiT」発表! 単一画像・動画から高品質なHDR環境マップを生成できる拡散トランスフォーマー

NVIDIA、トロント大学、ベクター人工知能研究所からなる研究チームが、1枚の画像・動画からその場所のリアルなライティングを推定し、高精度なHDR環境マップを生成できるDiT(Diffusion Transformer、拡散トランスフォーマー)、「LuxDiT」を発表。コードは近日公開される予定。

https://cgworld.jp/flashnews/01-202509-LuxDiT.html