中国テンセント(Tencent)社のHunyuanチームは10月23日(木)、オープンソースの世界モデル「Hunyuan World Models」シリーズの新モデルとして、高速・汎用3D復元モデル「HunyuanWorld-Mirror(Hunyuan World 1.1)」を公開した。動画や画像から3Dシーンを数秒で生成し、3DGS(3D Gaussian Splatting)やデプス(深度)マップ、サーフェスノーマル(法線)、カメラパラメータといった3Dデータを一度にまとめて出力できる。GitHubとHugging Faceでコードとウェイトが公開されており、基本的に商用利用が許可されるが、地理的制限などのある独自ライセンスとなっている。

Today, we are open-sourcing Hunyuan World 1.1 (WorldMirror), a universal feed-forward 3D reconstruction model.

— Hunyuan (@TencentHunyuan) October 22, 2025

While our previously released Hunyuan World 1.0 (open-sourced, lite version deployable on consumer GPUs) focused on generating 3D worlds from text or… pic.twitter.com/kklb5giNom

Today, we are open-sourcing Hunyuan World 1.1 (WorldMirror), a universal feed-forward 3D reconstruction model.

While our previously released Hunyuan World 1.0 (open-sourced, lite version deployable on consumer GPUs) focused on generating 3D worlds from text or single-view images, Hunyuan World 1.1 significantly expands the input scope by unlocking video-to-3D and multi-view-to-3D world creation.

Highlights:

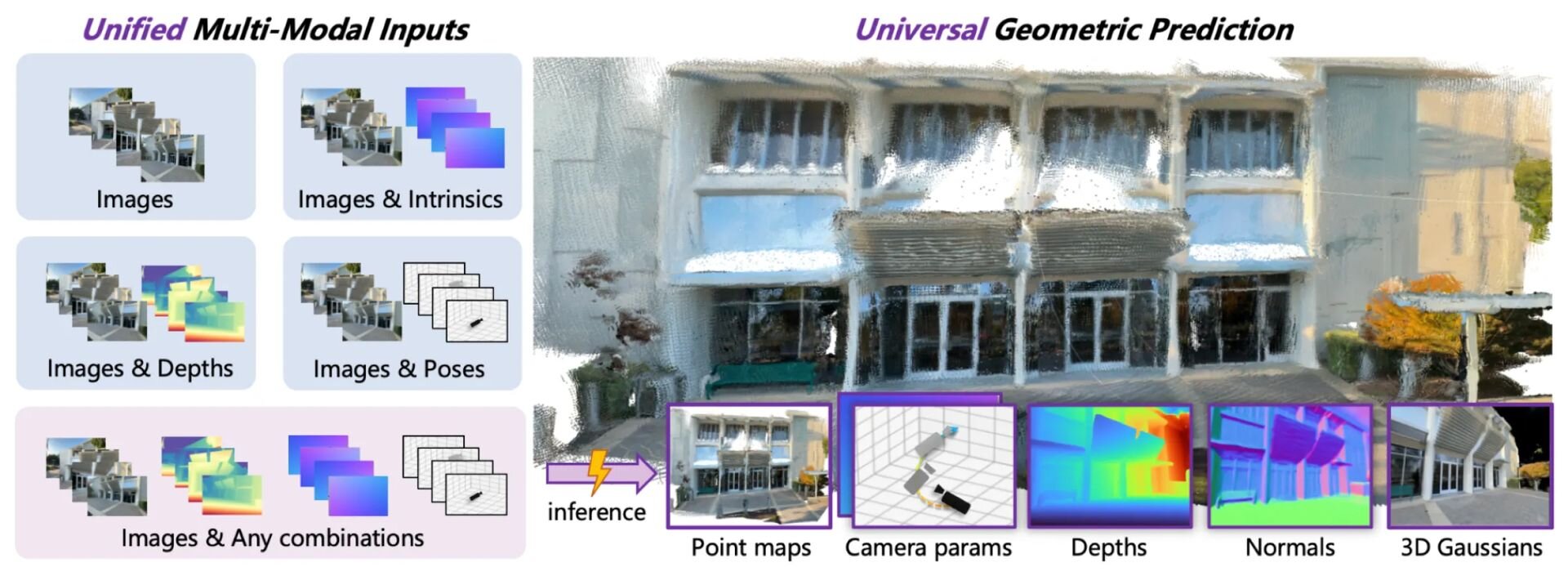

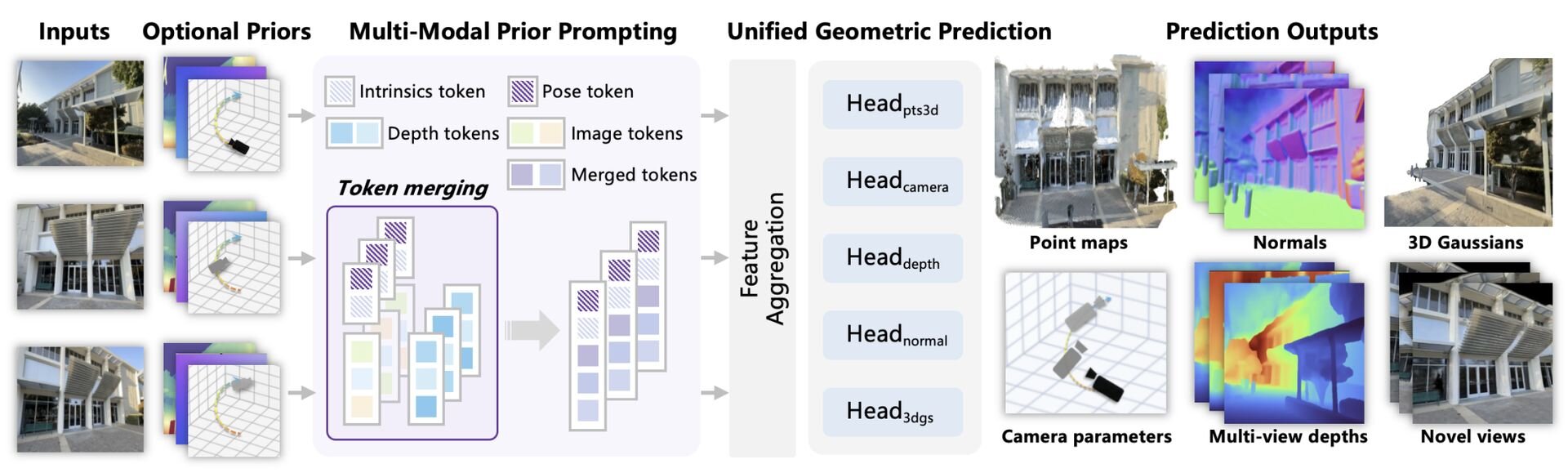

・Any Input, Maximized Flexibility and Fidelity: Flexibly integrates diverse geometric priors (camera poses, intrinsics, depth maps) to resolve structural ambiguities and ensure geometrically consistent 3D outputs.

・Any Output, SOTA Results:This elegant architecture simultaneously generates multiple 3D representations: dense point clouds, multi-view depth maps, camera parameters, surface normals, and 3D Gaussian Splattings.

・Single-GPU & Fast Inference: As an all-in-one, feed-forward model, Hunyuan World 1.1 runs on a single GPU and delivers all 3D attributes in a single forward pass, within seconds.本日、私たちは、汎用的なフィードフォワード3D復元モデルであるHunyuan World 1.1(WorldMirror)をオープンソース化します。

以前リリースしたHunyuan World 1.0(オープンソース化済み、コンシューマー向けGPUで展開可能なライト版)が、テキストまたは単一視点の画像からの3Dワールド生成に焦点を当てていたのに対し、Hunyuan World 1.1は入力の範囲を大幅に拡張し、動画から3Dおよびマルチビュー(多視点)画像から3Dへのワールド生成を可能にしました。

主な特徴:

・あらゆる入力に対応、最大の柔軟性と忠実性:(カメラの姿勢、内部パラメータ、デプスマップといった)多様なジオメトリ的な事前情報を柔軟に統合し、構造的な曖昧さを解消し、ジオメトリ的に一貫性のある3D出力を保証します。

・あらゆる出力、SOTA(最高水準)の結果:この洗練されたアーキテクチャは、高密度の点群、マルチビューのデプスマップ、カメラパラメータ、サーフェスノーマル、そして3D Gaussian Splattingといった複数の3D表現を同時に生成します。

・単一GPUでの高速推論:オールインワンのフィードフォワードモデルとして、Hunyuan World 1.1は単一のGPUで動作し、わずか数秒のうちに、単一のフォワードパスで全ての3D属性を出力します。

7月にリリースした「Hunyuan World 1.0」 は、テキストや単一画像から3Dワールドを生成することにフォーカスしていたが、「HunyuanWorld-Mirror」はその入力範囲が拡張され、動画やマルチビュー画像からの3Dシーン構築が可能となった。

動画・画像の入力時には、より高品質な3D復元を行うためのカメラポーズ・カメラパラメータ(レンズ特性など)・デプス(深度)マップなどのジオメトリ的な事前情報を利用でき、これにより、形状の曖昧さを解消して、正確かつ一貫性のある3Dシーンを生成できる。

入力データの処理には「フィードフォワード(feed-forward)」タイプのアーキテクチャが採用され、データはモデル内を一方向(入力→出力)にながれるだけで処理が完了する。従来の多くの手法に必要だったシーン単位での反復的な最適化は不要となるため、単一GPU上の数秒の処理だけで、全処理を完了する。

出力されるのは3DGSデータ、高密度の点群(ポイントクラウド)、マルチビューのデプス(深度)マップ、カメラパラメータ、サーフェスノーマル(法線)。これらの情報は1回の処理で同時に生成される。

■Hunyuan World Models Open-Source Series(HunyuanWorld-Mirror、HunyuanWorld-Voyager、HunyuanWorld-1.0プロジェクトページ)

https://3d-models.hunyuan.tencent.com/world/

■HunyuanWorld-Mirror(GitHub)

https://github.com/Tencent-Hunyuan/HunyuanWorld-Mirror

■HunyuanWorld-Mirror(Hugging Face)

https://huggingface.co/tencent/HunyuanWorld-Mirror

■WorldMirror: Universal 3D World Reconstruction with Any Prior Prompting(デモページ、Hugging Face Spaces)

https://huggingface.co/spaces/tencent/HunyuanWorld-Mirror

■HunyuanWorld-Mirror: Technical Report(PDF)

https://3d-models.hunyuan.tencent.com/world/worldMirror1_0/HYWorld_Mirror_Tech_Report.pdf

CGWORLD関連情報

●世界モデル「HunyuanWorld-Voyager」オープンソースで公開! 点群動画から3Dへの直接のエクスポートも可能

テンセントのHunyuanチームが世界モデル「HunyuanWorld-Voyager」をオープンソース(研究や個人利用に加え、一定の条件下で商用利用も許可する独自ライセンス)で公開。1枚の画像とユーザーが定義したカメラの軌道から、3D的に一貫性のある動画を生成できる。

https://cgworld.jp/flashnews/01-202509-HunyuanWorld-Voyager.html

●テンセント、オープンソースの世界モデル「Hunyuan3D World Model 1.0」リリース! 文章や画像から没入型・インタラクティブな3Dワールドを生成

テンセントがオープンソースの世界モデル「Hunyuan3D World Model 1.0」をGitHubとHugging Faceで公開。テキストまたは画像からインタラクティブな3Dワールドを生成でき、USDZやGLB形式でのエクスポートが可能。日本では月間アクティブユーザー数が100万人を超えない限り、商用利用も行える。

https://cgworld.jp/flashnews/01-202508-HunyuanWorld.html

●リアルタイム生成の世界モデル「RTFM」発表! ユーザーが操作すると同時にリアルタイムで動画を生成し、ワールド探索が可能

World Labsがリアルタイム生成の世界モデル(ワールドモデル)「RTFM: A Real-Time Frame Model」を発表し、デモサイトを公開。ユーザーによるインタラクションと同時にリアルタイムで動画が生成され、生成された3D世界や現実の場所を探索できる。

https://cgworld.jp/flashnews/01-202510-RTFM.html