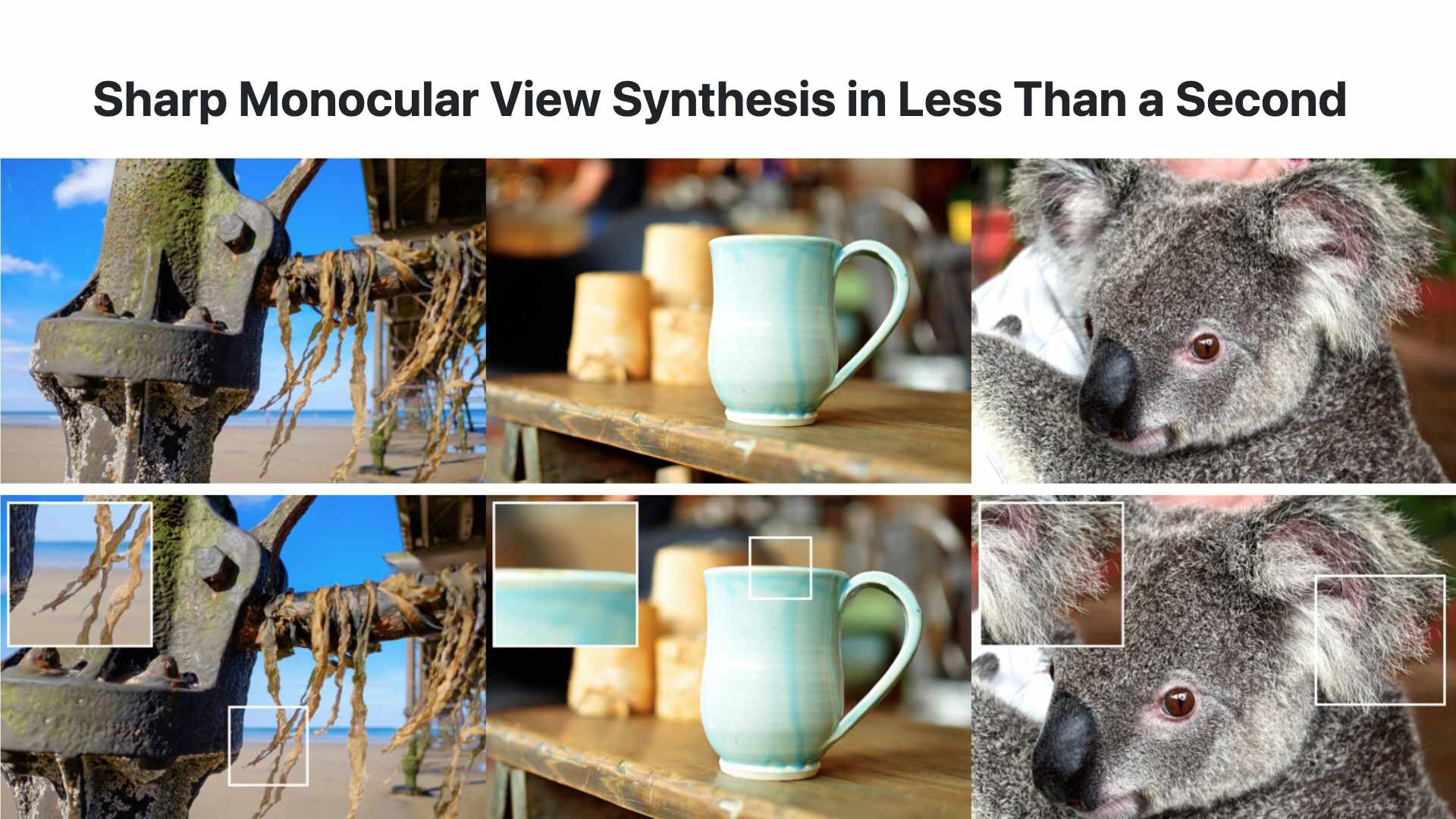

Apple社は12月16日(火)、1枚の静止画から高品質な3D表現を瞬時に生成する新たな技術「SHARP(Sharp Monocular View Synthesis in Less Than a Second)」を公開した。コードとモデルウェイトはGitHubとHugging Faceで公開されており、それぞれApple独自ライセンスの下で提供される。

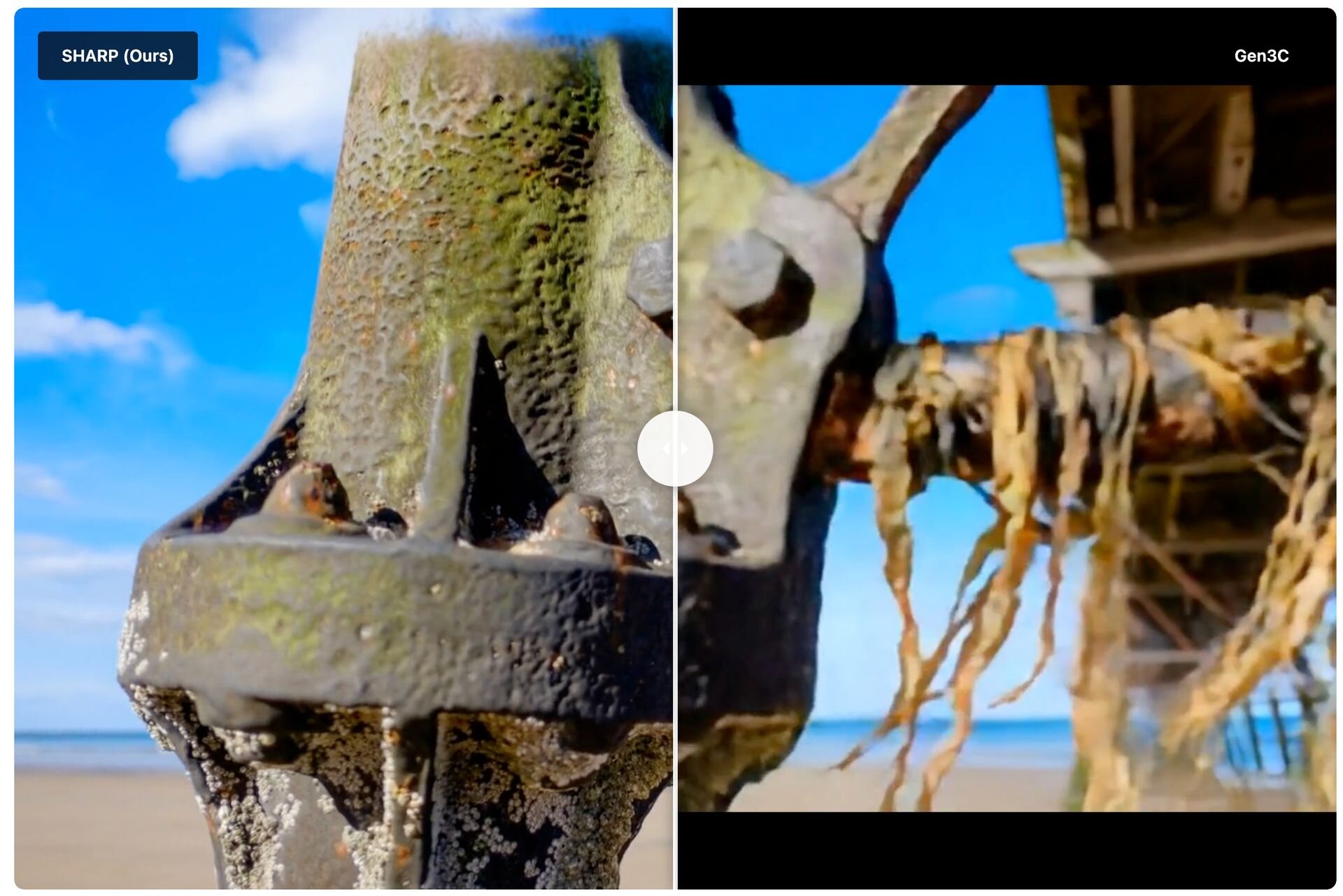

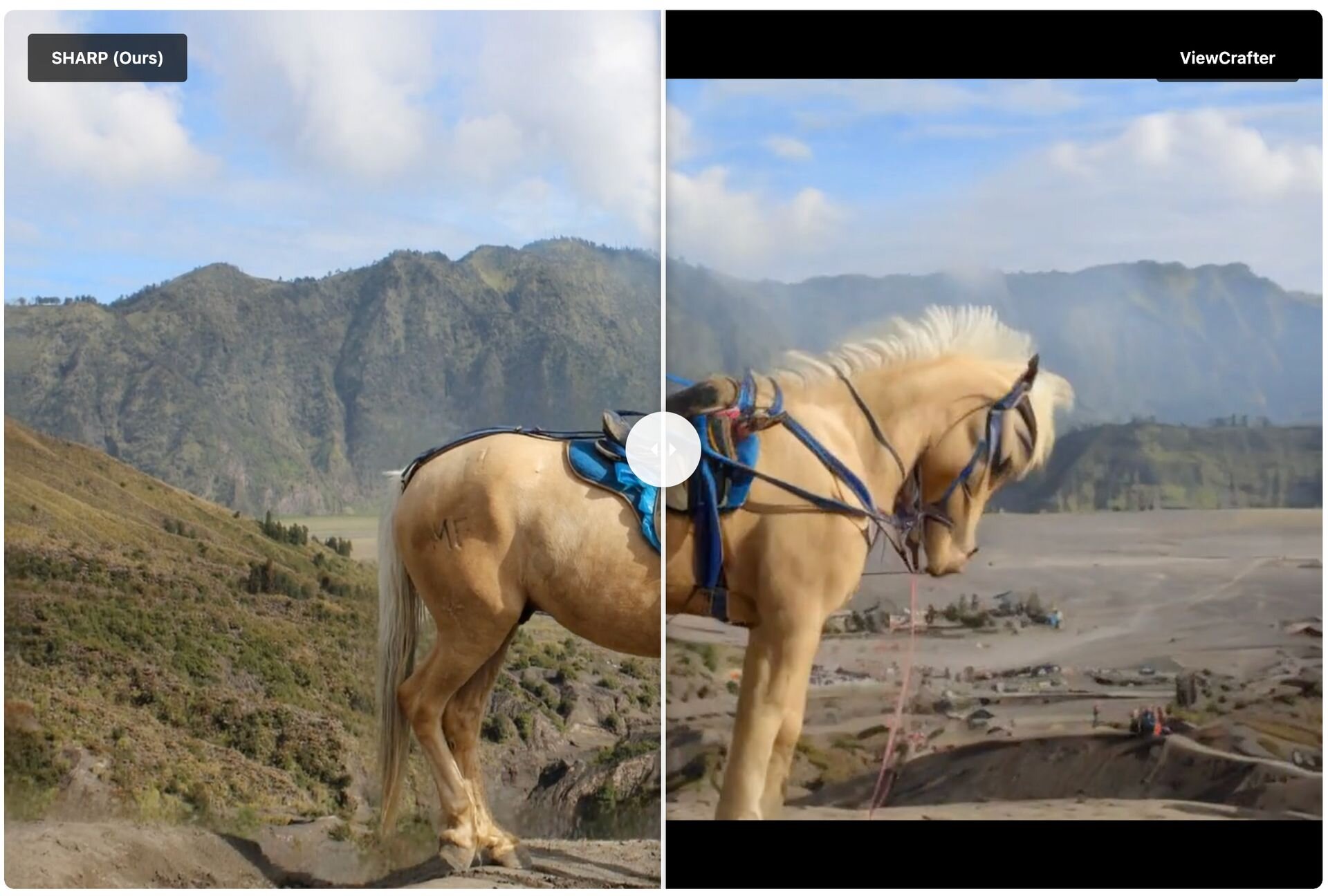

「SHARP(Sharp Monocular View Synthesis in Less Than a Second)」は、単一の画像から周囲の視点映像をつくり出す単眼視点合成(Monocular View Synthesis:MVS)技術。従来技術の課題であった処理速度とジオメトリの正確性を大幅に改善し、わずかな視点の移動を伴うフォトリアルな映像を生成する。SHARPは、ニューラルネットワークを用いた単一の順伝播パス(Feedforward pass)のみで3D表現のパラメータを直接出力するため、一般的なGPU環境においても高速に(1秒未満で)3Dシーンを構築できるという。

SHARPは入力された画像に基づき、シーンを構成する約120万個のガウス分布(Gaussians)のパラメータを回帰(Regression)によって直接算出し、3D Gaussian Splatting(3DGS)として生成する。生成された3DGSは既存のリアルタイムレンダラと高い親和性を持ち、100fpsを超える高解像度での描画に対応する。

高精度のシーン生成を実現するにあたって、SHARPは、特定の環境に特化した再学習を必要とせず、多様な屋内・屋外の風景に対して即座に適用できるZero-shot generalizationを採用し、未知のデータセットに対しても高い精度を発揮する。また、生成される3D空間は現実世界の尺度であるメートル法(メトリックスケール)を保持し、カメラの物理的な移動距離に基づいた正確な視点操作をサポート。Appleの研究チームによる実験では、従来手法と比較して画像品質の指標であるLPIPSやDISTSが大幅に改善され、合成時間は数千倍の高速化を達成したとのことだ。

■Sharp Monocular View Synthesis in Less Than a Second(プロジェクトページ、英語)

https://apple.github.io/ml-sharp/

■Sharp Monocular View Synthesis in Less Than a Second(GitHub)

https://github.com/apple/ml-sharp

■Sharp Monocular View Synthesis in Less Than a Second(Hugging Face)

https://huggingface.co/apple/Sharp

多数のユーザーが利用を報告

SHARPの発表後、国内外問わず多数のユーザーがコードやモデルをテスト・利用し、SNSでその実力を報告したり、技術を活用したアプリを公開している。

New paper from Apple - Sharp Monocular View Synthesis in Less than a Second

— Tim Davison ᯅ (@timd_ca) December 16, 2025

Mescheder et al. @ Apple just released a very impressive paper (congrats!). You give it an image and it generates a really great looking 3d Gaussian representation. Uses depth pro. It's really good.… pic.twitter.com/XSZCZA8iio

I tried out that newly released Apple “single image to gaussian splat” model today

— Brad Lynch (@SadlyItsBradley) December 17, 2025

It’s actually incredible. Unlike the current spatial scenes feature, you can actually WALK INTO the memory you captured on your phone

It only took about 10 seconds on my MacBook Pro to generate pic.twitter.com/t0LydOhtla

Okay, this is absolutely WILD – Apple’s new Sharp model is even more impressive on Vision Pro when you place it exactly where the original photo was taken.

— Phil Traut ᯅ (@SpatiallyMe) December 21, 2025

Since we’ll probably never have snow on Christmas again, seeing my parents’ garden covered in snow once more made me really… pic.twitter.com/RJhKTp3RKl

Appleの「SHARP」(https://t.co/R0jGF0dt3d)で2D写真から生成した3Dガウシアンスプラッテング(.PLY)を各種3D表示するWEBアプリを作りました。https://t.co/r4QtIRCvz1 pic.twitter.com/hGzCcDNqIS

— むっちゃん (@spmaker) December 22, 2025

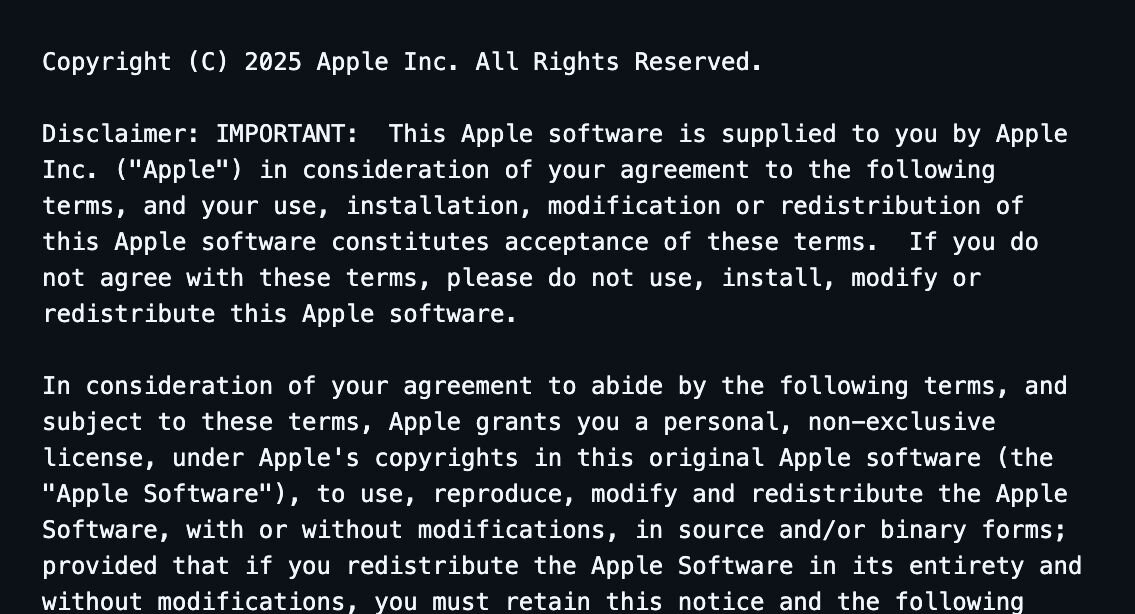

提供形態とライセンス

SHARPは、コードと学習済みモデルウェイトで異なるライセンスが適用されている。GitHubリポジトリ内のプログラムコードは、Apple独自の「Apple Software License」に基づいて提供され、主にサンプルコードとしての利用を想定している。一方、公開されている学習済みモデルウェイトについては、別途「Apple ML Research Model License」が適用される。これらは研究および非営利目的での利用を前提としており、商用利用や再配布については各ライセンス条項の詳細確認が必要だ。

■ml-sharp LICENSE

https://github.com/apple/ml-sharp/blob/main/LICENSE

■ml-sharpLICENSE_MODEL

https://github.com/apple/ml-sharp/blob/main/LICENSE_MODEL

CGWORLD関連情報

●3Dワールド生成モデル「Echo」発表! 独自の空間基盤モデルを用いて、メートル法ベースのジオメトリに裏付けされた物理空間の描画・編集を実現、クローズドβ中

SpAItialがテキストや1枚の画像から一貫性のある3D世界を生成する新モデル「Echo」を発表。Webデモでは3DGS(3D Gaussian Splatting)を採用し、低スペックな機材でもリアルタイムでジオメトリに裏付けされた空間の描画・編集、Webブラウザ上での自由な移動や探索を実現している。現在はクローズドベータ版の登録を受付中。

https://cgworld.jp/flashnews/01-202512-Echo.html

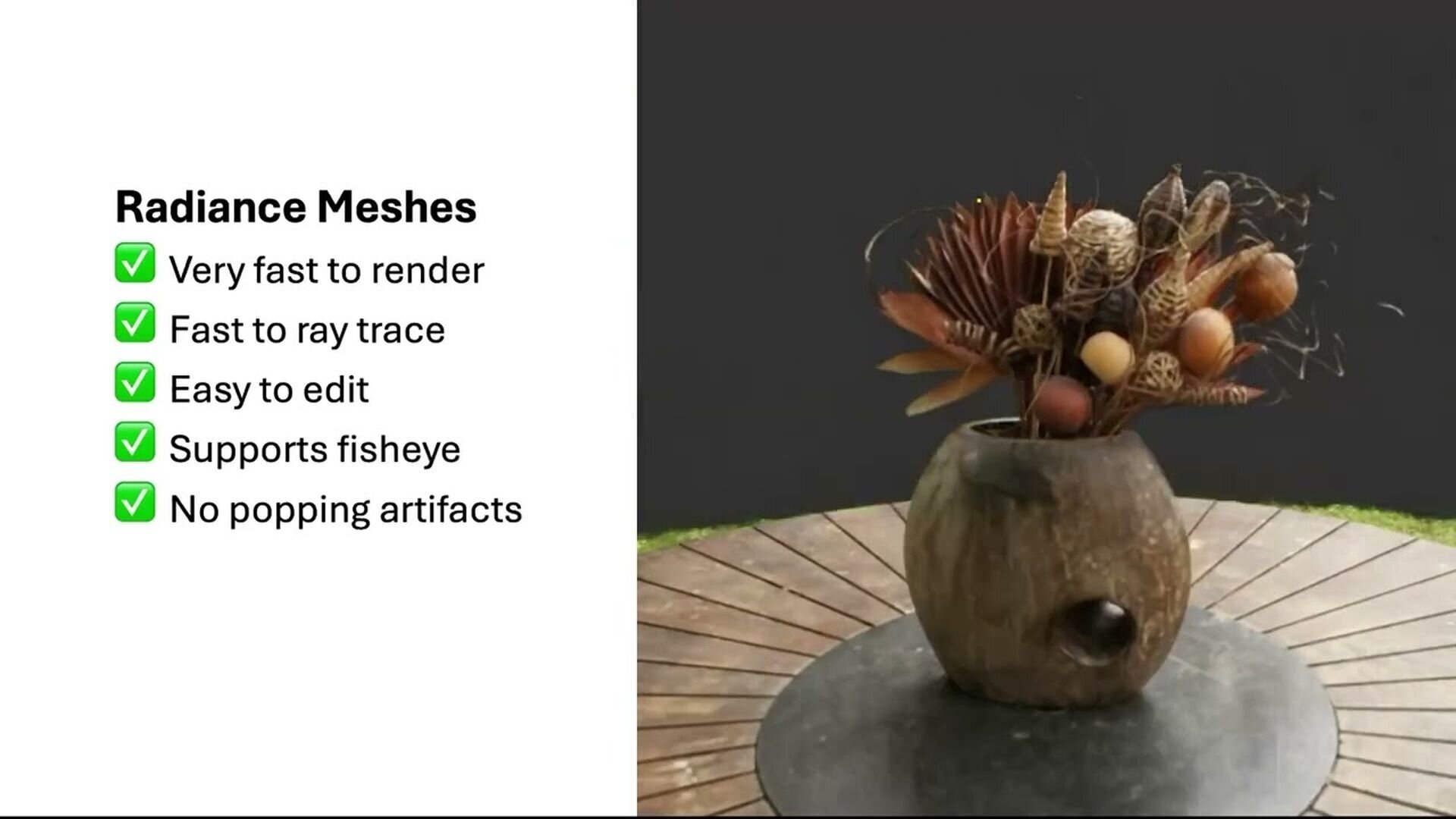

●Googleら、空間をメッシュを用いたラディアンスフィールドとして再定義する3D描画技術「Radiance Meshes」公開! 3DGSより高速描画、オープンソース

Google、カリフォルニア大学、Runwayからなる研究チームが、空間を不定形な霧や点群ではなく四面体(三角錐)メッシュを用いたラディアンスフィールドとして定義し直すことにより、NeRFや3DGS(3D Gaussian Splatting)など既存技術の壁を突破する新しい3D空間の描画手法「Radiance Meshes for Volumetric Reconstruction」をオープンソース(MITライセンス)で公開。

https://cgworld.jp/flashnews/01-202512-RadianceMeshes.html

●テンセント、オープンソースの世界モデル「HunyuanWorld-Mirror」公開! 動画や画像から最適化なしで3DGS・深度・カメラパラメータをまとめて高速出力

テンセントがオープンソースの世界モデル「Hunyuan World Models」シリーズの新モデルとして、高速・汎用3D復元モデル「HunyuanWorld-Mirror(Hunyuan World 1.1)」を公開。動画や画像から3Dシーンを数秒で生成し、3DGS(3D Gaussian Splatting)やデプス(深度)マップ、サーフェスノーマル(法線)、カメラパラメータといった3Dデータを一度にまとめて出力できる。GitHubとHugging Faceでコードとウェイトが公開されており、基本的に商用利用が許可されるが、地理的制限などのある独自ライセンスとなっている。

https://cgworld.jp/flashnews/01-202511-HunyuanWorld-Mirror.html