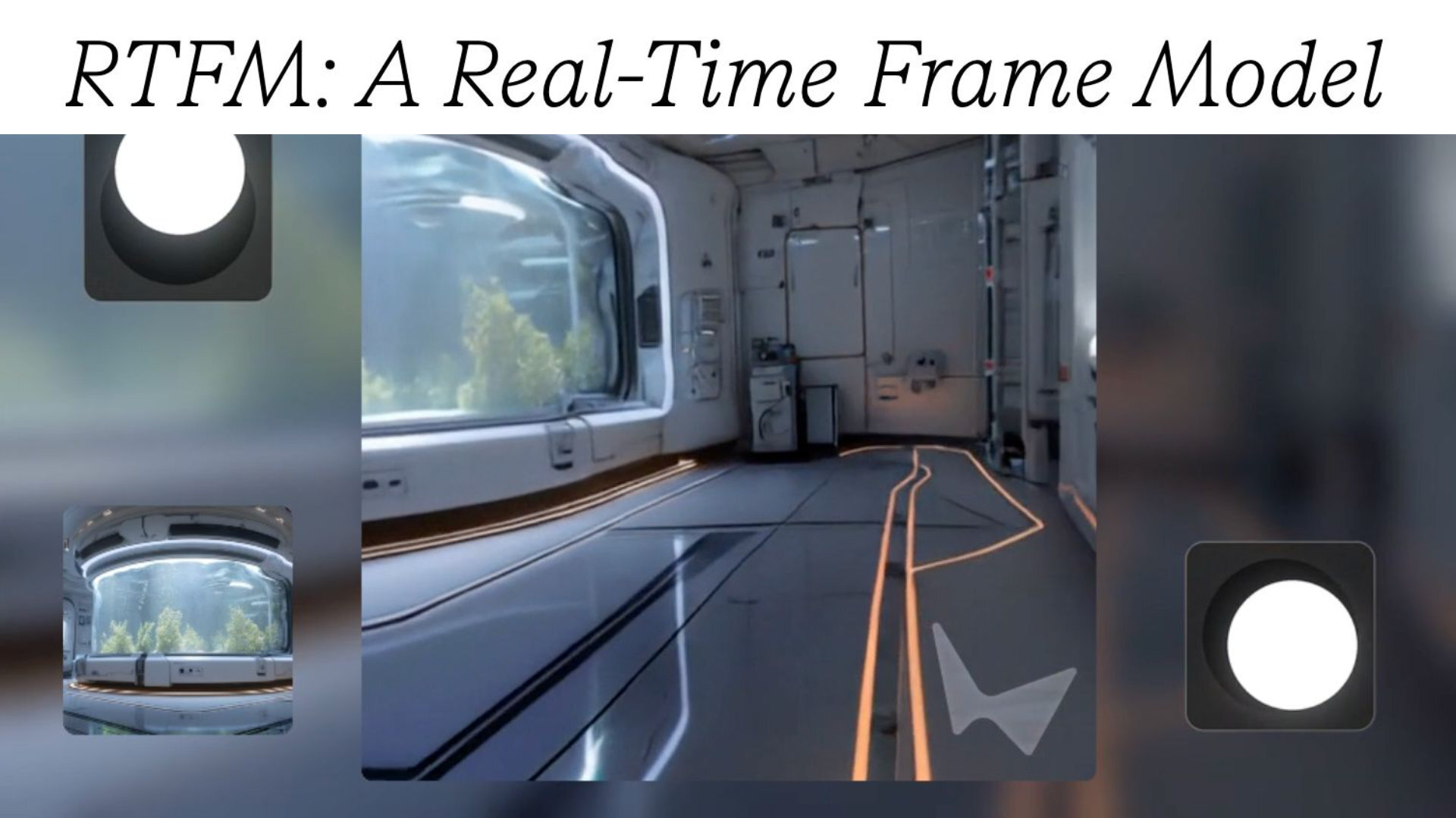

アメリカWorld Labs社は10月17日(金)、リアルタイム生成の世界モデル(ワールドモデル)「RTFM: A Real-Time Frame Model」を発表し、デモサイトを公開した。ユーザーによるインタラクションと同時にリアルタイムで動画が生成され、生成された3D世界や現実の場所を探索できる。

Introducing RTFM (Real-Time Frame Model): a highly efficient World Model that generates video frames in real time as you interact with it, powered by a single H100 GPU.

— World Labs (@theworldlabs) October 16, 2025

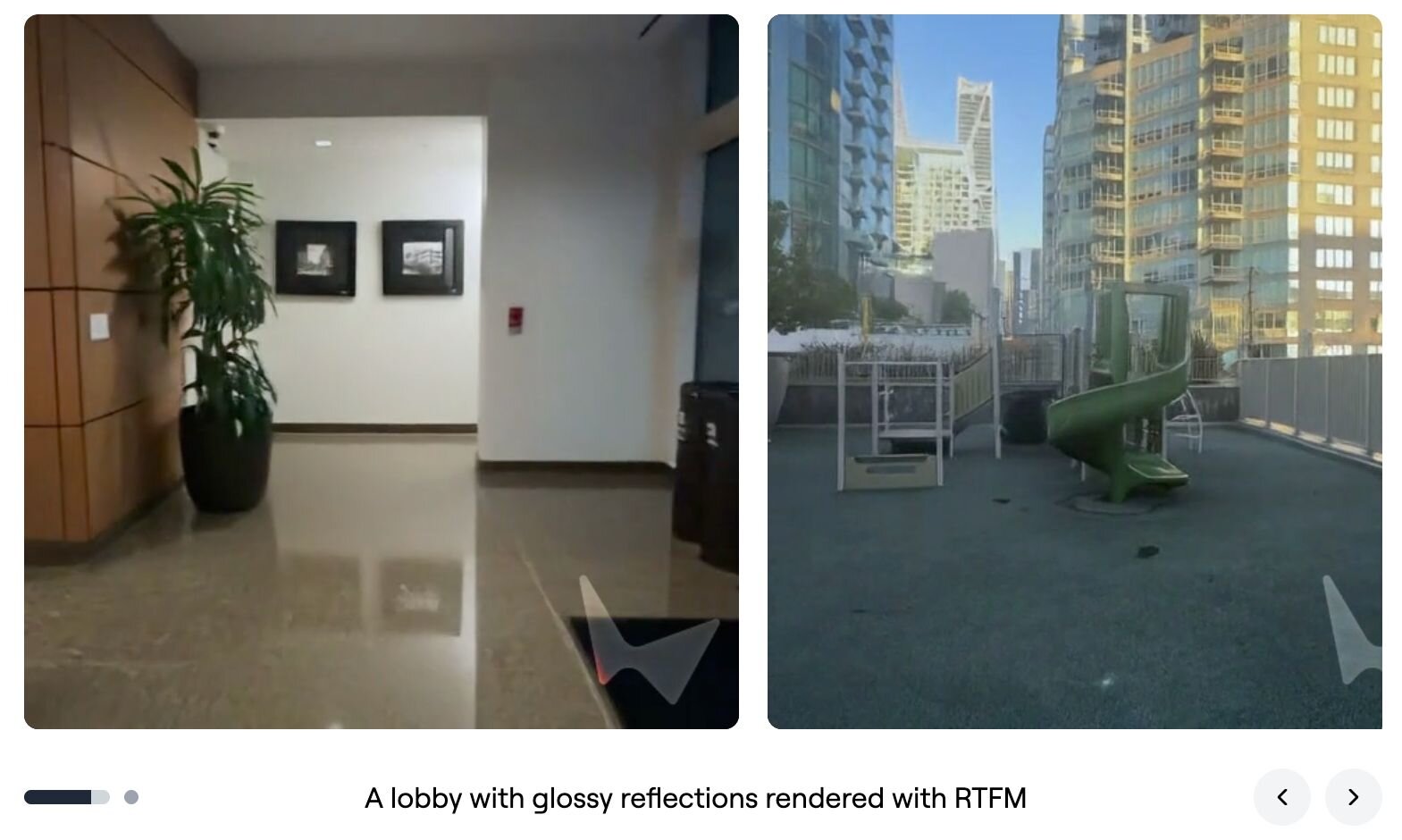

RTFM renders persistent and 3D consistent worlds, both real and imaginary.

Try our demo of RTFM today! pic.twitter.com/efS7qwQgQE

RTFMを紹介します。これは、あなたが操作すると同時にリアルタイムでビデオフレームを生成する、非常に効率的なワールドモデルです。NVIDIA H100 GPU 1基だけで動作します。現実および架空の世界を、永続的かつ3D的に一貫性のある形でレンダリングします。

RTFMは、従来のワールドモデルの課題となっている、LLMをはるかに凌ぐ計算能力の必要性、特に高解像度・高フレームレートでのインタラクティブな生成を実現するために、効率性・スケーラビリティ・永続性という3原則に基づき設計されたワールドモデル。

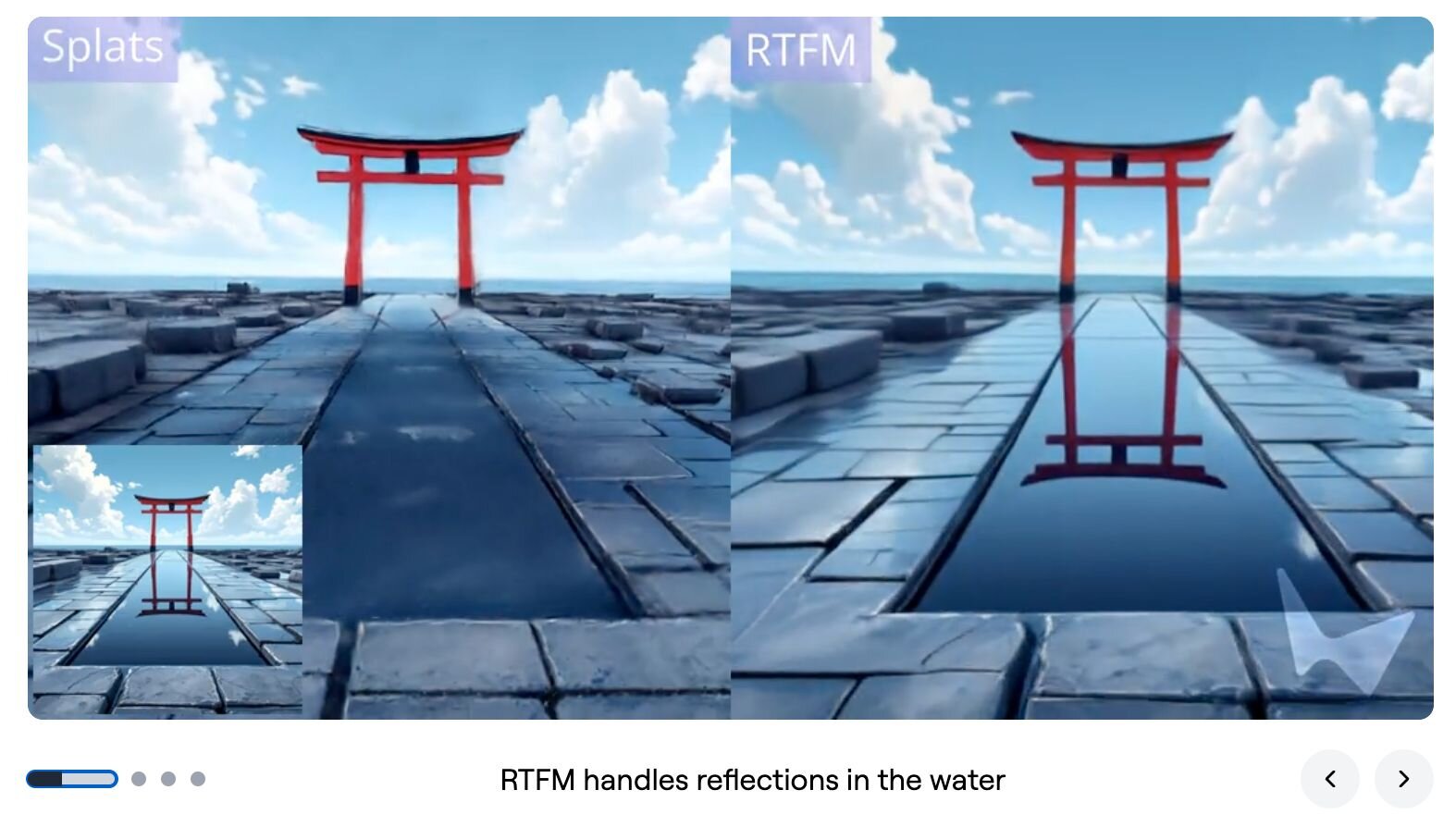

効率性面では、単一のNVIDIA H100 GPUだけでインタラクティブなフレームレートで動作。スケーラビリティ面では、従来の3DCG手法であるメッシュや3DGSを用いるのではなく、ニューラルネットワークを「学習済みレンダラ」として使用する。これは自己回帰型の拡散トランスフォーマー(Autoregressive Diffusion Transformer)で、大量の動画データからエンドツーエンドで学習し、反射や影などの複雑な効果も再現するという。

永続性面では、各フレームに3D空間での位置と向き(ポーズ)を持たせ、新しいフレームを生成する際、その場所の近くにあるフレームのみを「コンテキストジャグリング(Context Juggling)」と呼ばれる技術で参照する。これにより、計算コストを抑えつつ、広大な世界の永続性を実現する。

■RTFM: A Real-Time Frame Model(World Labsブログ、英語)

https://www.worldlabs.ai/blog/rtfm

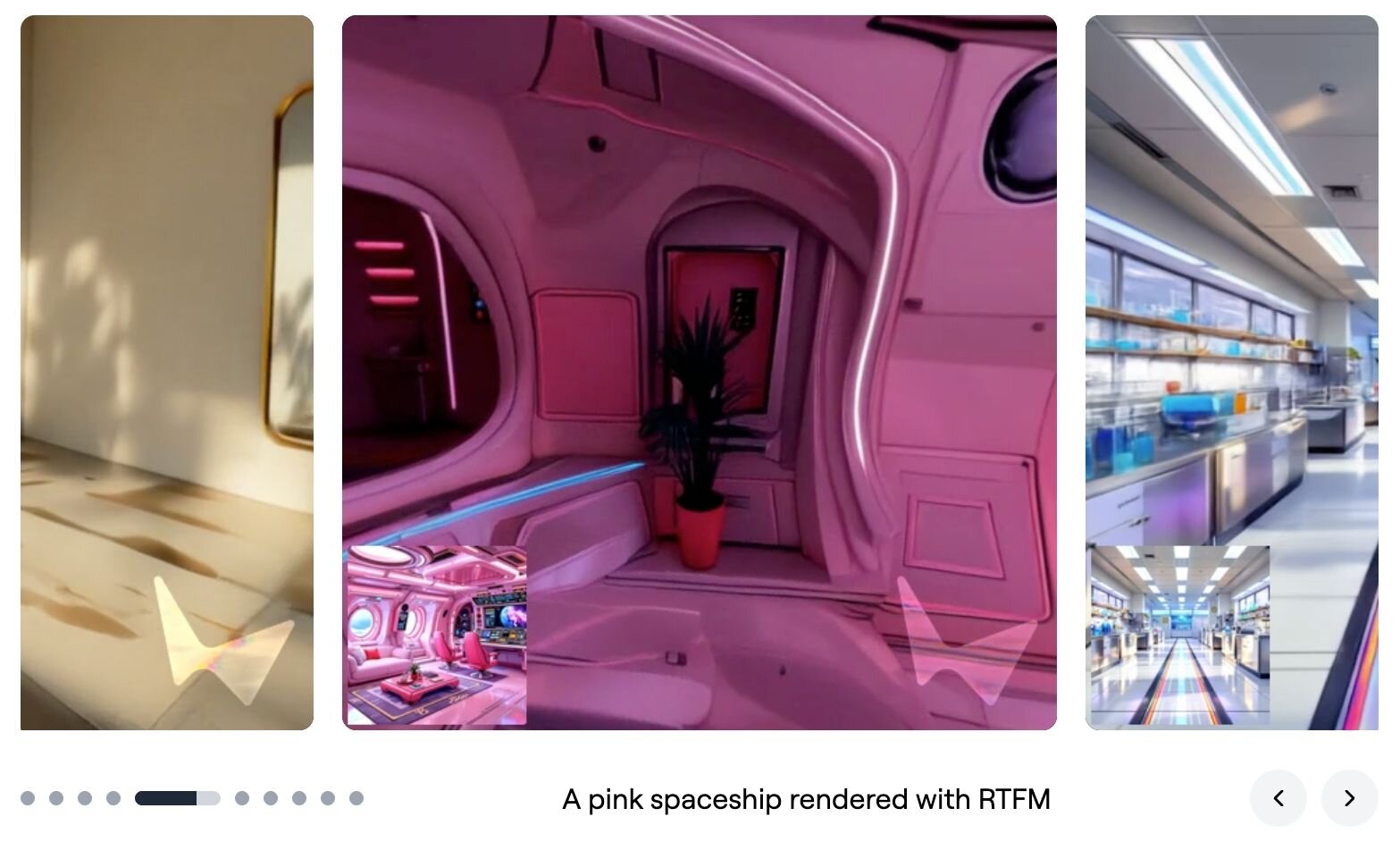

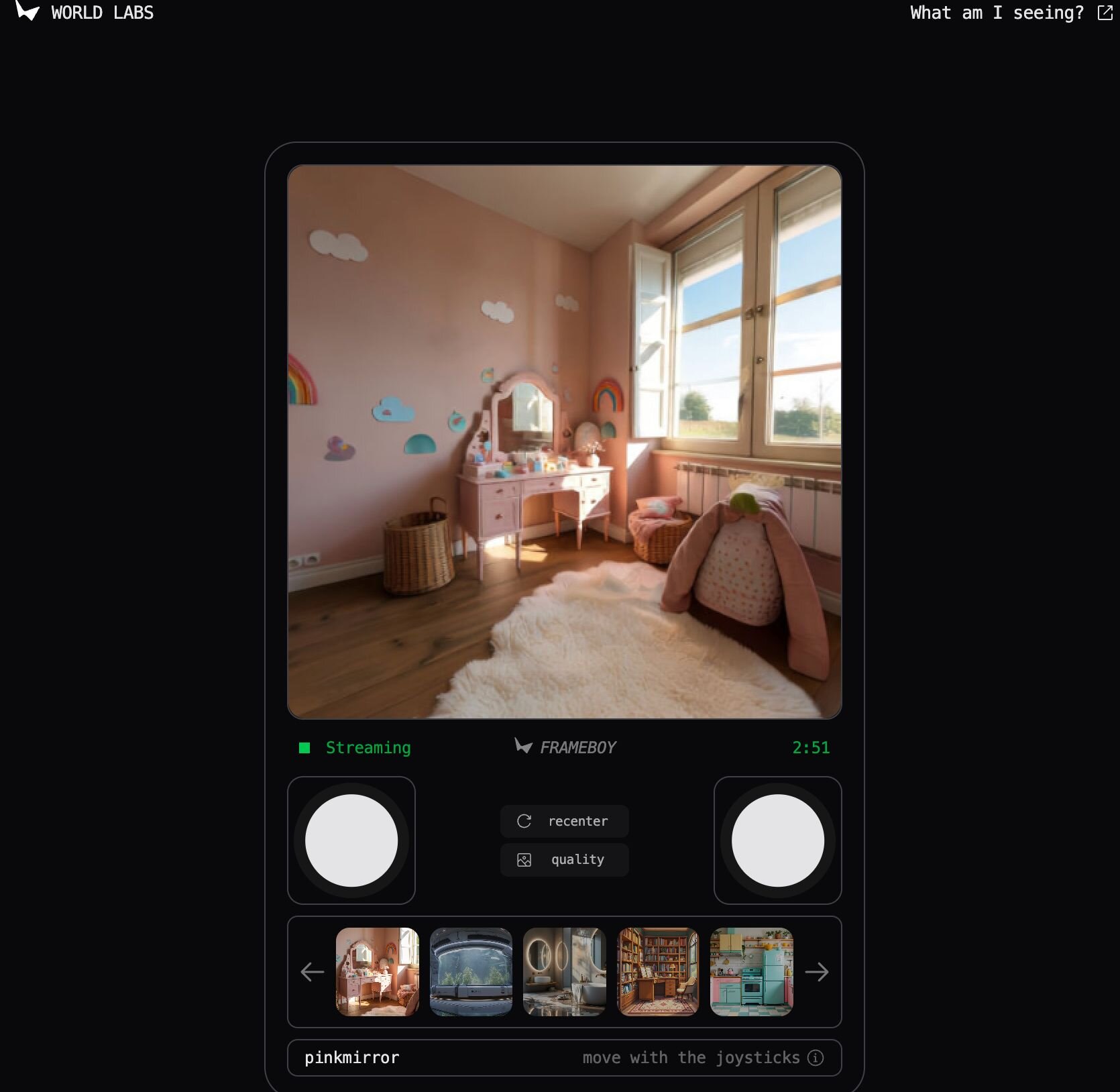

RTFMデモサイトでは、RTFMモデルによってリアルタイムで生成される、様々な3Dシーンをインタラクティブに探索することができる。

「pinkmirror」「biolab」「cozystudy」などの用意されたデモシーンを選択するとワールドが読み込まれ、ユーザーは視点を動かしながら、モデルがリアルタイムで描写する、永続的かつ3D的一貫性のある空間を体験できる。

■RTFMデモサイト

https://rtfm.worldlabs.ai/

CGWORLD関連情報

●ワールドモデル「Genie」のミニマル実装「TinyWorlds」公開! シンプルな実装で生成AIと世界モデルを手軽に体験できるプロジェクト

Anand MajmudarがGoogle Deepmindのワールドモデル(世界モデル)「Genie」のコアアイデアを、少ないコードでシンプルに、300万パラメータで実装したワールドモデル「TinyWorlds」をGitHubで公開。執筆現在はライセンス表記がないため、オープンソースかどうかは不明。

https://cgworld.jp/flashnews/01-202510-TinyWorlds.html

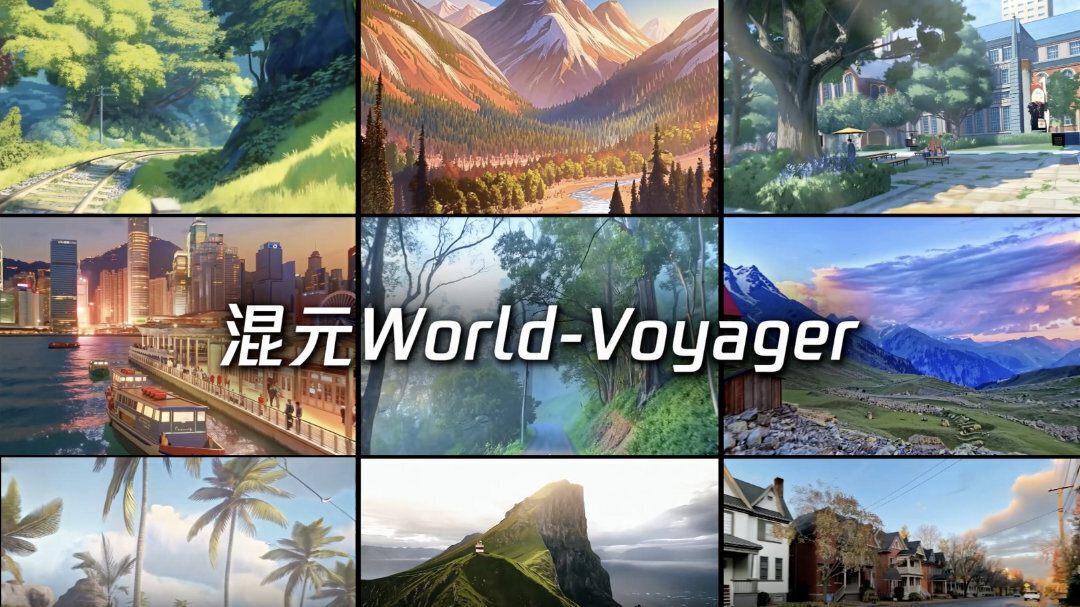

●世界モデル「HunyuanWorld-Voyager」オープンソースで公開! 点群動画から3Dへの直接のエクスポートも可能

テンセントのHunyuanチームが世界モデル「HunyuanWorld-Voyager」をオープンソース(研究や個人利用に加え、一定の条件下で商用利用も許可する独自ライセンス)で公開。1枚の画像とユーザーが定義したカメラの軌道から、3D的に一貫性のある動画を生成できる。

https://cgworld.jp/flashnews/01-202509-HunyuanWorld-Voyager.html

●世界モデル「Mirage 2」公開! 画像とプロンプトからリアルタイムでインタラクティブな空間を生成し、リンク共有でオンラインプレイが可能

Dynamics LabがAIシステム「Mirage 2」を公開。画像やテキストプロンプトから、ユーザーが操作・探検できるインタラクティブな3D世界をリアルタイムに生成する技術で、ユーザーが創作した世界(ゲーム)はオンラインで共有できる。Mirage 2は現在、ユーザーを問わずオンラインでプレイ可能となっている。

https://cgworld.jp/flashnews/01-202509-Mirage2.html