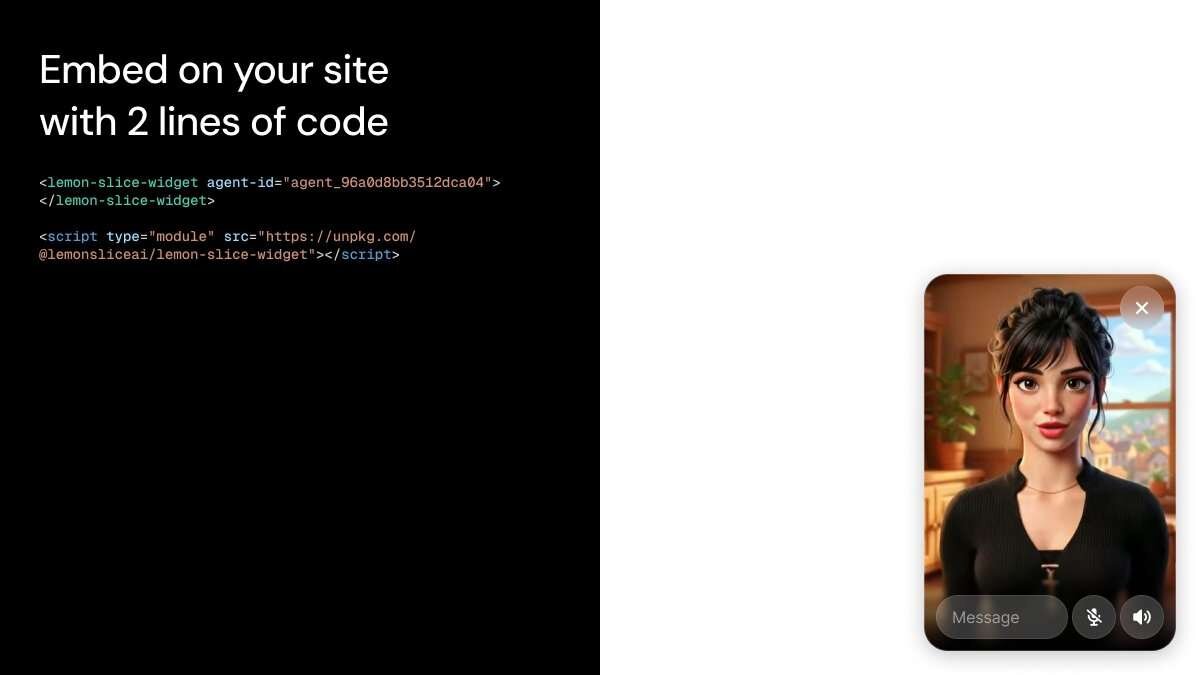

Lemon Slice社は12月17日(水)、インタラクティブな対話型AI動画モデル「Lemon Slice-2」をリリースした。実写・CGを問わず、人物やキャラクターの写真1枚からチャットボットや音声AIに利用可能なアニメーションを生成し、APIまたは埋め込みウィジェットとして利用できる。有料サブスクリプションへの加入が必要で、月額7ドル(約1,100円)から。

Give your voice agents a face.

— Lina Colucci (@lina_colucci) December 16, 2025

Introducing Lemon Slice-2 – the world's first interactive talking AI video model

Think of it as a face layer for your voice agents, available today in production as an API or an embeddable widget.

What makes Lemon Slice-2 great:

→ Easy: All you… pic.twitter.com/rPqZ5wW8Jh

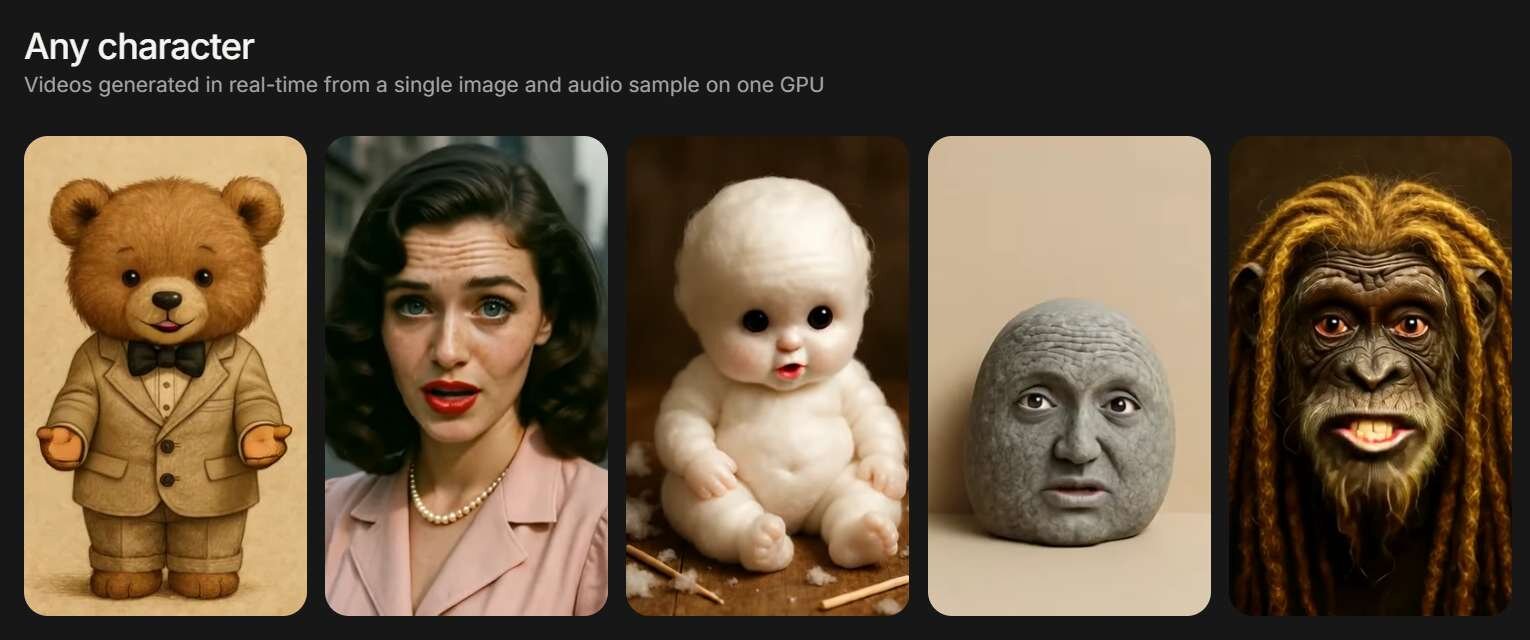

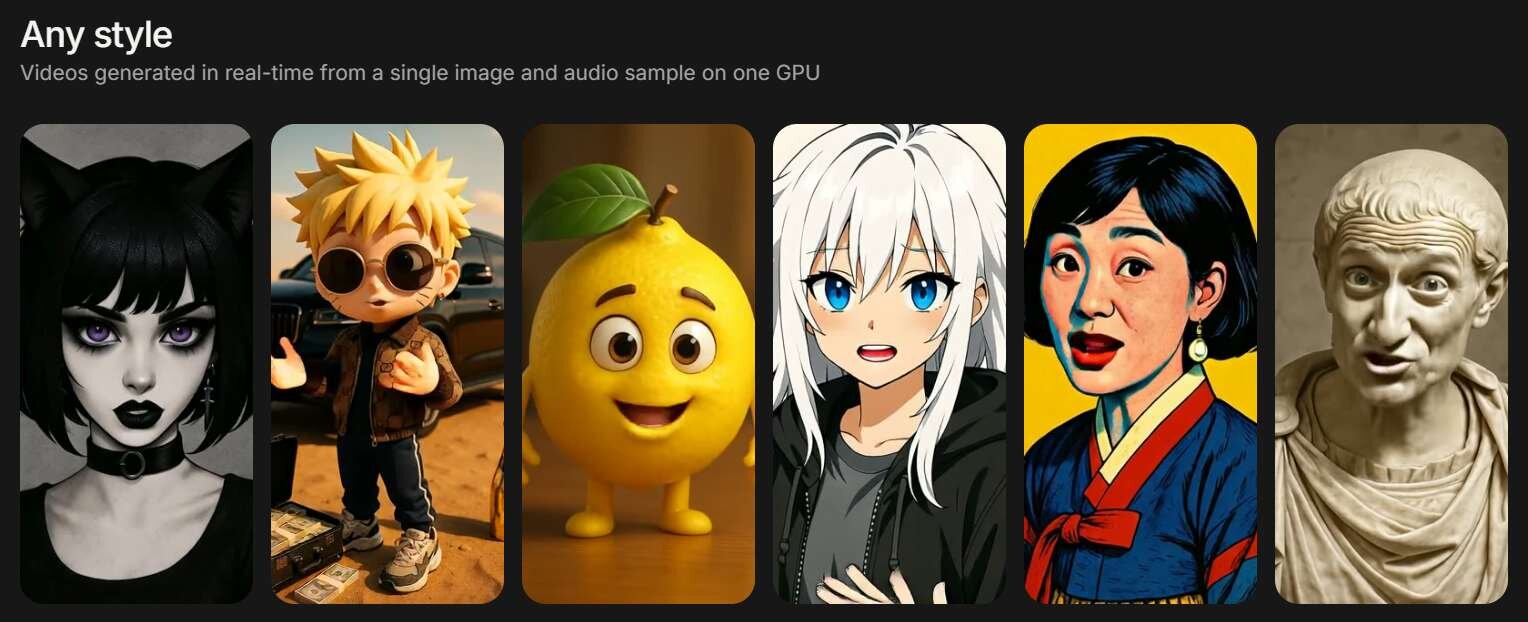

「Lemon Slice-2」は、顔として認識できるものであればあらゆるキャラクターやスタイルの画像を利用可能で、手や全身の動き(Full Body Motion)まで含めた対話アニメーションを生成できる。

技術基盤には、独自で開発した200億パラメータ規模のビデオ拡散トランスフォーマー(Video Diffusion Transformer)を採用。単一のGPU上で20fpsのストリーミング生成を実現している。同社は、Lemon Slice-2では映像を長時間生成し続けた際に画質の劣化やエラーの蓄積(Error Accumulation)が発生せず、理論上は無限に動画生成が可能としている。

Companies and creators are already building video agents that are:

→ Customer support agents who screen-share and show you where to click

→ Lead qualification agents that replace forms with real conversations

→ AI personal shoppers who try on clothes and guide purchases企業やクリエイターたちは、すでに以下のような動画エージェントを構築しています。

→ 画面共有を行い、どこをクリックすればよいか具体的に案内してくれるカスタマーサポートエージェント

→ 入力フォームの代わりに、リアルな会話を通じて見込み客の選別を行うエージェント

→ 服を試着して見せ、購入をサポートしてくれるAIパーソナルショッパー

Since Lemon Slice-2 is a diffusion model, you can modify the video in mid-conversation with text prompts - change style, clothing, or background.

— Lina Colucci (@lina_colucci) December 16, 2025

Try it for yourself on our homepage: https://t.co/x22Yfc4OqQ pic.twitter.com/fbaQLMQnuv

/3 Use Lemon Slice to add a customer support video agent to your website.

— Lina Colucci (@lina_colucci) December 16, 2025

For example, imagine you’re @Geico, your customers can actually talk to @TheGeicoGecko about their quote. pic.twitter.com/QTVuDNzwVi

■Lemon Slice-2公式サイト

https://lemonslice.com/

■Introducing Lemon Slice-2(公式ドキュメント)

https://lemonslice.com/research

プランと価格

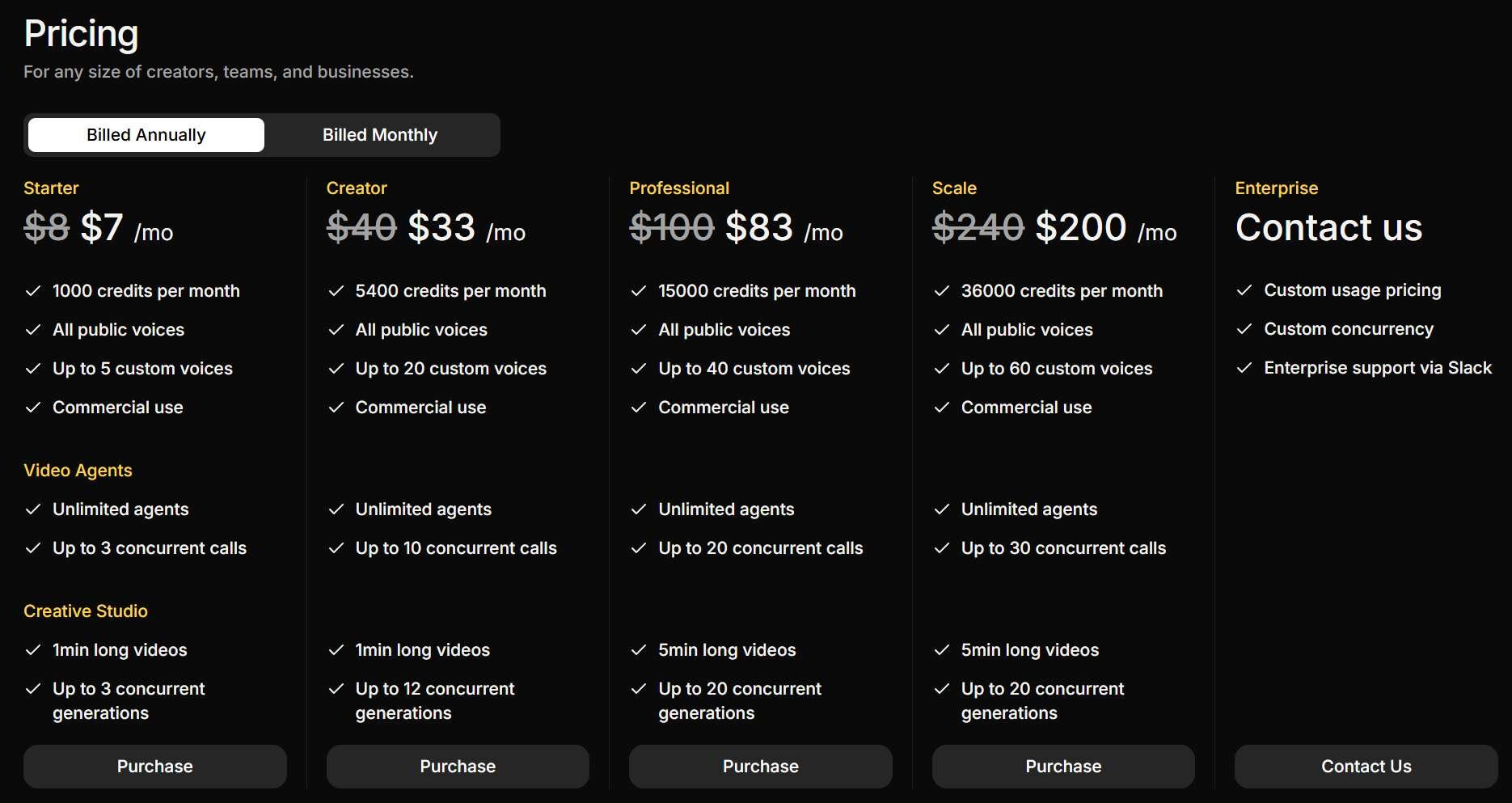

Lemon Sliceの利用には有料サブスクリプションへの加入が必要。個人向けの基本プランであるStarterプランは年払いで月額7ドル(約1,100円)。毎月1,000クレジットが付与され、全ての公開ボイス(Public Voices)が利用可能、独自のカスタムボイスは最大5つまで登録できる。Creatorプランは年払いで月額33ドル(約5,200円)。毎月5,400クレジットが付与され、カスタムボイスの登録枠が20まで拡張される。いずれのプランも商用利用に対応する。

■Lemon Slice-2 Pricing

https://lemonslice.com/pricing

CGWORLD関連情報

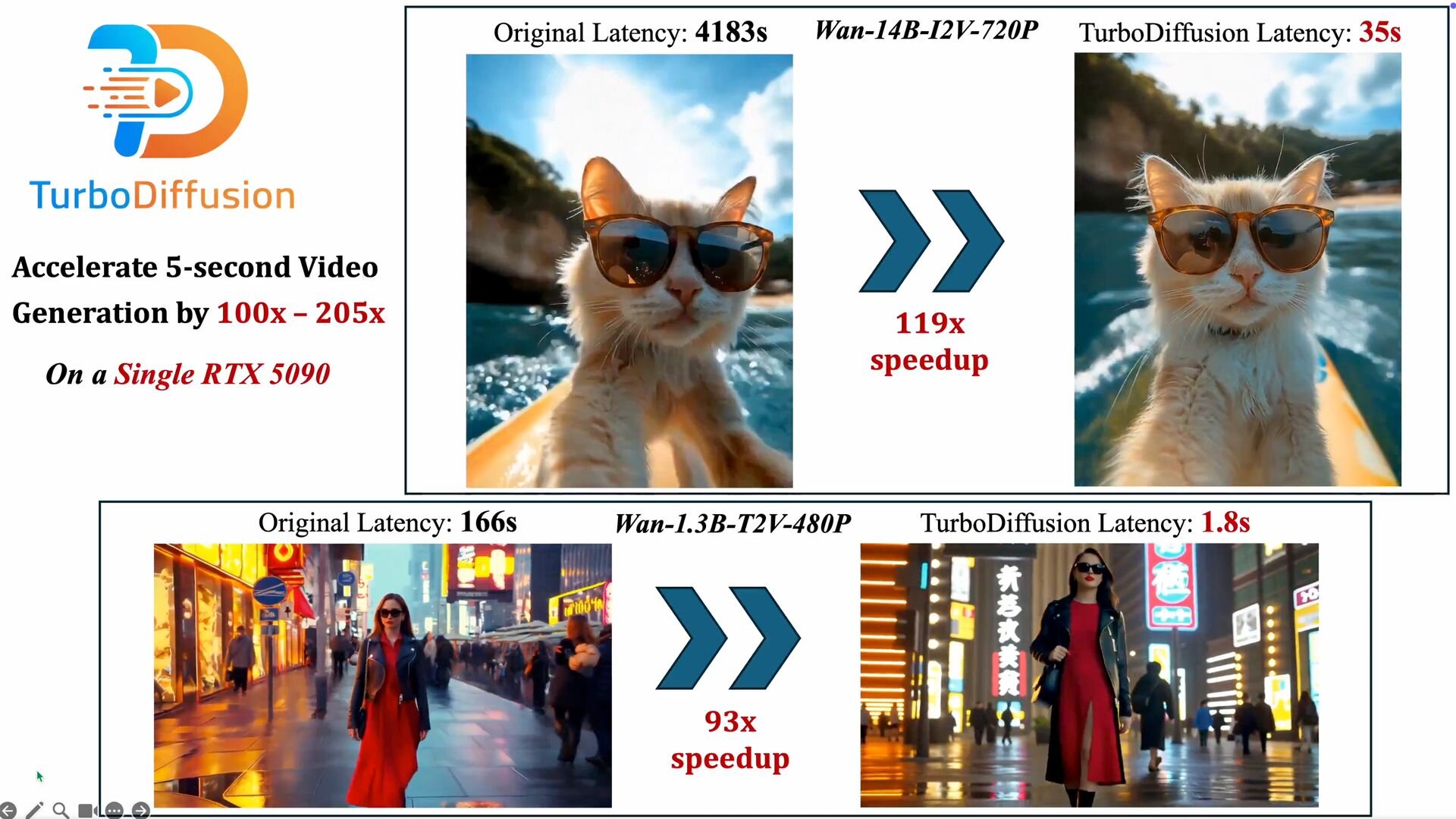

●オープンソースの高速な動画生成AIモデル「TurboDiffusion」公開! 単一のRTX 5090で従来技術比100~205倍高速

清華大学、生数科技、カリフォルニア大学バークレー校からなる研究チームが、動画生成AIの推論速度を向上させる新技術「TurboDiffusion」を公開。単一のNVIDIA GeForce RTX 5090を用いて数秒で動画生成が行えるという。ソースコードはGitHubで、学習済みモデルのチェックポイントはHugging Faceで公開されている。ライセンスはApache-2.0。

https://cgworld.jp/flashnews/01-202601-TurboDiffusion.html

●マルチモーダル生成AIモデル「Wan2.6」リリース! 1080p15秒、リファレンスキャラクターのインポート、マルチショット生成によるストーリーの自動構築など

Tongyi Labがテキスト・画像・音声入力を統合し、リアルな画像と動画を生成するマルチモーダル生成AIモデル「Wan2.6」をリリース。特定のリファレンスキャラクターを異なるシーンへ一貫性を保ったまま配役する「Starring」機能、単純な指示から複数のカットで構成される物語を自動構築する「マルチショット・ナラティブ」機能、ネイティブレベルでのA/V同期による自然な対話シーン、1080p、緻密なライティング制御などの特徴を備える。Wan2.6は公式プラットフォームやサードパーティ製プラットフォーム、APIから利用可能。

https://cgworld.jp/flashnews/01-202512-Wan2.6.html

●マルチモーダル動画生成AIモデル「Kling O1」リリース! テキスト・画像・動画・特定の被写体を組み合わた入力に対応、動画生成から編集・スタイル変換まで1モデルに統合

快手がマルチモーダル動画生成AIモデル「Kling O1 動画モデル」をリリース。テキストと参照画像、既存の動画、特定の被写体(エレメント)を混在させて指示を出し、3秒から10秒までの動画を生成できる。チャットによる複雑な動画編集やスタイル変換の機能も統合。公式Webアプリでは無料・有料プラン共に利用できるほか、各種サードパーティ製プラットフォームで提供されている。

https://cgworld.jp/flashnews/01-202512-KlingO1.html