アメリカRoboflow社は1月29日(木)、オープンソース(Apache-2.0ライセンス)のモーショントラッキングツール「trackers v2.1.0」をリリースした。本アップデートでは、高速かつ遮蔽に強い追跡アルゴリズム「ByteTrack」のサポートが追加された。また、Roboflow社のセグメンテーションモデル「RF-DETR」ともシームレスに連携が可能。

pip install trackers

— SkalskiP (@skalskip92) January 28, 2026

trackers v2.1.0 is out; this release adds support for ByteTrack, a fast tracking by detection algorithm focused on stable identities under occlusion.

link: https://t.co/9Fam5U1zuC pic.twitter.com/uRBudFyY7B

trackers v2.1.0 is out; this release adds support for ByteTrack, a fast tracking by detection algorithm focused on stable identities under occlusion.

trackers v2.1.0 がリリースされました。今回のリリースでは、遮蔽(occlusion)下でも安定して同一性を保持することに重点を置いた、高速な「検出による追跡(Tracking by Detection)」アルゴリズムである ByteTrack のサポートが追加されています。

trackers v2.1.0 がリリースされました。今回のリリースでは、遮蔽(occlusion)下でも安定して同一性を保持することに重点を置いた、高速な「検出による追跡(Tracking by Detection)」アルゴリズムである ByteTrack のサポートが追加されています。

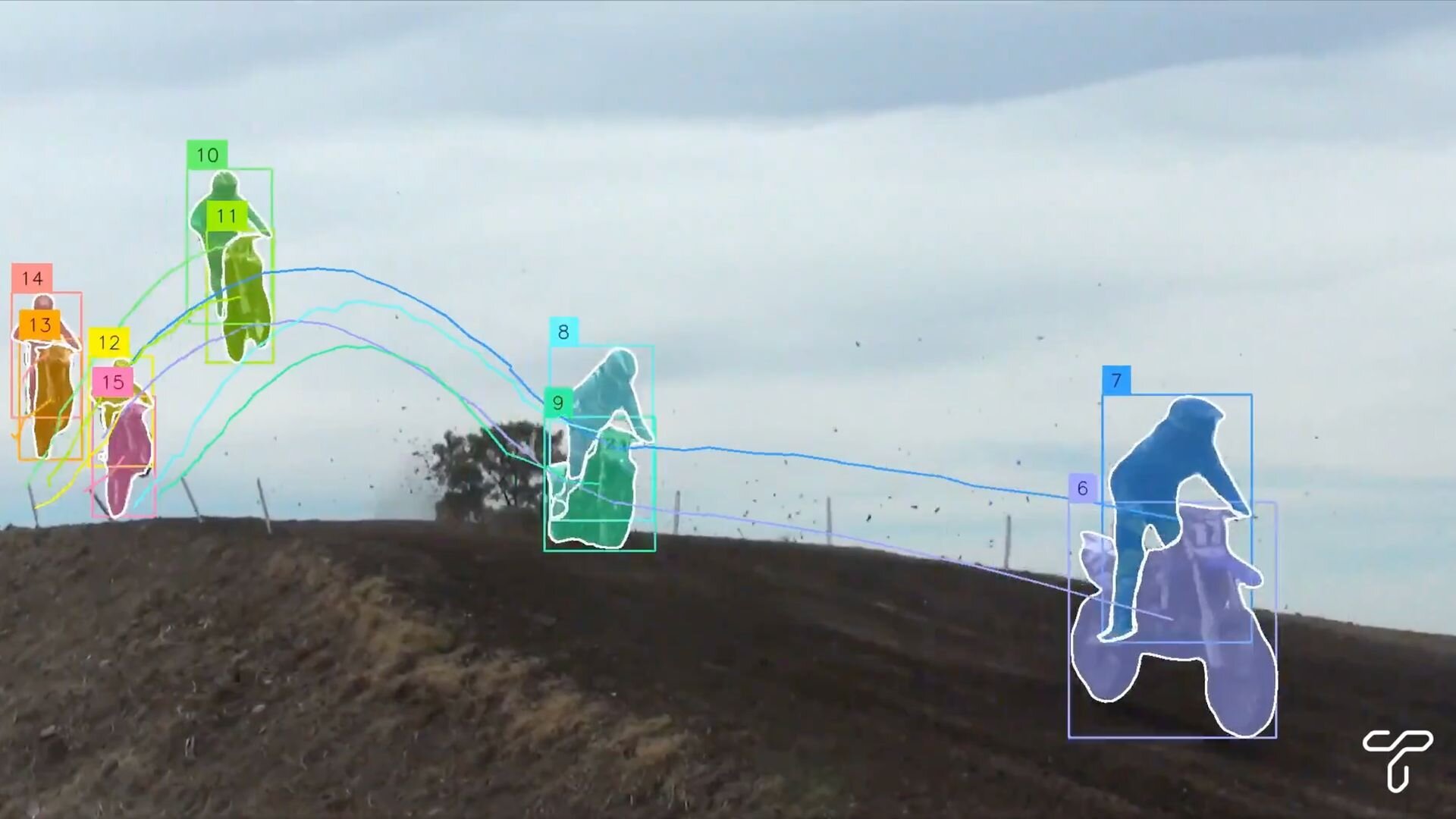

「trackers」は、映像内の物体を検出するだけでなく、それらが時間の経過とともにどう移動したかを記録する「Multi Object Tracking(複数物体追跡)」を実装するためのPythonライブラリ。通常の物体検出モデル(Detection Model)単体では、映像の各フレーム(コマ)ごとに「何がどこにあるか」を判定することはできるが、前後のフレームに映っている物体が「同一のものか」を識別することはできない。

しかしtrackersは、検出モデルが出力した結果に対し、フレームをまたいで一貫したID(識別番号)を付与する機能を提供する。これにより、例えば交差点を通過する車の台数カウントや、店舗内での人の動線分析、スポーツ選手の移動軌跡の可視化など、単なる検出を超えた高度な映像解析が可能となる。本ツールは、YOLOシリーズなどの一般的な検出モデルや、対象の形をピクセル単位で切り抜くセグメンテーションモデルと組み合わせて使用できるよう設計されており、既存のAIモデルに追跡機能を容易に付加できる。

trackers v2.1.0で新たにサポートされた「ByteTrack」は、物体検出の結果を用いて対象を追跡する「Tracking by Detection(検出による追跡)」という手法を用いたアルゴリズム。この手法における最大の課題は、対象が他の物体や障害物の後ろに隠れるオクルージョン(遮蔽)が発生した際に、追跡が途切れたり、別のIDに切り替わったりしてしまう点にあった。

これに対しByteTrackでは、信頼度の高い検出結果だけでなく、従来は破棄されていた信頼度の低い検出結果も保持し、追跡の計算に活用するアプローチを採用。これにより、対象の一部が隠れて検出スコアが一時的に低下した場合でも、既存の追跡データと照合して「同一の物体である」と再認識することが可能となった。この改善により、混雑したシーンや複雑な動きをする対象に対しても安定したID維持能力を発揮する。

また、trackersはRoboflow社の「RF-DETR」セグメンテーションモデルともシームレスな連携が可能。本モデルは、画像内の物体を矩形で囲むだけでなく、その輪郭に沿って正確に切り分けることができる。この高精度なセグメンテーション能力とtrackers v2.1.0の追跡機能を組み合わせることにより、開発者はよりディテール豊かで信頼性の高い映像解析システムを構築することができるとのことだ。

trackers lets you combine strong multi object tracking with your detection or segmentation model

— SkalskiP (@skalskip92) January 28, 2026

I use RF-DETR Segmentation, a state-of-the-art segmentation model we released last week

link: https://t.co/6tF4mhWkCA pic.twitter.com/YIfocK3F7B

RF-DETR Segmentation running real-time on webcam

— SkalskiP (@skalskip92) January 29, 2026

that was pretty cool live stream; you can still watch it

link: https://t.co/LdOW8uilY8 https://t.co/lcMQLgKHFQ pic.twitter.com/BBvDlXUC4C

taking pothole detection to the next level

— SkalskiP (@skalskip92) February 2, 2026

real-time; takes only 15 minutes to train; no manual annotations

- auto-annotated the dataset with SAM3

- fine-tuned RF-DETR segmentation model

- track and count potholes with ByteTrack https://t.co/WmCboyhYop pic.twitter.com/QSfRvPHeJP

taking pothole detection to the next level

real-time; takes only 15 minutes to train; no manual annotations

- auto-annotated the dataset with SAM3

- fine-tuned RF-DETR segmentation model

- track and count potholes with ByteTrack路面の穴(pothole)検出を次の次元へ

リアルタイム動作、学習時間はわずか15分、手動アノテーション(ラベル付け)は一切不要

・SAM3 を使用してデータセットを自動アノテーション

・RF-DETR セグメンテーションモデルをファインチューニング

・ByteTrack でポットホールを追跡してカウント

■trackers(GitHub)

https://github.com/roboflow/trackers

■RF-DETR: Real-Time SOTA Detection and Segmentation(GitHub)

https://github.com/roboflow/rf-detr

■How to Track Objects with RF-DETR and ByteTrack Tracker(Google Colab)

https://colab.research.google.com/github/roboflow-ai/notebooks/blob/main/notebooks/how-to-track-objects-with-bytetrack-tracker.ipynb

■ByteTrack(GitHub)

https://github.com/FoundationVision/ByteTrack

CGWORLD関連情報

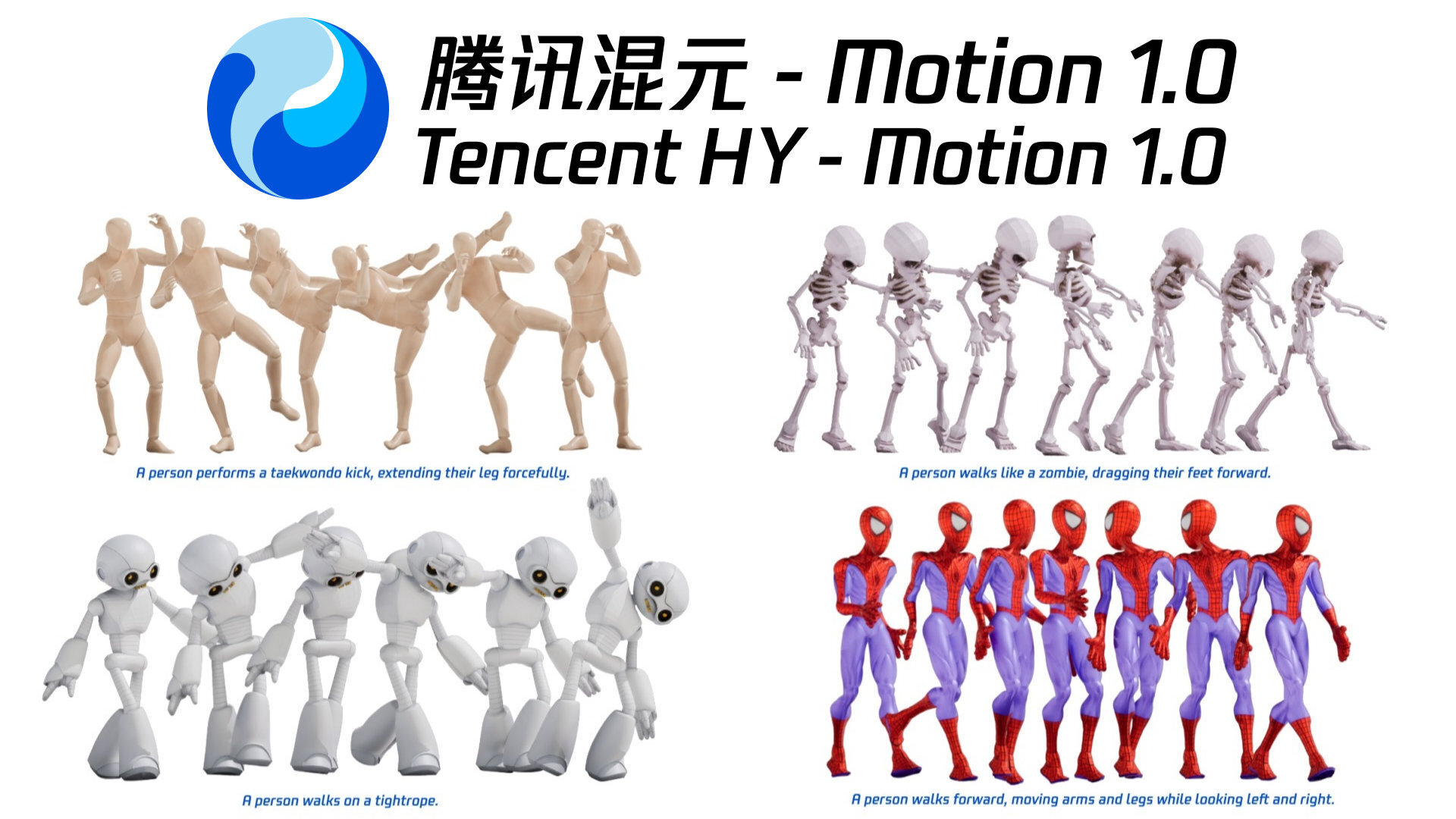

●テンセント、オープンソースのモーション生成モデル「HY-Motion 1.0」リリース! テキストプロンプトから3Dキャラクターのモーションを生成

テンセントのHunyuanチームが、テキストプロンプトに基づいて3Dキャラクターモデルの動作を生成する、オープンソースのAIモデル「HY-Motion 1.0」を公開。ソースと学習済みモデルのウェイトがGitHubとHugging Faceで配布されている。ライセンスは独自の「TENCENT HY-MOTION 1.0 COMMUNITY LICENSE」が適用されており、MAU1億人超の大規模プラットフォーマーを除く一般企業や個人は無償で商用利用、複製、改変、再配布が可能。

https://cgworld.jp/flashnews/01-202601-HY-Motion.html

●Metaの3D生成AI技術「SAM 3D」発表! 単一の2D画像から精密な3Dオブジェクトや人物を再構築、GitHubとHugging Faceでコード&データ公開

Metaが画像セグメンテーションAIの最新モデル「Segment Anything Model 3(SAM 3)」と、単一画像から3Dモデルを再構築する「SAM 3D」を発表。ソースコードはGitHubで公開されているが、独自ライセンスによって「SAM 3」基盤モデル、「SAM 3D Body」、「SAM 3D Objects」が明確に区分されている。データセットはHugging Faceで公開されているほか、同社AI技術のプレイグラウンド「Meta AI Demos」ではブラウザ上でSAM 3Dをテストできる。

https://cgworld.jp/flashnews/01-202511-Meta-SAM3D.html

●バイトダンス、オープンソースの単眼深度推定技術「Depth Anything 3」発表! 単一画像、多視点画像、動画のいずれからでも空間的整合性の取れたジオメトリを推定する基盤モデル

ByteDance Seedが単眼深度推定技術「Depth Anything 3」を発表。任意の数の画像入力から、カメラポーズの既知・未知を問わず、空間的に整合性の取れたジオメトリを予測する基盤モデル。ソースはGitHubで、デモはHugging Faceで公開されている。用途や規模に応じた複数のモデルシリーズが、2種類のライセンス(Apache-2.0またはCC BY-NC 4.0)で提供される。

https://cgworld.jp/flashnews/01-202511-DepthAnything3.html