大連理工大学、香港中文大学、快手の研究チームは2月14日(金)、動画生成AIフレームワーク「CineMaster: A 3D-Aware and Controllable Framework for Cinematic Text-to-Video Generation」の査読前論文(プレプリント)を公開した。Text-to-Videoの動画生成において、ユーザーが3D空間内のオブジェクトとカメラを操作して、高品質なシネマティック動画を生成できる技術となる。

CineMasterによる動画生成のながれ

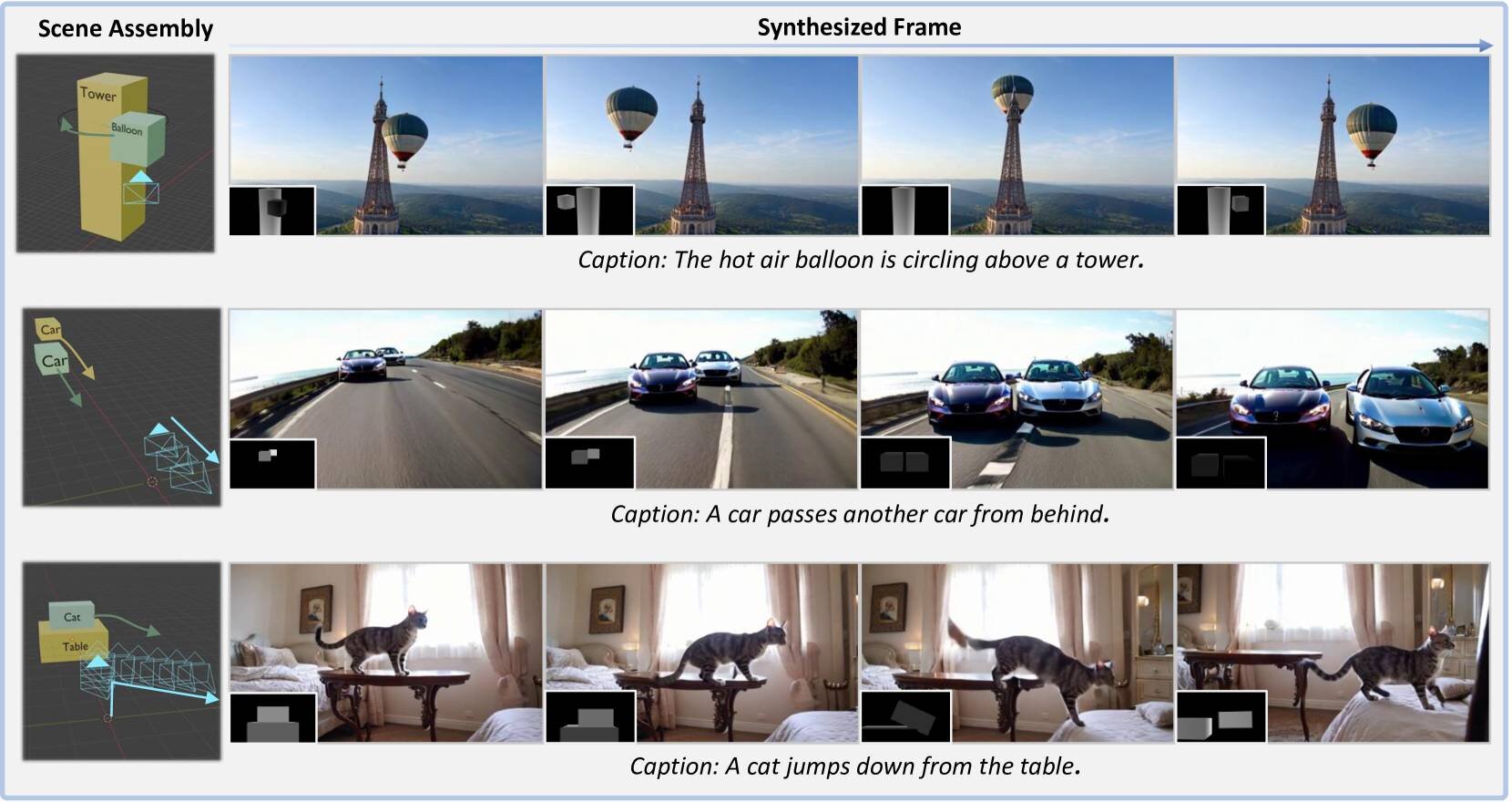

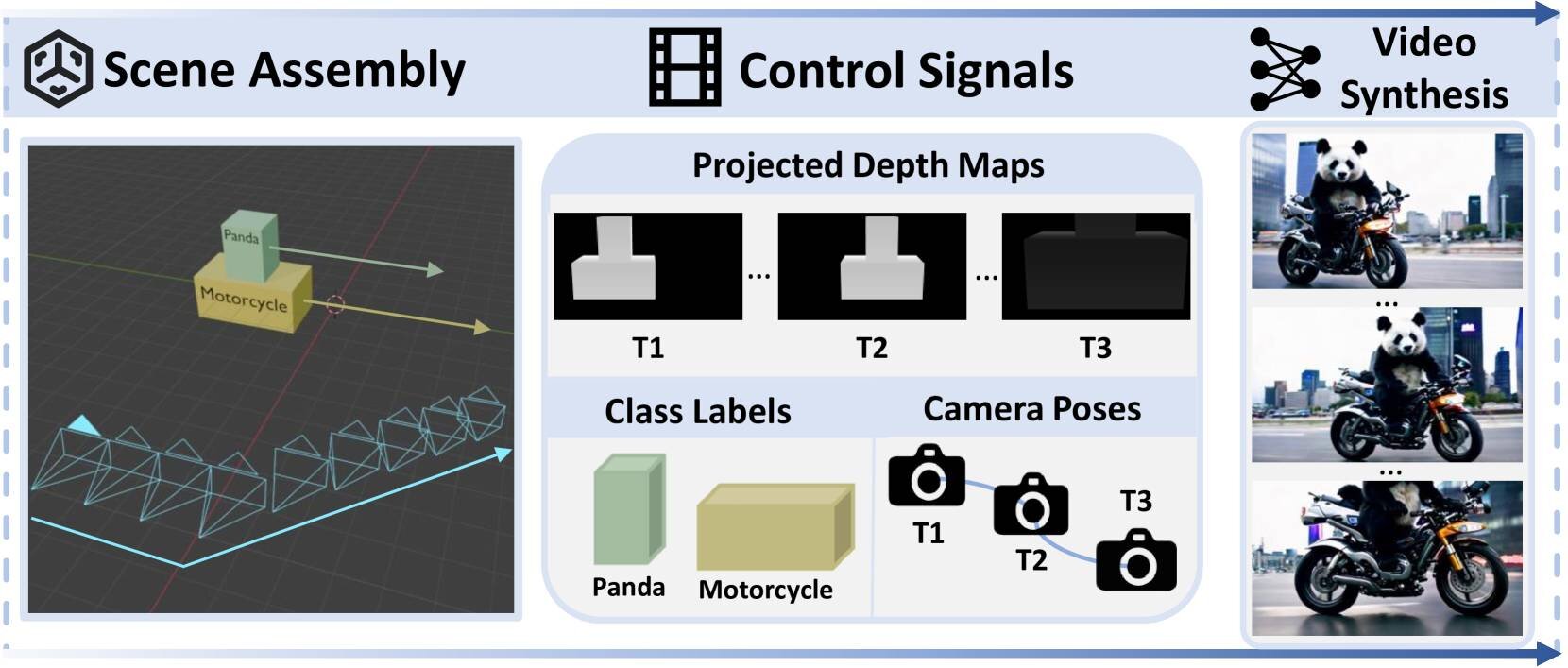

CineMasterは、シーン内のオブジェクトの正確な配置と3D空間におけるオブジェクトとカメラの柔軟な操作、そしてレンダリングされたフレームに対する直感的なレイアウト制御などが行えるフレームワーク。

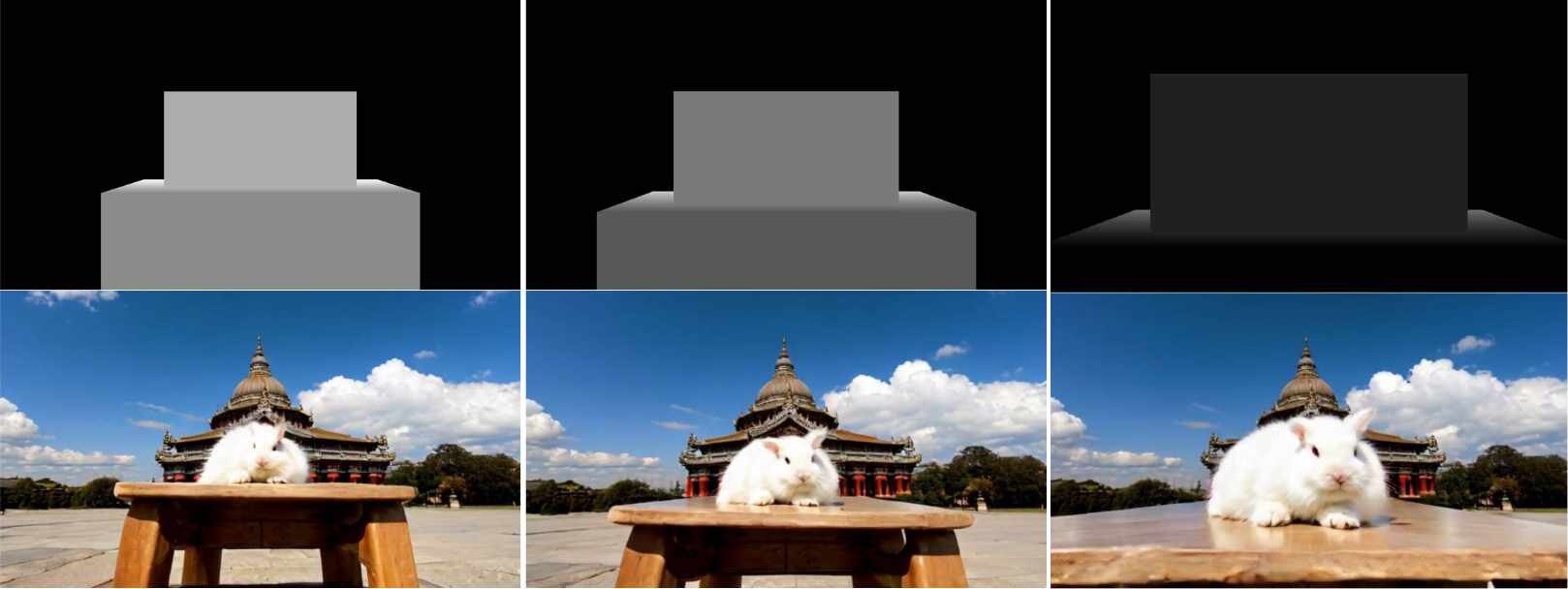

CineMasterは2ステージで動作する。第1ステージでは3D空間内にオブジェクトのバウンディングボックスを配置し、カメラの軌道を設定してユーザーが3D空間を直感的に操作することで、深度(デプス)マップやカメラの軌跡、オブジェクトのクラスラベルといった具体的なシーンの3D情報をコントロール信号として抽出する。

第2ステージでは、抽出したコントロール信号をText-to-Videoの動画生成に用いる拡散(diffusion)モデルにガイドとして入力する。これにより、3D空間表現としてユーザーが意図した動画を生成する。

なお研究チームは、CineMasterの動画生成に不足する3Dオブジェクトのモーションとカメラポーズのアノテーションを持つ実データセットを補うため、大規模な動画データから3Dバウンディングボックスとカメラの軌道データを抽出する自動アノテーションパイプラインを構築。これにより、従来の手法と比較して、より精密かつ多様な動画生成が可能になったとしている。

CineMaster lets you manipulate object and camera motion for video-generation using 3D primitives pic.twitter.com/29e4neVTtq

— Dreaming Tulpa (@dreamingtulpa) February 19, 2025

■CineMaster: A 3D-Aware and Controllable Framework for Cinematic Text-to-Video Generation(プロジェクトページ、英語)

https://cinemaster-dev.github.io/

CGWORLD関連情報

●TiktokのByteDanceらが動画生成AI「Goku」を発表! 動画広告作成に特化した「Goku+」も

香港大学の研究チームとByteDanceが動画生成AI「Goku」の論文を発表。GitHubのリポジトリやサンプル動画を公開した。高速推論を実現する最先端のアルゴリズム「Rectified Flow Transformers」をベースにしたモデルで、テキストや画像からの動画生成、テキストからの画像生成を行える。

https://cgworld.jp/flashnews/202502-ByteDance-Goku.html

●Adobeの生成AI「Firefly」で動画の生成が可能に! クレジット消費方式、フルHD・5秒、カメラコントロールあり

Adobeが動画生成AIモデル「Firefly Video Model」をAdobe Firefly Webでベータ公開。他社動画生成AIモデルと同様のクレジット消費制で、各種Creative Cloudプランのユーザーには毎月クレジットが付与されるほか、月額課金プランも用意される。

https://cgworld.jp/flashnews/202502-Adobe-FireflyVideo.html

●日本初の日本語対応の動画生成AI基盤モデル「AIdeaLab VideoJP」無償公開! 商用利用可、ライセンスに考慮しゼロから動画学習

AIdeaLabが動画生成AI基盤モデル「AIdeaLab VideoJP」をHugging Faceで公開。日本語および英語のプロンプト文から動画を生成でき、生成動画の商用利用も可能。ライセンスはApache-2.0。

https://cgworld.jp/flashnews/202502-AIdeaLab-VideoJP.html