2022年9月19日(月・祝)から22日(木)、NVIDIAは秋期GTC2022を開催した。最新のGPUやAI技術を活用したデモやビジネスが発表された同カンファレンスでは、AIとCGの融合領域に関するセッションも行われた。本稿では、そうしたセッションから3つをピックアップしてその内容をまとめていく。

CGを進化させるNVIDIAのAI研究

「Examining the Latest Deep Learning Models for Real-Time Neural Graphics(リアルタイム・ニューラル・グラフィックスのための最新ディープラーニング・モデルを検証する)」と題されたセッションでは、NVIDIAのテクニカルエンジニアリングディレクター、Andrew Edelsten/アンドリュー・エデルセン氏が同社のAI研究を応用したCG技術について発表した。

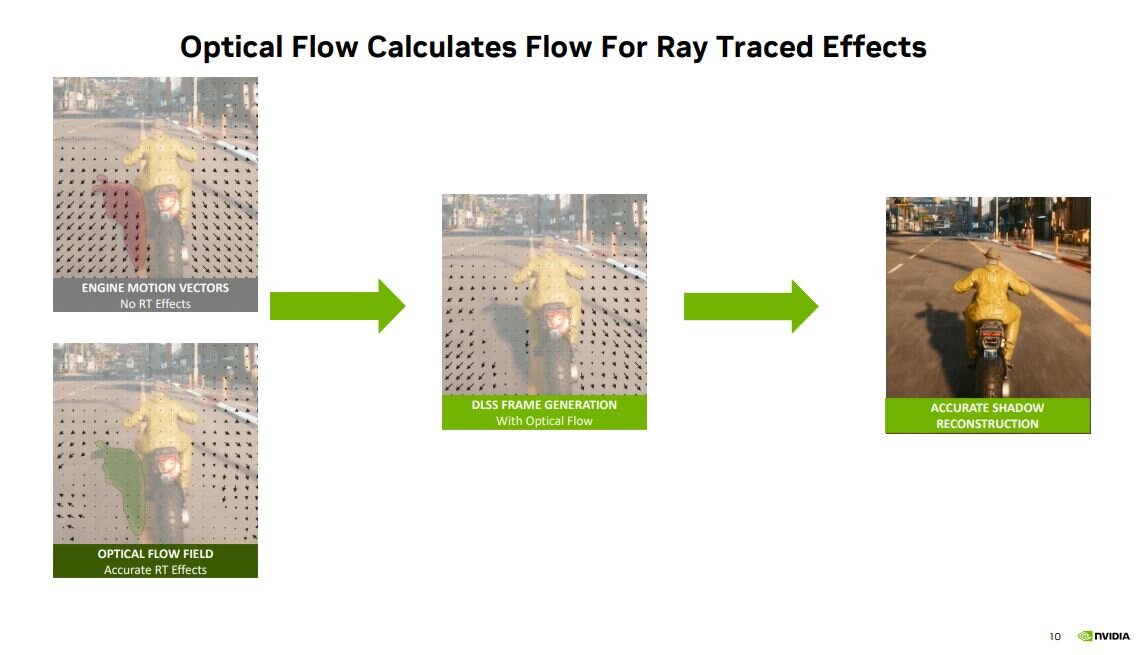

はじめにエデルセン氏は、NVIDIAが開発した最新レンダリング技術「DLSS 3」について発表した。同技術は4K画質の描画を可能としたDLSS 2が進化したものだが、DLSS 2との違いはフレームレートにある。DLSS 2が60fps程度だったのに対して、DLSS 3は約100fpsとなる。こうしたフレームレートの向上は、ゲームエンジンから描画オブジェクトのモーション情報を取得すると同時に描画フレームから光学的情報を取得して、これらの情報を合成することで可能となった。こうした合成処理によって、高フレームレートであっても高品質なレイトレーシング処理も実現した。

ついで発表されたのが、CGキャラクターの様々なモーションを強化学習によって習得させる技術である。この技術を使えば、「持っているものを振り回す」という基本モーションから「剣を振る」や「盾で殴打する」といったモーションを派生させられる。この技術を論じた論文は、SIGGRAPH 2022で採択された。

様々な画像を生成するAIモデルも発表された。例えば「GauGAN 360」は2019年に発表されたGauGANを360度画像の生成に対応させたものだ。同モデルを使えば、ラフなスケッチからフォトリアルな風景が描かれた360度動画を制作できる。ファンタジー世界のフィールドや建物を自動生成するAI「Dungeon Alchemist」も紹介された。同AIはKickstarterプロジェクトから誕生したものだが、これを使えばゲームに登場する多数の家を簡単に制作できるようになる。

エデルセン氏は、最後にSIGGRAPH 2022で最優秀論文を受賞したAI技術「Instant NeRF」を発表した。この技術は、数十枚の画像から数十ミリ秒以内に3Dシーンを生成するものである。同様の技術を開発するために、かつては1日から2日かけてAIを訓練していたのだが、最新のGPUを活用すればわずか数秒で訓練が完了する。

以上に紹介した技術は今後高速で実行されるようになって、ほぼリアルタイムで利用できるようになるだろう、と話してエデルセン氏はセッションを締めくくった。

AI技術が当たり前となったILMの制作現場

「ILM: Leveraging AI in Visual Effects and StageCraft Virtual Production(ILM:視覚効果におけるAIの活用とStageCraftバーチャルプロダクション)」と題されたセッションでは、ILM(Industrial Light & Magic)でリアルタイムクリエイティブプリンシパルを務めるLandis Fields/ランディス・フィールズ氏が、同社におけるAI技術活用についてインタビューに答えた。

インタビューでは配信ドラマ『マンダロリアン』で使われたディープフェイクが話題になった。映画『スター・ウォーズ』シリーズと世界観を共有している同ドラマでは、1977年から1983年に制作された旧三部作の主人公ルーク・スカイウォーカーが若い姿で登場した。

若き日のルークを映像化するにあたり、同ドラマ制作当時はディープフェイクをドラマ制作に使った前例がなかった。こうしたなか、プロデューサーのジョン・ファヴローが同技術を使うと決断したのだが、このことを知っていたのはごく少数の関係者のみであった。実際の撮影では、ルークと顔を入れ替える演者の演出には、ルークを演じていたマーク・ハミルも関わった。完成したディープフェイクを使ったシーンを見た時、まるでマーク・ハミルをタイムマシンで連れてきて撮影したように感じた、とフィールズ氏は語った。

ILMで使われているAI駆動型検索技術「DeepSearch」についてもフィールズ氏は答えた。同技術は、AIが画像を自動的に分類することでタグ付けされていない画像も適切に検索できるというもの。20年以上前のタグ付けされていない画像を大量に保有している同社にとって、タグ付けせずに検索できる同技術は現在ではなくてはならないものになっている。同技術を使えば、例えば空の映像を制作するとき、以前にハワイで撮影した2枚の画像とアイスランドで撮影したものをリストアップして比較できる、と同氏は話した。

フィールズ氏は、近年注目されるテキスト入力から画像を生成できるAI技術についても話した。この技術に関して興味深いのは、その使用方法がクリエイターによって異なるところだ、と同氏は述べた。

「NVIDIA Canvas」の撮影現場での活用状況にも言及された。ラフなスケッチからフォトリアルな画像を生成できる同ツールを使えば、いわゆる絵心がない制作関係者であっても映像に関するアイデアを出せる、とフィールズ氏は絶賛した。

30人のアーティストのコラボを可能としたOmniverse

「An Artist's Omniverse: How to Build Large-Scale, Photoreal Virtual Worlds(アーティストのOmniverse:大規模なフォトリアル・バーチャルワールドを構築する方法)」と題されたセッションでは、秋期GTC 2022のために制作されたCG動画『NVIDIA Racer RTX』の制作舞台裏に関するQ&Aがオンラインで行われた。

Racer RTXの制作過程に関しては、2022年9月20日(火)に公開されたNVIDIA公式ブログ記事で解説されている。その記事によると同動画は、NVIDIAのクリエイティブディレクターGabriele Leone/ガブリエル・レオネ氏率いるクリエイティブチームが同社開発の仮想空間プラットフォームOmniverseを用いたコラボレーションにより制作されたという。

Omniverseがもつ強力な演算能力によって、Racer RTX内のオブジェクトはほぼ全てシミュレーション可能となった。また、同プラットフォームによって複数のアーティストが同時に作業できるようになったことで、大幅に工数を削減できた。高品質なレイトレーシングの実行には、前述のDLSS 3が用いられている。

Racer RTXをめぐるQ&Aセッションではレオネ氏をはじめとした4人のアーティストが視聴者の質問に答えたが、注目すべき回答を箇条書きにすると以下のようになる。

・Racer RTXの作品コンセプトは、ラジコンカーが登場するレーシングゲーム『Re-Volt』と映画『トイ・ストーリー』シリーズからインスパイアされている。

・動画制作には平均して30人、多いときには40人が同時に関わっていた。

・アメリカ・ロサンゼルスで撮影した画像を参考にしたり、実写画像から制作したオブジェクトを使ったりした。また、ドローンで撮影した実写映像も活用している。

・ 動画内にあるオブジェクトはほぼ全てシミュレーションできるので、例えばライティングを日中から夜に簡単に変更できる。さらには、道路の摩擦も変更可能。

・ラジコンカーは、人間が手動で運転したものもあれば、AIが自律的に運転したものもある。

・動画内の植物は、植生アーティストが全て手作業で制作した。

なお、Racer RTXの制作に使われたシミュレーション素材は11月に一般公開され、Omniverseで編集できるようになる予定だ。

以上のようなセッションからわかるように、AI技術はCG制作において不可欠なものとなっている。そして、AIのCGへの応用を推進するNVIDIAの研究開発と製品の動向は、今後ますます目が離せないものとなるだろう。

TEXT_吉本幸記 / Kouki Yoshimoto

EDIT_小村仁美 / Hitomi Komura(CGWORLD)