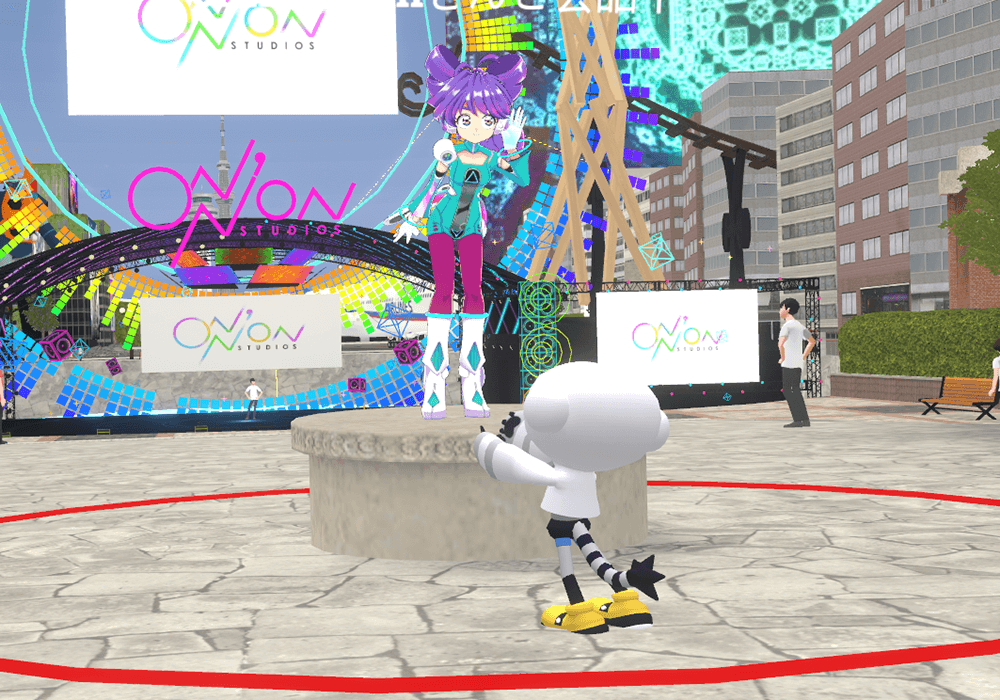

「ONN’ON STUDIOS」(オナノンスタジオ)は、東映アニメーションがVRChatで展開するメタバース・プロジェクトだ。2021年12月に企画がスタートし、2023年6月29日には3つめのワールドである「ImaginaryPark2070」(イマジナリーパーク2070)が公開された。

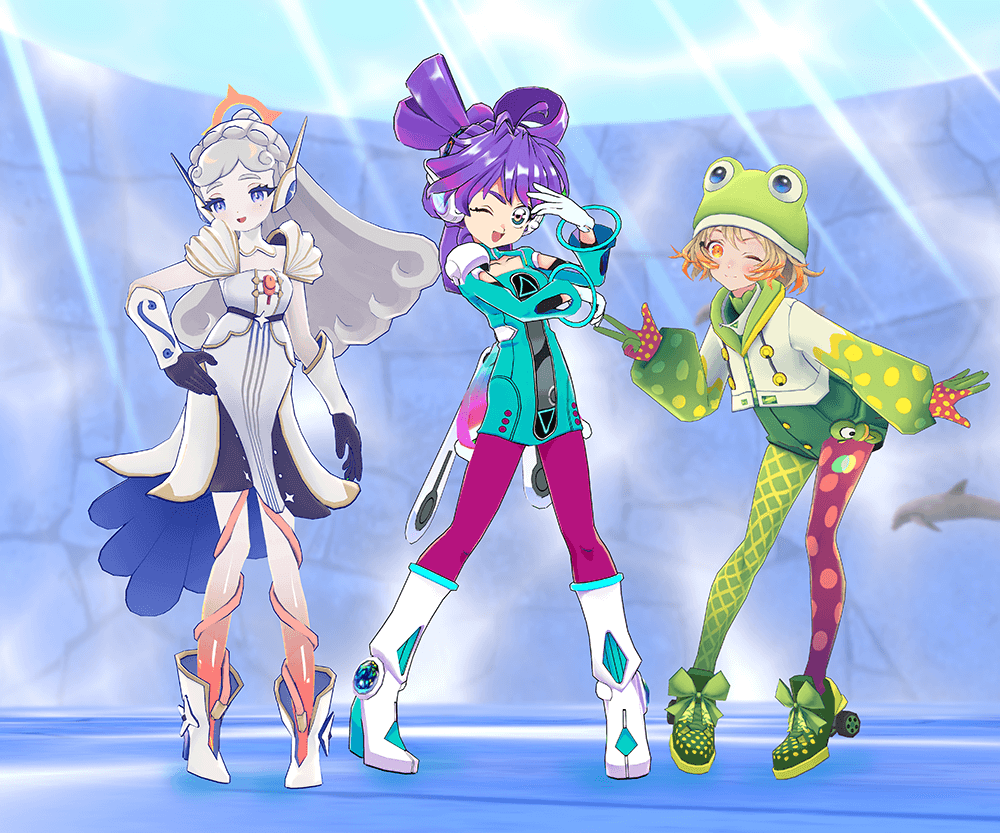

「ImaginaryPark2070」には「ONN’ON STUDIOS」公式キャラクターの「メモリ」と「えん」がAIコンシェルジュとして登場し、ユーザーは2人との音声による様々な対話を楽しめる。対話AIの実装はソニー・ミュージックソリューションズ(以下、SMS)が担当した。VRChatワールド内で対話AIを実装したねらいや、開発時の課題について、東映アニメーションとSMSのキーマンたちに話を聞いた。

関連記事

・東映アニメーションがVRChatワールドを展開! 90年代のノスタルジーを感じさせる「ノスタルジア1999」メイキング

INTERVIEWEE

池田 幹氏(進行管理/ソニー・ミュージックソリューションズ)、松平恒幸氏(企画/ソニー・ミュージックソリューションズ)

4つのエリアからなる、テーマパークのようなワールド

「ImaginaryPark2070」は4つのエリアで構成されたVRChatワールドだ。

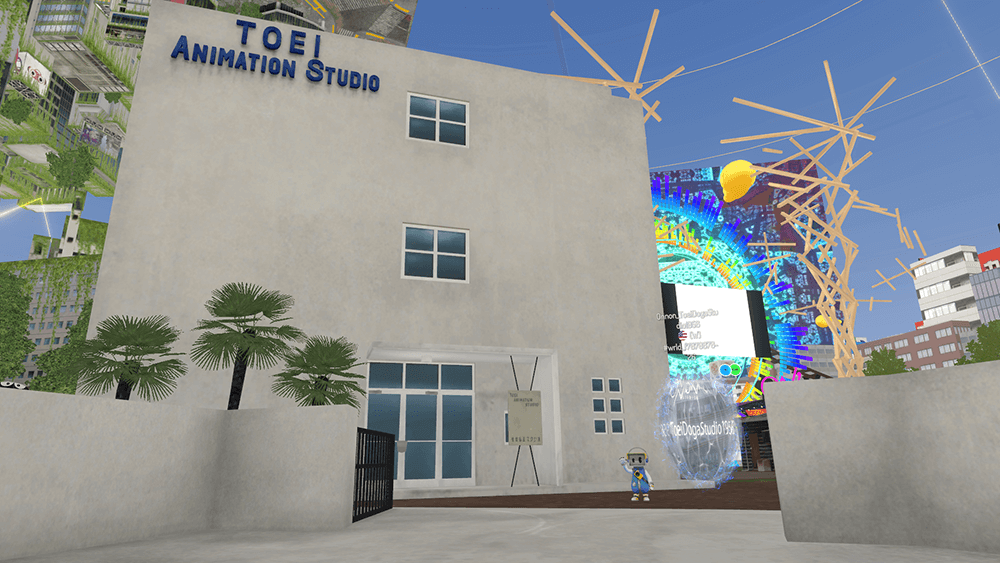

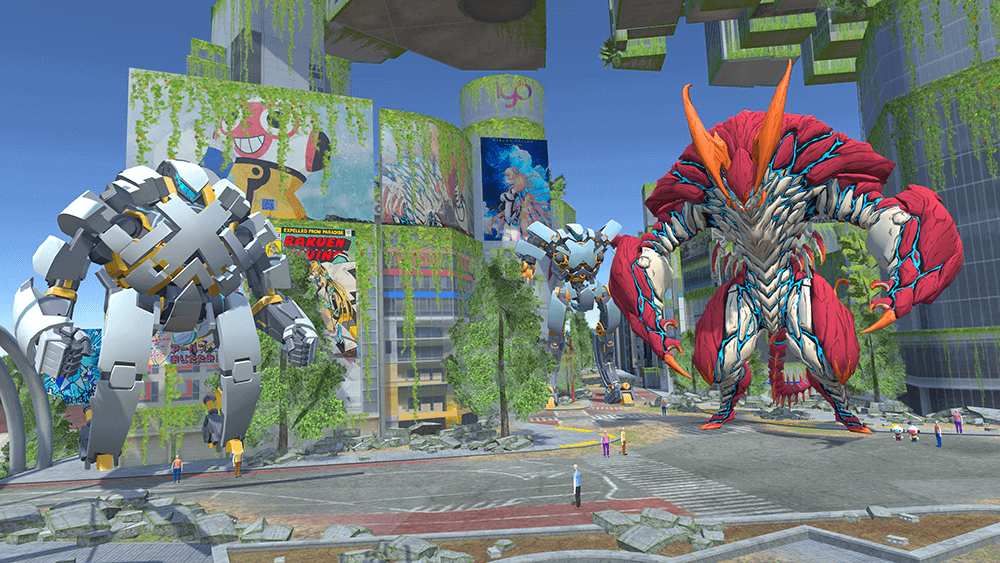

各エリアはそれぞれ異なる時代と世界観を表現しており、東映動画(現・東映アニメーション)の初代スタジオが建つ「1956年の大泉学園エリア」、かつての電気街の様子を再現した「1999年の秋葉原エリア」、『正解するカド』に出現した超巨大立方体・カドが存在感を放つ「2017年の羽田空港エリア」、『楽園追放 -Expelled from Paradise-』のキャラクターたちが荒廃した未来に立つ「2070年の渋谷エリア」が存在する。まるでテーマパークのようなワールド内にはクリエイターの描き下ろしイラストの展示や謎解きなどもあり、楽しめる要素が満載だ。

「ImaginaryPark2070」は3番目に公開された「ONN’ON STUDIOS」のワールドだが、構想はプロジェクトの発足時から練られていたという。

「バーチャル空間でアニメイベントをやることが最終目標のひとつなんですよ。その開催場所となる、多くの人が集まれる空間をまずはVRChat上につくりたかったんです」と、統括プロデューサーの野口氏は本ワールドの展開が念願だったことを明かした。

-

▲1956年の大泉学園エリア。初代の東映動画スタジオが建っており、「ONN’ON STUDIOS」が最初に公開したVRChatワールド「ToeiDogaStudio1956」へのポータルがある -

▲1999年の秋葉原エリア。AIBOをはじめ、当時のソニー製品の広告が多く並ぶ。エリアの一角には、『銀河鉄道999』の列車999号も展示されている

-

▲2017年の羽田空港エリア。刻々と模様を変えるカドの表面も再現されている -

▲2070年の渋谷エリア。『楽園追放 -Expelled from Paradise-』のアーハンや、『KAIJU DECODE 怪獣デコード』の怪獣といったキャラクターたちが立っている

「ImaginaryPark2070」の注目ポイントは、エントランスにいるAIコンシェルジュの「メモリ」と「えん」だ。彼らのアカウントをフレンド登録した上で本ワールドに入場すると、音声による対話を楽しめる。対話の内容は、アニメの話題から雑談まで多岐にわたる。

AIコンシェルジュの実装は当初の予定にはなかったが、野口氏と、ソニーのキャラクター対話AI技術との出会いがきっかけで実装に向けた検証が始まった。

「僕が使っていたXperia Ear Duoというソニー製のイヤホンには、AIアシスタントが音声認識をしてアナウンスを返す機能が搭載されていました。『ソードアート・オンライン』とコラボしたプラグインアプリ「Xperia Ear Duo(アスナ)」を入れると、アナウンスの声がヒロインのアスナに変わって、いろいろ喋ってくれるんです。『このしくみを使えば、VRChatでもキャラクターと対話できるんじゃない?』と思い、提案したのが始まりです」(野口氏)。

VRChatに対話AIを実装するまでの道のり

「ONN’ON STUDIOS」に企画段階から携わっているSMSは、過去にもソニーの開発チームと共に対話AI技術を実用化してきた実績があり、豊富な知見を有していた。

特にキャラクターボイスの音声合成技術は時間をかけて培ってきたため、野口氏から提案を受けた松平氏は「できます」と答えたが、VRChat上に対話AIを実装するまでには多くの課題があったという。以下では、開発時の代表的な課題を3つ紹介する。

外部システムとの通信が不可能

1つめの課題は「外部システムとの通信が不可能」というVRChatの仕様だった。

当初はクラウド上の対話AIシステムと、ワールド内に配置したAIコンシェルジュのキャラクターモデルを連携させようとしたのだが、セキュリティ対策の一環で、VRChatは外部システムとの通信ができない仕様になっていた。対話AIシステムは容量が大きいため、まるごとワールド内にもち込むことも難しかった。

そこでAIコンシェルジュ専用のVRChatアカウントとPCを用意して、VRChatワールドにログインした後、ワールド外の対話AIシステムと、ワールド内のAIコンシェルジュのアバターをPCを介して連携させることにした。

つまり「メモリ」と「えん」は、一般ユーザーと同じように「ImaginaryPark2070」にログインしているのである。そのため本ワールドは、常に2人以上のユーザーがログインしている状態となっている。なお、ワールドのインスタンスが異なると2人に会えないので、円滑にコンタクトしたいユーザーにはフレンド登録を促している。(AIアバターへのjoinの仕方)

❤\メモリちゃん、えんくんとお話しませんか/

— ONN’ON STUDIOS|オナノンスタジオ (@Onnon_Studios) June 29, 2023

【入場方法】

①「memory_onnon」「en_onnon」アカウントにフレンド申請

②フレンド承認後フレンドメニューから「Onnon_ImaginaryPark2070」へジョイン #onnon_studios #VRChat #ImaginaryPark2070 pic.twitter.com/SvNBuhIVR9

BGMによる音声認識の妨げ

2つめの課題は、「ワールドのBGMが音声認識の妨げになる」ことだった。BGMとユーザーの音声が混ざってしまい、音声を正しく認識できないという問題が発生したのだ。

一般的に音声認識のテストは無音環境で行われるため、テストで得られたパフォーマンスが実際の環境だと発揮されないということは多々ある。SMSはノイズキャンセリングの技術も有しているが、異なる技術を組み合わせるとシステムが複雑になるため、今回は導入を見送った。「片方の技術が上手くいっても、もう片方に不具合が出るということもよくあります。技術ごとに開発者がちがうので、統合させるとなると開発者間の連携も必要で、今回のスケジュール内での実現は難しいと判断しました」(池田氏)。

現在はBGMの音量を下げることで課題を克服しているが、将来的には音源分離技術などを導入し、ユーザーの音声だけを認識させることも視野に入れているという。

音声の1音目が欠ける現象

音声認識時に「ユーザーの音声の1音目が欠ける」という現象も課題となった。例えばユーザーが「ドラゴンボール」と発声しても、「ド」が欠けた「ラゴンボール」としか認識されないのだ。対話AIシステムの音声認識と意図理解において、この現象は致命的な課題だった。

この現象には、VRChatの仕様やユーザー環境なども関連していると予想され、根本的な解決は不可能だったという。そこで、「ラゴンボール」=「ドラゴンボール」というように、1音目が欠けていても元の単語と同じものとして認識させるチューニングが施された。

前述したようにSMSの対話AI技術は本プロジェクトの開始前から実用化されていたが、VRChat上で正常に機能させるためには、多くの試行錯誤とカスタマイズが必要だったわけだ。

AIコンシェルジュの音声データ生成のワークフロー

「ImaginaryPark2070」のAIコンシェルジュが発する音声データは、①音声認識、②意図理解、③シナリオ選択、④音声合成、⑤追加調整、の5段階を経て生成される。

まず音声を認識して言葉に起こし(音声認識)、その言葉がどのような意図をもって発せられたのかを理解する(意図理解)。その意図に対し、どう応答するのかを膨大なシナリオの中から選択し(シナリオ選択)、音声合成技術を用いて応答のシナリオを音声化する(音声合成)。合成した音声の中には、そのままだとイントネーションなどが不自然なものもあるので、必要に応じて調整を施す(追加調整)。

「意図理解」の精度を上げる調整

認識した音声の意図を理解する「意図理解」の精度を上げるためには、日本語の特徴や、対話のテーマに合わせた調整が必須だ。

例えばXperia Ear Duo(アスナ)の音声データ生成のテスト時には、ユーザーが「アスナ」と呼びかけても、キャラクター名の「アスナ」ではなく、仏教用語の「阿修羅」だと理解されてしまった。しかしアスナに阿修羅の話題を振りたいユーザーはほぼいないと思われるため、「阿修羅と聞こえたら、ほとんどの場合、アスナに呼びかけている」と理解させるファインチューニングが施された。

松平氏は「意図理解は、キーボードの予測変換をイメージするとわかりやすいです。同じ文字を入力しても、小説家の予測変換と、ビジネスマンの予測変換とでは、表示される候補が全然ちがいますよね。それと同じです」と例える。とりわけアニメの場合は、固有名詞をはじめ、日常では使われない単語が多いため、細部の調整が欠かせない。

ユーザーの中には、キャラクターや作品の正式名称を覚えていない人もいるので、「主人公」や「初代」などの関連するキーワードと正式名称を紐づける調整も施している。

約1,000種類の対話パターンを制御するシナリオ

対話AIと聞くと、2022年に公開されたChatGPTを思い浮かべる読者も多いだろう。だが「ImaginaryPark2070」のAIコンシェルジュは、ChatGPTのような大規模言語モデルを用いた自動応答システムは使わず、全ての対話をシナリオベースで制御している。

例えば「アニメは好きですか?」というAIコンシェルジュからの質問に、「はい」とユーザーが答えると、好きなアニメについて深掘りする質問へと分岐していくしくみだ。現時点で用意している対話パターンは約1,000種類にのぼる。

大規模言語モデルを用いた対話AIの場合、開発者が想定していない、事実とまったく異なる回答をしてしまうリスクがある。「ImaginaryPark2070」は東映アニメーションの公式ワールドなので、AIコンシェルジュの発言も確実に制御する必要があった。

「『ONE PIECE』の次の映画公開はいつですか? とユーザーに聞かれて、事実とちがう公開日を回答してしまったら、大変なことになりますからね」(野口氏)。このような事態を避けるため、シナリオはSMS側で作成し、作品に関連する部分は各権利元の監修も受けて逐一チェックしている。

ワールドを公開した現在も、シナリオの追加と修正は継続している。これまでの実用化経験を通して、SMSはキャラクターとユーザー間の対話に関する様々なデータを収集・分析しており、それを基にVRChatワールドのシナリオを作成した。しかし事前の想定と実際の対話にはズレがあった。

例えば「アニメは好きですか?」という質問に「いいえ」と答えるユーザーがほとんどいなかったことは予想外だった。「いいえ」という回答から分岐するシナリオも大量に用意していたが、大半のユーザーが「はい」と答えるため、「いいえ」から分岐するシナリオはほとんど使われていないという。

「そもそもアニメに興味がない人は、東映アニメーションが展開するワールドに来ないですよね(笑)。本ワールドの公開以降、VRChatでの対話AIに関するデータも日々蓄積されているので、その分析とシナリオの追加を続けています」(松平氏)。

キャラクターに合わせた独自の台本で音声素材を収録

シナリオは随時追加されているが、AIコンシェルジュのボイスは音声合成によって生成できるため、声優のボイスを新規に収録する必要はない。「最初に高品質な音声素材を収録しておけば、以降の追加収録は必要ありません。柔軟にシナリオの調整や追加ができるのは、音声合成のメリットですね」(松平氏)。

5〜6年前までは、AIに学習させる音声素材を収録するために、音素バランス文の朗読を声優に依頼していた。音素バランス文は、「キャ」や「ショ」といった拗音も含めた、ありとあらゆる発音を網羅した台本で、プロの声優でも朗読に難儀していたという。

しかし、ここ数年でAI技術が向上し、SMSのノウハウも蓄積されたため、音素バランス文は使わず、独自の台本で音声素材を収録しているという。「最初にキャラクターの設定を確立し、そのキャラクターが喋りそうなセリフを中心に、バランス良く多めに台本を用意すれば、ほぼイメージ通りの音声合成ができるようになりました」(松平氏)。

「メモリ」は少女のキャラクターなので、女性が一人称で独白している文章群で構成された台本を作成した。その中に多様な発音パターンや、東映アニメーション作品に関係する固有名詞も盛り込むことで最適化を図っている。

「えん」はお猿さんのようなキャラクターで、セリフの語尾に「ござります」を付けて喋る。これは「話し方にインパクトを加えたい」と考えた松平氏の発案で、時代小説も参考にしながら「ござります」が頻出する専用台本が作成された。

このような各キャラクターに合わせた台本作成は一般的なやり方ではなく、SMSがこれまでの経験を通して確立したノウハウだという。

台本を使った「メモリ」と「えん」の音声素材の収録は、声優1人につき4時間×3日間=12時間を要した。合計で約24時間の収録に立ち会った池田氏は、音声合成の素材収録ならではの難しさを語った。

「一般的なアニメのアフレコと、音声素材の収録とでは、求められることが全然ちがいます。前者ではセリフに感情を乗せ、抑揚や強弱をつけることが求められます。一方、後者ではキャラクターになりきった上で、一定のテンションとスピードを維持したまま喋り続ける必要があるんです。音声素材の収録に慣れていない声優さんは、このちがいに戸惑うことが多いですね」(池田氏)。

一定のテンションとスピードを維持した音声素材をAIに学習させると、高品質な音声合成が可能になる。声優としての技量に加え、音声素材の収録に慣れているかどうかで、結果に大きな差が出るという。

「メモリ」の音声素材の収録は、経験豊富な麻倉もも氏が担当しているため、高品質な音声合成が実現した。「えん」の音声素材の収録を担当した山根 綺氏には、音声合成には向いていないとされる抑揚の強い喋り方をあえてリクエストしたことで、ほかの対話AIとは一線を画した口調が実現し、ユニークなキャラクター性を打ち出すことができた。

驚いた声などの音声合成が苦手とするセリフは、声優の生の声をそのまま使うことで品質を担保する場合もあるが、「メモリ」と「えん」のセリフは全て音声合成で生成している。

本日もメモリちゃんとえんくんがワールドエントランスでお待ちしております

— ONN’ON STUDIOS|オナノンスタジオ (@Onnon_Studios) June 30, 2023

「memory_onnon」「en_onnon」アカウントへフレンド申請し、承認後ジョインをお願いいたします❕ pic.twitter.com/9z44DNFXYN

前述したように、音声合成の後には、必要に応じて追加調整も施している。この追加調整の工程をつくるために、あらかじめ全シナリオの音声合成結果を池田氏らが確認し、イントネーションなどの違和感の有無と、調整内容を判断したという。音声合成では音節の句切りやイントネーションを記した文章が同時に生成されるため、この文章を直すことで、音声を調整している。

最新の音声合成技術は、追加調整をしなくても話している内容が伝わるレベルに達しているという。しかし「ImaginaryPark2070」で交わされる対話の主なトピックであるアニメは、日常では使われない固有名詞や専門用語が多く、違和感のある音声が生成されがちだ。「メモリ」と「えん」のキャラクター性を保つ上でも必要との判断から、SMSでは追加調整を行なっている。

様々なキャラクターと対話できる未来を目指して

最終目標のひとつとして、野口氏は「ユーザーがアニメのキャラクターと対話できるようになること」も挙げた。「新作アニメのキャラクターや、既存アニメのキャラクターにいつでも会えて、直接対話もできる。そんなメタバース空間をつくれたら良いなと思っています」(野口氏)。

そのために実現したいことのひとつが「音声合成による芝居」だ。「例えば、あるアニメキャラのボイスを音声合成で再現するとしたら、技を繰り出す前の「はあぁぁぁ……!」というかけ声はできるかもしれません。でも、怒りがにじんだ戦闘前の声と、呑気に喋っているときの声のちがいを表現することは難しいです。そういう芝居の再現は、現時点では実現できていません」(松平氏)。

AI技術が進歩すれば、いつかキャラクターたちと自由に対話できる日が来るかもしれない。そんな未来を目指しながら、「ONN’ON STUDIOS」公式キャラクターたちの魅力や、彼らと対話する楽しさを伝えていきたいと、松平氏は意気込みを語った。

「メモリちゃんと、えんくんという、両極端な2人のキャラクターの音声合成をプロデュースできたことを嬉しく思っています。メモリちゃんの音声合成では、可愛くて、純粋に滑らかで高品質な対話を実現できました。えんくんでは、個性的でピーキーな音声合成に挑戦して、面白い成果を出せたと自負しています。今後も音声合成技術とシナリオの両面でアップデートを継続し、メモリちゃんを仮想世界で一番可愛い子にしたいです」(松平氏)。

なお今後は、AIコンシェルジュの英語対応も検討中だという。作品やキャラクターの正式名称の英語発音での再現、英語での音声認識と意図理解など、予想される困難は多いが、対話AIの技術開発は英語圏の方が進んでいるため技術的なハードルは低いという。

間断なく進化を続ける「ImaginaryPark2070」とAIコンシェルジュに、今後も注目していきたい。

『レインボー戦隊ロビン』Ⓒ東映アニメーション

『魔女っ子メグちゃん』Ⓒ東映アニメーション

『銀河鉄道999』©松本零士/零時社・東映アニメーション

『おジャ魔女どれみ』©東映アニメーション

『デジモンアドベンチャー』©本郷あきよし・東映アニメーション

『大空魔竜ガイキング』©東映アニメーション

『正解するカド』Ⓒ東映アニメーション/木下グループ/東映

『楽園追放』Ⓒ東映アニメーション・ニトロプラス/楽園追放ソサイエティ

『怪獣デコード』©円谷プロ・東映アニメーション

『ONN’ON STUDIOS』Ⓒ東映アニメーション

TEXT_遠藤大礎/Hiroki Endo

EDIT_李 承眞/Seungjin Lee(CGWORLD)、尾形美幸/Miyuki Ogata(CGWORLD)

PHOTO_弘田 充/Mitsuru Hirota