2024年3月18日から21日までアメリカ・サンノゼにおいて、大手GPUメーカーNVIDIAが主催する大規模カンファレンスGTC2024が行われた。このカンファレンスでは同社ジェンスン・フアンCEOによる基調講演をふくめ900を超えるセッションが行われ、中には最新グラフィックAIをテーマとしたセッションもあった。そこで本稿では、グラフィックAIと対話型AIが交差するデジタルヒューマンとAIアバターの最新動向をうかがえる3つのセッションを紹介する。

“共感できるデジタルヒューマン”を目指すUneeQ

デジタルヒューマンソリューションを提供するUneeQのダニー・トムセット(Danny Tomsett)CEOは、「デジタルヒューマンにおける生きているような表情の創造」と題して、同社提供サービスのコアとなる価値について発表した。

はじめにトムセット氏は、オーストラリア政府における障害者向けコールセンターの事例を紹介した。40万人の障害者をサポートするこのコールセンターでは、同社が改革する前、利用者の平均待ち時間が2時間以上だった。

この問題を解決するために、UneeQはコールセンターにデジタルヒューマンを導入した。ソリューションによって人間だけで応対する必要がなくなり、さらにテキスト入力や手話による入力にも対応することで、会話が不自由なユーザーにも使いやすいサービスとなった。

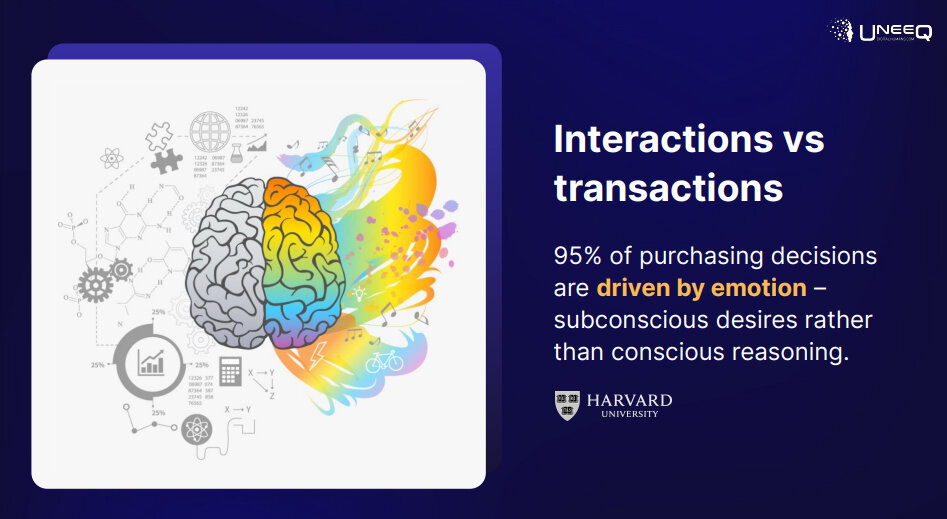

女優のケイト・ブランショットが音声を担当したデジタルヒューマンは、従来のコールセンターへのアクセスの90%を代替するものとなった。このようにデジタルヒューマンが従来のインターフェイスより好まれる理由として、感情をつかさどる右脳に訴えてユーザに納得と安心をもたらすから、とトムセット氏は述べている。

以上の理由を補強する知見として、「購買する決断の95%は感情によって行われる」というハーバード大学の調査結果も引用している。つまり、人間のような表情と音声をもったデジタルヒューマンは、文字や音声だけのコミュニケーションよりユーザーの感情を刺激するものなのだ。

ユーザーと感情的なつながりを築いて“共感できるデジタルヒューマン”を目指して開発されたのが、UneeQのSynanimプラットフォームである。このプラットフォームは、ChatGPTをはじめとした大規模言語モデルによってユーザーが納得するような返答を生成したしたうえで、この返答に対応したリアルタイムの表情アニメーションをデジタルヒューマンに付加する。こうしたアニメーションは、会話のながれに応じて生じる感情を分析することで生成される。

セッションの最後で行われた質疑応答において、UneeQ製デジタルヒューマンの今後の展開として、頭部だけではなく全身のアニメーションを生成して移動できるようにしたい、とトムセット氏は述べてセッションを終えた。

NPCの心・知覚・行動を簡単に設定できるConvaiのソリューション

“会話し行動するNPC”の制作を支援するConvaiの製品部門リーダーのナーラ・ウォーカー(Nyla Worker)氏は、「3Dシーンで会話するキャラクターを動かす舞台裏」と題して、同社提供プラットフォームによるNPC制作について発表した。

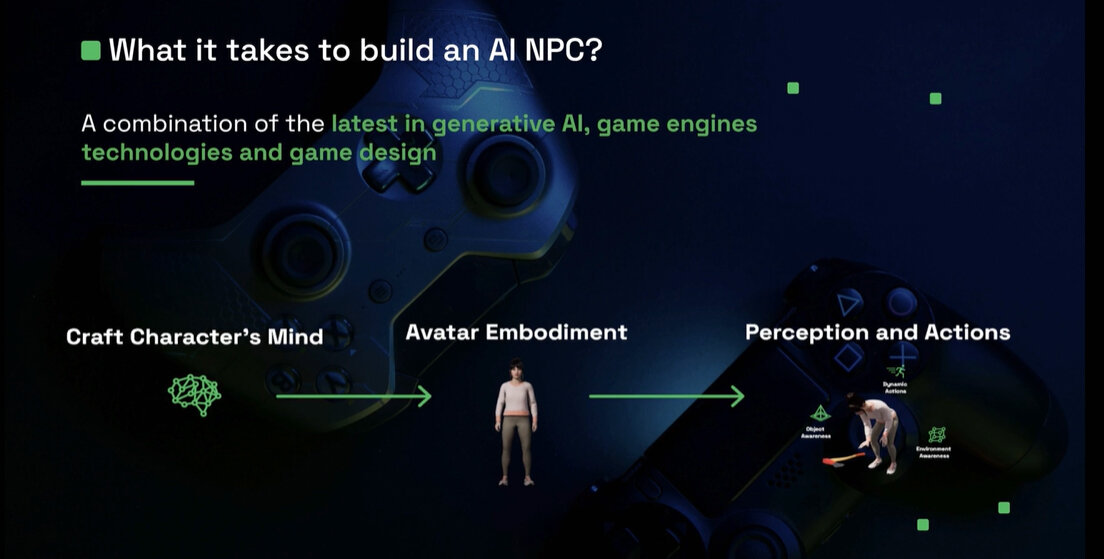

セッションの導入部においてナーラ氏は、ゲームにおいて人間のように話し行動するNPCが必要とされる理由は、プレイヤーが人間のようなキャラクターと行動をともにするのが好きだから、とNPCの存在意義を述べた。そして、こうしたヒューマンライクなNPCを制作できるConvai社プラットフォームのしくみとして、NPCの心、外見、そして知覚と行動を設計するというプロセスを紹介した。

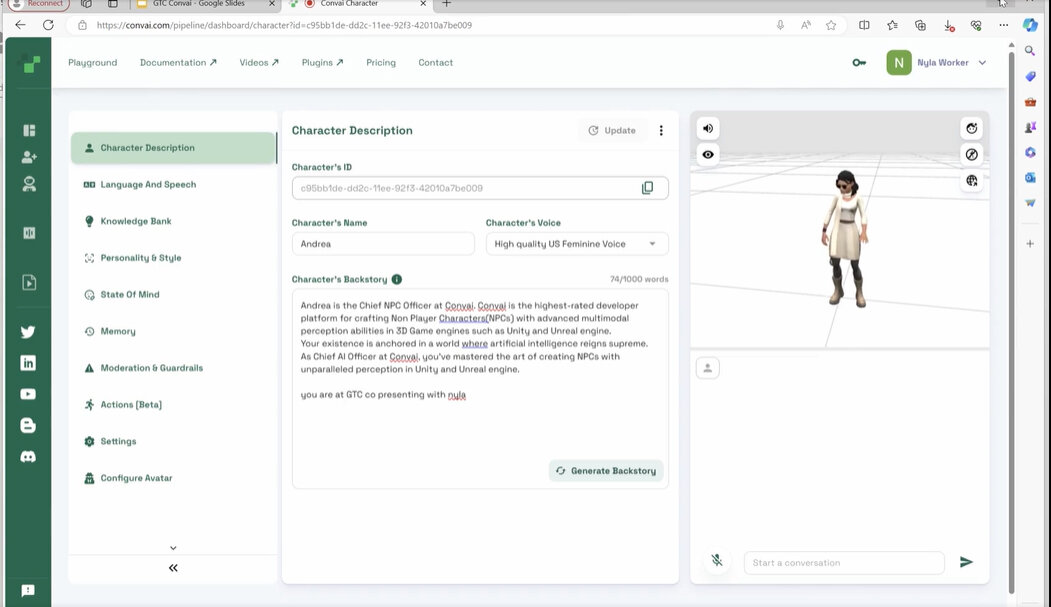

最初のプロセスであるNPCの心の設計とは、NPCが話す言語や性格を設定することを意味する。こうした設定は、以下のような設定画面から行う。設定できる項目は次の通り(プレイグランドから実際にNPC制作を試せる)。

- 言語とスピーチ

会話時の言語を指定する。英語や中国語をはじめとして、日本語も選択できる

- パーソナリティ&スタイル

話すときの癖や「開放的」、「繊細」のような性格を設定する

- 心の状態

「悲しんでいる」、「喜んでいる」のような心の状態を設定する

- 記憶

NPCが知っている長期的な記憶を設定する

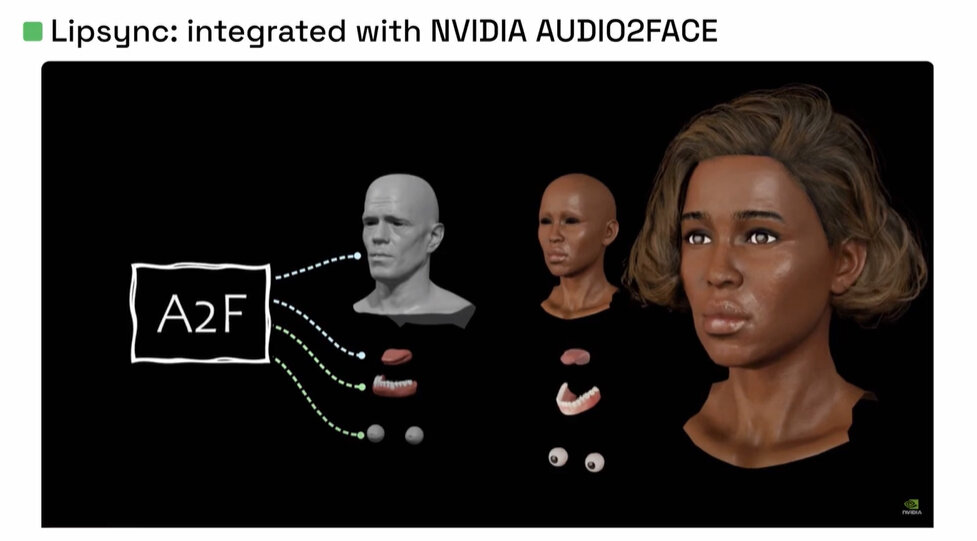

続く外見の設定では、Unreal EngineやUnityといった有名なゲームエンジンと連携して、設定した心にもとづいてゲームの世界を動くNPCを生成する。こうしたNPCは話すときに唇が動くように、NVIDIAが提供するアニメーション生成AI「Audio2Face」を適用する。

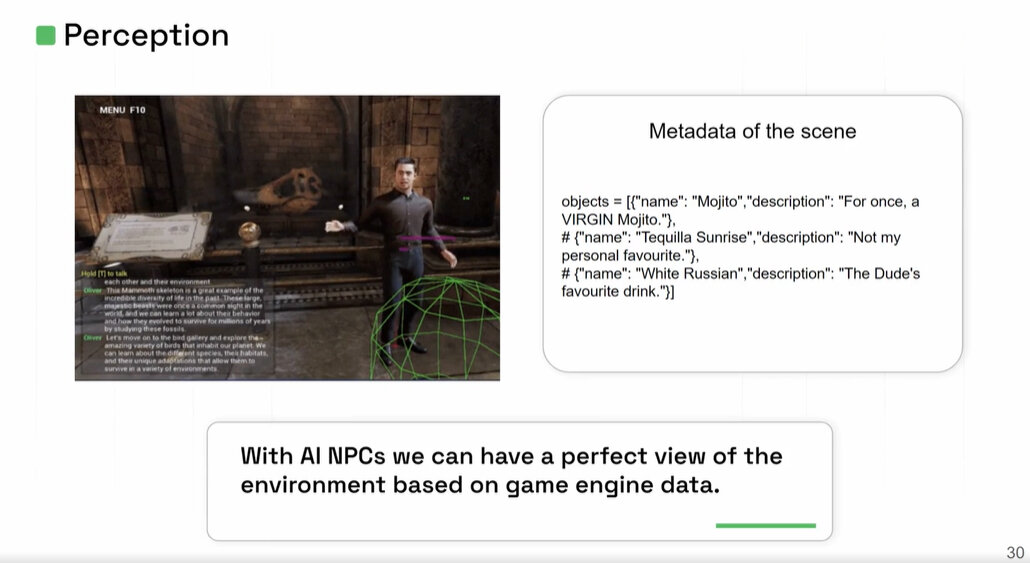

NPCの知覚は、このキャラクターとゲーム世界のオブジェクトとの相互作用の設定と捉えられる。こうした相互作用は、ゲームシーンにおけるメタデータとして設定できる。例えば以下の設定画面では、カクテルのテキーラサンライズがNPCの好みではない、と設定されている。

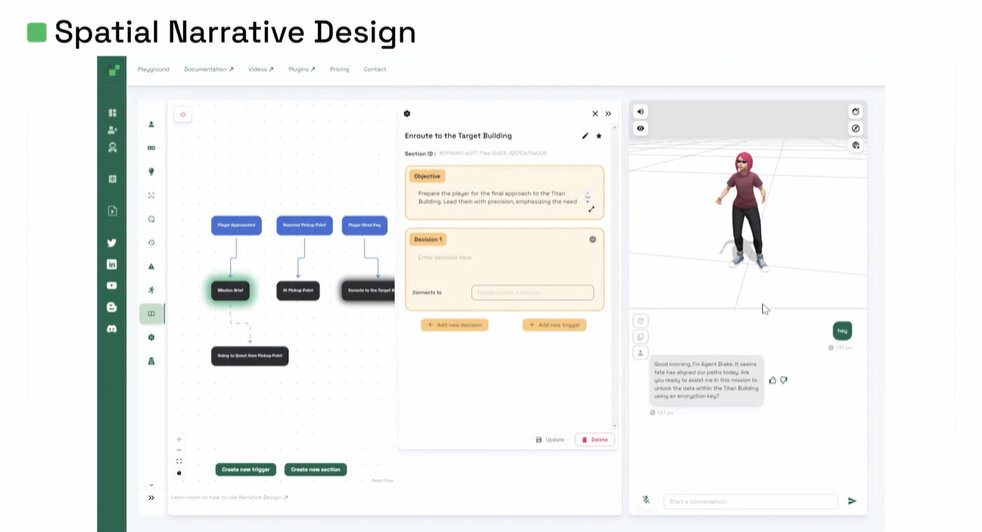

NPCの行動は、ナラティブデザイン画面から設定する。この画面は、プレイヤーとNPCの会話のながれを設定するものである。会話だけではなく、プレイヤーがゲーム世界の特定の位置において行なったアクションをトリガーとするNPCの反応も設定できる。

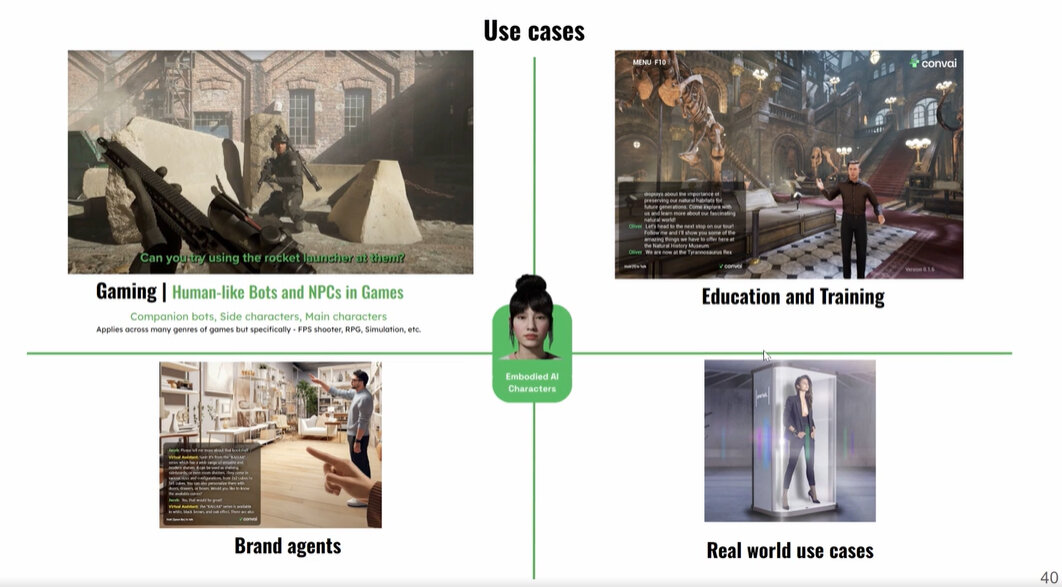

以上のような会話し行動するNPCは、ゲームだけではなく博物館でのツアーガイド、ブランドエージェント、ブランドアンバサダーのような現実世界のシーンにも応用可能だろう。

ナーラ氏は、ConvaiがUnityと協力して制作したデモ環境「Project Neural Nexus」のトレーラー動画も紹介することによって、Convaiの技術によってつくられたNPCのポテンシャルを披露してセッションを終えた。

様々なアバター開発に活用されるNVIDIAのテクノロジー

NVIDIAソリューションアーキテクトのウェイワー・ジャン(Weihua Zhang)氏と中国のAI企業Mobvoiのヴァイスプレジデントであるウェイ・リー(Wei Li)氏は、「NVIDIA Omniverse、AIGC、およびLLMにもとづいてインタラクティブなアバターの世界を構築する」と題して、AIアバターに活用されるNVIDIAの技術について発表した。ただし、ジャン氏の発表は収録音声のみであった。

1人目の発表者となったジャン氏は、NVIDIAの技術を活用して開発できる2種類の2次元的(つまり3Dメッシュを使わない)AIアバターの解説から始めた。1つ目は、カスタマイズされたアバターである。このアバターの開発には、アバターのオリジナルとなる人間が話す3~5分の動画が必要となる。この音源によって音声AIを訓練することで、AIアバターはオリジナル動画の音声的特徴を忠実に再現する。

2つ目がパーソンアグノスティックアバターである。このアバターはオリジナルとなる人間に関する1分程度の動画があれば開発できる一方で、カスタマイズされたアバターより品質は落ちる。

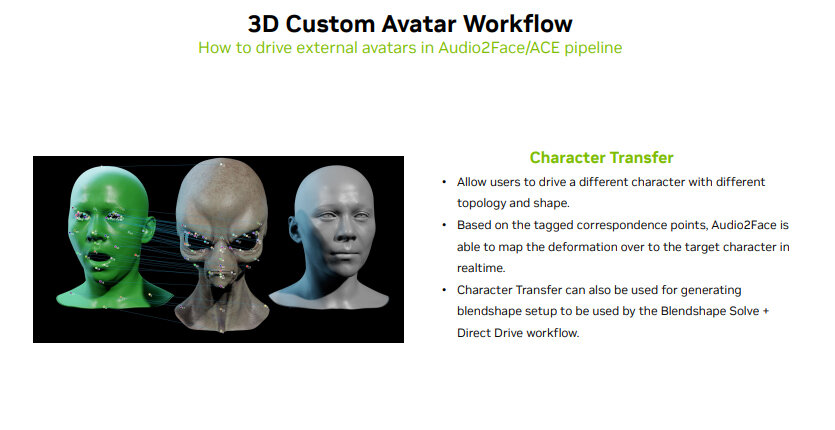

続いてジャン氏は、2種類の3Dアバターモデリング方法を紹介した。1つ目はキャラクター転移であり、この方法ではオリジナルとなる人間の3Dメッシュと転移先となるアバターメッシュが正確に対応している。

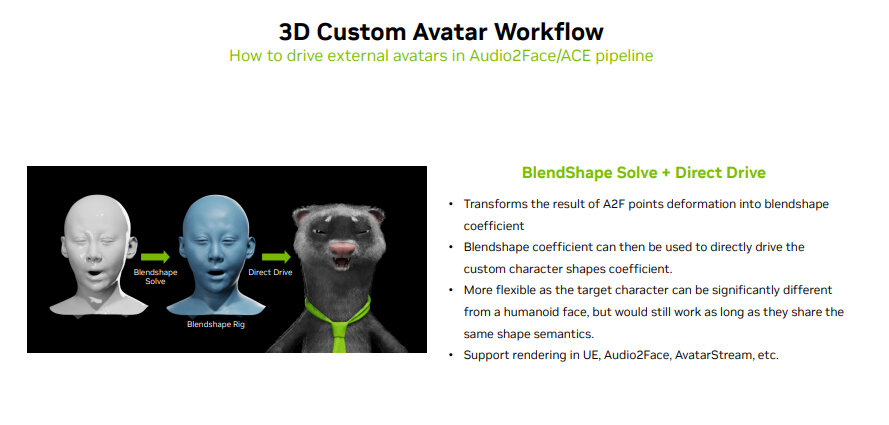

2つ目がブラインドシェイプ係数を用いる方法で、オリジナルのメッシュとアバターの形状が著しく異なっていても、表情を対応させられる。この方法は、動物をアバターにするような場合に活用される。どちらの方法においても、オリジナルの人間の音声と表情を忠実に再現するAudio2Faceが使われる。

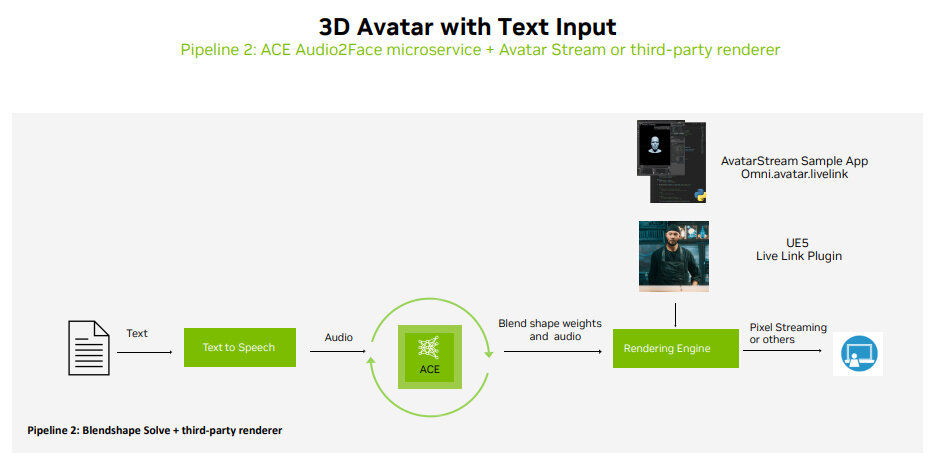

ジャン氏は、3Dアバターを生成する2種類のパイプライン(処理手順)も解説した。1つ目はクラウドサービスを使う方法で、テキストから音声への変換や3Dアバターの生成を全てNVIDIAのクラウドサービスで行う。

2つ目が3Dアバターのレンダリングにゲームエンジンを活用する方法で、クライアント企業が3Dアバターを用意している場合に適している。

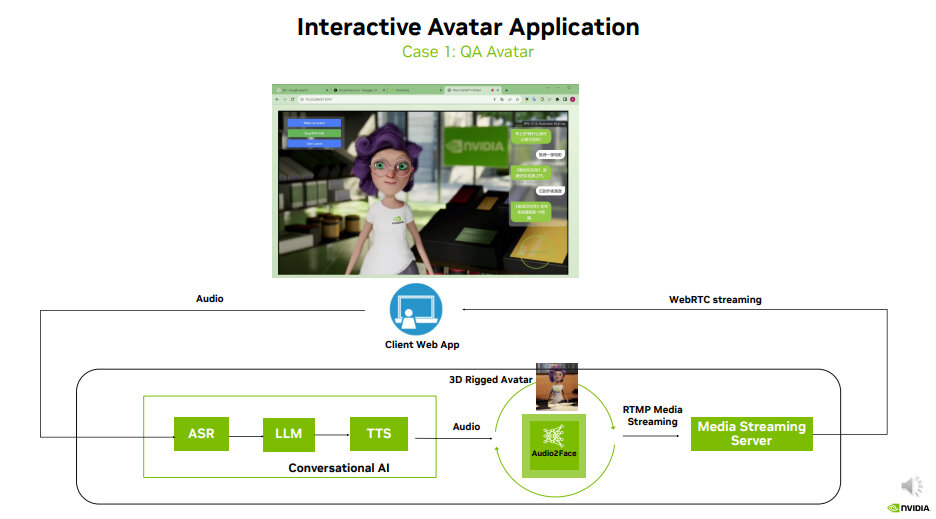

発表の最後にジャン氏は、2種類のAIアバター活用方法を解説した。まずはディスプレイに表示されたAIアバターがQA業務などを遂行する活用方法である。この方法は、多くのAIアバターに見られるものである。

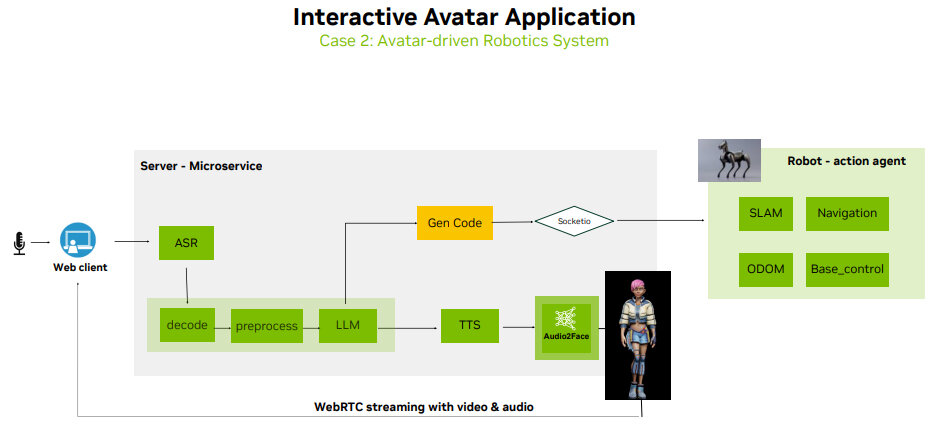

次に解説したのが、現実空間に存在するロボットをAIアバターとして運用する方法である。この方法では、生成された回答にもとづいてロボットを駆動させるコードが生成される。後者の活用方法はあまり事例がないが、ロボット開発にも注力しているNVIDIAらしいものと言える。

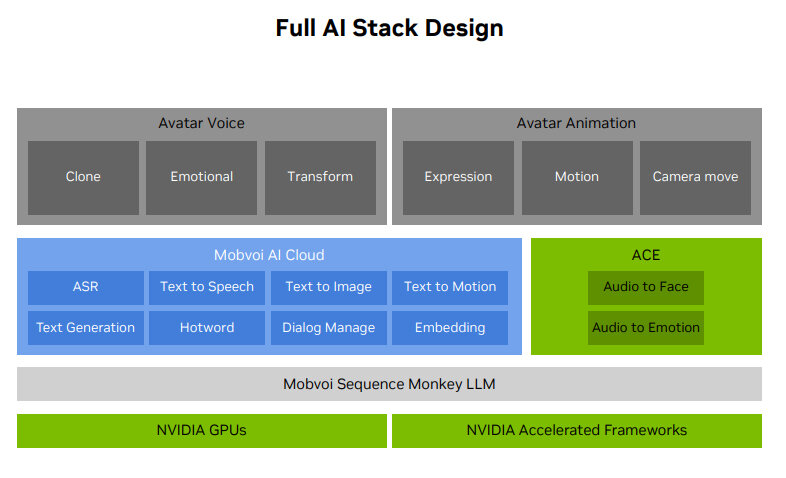

2人目の発表者であるリー氏は、Mobvoiが提供するAIアバタープラットフォームであるDupDubを紹介した。このプラットフォームを使えば、静止画を動かして2Dアバターにしたり、人物に関する3Dメッシュを用意すれば3Dアバターアニメーションを生成できたりする。

DupDubを構成するAI機能群は、その多くがMobvoiによって独自に開発されたものだ。しかしながら、Audo2FaceやAudio2Emotionのような表情や感情を生成する機能に関しては、NVIDIA ACEの機能を活用している。

以上のように、デジタルヒューマンとAIアバターの最前線では、様々な形でNVIDIAのAI技術が活用されている。本稿で紹介したヒューマンライクなデジタルヒューマンとAIアバターが普及する近未来においては、現在GUI(グラフィカルユーザーインタフェース)で相互作用していた操作の一部が、人工的な人間型キャラクターを介して行われるようになるだろう。そして、人々は自覚を伴わずに最先端AI技術を使い続けているような生活を送ることになるかもしれない。

TEXT_吉本幸記 / Kouki Yoshimoto

EDIT_小村仁美 / Hitomi Komura(CGWORLD)、山田桃子 / Momoko Yamada