現在、好評開催中の「大阪・関西万博」。4月13日の開幕から116日目を迎えた8月6日時点で、来場者数1500万人を突破したという(※公式プレスリリースより)。多種多様なパビリオン、イベントのうち従来の博覧会や美術展示とは一線を画した“体験型展示”として好評なのが、アニメーション監督やメカニックデザイナーとして高名な河森正治氏がプロデュースしたシグネチャーパビリオン『いのちめぐる冒険』だ。本稿では、全体的なクリエイティブディレクションと、『超時空シアター』などのテクニカルディレクション、開発を担当したバスキュールのメンバーに、その取り組みをインタビューした。

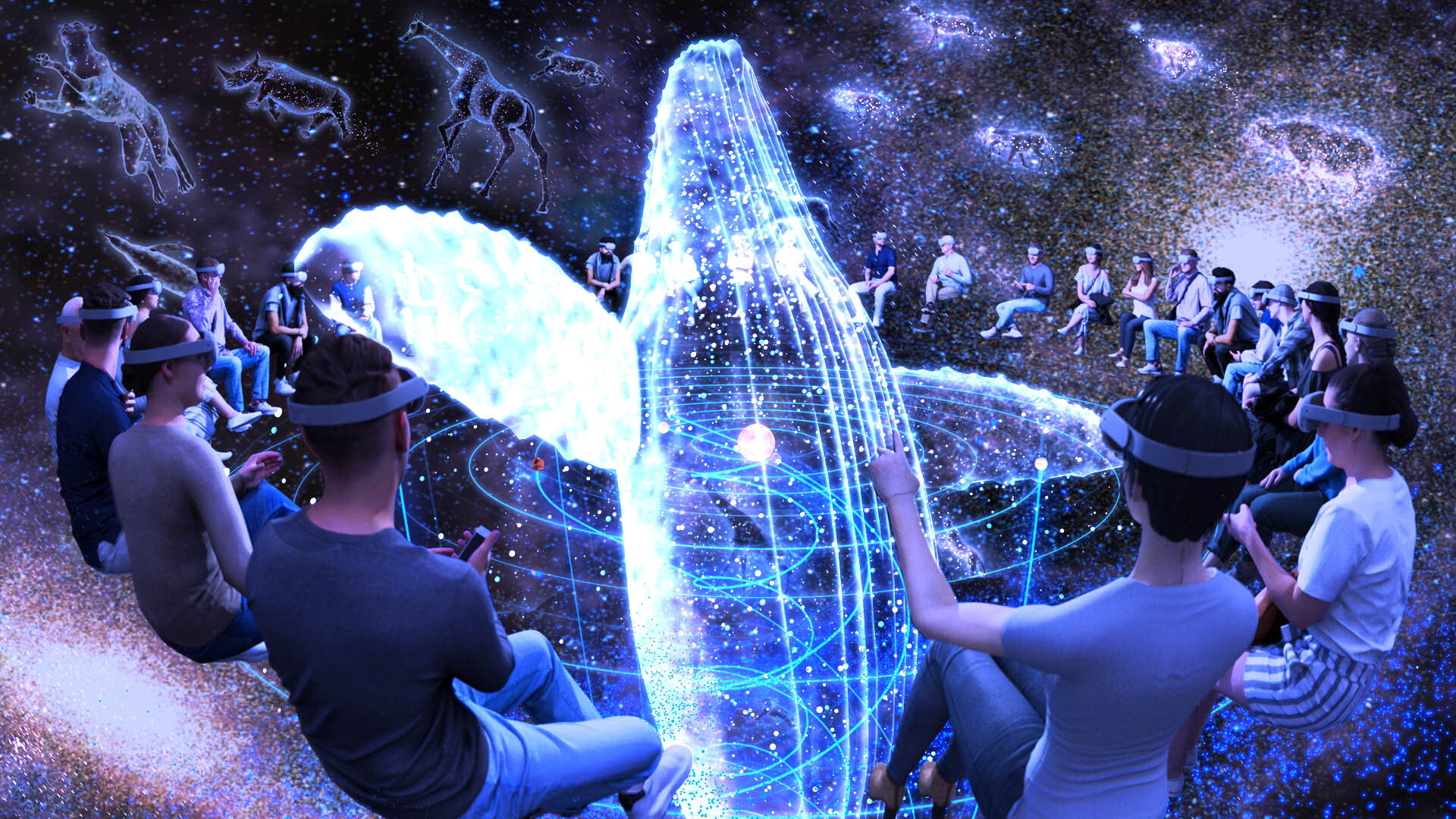

MR、VR、立体音響、リアルな空間演出が シームレスに“合体”。|超時空シアター『499秒 わたしの合体』

https://shojikawamori.jp/expo2025/contents/deepvision/

シグネチャーパビリオン『いのちめぐる冒険』

プロデューサー:河森正治

https://shojikawamori.jp/expo2025/

スキュー30ms未満に収めるなど、30台のHMDと空間を“完全合体!”

『いのちめぐる冒険』は、XR技術を活用したイマーシブ展示が2つ、自然科学などの正しいデータとエンタメ性を融合させたリアリティ展示が4つという、全6つのコンテンツで構成された、大阪・関西万博の中でもひときわコンテンツ数が多いパビリオンである。

「バスキュールは全体的なクリエイティブディレクションと、『超時空シアター』をはじめとするいくつかの展示のテクニカルディレクション、開発を担当させていただきました。プロジェクト自体は4年ほど前に始まりましたが、最初の2年間は河森さんがやりたいことを具体的な展示としてどのように落とし込むのが良いかといったことを考えたりと、企画を練り上げる期間でした」(武田誠也氏)。

『超時空シアター』の制作実務に着手したのは2023年4月だったという。

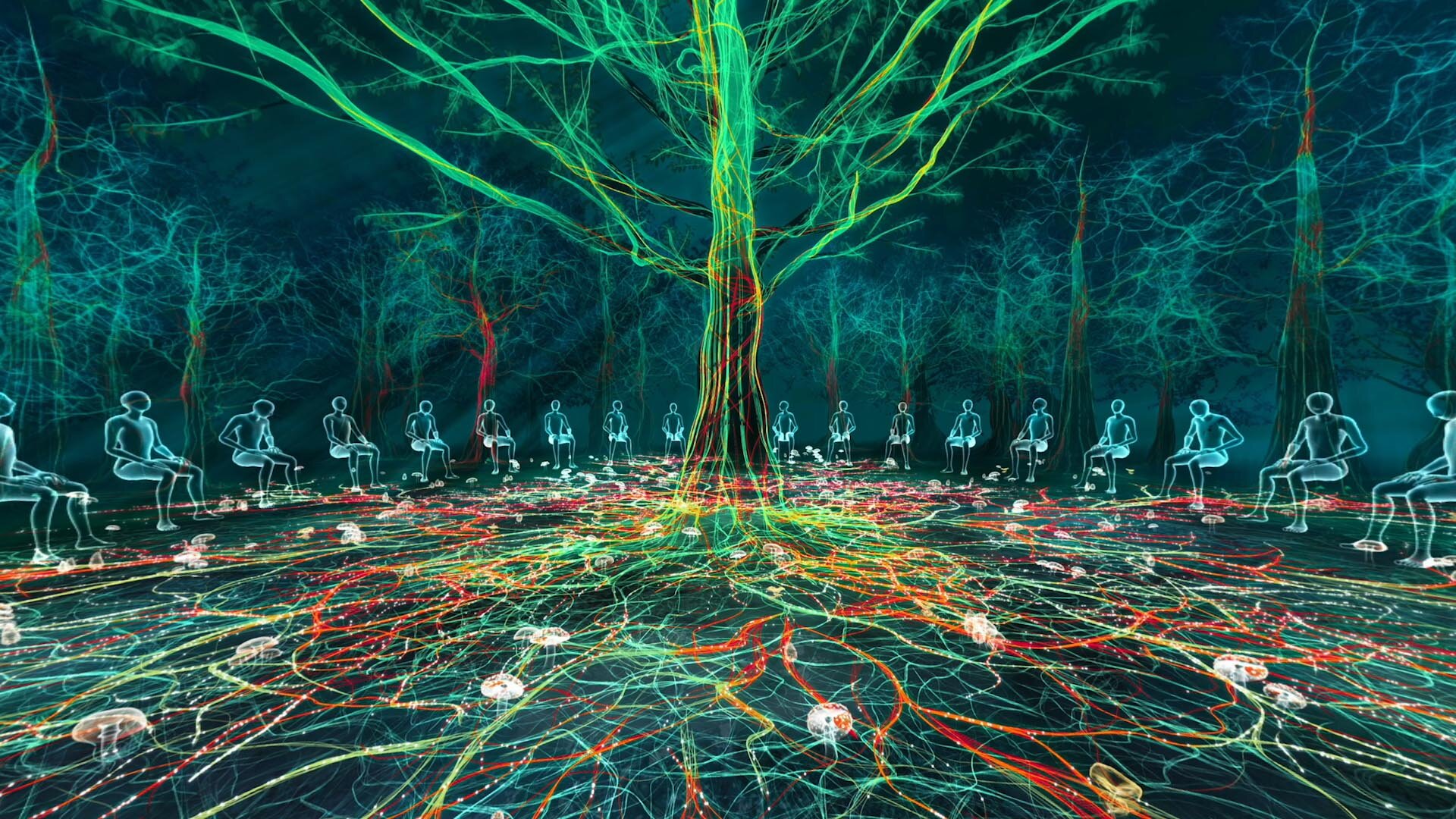

「30人の体験者が、MRとVRの世界を行き来しながらその体験をシアターの空間全体で共有させる必要がありました。そこへさらに立体音響も組み合わせる上では、MRとVRシーン間の速度感・光量・音像定位を精密に揃えて両者のトランジションに違和感を感じさせないレベルまで最適化。その上で車座のレイアウトにして、その位置関係を反映した体験者個別のMR映像と、全員で共通のプリレンダーVR映像を織り交ぜることで、ひとりひとりの体験者が異なる視点で見ている感覚になるように設計しました」(武田氏)。

さらにHMDに採用されたMeta Quest 3のスペックなどの特性を考慮して、映像をカクつかせないように設計するなど、没入感を高めるための様々な工夫が施された。

「30台のHMD(映像・音楽)とスピーカーから出る立体音響(SoVeC、寺坂波操、ソニーが技術開発・設計を担当)を完全に同期させるために、現場にローカルNTPサーバを設置して、各HMDが上映前に内部時計との差分を取得。再生トリガーを絶対時刻で発火させることでスキューを30ms未満に抑制しました。最も重要になったのは、184日という会期の間、稼働させ続けても壊れないようにすることです」(桜井浩幸氏)。

河森氏が掲げた本パビリオンのテーマ『いのちは合体・変形だ!』をXRで表現した超時空シアターは、30人が同時に宇宙スケールの食物連鎖を体験できるとあって体験者から高い評価を受けている。

Topic 01:MRとVRをシームレスに遷移させる

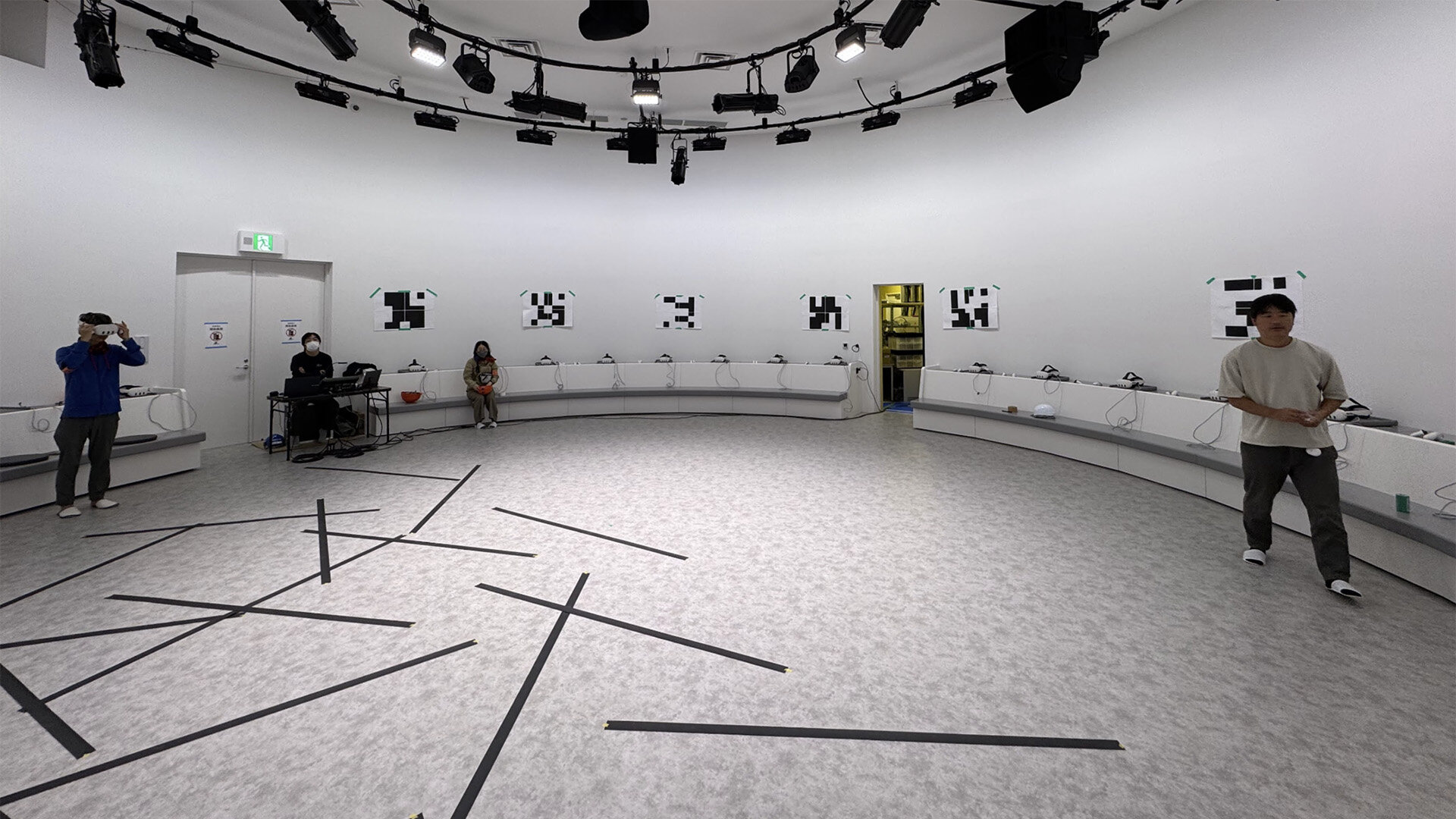

Topic 02:30人分の空間認識&共有

▲ 初期のトラッキング検証。壁面にマーカーを設置してみたが、対面壁が約10m離れているため効果が薄いことがわかった。空間認識では、Meta Quest 3がトラッキングロストすることを避けるために最低限の明るさを確保。MR演出で必要な暗さについては、Unity上で半透明の黒色マスクを配置することで対応。空間の共有についてもシアター内に2点の基準マーカーを設置し、各HMDがそれらの座標からローカル原点を推定するという空間アンカー方式を採用することで、確実に一定の精度を担保できるように設計された

Topic 03:MRと照明のシンクロ表現

▲ MRシーンではCGとパススルー映像の色味をマッチさせるためにリアル空間の照明もシーンごとに制御。クライマックスシーンでは、壁面に影を落とすMRのライティングやリアル照明にGOBO(Go Between Optics)を組み合わせることで、両者の一体感が高められた

24時間前から直前の1時間までの 地球や太陽の今を映し出す。|『宇宙の窓』

https://shojikawamori.jp/expo2025/contents/universe/

観測衛星の最新データを正しく、楽しくビジュアライズ

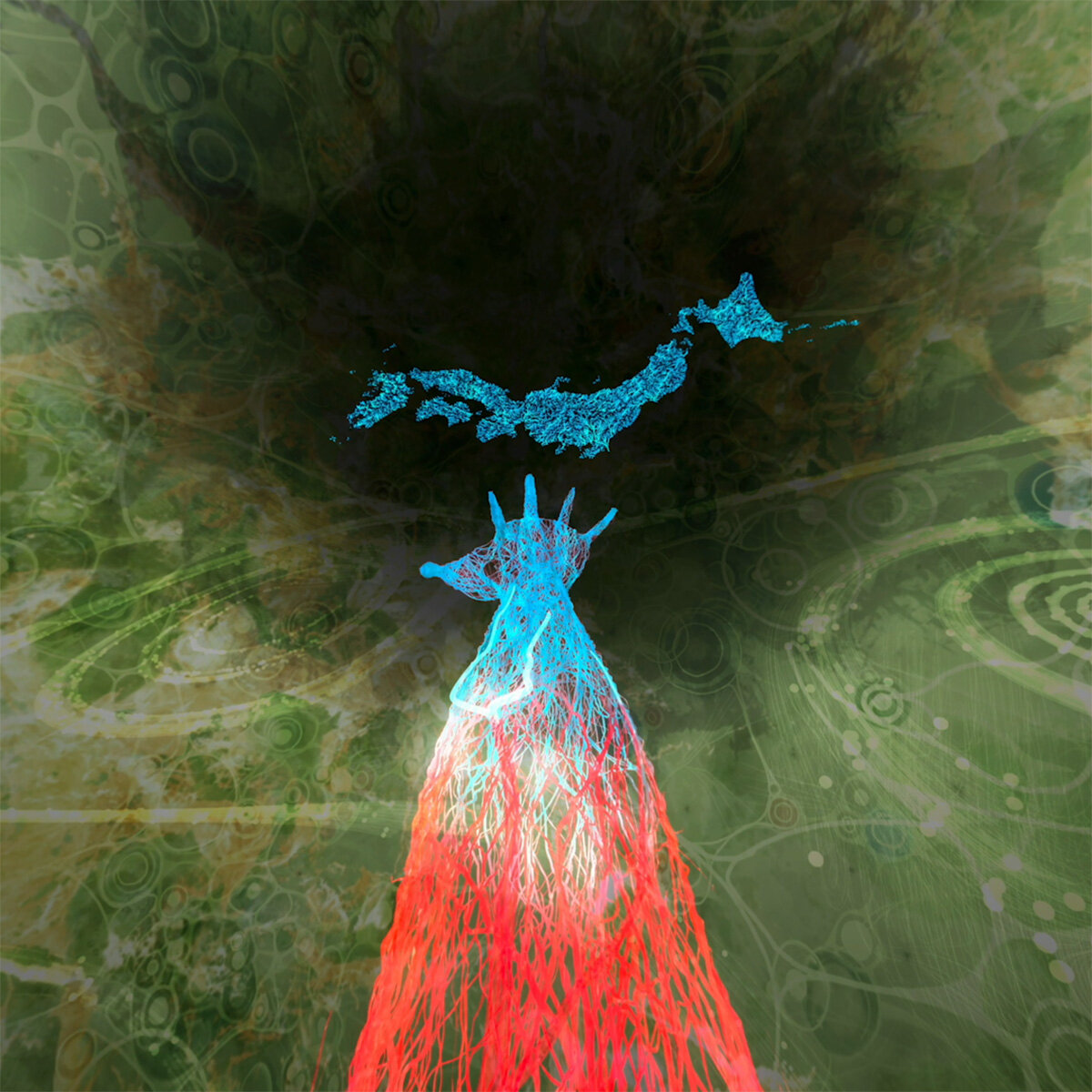

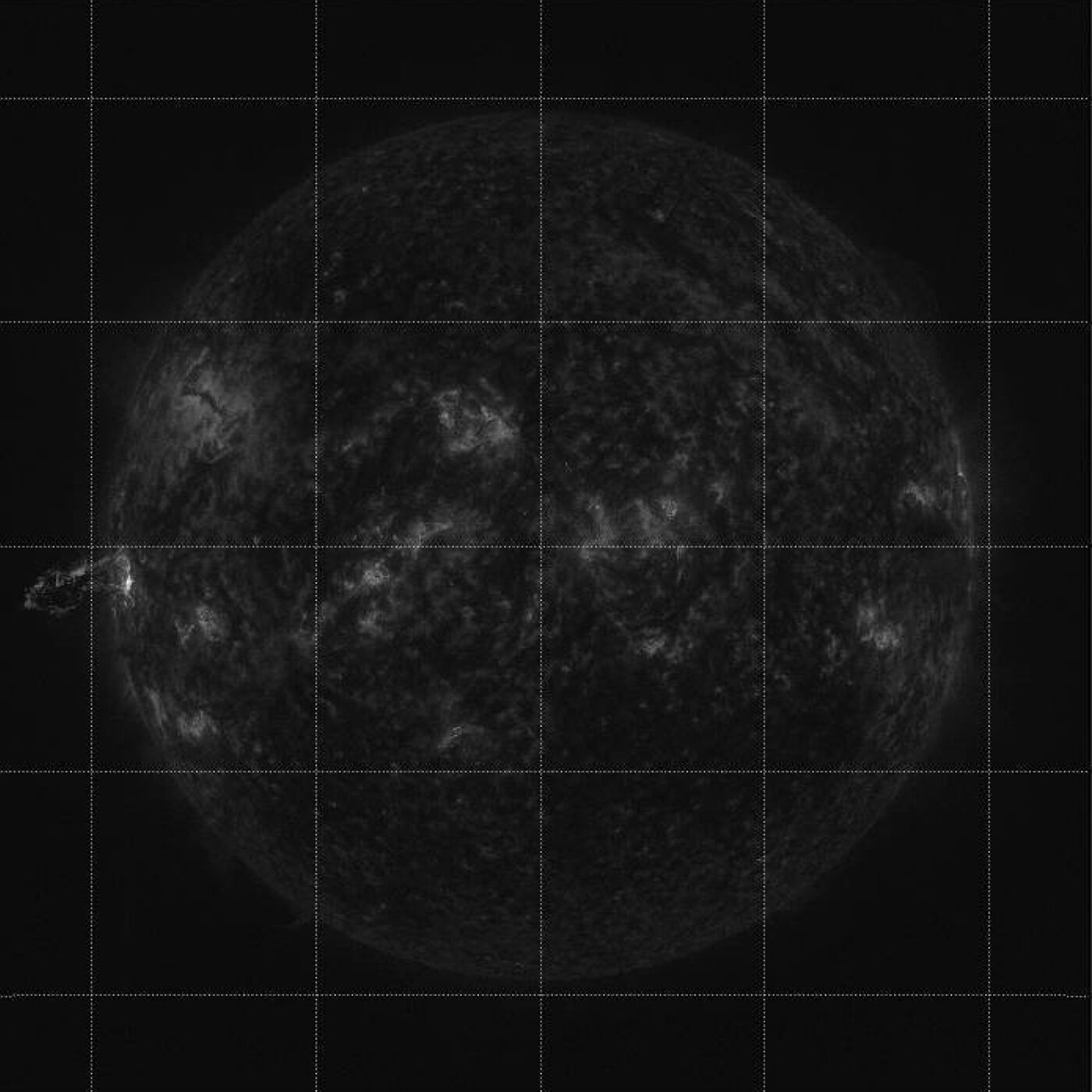

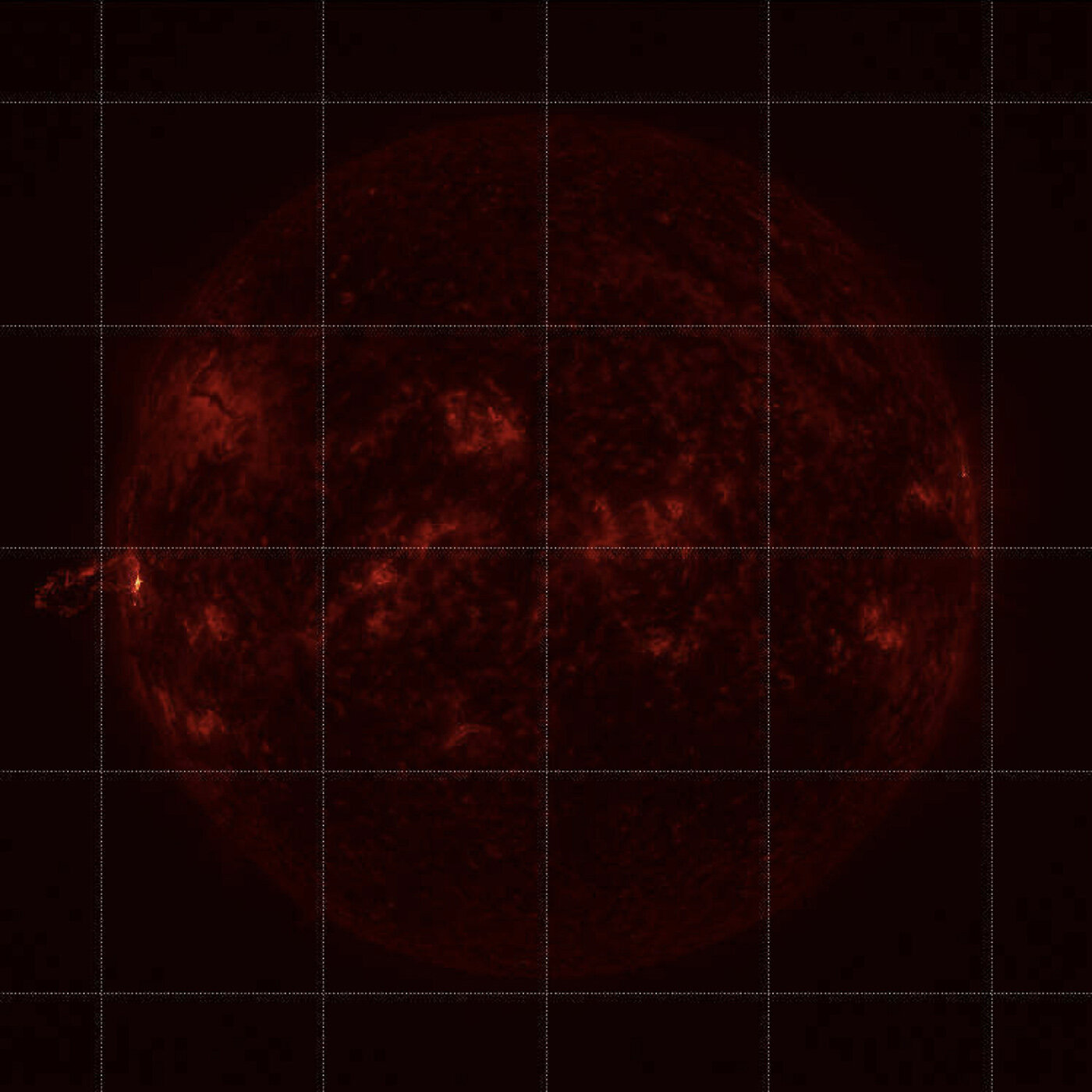

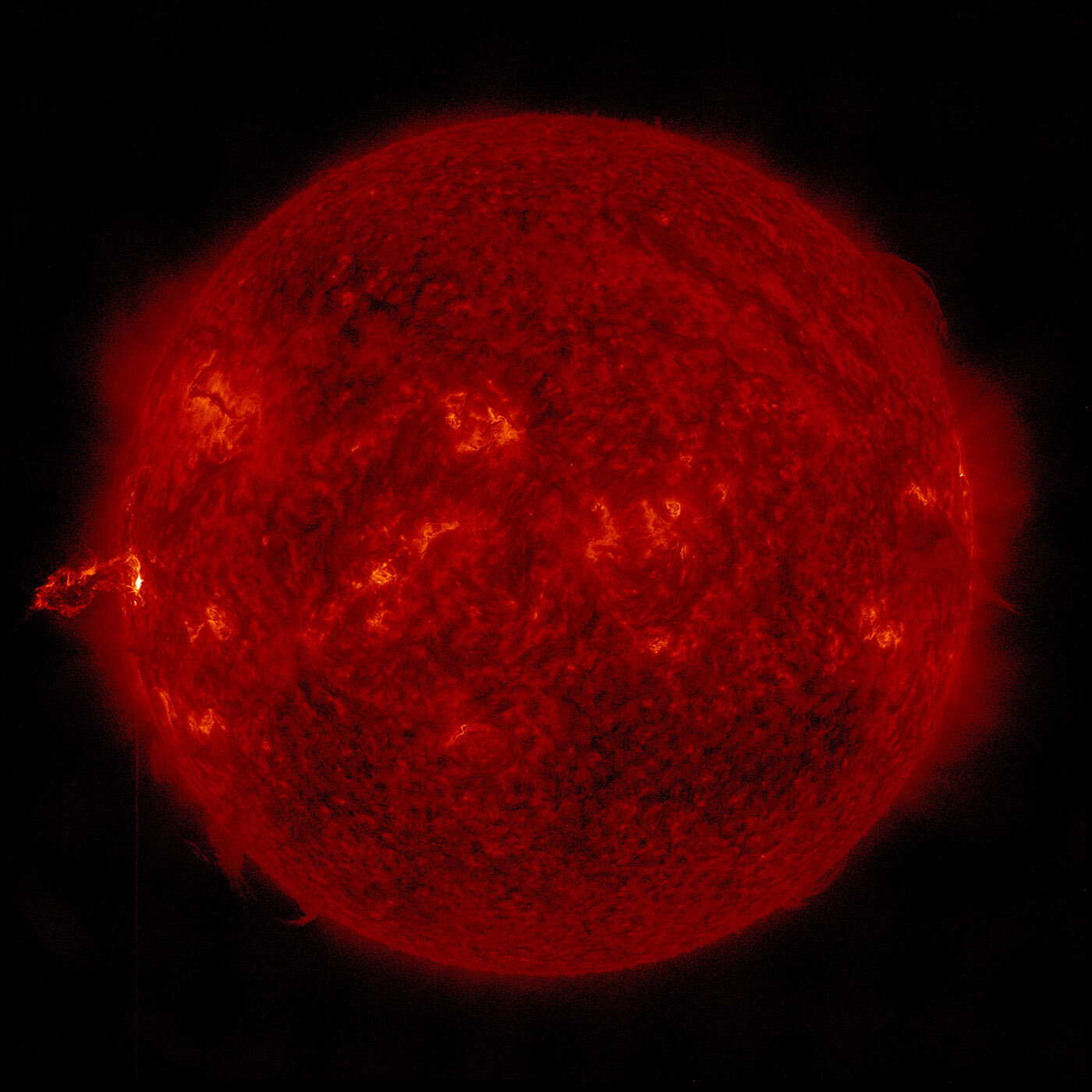

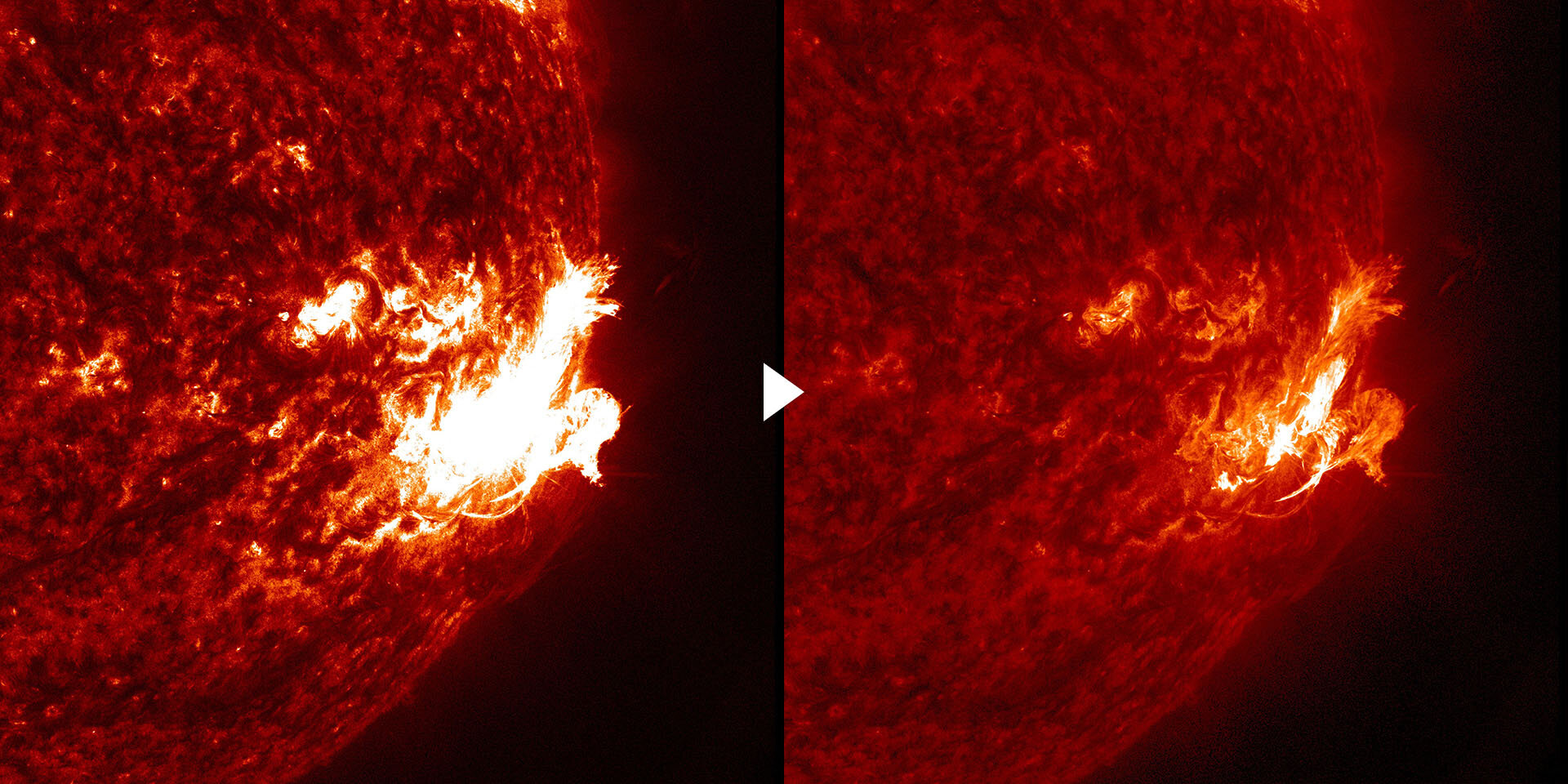

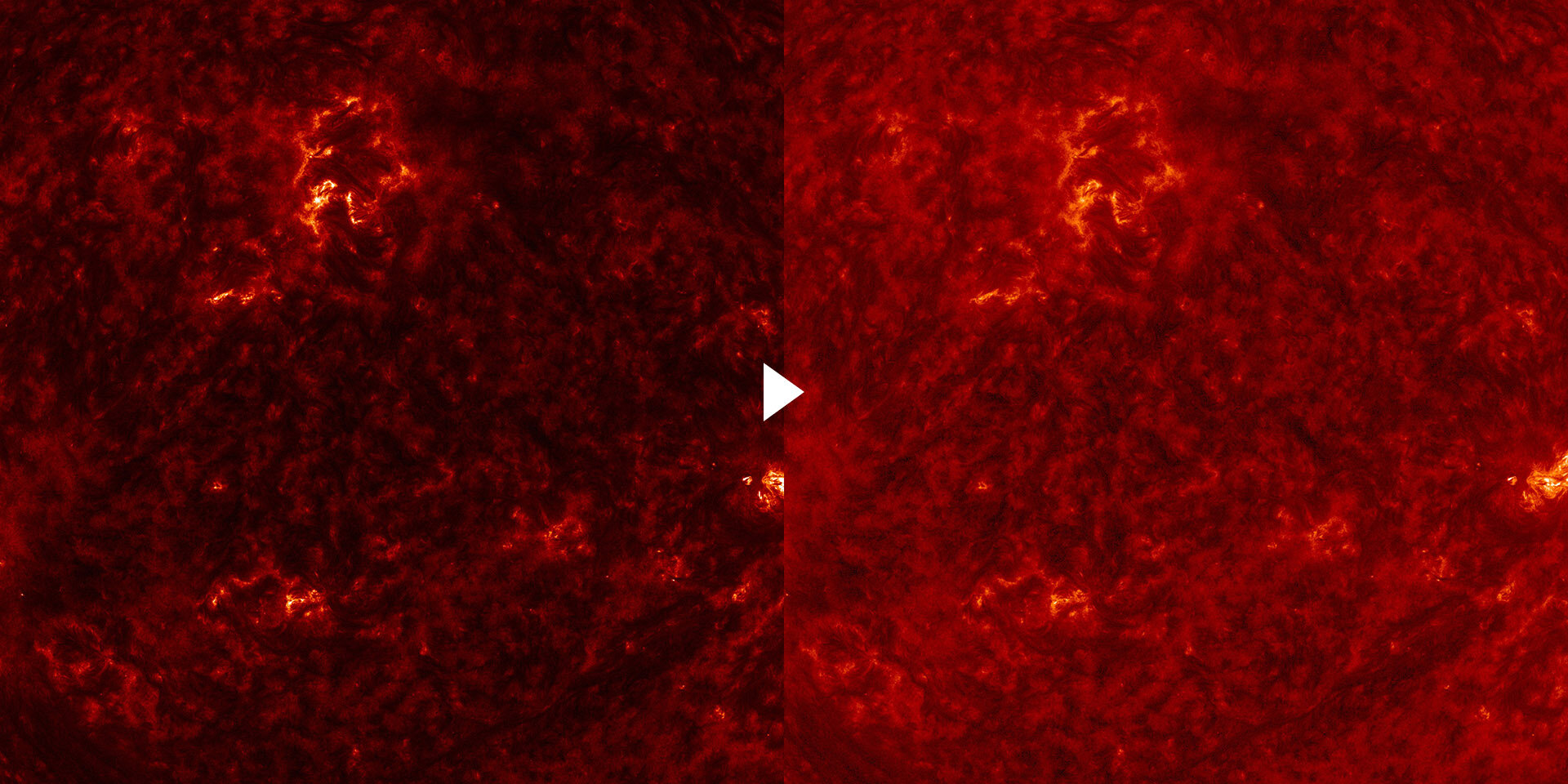

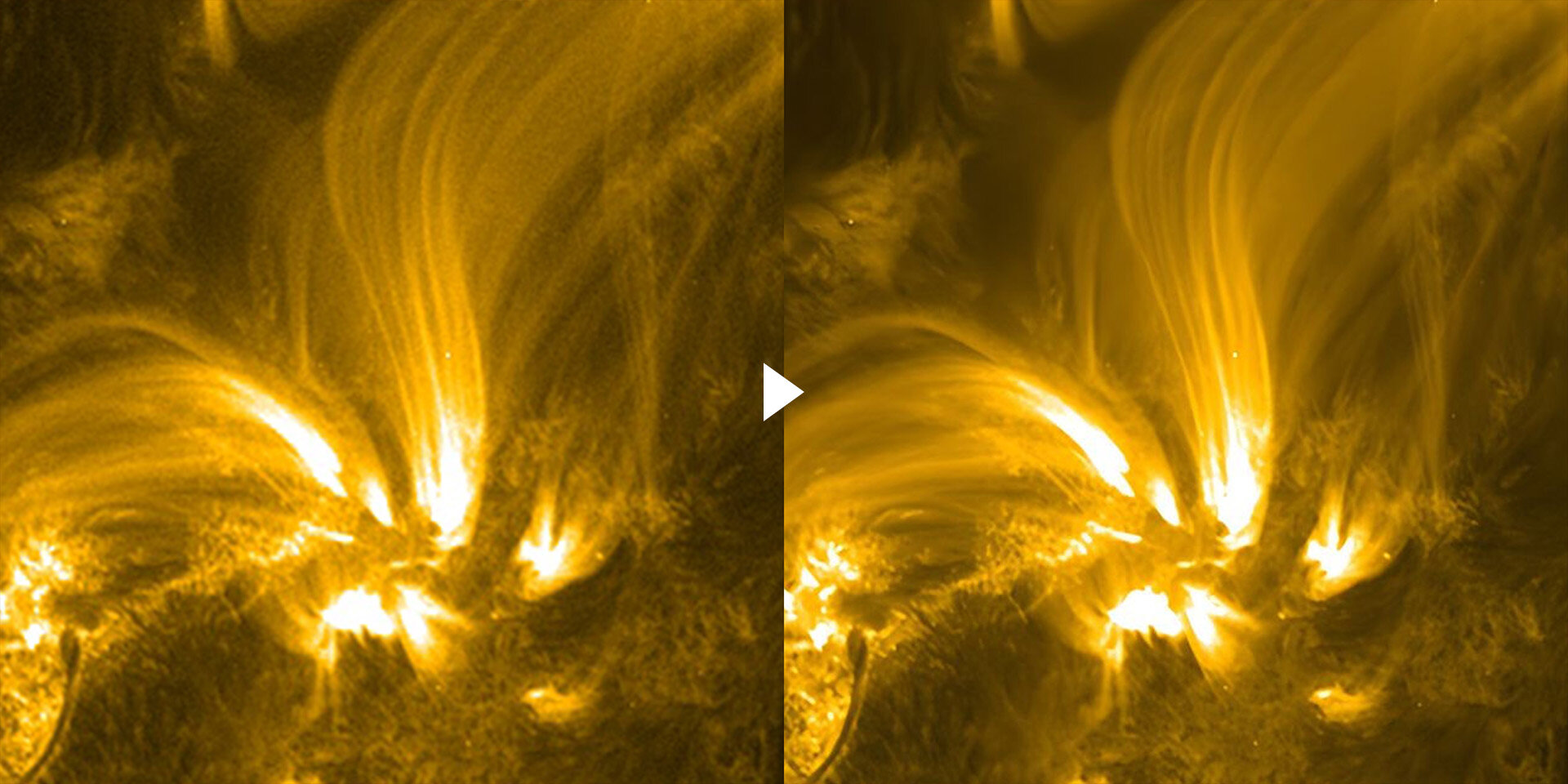

3万6千km離れた宇宙から見る今日の地球から卵の中で成長する鶏の胚まで、様々なスケールの“いのちの姿”を4m超のLEDビジョンに映し出す『宇宙の窓』。その最大の見どころは、気象衛星ひまわり(地球)と太陽観測衛星SODから届く観測データを、AIによるアップスケールなど様々な映像処理を施して24時間前から直近(約1時間前)までの地球/太陽を映し出すリアルタイム映像である。

「このシステムを構想したきっかけは、2022年に起きたトンガ沖の火山噴火のニュース映像でした。日本から約8,000kmも離れた場所の出来事が、地球規模だと、ものすごく近くで、ついさっき起きたことなのだと実感しました」(武田氏)。

当初はバスキュールの自社プロジェクトとして温めていたそうだが、「万博こそ、最適な発表の場」だと確信して、河森氏に提案したところ展示への採用が決まった。

「リアルタイム映像生成システムと、LEDに映すためのプログラムの実装を担当しました。万博という世界中の様々な文化・技術が交流する場で、科学的に意義のあるデータを正しく扱いつつ、多くの方々に楽しんでいただけるコンテンツにすることを意識しました」(勝田夕子氏)。

ひまわりとSDOの観測データは、AIによるアップスケール(太陽:4K→8K)、AIによるフレーム補間(地球:11Kサイズの画像2枚から中間フレームを7枚生成)に加え、画像キャリブレーションやノイズ除去などの処理を経て動画化される。8Kや11Kという非常に高解像度のデータを映像化、しかも昼夜を問わず生成し続けるため、GeForce RTX 4090搭載マシンが6台用意された(うち2台はバックアップ)。

「SODから取得した観測データの画像変換では、太陽フレアや磁気ループの微細構造が失われないように、局所コントラストの強調とトーンマッピングでディテールを保つようにするなど、科学的に意義のある情報を損なわないように注意しながら細かな調整を行いました。また、宇宙線のヒットや放射線損傷によるスパイクノイズが各フレームで散発的に現れるため、それがノイズなのか、それとも太陽の現象を捉えたものなのか適切な処理を施せるように調整する必要もあったので大変でした」(武田氏)。

さらに、展示環境に応じて適切な色味で映し出されるように、昼閒はコントラストを強く、逆に夜間は輝度を抑えて目に優しい映像に整えるといった色味の調整も組み込んでいるとのこと。『宇宙の窓』は予約不要で体験できるので、万博を訪れた際は必見だ。

Topic 01:観測データからの画像変換

Topic 02:AIによるアップスケール&フレーム補間

Topic 03:長期間の安定運用のために

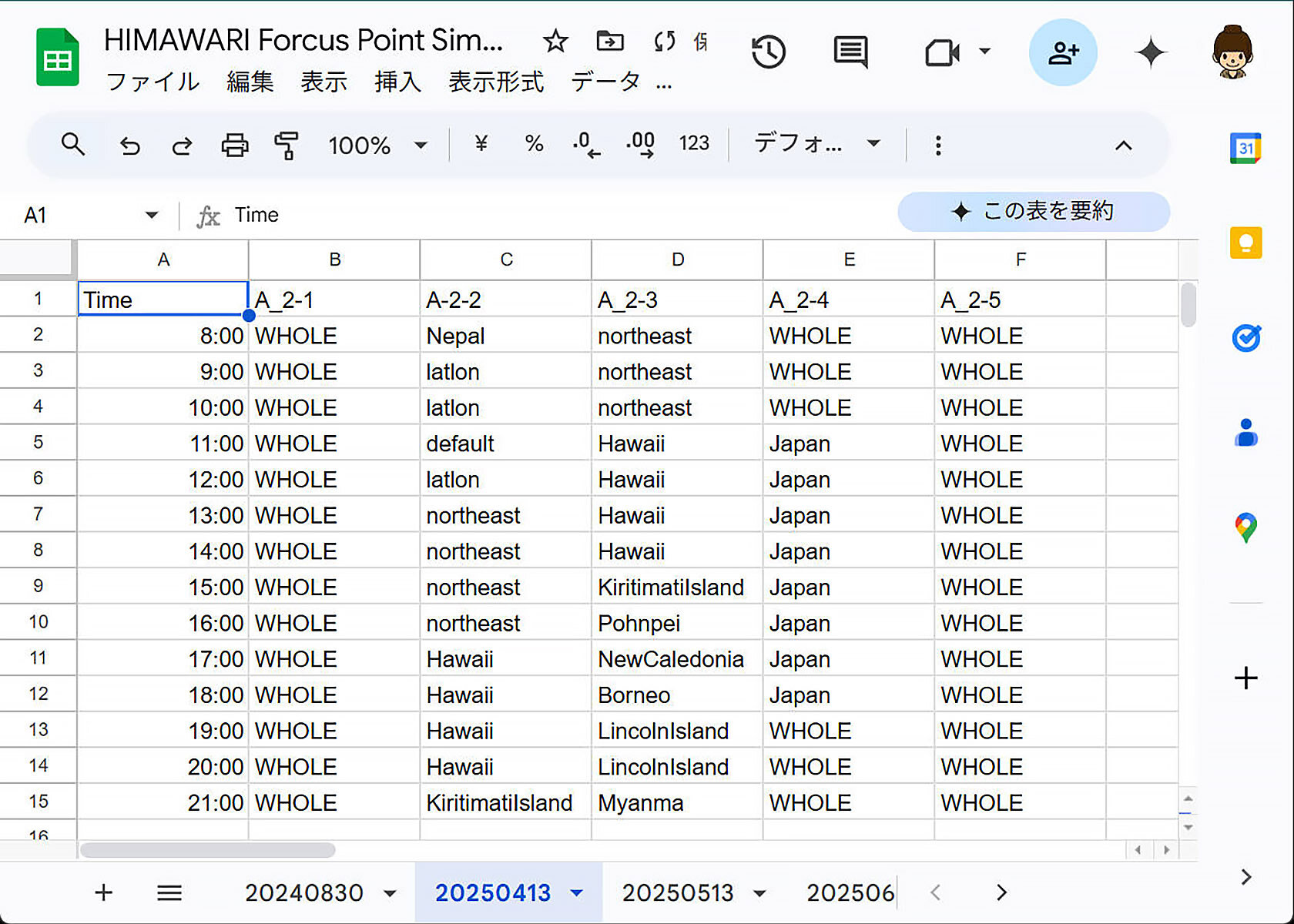

184日という会期の中で、季節や時間によって陽に照らされる場所が移り変わっていく地球と、フレアやプロミネンスなど活動の様子が刻一刻と変動する太陽。そこで常にその変化を解析し、「いつ、どのタイミングでもイイ感じの見え方のアングル」を自動的に選択するための自動カット割りシステムが開発された。 地球の場合は、地球公転軌道を時系列でシミュレーションし、その理論日照度を指標に自動的にズーム対象を判定するロジックを構築。さらに気象衛星ひまわりが捉える広い観測域をバランス良く選出できるよう、日照度と緯度に応じた補正値を加算した独自スコアを導入することで、映像全体に地理的バリエーションと発見性をもたせている。 さらに安定して運用するための監視システムも構築された。処理結果が自動的にSlackへ通知されるようにするのと同時に、もしエラーが発生しても自動的に再起動して復旧するようになっている

INTERVIEW & EDIT_NUMAKURA Arihito