2024年1月25日に開催されたAutodesk主催「Autodesk Animation Day」のイベントから、有限会社オレンジによるセッション‟『劇場版アイドリッシュセブン LIVE 4bit BEYOND THE PERiOD 制作における作業データの流れ”のセッションレポートをお届けする。

『劇場版アイドリッシュセブン LIVE 4bit BEYOND THE PERiOD』(以下、『劇場ライブ』)は、人気スマートフォン向けアプリゲームを主軸としたメディアミックスプロジェクト『アイドリッシュセブン』初のライブステージとなる劇場版アニメーションである。

Information

原作:バンダイナムコオンライン/都志見文太

監督:錦織 博、山本健介

制作:オレンジ

製作:劇場版アイナナ製作委員会

配給:バンダイナムコフィルムワークス、バンダイナムコオンライン、東映

©BNOI/劇場版アイナナ製作委員会

idolish7.com/film-btp

登壇者

ライブパフォーマンスありきの画づくり

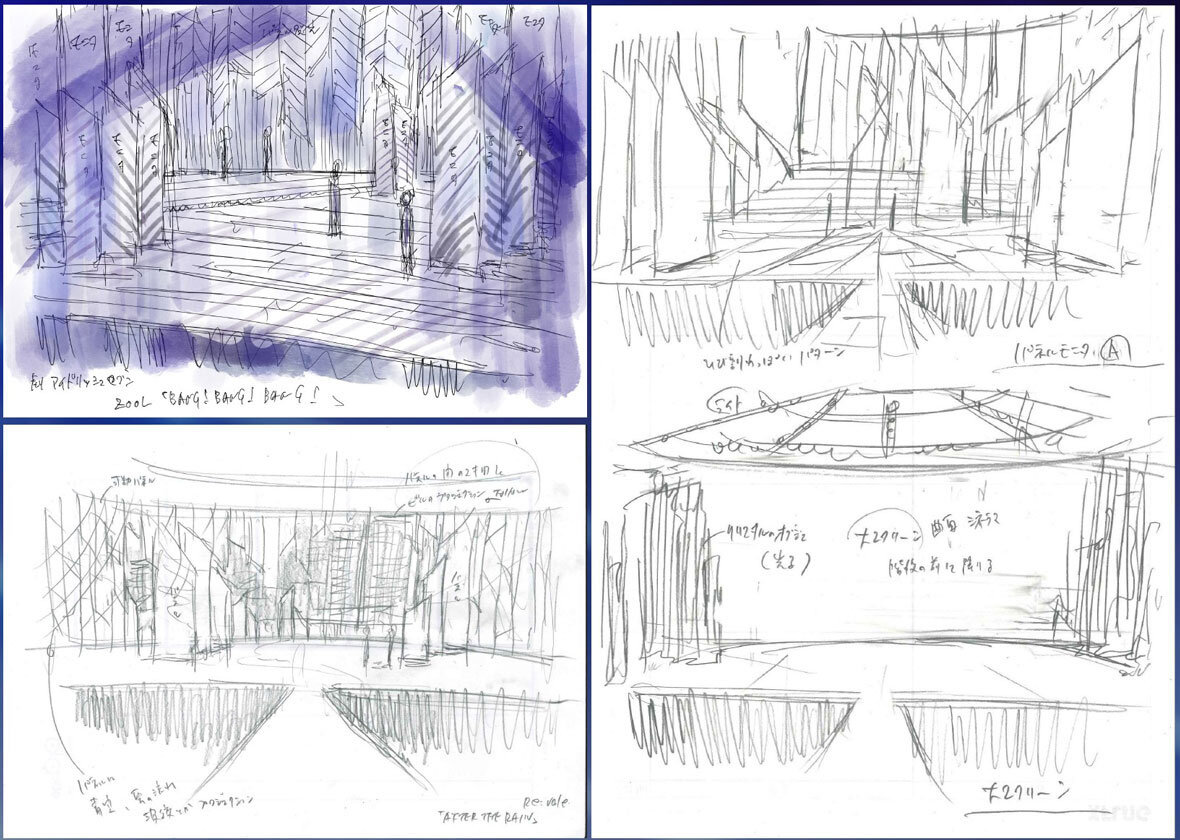

両監督で意見を交わした企画・演出

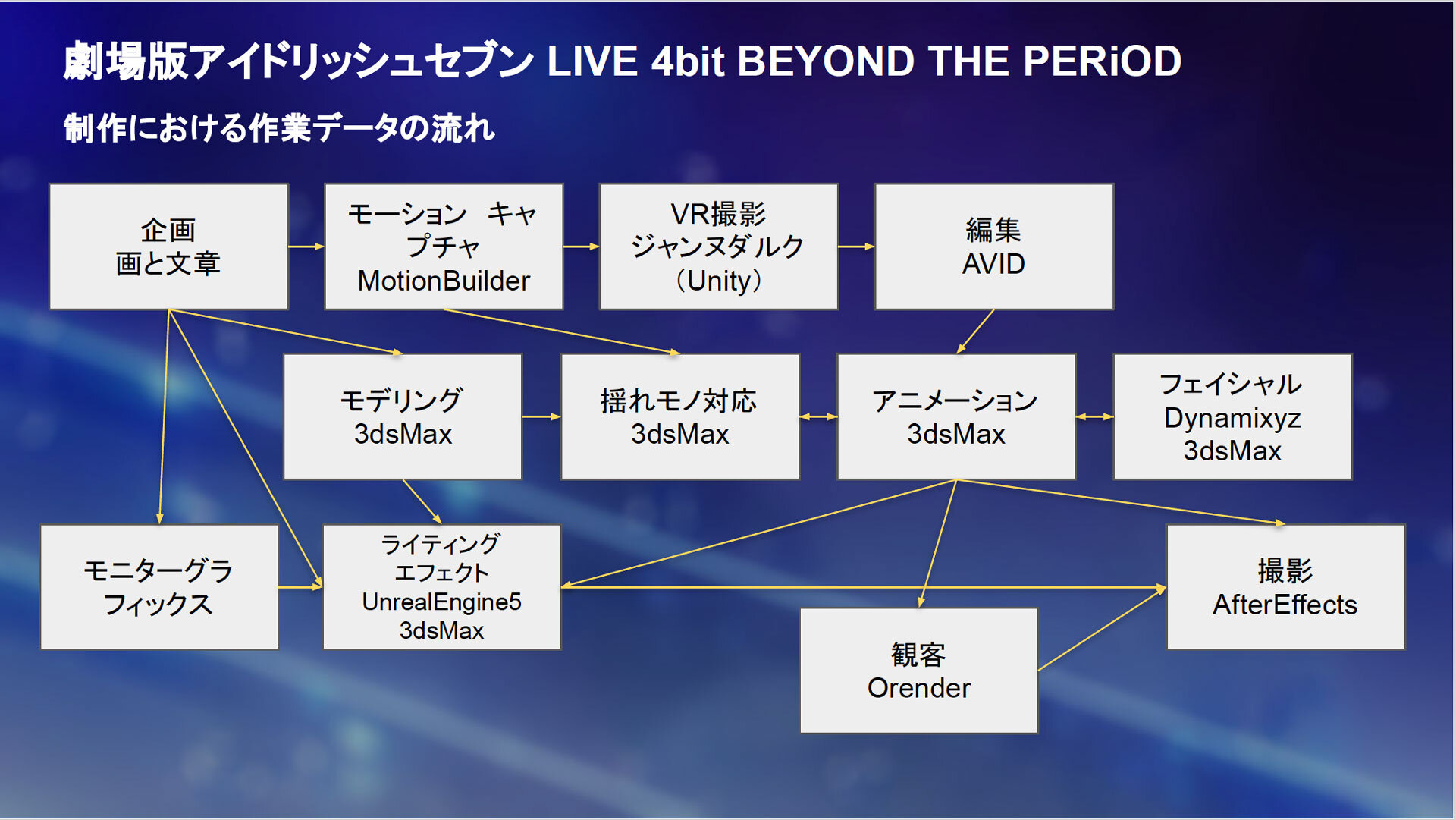

『劇場ライブ』は全編ライブ映像の作品であり、セットリストが一部異なる<DAY1>と<DAY2>が同時に制作された。カット数と時間尺はそれぞれ、<DAY1>が1283カット/92分51秒、<DAY2>が1348カット/93分57秒で、重複を除くと合計1736カット/119分12秒に及んだ。

制作初期においては、錦織 博監督(以下、錦織監督)のスケッチや文章をもとに、山本健介監督(以下、山本監督)は現場スタッフの立場からどうすれば映像化できるのかというアイデアを提案しながら企画・演出が固められた。

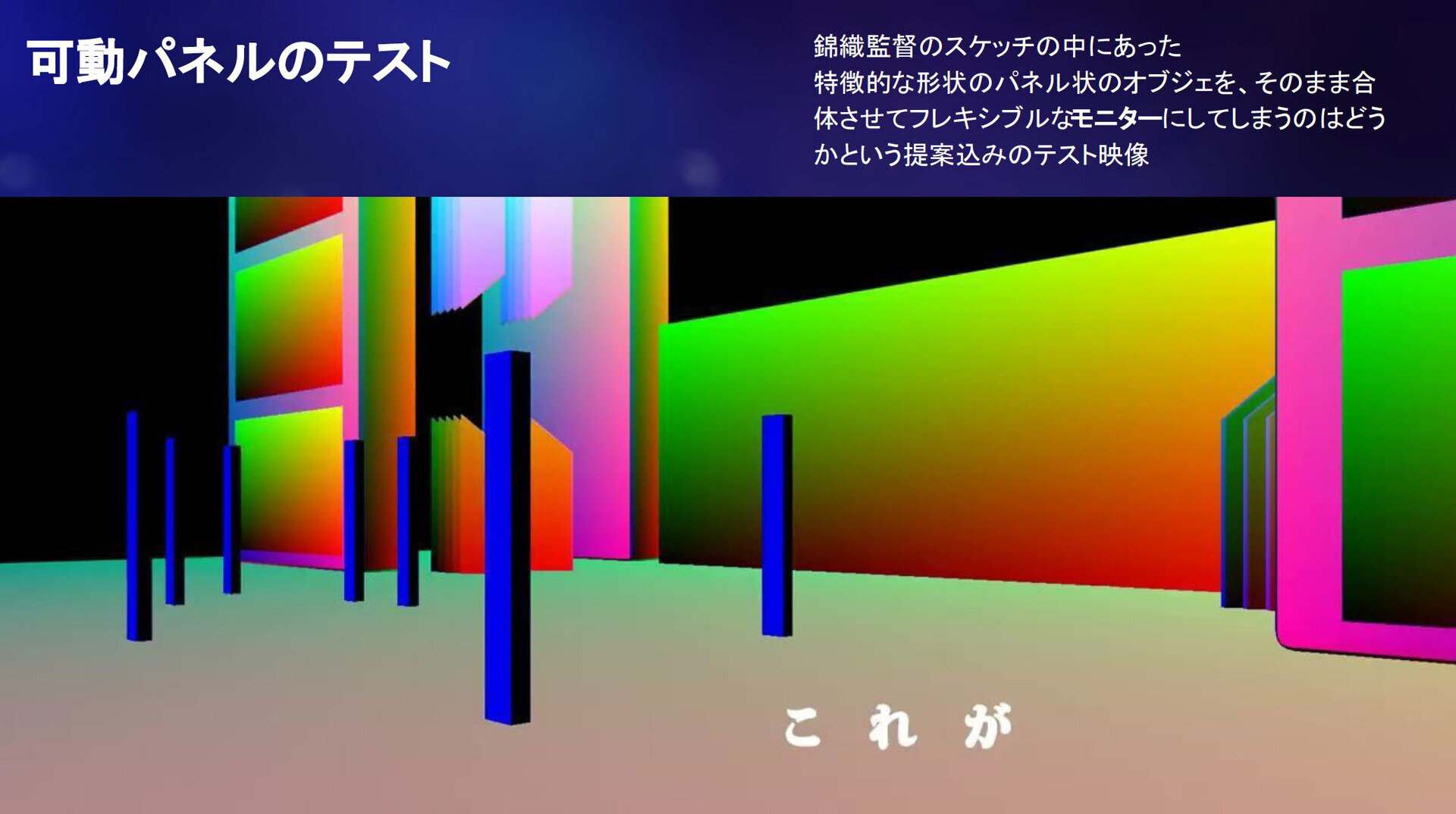

その過程で生まれた代表的なものが、ライブステージ上に置かれた「可動パネル」である。錦織監督が描いたスケッチの中に特徴的な形状のパネル型モニタが複数あったことに山本監督が着目し、フレキシブルなモニタとして扱ったら面白い演出ができるのではないかと考えたという。そこで可動パネルのテスト映像が作成・検証され、演出がライブに導入されることになった。

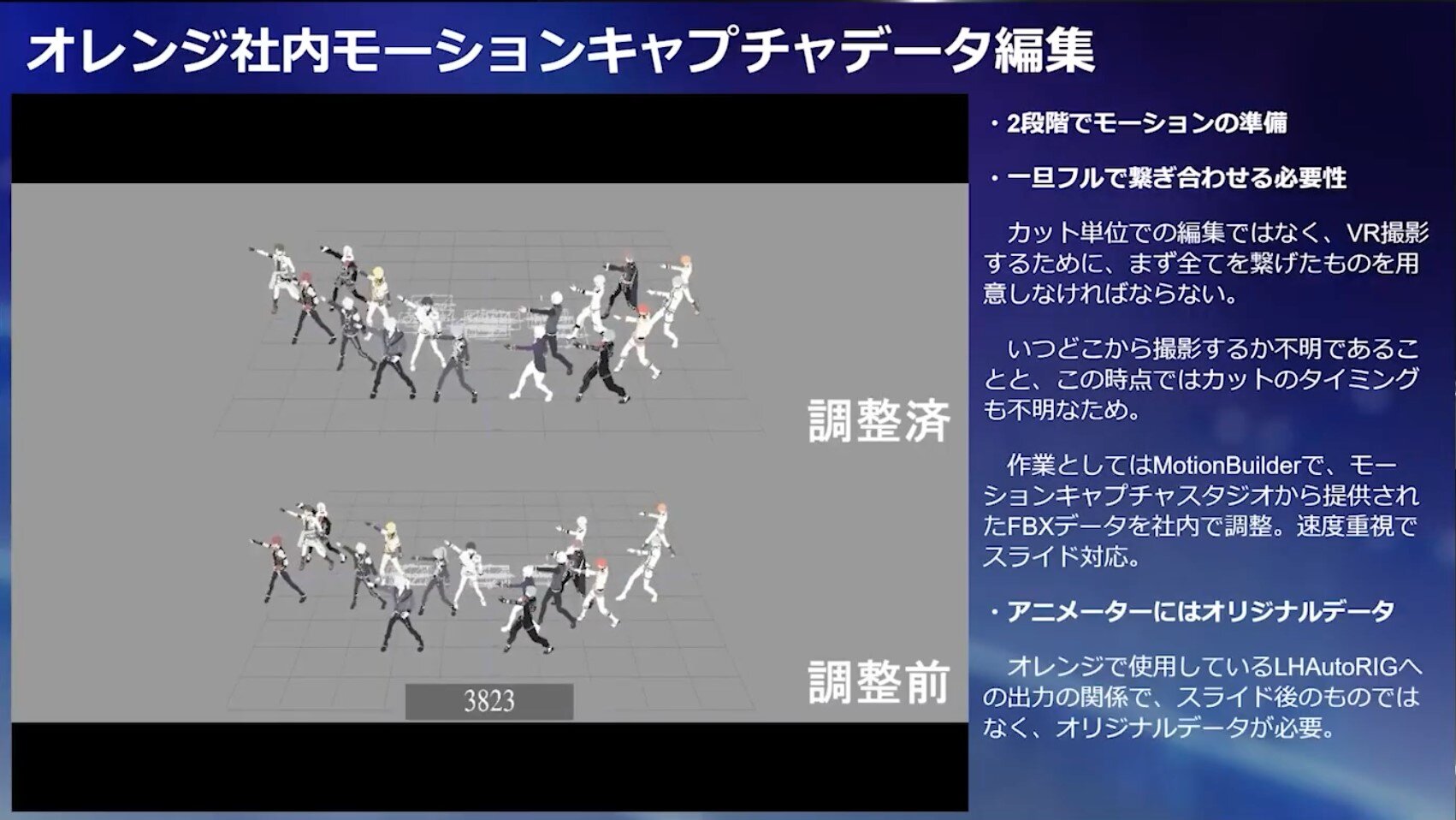

MotionBuilderにおけるキャプチャデータの編集

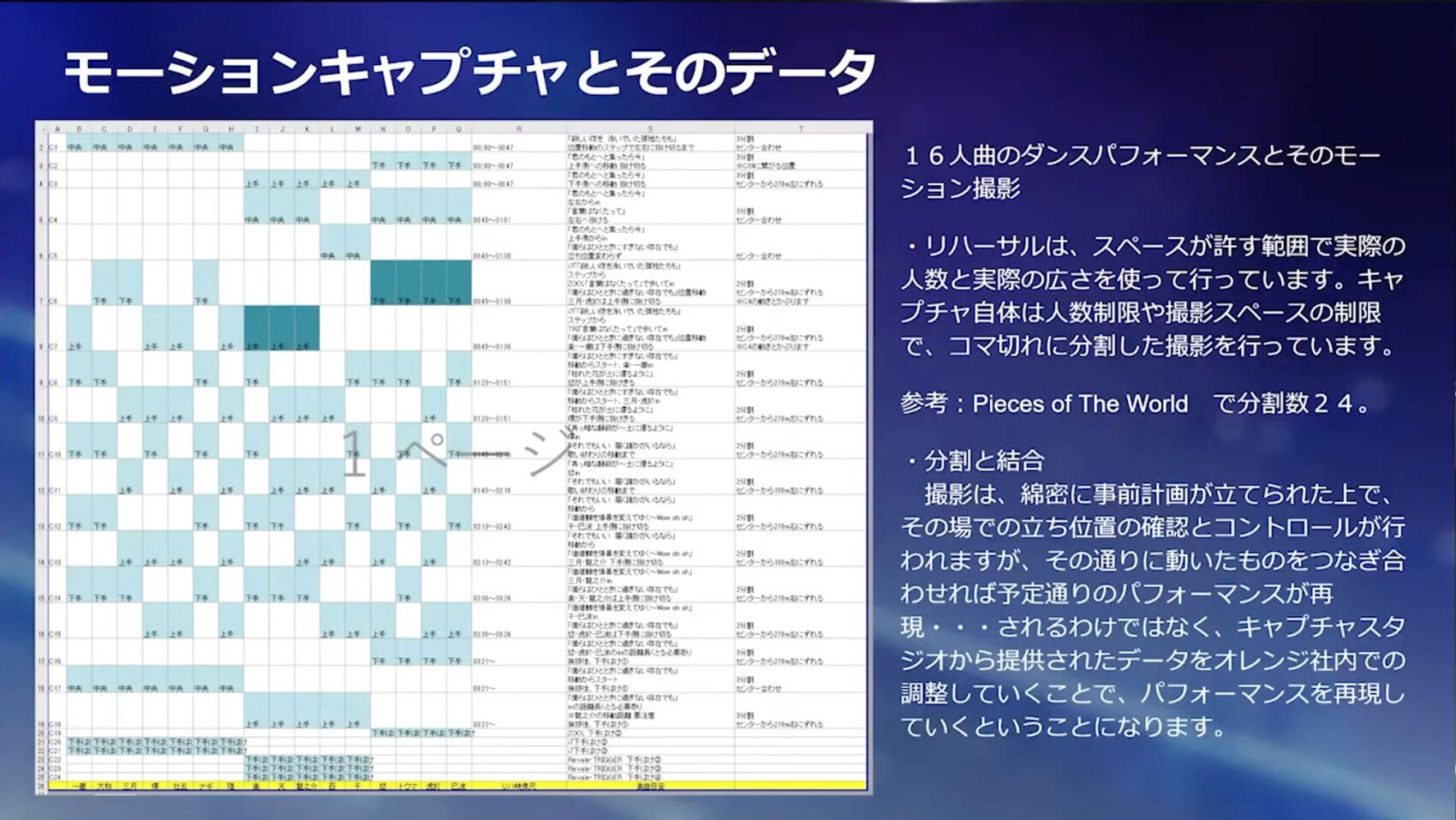

モーションキャプチャは楽曲によって撮影の難易度が異なり、歌唱人数や空間移動が少ない曲においては、1回の撮影で完了したケースもあったという。一方、本作の主題歌である「Pieces of The World」は『劇場ライブ』に登場するアイドル全16人が揃って歌うこともあり、最終的に24回に分けて撮影することになった。

キャプチャデータはアイドル16人分がバラバラの状態で届き、オレンジではMotionBuilderを使って編集を行なった。単純に16人のデータをひとつにまとめただけでは曲が進むごとに動きやフォーメーションにズレが生じてしまうため、細部を調整する必要があったという。

一般的なアニメ制作であれば各カット内で動きが成立していれば問題がないため、画面に映る部分の動きのみを調整していくことが多い。しかし本作では「パフォーマンスありきで画づくりを行う」コンセプトに基づき、この時点ではカットの切れ目やカメラの位置は決まっていなかった。そのため後の工程でのVR撮影用に、いったんすべてのデータを繋げたものを用意する必要があった。

全ての動きを正確に調整すると膨大な時間を要してしまうため、第一段階ではキャラクターをスライドさせて位置合わせだけを行なったデータを制作し、VR撮影に使用。演出が固まったところでアニメーターにスライド前のオリジナルデータを渡し、仕上げていくというフローがとられた。

VR撮影とカット制作

VR空間で行われたライブ撮影

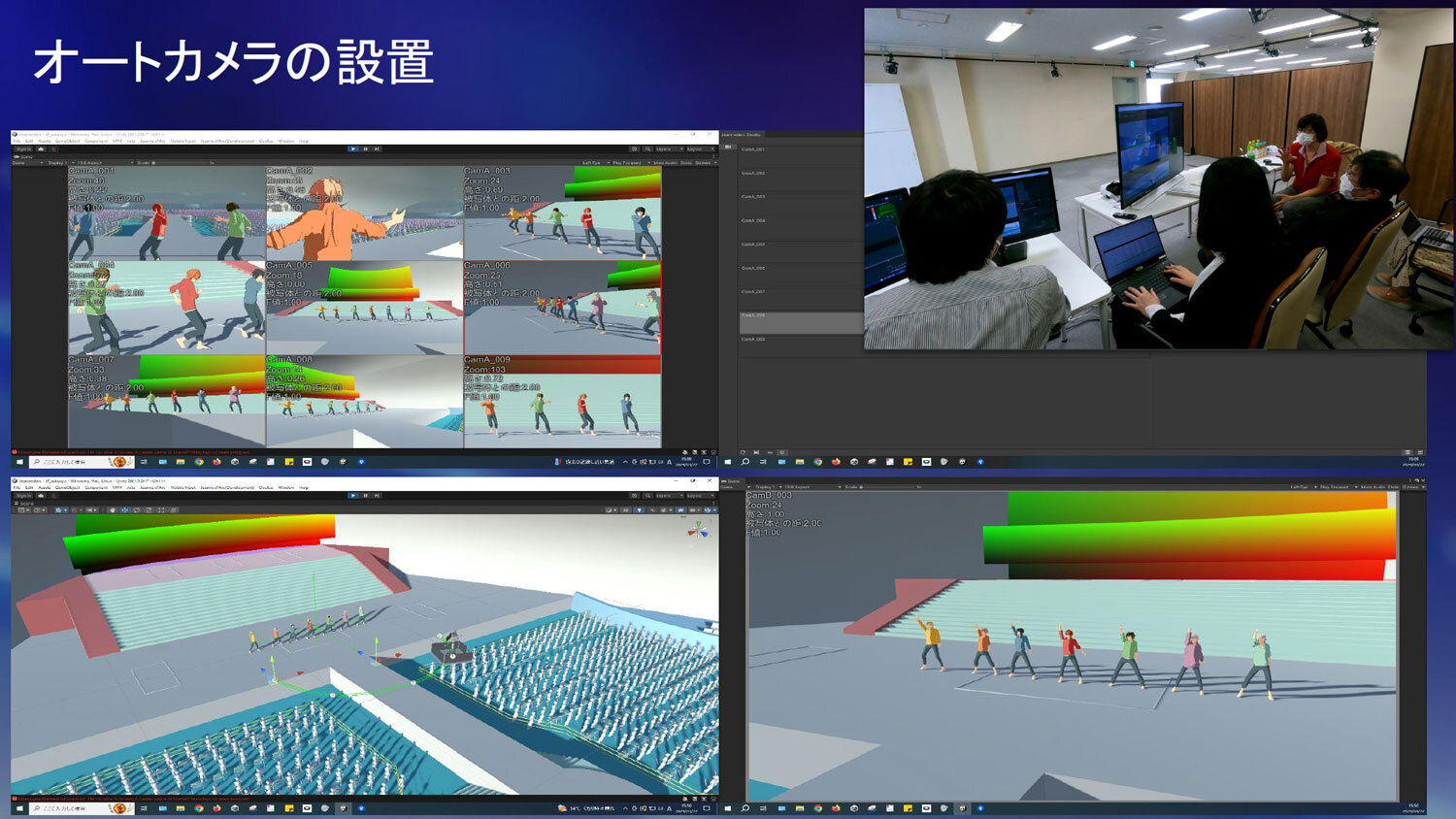

モーションキャプチャデータを繋げて作成されたライブパフォーマンスは、VR空間内で再現されバーチャルカメラによって撮影が行われた。撮影はカヤックが開発したバーチャルカメラシステム「ジャンヌダルク」を使用して行われている。

「Pieces of The World」の場合、固定カメラが119台、VR空間内のレールを移動するドリーカメラが24台、ドローンカメラが19台、山本監督と錦織監督が撮ったハンディカメラが31台の計193台のカメラを使用。約4分50秒の曲に対し、15時間以上の素材を撮影した計算になる。

当初はオートカメラの映像を中心に使い、ハンディカメラの映像は補助的に用いる予定だったが、ハンディの方が良い画が撮れたことから方針を転換。VR空間を観ながらの長時間撮影は過酷だったという。「VRには酔わないタイプなのですが、一日中やっているとさすがに酔いました」(山本監督)

撮影された大量の素材を編集スタッフが取捨選択し、仮編集ムービーを制作。編集は通常1人で担当するケースが多いが、本作ではリアル・ティの4人のスタッフがアイドル4グループを個別に担当する体制で挑んだ。グループごとに専任スタッフを立てたことで、それぞれの特色が自然と生まれ、差別化が図れたという。

UE5でのレンダリングとFlow Production Tracking(旧ShotGird)による効率化

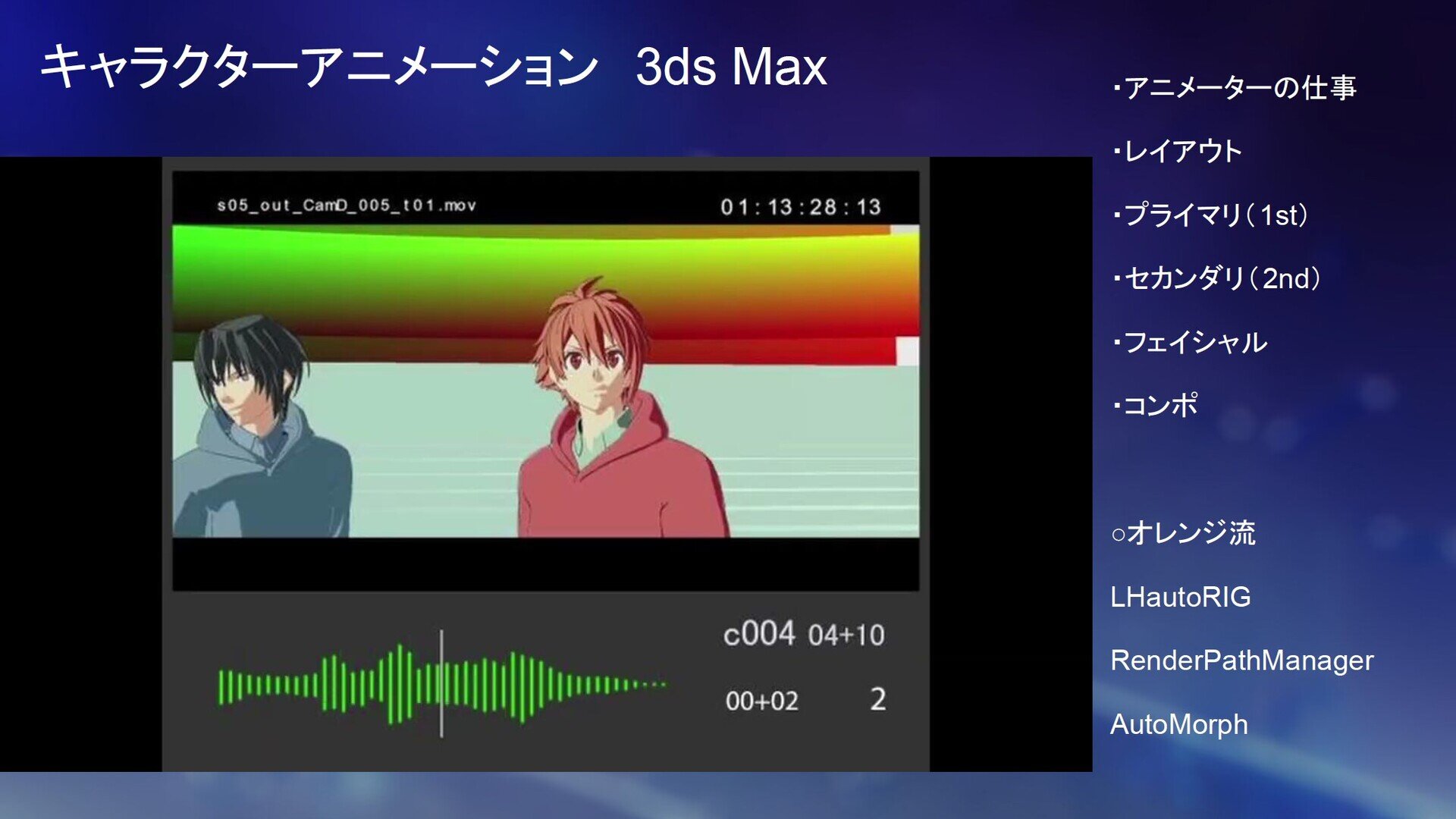

VR撮影後仮編集された映像をもとに、仕上げられたモデル、モーションに置き換え、各カットにライティングとエフェクトが施されていった。ステージのモデリングが完成した時点で、キャラクターのモデリングをはじめ多くの作業が同時並行で進められたという。CG制作のメインツールとしては3ds Max、フェイシャルアニメーションにはDynamixyzによるフェイシャルキャプチャも活用された。

なお、本制作におけるチャレンジのひとつとして、レンダリングがUnreal Engine5にて行われた点が挙げられる。Unreal Engine上で動くライティングシステムを構築して進められた。「すごく大変でしたが、ステージのレンダリング時間などを考えると、結果的にはこれしか選択肢はなかったと思います」(山本監督)

エフェクトの工程では3ds MaxやUnreal Engineなど、さまざまなツールを組み合わせてパフォーマンスに彩りを与えている。

プロジェクト管理にはFlow Production Tracking(旧製品名はShotGrid、以下FPT)が活用されたが、特にライティングの工程で役立ったという。FPTにはデータに絵や文字を直接書き込める機能があり、本作では演出のプランニングにおいて活用された。スマートフォンからも確認することができるため、大まかな動きやレイアウトであれば出先でもチェックバックができ、レスポンス速度の向上に貢献したという。

また、オレンジではファイルをFPTにアップロードすると、Slackから自動的に通知が送られてくるシステムが構築された。チェック担当者を指定すれば、その人物をメンションした状態でSlackから通知を送ることができる。FPTのカスタム性を活かしてつくられたこのシステムも、レスポンス速度の向上に貢献したことが語られた。

ライブに盛り上がる観客の表現

パフォーマンスをするアイドルやステージ演出だけではなく、ライブに参加する観客にもこだわって制作された。ペンライトを振ったり、体を動かしたりするモーションのタイミングにランダム性を持たせることで、観客ひとりひとりが盛り上がる様子が表現されている。

観客の制作にあたり、オレンジではUnityベースでレンダリングするためのシステムが複数開発された。一例として、『TRIGUN STAMPEDE』で砂漠などの背景美術レンダリング用に開発したスタンドアロンアプリの「Orender」を、本作では観客のレンダリングに使用している。

ステージ上のアイドルの位置に合わせて身体の向きを変える観客の様子を描写するため、3ds Max上でエリアごとに注視点を設定する仕組みが構築された。

また、現実のライブにおいては、ステージから客席までの距離によって歌声が届くタイミングがわずかに異なるため、ペンライトを振るタイミングが席の位置によってずれていき、会場全体のペンライトの動きが波(ウェーブ)のように見える現象が発生する。その光景を『劇場ライブ』にも取り入れることが試みられた。検証の結果、忠実に波を再現するとつくりものっぽさが出てしまうことが判明したため、自然な現象に見せるための微細な調整が重ねられたという。観客に届く歌声の音速まで意識して映像を制作するという、ライブ制作に対するこだわりが感じられた。

アナモルフィックレンズを使用した撮影

撮影のセクションにおいては、ライブに出演するアイドルグループごとにそれぞれ別の会社に制作を依頼するという体制が取られた。この体制によって、グループの特色が色濃く反映された仕上がりになったという。

山本監督による全グループ共通でのオーダーのひとつに、‟アナモルフィックレンズを使用した撮影”が挙げられる。『劇場ライブ』には16人のアイドルが登場することから、アスペクト比は横長のスコープサイズにすることが早い時点で決まっていた。シネマスコープの撮影時に使用するアナモルフィックレンズを使用することで、アイドルのパフォーマンスが実際にカメラで撮影されている様子の表現を目指した。水平に広がる青いレンズフレアや、縦長の楕円形になったボケ表現などを細かく丁寧に盛り込んでいったという。レンズを意識した画づくりを目指した結果、本物のライブを撮影したかのような臨場感が生まれている。

TEXT_遠藤大礎

EDIT_渡邊英樹、Mana Okubo(CGWORLD)

PHOTO_弘田 充/Mitsuru Hirota