2017年3月の初放送直後から「あの表情はどうなっているの?」「NHKの謎技術がすごい」などの驚きの声がSNSに多数投稿された『チコちゃんに叱られる!』。2018年4月よりレギュラー放送が始まった本作におけるCG制作の舞台裏を、NHKアートに聞いた。

※本記事は月刊『CGWORLD + digital video』vol. 240(2018年8月号)掲載の「CGと着ぐるみの融合でクルクルと表情を変える5歳児キャラクター チコちゃんに叱られる!」を再編集したものです。

TEXT_尾形美幸 / Miyuki Ogata(CGWORLD)

取材協力_畠山智早(ボーンデジタル)

PHOTO_弘田 充 / Mitsuru Hirota

▲TV番組『チコちゃんに叱られる!』

NHK総合/毎週金曜 午後7時57分/再放送 毎週土曜 午前8時15分

日本放送協会/ ©NHK

収録時の頭部は着ぐるみで、後日CGへ置き換える

3回の特別番組を経て2018年4月からは毎週放送となった『チコちゃんに叱られる!』。常に高視聴率を維持しており、TV離れが進んでいる19歳以下の若い世代の視聴率も好調だという。チコちゃんは「好奇心旺盛な、何でも知っている5歳児」という設定のキャラクターで、MCの岡村隆史(ナインティナイン)をはじめとする出演者に対し、「いってらっしゃーいってお別れするとき、手を振るのはなぜ?」などの素朴だが答えに詰まるギモンをぶつける。正解できなければ、顔を真っ赤にして目から黄色い炎を出し、頭から白い湯気を噴き出すチコちゃんに「ボーッと生きてんじゃねえよ!」と叱られてしまう。

番組内のチコちゃんは、スタジオを自由に歩き回り、クルクルと表情を変え、ときには頭の大きさまで変化する。「番組収録時のチコちゃんは着ぐるみで、木村祐一さんの声(ボイスチェンジャーで声音を変えている)に合わせて動き回ります。その様子を6台のカメラで収録し、45分番組として編集された映像を受けとった後、チコちゃんの頭部をCGに置き換えています」と、CGスーパーバイザーの林 伸彦氏は解説する。

番組の企画段階では全身をCGで表現することも検討されたが、早い時期に「着ぐるみが喋る」という今の方針が定められた。「現在の技術を使えば、リアルタイムにCGの頭部を生成し、モニタを介して出演者にチコちゃんが喋る姿を見せられるのでは?」というアイデアも出されたが、ヴァーチャルセット設備のあるスタジオを毎回使えるわけではなかった。加えて、チコちゃんの頭の一部分が、チコちゃんの手などによってカメラから隠れてしまった場合の処理も問題となった。「リアルタイムは無理があるだろう」との結論にいたったとCGディレクターの中野大亮氏は語る。以降では、そんな本作におけるCG制作の過程を詳しく紐解いていこう。

▲本作のCG制作に携わるNHKアートのスタッフ。左後列から、林 伸彦氏、平井暢哉氏、阿部 優氏、田中 智氏、大道琢磨氏、宮地 福太郎氏、鄭 有珉氏、吉村歩美氏、石井美奈氏、宮澤信寛氏、三上太一氏、小林大記氏、黄 振皓氏、野口智美氏、田中裕人氏、ワト・セサル氏、金 正煜氏、上田あい氏、チコちゃん、中野大亮氏、大井翔平氏、作田 葵氏

▲インタビューに答えるCGスーパーバイザーの林 伸彦氏【左】と、CGディレクターの中野大亮氏【右】

番組映像と頭部モデルだけでトラッキングを実現

2017年に放送された3回の特別番組では、中野氏をはじめとするNHKアートのスタッフがCG制作を担当し、徐々にデータやツールを拡充していった。「第3回からは3種類目の頭部モデルが追加され、さらにバリエーション豊かな表情を付けられるようになりました」(中野氏)。なおチコちゃんの頭部モデルは、着ぐるみの頭部を3Dスキャンしたデータを基につくられている。「3Dスキャンを活用したことで、着ぐるみからCGへ無理なく置き換えられたのに加え、トラッキングの精度も上がりました」(林氏)。

▲【左】上まぶたと下まぶたが別パーツに分離している頭部モデル/【右】上まぶたが周囲の皮膚と一体化している頭部モデル。この頭部モデルは、2017年12月放送の第3回の特別番組で追加された

▲『ボーッと生きてんじゃねえよ!』と叱るシーン用の頭部モデル。レギュラー放送開始後は、これら3種類の頭部モデルが使われている

レギュラー放送開始後のCGは3班体制でつくられており、1班の人数は約7人、1回あたりの制作期間は3週間ほど、カット数は平均200カット、尺は平均18分となっている。カット数と尺は、45分番組の中からチコちゃんが登場する部分のみを抜き出した場合の数値だ。「3班中2班はNHKアートのスタッフ、残る1班は外部の協力会社のスタッフで構成されています。これまでの放送分は、前半をヴォクセルさん、後半をCONTORNOさんにお願いしています」(林氏)。

▲【左】本作のCG制作に携わるヴォクセルのスタッフ。左後列から、島津義明氏、中島大志氏、木津慎吾氏、長野諒士氏、本田裕之氏、佐野友城氏/【右】同じくCONTORNOのスタッフ。左から、福島竜基氏、玉城涼太氏、萩原 有右斗氏、鍋田 涼氏、砂川 匠氏

レギュラー放送が軌道に乗ってからは、「にらめっこ」コーナーの変顔をはじめ、新たなバリエーション制作にも意欲的に取り組んでいるという。「最近はスタッフの作業スピードが上がってきたので、さらに番組を盛り上げるための新しい見せ方を試行錯誤しています」(中野氏)。

▲「にらめっこ」コーナー用の頭部モデル。本コーナーでは「にらめっこしましょ。あっぷっぷ」のかけ声に合わせ、趣向を凝らした新たな変顔が毎回披露される。「これらの変顔は、頭部モデルに表情を付けた後、新規のパーツを組み合わせることで表現しています。デザインから制作まで一貫してNHKアートが担当しており、毎回楽しみながらアイデアを練っています」(中野氏)

ワークフローはトラッキング、フェイシャルアニメーション、レンダリング、マスク処理、コンポジットの5工程からなり、カット単位に分けられたデータが工程間で受け渡されていく。

トラッキングでは、GeoTrackerというNuke C++ APIを使って開発されたプラグインが活用されている。GeoTrackerはTVドラマ『精霊の守り人』シリーズでも使われており、そこでの手応えを聞いた林氏が本作でも使ってみることにしたという。「GeoTrackerを使えば、番組映像と頭部モデルだけで高精度のトラッキングを実現できるとわかり、採用することにしました。映像からトラッキングできるため、頭部にもカメラにも特別なセンサーを必要とせず、収録現場にいっさい負担をかけない点が大きなメリットだと思います。収録現場にトラッキングの装置を入れることも検討しましたが、装置のエラーが起こったら打つ手がありません。GeoTrackerによるトラッキングが、最も不慮の事故が起こりにくい手段だろうと判断したわけです」(林氏)。

▲【左】番組収録時のチコちゃん。なお「素っぴんは本人NGです(笑)」とのこと/【右】収録現場の様子。6台のカメラで収録している

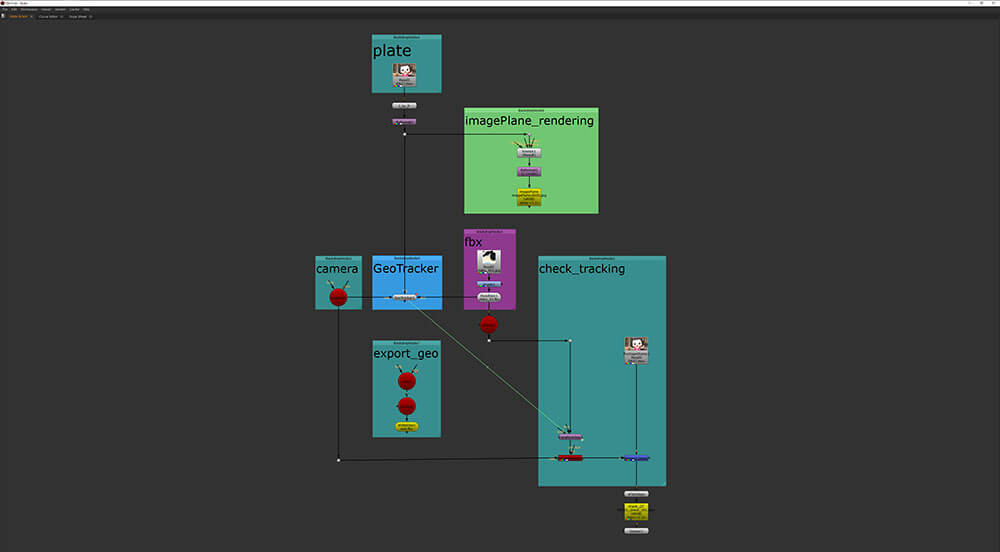

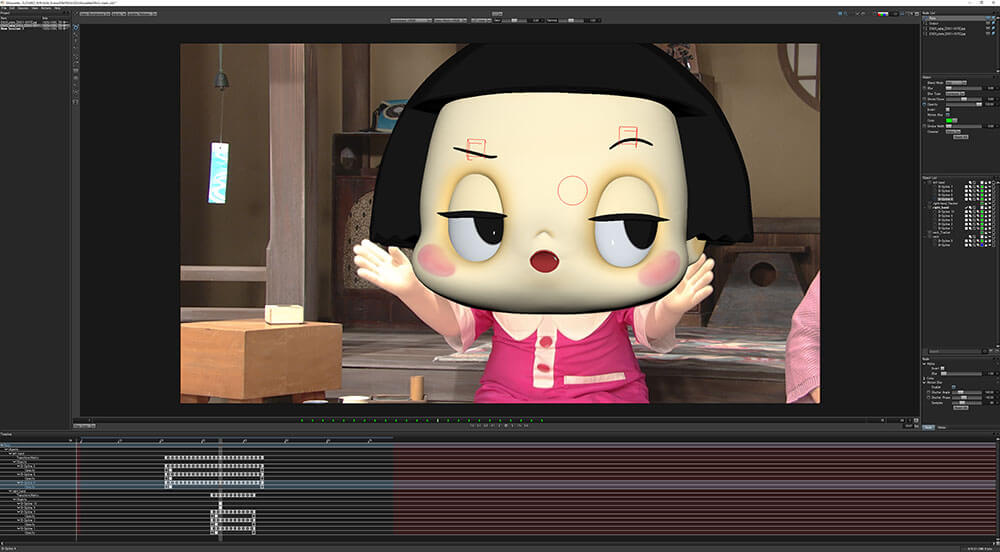

▲トラッキング中のNUKEの画面。番組収録時の着ぐるみの上に、3Dの頭部モデルを重ね、その動きを解析している。頭部モデルは着ぐるみの頭部を3Dスキャンしたデータが基になっているため、両者の形状にはほとんど差がなく、高精度のトラッキングが可能だ

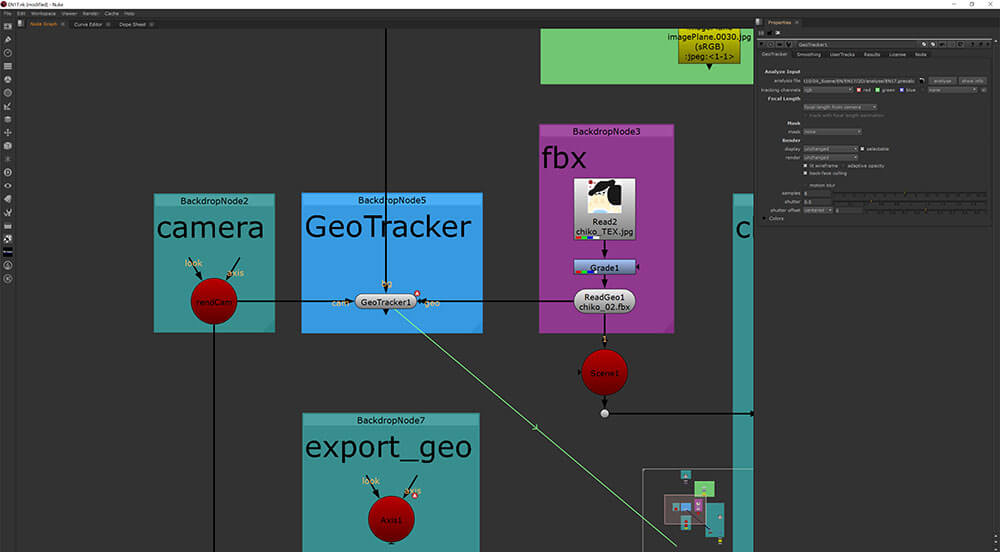

▲【左】NUKEのノードの全体像/【右】GeoTrackerのノード周辺の拡大。GeoTrackerは映像内の被写体の動きを解析し、そこに重ね合わせたジオメトリを動かすことでトラッキングを行う。完全な自動解析ではなく、人の手による位置合わせを必要とする場合はあるものの、自動化できる部分も多いため重宝していると中野氏は語る。なお、番組映像は位置やアングル、焦点距離などが異なる6台のカメラで収録されているため、スタッフが番組映像から各カットの焦点距離を推測し、進行管理表やGeoTrackerに入力しているという。トラッキング完了後は、ジオメトリ(頭部モデル)のFBXデータをMayaにインポートし、フェイシャルアニメーションを付けていく。「GeoTrackerを使うと、Z軸方向を向いて原点に固定されたカメラの前で、チコちゃんの頭部モデルだけが動き回るシーンデータが作成されます。当然、正確なライティングはできないわけですが、大きな違和感はなく、視聴者からは『目のハイライトがリアルだ』という声まで寄せられています。バラエティ番組の収録では顔が綺麗に映る明るいライティングがなされるため、それほど細かい調整を必要としないのだと思います」(中野氏)

[[SplitPage]]目線の配り方ひとつで、面白さが大きく変わる

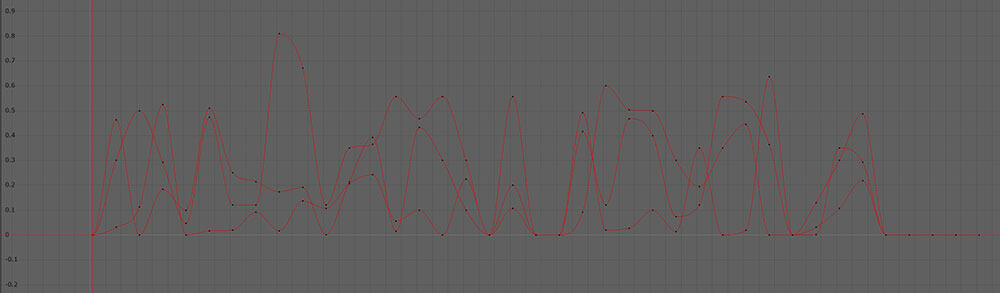

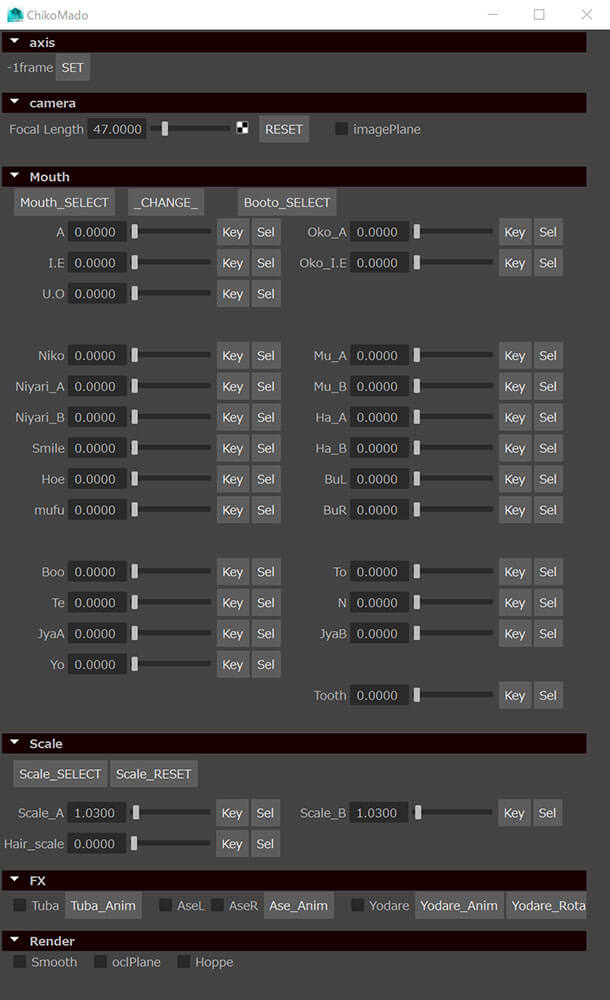

トラッキング後はFBXデータをMayaにインポートし、セリフに合わせたリップシンク、感情表現の順番でフェイシャルアニメーションを付けていく。第1回の特別番組では全カットのリップシンクを中野氏がひとりで手付けしたが、このままでは負担が大きすぎると判断し、社内のプログラマーにツール開発を依頼した。クルトンツールと名付けられた本ツールは、チコちゃんのセリフを解析し、リップシンクのキーフレームを自動生成する機能を有している。「クルトンツールはチコちゃんのセリフの中から『あ・い・う・え・お』の母音を抽出し、各母音に即した口の動きを付けます。人が手付けしたものに比べれば精度は低いですが、一定レベルのリップシンクは自動的に生成できるため、スタッフの負担は軽減されました」(林氏)。加えて、クルトンツールにはAIによる学習機能も搭載されており、使うほどに精度が上がっていくという。「クルトンツールが生成したキーフレームに対する僕やスタッフの修正結果を通して、徐々に本作ならではのキーの打ち方を学習させています」(中野氏)。

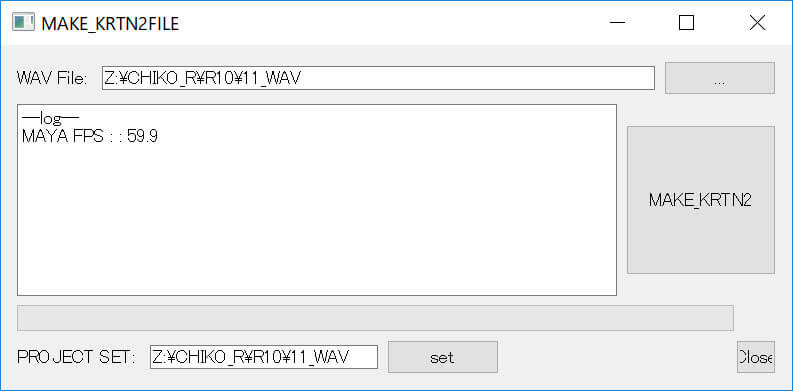

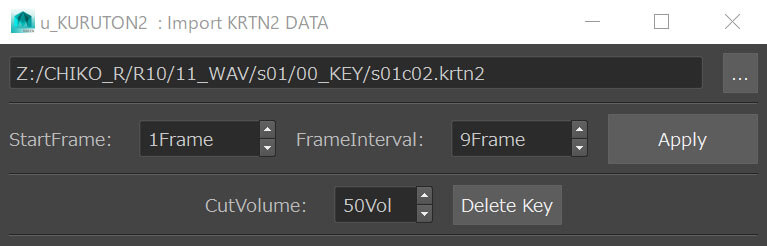

▲【左】クルトンツールの画面。WAV形式の音声データを入力すると、リップシンクのキーフレームが自動生成される/【右】クルトンツールが生成したキーフレームをMayaにインポートするためのウインドウ。何フレームおきにキーを打つのか、任意に選択できるようになっている

▲クルトンツールによって自動生成されたキーフレーム。「あ」「い・え」「う・お」の3種類のモーフターゲットに対して、9フレームおきにキーが打たれている

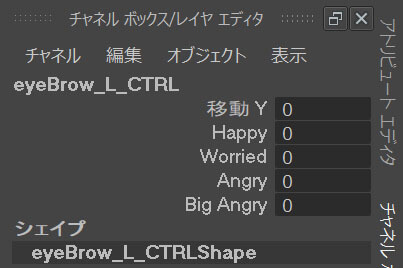

感情表現はチコちゃんというキャラクターのイメージを決定付ける重要な工程のため、初放送時からCG制作の舵取りを担ってきた中野氏と野口智美氏が担当している。「リップシンクもスタッフによって微妙にやり方がちがうため、野口と僕が修正し、統一感をもたせています。さらに眉毛、目、口の動きを細かく調整して様々な表情を付けていき、それが終わったらレンダリングを行います」(中野氏)。

本作にはチコちゃんが素朴なギモンを投げかけるスタジオコーナーに加え、チコちゃんと岡村隆史が会話をくり広げる縁側コーナーがある。後者はチコちゃんがほぼ出ずっぱりなのに加え、画面に大きく映るため、とりわけレンダリング時間を要するという。「縁側コーナーは会話劇なので、単純に喋っているだけでは面白くありません。だから表情や間の取り方をすごく大事にしています」(中野氏)。本作は全編を通して絵コンテなどの指示書がないため、チコちゃんの表情の多くはNHKアートに委ねられている。「番組演出の方々も思い入れがあるので、様々なアドバイスをくださいます。ただ、われわれのセンスもすごく問われており、目線の配り方ひとつで面白さが大きく変わります。感情表現は特に大事にしている工程だと言えますね」(中野氏)。もともと中野氏はバラエティ番組が大好きで、岡村隆史の出演番組も数多く見ているため、お笑いにまつわる豊富な引き出しをもっている。それが今の仕事に大きく役立っており、「まさに適任」と林氏は太鼓判を押す。

▲【左】視線、目の瞳孔の大きさ、上まぶた、下まぶたなどを調整するチャネル ボックス/【右】眉の位置や形を調整するチャネル ボックス

▲「あ」のモーフターゲットの操作結果

▲【左】「い・え」のモーフターゲットの操作結果/【右】「う・お」のモーフターゲットの操作結果。母音は本来5種類あるが、チコちゃんはデフォルメキャラクターのため、3種類に簡略化されている

▲母音以外にも「ニヤリ」「怒る」「焦る」「うふ」など、様々な表情のモーフターゲットが用意されている

▲「眠い」のモーフターゲットを操作すると、口からヨダレが出るようにもなっている

▲【左】画面中央のNullオブジェクトを使い、視線を調整している/【右】眉の位置や形を調整している

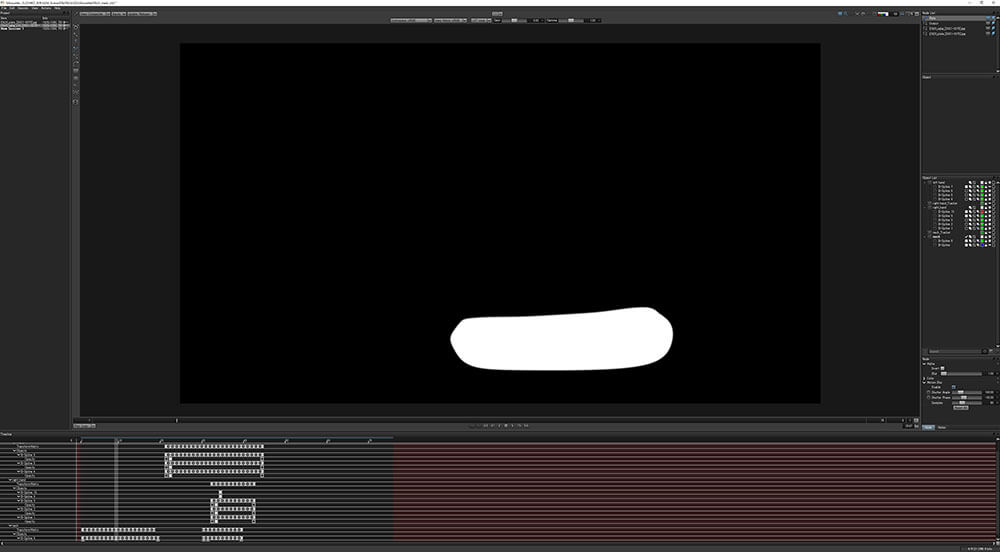

インターレースに対応するため、59.94fpsでマスク処理を行う

マスクはsilhouetteで作成し、そのトラッキングにはMochaを使っている。silhouetteはマスク作成専用ソフトで、ある程度の自動生成が可能なため作業を効率化できたという。「最初の1フレーム目のマスクを設定すれば、それ以降のマスクは自動生成されます。とはいえチコちゃんが大きく動いたりすると破綻するため、その都度修正していきます」(中野氏)。

▲チコちゃんの頭部モデルは着ぐるみの頭部よりひとまわり大きく設定されているため、頭部モデルから着ぐるみの頭部がはみ出すことはない。ただし肩の上端が隠れてしまったり、頭部モデルの底や穴が見えたりといった問題が発生するため、多くのカットでマスク処理が必要となる。【左】番組映像をsilhouetteに表示し、マスクを作成している/【右】マスク

▲【左】マスク適用前/【右】マスク適用後(紫色の領域がマスク適用範囲)

▲同じくマスク適用後

▲チコちゃんの手が頭部モデルの前にくる場合にもマスク処理が必要となる。silhouetteのマスクはスプライン曲線で作成するため変形が容易なのに加え、モーションブラーも適用できる。【左】マスク適用前/【右】マスク適用後

▲【左】モーションブラー適用前のマスク(紫色の領域がマスク適用範囲)/【右】モーションブラー適用後のマスク

▲前述のマスク(モーションブラー有り)適用後

コンポジットはAfter Effectsを使っており、あらかじめ作成してあるスタジオコーナーと縁側コーナーのベースコンポに各カットの素材を適用すれば、基本的な画づくりは完了する。「コーナーや収録条件によってライティングと色味は微妙に変わりますが、Mayaの設定は変えておらず、調整はAfter Effectsで行なっています。レギュラー番組の放送ペースに合わせるためには、わりきって可能な範囲で簡略化することも必要だと考えています」(林氏)。

▲基本的にチコちゃんの体に落ちる影は収録時のものがそのまま使われているが、しばらくの間、手が頭部の前にある場合には、コンポジット段階で擬似的な影が落とされる。【左】影を落とす前/【右】影を落とした後

▲影を落とした後の全身。手のマスクを使い、After Effects上でドロップシャドウによる影を落としている

なおトラッキングにNUKE、コンポジットにAfter Effectsを使った大きな要因は、本作の番組映像が60iのインターレースで収録されていたことだという。「トラッキングと同様、コンポジットもNUKEでやれないか検討したのですが、NUKEはインターレース映像のコンポジットに向いていないため、After Effectsを選択しました」(林氏)。「実は、一番苦労したのがインターレースへの対応でした。TVのバラエティ番組の場合、昔も今もインターレースが主流です。プログレッシブにできないか収録スタッフに相談してはみましたが、スタジオにはインターレースのカメラしかなく、視聴者が見慣れている映像でもあるので、インターレースに対応してほしいと言われました」(中野氏)。そのため本作は30fpsでトラッキングし、60fpsでアニメーション、59.94fpsでマスク処理を行い、コンポジット段階でインターレースに変換するという作業を経て制作されている。「フレーム数が倍になれば作業負担も倍になるので、できれば29.97fpsで作業を進めたかったのですが、29.97fpsでマスク処理をすると速い動きのカットでは走査線によるちらつきが出てしまうことがわかり、59.94fpsを選択しました」(中野氏)。

本作は以上の工程を経て制作されているわけだが、いずれはリアルタイムにも対応したいと両氏は語る。「ぜひ、チコちゃんを生放送番組に出演させたいです」(中野氏)。「それを実現するにはどんな技術革新が必要なのか、常に考えています」(林氏)。3回の特別番組を経て、レギュラー番組への対応を成し遂げたNHKアートは、すでに次の目標を定めているようだ。チコちゃんの今後の進化にも大いに期待したい。