Unreal Engineの用途として、日本でも関心を高めているのがバーチャルプロダクションだ。映画VFXを中心に手がけるNEWPOT PICTURESが音頭をとって実現した、LEDウォールを用いたバーチャルプロダクションの技術検証を紹介する。

TEXT_安田俊亮 / Syunsuke Yasuda

EDIT_沼倉有人 / Arihito Numakura(CGWORLD)、山田桃子 / Momoko Yamada

PHOTO_弘田 充 / Mitsuru Hirota

少規模VFXスタジオでも実現できる手法を模索

『スター・ウォーズ』シリーズの実写ドラマ『マンダロリアン』の撮影に採用されたことで一気に知名度を上げたバーチャルプロダクション(以下、VP)。グリーンバック撮影に代わる新たな撮影手法として注目されているものの、LEDウォールを用いたVPを実現するにはコスト面でも技術面でも多くのハードルが存在する。しかし、VPのメリットに着目し、より現場に即したかたちでの撮影環境をゼロからつくろうとしているVFXスタジオがある。それがNEWPOT PICTURESだ。

右から、VFXスーパーバイザー 藤原源人氏、システム・アドミニストレーター 山﨑桂一氏(以上、NEWPOT PICTURES)、ビジネスソリューション事業部 事業部長 河村英之氏、ビジネスソリューション事業部 メディアインテリジェンス課 担当課長 小野智史氏(以上、エヌジーシー)

newpotpictures.com www.ngc.co.jp/thewall

左から、CGディレクター 大山俊輔氏、メインプログラマー 片渕孝一氏。以上、ランハンシャ

run-hun.co.jp

「VPのメリットは大きく2つあります」とNEWPOT PICTURES代表取締役/VFXスーパーバイザーの藤原源人氏は話す。ひとつは、「"今どんな世界でどんな撮影が行われているか"が一目瞭然でわかること」。役者はその世界を感じながら演じられるし、撮影側も何を撮っているかが見た目でわかる。現場でイメージの共有が確実にできるので、その分撮影はスムーズに進む。

もうひとつは、「ポスプロの軽減」だ。背景のLEDには照明効果もあるため、例えばクルマのボンネットへの映り込みなどは撮影したものがそのまま使える。ハネた髪の毛のような繊細な部分も切り抜かれずに済むので、映像として嘘くさくならない。「後からやり直したり付け足したりする作業が減り、説得力も増します。現場には、大きな効果があるはずです」(藤原氏)。

そこでNEWPOT PICTURESでは、外部パートナーとの協業によるVPチームを発足し、サービス提供の事業化に向けて動き出した。取材した日は、1枚のLEDパネルを用いて映像の出力状況を確認する「最初のステップ」の技術検証が行われていた。用いられたLEDパネルは、サムスン電子製の「The Wall」。ポイントは、The Wallのピッチ(LEDチップ間の距離)が1.68mmであることだ。『マンダロリアン』で使用されたLEDウォールのピッチが2.84mmだったことから、「ピッチの細かいものなら良いのでは」という考えの下、The Wallの日本流通を担うエヌジーシーに連絡をとり、エヌジーシー側もこれを快諾。さっそく、同社のショールームで検証が実現することとなった。

トラッキングシステムは、市販のVRヘッドセット「VIVE Pro」のものを用いている。1台のPC、1枚のLEDパネル、そしてVRシステムの応用とあくまで「最小単位での検証」となったが、結果は「満足するものが出力できた」と藤原氏。NEWPOT PICTURES システムアドミニストレーターの山﨑桂一氏も「多少LEDのドットが見えるアングルもあったが、基本的にはピッチが綺麗に出ていた。ソフトウェアも意図通り動作してくれて、小規模でもVPが導入できると実感できました」と手応えを語った。

まずはVP実現の第一歩となったが、次のステップでは「監督や撮影監督、照明監督、制作部など、実写映画の現場スタッフの方々の意見を聞いていきたい」という。「今回も照明の調整など、現場の声がほしいなと思う場面がいくつもありました。現場の声を取り入れて、要望に合わせて環境を構築していくことで、より実際の制作現場に導入されやすくなるはずです。"映像VFXのバーチャルプロダクションならNEWPOT PICTURES"と認識していただけるように、今後も検証を重ねていきたいと思います」(藤原氏)。バーチャルプロダクションにおいても確かな存在感を放つUnreal Engineそのものの発展に、よりいっそう注目だ。

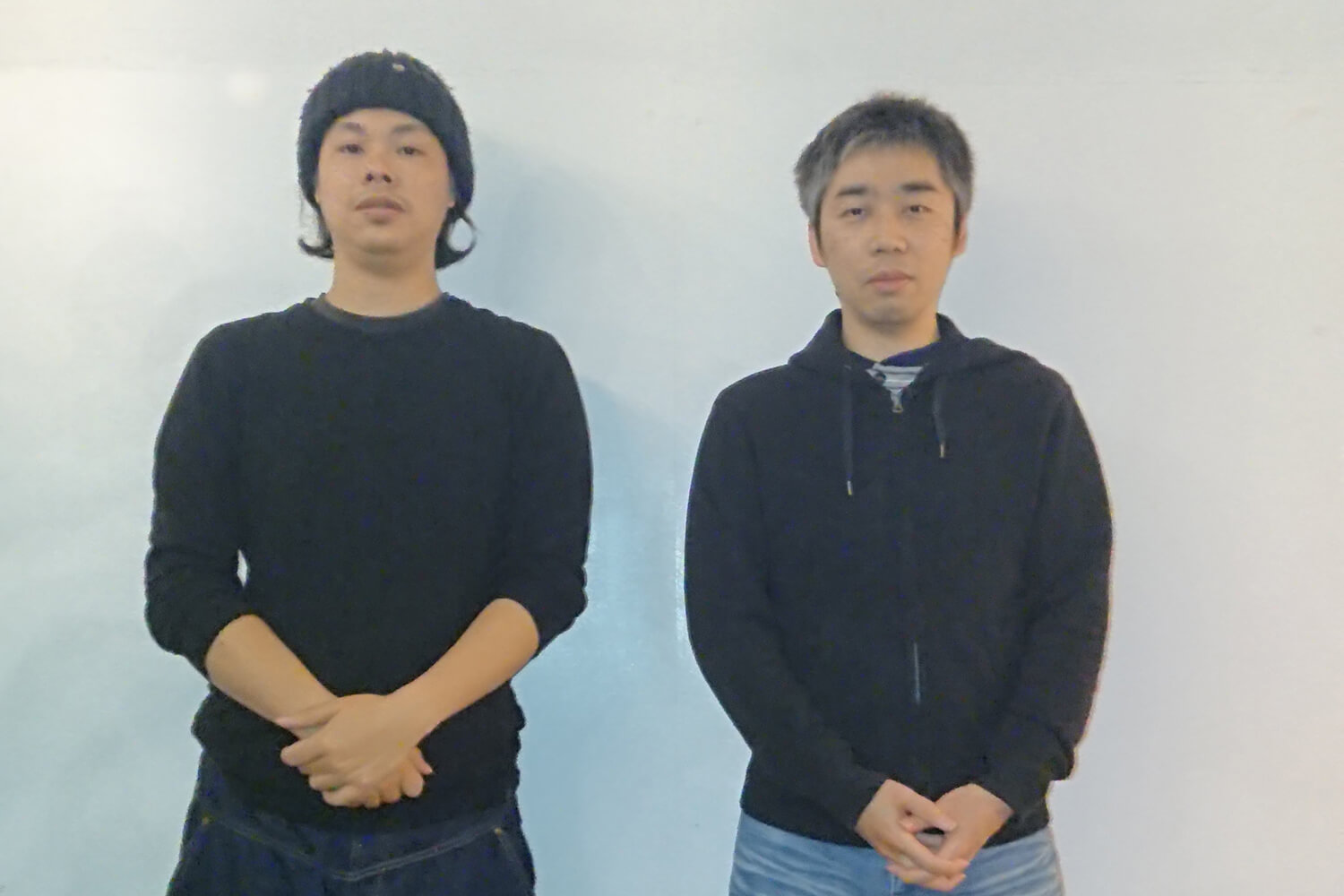

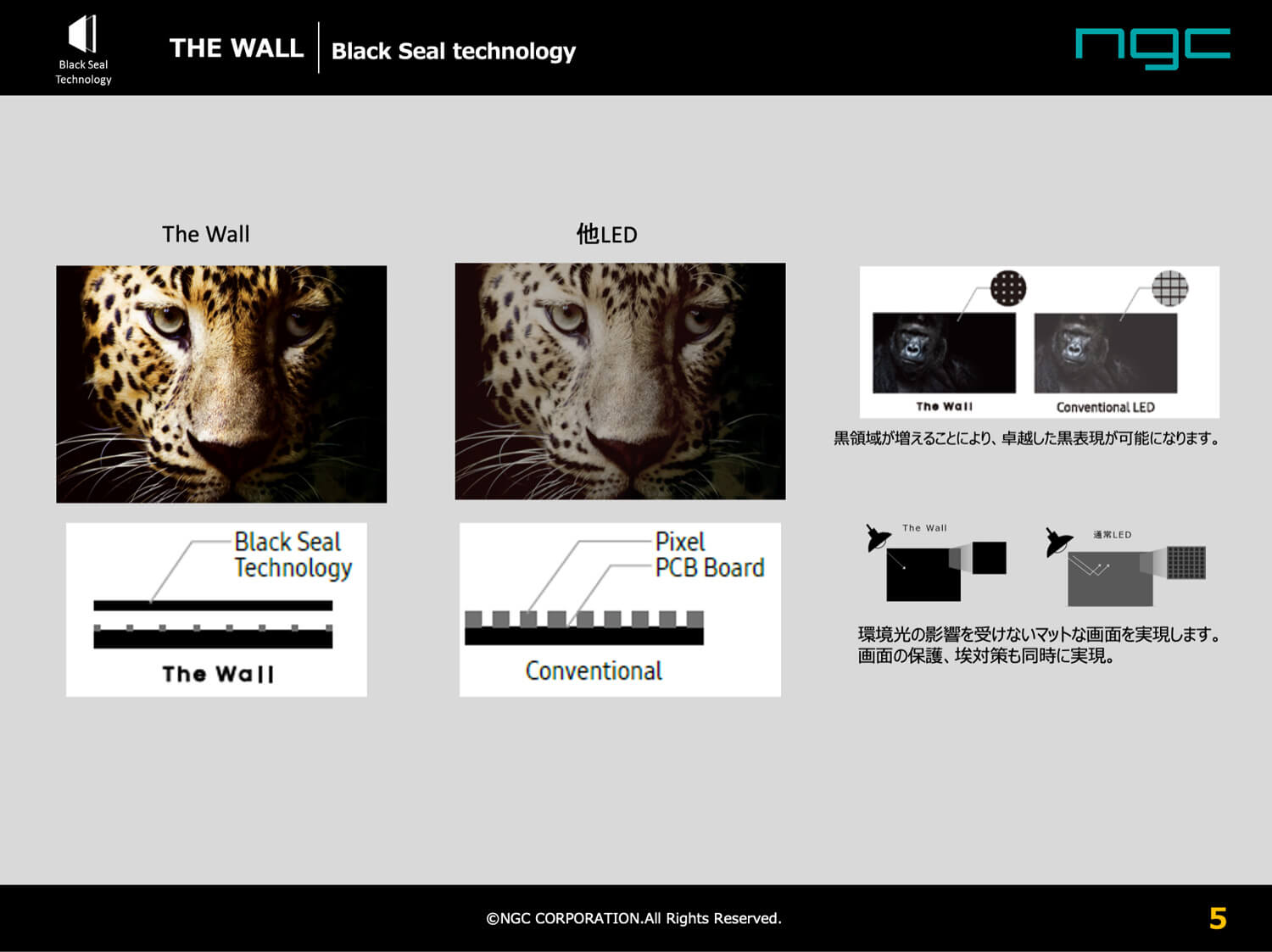

今回の検証に用いたLEDディスプレイ「The Wall」

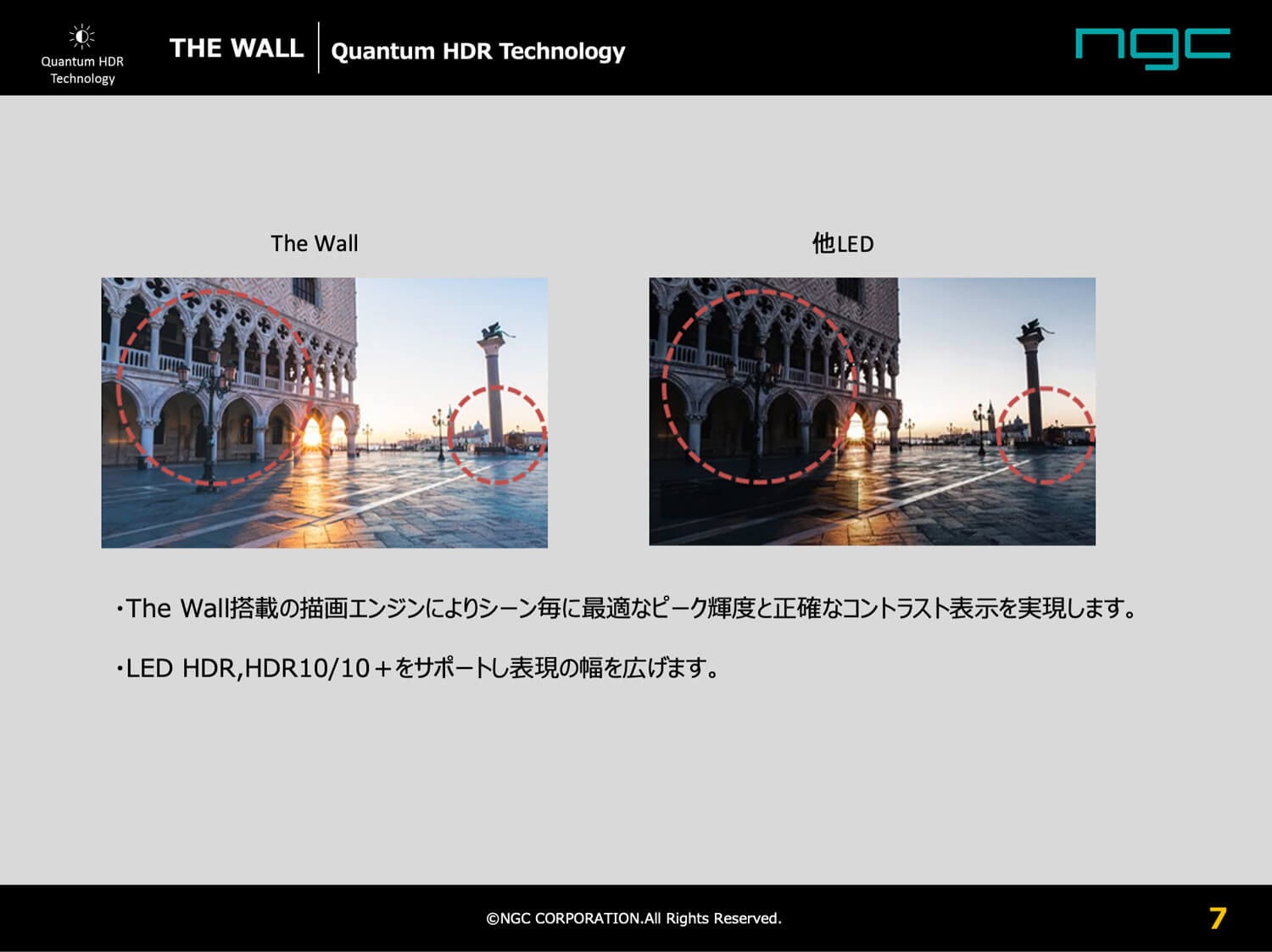

サムソン電子製の高精細LEDディスプレイ。「Perfect Black」「Pure Color」「Quantum HDR Technology」という3つの特徴を有しており、従来のLEDに比べ、大幅に表現力を高めている

▲「Perfect Black」の特性を解説した図(提供:エヌジーシー)

▲「Quantum HDR Technology」の特性を解説した図(提供:エヌジーシー)

▲「Pure Color」の特性を解説した図(提供:エヌジーシー)

"フレキシブルに実現できる"に絞って、システムを構築

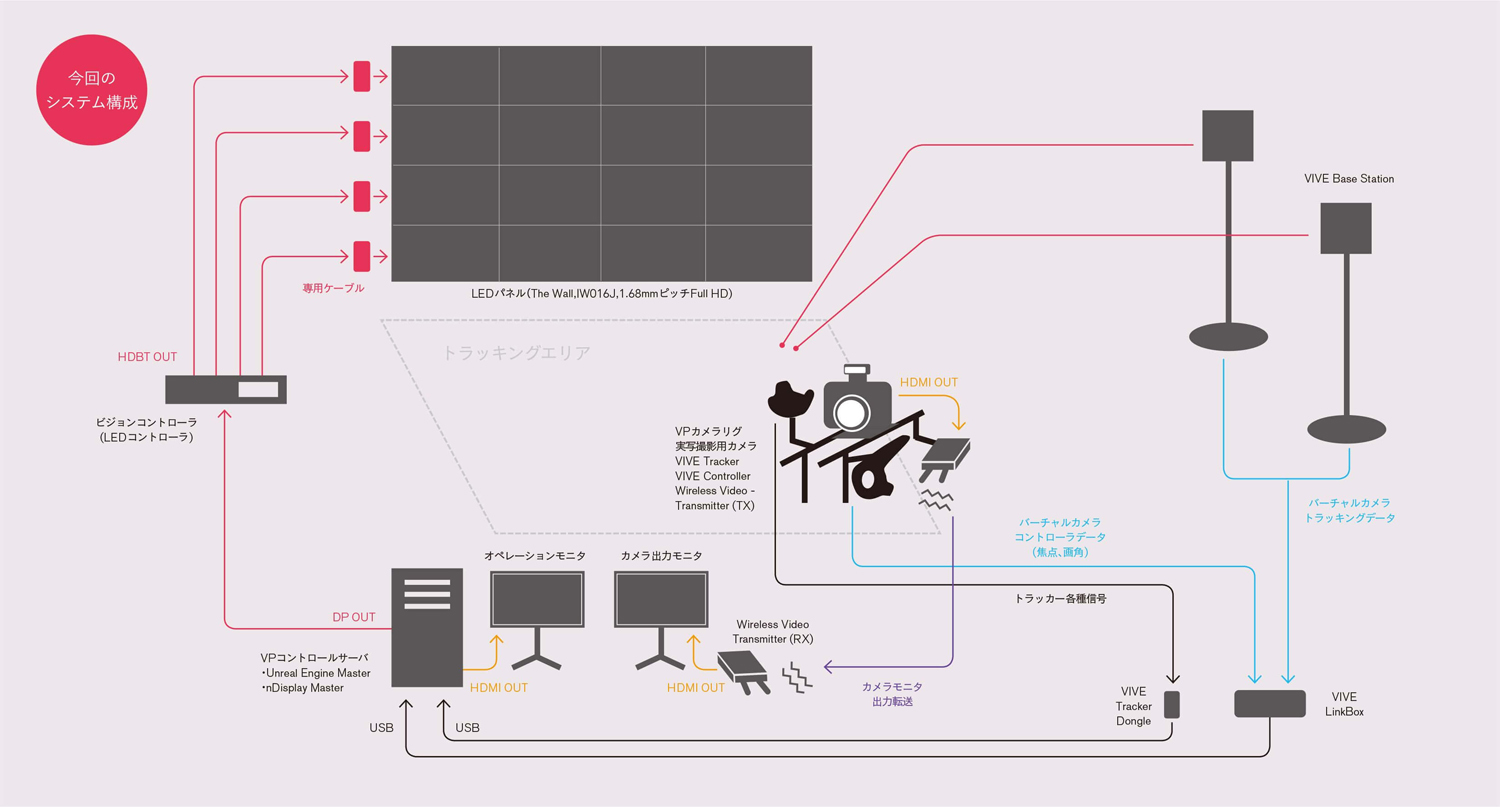

▲今回のバーチャルプロダクションのシステム構成を図示したもの

"バーチャルロケハン"など新たな可能性も模索

今回の技術検証におけるシステム構成は、バーチャルプロダクションの「LEDウォールへの出力」と「必要十分なスペック」の2点がポイントとなった。マスターサーバとしてCPUにインテルのXeon E5-2687W v3を2基、GPUはNVIDIA Quadro RTX6000、メモリは64GBを搭載したマシンを1台用意。Unreal Engine 4(以下、UE)でシーンを作成し、The Wallに出力している。

The Wallには現在、3製品がラインナップされているが、今回は前述の通り1.68mmピッチのパネルを使用。サイズは幅約3.2m×高さ約1.8mで、解像度は1,920×1,080だ。The Wallではさらにピッチが細かい0.84mm、0.86mm、1.22mm、1.26mmもラインナップされているが、検証実験上では1.68mmのピッチでも藤原氏は「十分満足」な結果が得られたとしている。

VIVE Proのトラッキングシステムは、開発する上でもUEと相性が良いことから選ばれた。主に使用しているのは、4つのVRベースステーション(位置測定用アクセサリ)とVIVEトラッカー(被測定物)。VRベースステーションは部屋の四隅に配置し、VIVEトラッカーは撮影用のカメラに装着している。カメラの動きをUEで読み取りながら、出力映像に反映させて撮影アングルとの整合性をとる。カメラの動きに合わせて映像が変化していくような仕掛けで、撮影された映像では背景がパネルだとは思えないような奥行きが感じられる。このしくみこそが、バーチャルプロダクションの肝だ。

藤原氏は"小規模のバーチャルプロダクション"について、本番の撮影に使う以外にも「ロケハンなどにも使える」ことに可能性を感じている。NEWPOT PICTURESが所有するレーザースキャナでロケ地をキャプチャし、UE上で再現すればわざわざ現場に戻らなくてもバーチャルなロケハンが可能になる。UE上で照明なども変えられるし、ニュアンスを検討するには十分な手応えを感じられるはず。検証が進めば、このアイデアはさらに具体化されていくだろう。「ただ、1枚のパネルでは照明の代わりにはならないと今回の検証でわかりました。さらに今後、より高解像度で出力する場合は、マシンリソースの見積もりを改めて行う必要がありそうです。こうした点も今後の課題となっています」(山﨑氏)。

▲UEを制御するPC。主なスペックは下記の通り

製品名:Dell Precision T7910

OS:Windows10 Pro

CPU:Intel Xeon Xeon E5-2687W v3×2(Dual)

Memory:64GB (DDR4-2133 16GB×4)

Storage:2.5inch SATA SSD 500GB×2(ArrayController RAID0)

Graphic:NVIDIA Quadro RTX6000

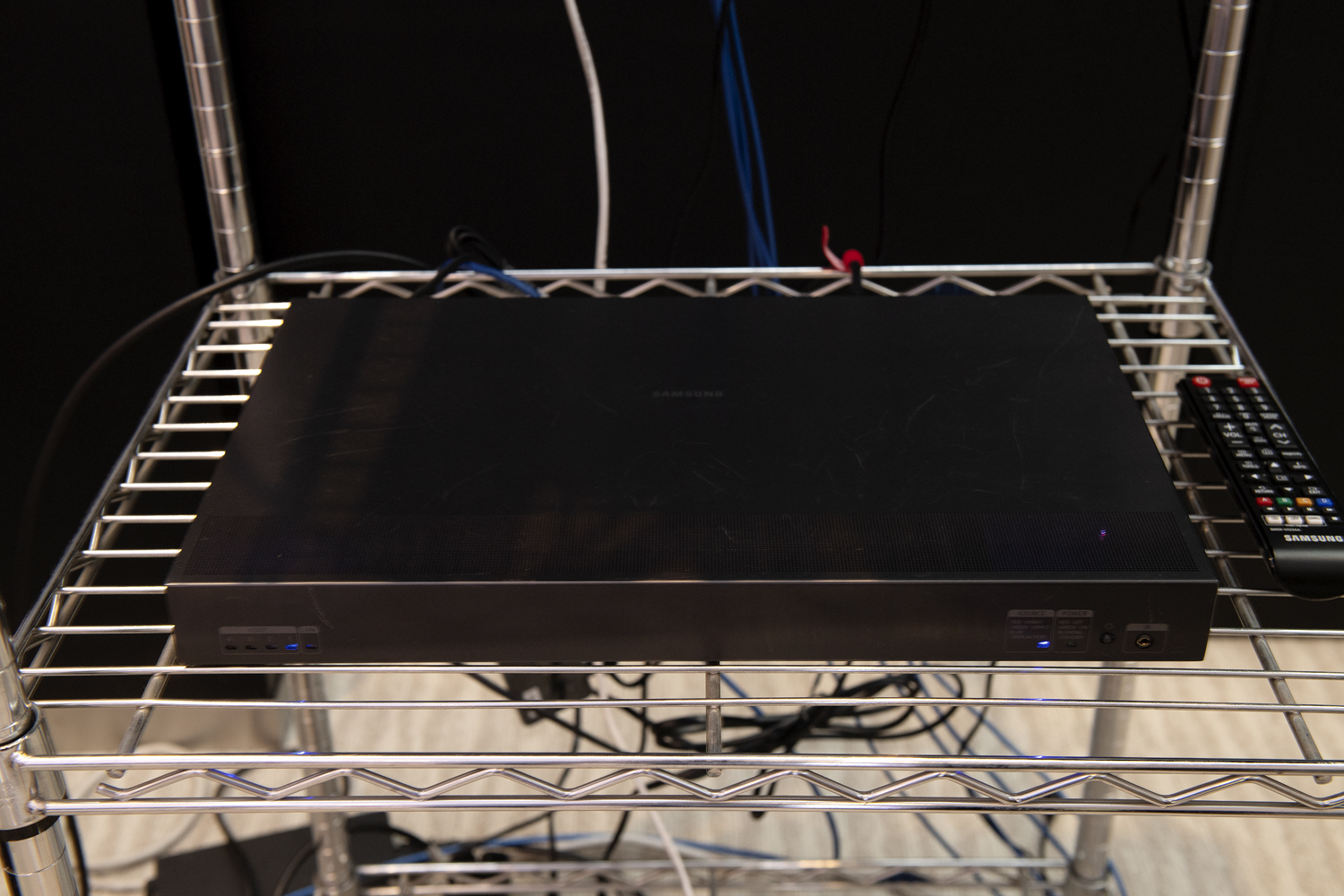

▲The Wallシリーズ向けLEDビジョンコントローラ「S-BOX」。PCからDisplayPort 1.2a信号をHDMI 2.0ケーブル×2でインプットする

▲今回の出力表示は、LEDピッチサイズ1.68mmのタイプの「The Wall 1.68mm」を使用。主なスペックは下記の通り

型番:IW016J

LED種類:Micro LED

LEDピッチサイズ:1.68mm

輝度(Peak/Max):1400nit / 1000nit

1Cabinetごとの解像度:480×270 Pixcels

"バーチャルスカウティング"など、新たな可能性も模索

NEWPOT PICTURESがを近い将来の目標に掲げている「バーチャルロケハン」。現実のロケーションのリアリティキャプチャを行い、UE上で環境を再現。そのビジュアルをLEDウォールに出力したり、VRコンテンツ化することで、バーチャルなロケハンを実施するというものだ

▲メッシュ化したモデルをUEに読み込んで、光のシミュレートを行なった例

[[SplitPage]]<2>次なる目標は、多画面出力!

UEを積極的に導入しているランハンシャとの協業

今回の検証において、トラッキングと映像出力を組み合わせたUEのシステムは、CGプロダクションのランハンシャが制作した。NEWPOT PICTURESの藤原氏から依頼を受け、CGディレクターの大山俊輔氏とメインプログラマーの片渕孝一氏が中心となり、本プロジェクトに参加している。

大山氏はUEを5年以上愛用していて、以前からVPに可能性を感じていた。一方の片渕氏は「正直、最初はピンときていなかった」そうだが、内容を知るうちにVPの面白みを知り、手探りながら楽しんで開発を進めている。

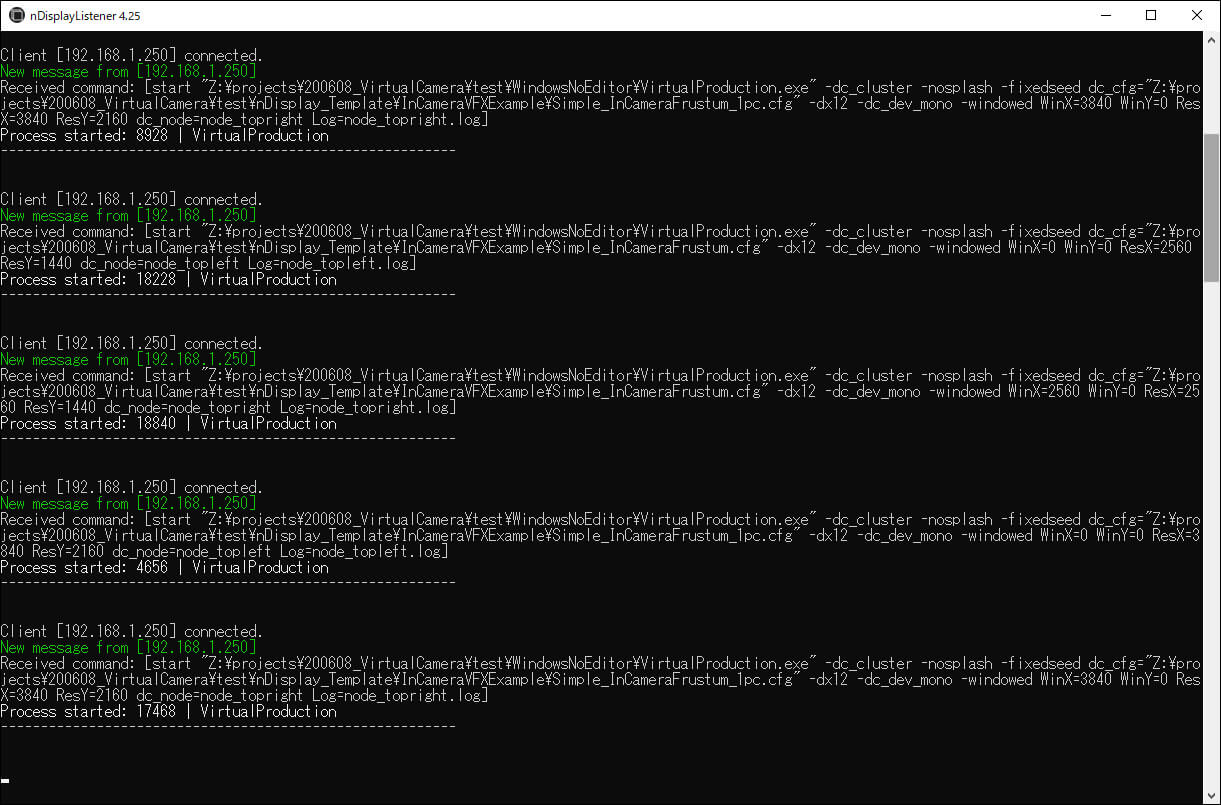

検証の第1ステップは結果上々といったところだが、本命は次の「多面でLEDパネルに出力するステップ」だと大山氏は語る。構想しているのは、背面と左右、そして天井の4面だ。今回の検証では背面1枚のみへの出力となったため使用するマシンは1台だったが、4面への出力ではマシン2台を使い、それぞれ2面ずつ出力することとなる。UEには複数のマシン、複数の出力先でリアルタイムに同期が取れるnDisplayという機能があり、さらにGPUのNVIDIA Quadro同士を同期させられるオプションボード「Quadro Sync 2」を利用することで、4面(1面あたり2.5K解像度で出力)の完全同期を実現する。

すでに27型のPCディスプレイ4台に対する多画面出力は検証済みだが、その段階でも大山氏は「早くLEDパネル4面で検証したい」と感じたという。特に視界が覆われることで、「その世界への没入感」が強くある。「モニタだけで見ていても迫力がすごい。バーチャルプロダクションによる撮影以外にも、舞台やライブで多面のLEDパネルを利用するケースが増えていくのではないでしょうか」(大山氏)。

VPはその特性上、事前に映像の具体的なイメージを描けているかどうかが重要だ。プランが明確であればあるほど、UEがもたらす効果はより大きくなっていく。「UEは映像を見ながらコンポジットを確認できるので、今でも監督から『Unreal Engine良いね』とよく言われます。今後VPがより盛んになってきて、UEと映像業界は今後ますます接近していくと思います」(大山氏)。

nDisplayでビデオウォールを実現

UEバージョン4.20で追加された「nDisplay」(docs.unrealengine.com/ja/Engine/Rendering/nDisplay/index.html)を用いれば、Unreal Engineプロジェクトを複数のディスプレイで同期してレンダリングできる

▲ランチャー。起動するプロジェクトや設定ファイルを選択してnDisplayを起動

▲リスナー。nDisplayでレンダリングする各PCに起動しておく

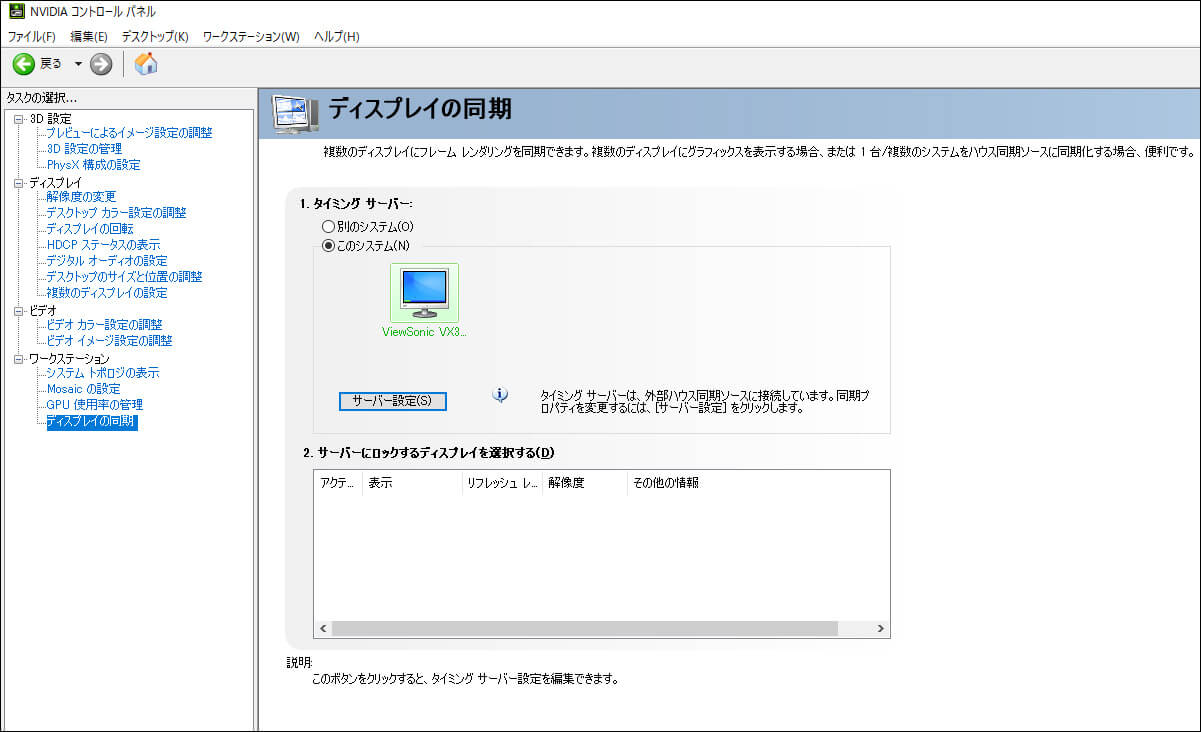

GenLockによる複数画面の同期

GenLockの同期には、ブラックマジックデザイン「Mini Converter Sync Generator」を使用

▲NVIDIA コントロールパネル上での同期状況の確認例

▲同マスターPCの同期設定

モニタ4台による、nDisplayの同期検証

ランハンシャによる、PC2台(マスター×1、スレーブ×1)とモニタ4台を用いた同期検証時の様子。グラフィックスボードはQuadro RTX 4000が用いられた

▲同期成功例

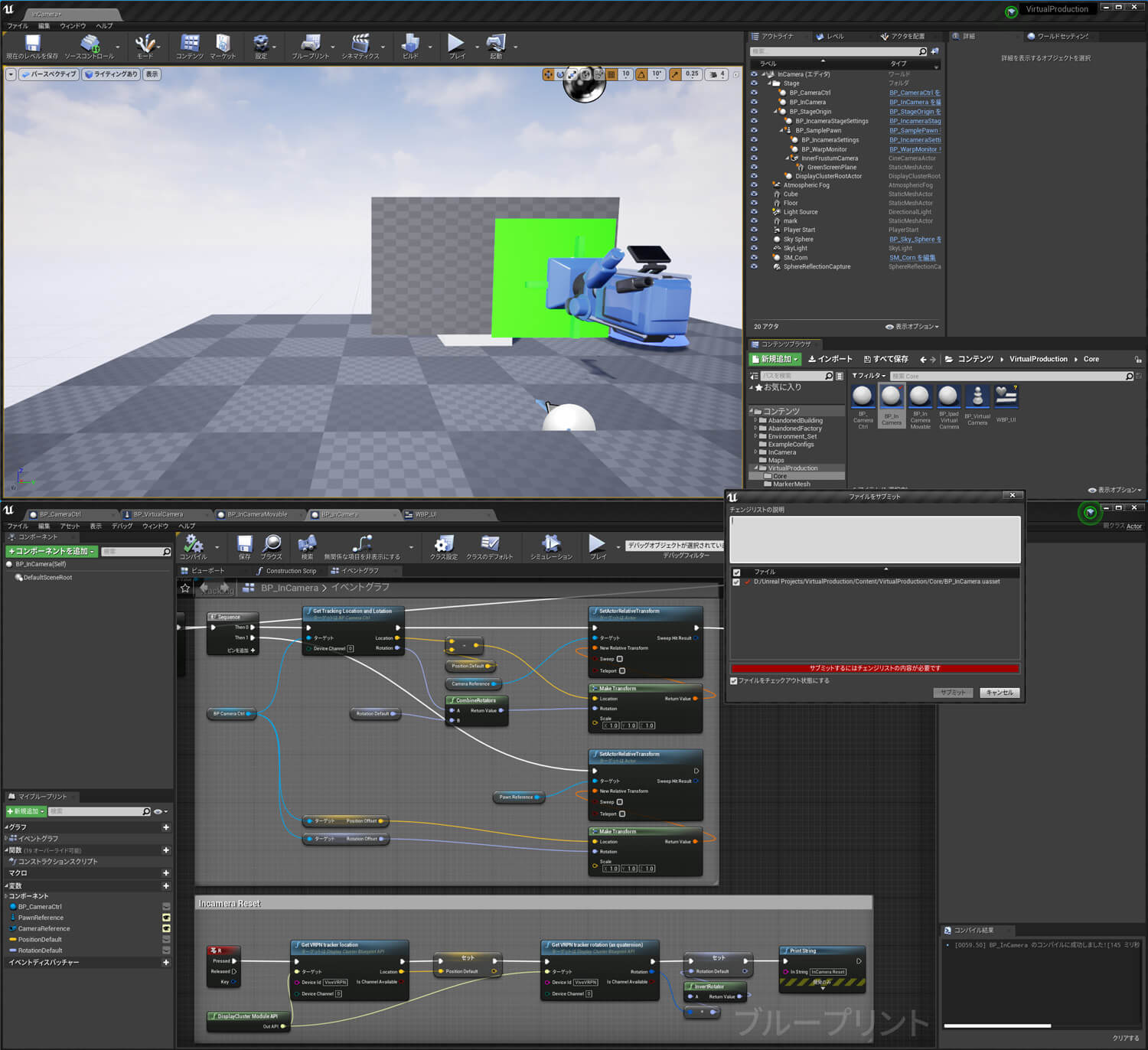

Unreal Engineの利点

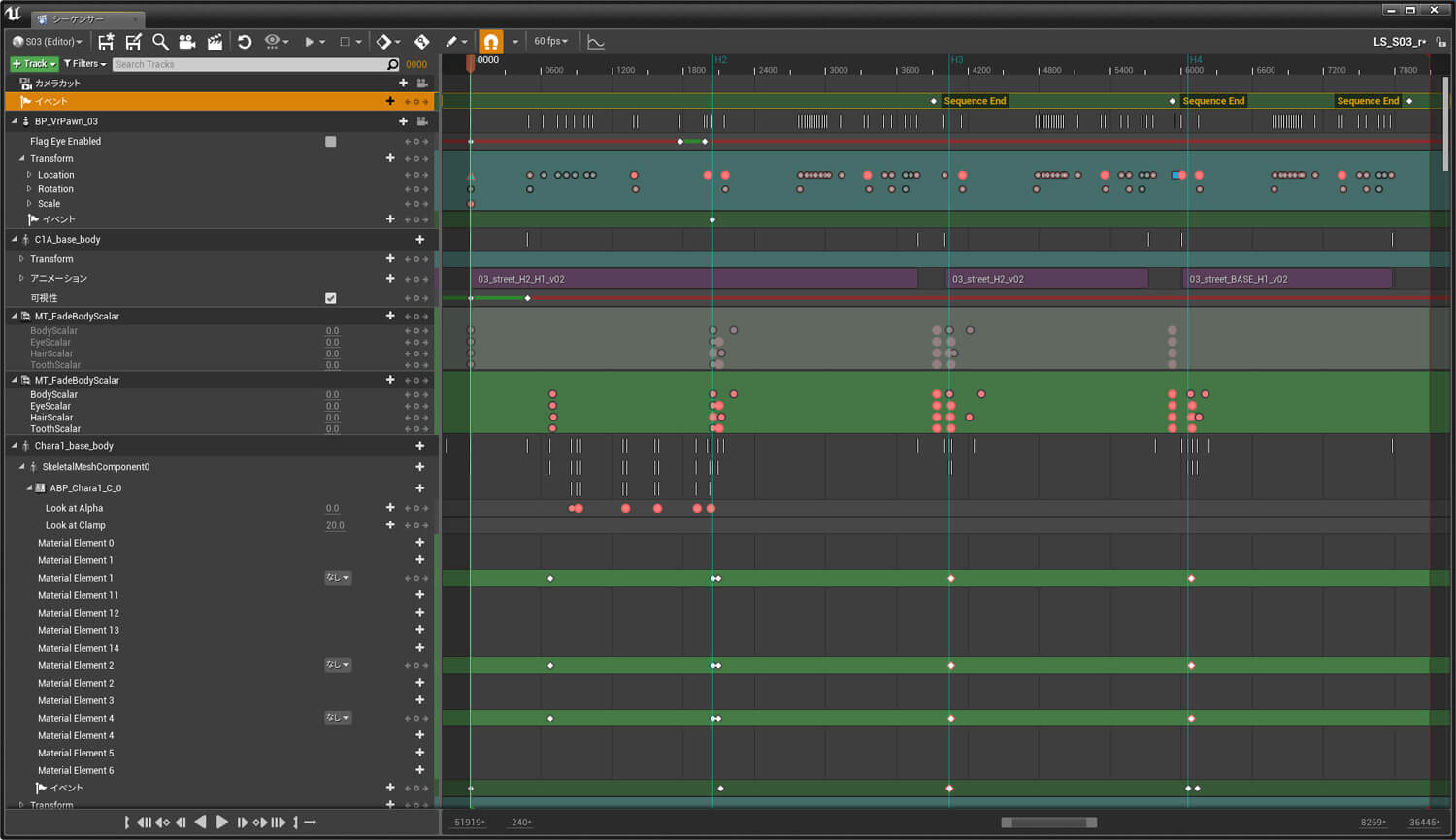

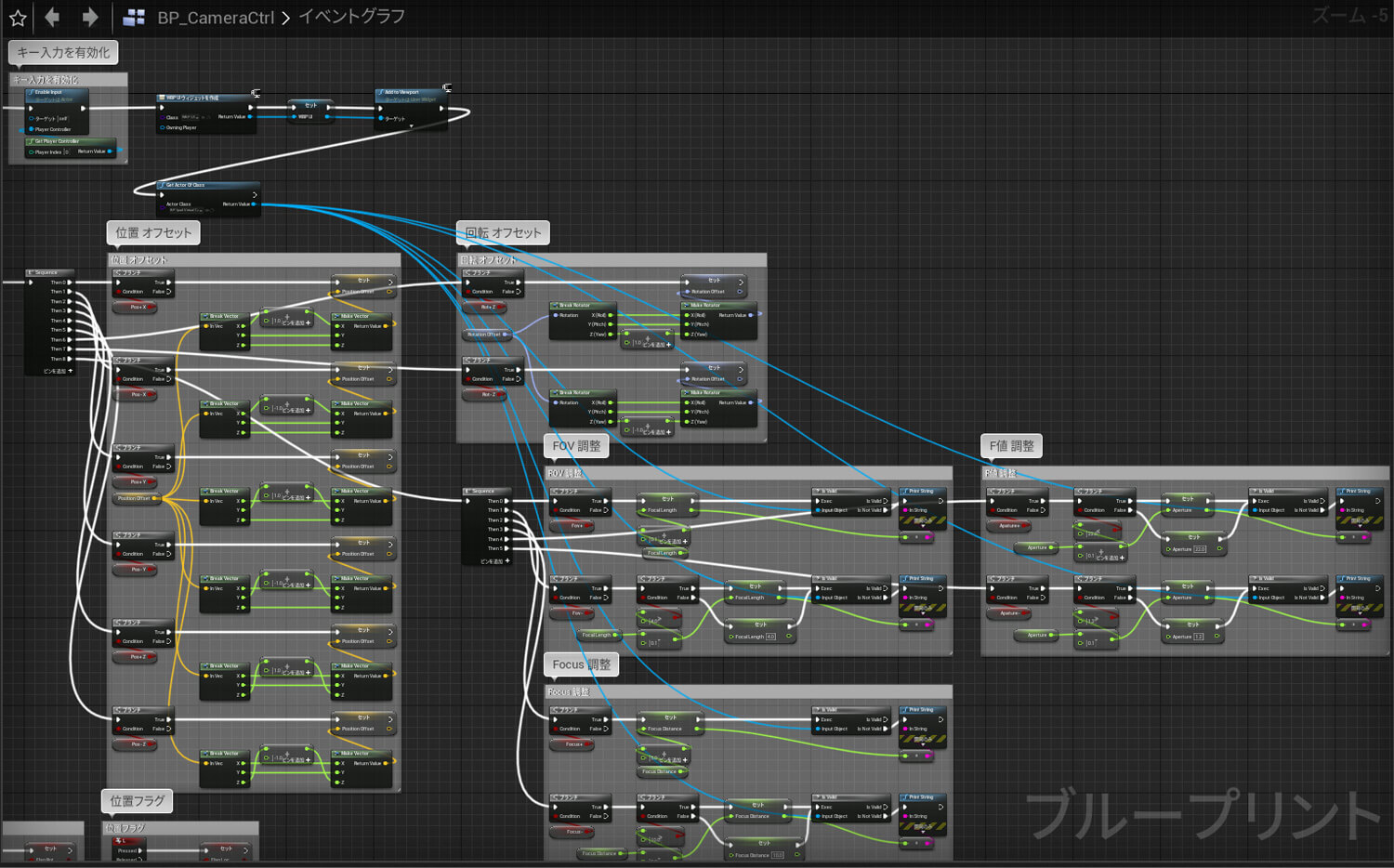

ランハンシャでは、大山氏の合流を機にUEの活用が広がっている。大山氏は、具体的な利点として「シーケンサー」(UEのマルチトラックエディタ)を挙げてくれた

-

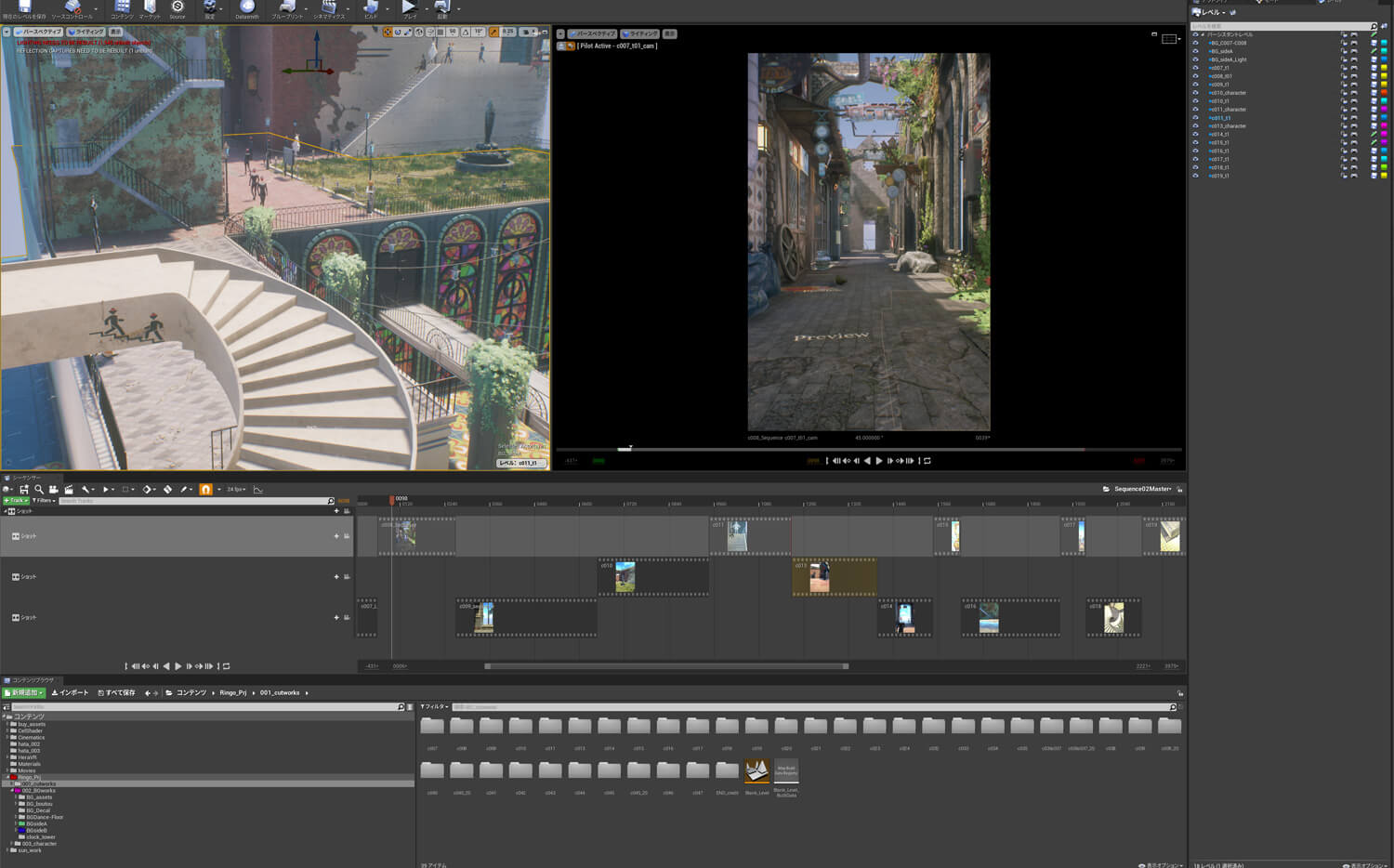

▲シーケンサーのUI。変数の制御、カメラアニメーション、キャラのマテリアル制御、ルックアット制御などを行なっている。また、イベントからシーケンサーのBlueprints(ブループリント)を呼び出している

-

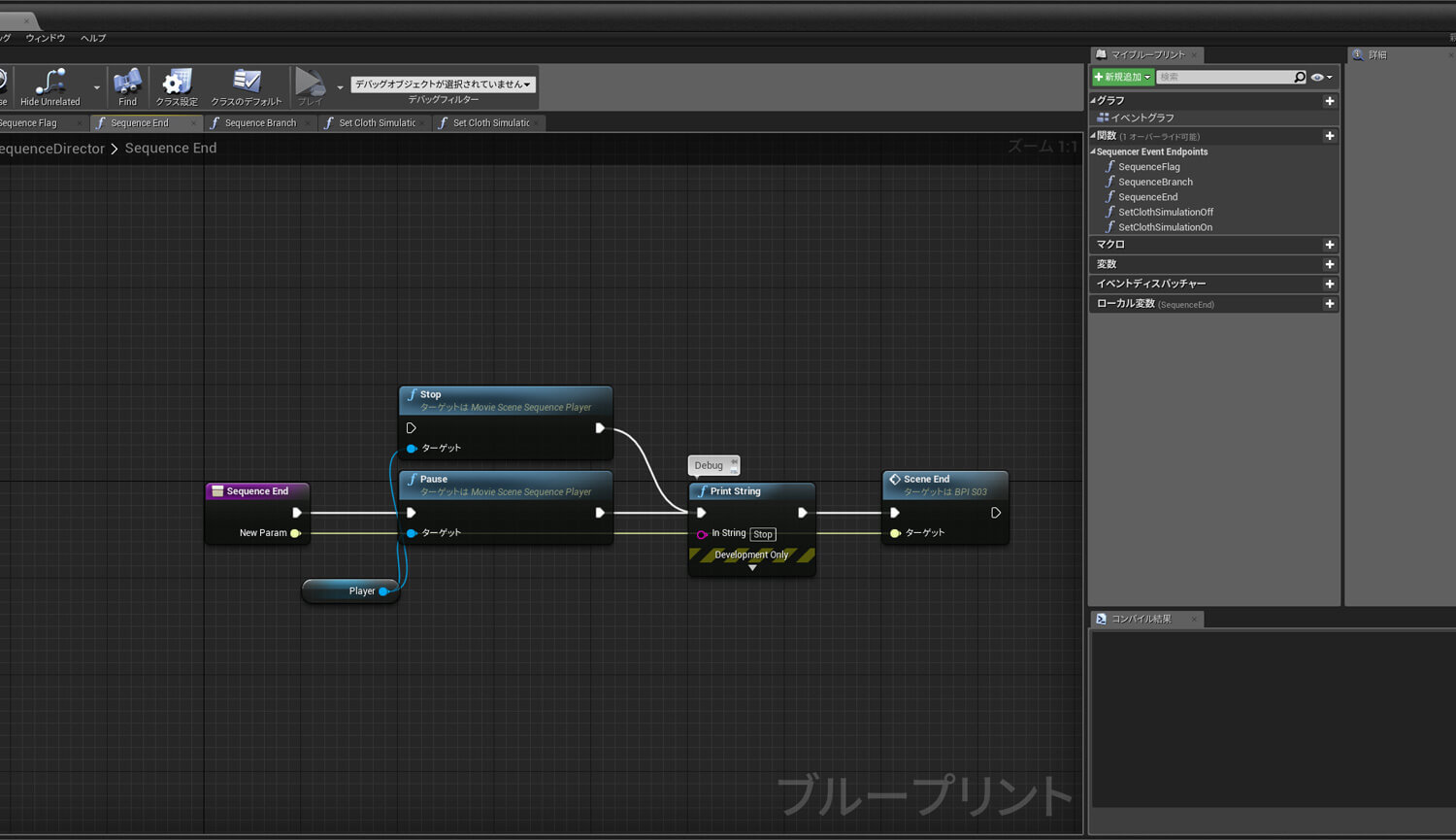

▲SequenceDirectorのUI。シーケンサー用のBlueprints

-

▲シーケンサーでshotを並べている様子。カメラワークなどリアルタイムで確認できるようになっているため、更新もスムーズに行える。「右のレベルのタブの中に各ショットのレベルを入れ、【シーケンサーのUI】の画像のようにショットのアニメなど制御しているシーケンサーをマスターシーケンスの中に入れることによってクリップのような扱いで並べることができます」(大山氏)

-

▲Blueprintsによるカメラの制御例

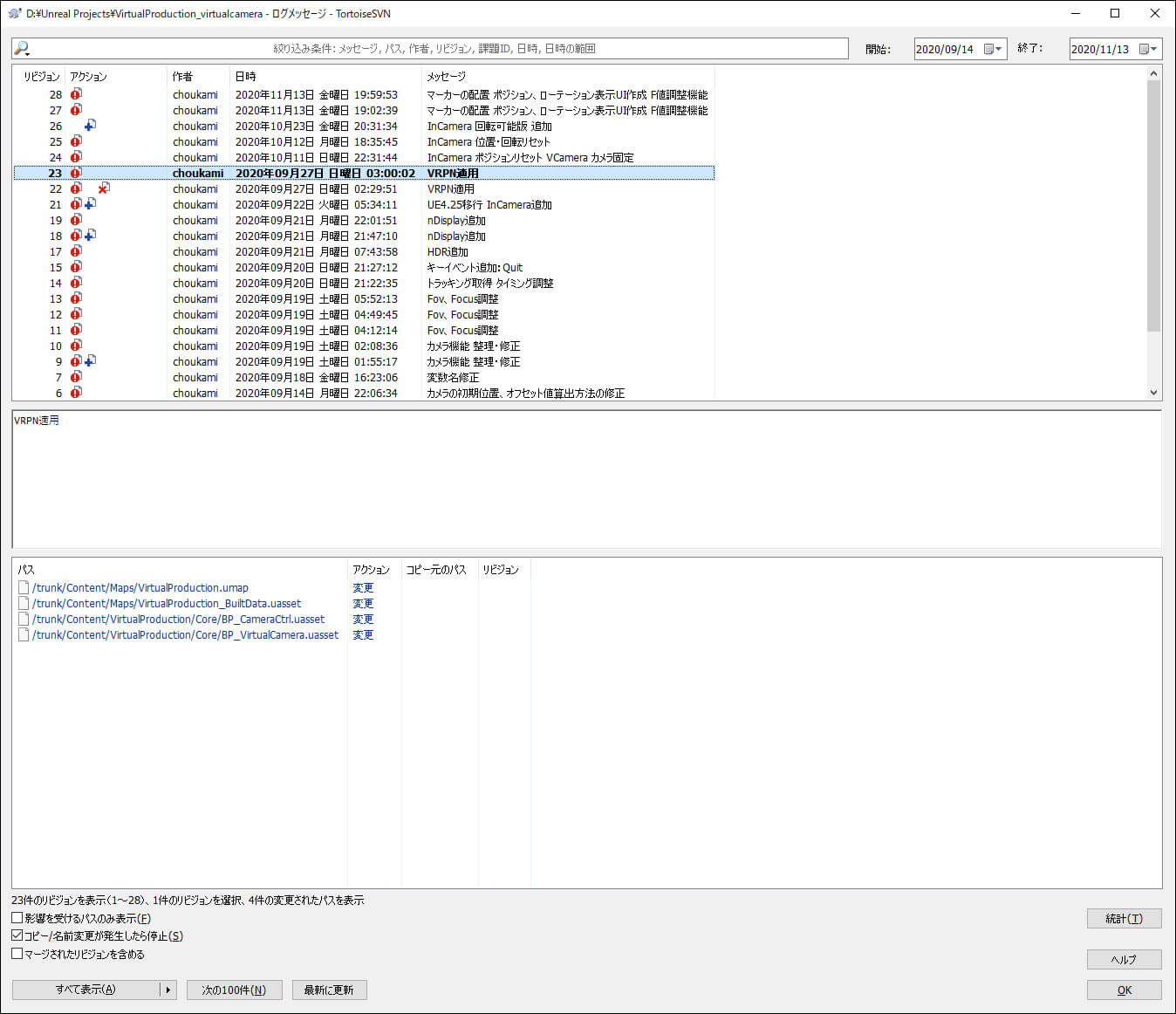

エピックゲームズは、UE作業データのバージョン管理システムとして、PerforceかSubersion(SVN)を推奨している。そこでランハンシャでは、SVNシステムをTortoiseSVNというGUIベースのクライアントを使用している

▲変更履歴のログ画面。任意のリビジョンに戻ることができるほか、派生バージョン(branch)の作成が可能

▲UEのソースコントロール機能。UE上からSVNにアクセスできる