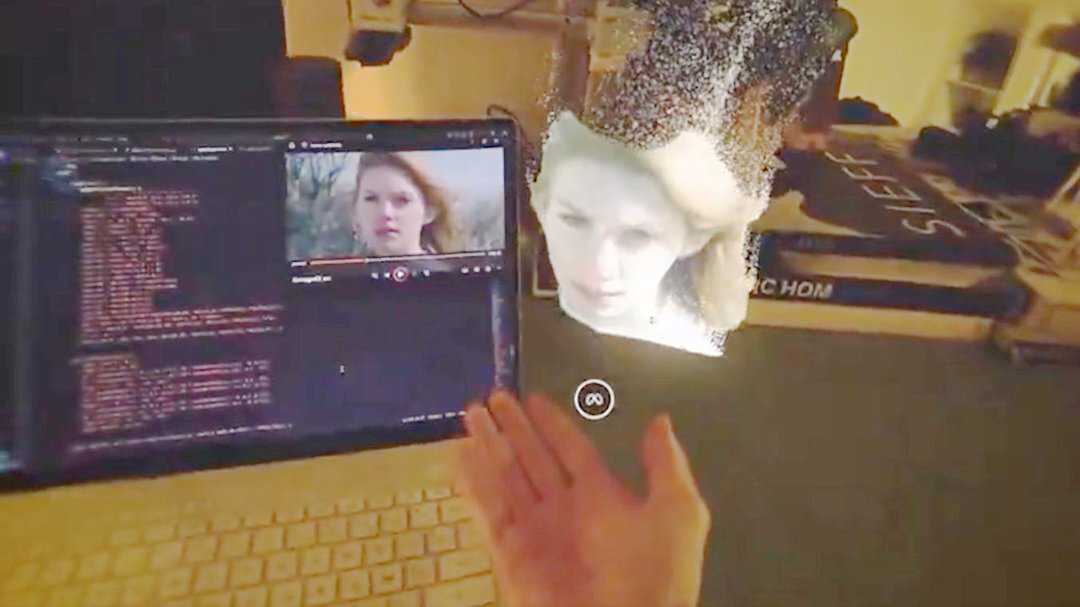

クリエイティブ・テクノロジスト/エンジニアのAlexandre Devaux氏は7月22日(火)、バイトダンスがオープンソース(Apache-2.0ライセンス)で公開している「Video Depth Anything」を活用し、動画から3Dホログラムを生成するWebXRのデモ「Video To Holograms GPGPU Curl Noise」を公開した。

Turn any video into a 3D hologram

— Alexandre Devaux (@AlexandreDevaux) July 22, 2025

Excited to share a working prototype that explores this, making standard videos feel more organic in WebXR. By leveraging video depth data, we can bring them to life as interactive particle clouds.

Demo: https://t.co/K4AqHKONdb#XR pic.twitter.com/cimjGCFD1u

Devaux氏は2D動画から深度情報を生成するAI技術「Video Depth Anything」を活用して、動画からインタラクティブなパーティクルクラウドを生成し、3Dホログラムへと変換するプロトタイプのWebXRコンテンツを公開した。xRデバイス(Meta Quest 3を推奨)を利用すると、生成されたホログラムを両手で操作することができる。また、xRデバイスなしでもWebブラウザで閲覧でき、マウス操作で回転やズーム、パーティクルの変換が行える。

Another Example captured on the Quest. Note that it's all running in WebXR thanks to @threejs, Hand occlusion and co :) pic.twitter.com/iU04bo2EAw

— Alexandre Devaux (@AlexandreDevaux) July 22, 2025

■Video To Holograms GPGPU Curl Noise (WebXR Enabled)(デモサイト)

https://whenistheweekend.com/hologram.html

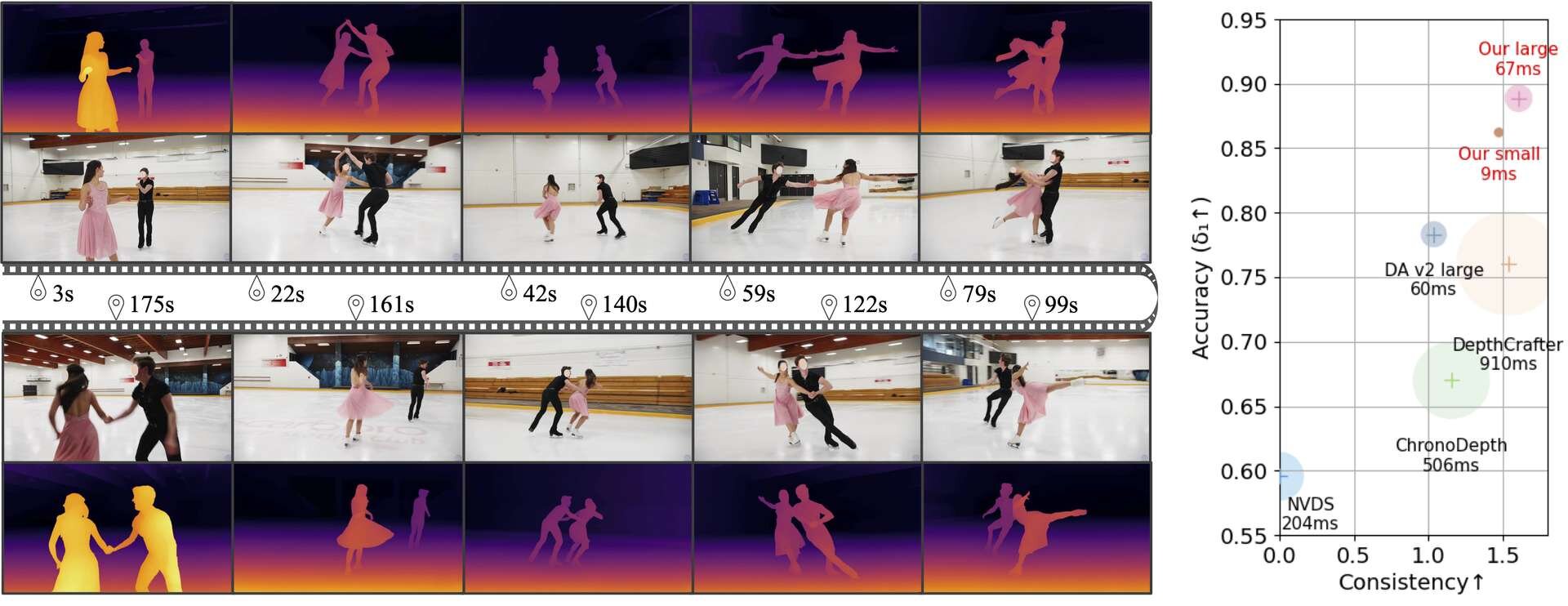

Video Depth Anythingについて

バイトダンスがオープンソースで公開しているAI技術。2D動画を解析して3Dで撮影したかのような深度(デプス)情報を生成できる。従来、深度推定を行う多数のAI技術では、フレーム単位で奥行きの推定値がズレることにより映像の“ちらつき”が生じるという課題があった。Video Depth Anythingはこの課題を、動画全体の時間のながれを理解して深度情報を生成することで解決する。また、長尺動画の処理では、映像を短い区間に区切りながら、少しずつ重ねて処理する方法により、破綻なく一貫した深度情報を生成できるという。

■Video Depth Anything: Consistent Depth Estimation for Super-Long Videos(プロジェクトページ、英語)

https://videodepthanything.github.io/

■Video Depth Anything(GitHub)

https://github.com/DepthAnything/Video-Depth-Anything

CGWORLD関連情報

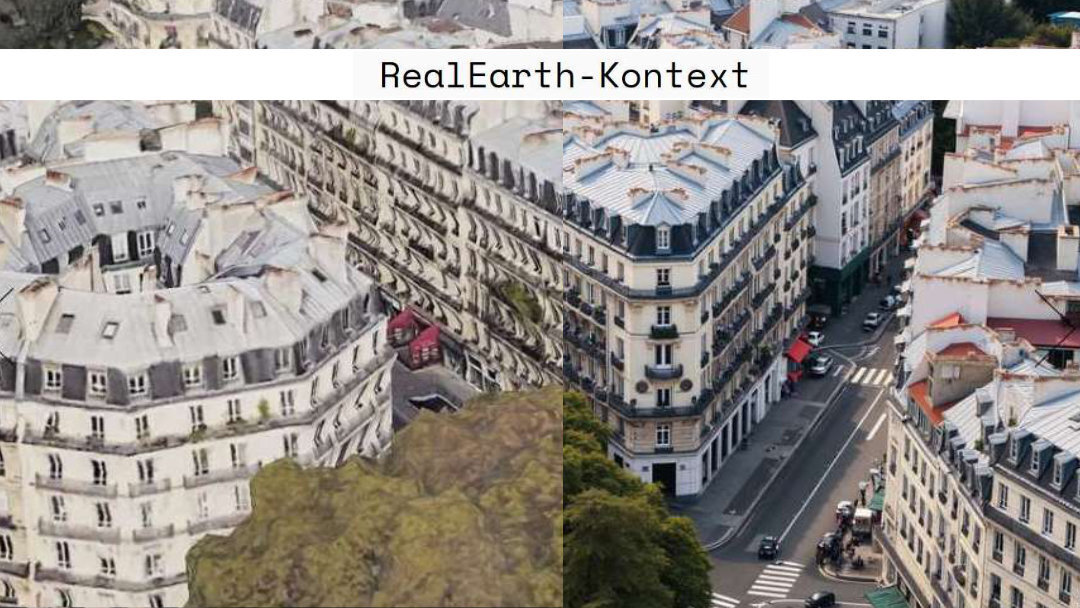

●低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換! Ismail Seleit氏がFLUX Kontext LoRAのトレーニングで実現、無料ダウンロード可能

Ismail Seleit氏が自身のLinkedInで「RealEarth-Kontext LoRA」のリリースを発表。低解像度のGoogle Earthのスクリーンショットを高解像度のドローン写真に変換できる無料のモデルで、同氏が運営する建築デザイン向け画像生成AIワークフロー支援サイト「form-finder」からダウンロードできる。

https://cgworld.jp/flashnews/01-202507-RealEarth-Kontext.html

●世界初のAIネイティブUGCゲームエンジン「Mirage」発表! ユーザーがリアルタイムでワールドを生成してプレイ可能

Dynamics Lab AIが世界初となるAIネイティブのUGC(User-Generated Contents、ユーザー生成コンテンツ)ゲームエンジン「Mirage」を発表。AIワールドモデルにより、プレイヤーがリアルタイムでゲームのワールドをインタラクティブに生成し、プレイできる。現在は「研究プレビュー(Research Preview)」の段階だが、Webブラウザで動作する2種類のプレイアブルデモが公開されている。

https://cgworld.jp/flashnews/01-202507-Mirage.html

●NVIDIA、新リライティングフレームワーク「UniRelight」発表! 入力画像または動画からシーン特性と照明分布を分析し高品質なリライトを実現

NVIDIA、トロント大学、Vector Instituteからなる研究チームが新しいリライティング(再照明)フレームワーク「UniRelight」を発表。1枚の入力画像または動画からシーンの固有特性と照明分布を共同でモデル化することで、高品質なリライティングと固有分解を可能にする。

https://cgworld.jp/flashnews/01-202507-NVIDIA-UniRelight.html