NVIDIA(NVIDIA Spatial Intelligence Lab、NVIDIA Research)、トロント大学、Vector Instituteからなる研究チームは6月19日(木)、新しいリライティング(再照明)フレームワーク「UniRelight」を発表した。1枚の入力画像または動画からシーンの固有特性と照明分布を共同でモデル化することで、高品質なリライティングと固有分解を可能にする。

Introducing UniRelight, a general-purpose relighting framework powered by video diffusion models.

— Kai He (@Kai__He) June 19, 2025

UniRelight jointly models the distribution of scene intrinsics and illumination, enabling high-quality relighting and intrinsic decomposition from a single image or video. pic.twitter.com/WMdgFTnUdj

Motivation: Our key insight is to jointly model relighting and albedo estimation. Scene intrinsics provides a strong prior for the relighting task, improving generalization and reducing shadow-baking artifacts.

私たちの主な目的は、リライティングとアルベド(物体の表面反射率)の推定を同時に行うことです。シーンの固有の特性を考慮することで、リライティングの精度が向上し、様々な状況への適用能力が高まります。また、影が焼き付いたような不自然なアーティファクトを減らすことができます。

UniRelight produces high-quality albedo and relighting results with realistic specular highlights and shadows under target lighting conditions on real-world videos.

UniRelightは実際の動画で高品質なアルベドとリライティングの結果を生み出します。特に目標とする照明条件下で、リアルな鏡面反射(光沢)と影を表現できます。

UniRelight is a specialized relighting model capable of handling complex material effects—including transparency, translucency, and subsurface scattering—while more faithfully preserving the content of the input video. pic.twitter.com/HyLTKtZLDL

— Kai He (@Kai__He) June 19, 2025

UniRelight is a specialized relighting model capable of handling complex material effects—including transparency, translucency, and subsurface scattering—while more faithfully preserving the content of the input video.

UniRelightは透明度や半透明度(translucency)、SSS(サブサーフェススキャタリング)といった複雑な素材の効果も処理できる、専門的なリライティングモデルです。入力動画の内容をより忠実に保ちながら、高度な視覚効果を実現します。

Qualitative comparison on in-the-wild data. Our method generates more plausible results than the baselines, with higher quality and more realistic appearance. pic.twitter.com/8ZGJDJQZAS

— Kai He (@Kai__He) June 19, 2025

Qualitative comparison on in-the-wild data. Our method generates more plausible results than the baselines, with higher quality and more realistic appearance.

実際の(制約のない)データでの比較では、UniRelightは既存モデルよりもはるかに説得力のある結果を生成しており、UniRelightがより高品質でリアルなルックを実現していることを示しています。

Our model's strong generalization capability also enables effective data augmentation across different scenarios.

UniRelightの高い汎用性は、様々なシナリオにおいて効果的なデータ拡張を可能にします。

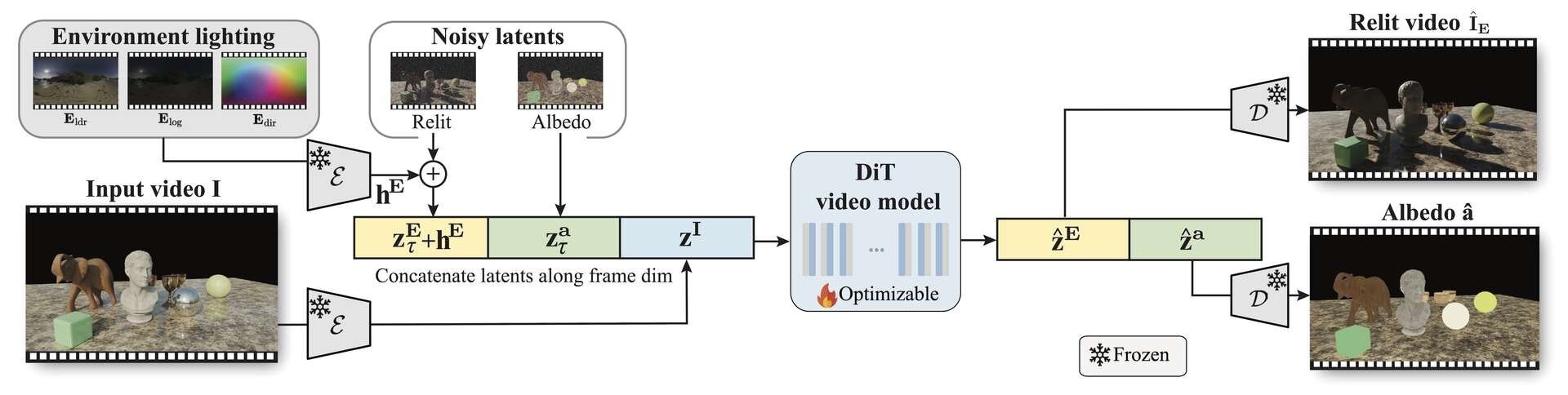

UniRelightは、動画拡散(diffusion)モデルの生成能力を活用し、事前学習済みのVAE(Variational AutoEncoder、変分オートエンコーダ)エンコーダ-デコーダを用いて入力・出力動画を潜在空間(latent space)にマッピングする。

そして、目標のリライト済み動画とアルベドの潜在変数(latents)を、入力動画のエンコードされた潜在変数と時系列方向に結合。さらに、環境マップから得られる照明情報をリライト済み動画の潜在変数とチャネル方向に結合する。

微調整されたDiT(Diffusion Transfomer)動画モデルは、結合された潜在変数からノイズを除去し、リライトされた外観と固有分解(intrinsic decomposition、動画内の物体がもつ色や質感を影や照明の影響から切り離して推定)を一貫して生成する。この2つの工程を同時かつ一貫して行うことにより、影や反射、透明度などのリアルで複雑な光の表現を動画内に生み出すことができる。

■UniRelight: Learning Joint Decomposition and Synthesis for Video Relighting(プロジェクトページ、英語)

https://research.nvidia.com/labs/toronto-ai/UniRelight/

CGWORLD関連情報

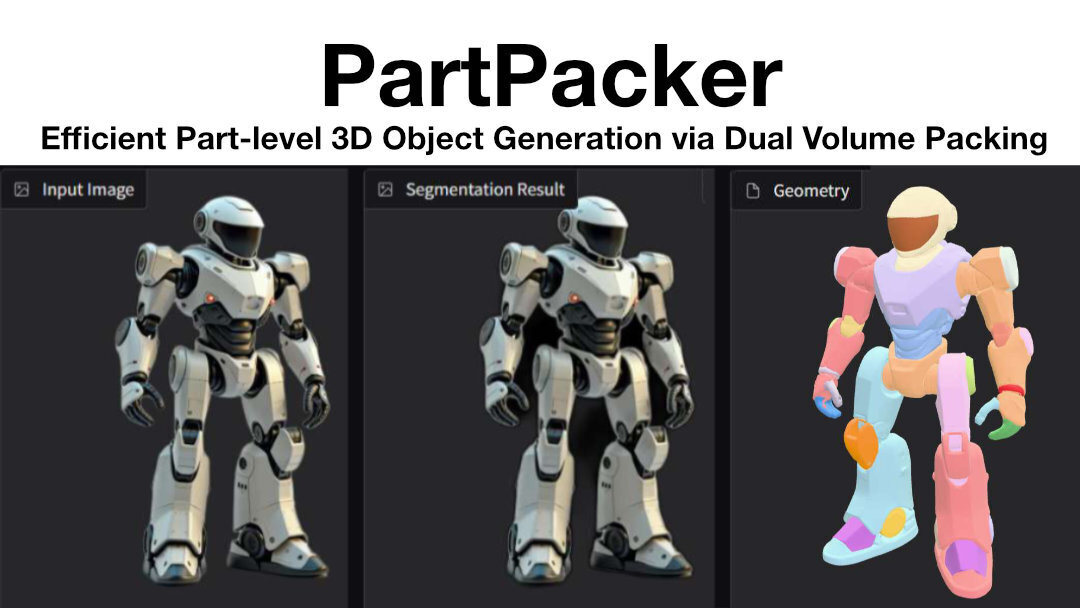

●NVIDIA、3Dモデル生成AI「PartPacker」GitHubで公開! 1枚の2D画像から意味のあるパーツ分割を施した3Dモデルを生成

NVIDIA(NVIDIA Deep Imagination Research)、北京大学、スタンフォード大学からなる研究チームが3Dモデル生成技術「PartPacker」を発表、GitHubでソースコードを公開した。ライセンスは「NVIDIA Source Code License」で、非商用目的での使用のみに制限されている。

https://cgworld.jp/flashnews/01-202506-NVIDIA-PartPacker.html

●3Dモデル生成AI「Sparc3D」リリース! 高精細な形状推定が特徴、Webアプリ「Hitem3D」上で1日5回まで無料で生成可能

南洋理工大学、Math Magic、インペリアル・カレッジ・ロンドンからなる研究チームが、3Dモデル生成AI「Sparc3D(Sparse Representation and Construction for High-Resolution 3D Shapes Modeling)」を発表。現在、Webアプリ「Hitem3D」上で1日5回まで無料で生成できる。コードはGitHubで公開される予定。

https://cgworld.jp/flashnews/01-202506-Sparc3D-Hitem3D.html

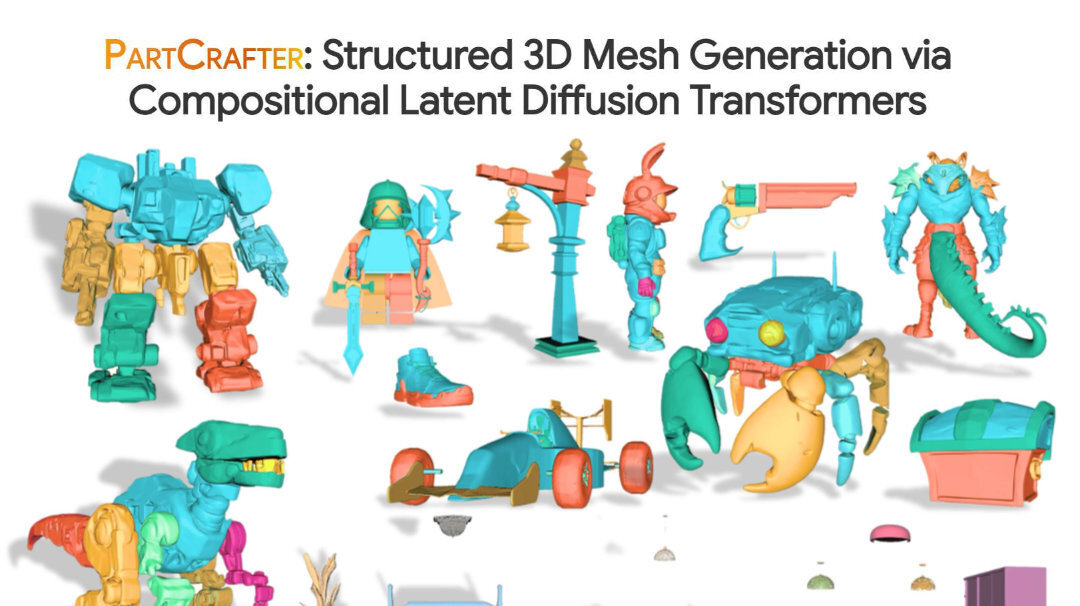

●3Dモデル生成AI「PartCrafter」リリース! 1枚の写真から編集可能な3Dパーツを瞬時に生成

北京大学、バイトダンス、カーネギー・メロン大学からなる研究チームが、パーツ単位で3Dメッシュを生成するAIモデル「PartCrafter: Structured 3D Mesh Generation via Compositional Latent Diffusion Transformers」をオープンソース(MITライセンス)で公開(コードとチェックポイントの公開は7/15を予定)。

https://cgworld.jp/flashnews/01-202506-PartCrafter.html