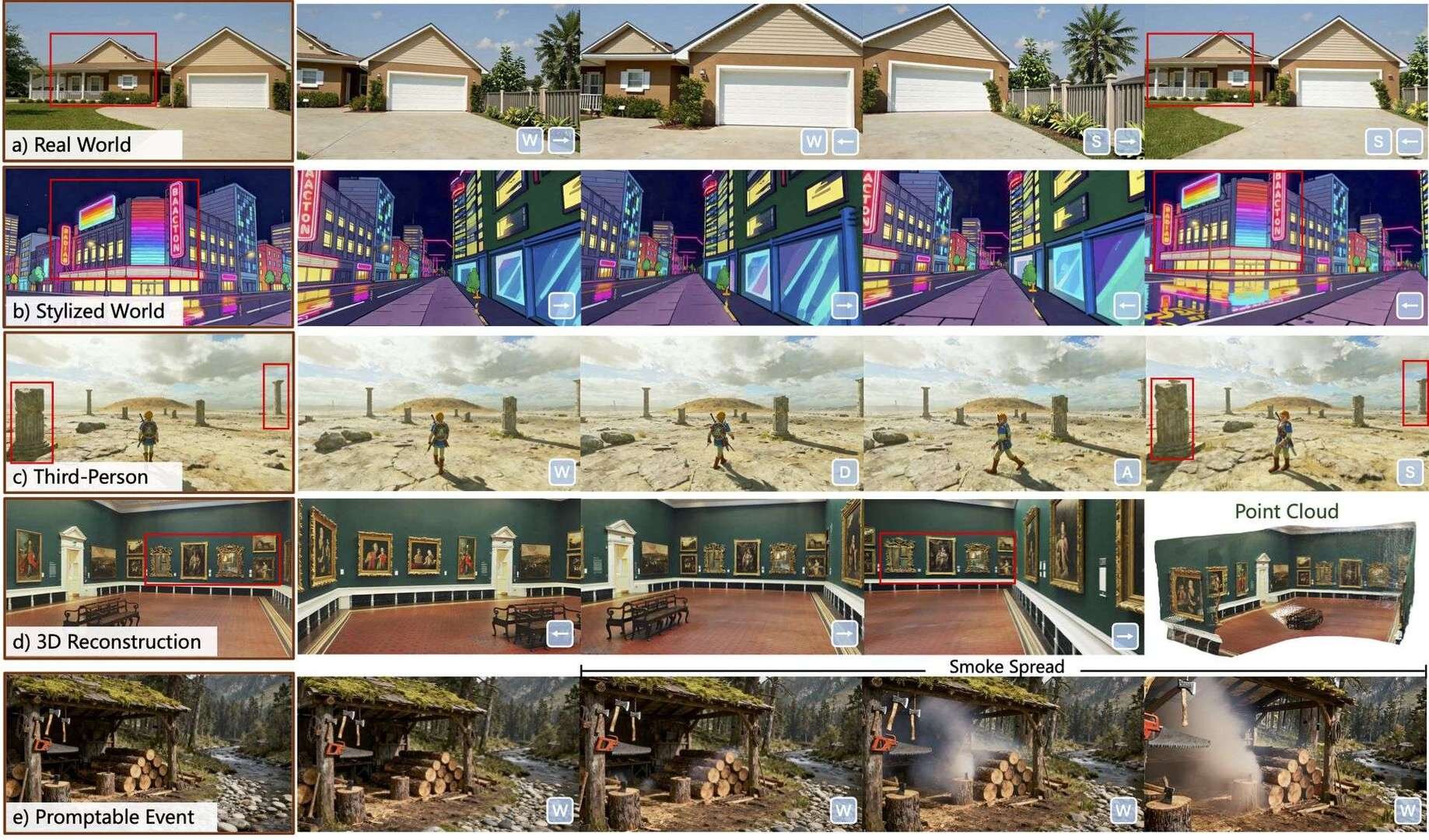

中国テンセント(Tencent)社のHunyuanチームは12月17日(水)、リアルタイム世界モデルフレームワーク「HY World 1.5 (WorldPlay)」を発表し、オープンソース(TENCENT HY-WORLDPLAY COMMUNITY LICENSE)で公開した。720P・24fpsのリアルタイム生成、一人称と三人称視点をサポートし、フォトリアルな環境からスタイライズされた空想的な世界まで、多様なシーンの生成が可能。また、テキストプロンプトによって特定のイベントを発生させる機能を備え、世界を無限に拡張していく応用もできるとのこと。

Introducing HY World 1.5 (WorldPlay)! We have now open-sourced the most systemized, comprehensive real-time world model framework in the industry.

— Tencent HY (@TencentHunyuan) December 17, 2025

In HY World 1.5, we develop WorldPlay, a streaming video diffusion model that enables real-time, interactive world modeling… pic.twitter.com/FJzWMfdp3t

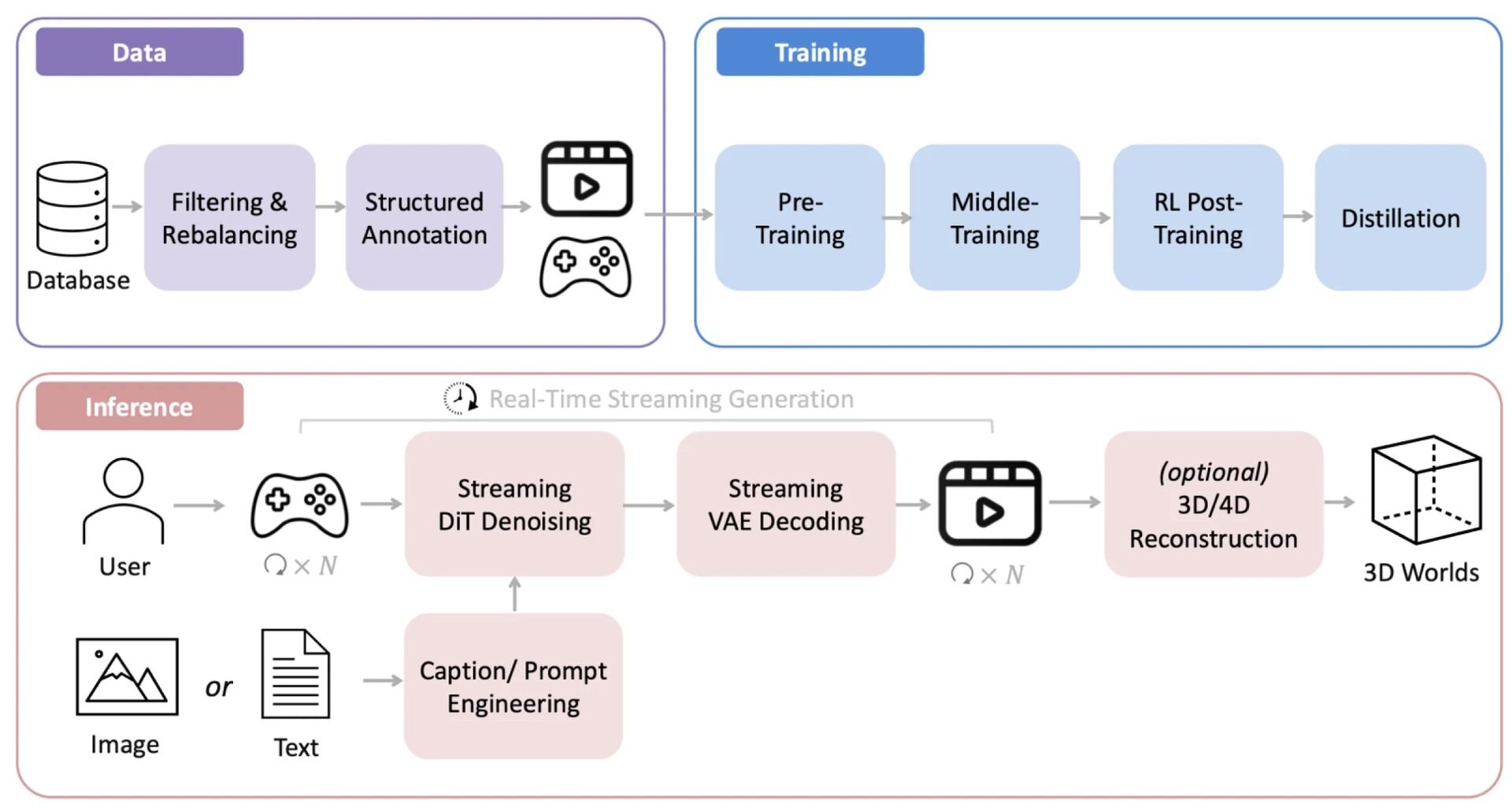

「HY World 1.5(WorldPlay)」は、テキストや画像の入力から、ユーザーが自由に探索・対話可能な3D世界を生成できる技術。従来技術では生成速度とメモリ効率がトレードオフの関係にあり、長時間の生成において整合性を保つことが困難だったが、HY World 1.5はストリーミング動画拡散モデル(Streaming Video Diffusion Model)として開発され、こうした課題を克服している。

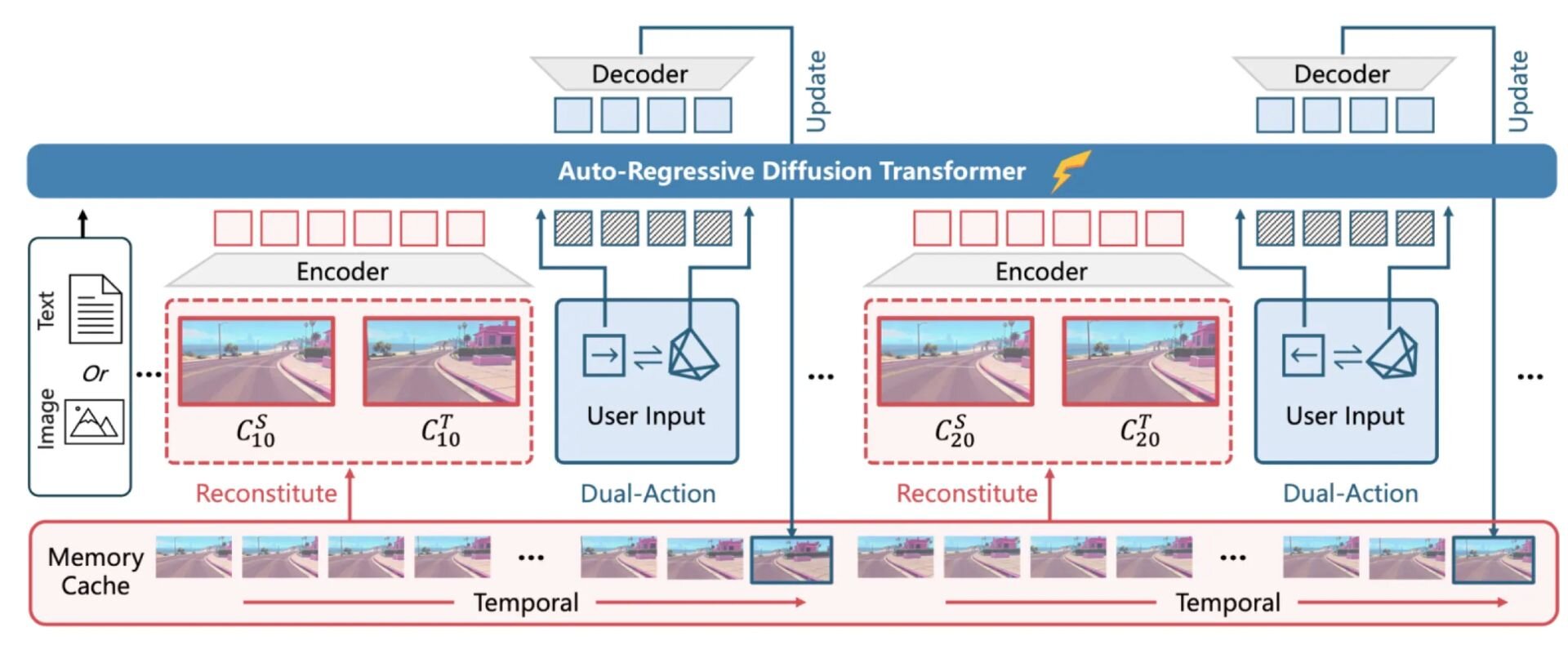

技術面では、独自の「再構成コンテキストメモリ(Reconstituted Context Memory)」メカニズムにより、長時間にわたる生成においても空間の歪みや破綻を防ぐジオメトリ的整合性(Geometric Consistency)を確保。

従来の手法では、生成時間が長くなるにつれて過去の情報を保持するメモリが減衰し、以前に生成した場所に戻った際に地形が変わっているといった不整合が生じやすかった。HY World 1.5では、過去のフレームから文脈を動的に再構築し、ジオメトリ的に重要な情報を維持し続ける「時間的リフレーミング(Temporal Reframing)」を採用することで、メモリ減衰の問題を緩和している。

HY World 1.5には、操作性を高める「双対アクション表現(Dual Action Representation)」、品質を高める「WorldCompass」、高速化技術「速度」を支える「コンテキスト強制蒸留(Context Forcing Distillation)」という3つの技術が導入されている。

「双対アクション表現(Dual Action Representation)」は、キーボードによる「前進・右移動」といった大まかな指示と、マウスによる「視点を滑らかに動かす」詳細な操作を、AIが統合的に理解し処理する仕組み。従来の手法では、どちらか一方のみでは「動きが不連続になる」あるいは「視点が意図せずずれてしまう(ドリフト現象)」といった問題が生じがちであった。HY World 1.5ではこれらを組み合わせることで、実際のゲームプレイと比較しても遜色のない、違和感のないスムーズな操作性を実現しているという。

「WorldCompass」は、生成される映像の品質と、ユーザー操作への応答性を両立させるために導入された、独自の強化学習システム。これは、基礎学習を終えたモデルに対する「仕上げの最適化(ポストトレーニング)」に相当するもので、AIが生成した結果に対し、「操作入力通りに動けているか」「映像として破綻していないか」を厳格に評価し、その結果をフィードバックする。これにより、モデルはより正確かつ高品質な映像を出力できるようになる。

「コンテキスト強制蒸留(Context Forcing Distillation)」は、高度な計算処理を一般的なGPUでも実行可能にする高速化技術。性能は高いが計算コストの重い「教師モデル」の知識と記憶構造を、軽量で高速な「生徒モデル」に効率よく継承させ、軽量モデルでありながら長時間の生成でも整合性を維持し、かつ高速な推論を可能とする。HY World 1.5は、VRAM 14GB程度のGPUでも動作するパフォーマンスを達成している。

HY World 1.5(WorldPlay)はオープンソースで提供され、ソースコードはGitHub、学習済みモデルはHugging Faceで公開されている。ライセンスは独自のTENCENT HY-WORLDPLAY COMMUNITY LICENSEが適用され、研究および非商用利用を広く許可する一方で、商用利用に関しては特定の条件や申請が必要となる場合がある。

■公式ワークスペース

https://3d.hunyuan.tencent.com/sceneTo3D?tab=worldplay

■HYWorld-1.5(プロジェクトページ)

https://3d-models.hunyuan.tencent.com/world/

■HY-World 1.5: A Systematic Framework for Interactive World Modeling with Real-Time Latency and Geometric Consistency(GitHub)

https://github.com/Tencent-Hunyuan/HY-WorldPlay

■HY-WorldPlay(Hugging Face)

https://huggingface.co/tencent/HY-WorldPlay

■テクニカルレポート(PDF)

https://3d-models.hunyuan.tencent.com/world/world1_5/HYWorld_1.5_Tech_Report.pdf

CGWORLD関連情報

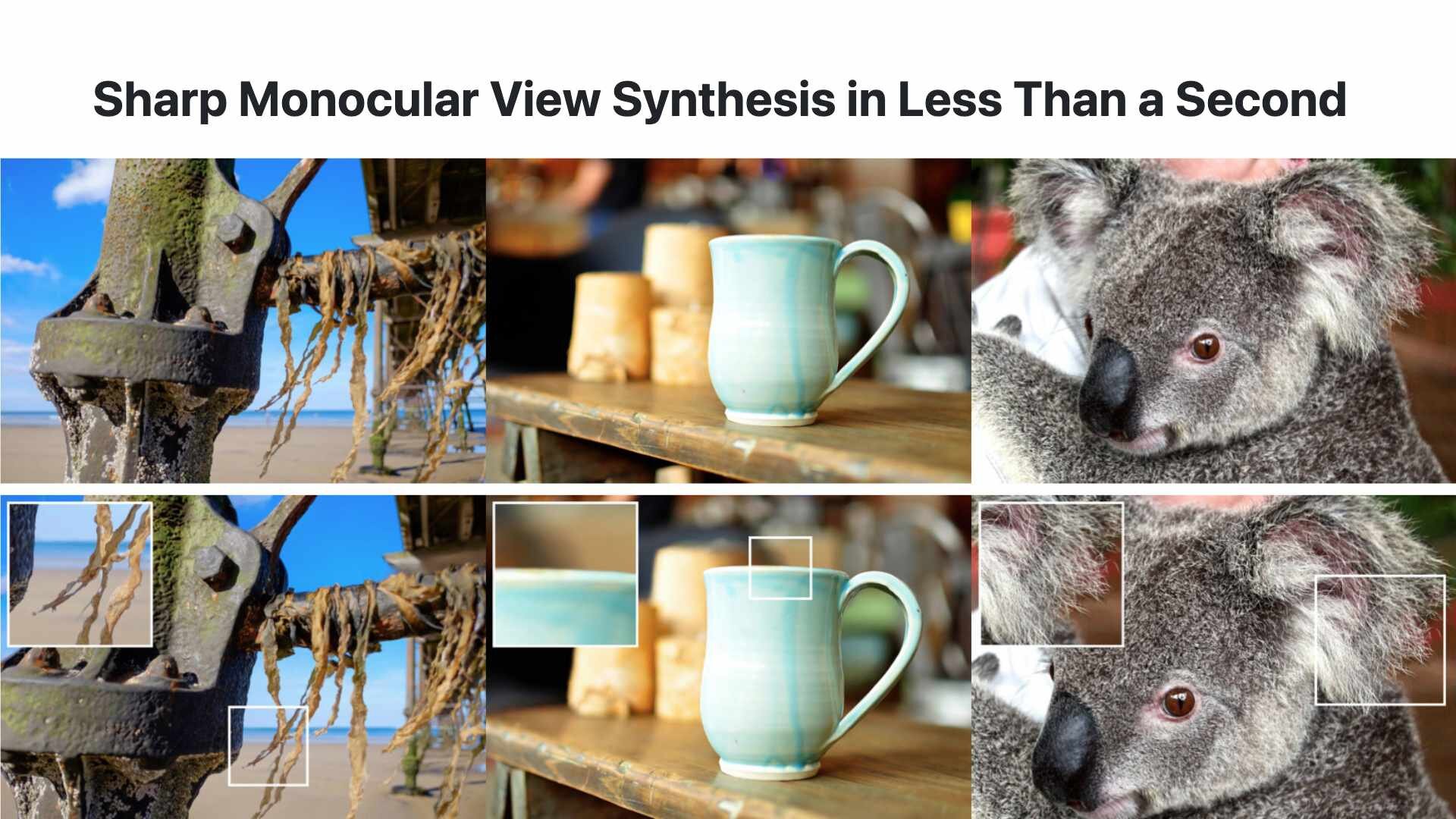

●Apple、単一画像から高品質な3DGSを生成する技術「SHARP」公開! 一般的GPU環境で高速3Dシーン構築可能

Appleが1枚の静止画から高品質な3D表現を瞬時に生成する新たな技術「SHARP(Sharp Monocular View Synthesis in Less Than a Second)」を公開。コードとモデルウェイトはGitHubとHugging Faceで公開されており、それぞれApple独自ライセンスの下で提供される。

https://cgworld.jp/flashnews/01-202601-SHARP.html

●3Dワールド生成モデル「Echo」発表! 独自の空間基盤モデルを用いて、メートル法ベースのジオメトリに裏付けされた物理空間の描画・編集を実現、クローズドβ中

SpAItialがテキストや1枚の画像から一貫性のある3D世界を生成する新モデル「Echo」を発表。Webデモでは3DGS(3D Gaussian Splatting)を採用し、低スペックな機材でもリアルタイムでジオメトリに裏付けされた空間の描画・編集、Webブラウザ上での自由な移動や探索を実現している。現在はクローズドベータ版の登録を受付中。

https://cgworld.jp/flashnews/01-202512-Echo.html

●テンセント、オープンソースの世界モデル「HunyuanWorld-Mirror」公開! 動画や画像から最適化なしで3DGS・深度・カメラパラメータをまとめて高速出力

テンセントがオープンソースの世界モデル「Hunyuan World Models」シリーズの新モデルとして、高速・汎用3D復元モデル「HunyuanWorld-Mirror(Hunyuan World 1.1)」を公開。動画や画像から3Dシーンを数秒で生成し、3DGS(3D Gaussian Splatting)やデプス(深度)マップ、サーフェスノーマル(法線)、カメラパラメータといった3Dデータを一度にまとめて出力できる。GitHubとHugging Faceでコードとウェイトが公開されており、基本的に商用利用が許可されるが、地理的制限などのある独自ライセンスとなっている。

https://cgworld.jp/flashnews/01-202511-HunyuanWorld-Mirror.html