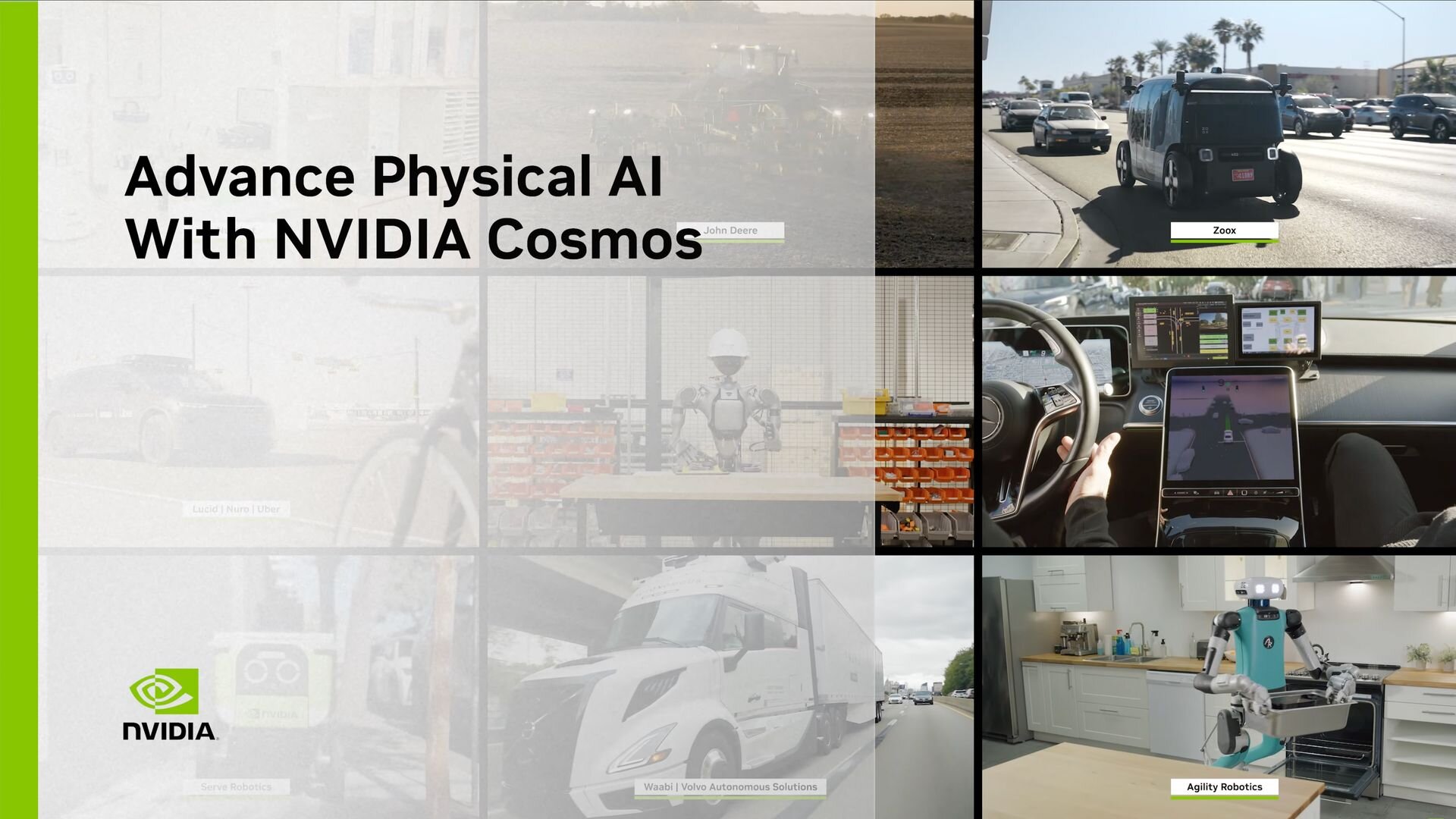

NVIDIA社は1月6日(火)、アメリカで開催された世界最大級のテクノロジ見本市「CES 2026(Consumer Electronics Show 2026)」において、新たなオープンモデルとツール群を発表した。そのひとつとして、フィジカルAIを開発・運用するための包括的プラットフォーム「Cosmos」をアップデート。「Cosmos Reason 2」、「Cosmos Predict 2.5」、「Cosmos Transfer 2.5」、「Isaac GR00T N1.6」の4モデルが発表された。

■NVIDIA Unveils New Open Models, Data and Tools to Advance AI Across Every Industry(公式ブログ)

https://blogs.nvidia.com/blog/open-models-data-tools-accelerate-ai/

進化した推論能力を持つ視覚言語モデル「Cosmos Reason 2」

NVIDIA Cosmos Reason 2 is here.

— NVIDIA AI Developer (@NVIDIAAIDev) January 5, 2026

An open, highly accurate reasoning vision language model for physical AI, featuring:

Improved spatio-temporal understanding and timestamp precision

Flexible deployment with 2B and 8B model sizes

Long-context reasoning with up to 256K… pic.twitter.com/LVmNbSnTRt

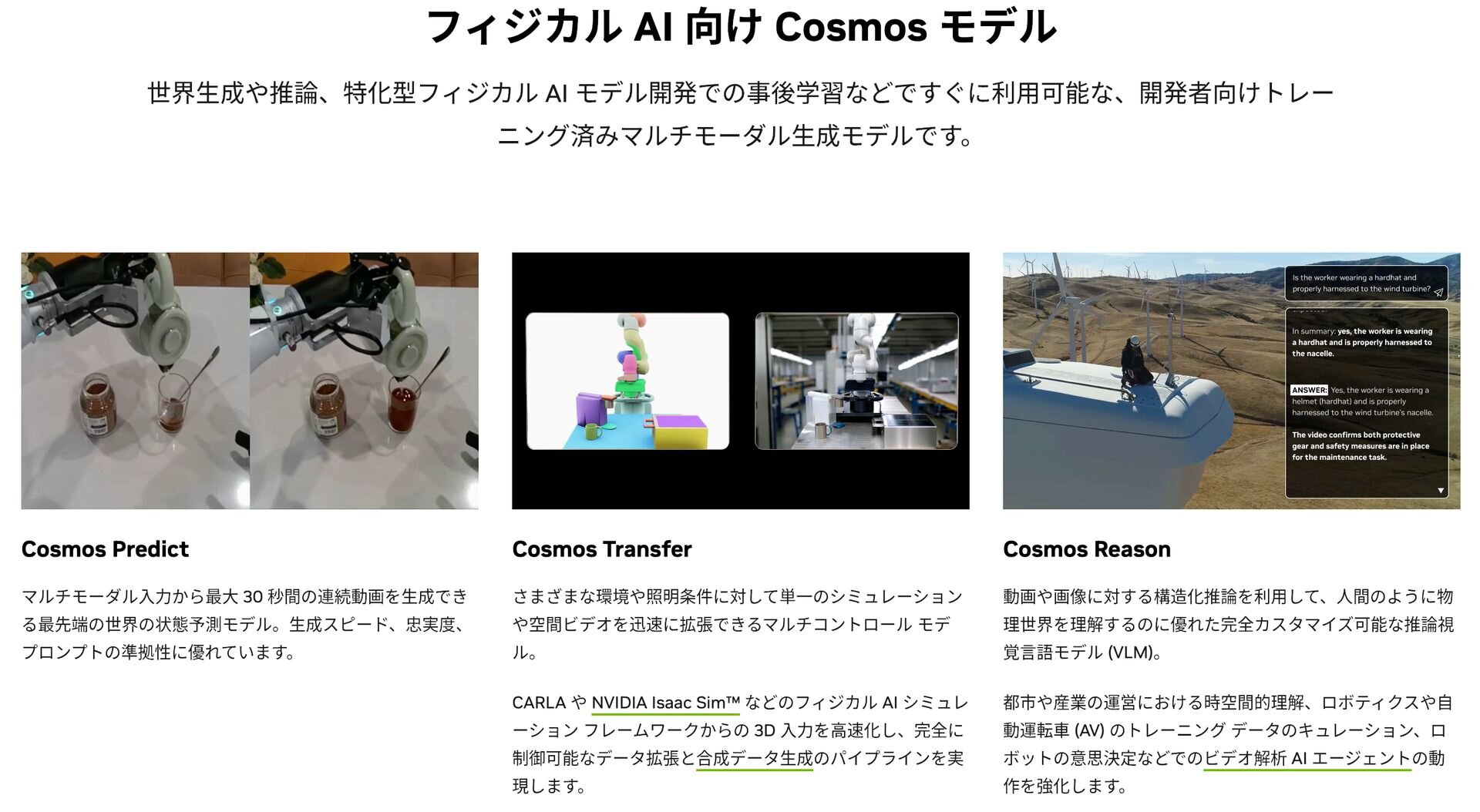

「Cosmos Reason 2」は、前世代よりも高度な推論能力を備えた視覚言語モデル(Vision Language Model、VLM)。画像や映像を入力として受け取り、そこに映る物体の動きや物理的な関係性を理解できる。これにより、フィジカルAIが単に物体を認識するだけでなく、状況を深く理解し、現実世界で適切に振る舞うための行動を論理的に決定できる。

Reason 2では空間と時間の理解力が強化されており、2Dや3Dの点による位置特定、対象物を囲むバウンディングボックスの座標取得、物体の移動軌跡の追跡が可能となっている。こうした機能強化によってロボットは、「目の前のコップを掴んで移動させる」といったタスクを計画する際、障害物を回避しながら適切なルートを算出することができる。

モデルのサイズは20億(2B)および80億(8B)パラメータの2種類が用意されている。コードのライセンスはApache 2.0、学習済みモデルウェイトは商用利用が可能な「NVIDIA Open Model License」の下で提供される。

■NVIDIA Cosmos Reason 2 Brings Advanced Reasoning To Physical AI(Hugging Face ブログ)

https://huggingface.co/blog/nvidia/nvidia-cosmos-reason-2-brings-advanced-reasoning

■Cosmos Reason 2(GitHub)

https://github.com/nvidia-cosmos/cosmos-reason2

■NVIDIA Open Model License Agreement

https://www.nvidia.com/en-us/agreements/enterprise-software/nvidia-open-model-license/

未来を予測する世界基盤モデル「Cosmos Predict 2.5」

Today’s Cosmos Cookbook Special A recipe that lets you generate and build realistic, physically accurate, and rule-aware sports videos with smooth player motions using LoRA post-trained on Cosmos Predict 2.5.

— NVIDIA AI Developer (@NVIDIAAIDev) December 3, 2025

Create videos that capture the natural kinematics of athletes… pic.twitter.com/FCnyXtB2f7

「Cosmos Predict 2.5」は、テキストや画像、過去の映像を入力として、その後に起こる物理世界の未来の状態を「映像」として生成できる世界基盤モデル(World Foundation Model、WFM)。ロボットアームが物体を操作する様子や、自動運転車が走行する風景などのシミュレーション映像を、実際に撮影することなく生成できる。物理法則を考慮した一貫性のある映像を生成できることから、ロボットの学習用シミュレータとしての活用が期待されている。

20億(2B)および140億(14B)パラメータのモデルが提供され、2億クリップの動画データで事前学習済み。コードのライセンスはApache 2.0、学習済みモデルウェイトは商用利用が可能な「NVIDIA Open Model License」の下で提供される。

■Cosmos-Predict2.5(GitHub)

https://github.com/nvidia-cosmos/cosmos-predict2.5

■NVIDIA Open Model License Agreement

https://www.nvidia.com/en-us/agreements/enterprise-software/nvidia-open-model-license/

シミュレーションと現実のギャップを埋める「Cosmos Transfer 2.5」

Today’s Cosmos Cookbook Special @Voxel51's recipe that uses Cosmos Transfer 2.5 to address scarcity in biodiverse data by taking a few existing moth images and generating rich, field-like agricultural scenes.

— NVIDIA AI Developer (@NVIDIAAIDev) December 3, 2025

Transform lab-style BioTrove moth shots into photorealistic… pic.twitter.com/wIMVt9b9Gh

「Cosmos Transfer 2.5」は動画のスタイル変換を行う技術。CGで生成した無機質なシミュレーション映像(Sim)を、ノイズやライティング条件が加わった現実の映像(Real)のように変換したり、逆に現実の映像を特定のアニメーションスタイルに変換したりすることができる。Omniverseベースのロボティクスシミュレータ「NVIDIA Isaac Sim」と組み合わせて利用することが想定されており、Transfer 2.5によって訓練データを現実に近い映像に変換することで、AIモデルが現実世界に配備された際にスムーズに適応できるようになる。

コードのライセンスはApache 2.0、学習済みモデルウェイトは商用利用が可能な「NVIDIA Open Model License」の下に提供される。

■Cosmos-Transfer2.5(GitHub)

https://github.com/nvidia-cosmos/cosmos-transfer2.5

■NVIDIA Open Model License Agreement

https://www.nvidia.com/en-us/agreements/enterprise-software/nvidia-open-model-license/

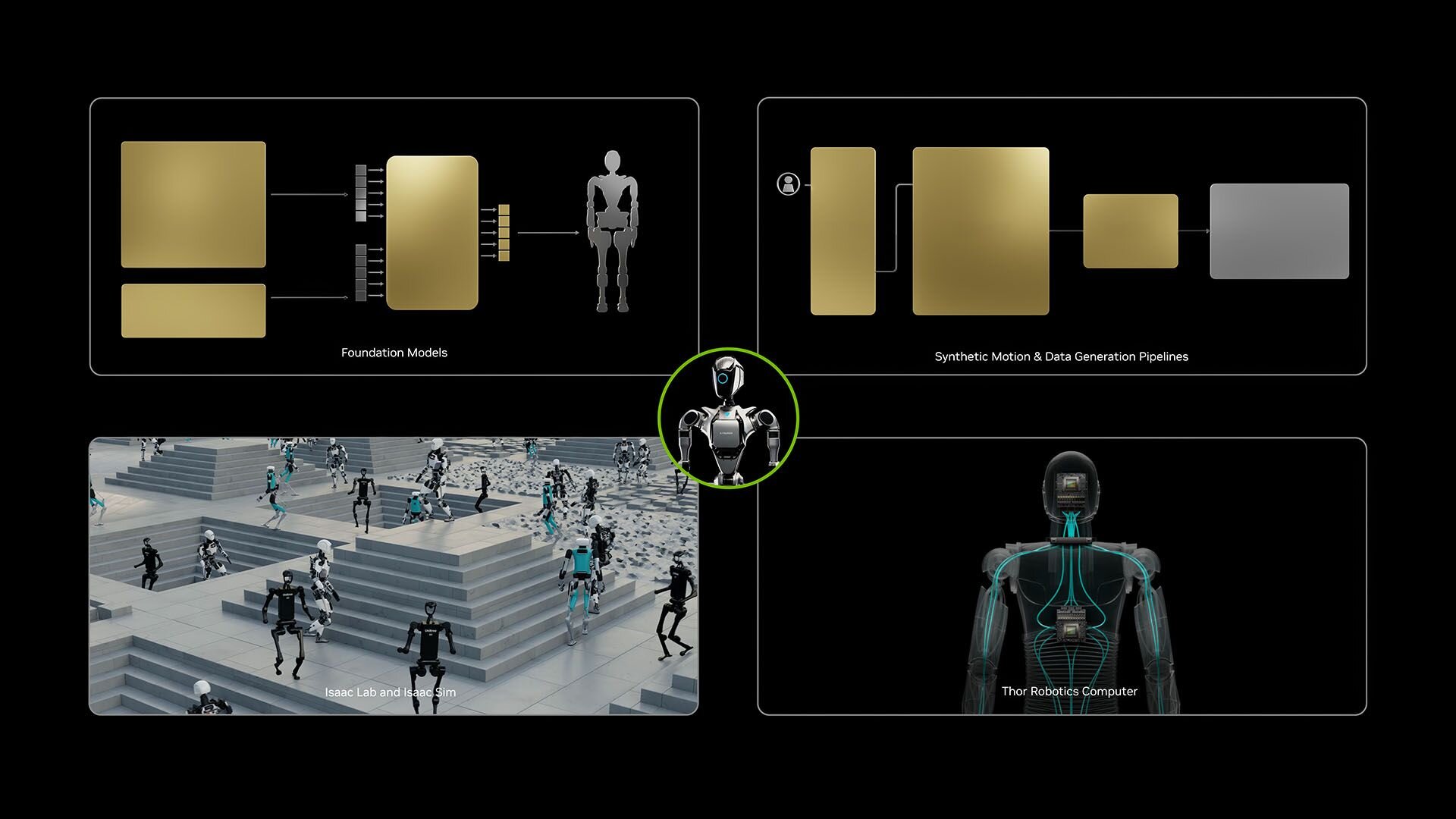

人型ロボットの身体能力を拡張する「Isaac GR00T N1.6」

「Isaac GR00T N1.6」は、上記のCosmos技術を統合し、具体的なアプリケーションとして形にした、人型ロボット向けの汎用基盤モデル。視覚・言語・行動を統合したモデル(Vision-Language-Action、VLA)となる。今回、新たにCosmos Reason 2を推論エンジンとして採用したことで、複雑な指示を理解し、より的確な全身運動を行えるようになった。

開発プロセスにはシミュレーション環境「Isaac Lab」が活用されている。ここでは3DCGで構築された仮想空間内でロボットが試行錯誤を繰り返し、歩行や物体の操作、ナビゲーションといったスキルを習得する。仮想空間で学習した制御ポリシーをそのまま実機に転送しても動作する「ゼロショット転送」を実現している。

ライセンスは「NVIDIA License(NVIDIA OneWay Noncommercial License)」の下で提供され、研究または評価目的のみでの利用が可能。商用利用は禁止されている。

■NVIDIA Isaac GR00T公式ページ

https://developer.nvidia.com/isaac/gr00t

■INVIDIA Isaac GR00T(GitHub)

https://github.com/NVIDIA/Isaac-GR00T

■NVIDIA License(PDF)

https://developer.download.nvidia.com/licenses/NVIDIA-OneWay-Noncommercial-License-22Mar2022.pdf

CGWORLD関連情報

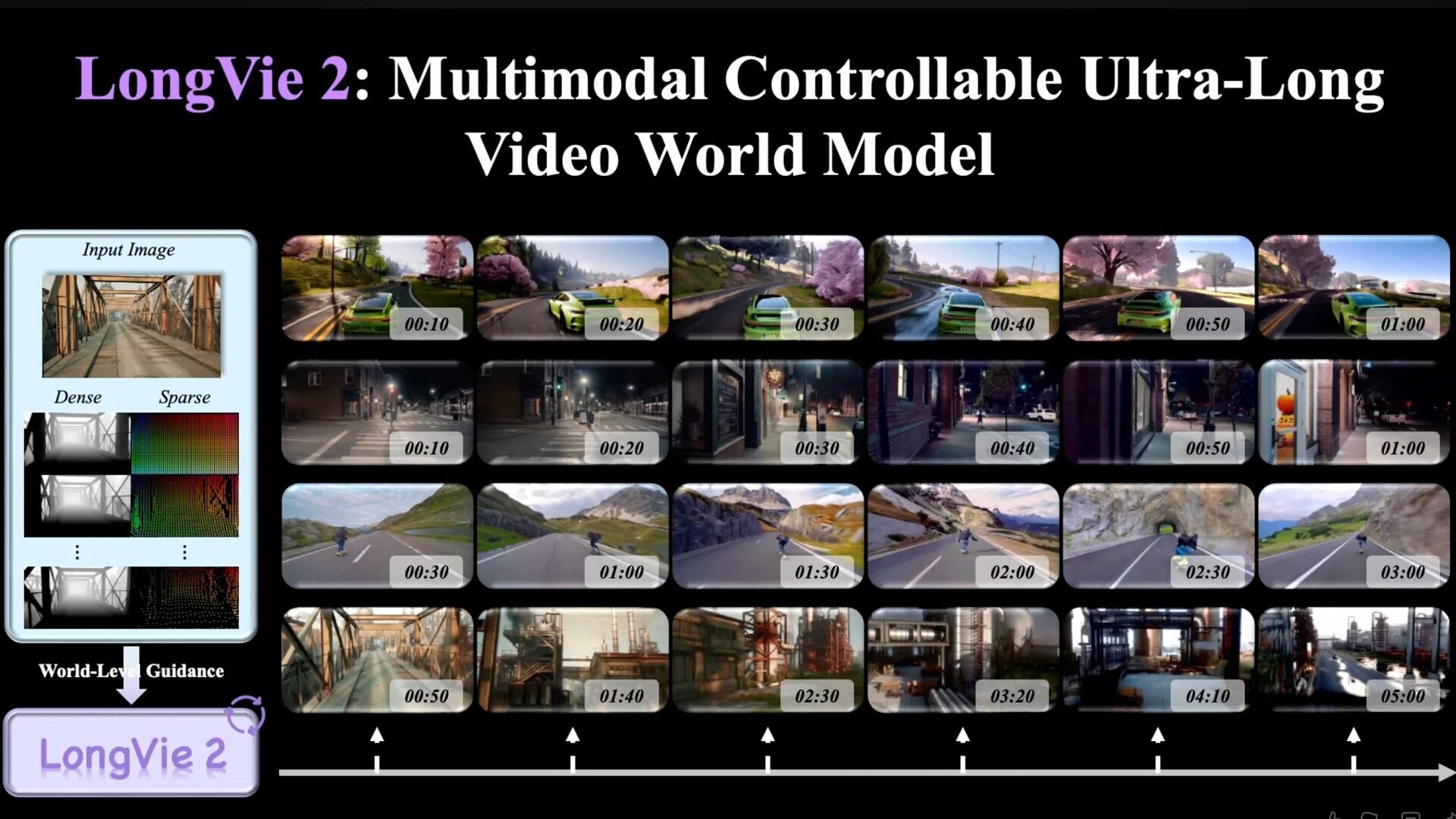

●NVIDIAら、最大5分間生成可能な世界モデル「LongVie 2」公開! ユーザー制御性、長時間生成における品質劣化防止、一貫性の確保

復旦大学、南洋理工大学 S-Lab、NVIDIA、清華大学、上海AIラボ、南京大学 PRLabからなる研究チームが、最大で3分から5分にわたる長時間の動画を生成可能なAIモデル「LongVie 2」を発表。GitHubではソース、Hugging Faceではウェイトが公開されているが、ライセンスについては不明。

https://cgworld.jp/flashnews/01-202601-LongVie2.html

●オープンソースのリアルタイム世界モデル「HY World 1.5(WorldPlay)」リリース! 720P・24fps、一人称と三人称の両視点をサポート

テンセントのHunyuanチームが、リアルタイム世界モデルフレームワーク「HY World 1.5 (WorldPlay)」を発表。オープンソース(TENCENT HY-WORLDPLAY COMMUNITY LICENSE)で公開した。720P・24fpsのリアルタイム生成、一人称と三人称視点をサポートし、フォトリアルな環境からスタイライズされた空想的な世界まで、多様なシーンの生成が可能。また、テキストプロンプトによって特定のイベントを発生させる機能を備え、世界を無限に拡張していく応用もできるとのこと。

https://cgworld.jp/flashnews/01-202601-HYWorld15.html

●3Dワールド生成モデル「Echo」発表! 独自の空間基盤モデルを用いて、メートル法ベースのジオメトリに裏付けされた物理空間の描画・編集を実現、クローズドβ中

SpAItialがテキストや1枚の画像から一貫性のある3D世界を生成する新モデル「Echo」を発表。Webデモでは3DGS(3D Gaussian Splatting)を採用し、低スペックな機材でもリアルタイムでジオメトリに裏付けされた空間の描画・編集、Webブラウザ上での自由な移動や探索を実現している。現在はクローズドベータ版の登録を受付中。

https://cgworld.jp/flashnews/01-202512-Echo.html