NVIDIA、スタンフォード大学、カリフォルニア工科大学、シカゴ大学、テキサス大学オースティン校からなる研究チームは12月24日(水)、数千種類のゲームをプレイ可能な汎用AI基盤モデル「NitroGen」を発表した。ゲーム画面のピクセル情報(視覚情報)のみを入力とし、コントローラの操作(アクション)を直接出力する「Vision-to-Action(視覚から行動へ)」型の基盤モデル。GitHubとHugging Faceでソースコード、学習済みモデル、データセットが公開されているが、コードとモデルは研究開発目的での利用に限定されているNVIDIA独自の非商用ライセンス(NVIDIA Source Code License-NC)が適用。データセットはCC BY-NC 4.0ライセンスで、こちらも非商用利用に限定されている。

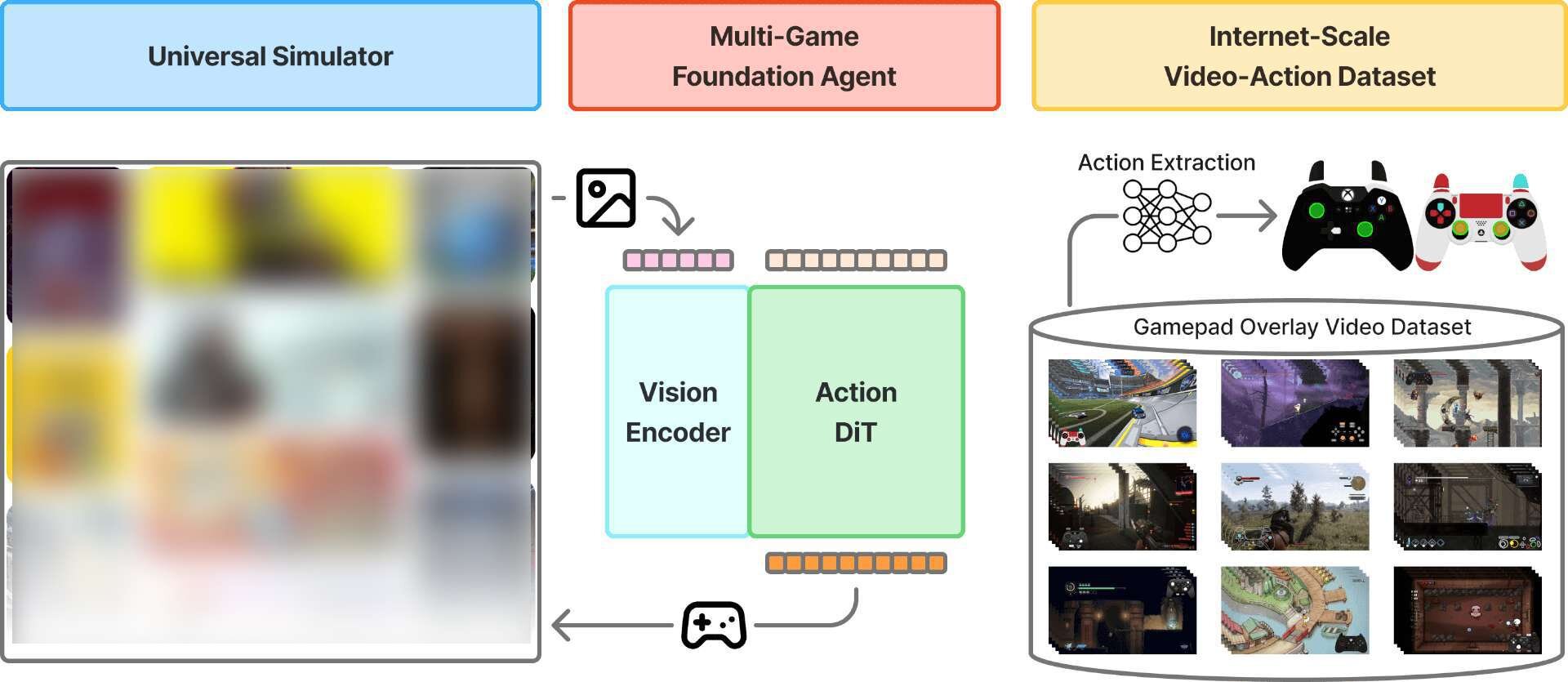

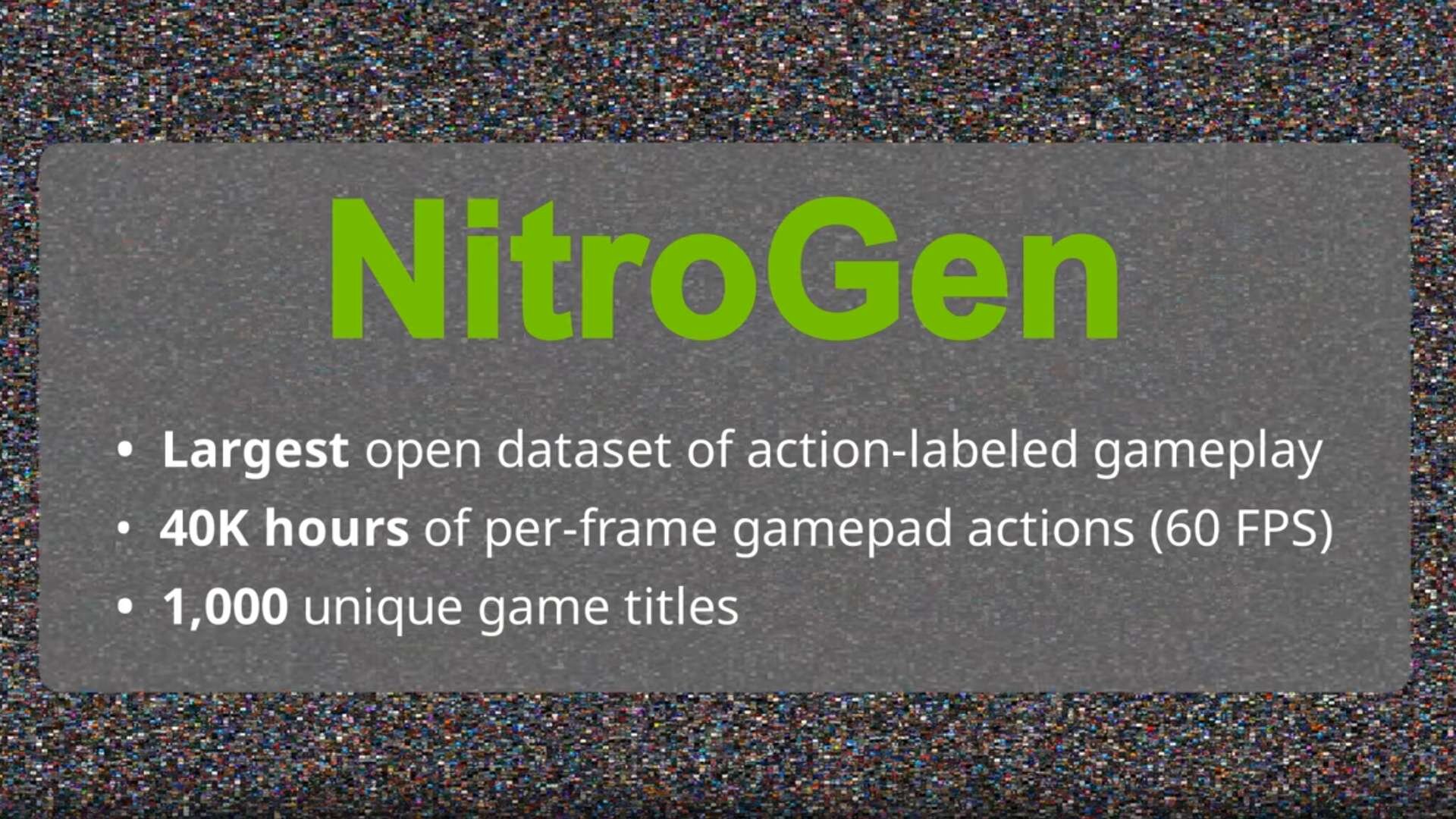

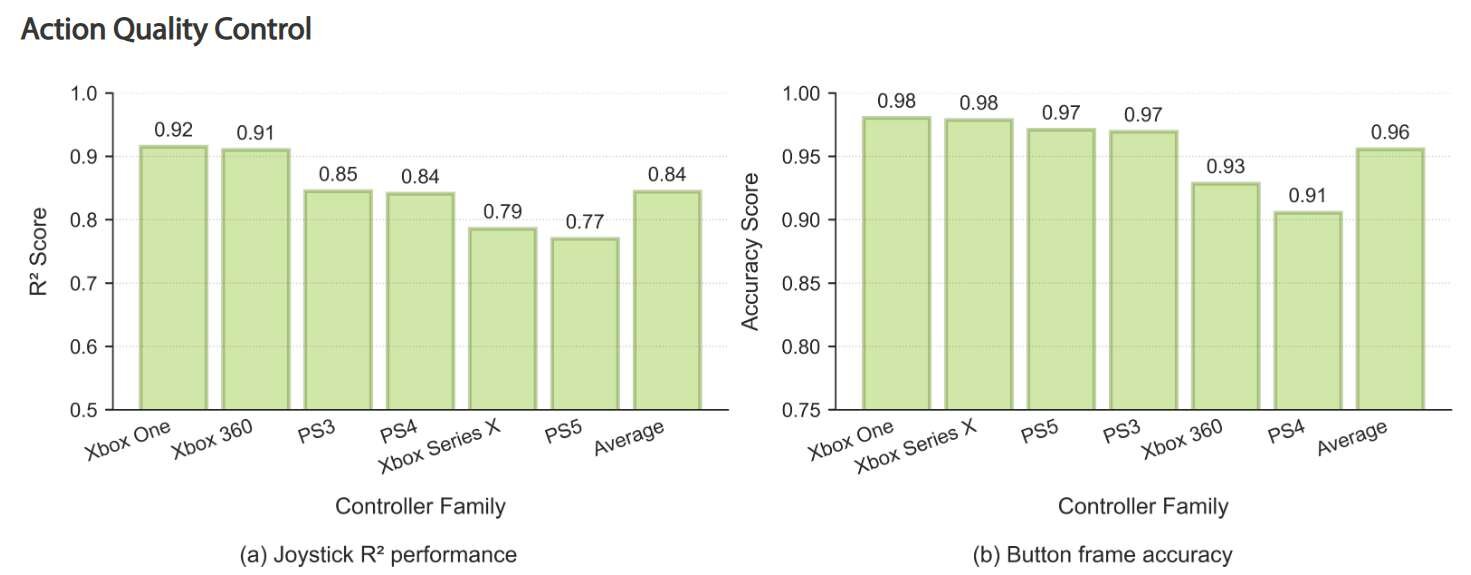

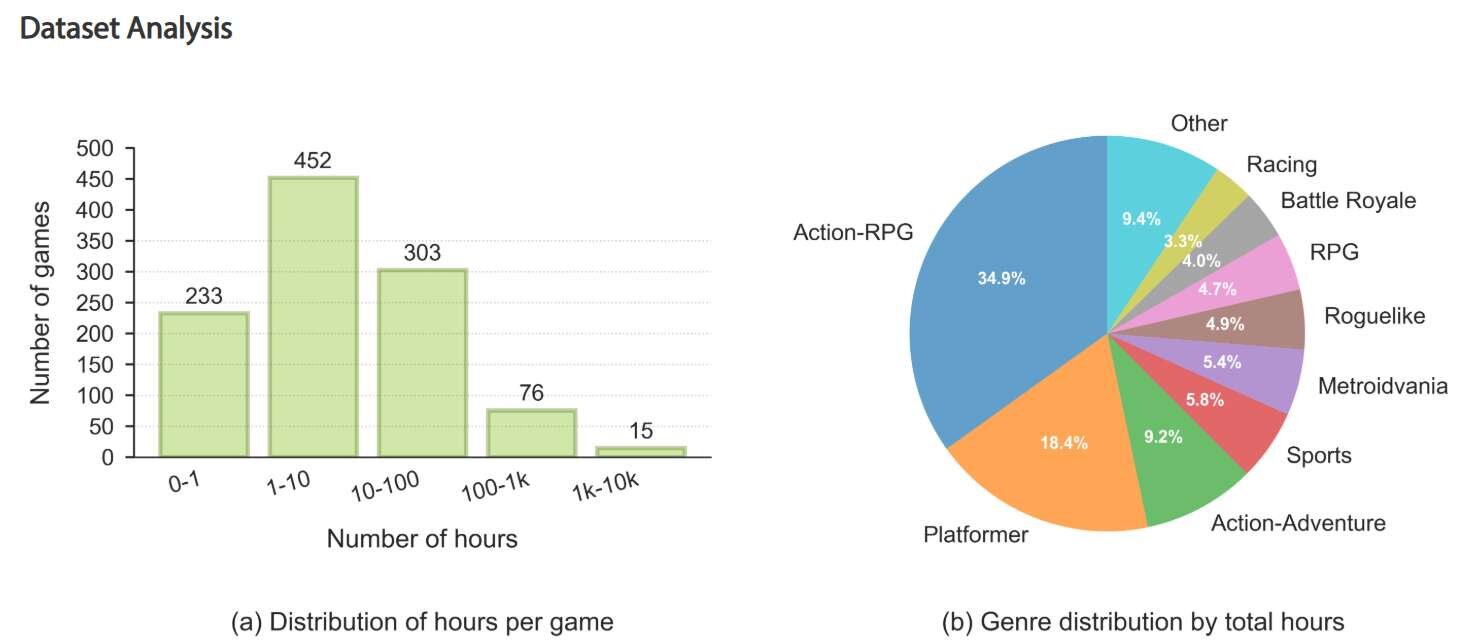

NitroGenは人間と同じように「画面を見る」ことだけで状況を判断し、適切なボタン操作を行うことができる、特定のゲームに依存しない汎用的な能力を獲得したAI基盤モデル。YouTubeなど、インターネット上に公開されている膨大なゲームプレイ動画、1,000以上の異なるゲームタイトルを含む約40,000時間分のゲームプレイ動画を収集し、これらを学習データとして利用している。各動画からは、画面上に表示されるコントローラの入力表示(オーバーレイ)を解析し、プレイヤーがどのタイミングでどのボタンを押したかというラベル情報を自動的に抽出・付与する手法を開発した。この大規模なデータセットを用いて、AIに人間の振る舞いを模倣させる「行動模倣(Behavior Cloning)」という手法で学習を行っている。

NitroGenはまた、学習に含まれていない全く新しいゲームに対しても、少量のデータで追加学習(ファインチューニング)を行うことで、高いパフォーマンスを発揮することが確認されている。実験では、3Dアクションゲームや2Dプラットフォーマー、迷路探索など、ジャンルの異なる多様なゲームにおいて、ゼロから学習させたモデルと比較して最大で52%高いタスク達成率を記録したという。

■NitroGen: A Foundation Model for Generalist Gaming Agents(プロジェクトページ、英語)

https://nitrogen.minedojo.org/

■NitroGen: A Foundation Model for Generalist Gaming Agents(GitHub)

https://github.com/MineDojo/NitroGen

■NitroGen: A Foundation Model for Generalist Gaming Agents(Hugging Face)

https://huggingface.co/datasets/nvidia/NitroGen

CGWORLD関連情報

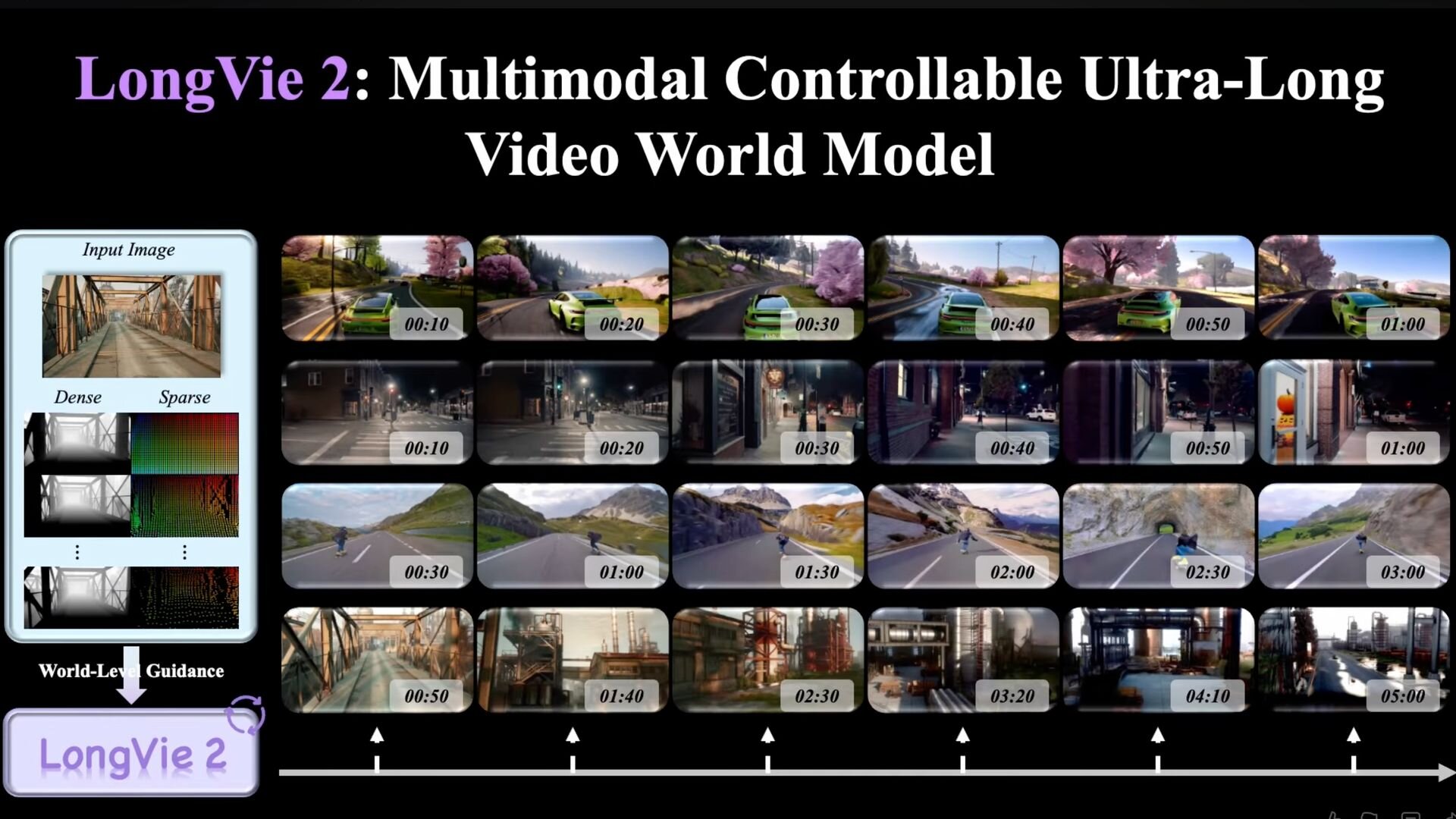

●NVIDIAら、最大5分間生成可能な世界モデル「LongVie 2」公開! ユーザー制御性、長時間生成における品質劣化防止、一貫性の確保

復旦大学、南洋理工大学 S-Lab、NVIDIA、清華大学、上海AIラボ、南京大学 PRLabからなる研究チームが、最大で3分から5分にわたる長時間の動画を生成可能なAIモデル「LongVie 2」を発表。GitHubではソース、Hugging Faceではウェイトが公開されているが、ライセンスについては不明。

https://cgworld.jp/flashnews/01-202601-LongVie2.html

●オープンソースのリアルタイム世界モデル「HY World 1.5(WorldPlay)」リリース! 720P・24fps、一人称と三人称の両視点をサポート

テンセントのHunyuanチームが、リアルタイム世界モデルフレームワーク「HY World 1.5 (WorldPlay)」を発表。オープンソース(TENCENT HY-WORLDPLAY COMMUNITY LICENSE)で公開した。720P・24fpsのリアルタイム生成、一人称と三人称視点をサポートし、フォトリアルな環境からスタイライズされた空想的な世界まで、多様なシーンの生成が可能。また、テキストプロンプトによって特定のイベントを発生させる機能を備え、世界を無限に拡張していく応用もできるとのこと。

https://cgworld.jp/flashnews/01-202601-HYWorld15.html

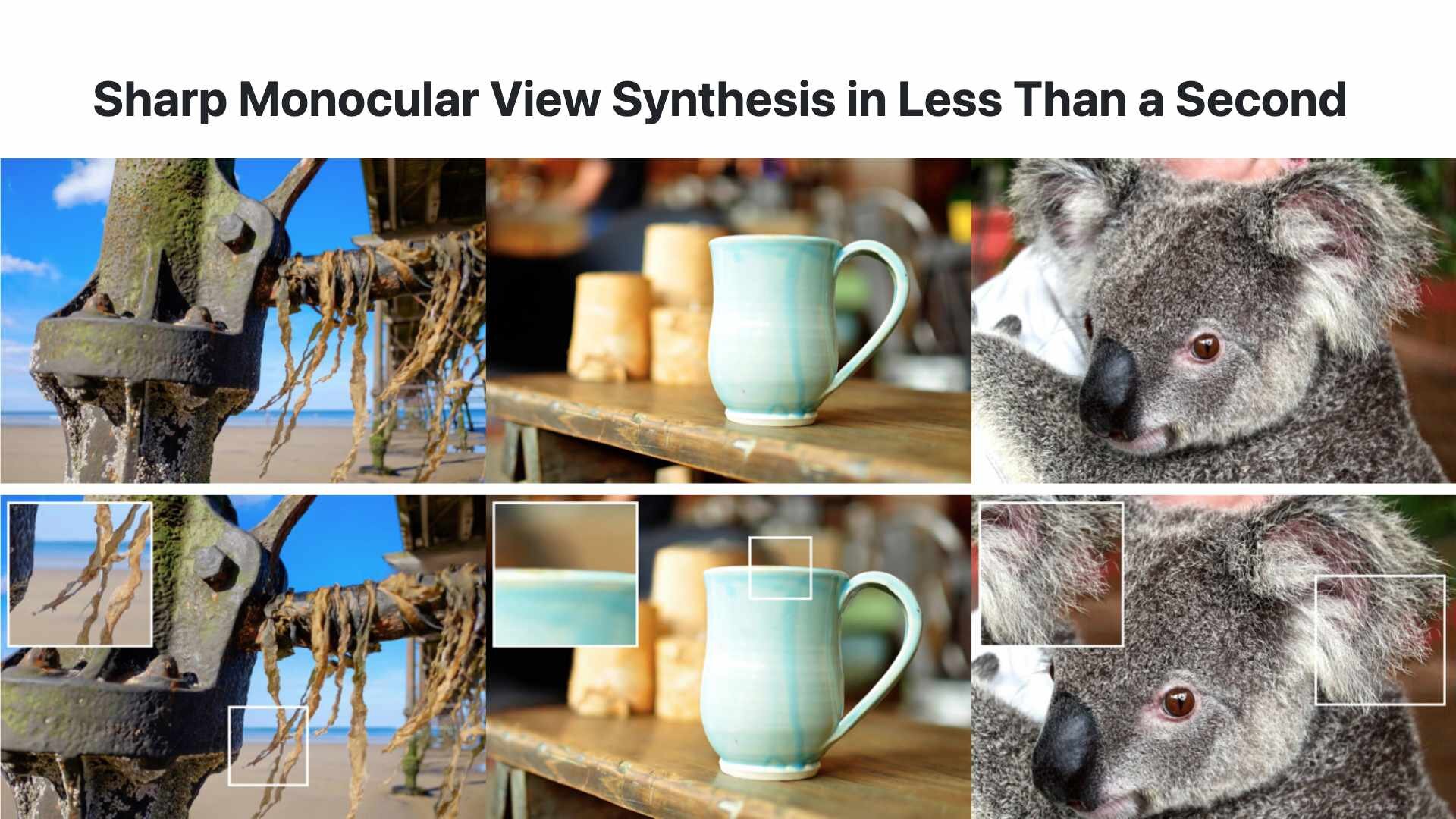

●Apple、単一画像から高品質な3DGSを生成する技術「SHARP」公開! 一般的GPU環境で高速3Dシーン構築可能

Appleが1枚の静止画から高品質な3D表現を瞬時に生成する新たな技術「SHARP(Sharp Monocular View Synthesis in Less Than a Second)」を公開。コードとモデルウェイトはGitHubとHugging Faceで公開されており、それぞれApple独自ライセンスの下で提供される。

https://cgworld.jp/flashnews/01-202601-SHARP.html