Meta社は10月4日(金)、動画生成AI「Meta Movie Gen」を発表し、ブログ記事、論文、機能紹介ページを公開した。Text to Video、サウンドの生成、動画のアレンジ(編集)、Image to Videoに対応するモデルとなり、生成される動画については、「業界初、異なるアスペクト比の長尺高精細ビデオを生成可能」だという。なおMeta Movie Genはまだ発表のみで、ユーザーが利用することはできない。

Meta Movie Gen is on the scene! Our breakthrough generative AI research for media enables:

— Meta (@Meta) October 4, 2024

-turning text into video

-creation of personalized video

-precision video editing

-audio creation

And while it’s just research today, we can’t wait to see all the ways people enhance… pic.twitter.com/I4Bq9if3eK

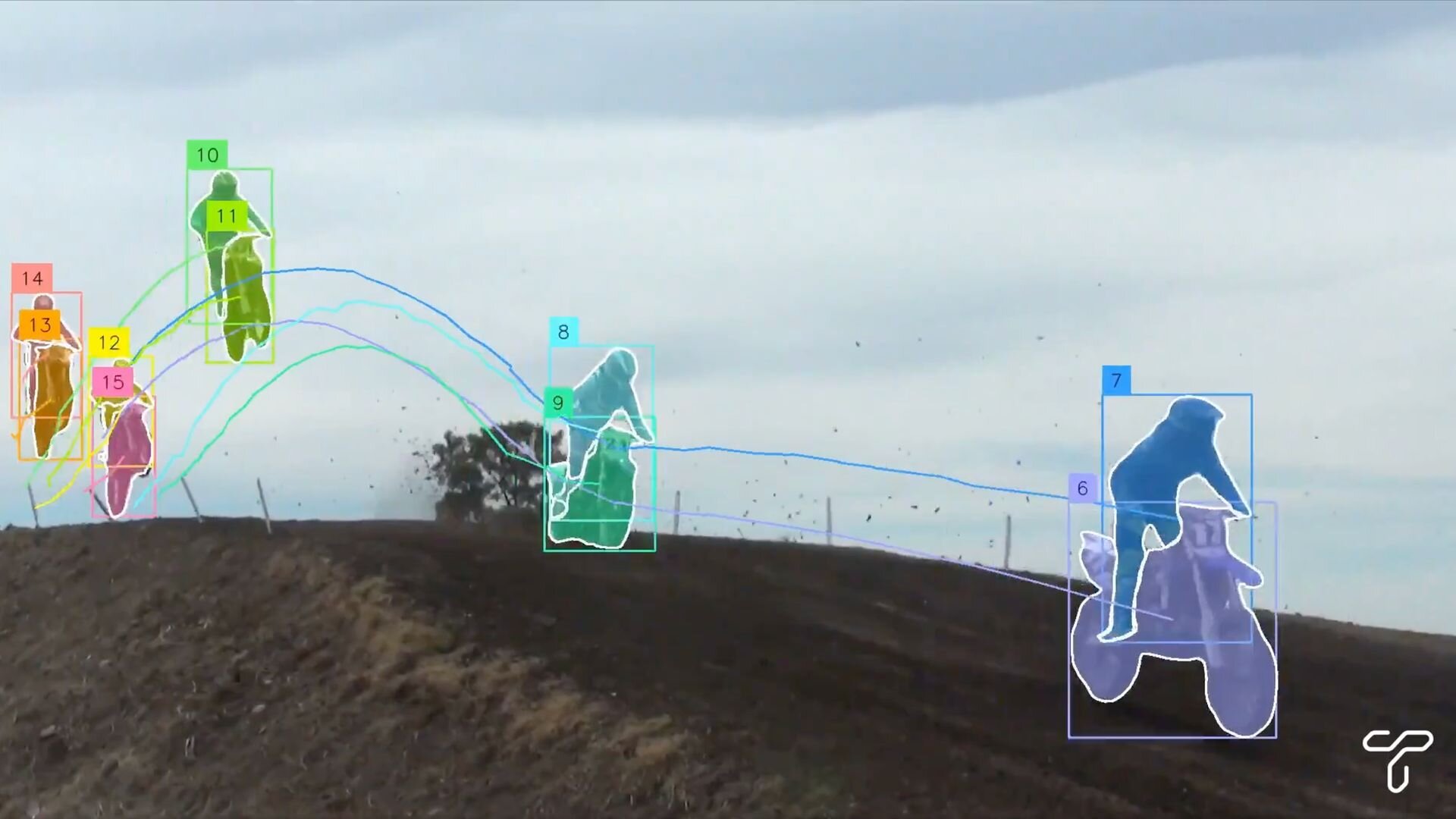

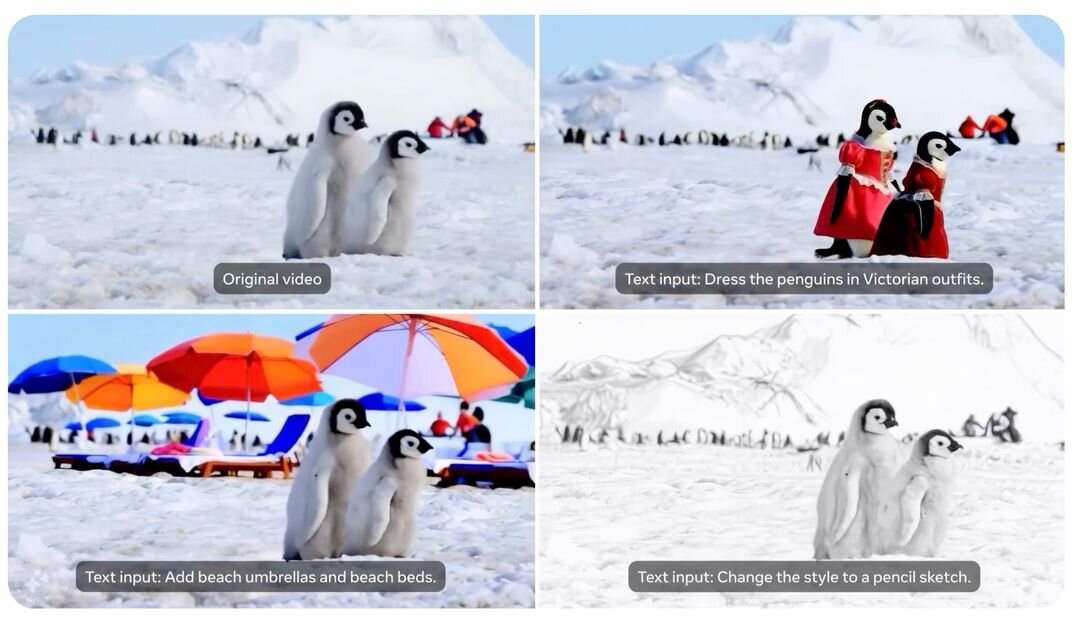

Meta Movie Genは、スタイルやトランジションなどをテキスト入力して、既存の動画をアレンジする機能も備える。キャラクターに持ち物を持たせたり、コスチュームを変更したり、背景のシーンを変更したりといった指示が可能だ。

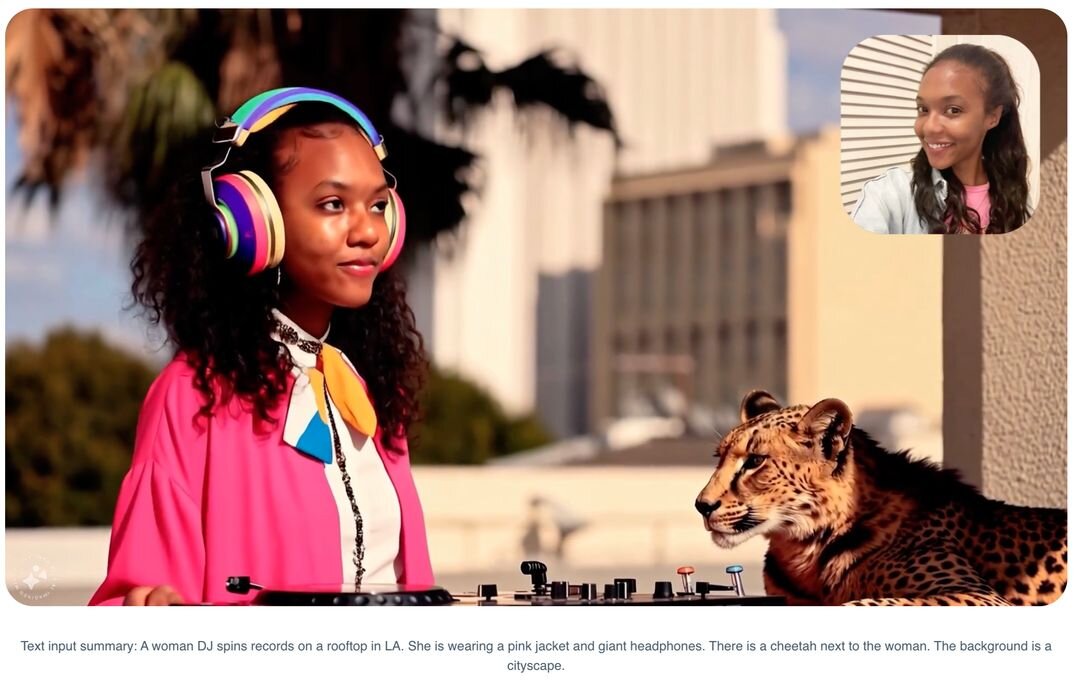

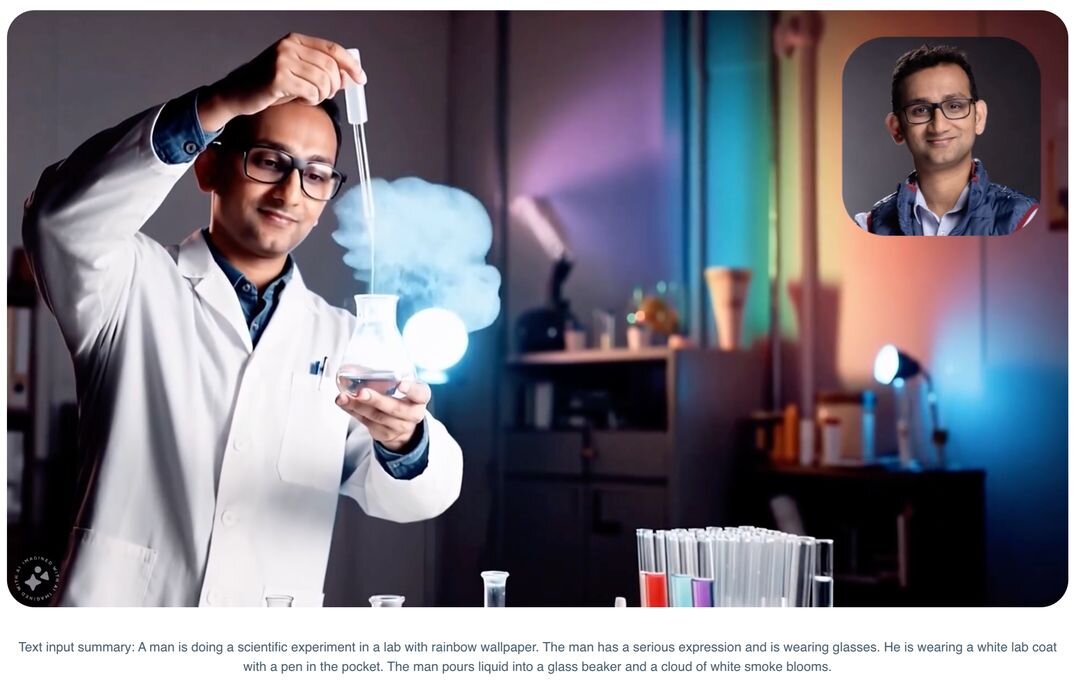

Image to Videoでは、「人間のアイデンティティと動きを保持したパーソナライズド・ビデオを生成」できるという。

さらにMeta Movie Genでは、動画に対して環境音・効果音・インストゥルメンタルBGMを付与できる。テキスト入力に沿って、動画と一貫性のあるサウンドを最大45秒生成可能とのことだ。下図のサンプルでは、壮大な劇伴BGMをバックに、崖と人物に激しく降り注ぐ雨音が違和感なく鳴っている。

MetaのAIリサーチチームはブログ記事内で、今回のMeta Movie Genを生成AI研究の「第3の波」と位置付けている。

Our first wave of generative AI work started with the Make-A-Scene series of models that enabled the creation of image, audio, video, and 3D animation. With the advent of diffusion models, we had a second wave of work with Llama Image foundation models, which enabled higher quality generation of images and video, as well as image editing. Movie Gen is our third wave, combining all of these modalities and enabling further fine-grained control for the people who use the models in a way that’s never before been possible.

我々の生成AI研究の最初の波は、画像・音声・動画・3Dアニメーションの作成を可能にするMake-A-Sceneシリーズのモデル(2022)で始まりました。拡散モデルの出現によって我々は、より高品質な画像・動画の生成と画像編集を可能にするLlama Image foundationモデル(2023)で第2の波を迎えました。Movie Genは第3の波です。モデルの利用者がこれら全ての様式を組み合わせて、これまでにない方法でさらにきめ細かに生成をコントロールできます。

■Meta Movie Gen公式ページ

https://ai.meta.com/research/movie-gen/

■ブログ記事:How Meta Movie Gen could usher in a new AI-enabled era for content creators

https://ai.meta.com/blog/movie-gen-media-foundation-models-generative-ai-video/

■論文:Movie Gen: A Cast of Media Foundation Models

https://ai.meta.com/static-resource/movie-gen-research-paper

CGWORLD関連情報

●Meta、3Dモデル生成AI「Meta 3D Gen」発表! テキストプロンプトから3DモデルとPBRテクスチャを高速生成、テクスチャ再生成による複数モデルのルック統一も

Meta社がText to 3Dの生成AI技術「Meta 3D Gen」の論文を同社Webサイトに発表。

https://cgworld.jp/flashnews/202407-meta3dgen.html

●動画生成AI「Pika 1.5」リリース! 新機能のPikaffectsで爆発・溶解・押しつぶしなどを手軽に適用、シネマティックショットにも対応

Mellis社が動画生成AI「Pika 1.5」をリリース。AIモデルがアップデートされ、6種類のユニークな効果をプロンプトなしで適用できる「Pikaffect」が利用できるようになったほか、映画『マトリックス』で知られるバレットタイム撮影やクレーンショットなどのシネマティックショットにも対応する。

https://cgworld.jp/flashnews/202410-Pika15.html

●Adobeが動画生成AIモデル「Firefly Video Model」ベータを今年後半にリリース! Premiere Proへの機能組み込みを予定、商用利用でも安全な設計である点を強調

Adobeは動画生成AIモデル「Firefly Video Model」のベータバージョンを2024年後半にリリースすることを発表、同モデルによる生成サンプルなどを公開した。

https://cgworld.jp/flashnews/202409-FireflyVideo.html

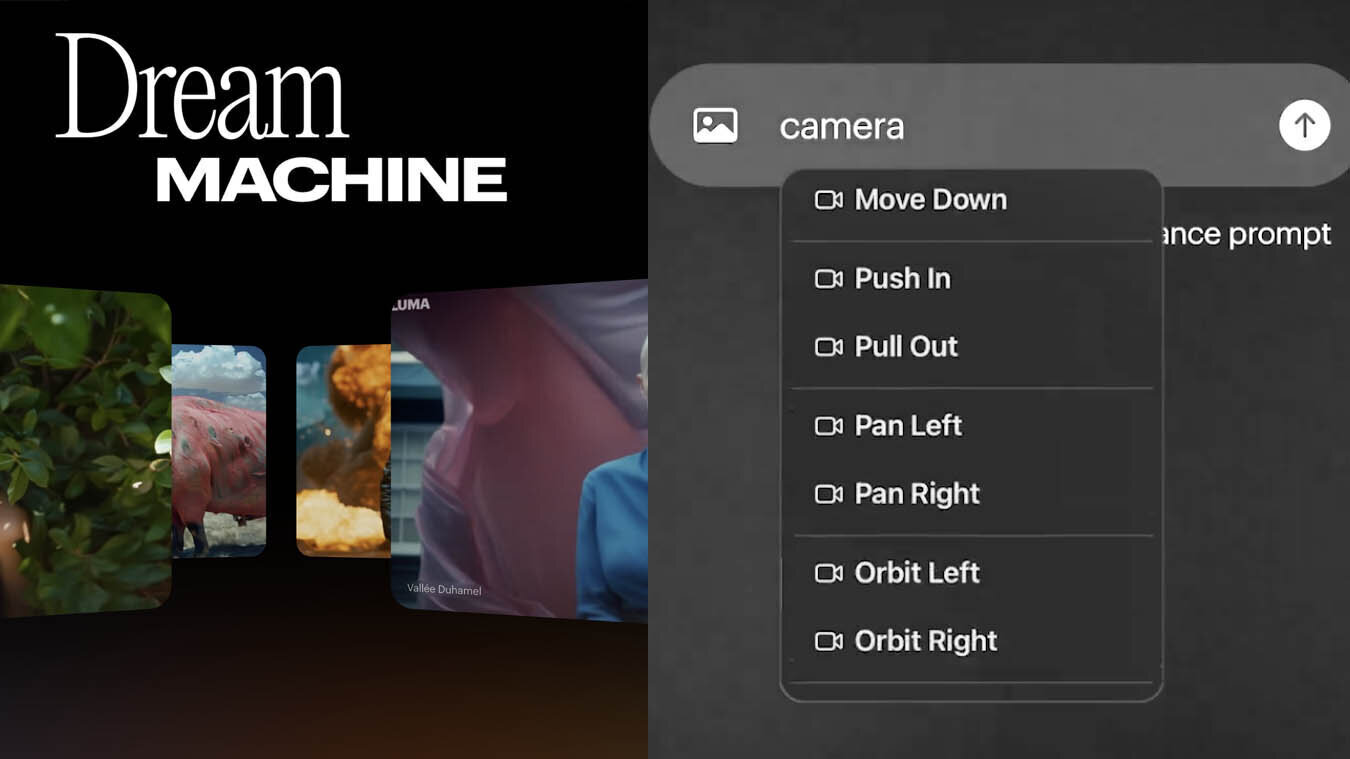

●Luma AIの動画生成AI「Dream Machine 1.6」リリース! カメラモーションのコントロールに対応、v1.5ではカスタムテキストのレンダリングにも対応

Luma AI社は動画生成AI「Dream Machine」の最新バージョン1.6を一般公開。Text-to-VideoとImage-to-Videoのどちらでも、テキスト入力のサジェストからカメラモーションの指示が行えるようになった。

https://cgworld.jp/flashnews/202409-DreamMachine.html