知覚AIから生成AI、そしてエージェント型AIへとAIが驚異的なスピードで進化を続けている。その原動力が、NVIDIAの先進的なテクノロジーとソリューションであることは明白だ。「なぜ、NVIDIAが選ばれるのか?」日本を代表するバーチャルヒューマンAIカンパニーAww代表の守屋貴行氏に、 NVIDIAとの技術提携のねらいと、今後の展望を聞いた。

Awwプロデュースのバーチャルヒューマンが、魅力的なわけ

——Awwは、日本の企業としてはいち早くバーチャルヒューマン(VH)の研究開発 、実用化に取り組まれました。その理由を改めて教えてください。

守屋貴行氏(以下、守屋):

大きくは外的要因と内的要因の2つがあります。まずは外的要因。僕は映像プロデューサーからキャリアをスタートさせましたが、当時から映像ビジネスに変革期が訪れたことを実感していました。

SNSが台頭してきたことで個人がメディアになっていく。そして、個人が発信するニッチなコンテンツによって全てのコミュニティが形成されていくはず。それと相まって仮想通貨の登場でブロックチェーンが台頭していくだろうと、2014〜2015年頃に予想しました。

そうなったときにコンテンツ制作の効率化、最適化する上ではAIが必須になるはずだと考えたのです。

内的要因については、映像プロデューサーとして特に3DCG技術に着目していました。Awwを設立する以前からフォトリアルなどのハイクオリティなデジタルヒューマン表現に取り組んでいく過程でゲーム開発 の技術が応用できるのではないかと研究開発を続けてきたことから、アジア初のVH「imma」が誕生しました。

守屋貴行/Takayuki Moriya

Aww inc.代表取締役社長。1983年生まれ、神奈川県出身。

映像プロデューサーとしてキャリアをスタートさせた後、AR、VR、XR事業、AIエンタメ開発、5Gコンテンツ制作など多岐に渡って携わる。2018年にimmaらアジア初のバーチャルヒューマンを創造し、Aww(アウ)を設立。創業1年足らずで60カ国以上、8,000以上のメディアに掲載され、Virtual Human事業を確立させる。

https://aww.tokyo/

——immaは、デビュー当初から数多くの広告や雑誌モデルに起用され続けていて、昨年は「TED Talks」にも登壇されましたね。AwwがプロデュースするVHが支持される理由を教えてください。

守屋:

VHをコンテンツIPとして展開していく上では、「アート・デベロップメント」、「プロデュース」、「ストーリーテリング」という3つの要素を上手く連携させることが重要です。

アート・デベロップメントは、テクノロジーとも言い換えられる3DCGを中心とするVHの造形や動作など実際の見え方に関わる要素です。

それに対してプロデュースとストーリーテリングは、VHの内的な要素と言えます。VHは、キャラクターモデルをつくれば完成とはなりません。Awwはハイエンドな映画やゲームの開発実績をひとつの武器にしていますが、テクノロジー自体で勝負したのでは、それこそNVIDIAさんのような巨大企業には絶対にかないませんから。

Awwでは、テクノロジーに加えてVHひとりひとりの個性を活かしたプロデュース、ストーリーテリングにも力を注いでいることが支持していただけるのだと思っています。

NIMマイクロサービスのおかげで開発効率とスピードが向上

——昨年6月17日付でNVIDIAとの技術提携を発表されました。どのような経緯で実現したのですか?

守屋:

実は以前にもNVIDIAさんから技術提携のご提案をいただいたことがありました。ただ、そのときは3DCGなどのAI以外の研究開発に注力していた時期だったためこちらからお断りしたんです......。

ですが、Awwを設立する以前からVHを発展させていく上ではAIテクノロジーが重要になるはずだと確信していました。

そうしたなか、昨年1月に「NVIDIA Avatar Cloud Engine(ACE)」(※AIを活用したインタラクティブなデジタルキャラクター(アバター)を開発・デプロイするためのマイクロサービスプラットフォーム)が発表され、生成AI推論のための「NVIDIA NIMマイクロサービス」として利用できるようになったタイミングで改めてお話をいただき、実現したのです。以前にお断りしてしまったにもかかわらず、本当にありがたかったですね。

——ACEを導入したことで、どのような恩恵を得ることができましたか?

守屋:

開発効率と実装するまでのスピードを大幅に向上させることができました。

Awwでは2023年から対話型AIの開発に取り組んでいるのですが、NIMのひとつ「Audio2Face」を利用することによって、昨年11月12・13日に開催された「NVIDIA AI Summit Japan」にて「AI imma」を英語だけでなく、日本語でもリアル タイムで会話可能なかたちで初披露することができました。

AIの基盤は、社内に持っているのですが、3DCGとAIをかけ合わせるテクノロジーという意味では、NVIDIAのサービスを利用することによって最短ルートで到達できると思います。開発では、同じくNIMマイクロサービスとしてRiva ASR(自動音声認識)とTTS(音声合成)、NeMOのLLM(大規模言語モデル)やRAG(検索拡張生成)なども利用できたりと、汎用性の高さはさすがNVIDIAだなと。AI関連のテクノロジーが自分たちのような規模感でも導入しやすくなりましたね。

——AIにリアルタイムで会話させるには、英語よりも日本語の方が難しいのでしょうか?

守屋:

そうですね。実のところ、昨年11月に初披露したAI immaは、僕の中では100点満点中50点ぐらいです。英語版に比べると口の動きやライティングなどの質感に課題が残っています。同じLLMでも英語と日本語では、データ量が全然違うことにも起因します。TTSの精度なども明らかに差があるので。

ただ、日本語の精度も改良が進んでいるので、時間の問題だと思います。また日本人の喋り方は、アメリカ人など英語圏の人に比べると目や口の動きが少ないといったちがいがありますし、自然な会話という点では反応が早すぎても相手が話している途中に話し出してしまうと不自然になってしまいます。そうしたことを考慮しながら改良を重ねていく予定です。

NVIDIAが提供する開発環境を利用することで、より積極的に新たなチャレンジができる

——AIテクノロジーを取り入れることによって、VHの活躍フィールドはどのように広がっていくとお考えですか?

守屋:

自社によるVHのIP展開と、他社との協業によるVHのIP展開の2軸で考えています。まず自社の展開では、AIテクノロジーをさらに利用していくことでコンテンツの制作数とバリエーションを急速に増やしていけるはずだと考えています。

最近、自社スタジオでキャプチャしたモーションをUnreal Engineに読み込んで作成したショート動画をimmaのTikTokで投稿し始めました。こうしたコンテンツの制作にAIを利用することで、本格的なモーション キャプチャではなく、アーティストがスマホで自撮りしたムービーを素材にした場合でもハイクオリティに仕上げられるようになるはずです。コンテンツ自体の作業効率を高められれば、その分、プロデュースやストーリーテリングというAwwの強みへさらに力を注げるようにもなります。

——制作効率という意味では、生成AIへの関心が高まっているように感じます。それについてはどのようにお考えですか?

守屋:

Awwでは、当初からフォトリアルな表現に注力しているため、3DCGモデルをはじめオリジナルのデータをベースにつくることにこだわっています。

IP化させる上では著作権などの各種権利を自分たちで持てるようにすることも必須ですが、生成AIをベースにした場合、その点に課題が残っているので、そうした意味でもオリジナルデータの重要度がより高まっていくのではないでしょうか。

——ありがとうございます。他社との協業によるIP展開についてもお聞かせください。

守屋:

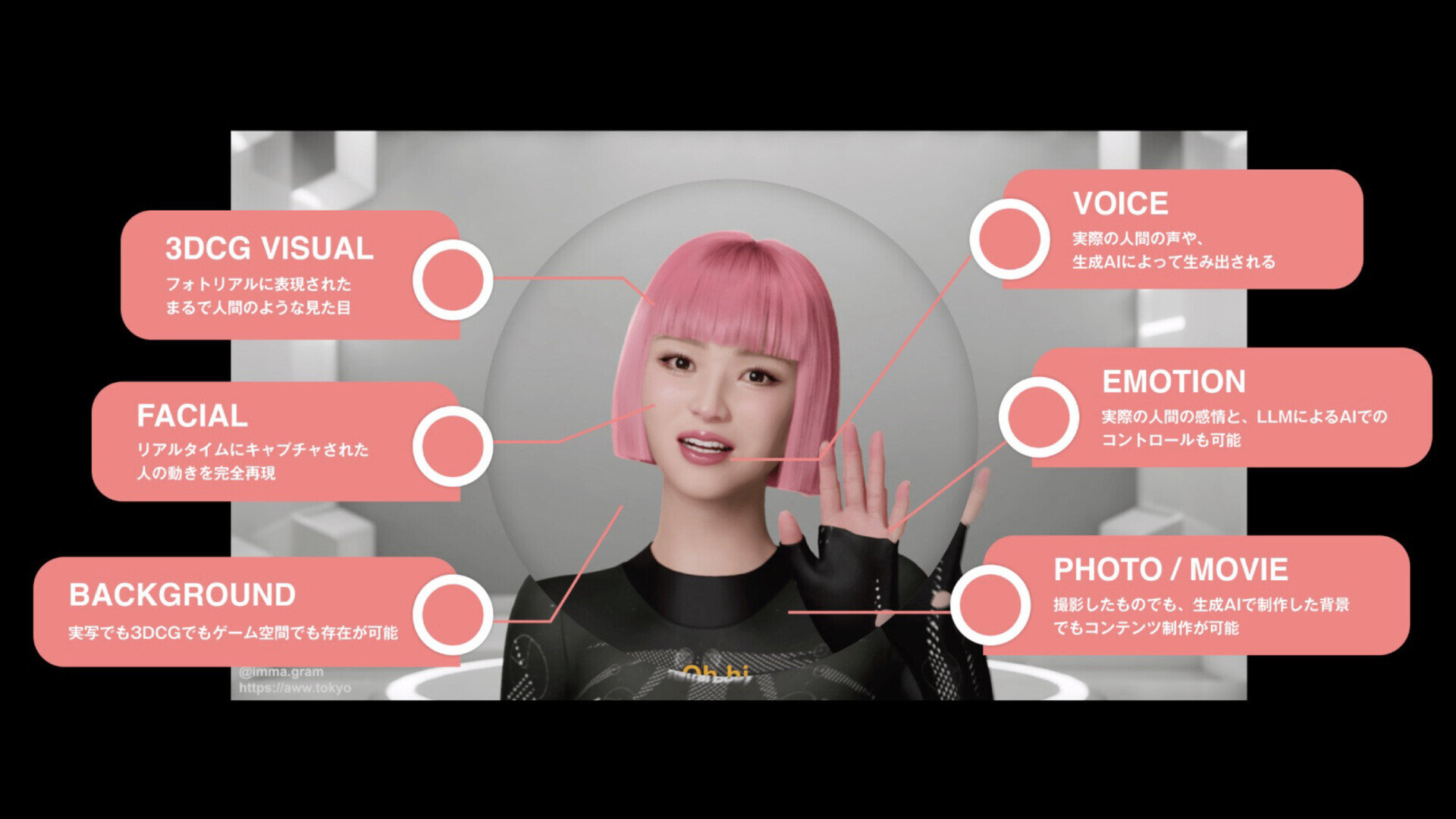

NVIDIAさんとの技術提携という大きな後押しを受けて、「MASTER MODEL®」の本格運用を始めました。これは、過去10年間の研究開発を通じて培われた知識と技術をひとつのマスターデータに集約したVH開発のための包括的な技術基盤になります。

MASTER MODEL®を利用することで、3Dスキャンを使わずにビジュアルのリファレンスから高品質なキャラクターを効率的に開発できるようになります。今までよりも低コストでハイクオリティなVHを社外にも提供していく計画です。

よく「専門的な技術スタッフが必要ですか?」的なことを聞かれるのですが、すでにMASTER MODEL®を利用して、クライアントさん側ではスマホ1台とPC1台を用意してもらうだけでVHを運用できるシステムを提供するといったことも行なっています。

個人や小規模でも利用しやすいものへ。NVIDIAのAIテクノロジー

NVIDIAは、エンタープライズ生成AIのためのソフトウェアプラットフォーム「NVIDIA AI Enterprise」を、より幅広い開発規模と開発環境で利用できるようにするための多種多様なサービスを積極的に展開している。デジタルヒューマン関連の注目トピックを紹介しよう。

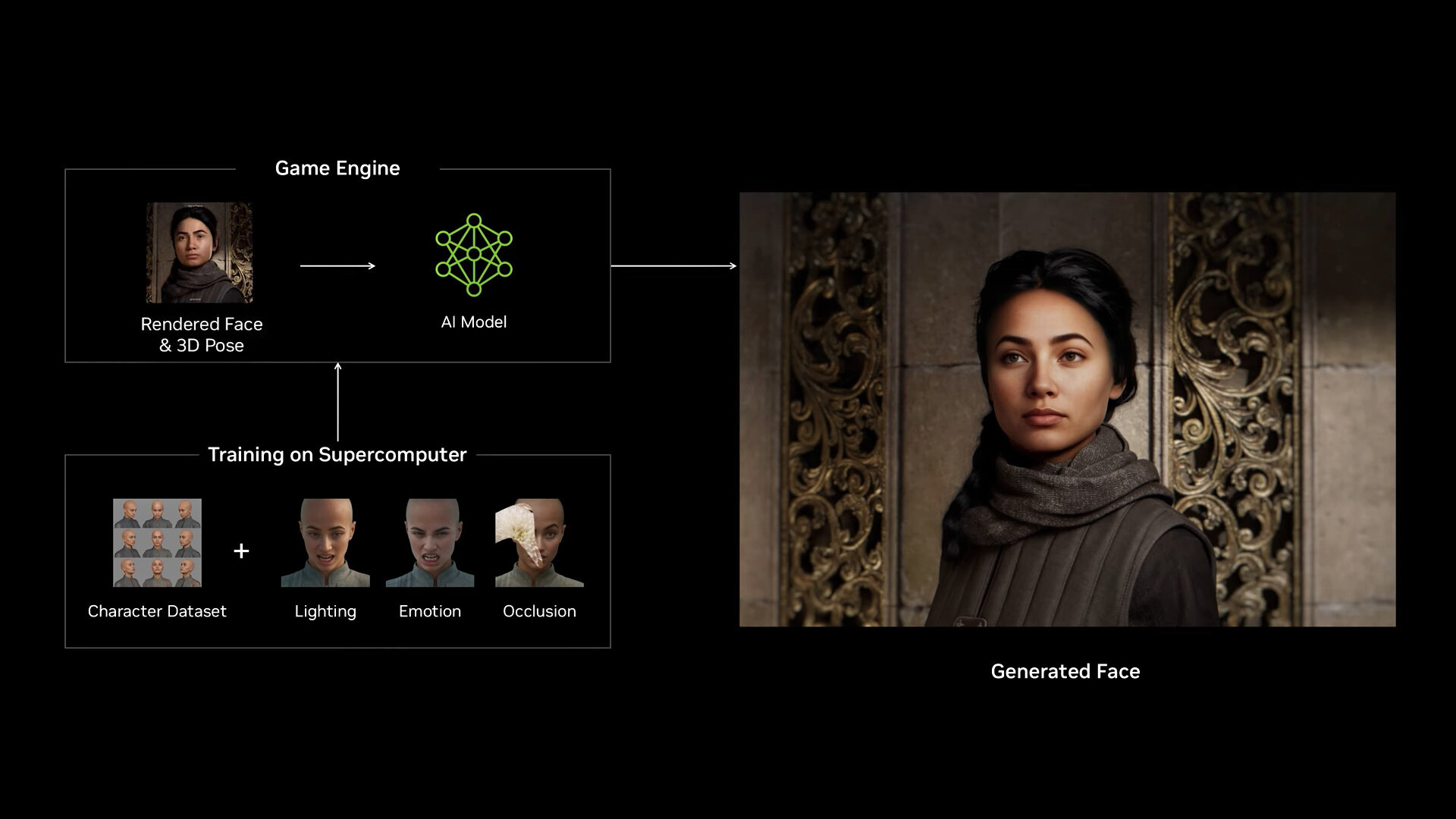

最新世代の「Blackwell」GPUアーキテクチャで「AIシェーダ」を導入

「CES 2025」で発表されたNVIDIA GeForce RTXˇ 50シリーズでは、GPUアーキテクチャをBlackwell世代に刷新。AIシェーダ「RTX Neural Shader」が新たに導入された。

従来のプログラマブルシェーダにリアルタイムのAIネットワーク処理を加えた技術であり、リアルタイムのデジタルヒューマン表現においても、映画品質のマテリアルやライティングなどが実現できるようになった。またBlackwellでは、機械学習によるフレーム生成機能が「DLSS 4」にアップデートされ、従来のレンダリング処理に比べて最大8倍のパフォーマンス向上も実現させた 。

NVIDIA ACEで実現できる自律型キャラクター

https://build.nvidia.com/nvidia/audio2face-3d

2Dポートレートと音声データからの2Dフェイシャル生成

https://build.nvidia.com/nvidia/audio2face-2d

デジタルヒューマンとの会話デモ

https://build.nvidia.com/nvidia/digital-humans-for-customer-service

RTX Neural Shaderの具体例が「RTX Neural Face」である。ラスタライズされたシンプルなフェイシャルと3D ポーズのデータを入力として受け取り、生成AIを使用して、時間的に安定した高品質のリアルタイムフェイシャルアニメーションが実現できるため、対話型AIのVHクオリティを大きく向上させることが期待できる。

なお Audio2Faceは現在、音声データから3Dフェイシャルの生成と、2Dポートレート&音声データからの2Dフェイシャルの生成を試すことができる。さらにデジタルヒューマンのデモ「James(3Dキャラクター)」と「Aria(2Dキャラクター)」との会話を試すことも可能だ。

RTX AI搭載ワークステーションへの期待も高まる

https://www.nvidia.com/ja-jp/design-visualization/workstations/

CES 2025にて、RTX AI PC向けAI基盤モデルも発表された。これにより、NVIDIA NIMマイクロサービスとAI BlueprintがPC上で利用できるようになる。つまり、PCやワークステーション環境における、VHなどの3Dアバ ター開発環境が強化される わけだ。Blackwell搭載のワークステーションを導入することで、ローカル環境におけるVHの開発・利用が広まっていくことが期待される。

今後、ローカルLLMやSLMに有利な大容量メモリを搭載するプロフェッショナル向けRTX GPUを搭載したワークステーションが各メーカーから順次発売されていく。1台のワークステーションから、クラウドに依存しないスタンドアロンで対話も可能なVHが実現できるようになる。ゲームチェンジャーとなるVHの誕生にも期待したい。

INTERVIEW & TEXT_NUMAKURA Arihito

PHOTO_弘田 充 / Mitsuru Hirota