映像制作やアプリケーション開発において、クオリティ向上のためには開発効率とイテレーション回数を能動的に高めていく必要がある。チェックとフィードバックをループするのではなく、クリエイター同士が対話をしながら共同で作業を進めていくNVIDIA Omniverseは現状のワークフローを革新的に進める可能性を秘めている。USDベースの協業プラットフォーム「Omniverse Machinima」を用いた制作の未来についてカヤックアキバスタジオの2名に聞いた。

天野清之 氏

カヤックアキバスタジオ

取締役/クリエイティブディレクター

佐川卓也氏

カヤックアキバスタジオ

CGディレクター

カヤックアキバスタジオ

秋葉原を拠点に、メタバース・ゲーム・アニメといったエンターテイメントを技術力と発想力を強みに企画開発する総合エンターテインメント開発会社

https://akiba.kayac.studio/

コンカレントパイプライン思想に基づいた制作を推進

--カヤックアキバスタジオの業務内容を教えてください。

天野清之氏(以下、天野):カヤックアキバスタジオはカヤックのエンジニアチームと3D制作チームを統合した開発部隊を有しており、一般的なアニメーション制作フローにも、あるいはUnityやUnreal Engineを用いたリアルタイム映像制作の技術開発にも対応できるスタジオです。もともとはアプリケーション開発やプラットフォーム開発を得意とするエンジニアチームですので、高い開発力を武器とした組織になっています。

--カヤックアキバスタジオはゲーム開発などに長けている印象がありますが、3DCGに関連する業務も幅広く行なっているのですね。

天野:デジタルアニメ事業を2021年7月に設立しており、現在はARやVR、ゲーム開発のノウハウを活用したアニメーション制作に力を入れています。持ち前の研究開発技術を活かして、内製のバーチャルカメラ技術「ジャンヌ・ダルク」なども開発していて、これらを用いて高速かつ高クオリティな映像制作を行なっています。基本的にはリアルタイム中心で、コンカレントパイプラインの思想に則って開発を進めています。近年では『機動戦士ガンダム閃光のハサウェイ』などを手がけています。

--コンカレントパイプラインもウォーターフォール型の制作にも対応できるカヤックアキバスタジオから見て、従来型の制作ワークフローに課題を感じる部分はありますか?

天野:アニメ業界は、日本が長年築き上げてきたワークフローが根強く残っています。特に、プロデューサーやディレクターなどの立場にいらっしゃる方にこそ強く浸透しているように感じます。これらの課題という意味では、上流工程が詰まってしまうと下流工程に「待ち」が発生してしまう点は改善の余地が多分にありますね。一方において、「どこの部分を改善したら一番クオリティアップに近づくのか?」という判断は極めて難しいです。既存のアニメのつくり方でできていた、ある意味では職人芸的な「アニメにとって大事な要素」が、リアルタイム3DCGを用いたワークフローを取り入れたことで抜け落ちてしまうことへの抵抗感もあります。例えば『機動戦士ガンダム閃光のハサウェイ』でも、飛び抜けてクオリティが高い部分は職人技が多かったように思います。私たちはあくまでデジタルクリエイターですから、リアルタイムCGを用いたワークフローを推進する立場ですが、いちアニメファンとしては圧倒的な作画技術に基づく従来型の制作手法の文脈も大切にしたいと考えています。

--お互いのワークフローを尊重し合いながら、コンカレントパイプラインを推奨していく立場ということですね。

天野:ゲーム業界であれば、企画・脚本・演出など設計部分の作業もラインが同時に走ります。そして、そのラインの中でイテレーションが回っていて、結合して改善してというのをくり返しながら最終形に向かっています。他方、映像業界では出戻りがかなり難しいため、イテレーションを回すにも限界があります。さらに、監督側から見れば、優秀なクリエイターは「コンテから情報を汲み取ってつくる」ので、中身がブラックボックス化しやすいとも言えます。情報の汲み取り方は個々人によってちがいますから、可能であれば途中で対話を挟んで、少しでもリテイクを軽減した方が良いでしょう。トップダウン的なつくり方を好む監督もいますが、今の時代は知識や技術、考える範囲が広すぎて、生活の時間、ライフタイムを越えてしまう。だからこそお互いが何度も議論をして、双方のパフォーマンスを高めていくのが重要だと思います。

USDとOmniverseへの大きな期待

--Omniverseについて、事前の印象や期待感などを教えてください。

天野:私たちはウォーターフォール型のアニメ制作現場に高速なワークフローを導入することを大きな課題として捉えています。2016年頃から、Pixarの掲げるUSD思想への挑戦も行なっていて、私自身がカヤックアキバスタジオの役員になってからも調査・研究を続けていました。Omniverseの協業についても期待を寄せる立場で、監督とクリエイターの間で「もっとこうした方が良い」というディスカッションを気軽に行うことのメリットは大きいだろうと考えていました。また、これはOmniverseを実際に触ってわかったことですが、非常にGUIが直感的なんですね。あらゆるプロフェッショナルなDCCツールを使いこなす監督は少数ですが、Omniverseであれば誰でも直感的に使える上にクリエイターと直接的に対話ができます。これは、雰囲気を探るブレストやイメージ合わせの領域においても、大きなアドバンテージになります。

--Omniverse上で開発を進めるだけでなく、対話をベースにしたブレストも可能ということですね。

天野:今のアニメ制作とゲーム・アプリ制作では根本からワークフローが異なります。ウォーターフォール型では、お互いのアウトプットを見ながらその場でイテレーションを回したり、相乗効果的に高め合ったりすることができません。Omniverseは、これができるのが良いところです。コンカレントパイプラインにおいては、スケジュール的な利点はもちろん、リアルタイムに動かしてリアルタイムに議論することによるクオリティアップが大きな利点になると思います。対話の重要性という意味では 、今 は「1人の天才だけ」では成立しないような開発規模になっていますね。

--監督自らが作画をしていた時代とは異なると。開発規模の拡大化は、あらゆる文脈で語られています。

天野:例えばiPhoneはスティーブ・ジョブズ氏の成果物として考えられていますが、あれは工業製品としての完成物なのかデザインワークとしての完成物なのか、あるいはサービスとしての完成物なのか、切り分けが難しい商品だと思うんですね。ジョブス氏が基板開発から量産までを1人でできたわけではないはずです。でも、彼が細部まで指針を出していたからこそできたものだとは思います。私自身はイテレーションと対話を続けながら、概念的にはiPhoneのようなものづくりをやっていきたいと考えています。

NVIDIA Omniverseの技術を抽出した「Machinima」

--今回検証に用いたエンターテインメント分野向けの「NVIDIA Omniverse Machinima」についてご説明をお願いします。

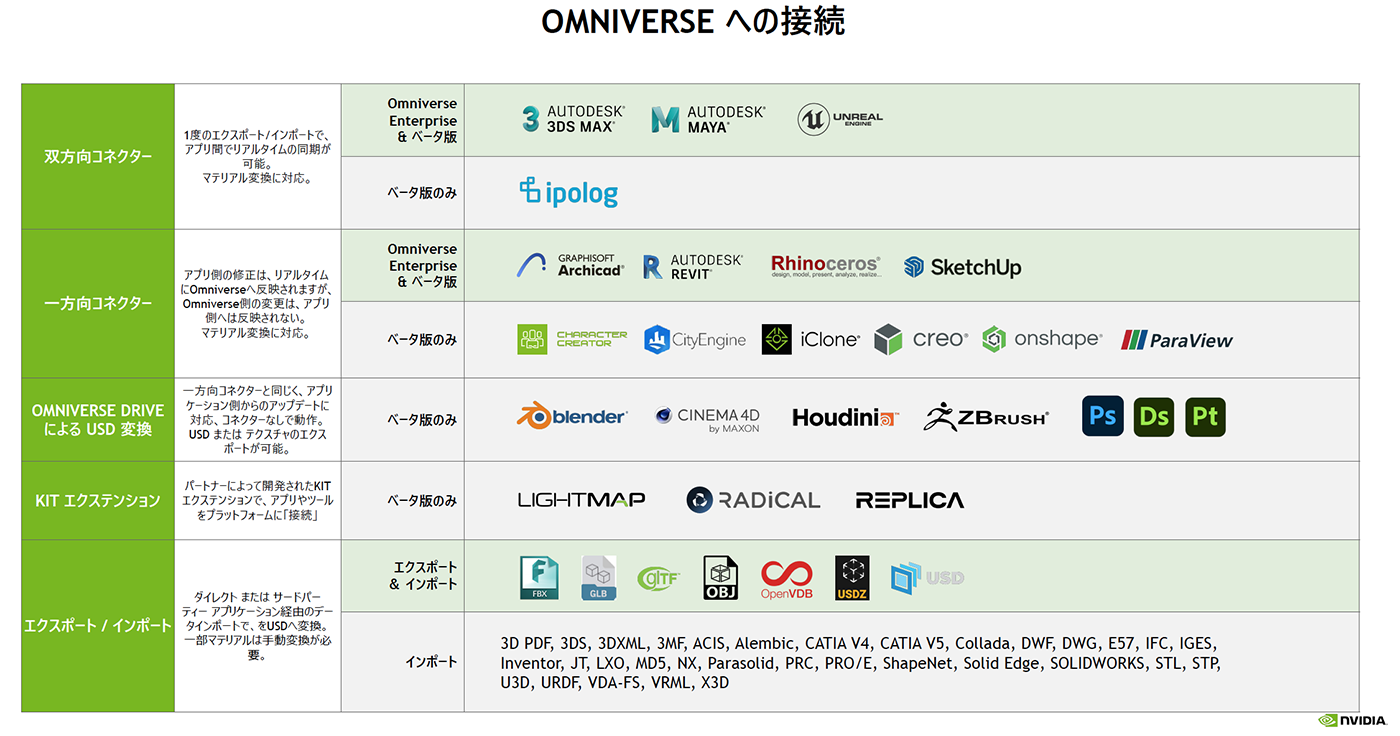

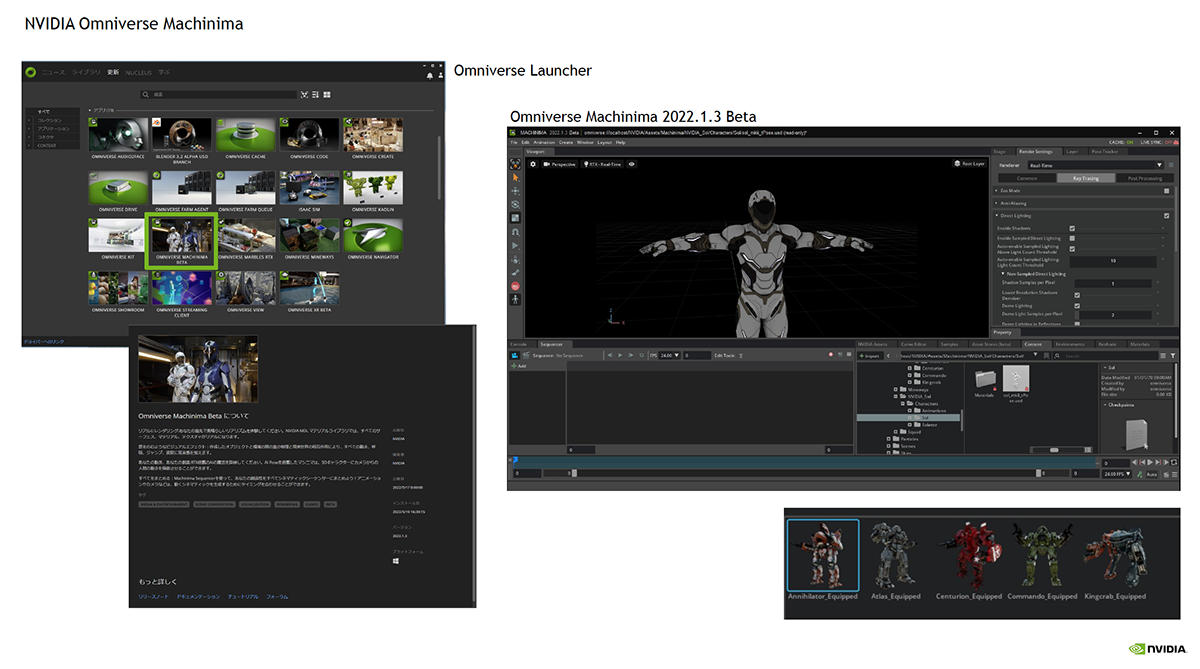

NVIDIA 田中秀明氏(以下、田中):Omniverseは、クリエイター同士が複数のアプリケーションを使ってコラボレーションできるプラットフォームです。Mayaや3ds Max、Unreal Engineなどに向けたコネクタを用意しており、各DCCツールとはUSDベースでデータのやり取りを行なってい ま す 。「Omniverse Machinima」はOmniverseCreateから一部機能を抜粋してまとめたもので、主にアニメーション制作に近い機能を気軽に扱えるようにしたアプリケーションです。

--アニメーション制作者をターゲットにしたOmniverse Createという位置付けでしょうか?

田中:コアターゲットはプロフェッショナルからハイアマチュアのゲーム開発者ですが、アニメ制作など映像制作者向けにも活用いただけます。Omniverse Machinimaに は「NVIDIA PhysX」や「Flow」、「Blast」といった物理シミュレーションや「Wrnch AI Pose Estimation」と い うAIによる姿勢分析およびリターゲットのシステム、そして「Omniverse RTX Renderer」などが含まれています。現在はβ版がダウンロード可能で、事前検証のためのツールとしてお使いいただけます。

--NVIDIAとして、Omniverseを今後どのように推進するのでしょうか?

田中:ここ最近では、メタバースの標準化を目指 す「METAVERSE STANDARD FORUM」というフォーラムに参加しました。メタバースに向けた基盤構築のベースとしてUSDを活用するというかたちで、いわゆるコンテンツを制作しているデベロッパー向けの基本ツールとしてOmniverseを利用していただきたいと考えています。また、Omniverse Createもランタイムアニメーションのブレンディングと再生のためのグラフエディタ「AnimGraph」や 新たなVMATERIALS 2.0など、編集機能が非常に充実してきました。まずはOmniverse Machinimaで機能を試して、その後にCreateを用いて実制作を行なっていただきたいと思っています。

Machinimaの検証で見えてきた可能性

--実際の導入に際して、ツールを触り始めるまではスムーズでしたか?

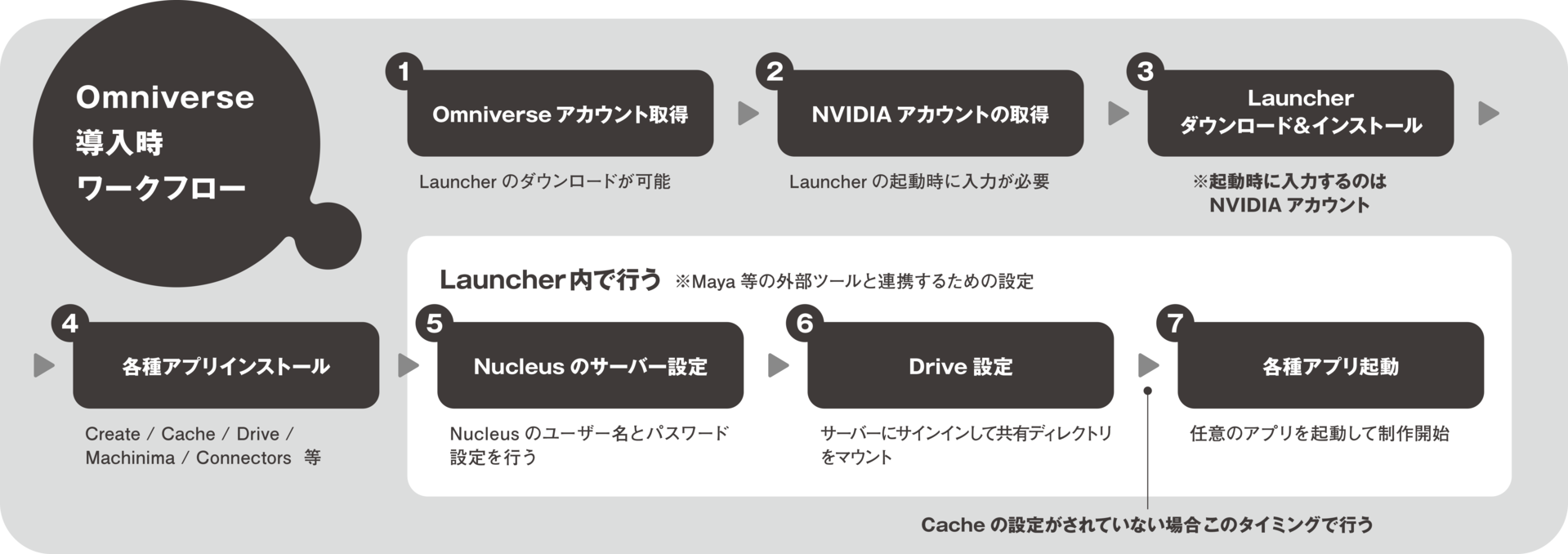

佐川卓也 氏(以下 、佐川):導入自体は大きなトラブルなく行えましたが、デザイナーツールとしての側面が強いアプリケーションなので、少し噛み砕いて説明があると良いと感じました。まずはOmniverseのアカウントを取得し、Launcherをダウンロードします。その後、LauncherにNVIDIAアカウントでログインし、各種ツールをインストールしていきます。続いて、アプリ間の連携をとるためのNucleusサーバの設定を行います。ここでもNucleusアカウントが必要になります。その後、Driveで共有ディレクトリをマウントして、準備完了です。各種ツールのチュートリアルを試す前に設定を済ませておいた方が好ましいと感じました。

天野:Omniverseは非常に直感的なツールだからこそ、導入の設定面がアーティストだけでは難しい場合もあると思います。ただ、この通りになぞっていただければ簡単にセットアップできますので、ぜひ参考にしてください。

--改めて、検証の概要を教えてください。

天野:今回は『からかい上手の高木さんVR』の教室アセットと、ReoNaスペシャルミニライブ『EX-“LIVE”CHRONICLE』の実際のシーンをOmniverse Machinima上にインポートして、実際の動きや扱いやすさを検証しました。『からかい上手の高木さんVR』は、もともとMayaで制作したアセットをUnityにインポートし、その後VRアプリケーションとしてOculusとSteamで配信していましたが、今回はMayaコネクタを経由してUSDを直接Omniverseに持っていっています。その後、ポスト処理やカメラワークの変更を試してみました。

--実際に触ってみた感想はいかがでしたか?

佐川:グラフィックスのクオリティは非常に高いですね。ポストエフェクトの品質も良いですし、ほしいルックに対して直線的にアプローチできる印象です。特にブルームやブラー系の品質が良かったのと、色収差などを含めたカラーグレーディングまで対応していました。デザイナーが直感的に操作できるUIですし、例えばオブジェクトがライトの影響を受けるか否かをライトのパラメータからアクセスして指定できるところも、DCCツールの使い勝手に近いと感じました。1点だけ、カメラのアングルを調整するためにビューポートに切り替えが必要でしたが、パースペクティブとカメラビューを2画面分割表示ができるとDCCツールの使い勝手にさらに近づくと感じました。

天野:予想よりも処理が高速なため、例えばVRなどを含めたリアルタイムのライブなどの需要にも応えられるのではないかと思いました。「Wrnch AI Pose Estimation」の精度も非常に高いですし、Omniverse Machinimaを複数台のマシンで起動して連携させたVRライブは可能性を感じます。通常の開発はもちろん、スピードと精度を考えると、十分に配信系との相性が良いのではないかと思います。

-

ライティングの検証

リアルタイムで反映されるライティングの処理については、質・速度ともに高い水準になっている。オブジェクトがライトに影響を受けるか除外するかをライトのパラメータからアクセスして指定できるところも、DCCツールの使い勝手に近くて便利に感じたという -

画面に対して処理を反映できるまでのプロセスが短く、デザイナーが直感的に操作できるUI、UXが嬉しい

パースペクティブとカメラビューを2画面同時に表示することができなかったので、カメラのアングルを調整するためにビューポートに切り替えが必要。2面分割表示ができるとDCCツールの使い勝手に近づき、イテレーション速度が上がるだろうとのこと

--Webカメラひとつでキャラクターに自分の動きを反映できるのは、どういった場面でメリットが大きいのでしょうか?

天野:個人単位やプロダクション単位でモーションキャプチャスタジオを用意するのは難しいので、安価かつ省スペースで高精度なアニメーションを作成できるのは明確な強みです。実際、アニメーターと一緒に「こんな感じの動きにしてみよう」、「意外と良いかもしれない」と、Omniverse経由のイテレーションを試しましたが、これが非常に良かったです。今の印象では、イテレーションを回すツールとしても、アウトプットのためのレンダラとしても、どちらも可能性を強く感じています。

田中:どのようなワークフローが好ましいかは、むしろ実際のクリエイターからのご意見も頂戴したいです。しくみの上では、思いついたアイデアをすぐに試せるだけの機能が揃っていると思いますが、具体的にどう活用するのが良いでしょう?

天野:Omniverseはゴールというか、用途が本当に多いです。何にでも使えるであろうツールが数多く用意されていることは嬉しい反面、一方に置いては「使い手側からすると、どれに使えば良いのか認識しづらい」という事情もあると思います。こうした中においては、ある意味では決め打ちの方がユーザーには届きやすいのではないかと考えています。OmniverseMachinimaはアニメーションやゲーム開発に特化しているとご説明がありましたが、このOmniverse Machinimaのように「どの方向性に特化にしているのか」を明確化してもらえたら、クリエイターにとってもとっつきやすいツールになるのではないでしょうか。

用途や働き方に合わせて使い分けよう!

Omniverseの性能を最大限引き出せる

Lenovo ThinkStation P620&ThinkPad P1 Gen 4

極めて高度な編集作業と美しいレンダリングを実現するOmniverse。この強みを十分に活かしきるマシンの条件について、今回はRTX A5500搭載のLenovo ThinkStation P620と、RTX A5000搭載のモバイルワークステーションThinkPad P1 Gen 4を実際に使用してもらい、操作性やスペックに関する所感を聞いた。

プロジェクトごとに必要なスペックを提供する

--3DCG開発には一定以上の水準のマシンが必要ですが、カヤックアキバスタジオでは普段どのように使用するPCを選定していますか?

天野:基本的には「必要なスペックを必要なタイミングで揃えていく」というだけですので、基準となる特定のスペックがあるわけではありません。逆に言うと、今回のようなモンスターマシンもなかなか購入機会があるわけではないので、その意味では検証は楽しみでしたね。佐川:プロジェクトによって使用するマシンはまちまちですが、私の場合はVRAM容量が必要なので、A5500搭載モデルなども購入して使用しています。「負荷を気にせず使える」ということが重要なので、予算が許せば上位のGPUを用意したいと考えています。今回は、一般的に業務で使っているマシンとしてInteli7-10875H、GeForceRTX 2070 SUPER、メ モリ64GBのマシンも用意しましたので、比較対象として使っていきます。

Omniverse Machinimaでも十分なフレームレートを担保

--Omniverseの検証用に、RTX A5500搭載のThinkStation P620と、RTX A5000搭載のモバイルワークステーションThinkPad P1 Gen 4をお使いいただきました。『EX-“LIVE”CHRONICLE』では負荷検証を行なったとのことですが、結果を教えてください。

佐川:『EX-“LIVE”CHRONICLE』は実写合成ベースかつシーンデータ量の多いサンプルとして、スペック面の検証を行いました。具体的には約100万ポリゴン、テクスチャ77枚(4,096×4,096、png形式)、マテリアル数111個のシーンとなります。このシーンがモバイル端末であるThinkPadP1 Gen 4で動くのかを検証してみました。

天野:このプロジェクトはUnityでのリアルタイムレンダリングでの一発書き出しを目指していたんです。ポリゴンが舞うような演出などはUnityシェーダなどで行なっていたので、完全なOmniverse移行はできませんでした。あくまで演出部分を除いたシーンですが、その上でポストエフェクトをかけたり、コンポジットを行なったり、いわゆるレンダラとしてOmniverseを使ってみました。結果は体感ベースですが「Omniverseのもつクオリティを担保するために十分な環境」だと思いました。遠慮なく使っても全く問題なく動作していた印象です。

佐川:またPCIe Gen 4規格であることに関係してか、アプリケーションでデータを起動する際に通常より速いという体感がありました。起ち上がりが快適なので、素早く作業に移ることができて助かりました。

P620(RTX A5500):219.3fps

P620(RTX A5500):182.9fp

--Lenovoマシンだからこそフルスペックを活かしきれたと。従来機でOmniverse上の-『EX-“LIVE”CHRONICLE』を操作するのは、やはり困難でしょうか?

天野:そもそも動かないんじゃないでしょうか? 少なくともリアルタイムで動作するという感覚にはならないはずです。

佐川:A5500搭載のP620では60fps以上は出ていましたが、従来なら恐らくその半分以下か、良くて18fps程度になるのではないかと思います。

天野:結局、こうしたライブ演出などはリアルタイムでフレームレートを担保するために泥臭い最適化をやる必要があるんです。見えない部分を削ったり、似たような演出でもう少し軽い処理を組んだり、シェーダを書き換えて負荷を減らしたりといった作業が必ず発生します。ただ、今回は「どう最適化しようか?」ではなく「どこまでやれるだろうか?」というポジティブな気持ちで作業ができました。普通はどこまでやりたいかの目標を決めて、その上で負荷計算を行なってオーバーするところを確認するのですが、今回は思考のベクトルが完全に逆でした。

佐川:フレームレートの話題で言えば、Unity上で展開した『からかい上手の高木さんVR』の シ ーンはP620が219.3fps、ThinkPad P1 Gen 4が86.2fps、RTX 2070 SUPER搭載の従来機では92.1fpsでした。GPU使用率もLenovo機は88%~100%で、従来機は32%と乖離がありまし た 。『EX-“LIVE”CHRONICLE』は 、同じ 順番で182.9fps、60.4fps、83.3fps、GPU使用率はいずれも80%を超えていました。この中でもThinkPad P1 Gen 4はフレームレートだけ見れば優位性は少ないものの、複数アプリケーションを起ち上げたときの快適性が体感上まったくちがいましたね。P620が圧倒的なのは当然として、作業効率としては検証機に軍配が上がります。

メニーコアCPUの恩恵

--CPUに関しては、メニーコアの恩恵を受けるような場面はありましたか?

佐川:OmniverseはGPUベースですので、CPUに関してはMaya Arnoldでのレンダリング速度を測定しました。今回は検証の都合上、MayaでフルHDサイズの一枚画をレンダリングしていますが、ここは当たり前のことながらRyzen3955WXを搭載するP620が約56秒、従来機が約2分と2倍以上の速度が出ていました。2倍というだけでも良い数値だとは思いますが、これはあくまで短距離走的なレンダリングですので、より大規模なレンダリングならこの差はさらに顕著になると思います。

--解像度や設定を高めたり、デノイズなどを行なったりすると、測定時間の差はさらに開くような印象があります。

佐川:もうひとつ興味深かったのは、ThinkPadP1 Gen 4へのCPU負荷と排熱の関係性です。低負荷の場合は91度 で 、高負荷(Arnoldレンダリング時)は80度と、冷却のしくみが走っているのか、むしろ負荷をかけた方が温度は低かったんですね。ファン構成などが非常に優秀なのだろうと感じましたし、その上で静音設計もしっかりしていたので、非常に良いマシンだと感じました。

--Omniverseにおいて、CPUはどのように使われるのでしょうか?

田中:Omniverseにおいても、例えばIrayによるレンダリングなどはCPUベースでも処理できます。CPU、GPU両方をフルで使いますので、どちらか単体のパーツが優れていればいいというわけではなく、トータルバランスを重視していただければと思います。リアルタイムにエフェクトを大量に出していくなど、ライブ用途でさらにハイスペックを目指すのであれば、P620であればデュアルCPUやRTX A6000の搭載はもちろん、RTX A6000×2枚といったマルチGPUシステムが組めるNVLinkまでサポートしています。一般的にウルトラハイスペックと呼ばれるようなマシンでも、Omniverseであれば十分に性能を活かしきることができるのではないかと思います。

ハイエンドモデルは誰がどの工程で使うべき?

--モバイルワークステーションとデスクトップの使い分けについてもお聞かせください。

天野:普段から両方使っています。プログラマーだけはノートPCだけという方もいますが、基本的には2台持ち体制の人が多いですね。プロジェクトにもよりますが、ハードなスケジュールなときはハイスペックなノートPCを手元に置いておいた方が、場所を選ばずCG作業ができるので好ましいです。少なくともUnityやUnreal Engineを扱うメンバーは、2台持ちがマストだろうという印象です。

佐川:私もベースの作業はノートPCで進めて、処理が不足する場合はデスクトップと使い分けを行なっています。建築などノンゲームの分野においても、今はノートPCで作業をする人も増えているような印象はあります。

--今回のようなハイエンドなマシンが向いていると思われるアーティスト像について教えてください。

天野:フルスタックで開発できるクリエイターですね。アニメーターやモデラーなど、個別の工程を担当する人間ではなく、シーン構築を含めてデータをまとめるアーティストでないとスペックを使い切るのは難しいと思います。

佐川:やはり、シーン構築を行なって、最終的なコンポジットまでを担当するアーティストに合うのではないかと思います。誰が使っても嬉しいスペックではありますが、より負荷の高いシーン構築等を行うアーティストの方が受ける恩恵は大きいと思います。もっと噛み砕くと、個別の作業ではなく、後ろの方の工程で何でもやるアーティスト。スケジュールから見ても時間が不足しがちですし、イテレーションの速さなども含めてハイエンドマシンは役に立つと思いました。

--Lenovoはリモートデスクトップソリューション「TGX」を用意しています。カヤックアキバスタジオではリモートデスクトップ活用も進んでいるのでしょうか?

天野:当社はセキュリティの観点から現状フルリモートになっていませんが、最初の緊急事態宣言下では全員が自宅にマシンを郵送して作業を行うなどの対応に迫られました。その中で、当然「遠隔でPCアクセスはできた方がいい」という状況ももちろんありました。翻って現在、それぞれのライフスタイルに合わせて、働き方が変わり始めました。リモートワークも当たり前になっています。同時に、人材面においても、海外のアーティストとリモートで協業することができるようになりました。TGXはGPU側でのエンコードで低帯域であることと、4K60fpsを4画面対応すると聞いています。今やリモートが当たり前である以上、その選択肢が増えることは大変ありがたいことです。

--ありがとうございます。最後に、改めて検証機について総評をいただければと思います。

佐川:ThinkStation P620について、あれだけの性能を誇るマシンであれば普段の仕事でもぜひ使ってみたいというのが率直な感想です。今回の検証は16コアで行いましたが、同機はコンパクトな1CPU筐体で64コアまでスケールできるので、今回以上に重いデータをOmniverseやレンダリングで扱う場面でも安心ですね。

天野:イテレーションを回すようなTAやディレクター層には特に向いているかもしれません。どんなに優秀なクリエイターだって、絶対に24時間しかパフォーマンスを発揮できないわけです。レンダリングなどの時間短縮によって実質的な制作時間を長くして、クオリティアップに注力できるよう、なるべく高いスペックのマシンは使っていきたいと考えています。ThinkPadP1 Gen 4は、まさに最近は働き方が大きく変革する時代ですから、セキュリティ面に配慮さえすれば非常に強力な武器になると思います。

TEXT_神山大輝(NINE GATES STUDIO)

PHOTO_竹下朋宏