7月7日(金)、ボーンデジタル主催によるNukeセミナー「Nuke Meetup Tokyo 2023 Summer」がワテラスコモンホールにて開催された。

本イベントは2022年12月に行われた「Nuke Meetup Tokyo 2022」に続く第2弾で、話題作『父と娘の風景|相鉄東急直通記念ムービー』のメイキングをはじめ、Nuke Python APIを活用したツール開発事例、前回好評を博した映画『ゴーストブック おばけずかん』のCopyCatの解説まで、内容は多岐に及んだ。本記事ではその模様をダイジェストでレポートする。

Information

「Nuke Meetup Online」

開催日:2023年11月22日(水)

時間:19:00-20:30

会場:オンライン

主催:ボーンデジタル

協賛・協力:Foundry

参加費:無料 ※事前登録制

https://www.borndigital.co.jp/seminar/31665.html

イベント概要

「Nuke Meetup Tokyo 2023」

開催日:2023年7月7日(金)

時間:17:00-20:00

会場:ワテラスコモンホール(東京・淡路町)

主催:ボーンデジタル

協賛・協力:Foundry

参加費:無料 ※事前登録制

https://www.borndigital.co.jp/seminar/30312.html

『父と娘の風景』メイキング

セッション「父と娘の風景|相鉄東急直通記念ムービー メイキング」には株式会社slantedよりVFXスーパーバイザー・山内 太氏とリードCGアーティスト・大塚和樹氏が登壇。

国際広告賞「カンヌライオンズ2023」金賞ダブル受賞をはじめ、国内外から高い評価を得た『父と娘の風景』をどのように作り上げたのかを解き明かした。

『父と娘の風景』は父と娘の12年の歳月を148秒で表現した映像作品。総勢50人のキャストによる1ショット長回しにチャレンジしており、slantedは柳沢 翔監督が絵コンテを描く段階から作品に携わった。

企画当初は舞台となる電車の車内はほぼ美術セットで撮影し、slantedは窓の外の景色だけを3DCGで表現する予定だった。しかし最終的には車両はほぼグリーンバックでの撮影に決まり、車内や駅構内、車両内に落ちる影など、多くの部分を3DCGで手がけることになり、slantedの作業量は飛躍的に増加した。

CGWORLDではセッションで語られたメイキングについて、インタビューも交えて以下の記事で解説しているため、詳細はこちらを確認してほしい。

>>相鉄線の歴代車両と駅を3DCGで再現! 父と娘の12年を"50人ワンカット"で撮影した相鉄・東急直通線開業記念ムービー『父と娘の風景』の舞台裏

https://cgworld.jp/article/2307-sotetsumovie-making.html

本レポートではNuke XのSmart Vectorツールを駆使して、現場でのトラブルに対応した事例を紹介しよう。『父と娘の風景』では父親役をオダギリジョー氏が担当。映像冒頭のまだ若い頃の父と、最後の白髪交じりになった12年後の父を演じている。

撮影は1ショット長回しのため、オダギリ氏はカメラが後方に移動して画面に映らなくなったら車内セットの外へ。そのまま先頭車両まで駆け込んで、白髪のウィッグを付けてからカメラの前に再び姿を見せる。

しかし現場でリハーサルをしてみると衣装替えの時間がほとんどなく、ウィッグを前髪にしか付けられないことが判明した。

そこで急遽、オダギリ氏の髪の毛にトラッキング用のマーカーを貼ることに。このアイデアが功を奏し、Nuke XのSmart Vectorツールで白髪を盛ることに成功。自然に年を重ねた姿を表現できた。

質疑応答のコーナーでは、複数の質問が飛び出した。

まず撮影現場と3DCGのライティングで苦労した点について、山内氏は現場では全員に照明を均等に当てるのが不可能だったことが難点だったとふり返る。

完成映像ではどの車両にも下手側から光が当たって平行の影を落としているが、実際の現場では照明を置ける場所が限られるため、どうしても角度が付いてしまう。

そこで3DCGでは撮影のライティングを活かしながらも、ショットの最後にアニメーションによる動きを加えるなど、影が不自然に見えないように処理を施すことにした。

車窓の合成については、ショットの序盤は本物の車両の最後尾から撮った実写映像を使用。父と娘の年月が経ってからは3DCGに置き換えている。

山内氏は「父と娘の映像が派手すぎるので、車窓で何が起きているのかほとんどの人が気付いていないと思いますが、実は外でも年月の経過を表しているんです」と演出意図についてコメント。例えば並木の青葉が繁ったり、紅葉に染まったりと、3DCGで四季を描いていることを明かした。

到着する駅もCGだが、ホームに降りてからの風景はまた実写に戻るなど、実写とCGが巧みに融合している点も本作の魅力であることがよくわかる講演となった。

Nuke Python APIによるツール開発

ショートセッション「映像制作におけるツールの活用〜R&Dの取り組みと広がりについて〜」には株式会社クオリスの代表・茅野宏祐氏が登壇。Nuke Python APIでどのようなことを実現できるのかを受講者に伝えた。

近年の映像制作では1つのツールだけで作業が完結することは珍しく、複数のツールを渡り歩いて完成させることが当たり前の状況にある。

ツールの提供者側はそれを前提とした上で、SDKやAPIなどを搭載することによって、ユーザーの幅広い要望に応える姿勢を見せている。今ではスクリプトを用いて、アーティストが手を動かすのと同様のことを実現するのも難しくない時代になってきたのだ。

そのような背景を解説した上で、セッションではNuke Python APIの概要を紹介。さらにクオリスがNuke Python APIを初めて扱ったときの事例にも触れた。

Nuke上にコンポジットされたデータを抽出し、ゲームの実機に向けて出力するという複雑な案件だったが、工数はわずか1ヶ月程度。これには茅野氏自身も驚いたそうだ。

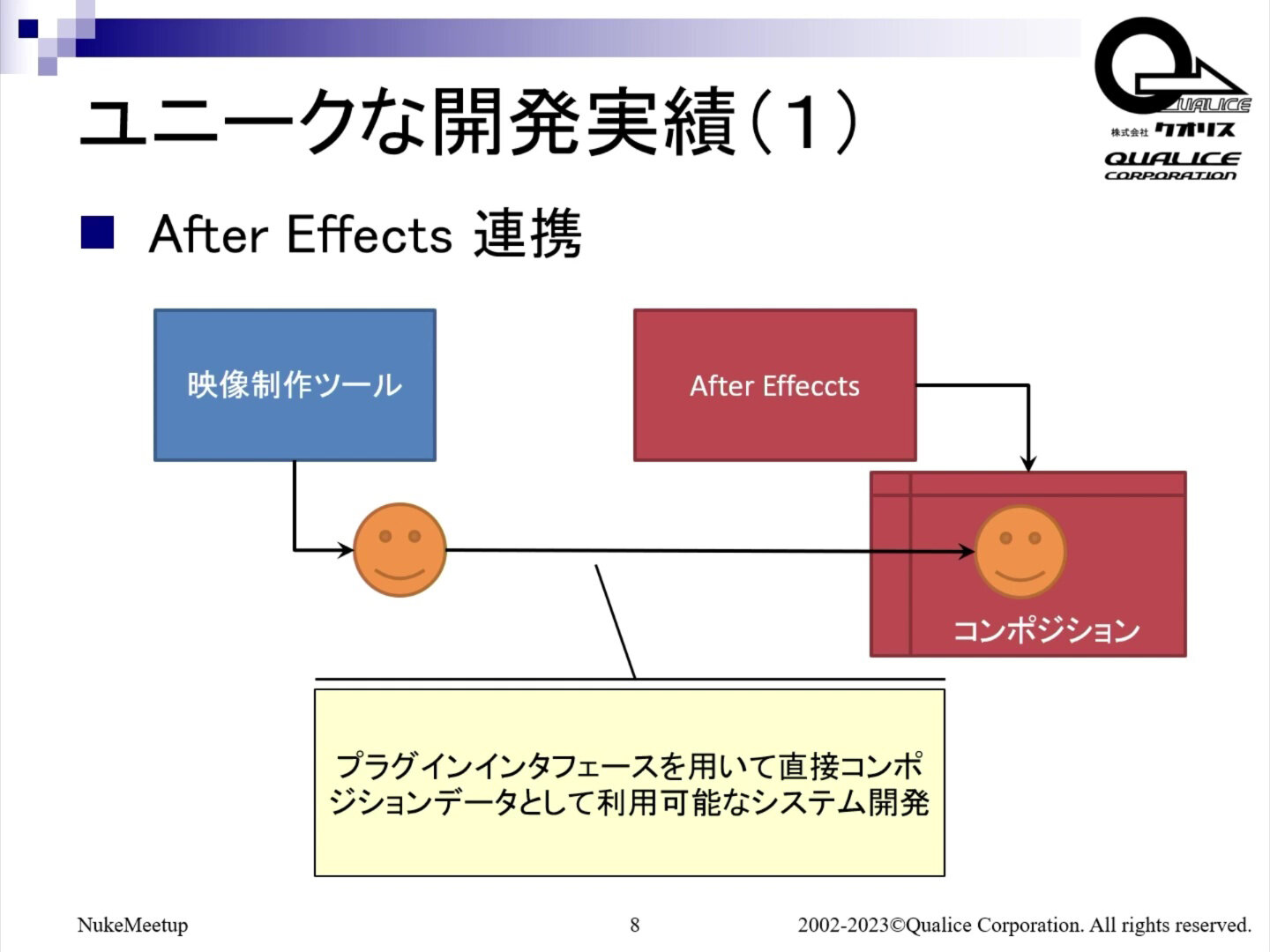

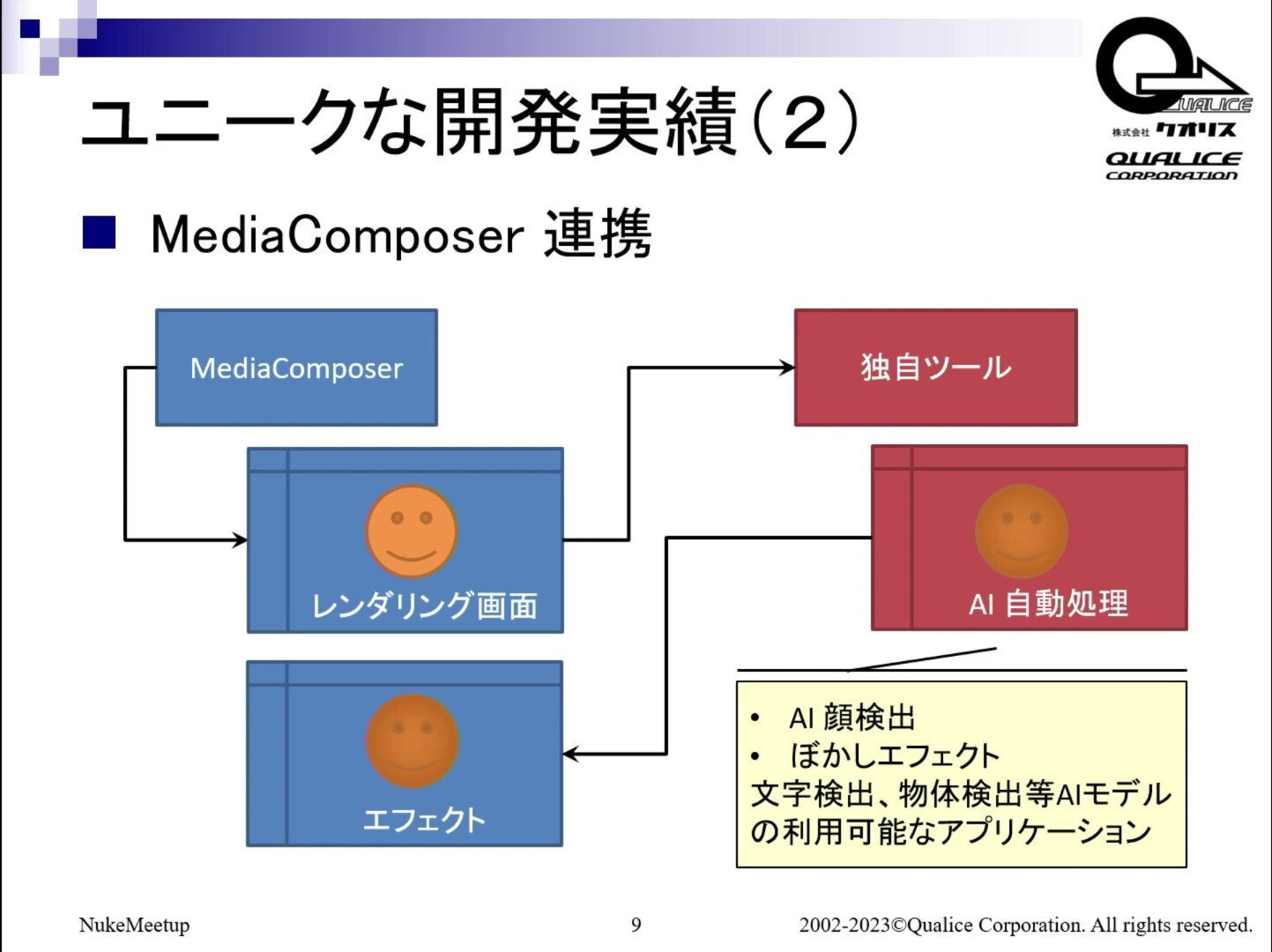

そのほか、Nuke以外のユニークな開発事例なども言及。After Effectsのコンポジションに別の映像制作ツールで作ったレンダリング画面を直接差し込んだり、Media Composerのレンダリング画面を抜き出して独自ツールでAI処理をした後、再びMedia Composerに戻したりした事例を取り上げた。

茅野氏は「Nukeも含めた様々なツールはスクリプティングの機能も提供していて、実際のコンポジット作業はスクリプトをちょっと知るだけで非常に効率的なものにできる」とコメント。

多くがPythonで書かれていることから、"Python won't make you a better artist, but it'll make you a more efficient one."(Pythonを使用するとより優れたアーティストになるわけではありませんが、より効率的なアーティストにはなれます)という言葉を取り上げて、アーティストにとっても非常に役立つ武器になると語った。

映画『ゴーストブック おばけずかん』CopyCatで作業時間を短縮

昨年12月のセミナーの再演となる「ゴーストブック おばけずかんによるNukeの使用事例 〜特にコピーキャットが最高です〜」には株式会社白組のコンポジター/スーパーバイザーの大久保 榮真氏が登壇。セミナー最長の80分に及んだセッションの中から、CopyCatを使ってマスクを自動で切る方法についてレポートする。

実例として取り上げたのは、2022年公開の映画『ゴーストブック おばけずかん』に登場する「旅する雲梯」のショットである。

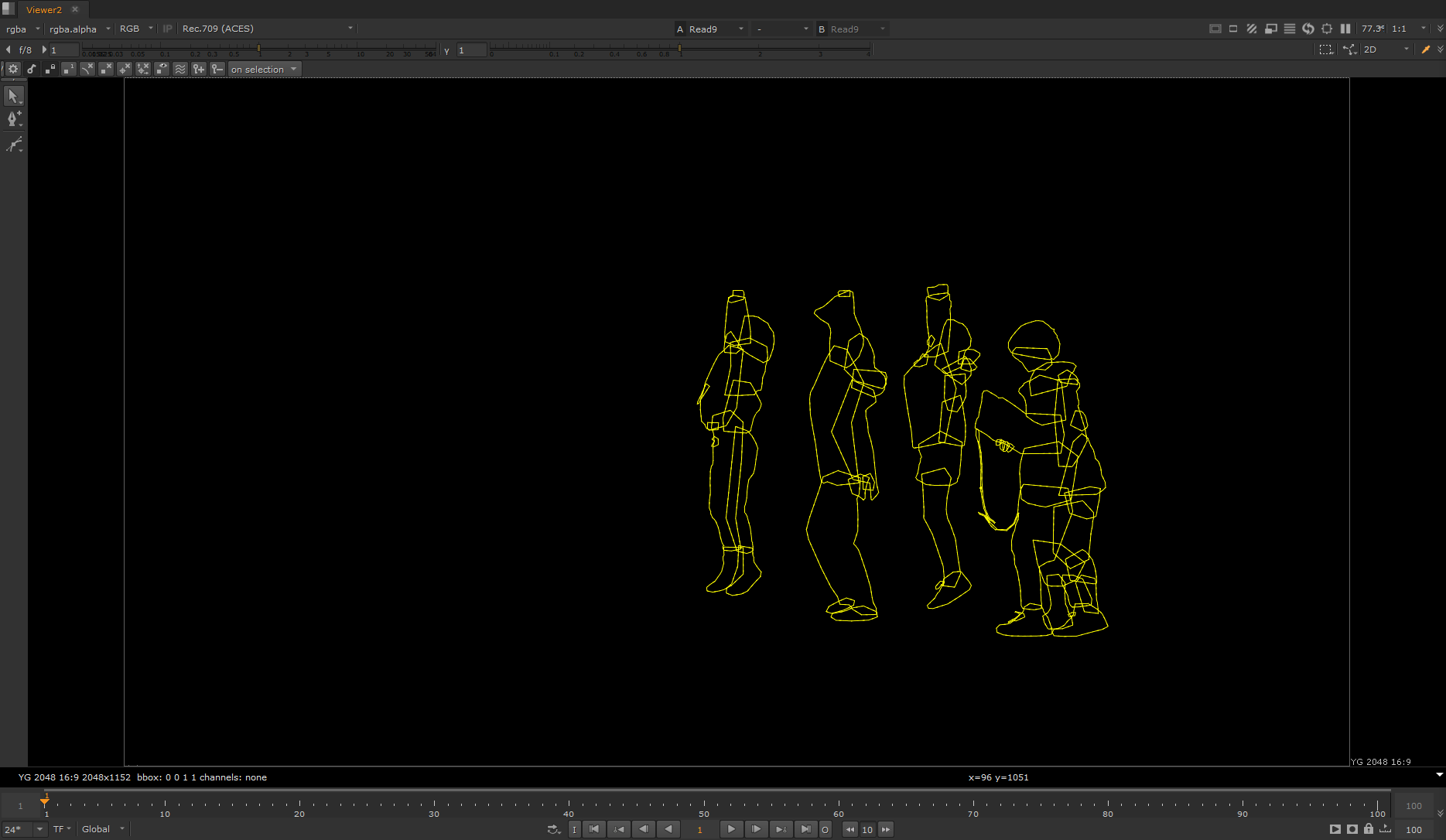

「旅する雲梯」はぶらさがると勝手に動き出し、そのまま空に飛んで行ってしまうおばけだ。脚は3DCGだが、はしごの部分のみ美術セットで作成されている。大久保氏によると、演者が触れるなどして直接干渉する箇所に関しては、CGで制作すると手間がかかるためセットにすることが多いそうだ。

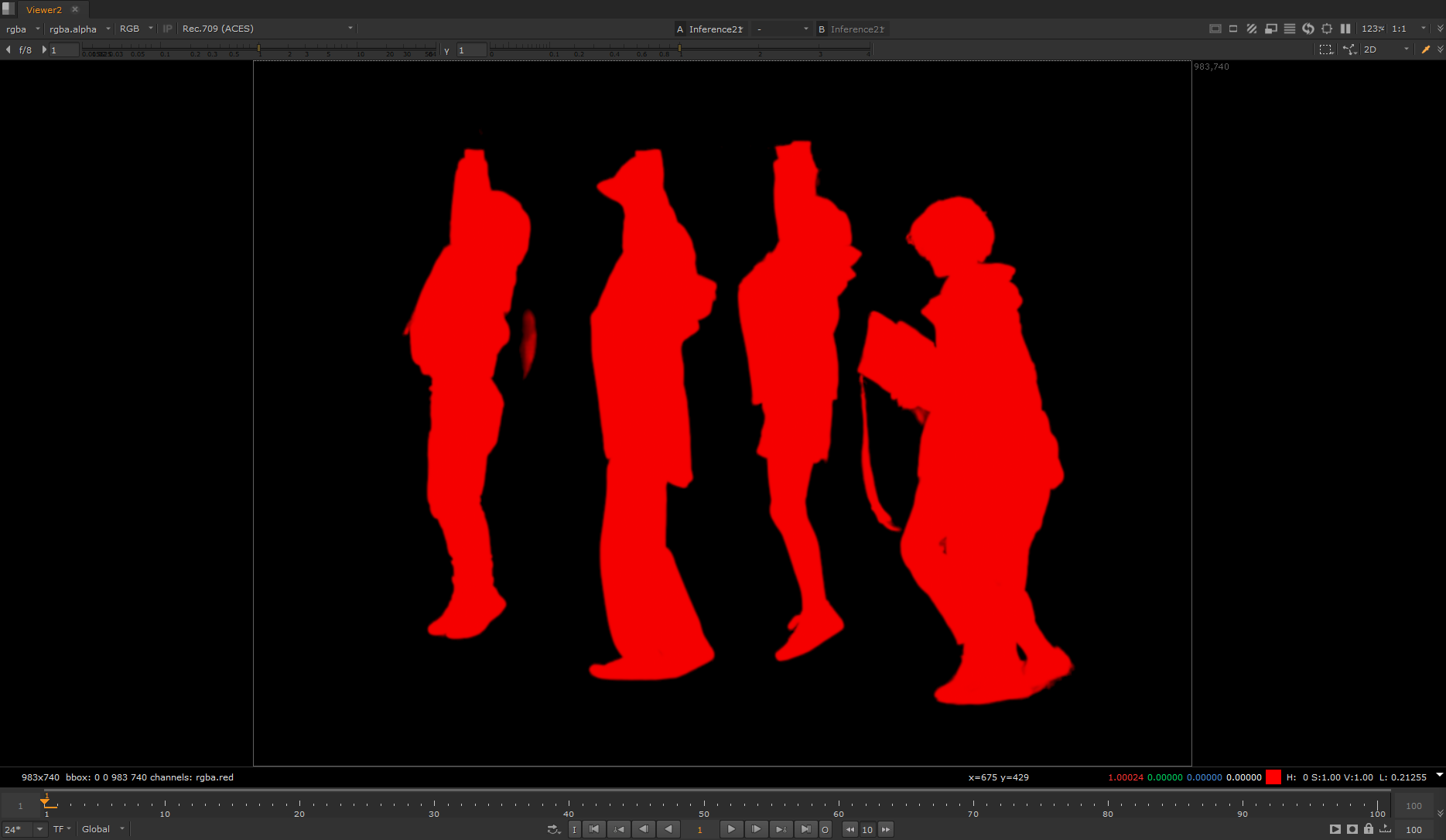

演者と脚をそのまま合成すると重なってしまうので、マスクを切る必要がある。しかし約10秒のショットで、人間5人分のマスクを切るのは手間がかかる。そこでCopyCatを利用して作業の効率化を図った。

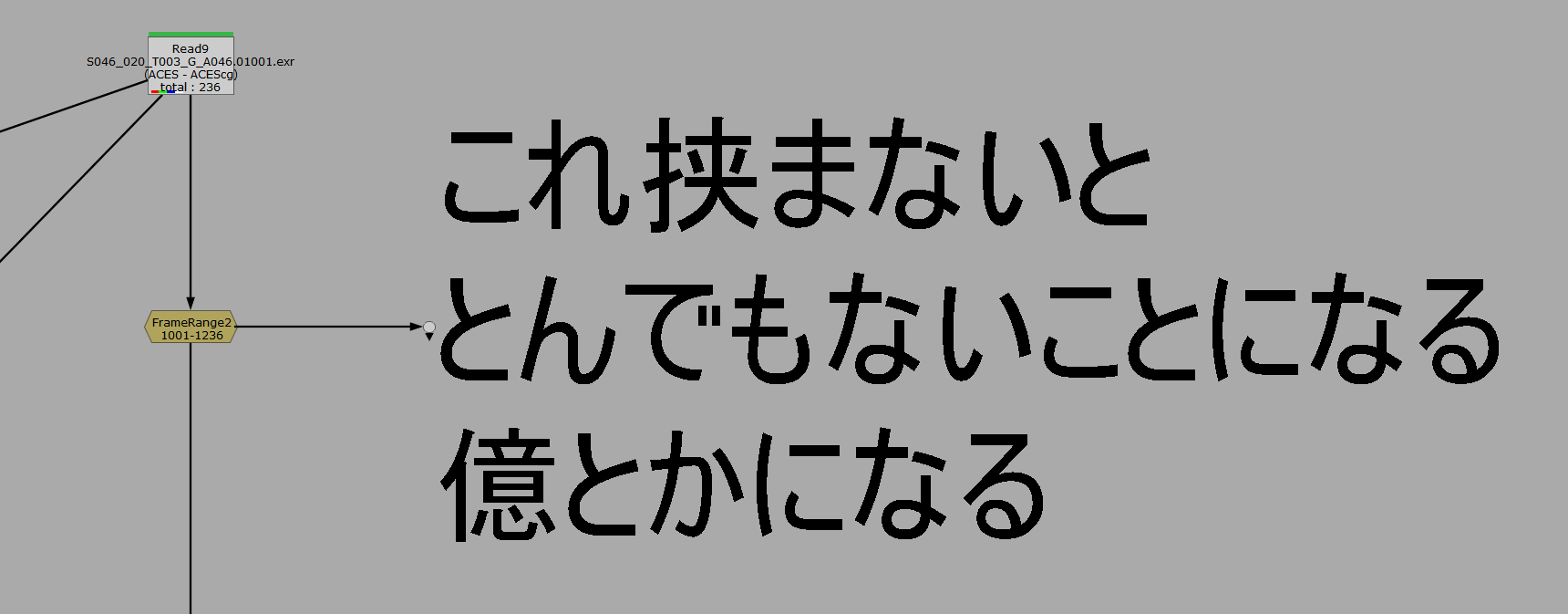

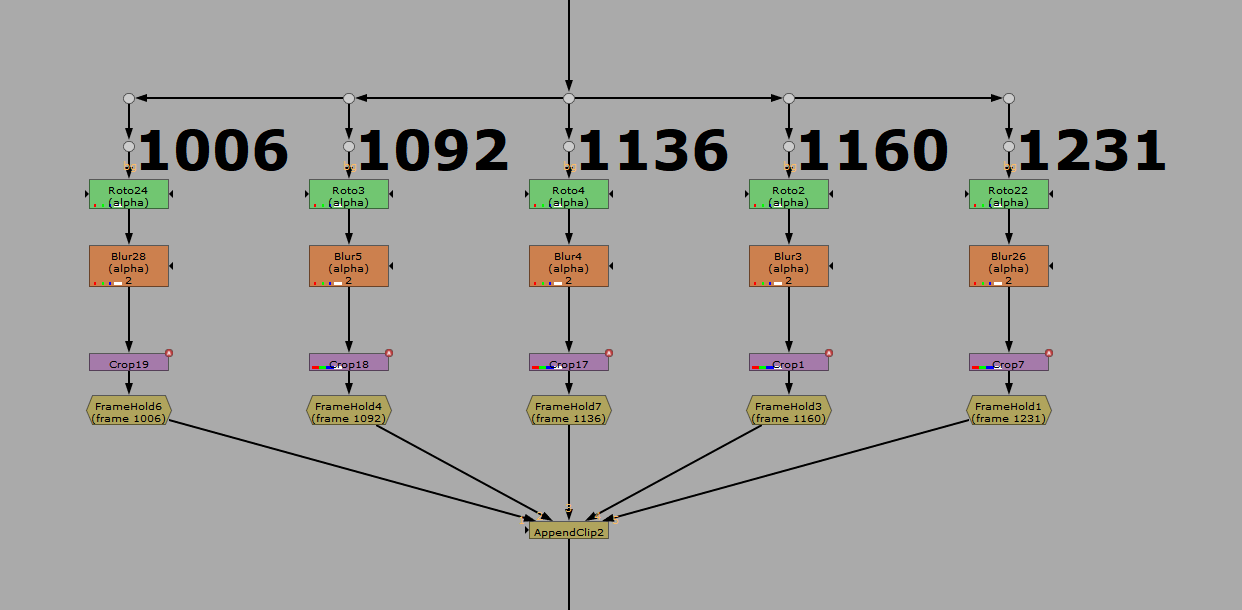

まずはFrame Rangeを挟み、計算するフレームの尺を設定。これをしないと計算量が非常に多くなってしまうため、絶対に欠かせない工程となる。

続いて、CopyCatに学習させる参考用として、手動で切ったマスクを何枚か用意する。

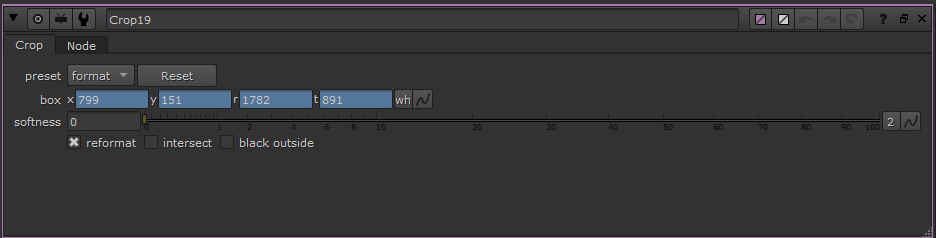

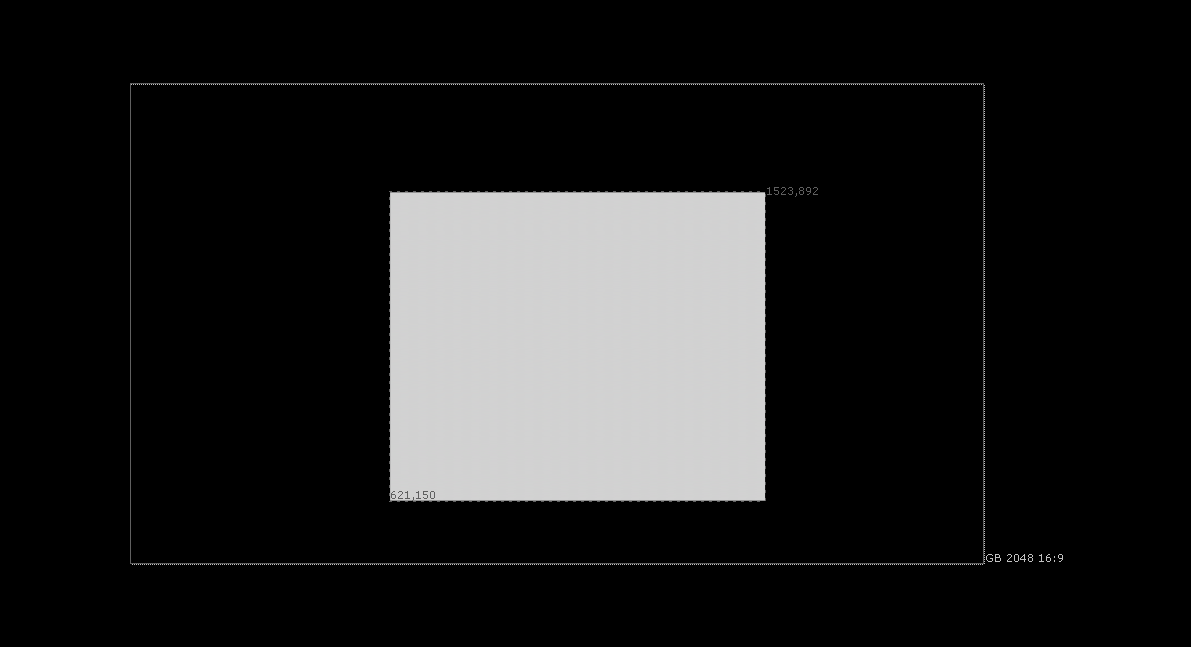

今回は5フレーム分のマスクを切って、エッジをボカした。次に画面の中から必要な部分だけをクロップ。この作業によって画面全体ではなく、切り抜かれた箇所だけを計算するようになって処理速度がアップするのだ。

そしてFrameHoldすると1フレーム分が完成。これを5フレーム分行う。作業順を入れ替えると上手くいかないため、マスクを切る→エッジをボカす→クロップ→FrameHoldの順番をきっちり守ることが重要になる。

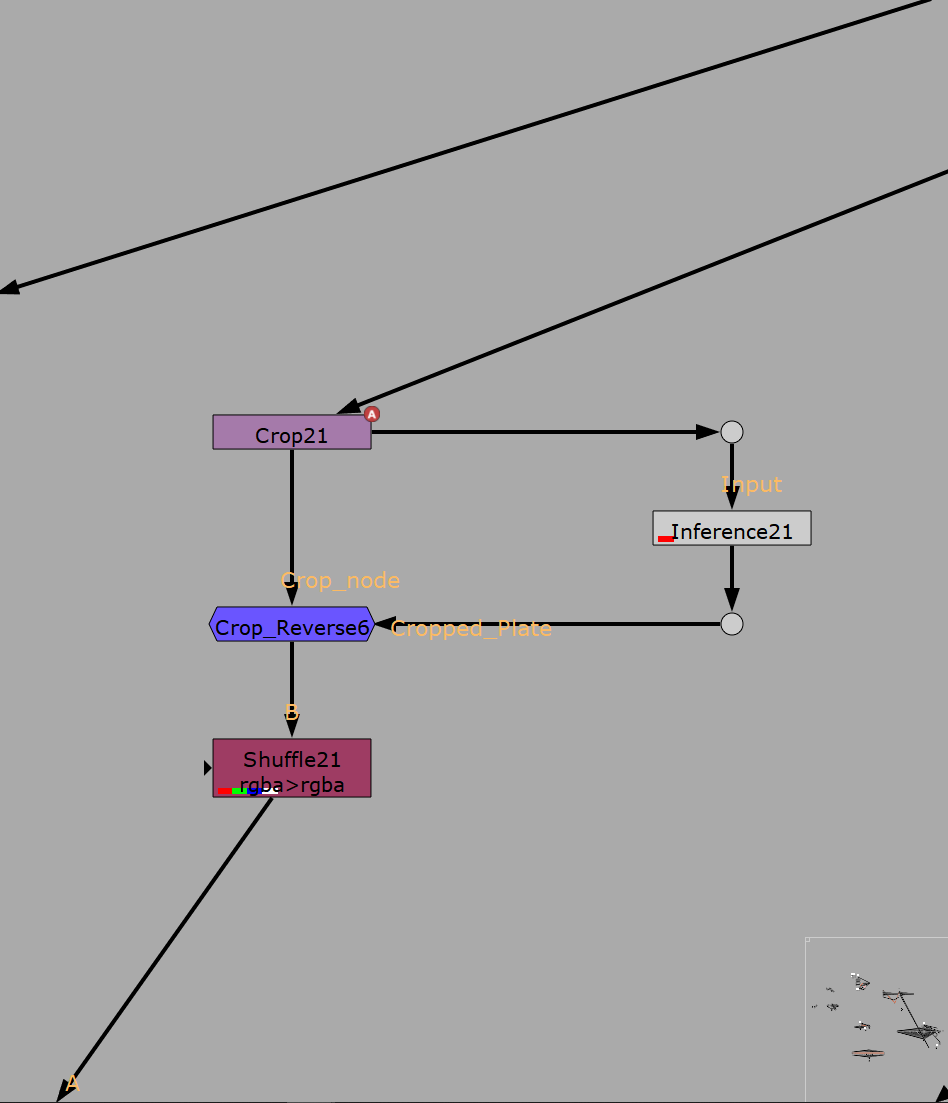

5フレーム分それぞれをAppendClipに接続。最後に教える側であるマスクはCopyCatノードのGround Truthに、教わる側の元画像はInputに繋げれば事前準備は完了だ。

実際にCopyCatをかけると、マスクが自動で次々にできあがっていく。もちろん細かなミスはあるため手直しは必要だが、それでも作業時間を大幅に短縮できる。人間のマスクを切る場合は、Initial WeightsをHuman Mattingにすると精度が上がるという。

なお今回のショットではGPUはGeForce RTX 3070を使用しており、計算時間は10時間ほど。CopyCatを退社前に実行し、翌日の出社時に確認することが多かったという。

また、大久保氏がNuke14と13を使って同一環境下で試したところ、14の方が3倍ほど計算速度が速かったとのこと。効率化のためにも最新版を使うようにしたい。

質疑応答では「学習させるために自分で切るマスクは、どのフレームを選べばいいのでしょうか?」との質問が出た。大久保氏は「いろいろなフレームがあった方が精度は良くなります」と回答。

もし人間が360度回転するショットであれば90度ずつ異なる角度から体が見えるフレームを用意した方が良いし、歩いているショットであれば右足を前にしたフレームと左足を前にしたフレームの両方ともあった方が良い。基本的に学習用のマスクは多ければ多くなるほど精度は高くなる。

ただ忙しい場合はマスクを5枚用意せず、3枚や2枚などで実行することもあるそうだ。その場合も意外に上手くいくため、スケジュールに合わせて柔軟に対処できるのもCopyCatのメリットである。

最後に大久保氏は「CopyCatを薦めると『精度はどうなんですか?』と必ず聞かれるのですが、映画実用レベルで使えます」と実践にも役立つと断言。上手い人間がマスクを切ってもエラーが出ることはあるし、マスクを頑張って褒められることはないため、「マスクはCopyCatに任せてVFXをやりたい人にピッタリのツールだと思います」と太鼓判を押した。

TEXT_高橋克則 / Katsunori Takahashi

EDIT_小村仁美 / Hitomi Komura(CGWORLD)