コンピュータグラフィックスとインタラクティブ技術に関するトップカンファレンスであるSIGGRAPH Asia 2023が2023年12月12日(火)から15日(金)まで開催された。オーストラリア・シドニーにおいて開催された同カンファレンスでは50のセッションが行われ、合計233本の技術論文が発表された。

本稿では、こうした発表のなかからXRとAIに関連した注目論文を10本、紹介する。

関連リンク

●発表された技術論文に関する全プログラム(公式ページ)

https://asia.siggraph.org/2023/full-program/

●カンファレンスで発表された注目すべき論文をピックアップしたダイジェスト動画

●技術論文に関する動画やサンプルコードのリンク集(非公式)

https://kesen.realtimerendering.com/siga2023Papers.htm

1:物理世界を忠実に再現するカメラシステム&AIモデル

VR-NeRF: High-Fidelity Virtualized Walkable Spaces

https://vr-nerf.github.io/static/VRNeRF-SIGAsia2023.pdf

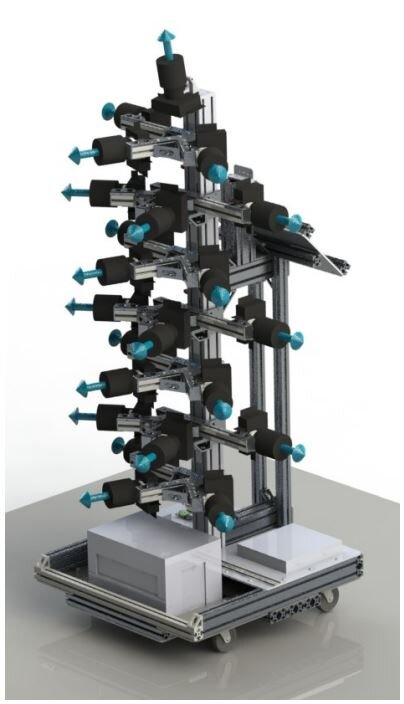

Metaらの研究チームが発表した本論文は、物理世界を忠実に再現する仮想世界を構築するためのカメラシステムとAIモデルを提案している。

提案されたカメラシステムで物理世界を撮影後、その撮影データを使ってAIモデルが仮想世界を描画すると、その世界は物理世界と視覚的に近いものとなる。VRヘッドセットを着用すれば、この仮想世界を歩行する体験ができる。

以上のカメラシステムは「EYEFUL TOWER」と命名され、80✕80cmの台座の上に180cmのポールをつなげたカメラ塔には3台のカメラを7段設置し、さらにカメラ塔上部に1台のカメラを設置した。こうしたカメラ配置は、人間の視野を正確に再現するためのものである。物理世界の撮影は、30cm間隔に行う必要がある。

2:テキスト入力からシネマグラフを生成するAIモデル「Text2Cinemagraph」

Text-Guided Synthesis of Eulerian Cinemagraphs

https://arxiv.org/pdf/2307.03190.pdf

アメリカ・カーネギーメロン大学らの研究チームが発表した本論文は、テキスト入力からシネマグラフ(一部分が動く静止画)を生成するAIモデル「Text2Cinemagraph」を提案している。

このモデルを使うと、例えば「日没時にゴッホの絵のスタイルで丘の間に落ちる大きな滝、4K」というプロンプトからこのテキストに対応したシネマグラフを生成できる。このモデルは、静止画部分と動く部分を分けて描画することで高精細なシネマグラフを実現する。

現時点のText2Cinemagraphには、いくつかの描画シーンにおいて限界が露呈する。例えば、複雑な構図の風景の一部を動かすことに失敗することがある。また、水の流れる方向が大きく変化する場合にも描画に失敗することがある。

3:テキスト指示で動画を編集可能にするAIモデル

Rerender A Video: Zero-Shot Text-Guided Video-to-Video Translation

https://arxiv.org/pdf/2306.07954.pdf

シンガポール・南洋理工大学の研究チームが発表した本論文は、テキストによって動画を編集する技法を提案している。

この技法を使えば、任意の動画に対して「南国風の色彩で」とテキスト入力すると、指示されたスタイルに動画を変換できる。この技法にはスタイルを変換するAIモデルと、変換した動画フレームの一貫性を維持するAIモデルが使われている。

以上の技法の実用的な応用事例には、アニメ調の動画をフォトリアルに変換する、あるいはその逆の変換が考えられる。さらには犬が映っている動画に関して、犬の頭部だけを猫やうさぎに変換することも可能である。

この技法は、入力動画から一定間隔にフレームをサンプリングしたうえでスタイルを変換している。それゆえ、短時間に急激に変化する動画のスタイル変換には失敗することがある。

4:複数の概念が含まれた画像から個々の概念を抽出してテキスト編集する技法「Break-A-Scene」

Break-A-Scene: Extracting Multiple Concepts from a Single Image

https://arxiv.org/pdf/2305.16311.pdf

Googleらの研究チームが発表した本論文は、複数の概念が含まれた画像から個々の概念を抽出してテキスト編集できる技法「Break-A-Scene」を提案している。

この技法を使えば、例えば人形が映っている画像から人形だけを抽出して、背景をテキストで指定した人形の画像が生成できる。この技法は、抽出した概念だけに対象としてテキスト編集できるようにするアルゴリズムを実装することで実現した。

Break-A-Sceneの実用的な応用事例には、複数の被写体が映った画像に対して、被写体の配置を編集することが挙げられる。また、任意の画像から背景だけを抽出して、被写体を変えることもできる。

Break-A-Sceneの制限事項として、例えば白昼に撮影された画像から被写体を抽出した場合、その被写体を夜間の背景に挿入しても被写体の照明は白昼のままであるときがあることが指摘できる。

5:1枚の人物画像からその人物の3Dオブジェクトを生成するAIモデル「Human-SGD」

Human-SGD: Single-Image 3D Human Digitization with Shape-Guided Diffusion

https://arxiv.org/pdf/2311.09221.pdf

クウェート大学らの研究チームが発表した本論文は、1枚の人物画像からその人物の3Dオブジェクトを生成するAIモデル「Human-SGD」を提案している。

1枚の画像から人物の3Dオブジェクトを生成するモデルはすでに存在しているが、発表したモデルは衣服の描画が大きく改善されている。というのも、Human-SGDは、事前に衣服の描画に関する訓練を行なっているからである。

Human-SGDには克服すべき2つの制限事項がある。1つ目は、視点に依存した描画が不完全なことである。同モデルは、人物の背面描画において前面描画と異なる照明表現が上手くできない。2つ目は、人物の多様なポーズに対応していないことである。こうした制限事項を克服すれば、より汎用的な3D人体描画が可能となる。

6:リアルタイムでフォトリアルな衣服を着用したアバターを生成する技法

Drivable Avatar Clothing: Faithful Full-Body Telepresence with Dynamic Clothing Driven by Sparse RGB-D Input

https://arxiv.org/pdf/2310.05917.pdf

https://drive.google.com/file/d/1D7JOnEc0zA2vMwxDARiP6NHeQVxvH929/view?t=10

アメリカ・カーネギーメロン大学らの研究チームが発表した本論文は、RGB-Dカメラで人物を撮影すると、リアルタイムでフォトリアルなアバターを生成する技法を提案している。この技法には、衣服をフォトリアルに描画するAIアルゴリズム「N-ICP」が使われており、衣服のたるみや動きを再現できる。

N-ICPは、はじめに被写体となった人物の体型から衣服の3Dオブジェクトを生成後、そのオブジェクトを初期条件として衣服の動きを物理演算によって出力する。こうした処理によりフォトリアルな衣服描画が実現したが、風にあおられるスカートのような急激な衣服の形状変化にはまだ対応できない。

今後の研究方針として、衣服の急激な形状変化への対応に加えて、多人数の衣服描画の実現が掲げられている。

7:テキスト入力からストーリーのある動画を生成するAIモデル「TaleCrafter」

TaleCrafter: Interactive Story Visualization with Multiple Characters

https://arxiv.org/pdf/2305.18247.pdf

中国・清華大学らの研究チームが発表した本論文は、テキスト入力からストーリーのある動画を生成するAIモデル「TaleCrafter」を提案している。

このモデルに対して例えば「王子と猫に関するストーリーを語って」と入力すると、指示されたキャラクターが登場するストーリー動画を生成する。ただし、登場キャラクターが動く描画はなく、カメラアングルが変化する動的なスライドショーのような動画が生成される。こうした動画のレイアウトは編集可能である。

TaleCrafterの性能検証のために、同様の機能をもつ既存モデルと比較実験を実施した。50人の被験者に対して、画像品質などの3項目に関してTaleCrafterと既存モデルを評価してもらったところ、TaleCrafterが3項目で最高得点となった。

なお、TaleCrafterの画像生成にはStable Diffusionを用いているため、画像生成の限界はStable Diffusionの性能に依存する。

8:複数のNeRF生成オブジェクトを合成する技法「SeamlessNeRF」

SeamlessNeRF Stitching Part NeRFs with Gradient Propagation

https://arxiv.org/pdf/2311.16127.pdf

香港中文大学の研究チームが発表した本論文は、複数のNeRF生成オブジェクトを合成する技法「SeamlessNeRF」を提案している。この技法を使えば、例えばミロのビーナスのNeRF生成オブジェクトと腕のある彫像のそれを合成して、腕のあるミロのビーナスを生成できる。

SeamlessNeRFの実用的な応用事例には、複数の複雑な形状のNeRFオブジェクトをモデリングの手間を省いてつなぎ合わせることが挙げられる。また、既存のアニメキャラクターのカスタイマイズも容易になる。

SeamlessNeRFを使ってNeRFオブジェクトを合成する場合、オブジェクトごとのライティングとマテリアルを考慮していないため、合成後にそれらの設定に齟齬が生じることがある。こうした齟齬の克服が、今後の研究課題として挙げられる。

9:ヒト型キャラクターの複雑なモーションを生成するAIモデル「C-ASE」

C·ASE: Learning Conditional Adversarial Skill Embeddings for Physics-based Characters

https://arxiv.org/pdf/2309.11351.pdf

香港大学らの研究チームが発表した本論文は、ヒト型キャラクターがモーションを学習するフレームワークを提案している。このフレームワークには、「C-ASE」と命名されたAIモデルが実装されている。

このモデルは基本的なモーションを習得すると、そのモーションを組み合わせて多様かつ複雑なモーションを生成できるというものである。

C-ASEには2つの制限事項がある。1つ目は、同モデルはGANベースであるため、GANベースモデルがしばしば陥るモード崩壊(変化に乏しい画像を描画すること)が生じることである。この問題は、ベースモデルに拡散モデルを採用することで改善される可能性がある。

2つ目は、モーションの品質はそれを実行するキャラクターの構造に依存することである。論文では31個の関節があるスケルトンで実験を行なったが、関節が17個のそれではモーションの品質が低下するかも知れない。

将来的な目標として、格闘ゲームのコンテストに出場できるレベルのモーション訓練が可能なフレームワークの開発が掲げられている。

10:1枚の画像から編集可能な3Dオブジェクトを生成するAIモデル「HyperDreamer」

HyperDreamer: Hyper-Realistic 3D Content Generation and Editing from a Single Image

https://arxiv.org/pdf/2312.04543.pdf

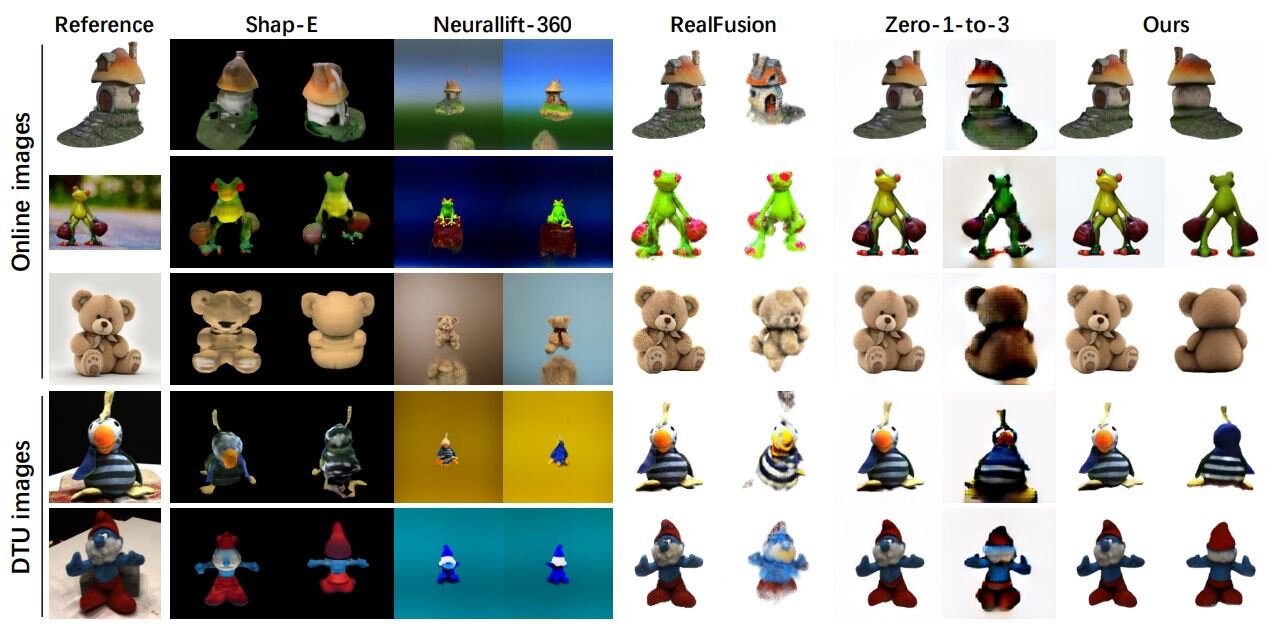

香港中文大学らの研究チームが発表した本論文は、1枚の画像から編集可能な3Dオブジェクトを生成するAIモデル「HyperDreamer」を提案している。このモデルで生成した3Dオブジェクトは、テキストによる指示で編集できるほか、照明設定の変更も可能である。

以上の論文では、HyperDreamerで描画したオブジェクトと、既存3Dオブジェクト描画モデルによって描画したオブジェクトを比較した画像が掲載されている。以下の画像の「Ours」がHyperDreamerの描画結果なのだが、最高品質であることが確認できる。

HyperDreamerは描画を高精細にする超解像に対応しているため、描画した3Dオブジェクトにズームインしても描画が粗くならない。

SIGGRAPH Asia 2023では、グラフィックAIを論じた論文数が前回に比べて増えており、もはやグラフィック技術にAIが使われるのは当たり前になったと言える。発表されたグラフィックAIの応用分野も多岐に渡るが、3Dオブジェクト生成と動画生成・編集に関するものが目立っている。

こうした分野のグラフィックAIの進化は、3Dオブジェクトと動画の制作に関する技術的な敷居を大きく下げることにつながる。AIの進化のおかげで、2024年には伝統的なグラフィック技術教育を受けていないユーザが3Dオブジェクトや動画の制作に参入すると予想される。そうなれば、斬新なアイデアに基づいたクリエイティブ作品が誕生するかも知れない。

TEXT_吉本幸記 / Kouki Yoshimoto

EDIT_小村仁美 / Hitomi Komura