株式会社 エルザ ジャパンは2023年6月28日(水)と29日(木)の2日間、東京・有明にて「ELSA XR プライベートセミナー」を開催した。今回はそのセミナーの模様をお届けする。

XR に関するソフトウェア・ハードウェアの最新動向を紹介

セミナープログラムはエルザジャパンによる「ELSA製品最新情報」、フィンランドVarjo社のMiika Jokinen/ミーカ・ヨキネン氏をゲストに迎えた「Varjo製品最新情報」、Epic Games Japan合同会社の向井秀哉氏による「海外のバーチャルプロダクションスタジオと最新動向」(28日)、PROTOTYPE Incの渡辺光章氏による「Sci-Fiからバックキャストしたモビリティの未来と最新事例」(29日)、NVIDIA合同会社の中嶋雅浩氏による「共創で突破するビジュアライゼーションの限界 Omniverse Enterprise」というラインアップ。

会場ではセミナープログラムと併せて、ELSA最新製品の展示および体験デモも実施。体験デモにはELSAが販売を開始したXRヘッドセット「Varjo XR-3 Focal Edition」、モバイル・バックパック型ワークステーション「ZOTAC VR GO 4.0 A4500」、デスクトップ型の「ELSA VELUGA」シリーズなどを用意していた。

本記事ではセミナープログラムの中から「ELSA製品最新情報」と、NVIDIAのセッション「共創で突破するビジュアライゼーションの限界 Omniverse Enterprise」をピックアップして紹介する。

なお、Epic Gamesのセッション「海外のバーチャルプロダクションスタジオと最新動向」については、こちらで別途レポートしているので、併せて参照してほしい。

ELSAの最新XR3製品の紹介

まずはエルザ ジャパンの林本和浩氏が、ELSAのXR最新3製品を紹介した。

Varjo XR-3 Focal Edition

産業機器の操作や乗り物の運転のシミュレーションに利用される、業務用MR(複合現実)ヘッドセット「Varjo XR-3 Focal Edition」。「Varjo XR-3」の上位機種として、Varjo XR-3の全機能を継承しつつ、人間の眼と同等レベルの視覚精度でMRコンテンツを視認できるところまで解像度を高めた。

MRカメラシステムは12メガピクセルの解像度を備えており、ヘッドセットから30~80cm(XR-3標準モデルは 45~250cm)という、手の届く範囲に対して最良の視認性をもたらすよう設定。また、LiDAR+RGBによる最大5mのデプスセンサー、アイトラッカーとハンドトラッカーも内蔵している。

動作環境はCore i9-9900K、Xeon W-2245、Ryzen 7 3700X以降、 8コア16スレッド 以上の CPU、32GB以上のRAM、NVIDIA RTX A6000、GeForce RTX 3080以上のGPU。

ELSA VELUGA G5シリーズ

ワークステーション製品「ELSA VELUGAシリーズ」に、「VARJO READYデスクトップワークステーション」を追加。Varjo XR-3 Focal Editionを快適に利用できる6100E、7100E、9400Eの3モデルが用意されている。6100Eと7100Eについては、CPUはIntelとAMDから、GPUはRTXシリーズとGeForceシリーズの中からカスタマイズできる。9400EはAMD Ryzen Threadripper Pro 5995 WXを搭載したモンスターマシンとなっている。

その他、コンパクトながらハイパフォーマンスな3100E、ラップトップ式のモバイルワークステーション15G46Mもリリースした。

ZOTAC VR GO 4.0 A4500

PC接続型XR-HMDの接続に特化したモバイル・バックパック型ワークステーションとして、VarjoXR-3に唯一対応する「ZOTAC VR GO 4.0 A4500」を発表。第11世代Core i7とRTX A4500を搭載したモバイルPCを小型のバックパック型にした製品で、ケーブルを踏む危険性のない、没入感の高いXR体験が行える。電源はホットスワップが可能なデュアルバッテリーを採用しており、Varjo XR-3のヘッドセット接続用DCケーブルも付属する。

外形寸法は約280.4(幅)×約347.5(長さ)×約87.1(高さ)mm、バッテリーを除く重量は2.94kg。

NVIDIAによるセッション 「共創で突破するビジュアライゼーションの限界 Omniverse Enterprise」

両日共に、セミナーの締めくくりはNVIDIA中嶋雅浩氏による「共創で突破するビジュアライゼーションの限界 Omniverse Enterprise」。「Omniverse」(および「Omniverse Enterprise」)の概要から導入事例まで、約1時間にわたって詳しく紹介してくれた。

Omniverseはデジタルツインをベースとした「インダストリアルメタバース」を構築・運用するためのプラットフォーム。中嶋氏は「NVIDIAはハードウェアベンダーとしての認識が強いかと思いますが、実は社内の半数以上がソフトウェアの開発者で、このOmniverseもかなり大きく投資を行なっているもののひとつです」と、本事業はNVIDIA内でも重要なプロジェクトであることを強調する。

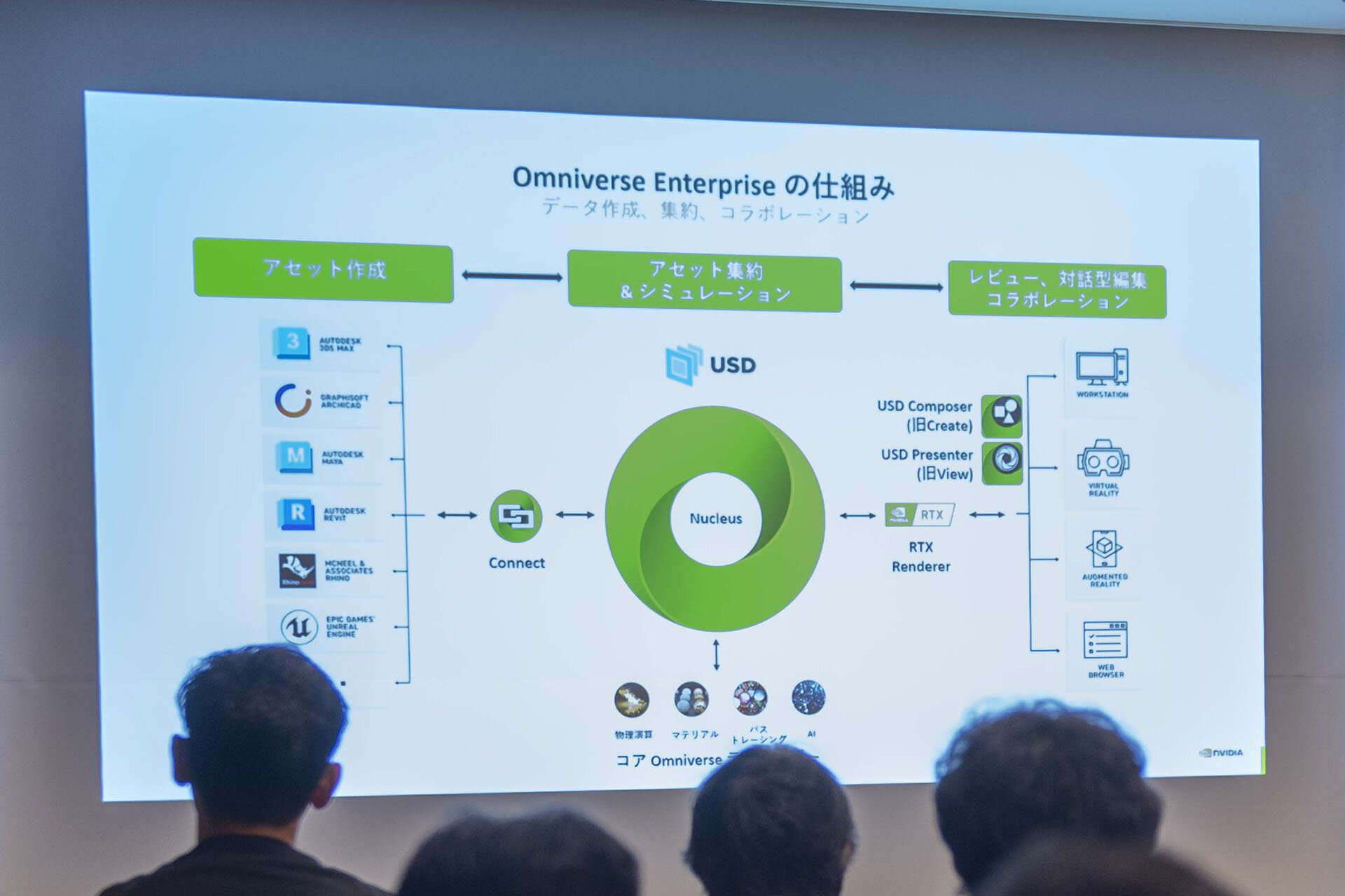

Omniverseのしくみとして、アセットはUSD形式をハブとしてOmniverseと制作ツール間を行き来できる。またエンタープライズ用途のサブスクリプションライセンス Omniverse Enterpriseでは実機レビューや2名以上のユーザーによるコラボレーションまでワンストップで行える

近年、デジタルツイン制作は大規模化、大容量化の一途を辿り、関わるスタッフも増えている。そうなると必然的に各セクションのスタッフがバラバラのツールを使ってアセット制作を行うことが増え、データの集約が課題となる。

そこでNVIDIAはOmniverseにおいて、Pixarが策定した汎用ファイルフォーマットUSD(Universal Scene Description)をハブとして各種アプリケーションのデータ形式の差異を吸収する方法を採用。

「USDはデータをいかに短時間で効率良くつくっていくのかをテーマに、たくさんの人々が知恵を絞って完成させた、知の集大成とも呼ぶべきファイル形式です。内部的にはレイヤー構造になっているため、アプリケーションごとに別のデータを取り込んだり、あるいは別々のスタッフが同じアプリケーションで作業したデータを取り込んでも、各データは独立して管理できます」(中嶋氏)。

Omniverseのワークフロー

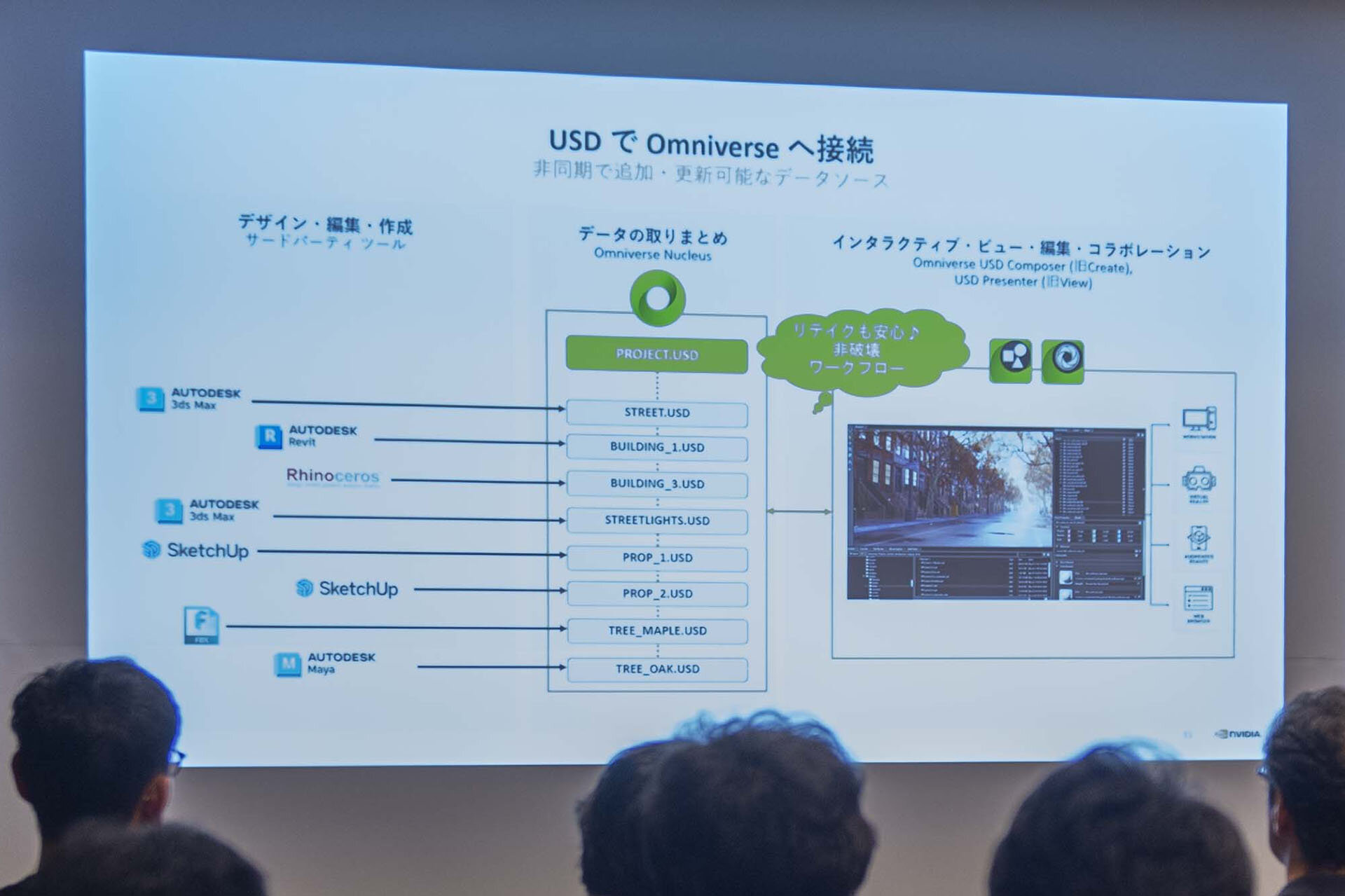

スタッフは制作ツールでアセットを制作し、USD形式でOmniverseと接続。この方法で各スタッフがOmniverseに同時アクセスし、デジタルツイン全体をリアルタイムでアップデートしていくというのが、USDを介したOmniverseによるワークフローだ。

作業中のデータはRTXテクノロジーによってリアルタイムレイトレーシングされ、物理シミュレーションも反映される。完成したデジタルツインコンテンツは各種デバイスに送信して実機レビューを行うことも可能だ。

このワークフローの利点はいくつもある。まずは部分的な修正が発生しても、全体としての手戻りはなく、必要箇所のみ修正するだけで、Omniverseが全体を再計算してくれるというところ。そして、制作作業の拠点を選ばず、外注による作業者とのコラボレーションもしやすいということ。さらに、マネージャーは全体の様子をリアルタイムで確認できることから、製品開発のリードタイム短縮が期待できる。

「NVIDIAは現在、3DCGツールやハードウェアベンダーの協力の下、Omniverseを世界最大のツールエコシステムにすることを目指しています」と中嶋氏。Omniverseは30万ダウンロードを超え、デジタルツイン制作に関する主要アプリケーションとのUSDコネクションは200種類を数え、連携が取れた状態にあるという。

拡張性も備えたUSDのコネクタ

USDとOmniverseのリアルタイム同期(ライブシンク)が可能なアプリケーションは多数ある。制作アプリケーション側からも、Omniverse側からもアップデートを同期できるツールは3ds Max、Maya、Unreal Engineなど。Houdiniは現在ベータ版のみ対応する。制作アプリケーションからのみアップデートをライブシンクできるツールはArchicad、Revit、Rhinoceros、SketchUpなど。それ以外のファイル形式は一般的なインポート・エクスポートでOmniverseに取り込むことができる。

ちなみに、このコネクタにはSDK(ソフトウェアの開発に必要なデータなどがまとめられたもの)が用意されている。そのため、自社ツールとOmniverseをライブシンクするコネクタを開発して追加するという、パイプラインでの活用も期待できる。

また、USDにはメタデータをもたせることが可能なため、3Dデータではないもの、例えばCSVや図面、各種センサーの情報などもOmniverseに取り込むことができる。取り込んだ情報はOmniverse上で処理し、オーバーレイ表示などの方法で可視化できる。「こうした情報を整理して、プロジェクトのダッシュボードをOmniverseの中につくることもできます」(中嶋氏)。

なお、Omniverseの特長のひとつ、リアルタイムレイトレーシングだが、これが実はVRコンテンツにも適用できるという。中嶋氏は「これまではテクノロジー上の理由から、VRコンテンツでリアルタイムレイトレーシングは行えませんでした。やっとパフォーマンスが追いつくようになってきたので、いよいよです。また、USDとのコネクションを活用することで、VRの体験中にダイナミックにコンテンツを変更するような使い方もできます」と話す。OmniverseとGPUの掛け合わせによる、さらなる上質なVR体験がすぐそこまで来ている。

Omniverseの導入事例:BMW「スマート・ファクトリー」

セミナー後半では、Omniverseの導入事例がいくつも紹介された。そのひとつ、BMWの「スマート・ファクトリー」についてここで取り上げる。

BMWに限らず、工場の運用管理においては、プランナーやエンジニアなど多数の専業スタッフが日夜専用ツールを用いて業務を遂行しており、各種データもバラバラになりがちだ。しかし、そのような部門間の分断は、会社が意思決定を行う際に障壁となる。各専門チームと上層部は個別に会議室で報告を受けるといったやり方にならざるを得ず、上層部の総合的な判断に狂いが出る可能性があるためだ。

そこで、BMWではデータを全てUSDに変換し、プランナーやエンジニアなど全てのステークホルダーが同じ状態で意思決定できるよう、工場のデジタルツインをOmniverse上に構築した。全員で決める必要がある運用上の課題などは、全てOmniverseの中でシミュレーションを行い、解決するようにした。

BMWではこのワークフローへの変更後、アウトプットが10〜25%増加し、予定外のメンテナンスは80%まで削減し、コストは70〜80%削減、最終品質が25%向上したという。

information

株式会社 エルザ ジャパン

https://www.elsa-jp.co.jp/special/detail/nvidia-omniverse/

TEXT__kagaya(ハリんち)

EDIT_山下一貴 / Itsuki Yamashita(CGWORLD)