[PR]

コスパに優れた慣性式モーションキャプチャシステム「MVN」が、最新の2020.0にメジャーアップデートされた。 前回のバージョン2018で慣性式の弱点と言える磁気干渉の問題を克服したが、今回の2020ではVIVEトラッカーをネイティブサポートすることで位置ズレの問題を解消。 最大4人でのインタラクティブ性を伴う収録にも対応するなど、さらに使い勝手よく進化している。

-

-

ゼロシーセブン株式会社

ゼロシーセブン株式会社 センシングプロダクツ事業部

〒107-0052

東京都港区赤坂5-4-7 The Hexagon 7F

TEL:03-3560-7747

E-MAIL:info@0c7.co.jp

URL:http://zeroc7.jp/products/mvn3/

現在、ゼロシーセブン株式会社では「MVN Animate 2020」最新版2020リリースにあわせて、

法人様限定で、割引オファーを実施中!!

導入を検討しているお客様、導入済みのお客様も通常価格より、グッとお求めやすい価格でご提供いたします。

ご希望のお客様は下記フォームよりお申し込みください。担当よりご連絡いたします。

>>お申し込みはこちらから

場所を選ばずにモーションキャプチャが可能なXsens MVNの魅力

ゲームやアニメ、ライブエンターテインメントから製品開発における動作分析まで幅広く活用されるモーションキャプチャ技術。現在は光学式と慣性式の2種類が一般的であり、光学式は大規模な収録スタジオを必要とするが、そのぶん精度の高いキャプチャが行える。一方の慣性式は場所を問わない収録環境の自由度と、簡易的にキャプチャできるという利点があるものの、一般的に光学式と比べて汎用性や精度が劣る、などの課題も少なくない。

こうした状況において、「場所を問わず、10分もあればキャプチャできる」という慣性式の利点を残しながら、精度面の弱点を克服したのがXsens MVNだ。MVNは加速度やジャイロなどの10軸センサー情報を統合して正確な方位を取得できる「センサーフュージョンアルゴリズム」と、モデルの正確な接地情報(フットコンタクト)を検知可能かつポスト処理を自動化する「Motion Captureエンジン」の2つのコアテクノロジーをもつ慣性式モーションキャプチャで、ゲーム業界やVTuber運営会社、伝統芸能アーカイブの分野でハイエンドなユーザーに広く活用されている。

MVNは2018年のアップデートで「磁場の影響を除去」「スキンアーティファクトを除去(HD Reprocessing)」という2つのエンジンを追加。特にHD Reprocessingはユーザーからの評価が非常に高く、「激しいアクションを収録した際もフットスライドが少なく、接地情報を修正しなくて済むようになったという声をいただいています。近年ではスマートフォンアプリでも3Dモデルを使用するケースが増えていますが、"必要最低限のポスト処理だけでローンチしたい"というスピードプロダクションでも活用が進んでいます」(渡邊英樹氏)と、精度面の向上につながったとの声も多い。実際に、光学式モーションキャプチャを導入している大手スタジオが後発でMVNを導入する事例があることからも、同製品の信頼性の高さが窺える。

さらなる進化のカギは「複数人のパフォーマンス精度」

これまでのアップデートで、場所を問わず、ポスト処理不要で高精度な収録を行うことができるようになったMVNの次なる課題は、複数人でパフォーマンスを行う場合の相対的な位置ズレだった。これは慣性式全般の弱点であり、例えば4人のアイドルがダンスパフォーマンスを行う場合、激しいアクションと共に細かなドリフトが積算してしまい、最終的なズレが大きくなってしまうというものだ。

慣性式の中ではドリフトが少ないMVNでも、長時間にわたるキャラクター同士の掛け合いが発生するようなVTuber業界のライブステージや、「キャラクター同士が手を合わせる」など互いの正確な位置関係の把握が必要な演出においては、ユーザーがそれぞれ工夫をしながら使っているような状況だったという。

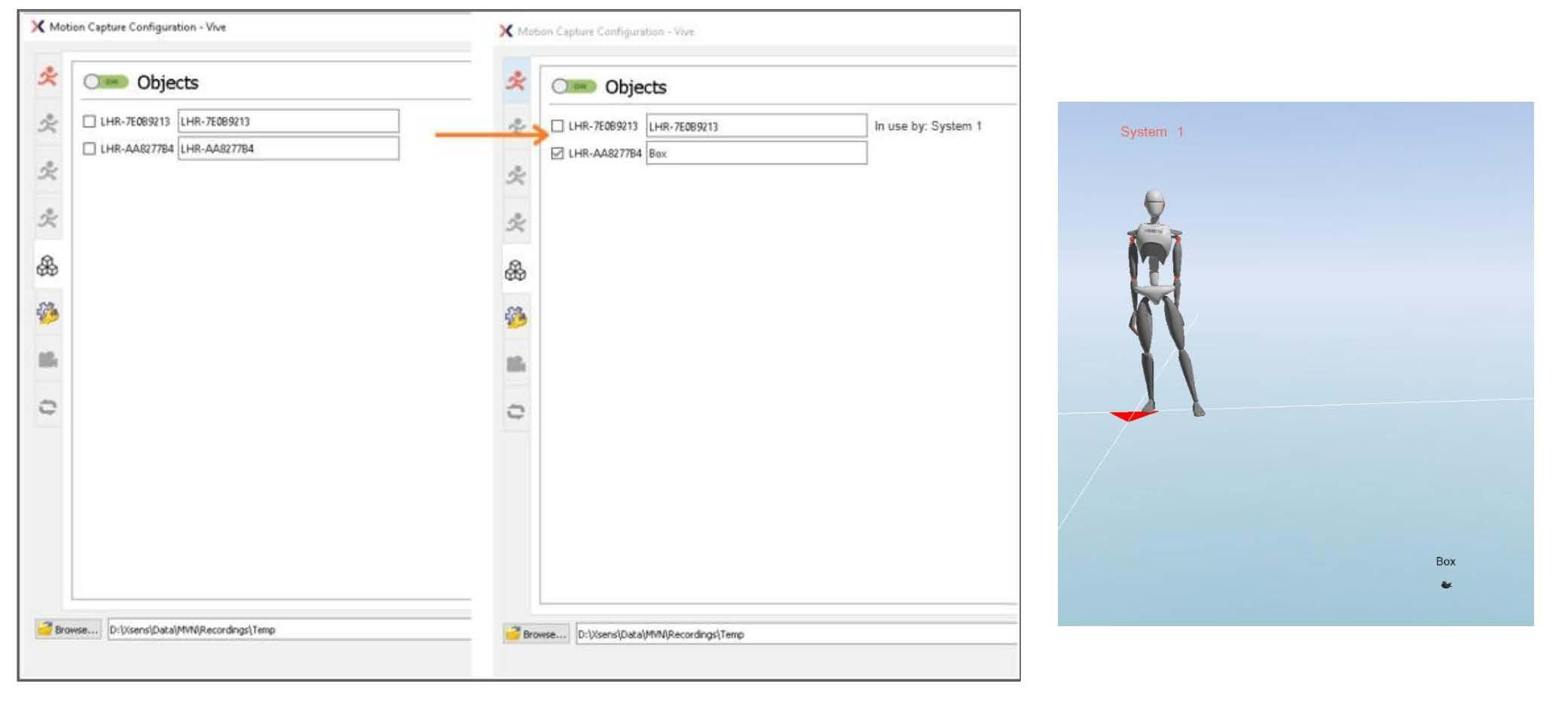

こうした状況を解決するために、MVN 2020.0のアップデートではHTC VIVEトラッカーをネイティブサポートし、位置ズレの問題解決を実現。「MVNでは最大4名の同時収録が可能ですが、このときにお互いの相対位置がずれてしまう問題はXsens側も把握していました。今回のアップデートは、この状況をVIVEトラッカーで解決しようというコンセプトです。アクターの腰や腕などの部分にVIVEトラッカーを装着してもらい、相対的に他の人の位置を特定することによって、時間経過に伴うドリフトを最小化することができるようになります」(渡邊氏)。

▲VIVEトラッカーの腰への装着例

▲VIVEトラッカーの腕への装着例

▲VIVEトラッカーによる位置補正ありとなしの比較。位置補正なしの場合、はじめに2人が両手を合わせた状態から時間が経過していくにつれて相対位置がずれていき、最後にもう一度手を合わせたときに大きくずれている。一方で位置補正ありの場合は最後まできちんと合っていることがわかる

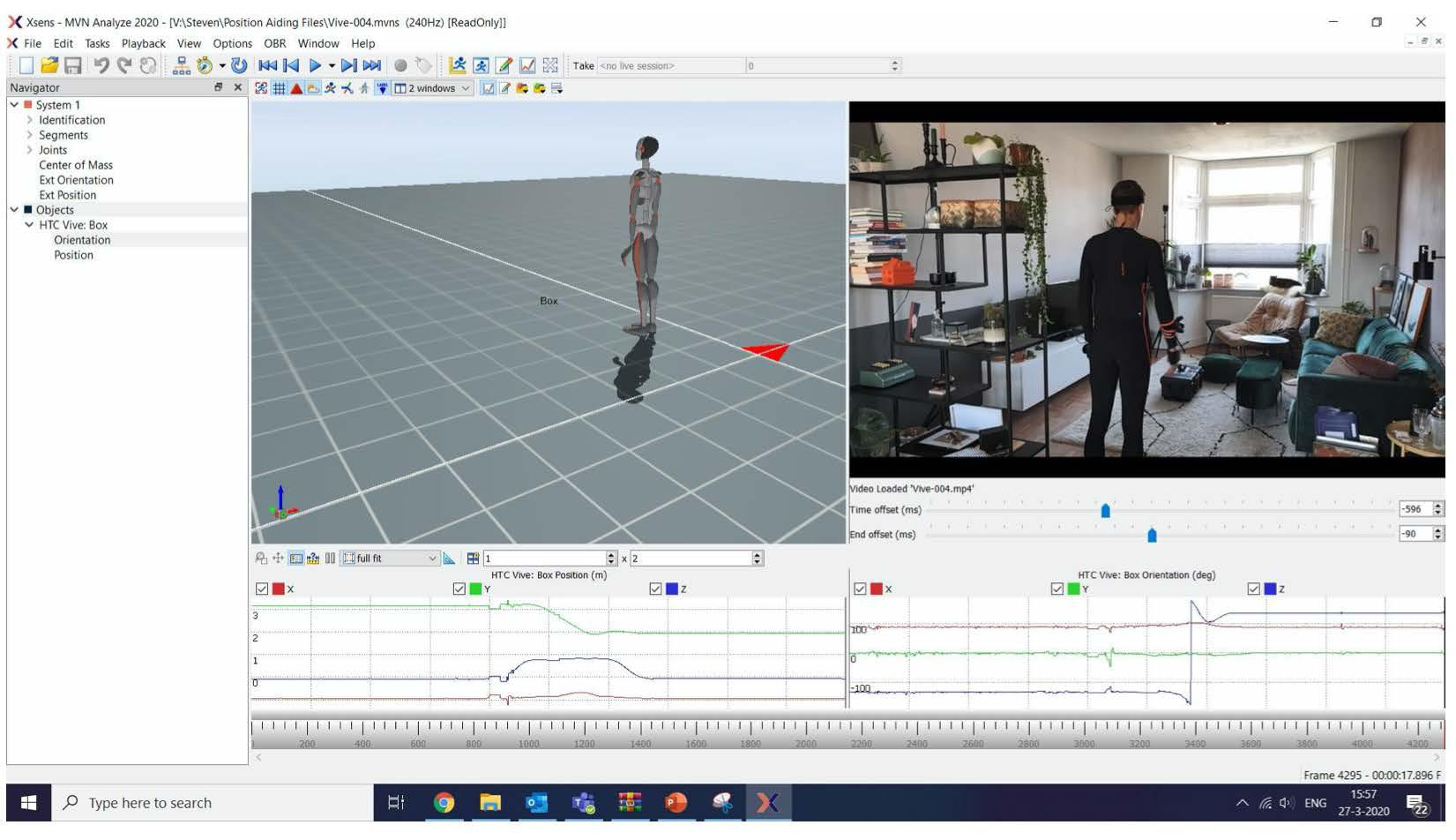

このアップデートの利点は位置ズレの解決だけではない。VIVEトラッカーをネイティブで認識することにより、トラッキングできる空間上にプロップを自由に配置することができるようになっている。従来は手から離れてしまったプロップ位置をトラッキングすることができなかったため、これは純粋に「できることが増えた」アップデートと言えるだろう。いわゆるオブジェクトトラッキング機能の実装だ。

▲VIVEトラッカーによってオブジェクトトラッキングが可能になり、物を投げたり物にぶつかって動いたりといったインタラクションを伴った動きにも対応できるようになった

ハードウェアとして必要なのは人数分のVIVEトラッカーとベースステーションのみで、ベースステーションを4基用いれば10m四方の空間で精度の高いモーションキャプチャが可能だ。「私が行なった検証では、2人のアクターがアクションを取った後、最後に手を合わせるといった難しいモーションも綺麗に再現できており、精度の高さに驚いています。MVNで同時にトラッキングできるのは最大4名で、プロップなども含めたHTC VIVEの認識数は最大16個となります。ベースステーションを用いて最大10m四方の中で高精度の収録を行うか、100m走るなどの空間制約のないアクションをMVN単体で行うか、ユーザーは使い分けをしていくことになります」(ジョン・ウォンソク氏)。

▲システム構成

▲計測範囲

なお、この機能は現在オフライン補正のみ(ライブプレビュー時にはズレは残るが、ポスト処理で補正が有効)だが、秋頃に予定されている次回のアップデートではリアルタイム補正も可能になる見込み。つまり、今後はMVNとVIVEトラッカーだけでバーチャルカメラが実現可能となる予定だ。

MVN Animateが正式に日本語対応、サードパーティのフェイシャルキャプチャとのネットワーク同期も可能に

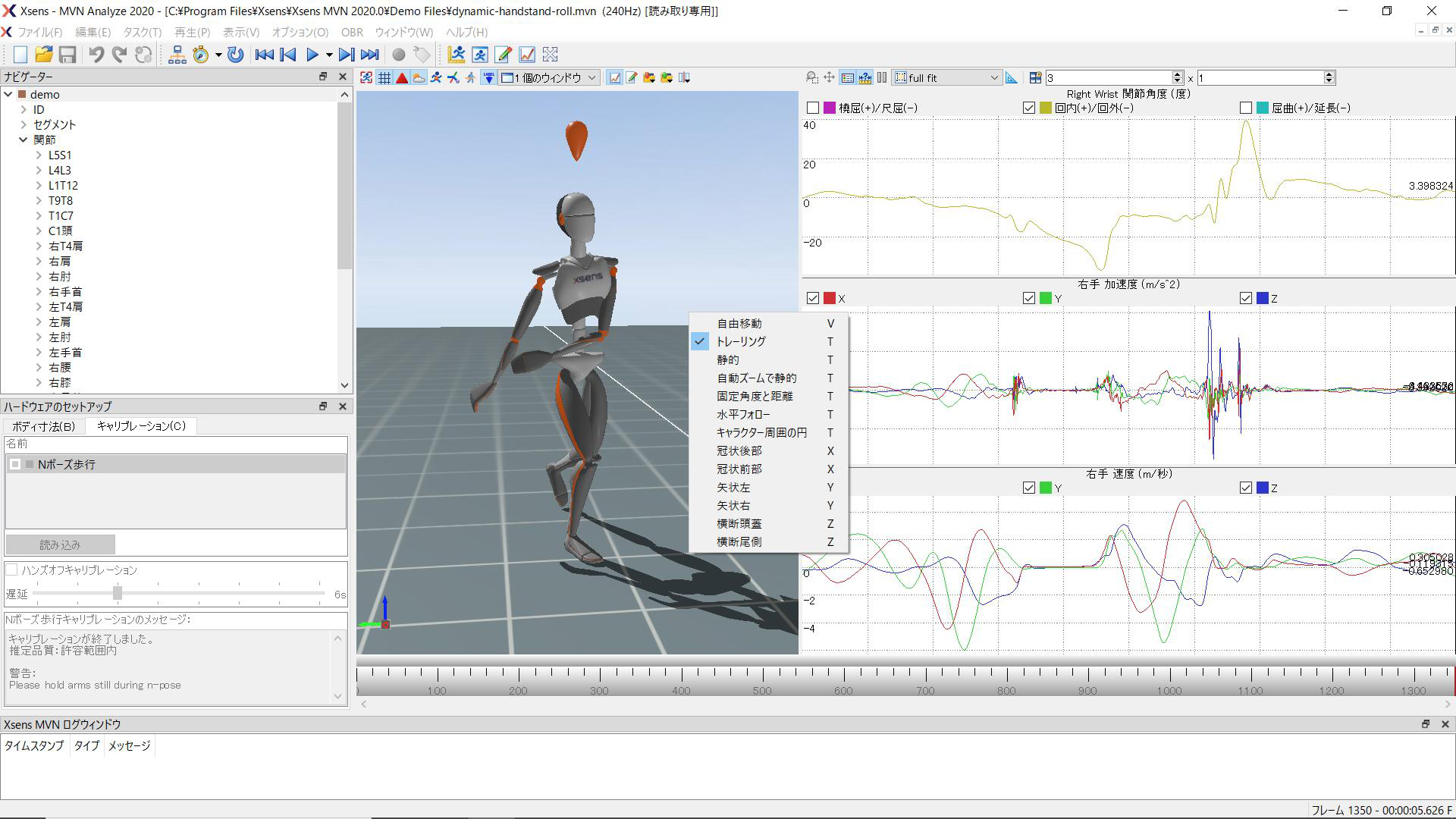

MVN Animateの日本語対応も今回のアップデートの要点のひとつだ。デフォルトの英語に加え、今回から日本語・中国語・韓国語にも対応するため、国際色豊かなスタジオではクリエイター自身が好きな言語を選択できるようになるメリットがある。キャリブレーションの結果などを示すポップアップのエラーメッセージも日本語化されていることから、重要な情報の見落としも減りそうだ。

▲メニューやオプション名が日本語対応したUI。初めて使用する場合でも、ひと目で内容が把握しやすくなった。また、英語だとスルーしがちなポップアップメッセージも日本語化することでトラブル防止に一役買っている

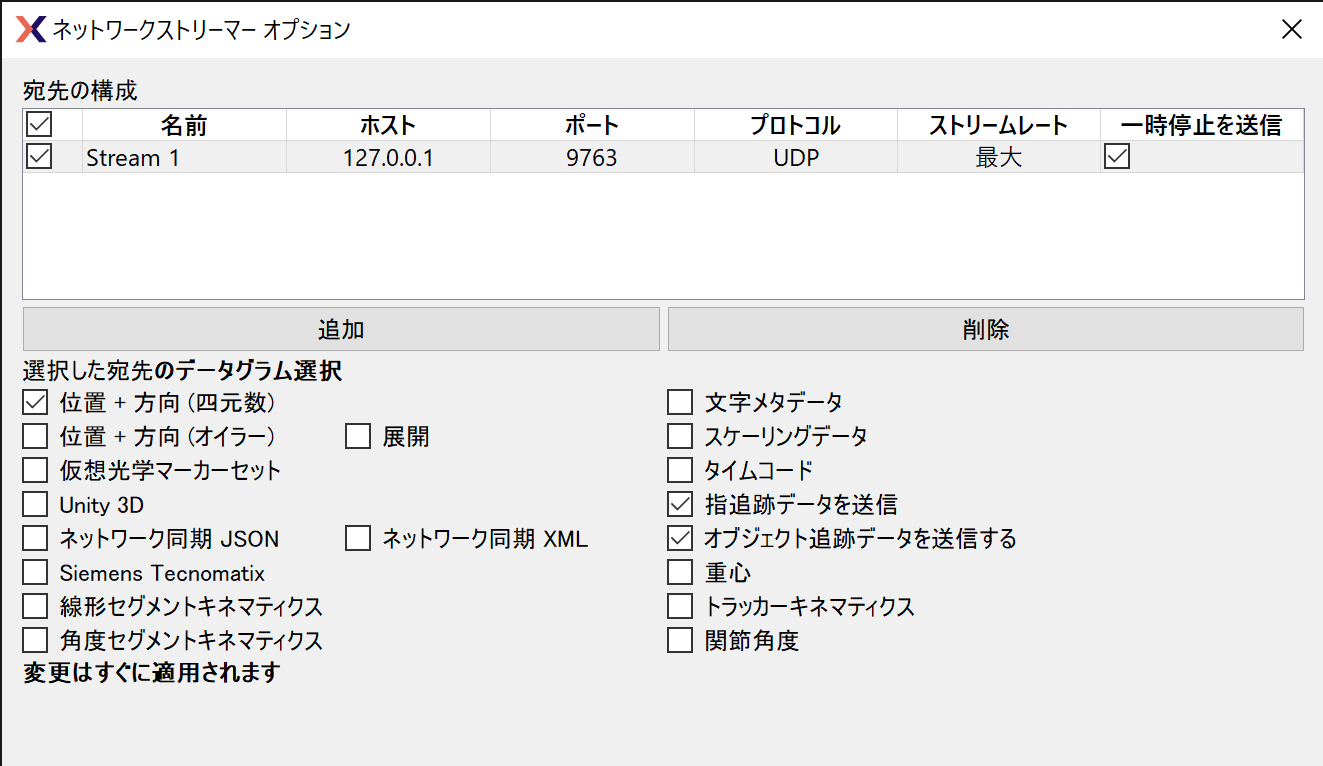

また、FacewareやDynamixyzなど他社製フェイシャルキャプチャソフトとネットワーク同期を行う機能が追加されており、モーションキャプチャと共にフェイシャルの同期収録も可能となっている。フェイシャルも同時一緒に収録したいというニーズは非常に高く、例えば国内においてはVTuber、海外においてはデジタルヒューマンの潮流があることから、今後MVNとFacewareやDynamixyzを併用するような収録方法が広く行われるだろうと渡邊氏は説明する。

「欧米ではフォトリアルな3DCGの人物を制作する需要が高まっています。例えば昨年のTEDでは、Digital DomainのDoug Roble氏が自身の精巧な3Dモデルを使って講演を行なっていました。これはLightStageで制作した3DCGモデルをモーションキャプチャとフェイシャルキャプチャをもとにUE4上で動かすといったしくみで、表情筋の動きのパターンを機械学習によって再現しています。こうした事例は将来的に国内でも増えてくるはずです」(渡邊氏)。

▲2019年5月に開催されたTEDカンファレンスでのDoug Roble氏による講演。ボディの動きをMVNのキャプチャスーツとManus VRのグローブでキャプチャし、フェイシャルをFox VFX LabのヘッドマウントカメラとDigital Domainのインハウスツールを使ってリアルタイムに再現した

そのほかにも、従来シングルCPUでしか動作しなかったHD Reprocessingがマルチスレッドに対応し、ポスト処理の時間的コストが何倍も削減できるようになったことも大きなポイントだ。

今後は先述のVIVEトラッカーのリアルタイム対応が予定されているほか、ゼロシーセブンとしても定期的にウェビナー形式でMVNの活用法を周知していく予定とのこと。モーションキャプチャシステムを内製でもつ工数的なメリットは大きいため、今後さらなる需要が見込まれそうだ。

▼最大30%OFF 限定割引キャンペーン実施中!!

現在、ゼロシーセブン株式会社では「MVN Animate 2020」最新版2020リリースにあわせて、 法人様限定で、割引オファーを実施中!!導入を検討しているお客様、導入済みのお客様も通常価格より、グッとお求めやすい価格でご提供いたします。 ご希望のお客様は下記フォームよりお申し込みください。担当よりご連絡いたします。

>>お申し込みはこちらから

▼INFO

Xsens MVN2020ウェビナー

主催:ゼロシーセブン株式会社

日時:6月3日(水) 14:00~15:00

内容:MVN Animate (CGアニメーション用途向け)

定員:先着100名様

申し込み:下記フォームよりお申し込みください

<http://0c7.co.jp/contact/webinar/mvn-webinar.html>

Virtual Ergonomics Event(Webカンファレンス)

日時:5月27日(水) 日本時間16:15~23:00

内容:MVN Analyze(人間工学/バイオメカニクス用途向け)

申し込み:下記フォームよりお申し込みください

<https://www.xsens.com/virtual-ergonomics-event>

Xsens and Glassbox バーチャルプロダクション(英語)

日時:5月29日(金) 日本時間18:00~19:00

内容:MVN Animate (パフォーマンスキャプチャ)

申し込み:下記フォームよりお申し込みください

<https://content.xsens.com/xsens-and-glassbox-demonstrate-streaming-motion-capture-data-and-virtual-production-techniques-through-a-virtual-private-network>

Xsens and Dynamixyz(Unity&Unrealへのパイプライン)

日時:6月3日(金) 日本時間17:00~18:00

内容:MVN Animate (パフォーマンスキャプチャ)

申し込み:下記フォームよりお申し込みください

<https://content.xsens.com/xsens-full-body-dynamixyz-facial-mocap-solutions-syncing-the-pipeline-into-unreal-and-unity

>