昨年2020年12月2日(水)から4日(金)まで、コンピュータグラフィックス技術に関する国内最大の学術シンポジウムである「Visual Computing 2020」(以下、VC2020)が、オンライン開催された。同イベントは、CG技術に関わる先端的な学術研究成果や、その制作現場への還元について産学の垣根を超えて議論する場として、画像電子学会 Visual Computing研究会、情報処理学会 コンピュータグラフィックスとビジュアル情報学研究会、映像情報メディア学会 映像表現&コンピュターグラフィックス研究委員会による共催、およびCG-ARTSによる特別後援のもとで開催されている。28回目を迎えた今回は、1993年の初開催以降最多となる500名の技術者、研究者、クリエイター、学生が参加し、最新の研究成果に関する論文発表やポスター発表、企業出展などの多様な企画が催された。

その中でも本レポートでは、研究論文セッションで発表された国内CG研究の最新動向の一端を紹介する。特に、VC論文賞を受賞した「セルアニメ作品の3次元的な矛盾に着目した2.5Dモデルの一検討」(筆頭著者:東京大学 福里 司氏)と、VCショート発表賞を受賞した「動画生成のための3次元顔変形モデル」(筆頭著者:サイバーエージェント AI Lab 楊 興超氏)の2つの論文にフォーカスする。

TEXT_向井 智彦 (東京都立大学システムデザイン学部インダストリアルアート学科 准教授)/ Tomohiko Mukai(Associate Professor, Department of Industrial Art, Faculty of Systems Design, Tokyo Metropolitan University)

EDIT_山田桃子 / Momoko Yamada

Special thanks to Visual Computing 2020 運営委員会

「VC2020」のセッション概要

VC2020は、最新の学術研究成果を報告する場である研究論文セッションをはじめ、関連分野で活躍されている著名な研究者による特別講演、近年注目を集めている研究開発者による招待講演、萌芽的な研究について議論するポスターセッション、および企業出展・協賛企業講演セッションで構成された。いわゆる登壇発表にあたる論文発表と特別講演、招待講演はZoom上でオンライン配信されるとともに、参加者専用のslackを通じて意見交換を行うというスタイルで行われた。また、対話や交流が主となるポスターセッションや企業出展は、Remoというオンラインイベントツールを用いて行われた。

特別講演

ユタ大学のCem Yuksel氏と国立天文台の田崎文得氏による2件の特別講演が行われた。Cem Yuksel氏による「Simplifying Complexity in Computer Graphics」と題した海外特別講演では、SIGGRAPHなど著名な学術会議においてYuksel氏が発表した多数の研究成果のダイジェストが紹介された。講演の中では一貫して、簡潔なアイデアや計算方法によって精細かつ複雑なCG映像を表現するという研究姿勢が示されていた。また、Yuksel氏独自のリアルタイム映像合成システムも聴衆の大きな関心を集めていた。

田崎文得氏による「ブラックホール画像化 EHTプロジェクトによる史上初の成果-」と題した特別講演では、2019年4月に国内外で大きな話題となった、史上初のブラックホールの映像化に関わる様々取組が紹介された。具体的には、最先端の望遠鏡システムや画像処理技術、統計分析手法の応用や、国際的プロジェクトチームの連携、そして研究成果を一般社会に広報するための工夫などについて講演された。講演の中では、映像化システムの妥当性を検証するための事前実験において、雪だるまの形状を模した仮想ブラックホールデータが用いられたという、とてもユーモラスな秘話も紹介された。

招待講演セッション

世界的に著名な学術雑誌や国際会議で発表された、15件の研究成果に関する招待講演が行われた。世界的最高峰のCG会議であるSIGGRAPH ASIA 2019とSIGGRAPH 2020で発表された論文を筆頭に、国際的もトップレベルと認知されている研究成果について日本語で聴講できる数少ない機会であるとともに、著者自身から研究活動における苦労話などを聞くことができる珍しい機会であった。

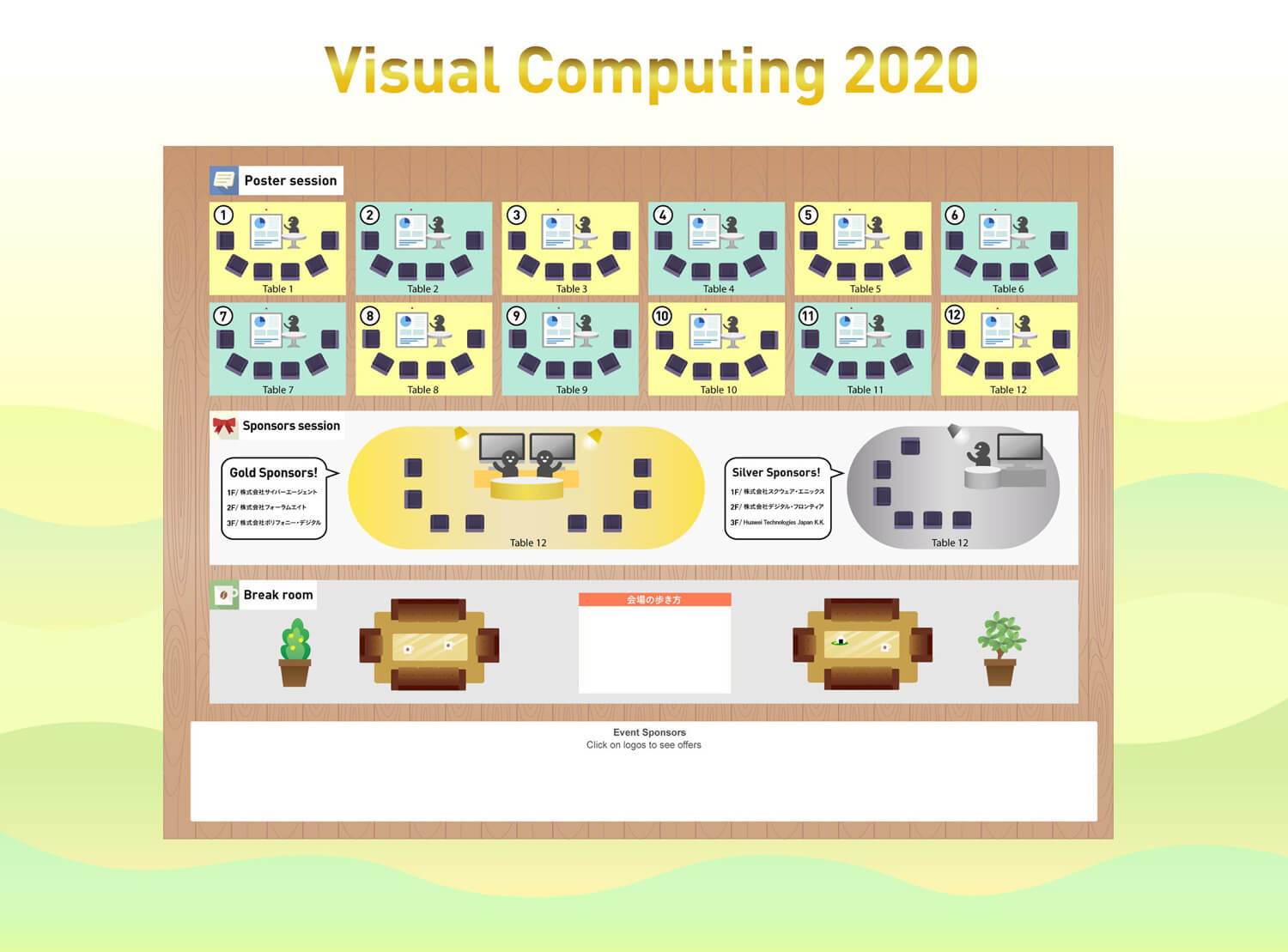

ポスター・企業展示セッション

Remo上に用意された仮想ルーム内に発表者と聴講者が集い、萌芽的な研究内容について意見交換が行われた。ポスターセッションは会期中の各日、それぞれ10~20件程度の発表を実施。学生の卒業研究や修士研究をはじめ、大学教員や企業研究員による多様な発表に対して、多くの聴講者が熱心に耳を傾けていた。また、企業展示セッションも同一時間帯に開催され、各協賛企業の開発者や人事担当者と大学生・大学院生・教員が交流を深めていた。ちなみに今回の協賛企業講演の中で、前回のVC2019において協賛企業ブースを訪れた学生が、その後にインターンを経て社員採用に至った事例が紹介されていた。CG業界への就業を志望する学生と産業界とを繋ぐ機能という、学会の側面を端的に表わすエピソードであろう。

研究論文セッション

研究論文セッションでは、30名の査読委員による厳正な査読を経て採択された11件のロング発表と、22件のショート発表が行われた。その中から専門委員による第一次審査(論文の評価)と第二次投票(登壇発表と論文の総合評価)を経て、VC論文賞1件とVCショート発表賞1件がそれぞれ選出された。本稿ではこの2件の受賞論文の内容を紹介する。

なお、これらのセッション以外にも協賛企業講演や、スタジオジブリとバンダイナムコ研究所による企業招待講演も行われた。詳細については関連記事「スタジオジブリとバンダイナムコ研究所、それぞれの研究開発のリアル~Virtual Computing 2020企業招待講演レポート」を参照されたい。

セルアニメ作品の3次元的な矛盾に着目した2.5Dモデルの一検討

福里 司氏(東京大学)

www.i.u-tokyo.ac.jp

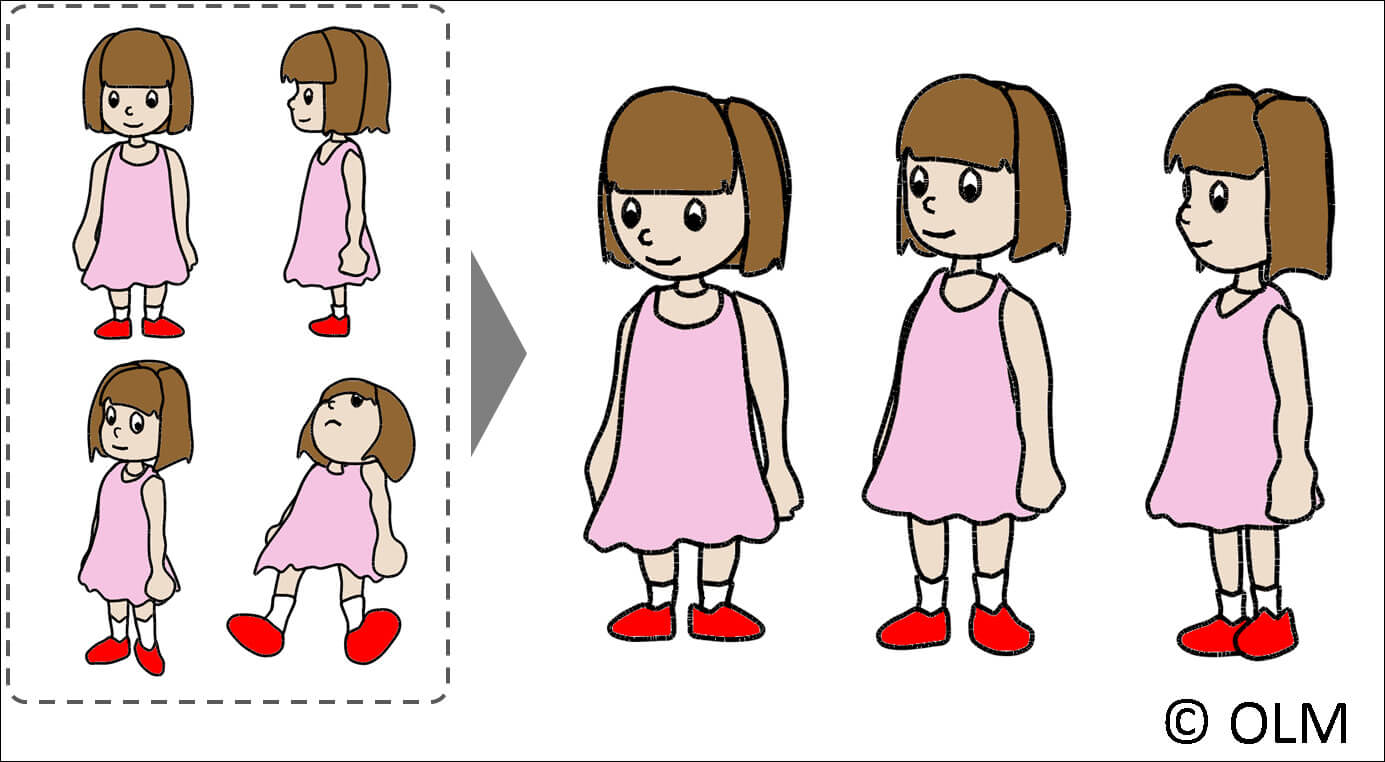

VC論文賞を受賞したのは、福里 司氏(東京大学)と前島 謙宣氏(オー・エル・エム・デジタル/IMAGICA GROUP)による「セルアニメ作品の3次元的な矛盾に着目した2.5Dモデルの一検討」である。誤解を承知のうえで簡潔に表現すると、この論文はLive2Dの進化版に関する研究成果について報告している。つまり、2Dイラスト画像の変形によって3D的な映像表現を実現するという、2.5Dモデルの基本的なアイデアを発展させることで、従来技術よりも直観的かつ高品質な映像を得るための計算方式を提案している。さらに、2.5Dモデルを効率的に設計するためのユーザインターフェースも同時に提案し、ユーザテストを通して提案手法の有用性を報告している。

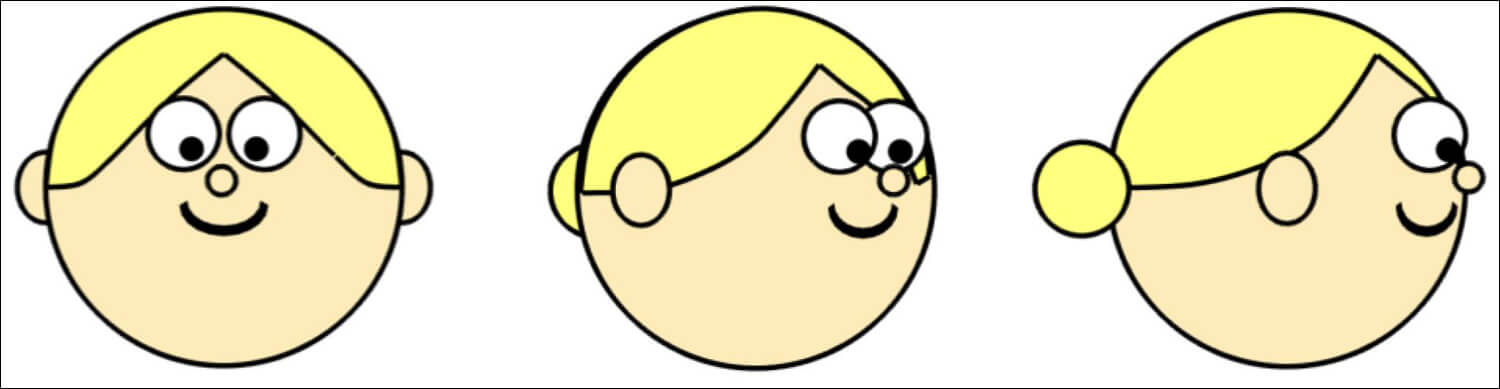

この研究の背景として、セルアニメ作品制作の効率化に対する需要が挙げられる。たとえば、奥行方向を含むカメラワークなどの3D運動を表現する技法として、セル画調の3Dキャラクタモデルを利用するアプローチが広く普及している。しかし、セルアニメ作品に見られるような、複数の視点の間に生じる3D構造上の矛盾に対応できないという欠点がある。たとえばミッキーマウスの耳部は、どのような視点から見ても円形で表現され、かつ片方の耳が下側に移動している。しかし、一般的な3DCGソフトウェアで単一の静止3Dモデルを制作する方法では、そうした現実世界ではありえない表現を実現できない。こうした短所を補う技術も盛んに研究されており、たとえば視点に合わせて3Dキャラクタモデルを変形させる技術が提案されている(文献「View-dependent Geometry」、「View-dependent Control of Elastic Rod Simulation for 3D Character Animation」)。この技術では、カメラの移動に応じて3Dモデルを形状変形させることで、セルアニメ作品特有の「ゆがみ」を表現する。ただし、こうした技術を導入したとしても、基準となる3Dモデルの制作自体が難しいことには変わりない。たとえば「スネ夫の髪型」のような大きな「ゆがみ」を伴うセルアニメ表現では、ベースとなる3Dモデルの制作に加えて、視点移動に応じたモデルの変形について、試行錯誤的な検討や作業が必要である。

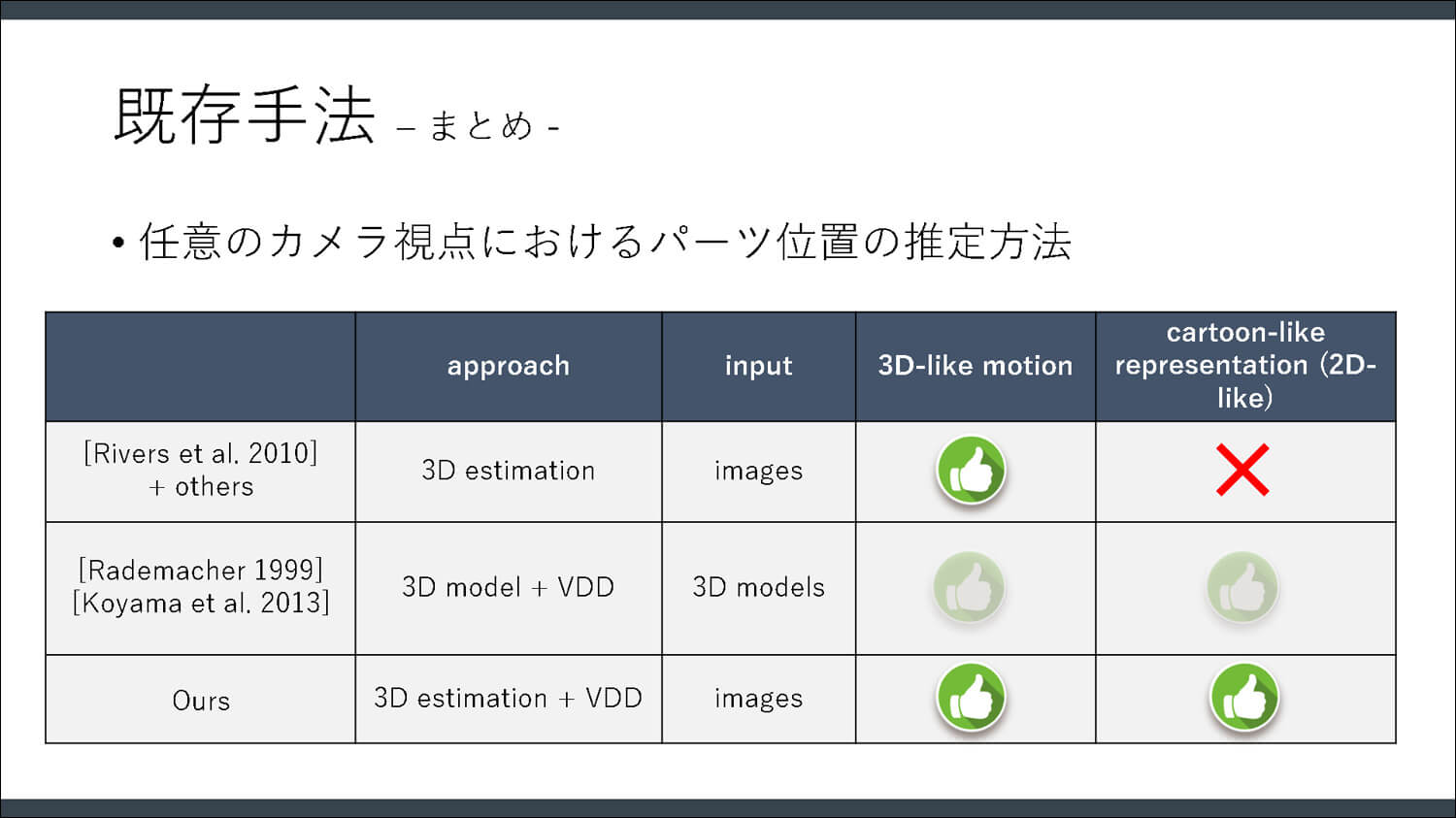

一方、3Dキャラクタモデルの代わりに、数枚の2Dイラスト画像の移動や変形、レイヤー合成によって、3D的な動きを実現する技術が研究されている。たとえばLive2Dなどの既存ソフトウェアでは、イラストを構成する複数のパーツをレイヤー状に構成し、それら各パーツに変形を加えることによって3D的な動きや視点移動を表現する。SIGGRAPH 2010で発表された「2.5D Cartoon Models」という論文では、2Dイラスト各パーツの奥行き位置をカメラ移動に応じて自動推定することで、パーツの重なり順を自動決定する方法が提案されている(文献「2.5D Cartoon Models」)。

Riversらの2.5Dモデルは、次のようなながれで構築される。

(1)イラスト各パーツの位置と形状を操作することで、いくつかの視点におけるモデルの外観を決定する

(2)入力された各パーツの2D中心位置を対象とした三角測量により、3D空間内における入力パーツの奥行き位置を推定する

(3)任意の視点におけるパーツの位置と重なり順を、複数の入力イラストの3D位置を対象とするブレンド計算を通じて推定する

(4)入力データに対するモーフィング処理によって、各パーツの形状を合成する

このように、複数の入力イラストを平面上に描画するだけで、2.5Dモデルを自動的に構築できる。ただしRiversらのアルゴリズムでは、三角測量という物理的に正しい計算法を用いてパーツの奥行き情報を定めるため、視点に応じたゆがみや位置関係の矛盾など、セルアニメ特有の変形を再現できない問題があった。このように、従来技術では比較的シンプルな変形ルールのみを用いるため、現実世界では生じ得ないような、セルアニメならではの表現には不向きであった。

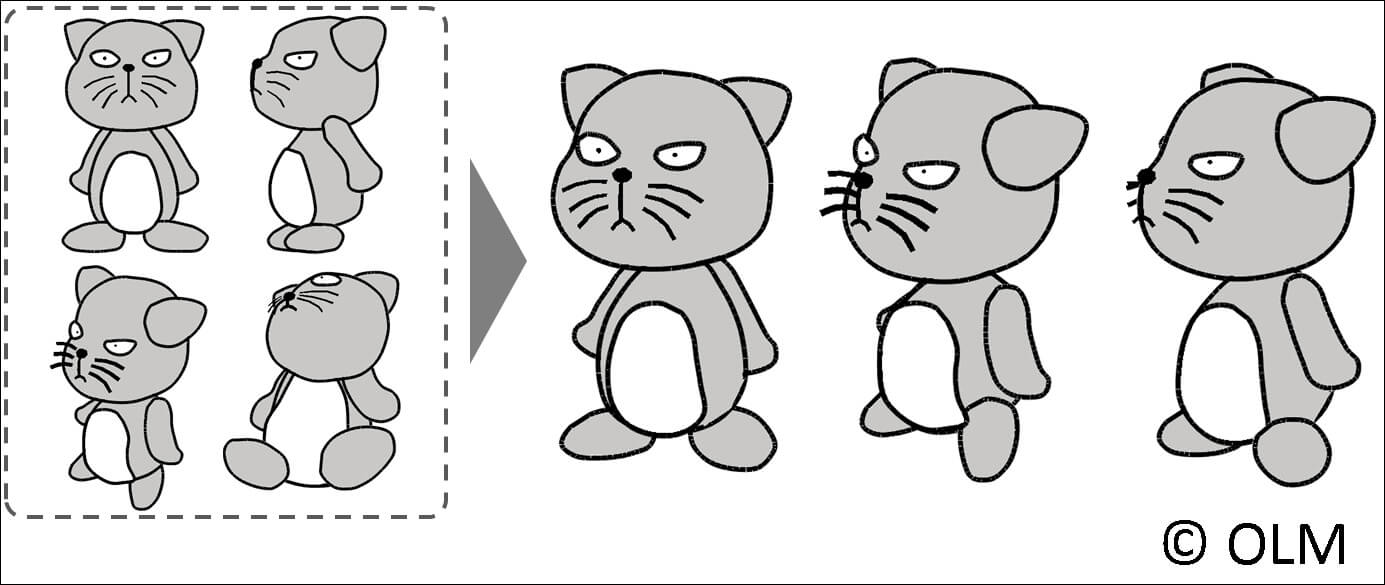

そこで福里氏らは、3Dキャラクタを用意せずにセルアニメ特有の「ゆがみ」を自由にコントロールするアプローチを採っている。提案技術では、まずRiversらの2.5Dモデルと同様に、事前にパーツ単位に分割された2.5Dレイヤーモデルを用意し、いくつかの視点に対応したイラストパーツ位置と形状を指定する。具体的には、各パーツに対して頂点単位の編集、パーツの平行移動、拡大縮小、回転などを施すことで、各視点に対応するパーツ形状を決定する。例えば図に示すネコの2.5Dモデルは、顔、耳、目、黒目、鼻と口、ひげ、胴体、お腹、腕、足といったパーツで構成されている。これらのパーツそれぞれについて、正面、左側面、左斜め上、左斜め下の四つの視点に対応する2D位置と形状を手動指定する。そして、セルアニメ特有のゆがみを考慮した新しい3D位置計算法によって2.5Dモデルを構築する。その結果、左側面の任意の視点からみたモデル形状を表現できるようになる。

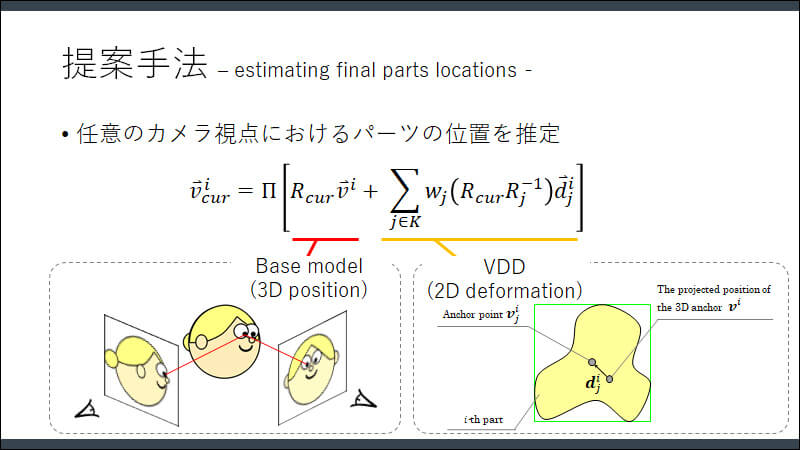

福里氏らが提案するアルゴリズムについて、さらに詳しく紹介する。まず、2次元イラスト各パーツの3D位置は、図に示す計算式を通じて推定される。式中でBase modelと赤線が引かれた部分は、各イラストパーツの2D位置は、基準姿勢におけるパーツ位置を回転させることで定めことを表している。ここまではRiversらの方法と同一であるが、提案法ではさらに、三角測量の計算で生じる誤差を、セルアニメに特有な視点依存ゆがみ(View-Dependent Deformation、VDD)として計算対象に含めている。この点が論文のキーアイデアであり、従来研究では単なる計算誤差として除外されていた値を、セルアニメ表現を実現するための重要な数値として捉え直している点がユニークである。たとえば動物の耳を顔側面から見ると現実世界では重なって見えるが、2次元イラスト特有の表現として、両耳をそれぞれ前後にずらすことで両耳とも見えるよう描くことがある。そうした視点依存のズレを明示的に計算式に組み込むことで、非現実的な表現を計算可能にしている。

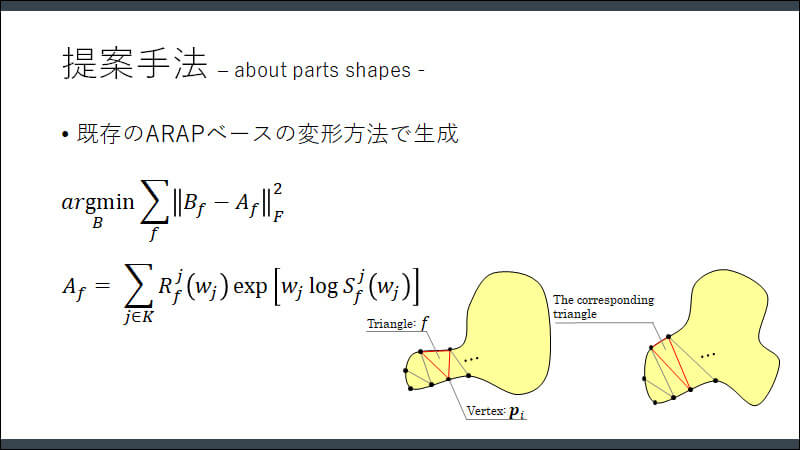

さらに福里氏らは、As-Rigid-As-Possible(ARAP)変形法を用いてパーツを変形する方法を導入している。これまでの技術では、イラストパーツごとに単純なモーフィングを施すが、そうした方法ではパーツの回転に対応できないという問題があった。例えば、正方形のパーツがあるとき、無回転の正方形と180度回転した正方形にモーフィングを施すと、ちょうど中間にあたる形状は直線状に潰れてしまう。一方、ARAP変形ではパーツの回転方向をなるべく揃えたうえで中間形状を計算するため、モーフィングに伴う形状破綻を生じることなく直観的に正しい結果を得られる。

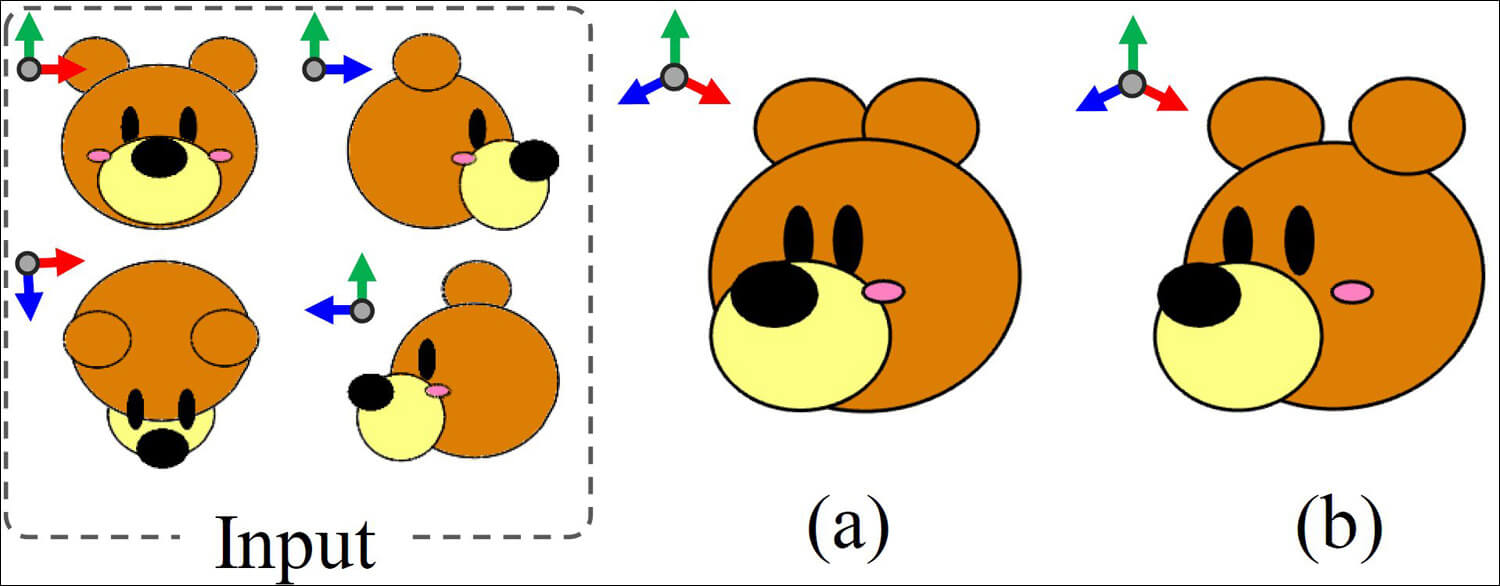

こうした提案技術の妥当性を、いくつかの実験を通じて評価している。まず、クマのイラストを用いてRiversらの先行技術と提案技術の差異が比較された。3D位置推定のみを行うRiversらによる先行技術(a)では、クマの両耳がともに顔面パーツの後ろのレイヤーとして推定されている。一方、提案技術では手前にあたる左耳が顔面パーツより前面に描画されており、直観的に正しい結果が得られている。

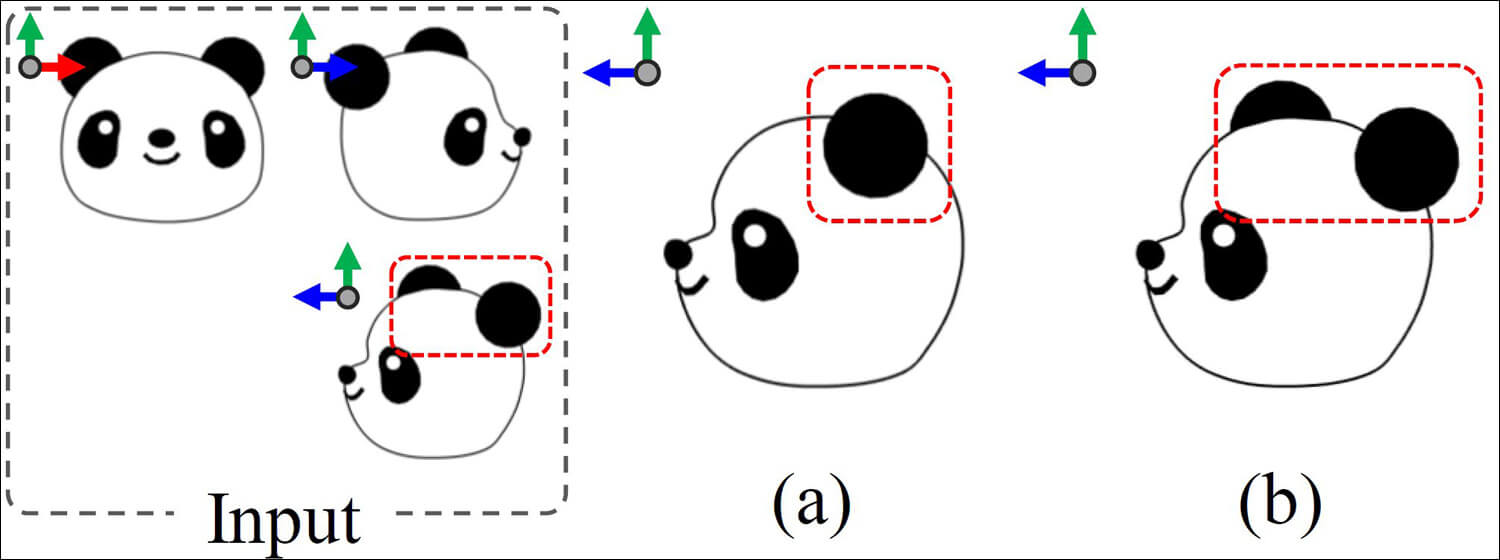

また、パンダのイラストで見ると、先行研究(a)では入力イラストの再現に失敗している。具体的には、顔の側面からそれぞれ捉えた入力イラストとして、耳を前後にズラした配置を与えているにもかかわらず、生成された2.5Dモデルでは両耳が重なった結果を生じている。これは、入力イラストは3Dの幾何学的構造としては矛盾するため、三角測量による位置推定では誤差として切り捨てられてしまうためである。一方、提案法ではそうした矛盾を重要な特徴として保存するため、入力イラストに似た直観的な結果が得られている。

こうした2.5D技術は、アニメーション制作にも応用できると述べられた。具体的には2.5D モデルを数フレーム分用意し、各要素(アンカー情報、ゆがみ情報、形状)を中割処理することで、時系列方向に対するキーフレームアニメーションを設計するデモンストレーションが示されていた。

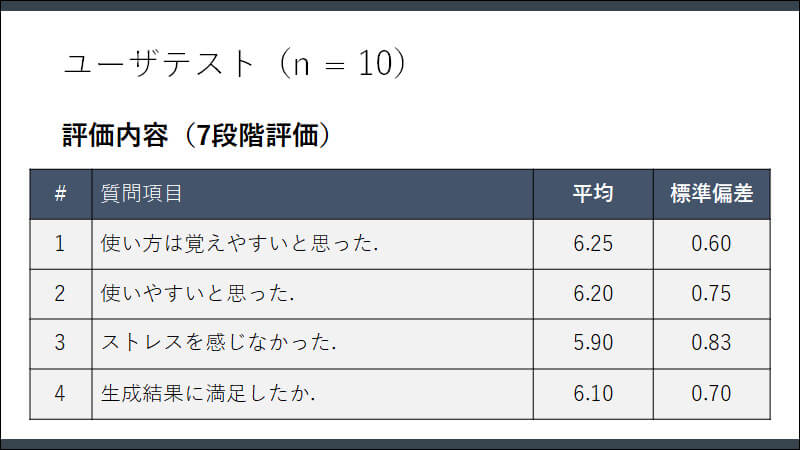

提案手法の有用性を検証するために、複数の試用者が参加したユーザテストも実施されている。実験では、まず各被験者に対してプロトタイプシステムの使用方法を覚えるためのチュートリアル(5~10分)を行った後、福里氏らが事前に用意した2D レイヤーモデルを用いて2.5D モデルを作成する実験を行った。その結果として、試用者からスライドに示す4つの項目に対する評価結果が得られた(最高スコアは7.0)。このように、提案システムに対して十分満足していることが確認されている。

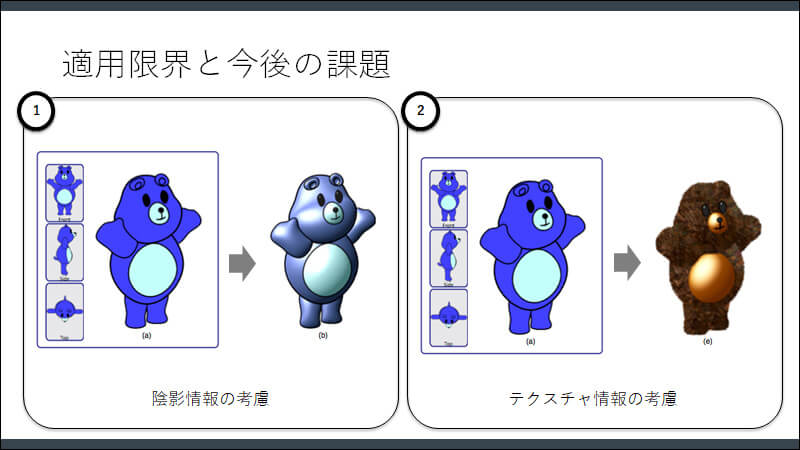

当日のデモンストレーション映像では、現時点でも十分に使いやすそうなシステムが示されていた。質疑応答の中では「スネ夫の髪型の2.5D表現も可能か?」という質問に対し、福里氏は「未実験ではあるが、技術的に可能である」と回答されていた。ただし現状では、視点に対するパーツの位置と形状を最適化するものにすぎないため、イラスト内のテクスチャ情報や陰影情報を扱うことはできない点が問題点として挙げられていた。今後は、システム上で陰影情報やテクスチャ情報を付与する機能を追加することで、より実用的な技術を目指すとのことである。

[[SplitPage]]動画生成のための3次元顔変形モデル

楊 興超氏(株式会社サイバーエージェントAI Lab)

www.cyberagent.co.jp/techinfo/labo/ai/

VCショート発表賞を受賞した論文「動画生成のための3次元顔変形モデル」は、サイバーエージェントAI Labの楊 興超氏と山口 光太氏、南カリフォルニア大学の齋藤 隼介氏による共同研究の成果である。楊氏らは広告クリエイティブ制作支援となる技術開発に取り組んでおり、この研究を通じて、ある特定人物が出演する映像を自在に合成できるような映像制作環境の実現を目指している。つまり、多様な収録パターンをそれぞれ個別に撮影することなく、特定人物の複数の表情パターンを一回撮影するだけで、あとは任意の表情や動きの事後的な合成を可能とするための技術を研究している。本受賞論文ではその1つの成果として、特定人物の顔の向きや表情を編集可能な3次元顔変形モデル(3D Morphable Model、以降3DMM)を構築したうえで、別の演者の表情変化に追従するような顔映像を合成する技術が発表された。

この研究背景として、広告のように大量の動画制作が求められる現場において、実在人物の映像撮影と編集に費やされるコストの大きさが挙げられた。一般的に撮影パターンの数や尺の長さが大きくなるほど、最終的な映像を選るまでに要する時間的、金銭的コストは増加する。特に著名人を起用した動画制作において、再撮影を要するほどの修正が生じた場合には深刻なコスト増加を招く。そこで揚氏らは、著名人などの特定人物が登場する映像制作を容易に行うための手段として、撮影されたデータを用いて任意の表情変化を事後合成できる技術の確立を目指している。特に、複数の被写体人物が示す様々な3D顔表情スキャンデータを用いて構築される、3DMMと呼ばれる統計的モデルについて研究している。この技術を応用することで、様々な見た目のデジタルアバターを対象として、任意の感情や発話内容に対応する3D顔形状を合成できることから、国内外で近年目覚ましく発展している。その中でも本論文では、日本人女性を対象として構築された3DMMを映像制作に応用した結果について報告している。

頭部や顔を扱う動画の制作や編集を目的とした手法は数多くの先行研究例がある。例えば、3DMMを用いた顔入れ替え(Face Replacement)と表情転写に基づいた顔再現(Face Reenactment)が代表例として挙げられる(文献「3D Morphable Face Models -- Past, Present and Future」)。3DMM研究のためのデータセットとして、これまでの研究では主に欧米系の人物を中心に多様な性別や年齢層のデータを集めたBasel Face Model(文献「Morphable Face Models - An Open Framework」)がよく利用されている。しかし、精確な3DMMを構築するためには、データセットに含まれる人種、性別、年齢の分布が、撮影対象人物に近いことが望ましい。極端な例を挙げれば、老齢の欧米人男性のみが含まれるデータを用いても、若年の日本人女性の顔表情を再現するのは極めて困難である。そこで楊氏らは日本国内における活用を念頭に、日本人女性に特化したデータセットの構築と、それらを用いた3DMMの構築に取り組んでいる。

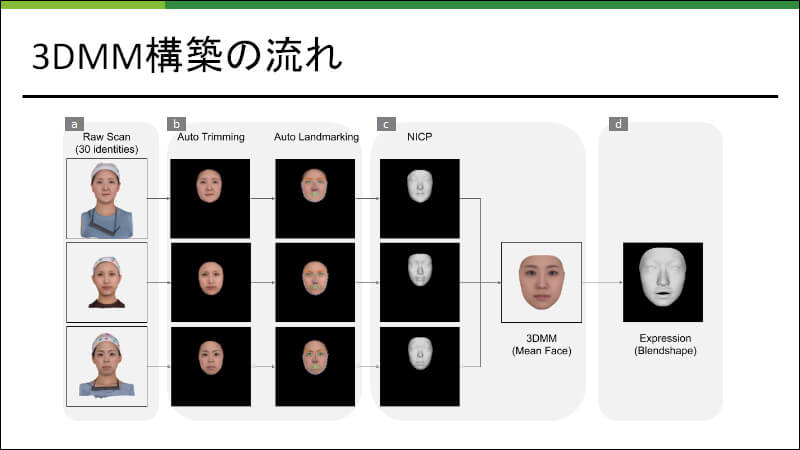

楊氏らが提案する 3DMM構築の処理手順は、図に示すとおり、顔表情の3Dスキャンデータ収録、顔以外の領域のトリミング、ランドマーク推定、顔の向きや大きさの正規化(レジストレーション)、3DMM の生成、そして平均顔からブレンドシェイプの追加という 6ステップで構成されている。

実験データとしては、20代から40代の日本人女性30人を対象に、無表情の頭部3D形状スキャンデータを収集している。マルチビュー3次元復元スキャンシステムを利用し、異なる視点から撮影された複数枚の頭部画像を用いて、各人物の3次元メッシュデータを構成する。このとき、図に示すように、被写体となる人物の身長や姿勢に応じてデータの位置や向きが異なり、またメッシュのトポロジーは不揃いになるため、以降に述べる正規化処理を施す。

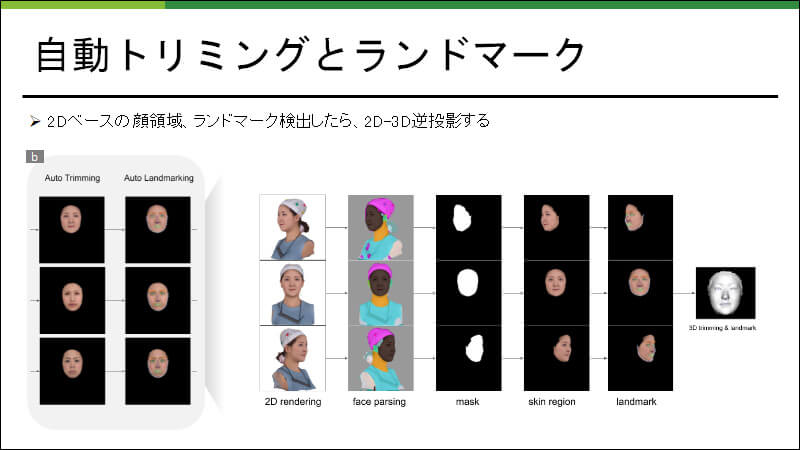

まず、スキャンデータから顔領域の自動抽出を行う。ここでは図に示すように、3次元空間上顔モデルの正面と側面に置かれたバーチャルカメラを用いて2次元画像をレンダリングする。次に、レンダリングされた顔画像に対して二次元領域分割(文献「Bisenet: Bilateral Segmentation Network for Real-Time Semantic Segmentation」)を施した後、顔以外の耳や髪、帽子などと判定された領域を3次元空間に逆投影し、対応するポリゴンを除去する。そして、穴埋め処理を施すことでスキャンデータの欠損部分を補う。

続いて、自動トリミングと類似した処理手順を通じて、スキャンデータ上の顔ランドマーク位置を推定する。図に示すように、まず仮想カメラからみたレンダリング画像上で 68個の顔ランドマーク位置を推定する(文献「How Far Are We from Solving the 2d & 3d Face Alignment Problem?(and a Dataset of 230,000 3d Facial Landmarks)」)。そして、それらを 3次元スキャンデータ上に逆投影することで3次元ランドマーク位置を推定する。

そして、複数のメッシュデータの位置合わせと形状合わせを行う。楊氏らは、手動でトリミングしたBasel Face Modelの平均顔をテンプレートメッシュとして利用する方法を採っている。まず、3次元ランドマーク位置を参照し、顔モデルをテンプレートメッシュの向きと位置に合わせる。次に、顔モデルの形状に合致するようにテンプレートメッシュを自動変形する。この処理を全てのスキャンデータに対して施すことで、トポロジーが共通な3次元メッシュデータが得られる。

最後に、全ての顔メッシュの頂点座標を対象として主成分分析を施し、3DMMの形状と色の変化パラメータを推定することで、3DMMを構築する。そして全ての顔メッシュの中間形状を平均顔として算出し、その平均顔をベースとすることで図に示すような130 パターンの表情ブレンドシェイプを作成する。これらには口、鼻に関する表情が90 パターン、目に関する表情が40パターン含まれる。なお、推定された3DMMパラメータは、動画の表情生成や表情転写のためにも利用される。

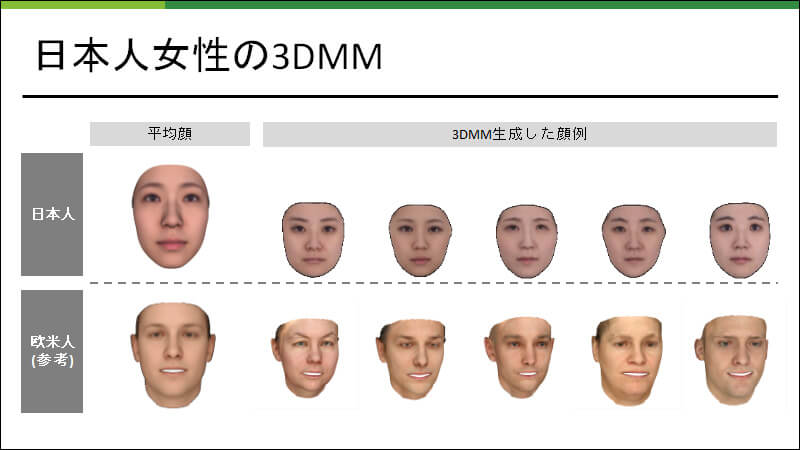

3DMMを用いて生成される顔の品質を評価するため、いくつかの実験結果が示された。まず、図に示すように、日本人女性3DMMを用いて生成される顔形状の例が示された。これらは3DMMパラメータを様々に変化させることで合成された表情であるが、いずれもデータセットに含まれる日本人女性の特徴が反映された自然な結果が得られている。

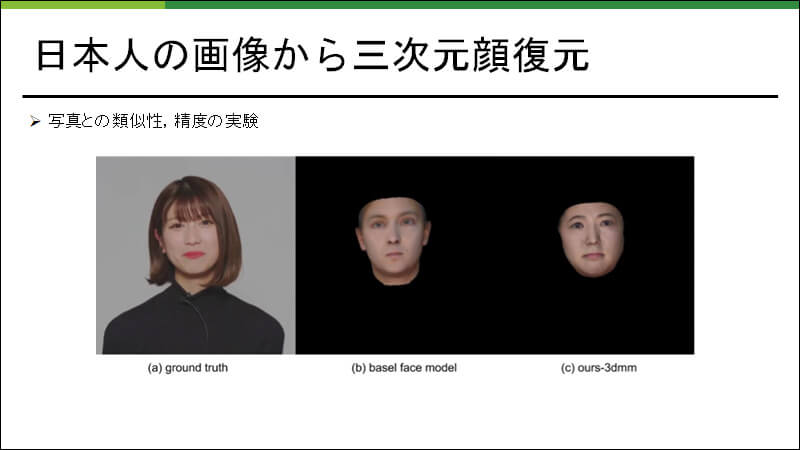

次に、日本人女性の無表情顔画像を入力として、その表情に最も類似した3次元顔形状を推定する実験結果が示された。200人の欧米系人物を被写体とするBasel Face Modelに対して、提案法のほうが良好な映像品質を与えることが確認されている。これは、Basel Face Model を構築した顔データベースは男性のモデルも含まれているため、日本人女性の写真に対して復元しようとしても、欧米人男性の特徴が現れてしまうためである。一方、日本人女性3DMMを用いて3次元復元する場合には、人種や年齢層が近い人物のデータを参照することになるため、高品質な結果が得られやすいことが示された。

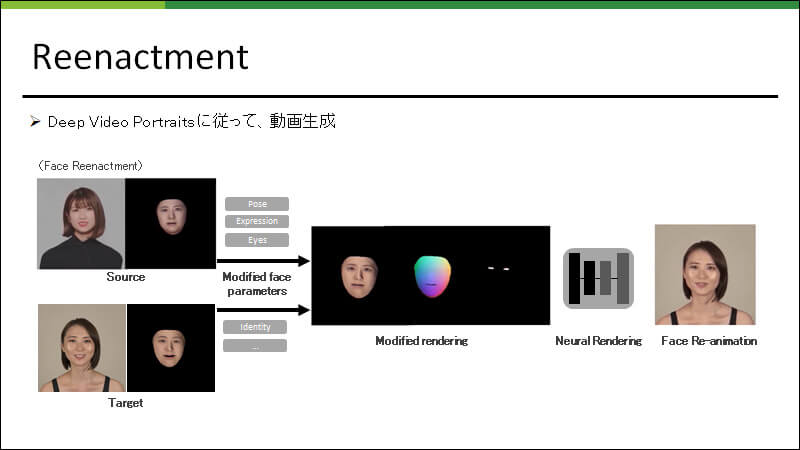

次に、表情転写の実験結果が示された。この実験では、3DMMに含まれる被写体人物の表情を、別の役者の表情変化によって操作している。まず、役者の2次元入力画像を近似するような3DMMパラメータを推定する。次に、顔形状の個人性および照明条件に対応する3DMMパラメータを、出演者の数値によって置き換える。その結果、出演者の見た目を保ちながら、役者の表情と頭部の運動が転写された3次元顔形状を合成している。さらに、役者の動画映像から検知される目線に応じて3DMMの目線を調整することで、あたかも役者の挙動や表情を出演者が模したような新しい映像が生成されていた。

楊氏らが提案する3DMMのもう1つの特長として、構築した3DMM の表情のパラメータがブレンドシェイプとして表されている点が挙げられる。つまり、3DMMパラメータを直接的、間接的に調整することでアニメーションを作成することもできる。さらに、自動生成した動画の表情にアーティストの編集を加えることで、効率良く品質な動画生成することも可能であろう。このように、さまざまな応用が期待される将来性の高い技術であるが、現時点では基礎研究の段階に留まっているため、今後はさらに容易に利用できるシステムの開発など、現場での環境整備を進める予定とのことである。

企業研究者による応用論文

ここまで紹介した2本の受賞論文以外にも、論文セッションでは多様な研究成果が発表されたが、本稿では特に、シンポジウム招待枠として発表された応用論文について簡潔に紹介したい。VC2020では、デジタル・フロンティアの後藤浩之氏らによる「Hair for Digital Human: 不気味の谷を越えるために」、奈良先端科学技術大学院大学の品川政太朗氏らによる「セマンティックセグメンテーションに基づくアニメ作品の自動彩色」、華為技術日本の岩本尚也氏らによる「3D LIVE MAKER: 好きなキャラクタに命を吹き込むまで」の3件の応用論文が、VC2020委員会からの招待として執筆・発表された。各社における製品開発における学術研究成果の応用をテーマとして、例えばインハウスツールや技術デモの開発において参照した研究例や、それらの実装結果と検証結果、実用化に向けて施された現場での工夫などがまとめられた論文である。現場での要求に即した学術研究成果を調査、選定する過程が、実際の採用に至らなかった研究例も含めて紹介されるとともに、実用にたる品質や性能を得るための拡張方法など、実践的な話題がまとめられていた。それらの中では、学術研究成果が現場での実用化に至らない一因として、製品開発で求められる品質水準の高さやワークフローとの兼ね合いがあることなどが示唆されていた。そうした制作者や開発者としては当たり前のことながら、大学などの研究機関に所属する研究者にとっては肌感覚としての理解が難しい内容も取り上げられていた点が特徴的であった。

VC2021に向けて

Visual Computingは今後も学術論文発表をメインセッションに据え、学術研究の場から広く情報発信する場として開催される予定である。本年のVC2021は、本稿の執筆時点では、9月下旬開催を念頭に計画されている。研究者や学生のみならず、映像制作に携わる多くの方、とくに技術者・開発者にとっても有意義なイベントになるよう、各種企画やスケジュール策定について検討されている。ぜひ、プロやアマ、デザイナーや技術者などの区分を問わず、コンピュータグラフィックスに関心がある多くの方に参加いただき、その生の声を研究者や学生に遠慮なく投げかけていただきたい。そうした契機を通じた交流の促進、より一層スムーズな産学連携のために、Visual Computingをはじめとする学会の場も活用していただければ幸いである。