筑波大学の近藤生也氏、浅野悠人氏、落合陽一氏は10月22日(水)、2025年日本国際博覧会(大阪・関西万博)のシグネチャーパビリオン「null²(ヌルヌル)」で使用された3Dリアルアバター技術「Instant Skinned Gaussian Avatars」を、オープンソース(MITライセンス)で公開した。デモサイトも用意されている。

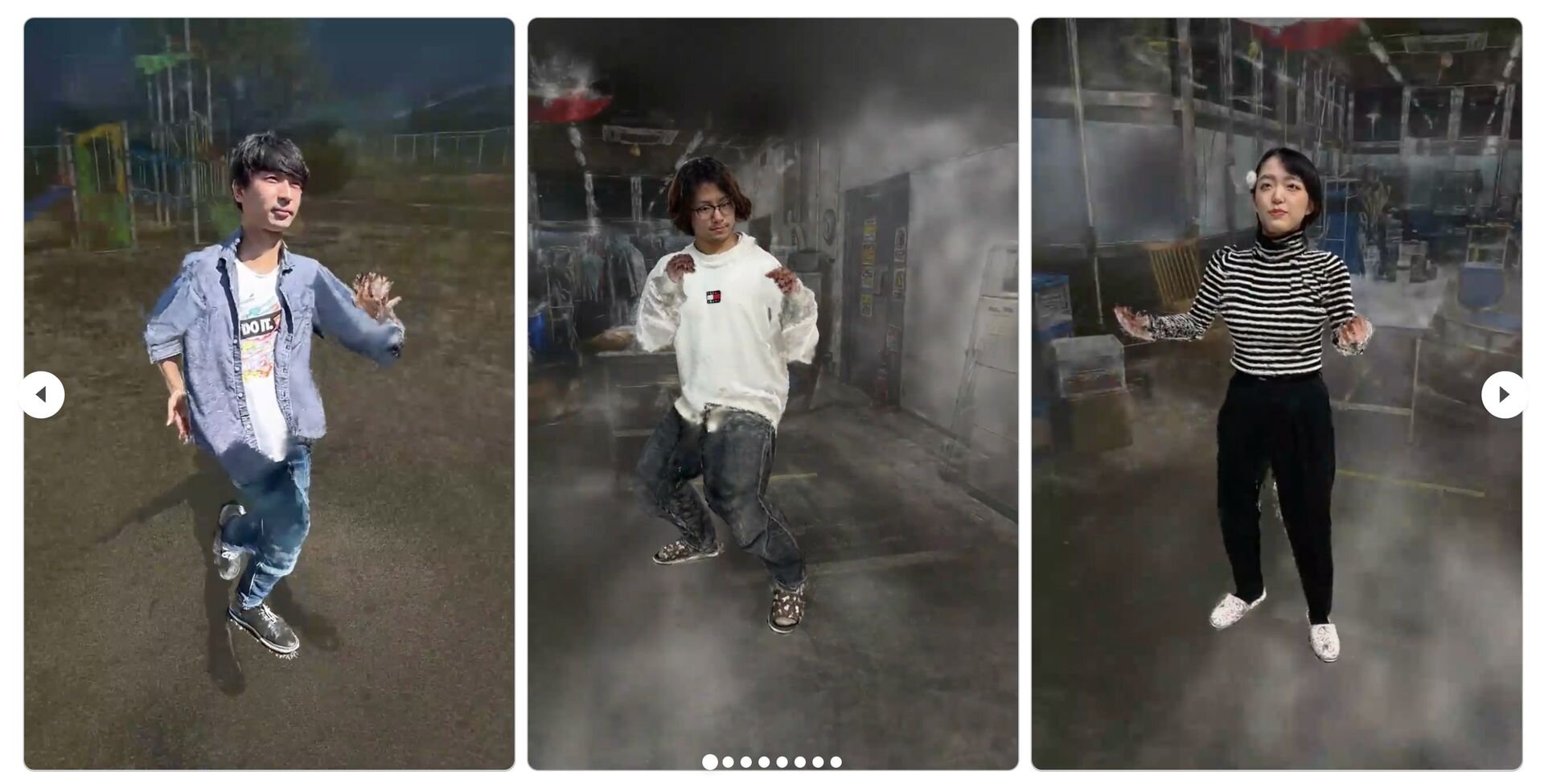

万博落合館 #null2 で使っていた3Dリアルアバターの技術『Instant Skinned Gaussian Avatars』を、デモ・コード合わせて公開します! スマホアプリ scaniverse で撮ったスキャンを入力にして、30秒で動く3Dアバターを生成します。デモはブラウザで (スマホでも) 遊べます!https://t.co/pIEqBbTrKY pic.twitter.com/uaooS1wK0f

— Naruya Kondo (@namahoge) October 22, 2025

「Instant Skinned Gaussian Avatars」は、スマートフォンの3Dスキャン(Scaniverseなどから取得したPLYデータ)から、わずか数分(アバター生成自体は約30秒)で高品質な3Dアバターを生成し、WebブラウザやVRデバイス上でリアルタイムに動作させることを可能にする技術。高精細な3D Gaussian Splatting(3DGS)データを用いてリアルタイムで変形(スキニング)させることにより、3DGSならではの高いビジュアル忠実性(フィデリティ)を保ったアバターアニメーションを実現する。

アバターの骨格部分には標準的なVRMメッシュを使用し、メッシュの頂点の動きに追従するよう、膨大な数の3DGSの位置をリアルタイムで並列に計算する。この処理はシェーダ言語のGLSLレベルで最適化されており、WebGLを用いたブラウザ上でも高いパフォーマンスを得られる。

GitHubで公開されているプロジェクト「Gaussian-VRM」は、本技術のthree.js(Web向け3Dライブラリ)実装。深層学習モデルやライセンスに制約のあるメッシュオプティマイザなどは使用していないことから、商用・非商用を問わず利用できる。

■Instant Skinned Gaussian Avatars for Web, Mobile and VR Applications(プロジェクトページ、英語)

https://gaussian-vrm.github.io/

■Instant Skinned Gaussian Avatars(GitHub)

https://github.com/naruya/gaussian-vrm

■Instant Skinned Gaussian Avatarsデモサイト

https://naruya.github.io/gaussian-vrm/

null²(ヌルヌル)とは

「null²」は、落合陽一氏が「いのちを磨く」をテーマにプロデュースする、大阪・関西万博のシグネチャーパビリオンのひとつ。パビリオンの名称は、プログラミングで何もないことを示す「null」と、仏教における実体がないことを示す「空(くう)」の概念を掛け合わせたものに由来する。パビリオンは、落合氏が提唱する、人間・自然・テクノロジー・データがシームレスに接続され、境界が溶け合った新しいビジョン「デジタルネイチャー(計算機自然)」を具現化する場として設計されている。

内部は「ミラーシアター」と呼ばれる鏡張りの空間となっており、来場者は自らの姿がスキャンされ、リアルタイムで生成されるデジタルアバター「Mirrored Body」と対峙する。今回オープンソースで公開された「Instant Skinned Gaussian Avatars」は、この未知の体験を実現するための基幹技術として採用されたもの。

万博終了後は、本パビリオンを別の場所に移設・再構築するためのクラウドファンディングが実施され、第一目標の1億円、第2目標の2億円をすでに突破。現在は第3目標の3億円を目指して資金を募っている。

なんと皆様の応援のおかげで200%達成! 感涙です! 皆様本当にありがとうございます!

— 落合陽一 Yoichi OCHIAI (@ochyai) October 22, 2025

ぬるぬるのお引越|万博・落合陽一 null²パビリオン次なる場所へ #クラウドファンディング #READYFOR #ぬるぬるのお引越 #null2 https://t.co/zf2Iwkg3O2 @READYFOR_cfより

■大阪・関西万博シグネチャーパビリオン「null²」公式サイト

https://expo2025.digitalnatureandarts.or.jp/

■ぬるぬるのお引越|万博・落合陽一 null²パビリオン次なる場所へ(クラウドファンディングREADYFOR)

https://readyfor.jp/projects/null2_2025

CGWORLD関連情報

●オープンソースの大規模3D都市モデル生成技術「Skyfall-GS」発表! 衛星写真とAIのみで建物の側面や地上レベルのディテールを補完し、リアルタイムで3Dモデルを生成

国立陽明交通大学(台湾)、イリノイ大学アーバナ・シャンペーン校(UIUC)、サラゴサ大学、カリフォルニア大学マーセド校(UC Merced)からなる研究チームが、オープンソース(Apache-2.0ライセンス)の大規模3D都市モデル生成技術「Skyfall-GS: Synthesizing Immersive 3D Urban Scenes from Satellite Imagery」を発表。GitHubではコードが公開されているほか、データセットや3DGSのPLYファイルも公開されている。

https://cgworld.jp/flashnews/01-202510-Skyfall-GS.html

●Blenderで3DGSがレンダリングできるオープンソースのアドオン「3DGS Render Blender Addon by KIRI Engine」v4.0リリース! ビューポートのリアルタイムレンダリングを活用しながら編集が可能に

KIRI InnovationがBlender内で3D Gaussian Splatting(3DGS)データを扱える無料アドオン「3DGS Render 4.0」をSuperhiveとGitHub(オープンソース:Apache-2.0ライセンス)でリリース。EditモードとRenderモードからなる新しいワークフローが導入され、リアルタイムレンダリングを活用しながら3DGSデータの編集が可能になった。

https://cgworld.jp/flashnews/01-202510-3DGS-Blender-KIRI-v4.html

●NVIDIAが3DGS技術「LongSplat」発表! スマホで撮影したカジュアルな動画から空間の3DGSモデルを生成し、自由な視点の映像をつくり出す

国立陽明交通大学とNVIDIAの研究チームが、スマートフォンなどで気軽に撮影した長尺かつ複雑な動きを含む動画から3D Gaussian Splattingモデルを生成し、新しい視点の画像を生成するフレームワーク「LongSplat」を発表。GitHubではNVIDIAライセンスでコードが公開されている。

https://cgworld.jp/flashnews/01-202509-LongSplat.html