本連載では、アカデミックの世界に属してCG・映像関連の研究に携わる人々の姿をインダストリーの世界に属する人々に紹介していく。第11回では「デザイナーとエンジニアの共存には、両方の言葉を理解できる人が必要」という考えの下、デザインと情報技術の両方のスキルをもつ人材の育成を目指す和歌山大学の床井浩平准教授に自身の研究室について語っていただいた。

※本記事は月刊『CGWORLD + digital video』vol. 251(2019年7月号)掲載の「ACADEMIC meets INDUSTRY 和歌山大学 システム工学部 システム工学科 視覚メディア研究室」を再編集したものです。

TEXT_床井浩平 / Kohe Tokoi(和歌山大学)

EDIT_尾形美幸 / Miyuki Ogata(CGWORLD)

取材協力_芸術科学会

デザイナーとエンジニアが共存する、東洋現像所での実務訓練

和歌山大学の床井浩平です。お世話になっております。本誌では、以前シェーダに関する記事を書かせていただきました。その節はありがとうございました。私は工業高専の電気科を卒業後、豊橋技術科学大学の3年次に編入し、大学院修士課程を経て、1986年に和歌山大学の経済学部の産業工学科に就職しました。その後、1995年に設置されたシステム工学部に移り、現在そこの准教授をしています。

-

-

床井浩平

和歌山大学 システム工学部 システム工学科 准教授

博士(工学)

専門分野:インタラクティブCG

www.wakayama-u.ac.jp/~tokoi/

さて私とCGの関わりですが、さかのぼれば高専の電算室で学生に開放されていた16bitミニコンを使って、タイプライターで紙に活字を重ね打ちして濃淡をつけることで絵を描いたのが最初のように思います。でも、そのときはそれをCGだとは認識していませんでした。その後、編入した大学では画像処理や自然言語処理、人工知能などを研究している研究室に入りました。そこにグラフィカというメーカーのグラフィックディスプレイがあったので、私はこれを使ってスキャンライン法によるレンダリングの研究をしました。

私とCGの関わりを決定づけたのは、大学の実務訓練、いわゆる企業内インターンシップでした。豊橋技術科学大学は1学期・2学期・3学期の3期制で、実務訓練は学部4年次3学期の必修科目でした。この実務訓練で、私は東洋現像所(現・IMAGICA Lab.)の品川ビデオセンター(現・品川プロダクションセンター)に、もうひとりの同級生と一緒にお世話になりました。

東洋現像所は主に映画やTV番組、TVコマーシャルの編集などのポストプロダクションを行うスタジオでしたが、当時は大阪大学の大村皓一先生を中心とするCGグループが開発したLINKS-1というCGシステムの開発の継続と、それを用いたCG制作を行うトーヨーリンクスを設立していました。しかし私がお世話になったのは、品川ビデオセンター内にあった、小高金次氏率いるCG部門でした。そこは当初に導入したシステムの名前から「アクメシステム」と呼ばれており、VAX11/780上でMOVIE.BYUというソフトウェアを使って、スキャンライン法による映像制作を行なっていました。

▲1984年のインターンシップ時にVAX11/780でレンダリングした画像

東洋現像所では、出勤したら迷彩服を着た人たちに会社が占拠されていた(ロケが延びていた)など、多くの貴重な体験をさせていただきました。中でも、そこで「本物のCGプログラマー」にご指導いただけたことが、私にとって一番大きな収穫だったと思います。そしてもうひとつ、私のその後の考え方に強く影響を与えたのは、そこがデザイナーとエンジニアが共存する場所だったことです。これら2職種の人たちは、どちらも自分の主張や立場を譲らず、議論がエキサイトしてしまうときもありました。これが私には、互いの「言葉」や「見えている世界」が異なるので、同じものであってもちがう方向から解釈してしまうために起きているように思えました。それでも、そういう議論を経て、作品は納期までに確実に納められていきました。このときの経験から、私はこういう現場では両方の言葉を理解できる人が必要なのではないかと考えるようになりました。

SIGGRAPH '84に参加し、当時のPixarやPDIなども見学

その後、私はそのまま大学院に進学しました。修士論文では、当時JCGLのデザイナーであり中学校の同級生でもあった山本晋士氏が「CSGでのモデリングは楽しいけど、形状確認に時間がかかるのが難点」と言っていたことから、「ならばそれをインタラクティブにできるようにしよう」と考え、学部の卒業研究をベースに2次曲面の集合演算形状をスキャンライン法でインタラクティブにレンダリングする手法を研究しました。これは後に私の博士論文のテーマの基にもなりました。

東洋現像所では、実務訓練終了後も長期休暇中はアルバイトとして面倒を見ていただいたのに加え、SIGGRAPH'84にも連れて行ってもらいました。その折には当時Lucasfilm内にあったPixar Animation Studiosや、後にDreamWorks SKGに買収されたPacific Data Images(PDI)、『Tron』(1982)の制作に関わったDigital EffectsやMathematical Applications Group(MAGI)、オハイオ州立大学のキャンパス内にあったCranston/Csuri Productions(CCP)なども見学しました。

▲SIGGRAPH'84のエキシビジョン会場

▲併せて見学したPixar Animation Studiosの社屋。当時はLucasfilm内にありました

その経験から、「アメリカでは、大学の先生がCGプロダクションの運営もしてるんだ......」と、漠然と思っていました。 前述した日本のLINKS-1というCGシステムも、大学発ながら実際にCGプロダクションで活用されていました。だから私は、CGは大学と産業が同じところに立って活動する領域なのだと考えていました。

デザイナーとエンジニアの共存を目指し、システム工学部へ

前述の考えがあり、また東洋現像所からお招きいただいていたこともあって、私は同社に就職する気でいたのですが、個人的な事情から直前になって辞退してしまいました。ごめんなさい。これに関しては、今も当時の関係者の皆様に本当に申し訳なく思っております。本当にごめんなさい。それで翌年の1986年2月、卒業の間際になって、和歌山大学の経済学部に就職が決まりました。そのため、私とCGの制作現場との関わりは、そこでいったん切れてしまいました。

ところがその後、和歌山大学に理工系学部を設置することが決まりました。ただ、当初計画されていた学科構成が地域産業の特色を反映したものということもあり、すでに経済学部になじんでいた私は、そのまま経済学部にいるつもりでいました。けれども文部省との交渉から帰ってきたスタッフから「デザインと情報を組み合わせた学科を提案された」という報告があり、新しい学部に「デザイン情報学科」ができることになりました。まさに「デザイナーとエンジニアの共存を目指す場所」がすぐ近くにできることになったのです。私はそれを横目で眺めてはいられないだろうと思い、1995年に設置された「システム工学部」に移りました(デザイン情報学科の学生受け入れは1997年から)。

次ページ:

就活生に立ちはだかった大学とCG制作現場の高い壁

就活生に立ちはだかった大学とCG制作現場の高い壁

前述のシステム工学部が目指したのは「複数領域の分野を横断する知識を身に付け、システム的思考をもった人材の育成」であり、デザイン情報学科は「デザインと情報技術の両方のスキルをもつ」ことを目標にしていました。しかし、当時はほとんどの場合デザイナーとエンジニアの採用は独立していて、両方のスキルをもった人材の必要性は、仮に現場で認識されていたとしても、少なくとも採用の現場では考慮されませんでした。

それともうひとつ、大学の、特に理工系の学部や大学院からCG制作関連の会社に就職しようとしても、そもそもパスが見つからないという問題がありました。これはコンテンツ産業の中心から離れた地方の大学が抱える課題なのかもしれません。しかし私には、私が就職した後、デザイン情報学科の最初の卒業生が就職する2001年までの間に、大学とCG制作現場に高い壁ができてしまったように思えました。

実際、卒業生はシステムエンジニアやメーカーのデザイナーなどでの引き合いはあったものの、コンテンツ制作の領域へはほとんど送り出すことができませんでした。それでも何人かの就活生は自分でパスを探して果敢に挑戦したのですが、「デザインと技術開発の両方ができます」と言ったら「うちは開発はやってないからねぇ」とお祈りされ、次のところでは戦略を変えてデザイナー志望で行ったら「技術の人じゃないの?」とまたお祈りされた、ということも起こりました。

それでも、その後はゲーム関係を中心に、コンテンツ産業への就職は増えていきました。「テクニカルアーティスト」というキーワードを聞いたときは、「それは私たちが目指してきたものそのものじゃん」とも思いました。一方で、まだCG制作、映像制作の現場への壁は高く、わずかの人がほかの就活生とはまったく異なるスタイルで活動し、ものすごい苦労を経て、ようやくたどり着くような状況でした。私自身、2014年に大阪で開催されたボーンデジタル主催のセミナーに参加したとき、名刺交換の折に「どうして大学の先生が来てるんですか」と真顔で言われて面くらいました。だから今回この連載のお話を伺ったとき、ようやく、本当にようやく、そういうところに目が向けられるようになったと、まるで片思いが実ったかのような気持ちになりました。

基礎と演習を組み合わせ「デザインエンジニア」の育成を目指す

システム工学部は創立20周年を迎えた2015年に学科をシステム工学科1学科に統合し、それまでの5学科は「メジャー」と呼ばれる10の教育研究グループに再編されました。学生は1年次にメジャー紹介講義やメジャー体験演習を履修し、2年次に進級する際に、この中から2つのメジャー(第1メジャー、第2メジャー)を選択します。卒業研究は第1メジャーに所属する教員の指導を受けることになります。この組み合わせは任意なので、学生は自分が何をどのような構成で学ぶかを自分で設計することになります。ただし、現時点では標準的な9種類の組み合わせを「コース」として提案しています。

私がいたデザイン情報学科は「メディアデザインメジャー」と「社会情報学メジャー」に分かれ、私は現在メディアデザインメジャーに所属しています。

▲メディアデザインメジャーの教員構成。メディアデザインメジャーのスタッフはデザイン・視覚・聴覚からなる3分野の教員で構成されており、メッセージを伝達する媒体としてプロダクトをデザインする立場、それを空間に配置して評価する立場、そのユーザーインターフェイスやユーザービリティなどプロダクトと人との関わりを追求する立場、その幾何学的な構造や視覚的な表現を構成する立場、音声によるメッセージの伝達や聴覚による認識を研究する立場から、互いに連携して教育研究に取り組んでいます

メディアデザインメジャーではデザイン情報学科が目指していたものを一段深めて、デザインをメッセージの伝達を行うメディアとして捉え、デザイン・視覚・聴覚を取り扱う情報技術のスキルをもつ「デザインエンジニア」を育成することを目標に置いています。そのために、カリキュラム上でも理数系やプログラミング、デザインなどの基礎的な科目に加え、学生自身が企画から始めて何らかの制作物を完成させるまでの一連のプロセスをたどる制作系の演習を複数用意しています。また、これらの演習科目では学生同士が役割を分担して工程計画を策定するグループワークや、地元の企業との協業により地域に根差した課題に取り組むプロジェクトベースト・ラーニングの実践も行なっています。

-

- ◀▲デザイン情報総合演習の学生作品。【上左】GPSを用いた位置ベース鬼ごっこの『追儺』/【上右】砂漠緑化がテーマの農場系シリアスゲーム『MISSION OF GREEN』/【下】プレイフルパレットで色のつくり方を学ぶ『くりおねいろ』。いずれも最終プレゼン資料の表紙

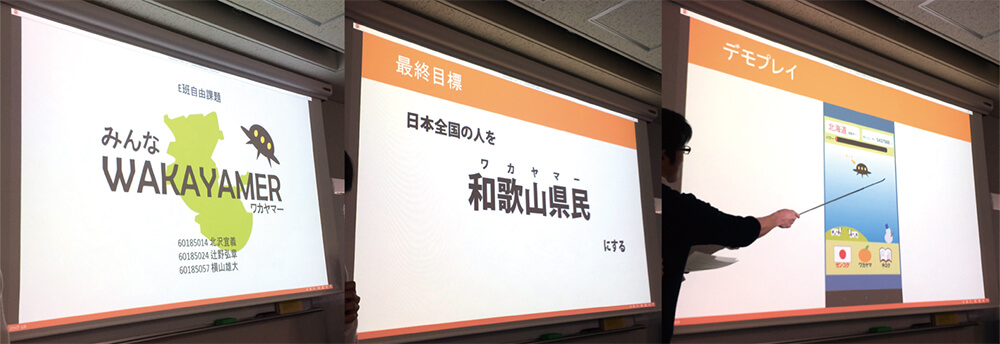

▲デザイン情報総合演習の前身である、メディアデザイン演習の最終プレゼンの様子。本演習の評価では、作品の内容や技術レベルに加え、最終プレゼンでどのくらい教員やほかの学生にアピールできたかという点も重視されます

[[SplitPage]]RESEARCH 1:全周ダイナミックプロジェクションマッピング

・私の研究の立ち位置

少しは私たちの研究についても書こうと思います。前述の通り、私自身の研究は友人のデザイナーのひと言から始まっており、東洋現像所での実務訓練での経験もあって、私の研究の立ち位置は「デザイナーの想像力を掻き立てるようなツールをつくりたい。エンジニア側からデザイナーに提案できるような表現をつくりたい」というところにあります。そのために最も重視していることは、デザイナーの試行錯誤を妨げないインタラクティブ性を維持することです。私の研究のきっかけがレイトレーシングではなくスキャンライン法だったのも、それが理由です。現在は、主にOpenGLを用いてグラフィックスハードウェアの機能や性能を活用するところに重点を置いています。

・「支援ツールの評価」の難しさ

一方で、学生の研究テーマは学生自身に決めてもらっているので、結構とりとめのないことになっています。それでも学生が私の考えを推察してくれるのか、「~の支援ツール」みたいなテーマが毎年提案されてきます。

ただ、そういうテーマはいつも「評価はどうするのか」という指摘を受けます。それは実際にデザイナーに使ってもらって評価してもらうしかありません。私たちの研究は、本当は産業との連携なしには成立しないのです。しかし、現実にはなかなかそういう機会がありません。内定が決まった学生に「内定先に頼んでみたら」と言ってみたこともあったのですが、「内定の段階でそんなこと頼めない」とスルーされました。

そういうこともあって、デザイナーの利用を想定した研究は、実は私自身ではあまり成果を得られていません。その代わり、グラフィックスハードウェアを活用することによって得られる高速性の研究では一定の成果を出せてきたように思います。この技術は、図形や画像の表示と処理に加え、後述するVRシステムや、ゲームなどのインタラクティブなコンテンツへの応用に対しても有効です。

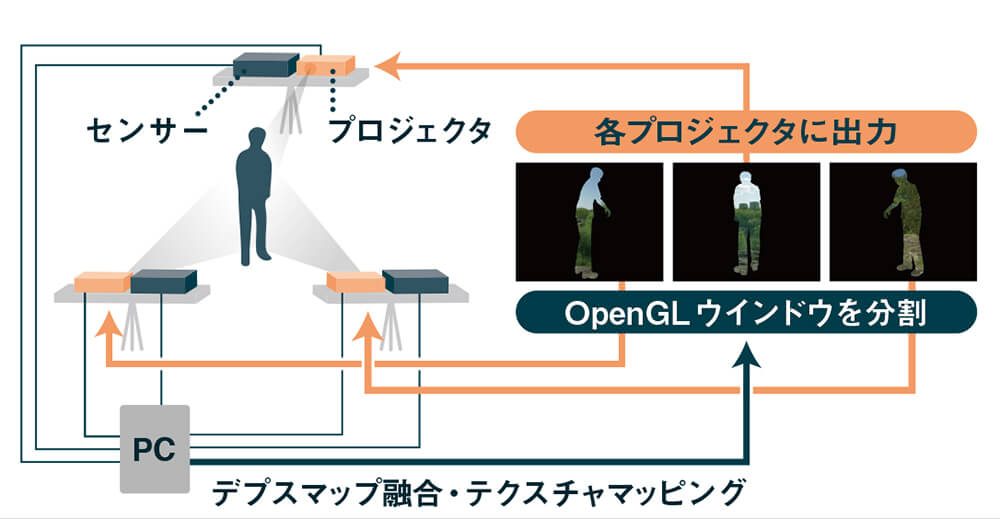

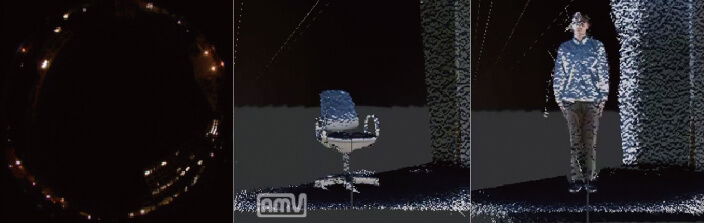

・姿勢が変化する人体への全周プロジェクションマッピング

2014年の修士研究では、人体のような変形する物体の周囲にカラー画像と一緒に深度画像(距離画像)も取得できるRGB-Dカメラを複数配置し、それらから得た深度画像をグラフィックスハードウェア(GPU)上で合成し、被写体の全周形状をダイナミックに再構成することを試みました。さらに、再構成された形状にテクスチャマッピング(リフレクションマッピング)を施した映像をプロジェクタで被写体に再投影しました。これにより被写体の姿勢の変化に応じて見かけが変化するダイナミックな全周プロジェクションマッピングを実現しました[1]。

しかし、本研究で用いたプロジェクタは一般的なものであり、RGB-Dカメラの遅延も大きいために、被写体は速く動くことができませんでした。なお、本研究の発表後に、超高速プロジェクタを用いた高品質な手法が開発されています[2]。

▲被写体の姿勢変化に追従する全周ダイナミックプロジェクションマッピングの構成。3台のRGB-Dカメラと3台のプロジェクタを用いています

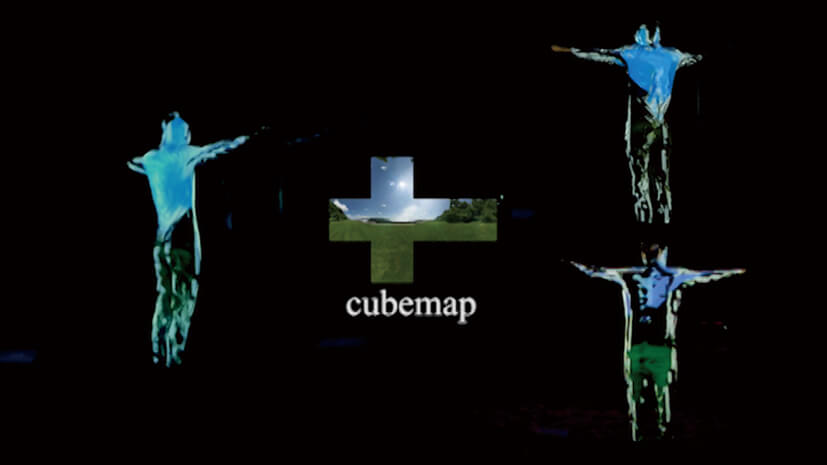

▲全周ダイナミックプロジェクションマッピングを適用した被写体を、別のカメラで3方向から撮影したもの。再構成された被写体の形状に中央のキューブマップを用いたリフレクションマッピングを施したものを被写体に再投影しています

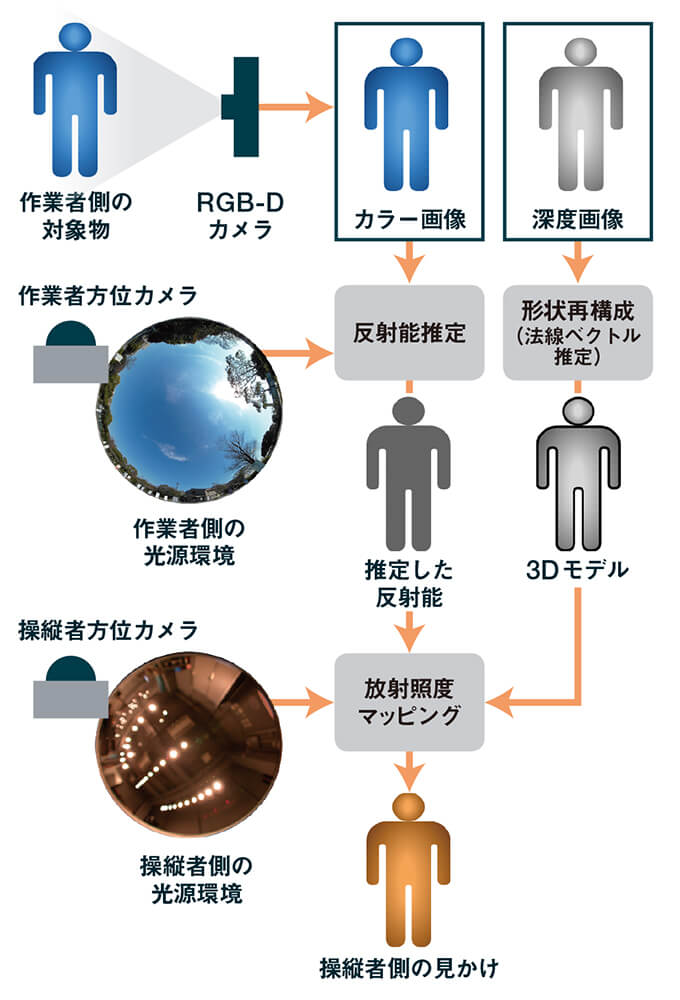

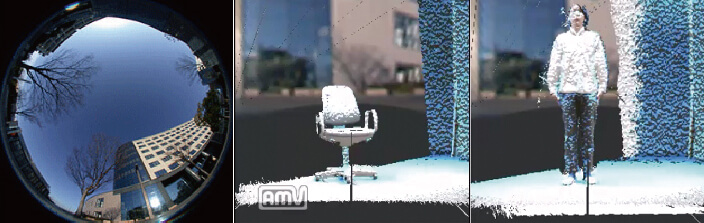

・別の光源環境に置き換えるリライティング処理

そこで2017年の修士研究では先の手法を応用して、RGB-Dカメラの深度画像から再構成された被写体の形状の法線情報と、全方位カメラにより取得した被写体の光源環境を基に、RGB-Dカメラのカラー画像から反射能(アルベド)を推定して光源環境の影響を削除し、別の全方位カメラにより取得した光源環境に置き換えるリライティング処理も試してみました[3]。

反射能の推定は、まずRGB-Dカメラのカラー画像上の1点における法線を推定し、その方向を中心に光源環境をサンプリングして、その点における放射照度を求めます。これにスクリーン空間アンビエントオクルージョンの手法により、表面の凹凸による遮蔽度を反映します。この放射照度とカラー画像との関係から、その点の反射能を推定します。

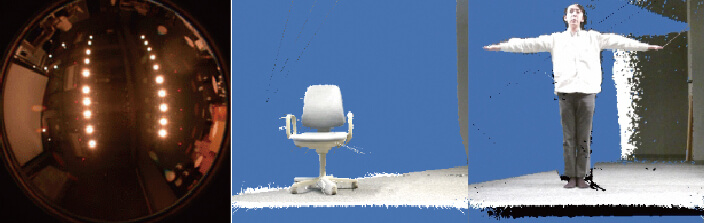

下図にて、被写体を屋内の光源環境(ダウンライト)で撮影し、その光源環境を夜間の屋外と昼間の屋外へと置き換えた結果を示しています。夜間の屋外へ置き換えたときに下から光が当たっているように見えるのは、光源環境の取得に単一の魚眼レンズを用いており、地面側からの光の放射を定数にしていたためです。

▲RGB-Dカメラと全方位カメラを用いた、光源環境の置き換え処理の手順

▲【左】元の光源環境/【中】被写体(椅子)/【右】被写体(人体)

▲【左】夜間の屋外の光源環境/【中】【右】元の光源環境から、夜間の屋外へと置き換えた結果

▲【左】昼間の屋外の光源環境/【中】【右】元の光源環境から、昼間の屋外へと置き換えた結果

・参考文献

[1]森正樹, 床井浩平: "運動する人体の全周に対するリアルタイムプロジェクションマッピング" インタラクション2015

[2]Narita Gaku, Yoshihiro Watanabe, Masatoshi Ishikawa: "Dynamic projection mapping onto deforming non-rigid surface using deformable dot cluster marker" IEEE transactions on visualization and computer graphics 23.3, pp. 1235-1248, 2017

[3]早川玲央, 床井浩平: "光源環境を反映したリアルタイム映像合成" NICOGRAPH 2017, 芸術科学会, 2017

RESEARCH 2:ロボットの視界再現などのVRシステムへの応用

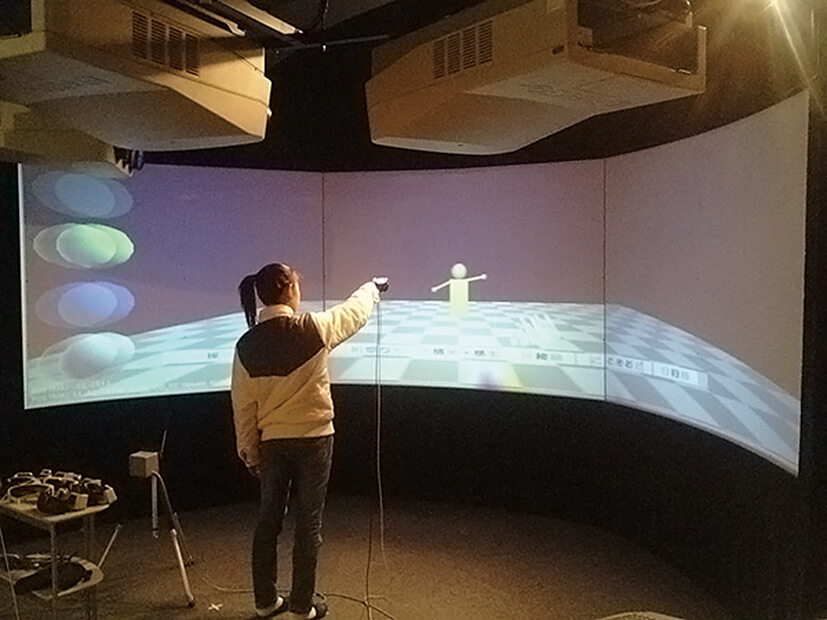

・臨場感通信の研究

VRシステムは人間の行動に対してリアルタイムに反応を返す必要があり、グラフィックスハードウェアの支援なしに実現することは困難です。本研究では、最初にSilicon Graphics社のOnyx / Reality Engine 2に6台のBarco製プロジェクタを接続し、それぞれ3面の100インチスクリーンに時分割多重で立体映像を投影するシステムを導入しました。この3面のスクリーンは台形に折り曲げて配置し、利用者がその中心に立てば視野の140度が覆われる没入型のディスプレイになっています。

2001年の卒業研究では、これを用いて現実には目の前にいない人に殴られた感じを再現する研究などを行いました。また2003年の卒業研究では、手の平に取り付けたセンサーグローブ(SuperGlove-C)と位置センサー(Fastrak)を用いて、空間中に文字や図形を描いて相手に投げつけるチャットシステムの研究を行いました。

▲2組みの没入型ディスプレイを用いて、双方が痛くない殴り合いをする実験。目の前にいない相手に殴られた気がする表現の追及を行いました

▲同じく没入型ディスプレイを用いた実験。利用者は手の平にセンサーグローブと位置センサーを取り付け、ハンドジェスチャにより空間中に文字や図形を描いて相手に投げつけるチャットシステムを体験しています

・ロボットの視界再現の研究

現在は低価格になったヘッドマウンテッドディスプレイ(HMD)を用いて、遠隔地のロボットの視界を再現するシステムの開発を行なっています。遠隔地で地質などの各種調査を行おうとする場合、人間が現地におもむけば詳細な調査を実施できます。しかし月面のような場所では、そもそもそこに行くことが困難であるか、行っても現地での移動や生命維持に莫大な費用がかかってしまいます。このため、一般には現地にロボットなどを設置し、遠隔操作により調査活動を行う方法が採られています。ただ、従来の遠隔操作方法では、人間が直接行うほどの柔軟かつ詳細な調査を行うことが難しいと考えられます。そこで遠隔地のロボットが置かれた環境自体を操縦者の下で再現するテレイグジスタンス[1][2]の技術を用いて、操縦者に遠隔地にいるのと同じ感覚を与える手法が試みられています[3]。

この手法の実現上の課題のひとつに、遠隔地のロボットと操縦者の通信の遅延があります。一般的なテレイグジスタンス技術はロボットと操縦者の間に高速・広帯域の通信路があることが前提になっています。ところが地上-月面間の通信では、帯域が非常に狭いだけでなく、大きな伝送遅延が存在します。このうち帯域の問題は将来改善される可能性がありますが、伝送遅延は物理的距離に起因するため、改善する手法が存在しません[4]。したがって、このような条件の下で遠隔地の環境をテレイグジスタンス技術により操縦者の周囲に再現しても、操縦者の動作に対する表示遅れのために操縦者はロボットを正しく操縦できないことが予想されます。

そこで本研究では、遠隔地のロボットの周囲の環境映像をあらかじめ操縦者の側に転送しておき、そこから操縦者の視野の映像を切り出して表示するシステムの開発を行なっています。これにより、操縦者の頭部の動き(視線の移動)に伴う表示の遅れを見かけ上は解消することができます。また、本システムは予測ディスプレイ技術[5][6]を用いた作業効率の改善手法[4]の評価のために、操縦するロボットをCG映像として環境映像に合成(重畳)表示する機能を有しています。

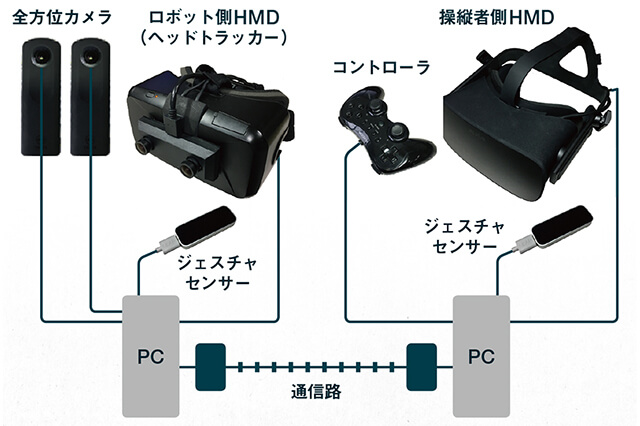

・試作システムの概要

本システムは、ロボット側に置いたカメラの映像を操縦者が装着したHMDで観測する、テレイグジスタンス視覚系において典型的な構成[7]になっています。操縦者側のHMDに映像を表示するソフトウェアは、ロボット側のカメラからネットワーク経由で取得した環境映像から操縦者の視野の映像を切り出す機能や、重畳表示している3次元形状データの位置や姿勢をマウスやゲームパッドで調整する機能、操縦者が装着したHMDのヘッドトラッキング情報をロボットに伝送する機能などをもっています。

▲2つのHMDを用いて、遠隔地の環境映像を、遠隔地の作業者(ロボット)と、作業者に指示を与える指示者との間で共有するシステムの構成。全方位カメラを用いて遠隔地の環境映像を取得し、HMDのヘッドトラッキング情報とジェスチャセンサーで取得した作業者の姿勢情報と共に指示者へ伝送します。一方で、指示者のヘッドトラッキング情報とジェスチャセンサーによる姿勢情報も、作業者に伝送します

なお、この実験には玉川大学 工学部 岡田研究室が所有する川田工業NEXTAGEを用いました。しかし、ソフトウェア開発のため、ロボットを使用せず、人(作業者)がHMDを装着して代わりを務められるようにもしています。この場合、指示者(操縦者)は作業者と視野を共有し、指示者の注視方向を示すマーカーと手の動作を表すロボットハンドを作業者の視野に重畳します。また、もとより作業者(ロボット)の注視方向を示すマーカーと手の動作を表すロボットハンドを指示者の視界にフィードバックしているので、このシステムはロボットの視界の伝送だけでなく、テレイグジスタンスや遠隔行動誘導、体験共有の実験などにも使用できます[8]。

▲【左】実験に使用したロボット(川田工業NEXTAGE)/【右】ロボットの頭部に取り付けた全方位カメラ(RICOH THETA S)

▲遠隔地の作業者の視界を指示者と共有する実験。双方の注視方向や手の姿勢を視界に重畳して表示することができます

・参考文献

[1]Susumu Tachi: "Telexistence" 2nd edition, World Scientific, 2014

[2]舘暲: "テレイグジスタンス" 日本ロボット学会誌, vol. 33, no. 4, pp. 215-221, 2015

[3]河野功 他: "月の縦孔・地下空洞探査のためのスーパーテレイグジスタンスロボットの研究" 第33回日本ロボット学会学術講演会講演予稿集, 2015

[4]大山英明, 金奉根, 城間直司: "時間遅れの大きい通信下におけるテレイグジスタンス型ロボット操縦のための表示システム" 宇宙科学技術連合講演会講演集 59, 4p, 2015

[5]M. V. Noyes, T. B. Sheridan: "A Novel Predictor for Telemanipulation Through a Time Delay" Proc. Of 20th Annual Conf. on Manual Control, NASA Ames Research Center, 1984

[6]T. B. Sheridan: "Space Teleoperation through Time Delay: Review and Prognosis" IEEE Transactions on Robotics and Automation, vol. 9, no. 5, pp. 592-606, 1993

[7]柳田康幸: "テレイグジスタンス視覚系の最近の研究動向" システム/制御/情報, システム制御情報学会誌, 46. 12, pp. 745-750, 2002

[8]大山英明, 城間直司, 八木下明宏, 根本太晴, 岡田浩之, 鈴木夏夫, 床井浩平: "TelExistance Display System (TED): テレイグジスタンス/遠隔行動誘導/体験共有のためのAR表示オープンソースソフトウェア" 第18回計測自動制御学会システムインテグレーション部門講演会 SI2017, 2C2-06, 2017

info.

-

-

月刊CGWORLD + digital video vol.251(2019年7月号)

第1特集:デジタルヒューマン&バーチャルスタジオ

第2特集:世界観を表現するデジタルアート

定価:1,540円(税込)

判型:A4ワイド

総ページ数:128

発売日:2019年6月10日

cgworld.jp/magazine/cgw251.html