今から約20年前の1995年、Pixar Animation Studios(以降、Pixar)初の長編フル3DCGアニメーション映画『トイ・ストーリー』が公開された。CG・映像専門月刊誌『CGWORLD』が創刊されたのは、その3年後の1998年だ。当時から現在までの間に、3DCGの技術はどのように発展してきたのだろうか?本記事では、モデリング、レンダリング技術を中心に、その変遷を紹介する。技術開発の歴史を知れば、3DCGの本質をより深く理解できるようになるだろう。

※本記事は、『CGWORLD Entry』vol.13(2015年9月発行号)掲載の「3DCG今昔物語 ∼技術変遷をふり返る∼」を再編集したものです。

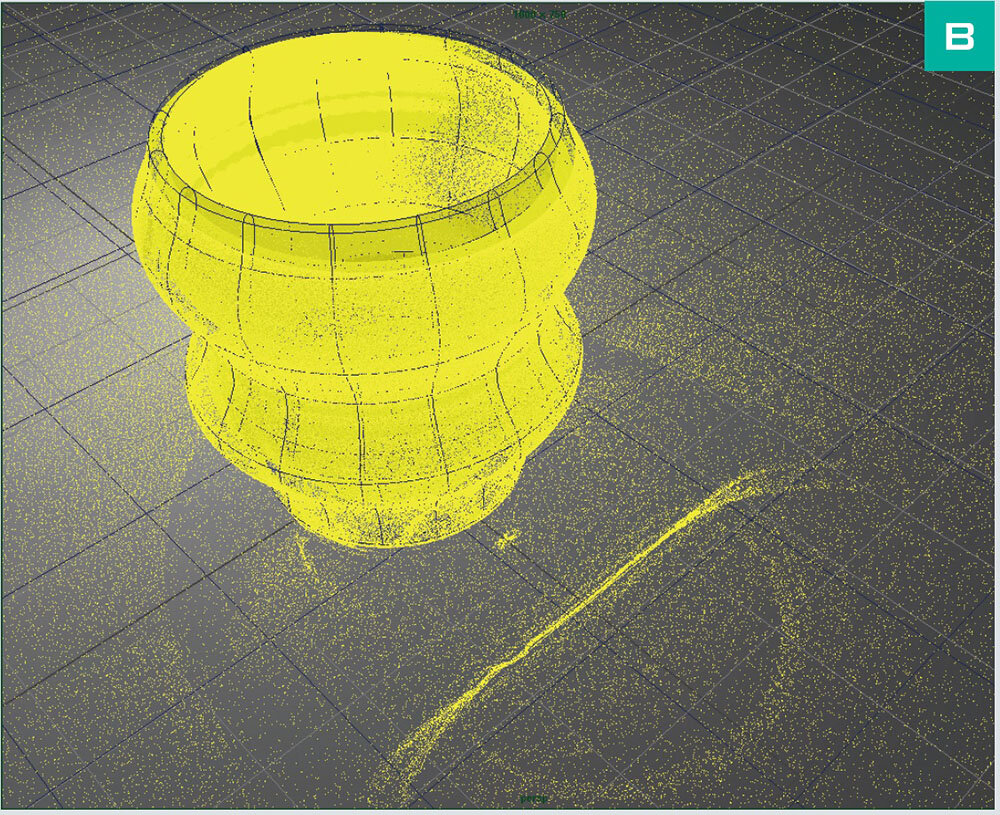

サブディビジョンサーフェスによる滑らかな曲面表現

『CGWORLD』が創刊された1998年は3DCGにとってどんな年だったのかふり返ってみよう。劇場映画でいえば、ロングラン公開となった『タイタニック』が世間の話題の中心にあった(上映開始は1997年)。『タイタニック』は大ヒットし、同じジェームズ・キャメロン監督作品である2009年公開の『アバター』が記録を塗り替えるまでの10年以上、世界映画興行成績第1位の座に君臨し続けることになる。『タイタニック』はアメリカのアカデミー賞でも視覚効果賞含め11部門を受賞し、3DCG業界以外にとっても歴史的な作品となった。

『タイタニック』公開以前、3DCGは主にSFやアクション映画で多用され、文芸作品には使われない、必要ないと考えられていた。しかし『タイタニック』の公開を境に、どんなジャンルの作品であっても、3DCGの使用は珍しくない時代へと転換していった。『タイタニック』のVFXを手がけたDigital Domainでは、膨大なショットのコンポジット(実写映像と3DCGの合成)作業において、社内で開発されたノードベースのコンポジットツールを活用した。このツールが形を変え、現在ではNUKEとして業界内で広く使われていることは興味深い。

先に紹介した作品以外にも『メン・イン・ブラック』(1997年7月)、『エイリアン4』(1997年11月)、『スターシップ・トゥルーパーズ』(1997年11月)、『フラバー』(1997年11月)、『ザ・グリード』(1998年1月)、『GODZILLA』(1998年5月)、『スモール・ソルジャーズ』(1998年7月)など、数多くの実写映画の中で、生き生きと動く3DCGキャラクターが表現された。また『アルマゲドン』(1998年7月)では大量の3DCGエフェクトによる宇宙空間での破壊や爆発、『プライベート・ライアン』(1998年9月)ではVFXを活かした臨場感あふれるドキュメンタリーのような映像が表現された。

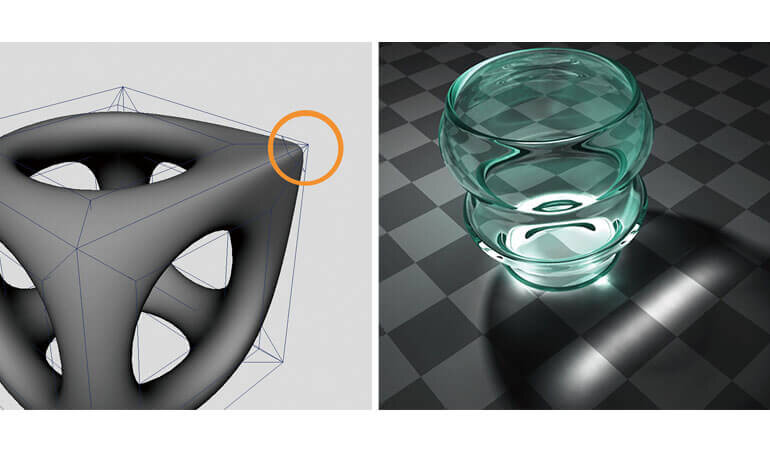

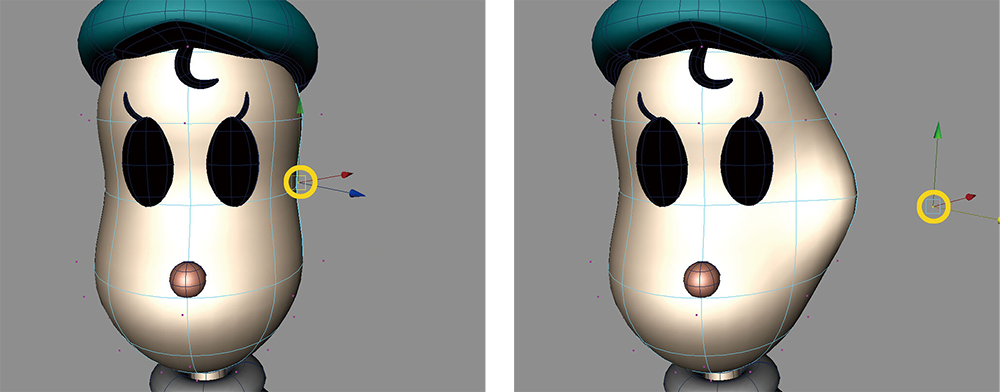

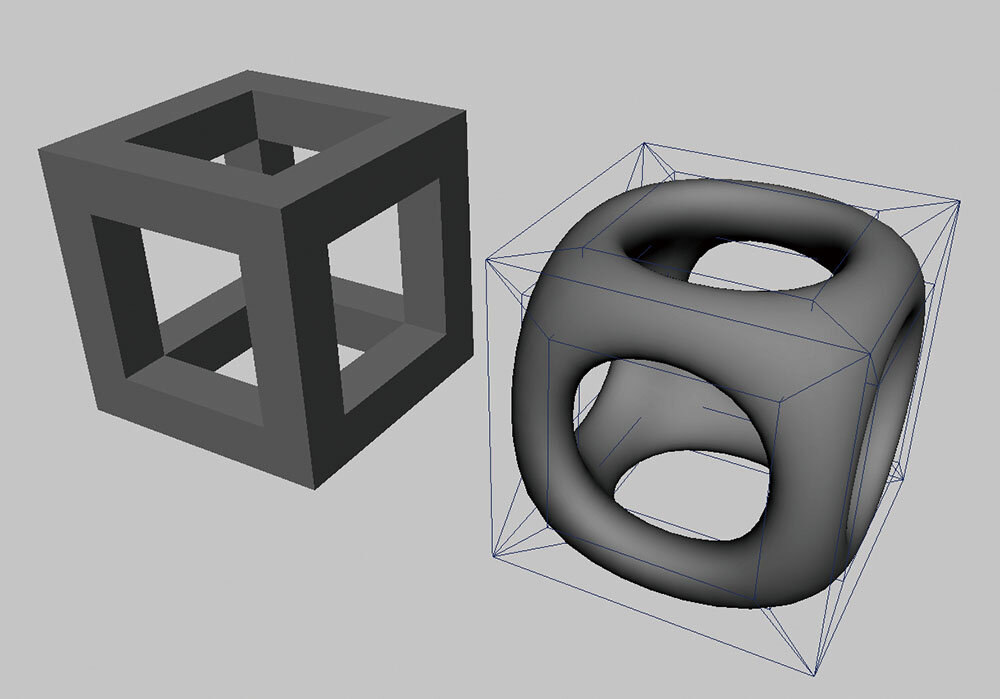

フル3DCGアニメーション映画においても、『トイ・ストーリー』(1995年)の興行的成功を受け、多くの作品が増産され始めていた。1998年にはPixarの2本目となる長編映画『バグズ・ライフ』と、DreamWorks Animationによる初の長編フル3DCGアニメーション映画『アンツ』が公開された。奇しくも、両作とも虫をキャラクター化した映画であった。この『バグズ・ライフ』と同時公開された短編作品『ゲーリーじいさんのチェス』において、それまで基礎研究レベルだったサブディビジョンサーフェスが実用レベルまで磨かれ、実際に使用された。当時のモデリングでは、NURBSメッシュなどの自由曲面を使って滑らかな曲面を表現することが多かった。しかしサブディビジョンサーフェスの実用化以降、この技術がモデリングの主流となっていった。

なお、コンシューマゲームでは1994年にソニー・コンピュータエンタテインメント(現、ソニー・インタラクティブエンタテインメント)からプレイステーション、セガ・エンタープライゼス(現、セガゲームス)よりセガサターンが発売され、3DCGを活かしたゲームが市場を席巻することになった。1998年には、それぞれシリーズ初の3DCGゲームである『メタルギアソリッド』(プレイステーション)や『ソニックアドベンチャー』(ドリームキャスト)が発売された。

グローバルイルミネーション、アンビエントオクルージョンによる自然でリアルな陰影表現

3DCG業界における1998年の最大トピックは、Alias Systemsから3DCGソフトウェアのMayaが発売されたことかもしれない(2016年現在、Mayaはオートデスクによって開発・販売されている)。それまでのハイエンド3DCGはグラフィックスワークステーションと呼ばれる高価なコンピュータを使用して制作され、PCベースの3DCGツールと差別化されていたが、この時期から急速にプラットフォームがPCに移行していった。

1990年代末には3DCGを用いた商業作品が当たり前のものとなり、よりクオリティの高い3DCGを求めてレンダリングの技術開発が意欲的に進められた。この頃までのマテリアル表現には、1970∼1980年代に開発されたシェーディングモデルが使われていた。これは物体表面における光の振る舞いを極めて単純化したシェーディングモデルで、物理的な正しさは追求していなかった。しかしアメリカの映画市場では、実写と3DCGを組み合わせた自然でリアルな映像表現が求められており、現実世界の光の性質に基づいたレンダリング技術が開発されていった。

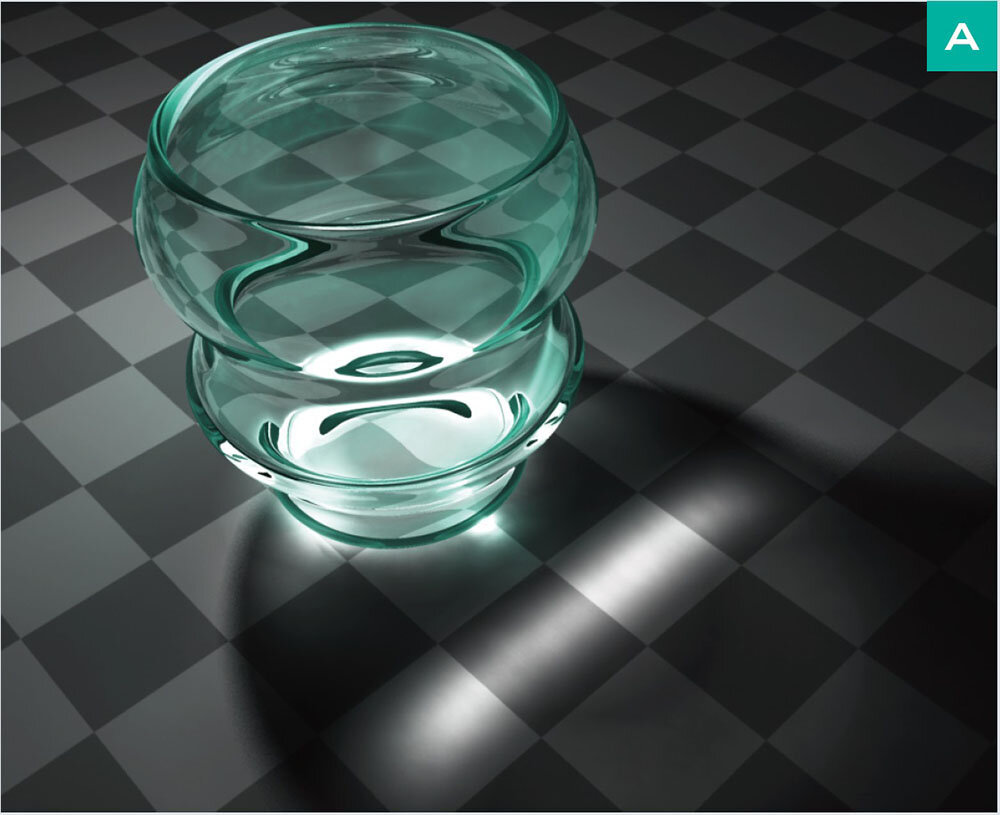

3DCG空間全体に影響する複雑な照明効果を計算し、やわらかく自然な間接光と陰影を生成するレンダリング方法のことをグローバルイルミネーション(Global Illumination/以降、GI)と呼ぶ。研究レベルであれば、1980年代中頃にはラジオシティ法などのアルゴリズムは開発されていたが、計算量が膨大なのに加え、計算方法に合わせたオブジェクトのポリゴン分割を行う必要があること、コースティクスを表現できないことなどから実制作での使用は難しいと考えられていた。しかし1998年、Blue Sky Studiosの短編作品である『バニー』が発表された。本作は全編にラジオシティ法を導入した意欲作で、作品内容も評価され、翌年のアカデミー賞で短編アニメーション部門賞を受賞した。本作の尺は7分弱だったが、レンダリングの計算には1年以上を要したという。

一方、1996年にはヘンリク・ヤンセン(Henrik Jensen)氏(現、カリフォルニア大学 サンディエゴ校 教授)らがフォトンマッピング法によるGIを発表し、コースティクスの表現が可能となった。さらに視点からの光の追跡、光源からの光の追跡の双方を行うことで、オブジェクトのポリゴン分割に左右されず、質の高いレンダリング結果を得られるようになった。コンピュータの性能が向上し、それまで諦めていた計算量の多い処理が実用レベルに近づいてきたことも追い風となった。

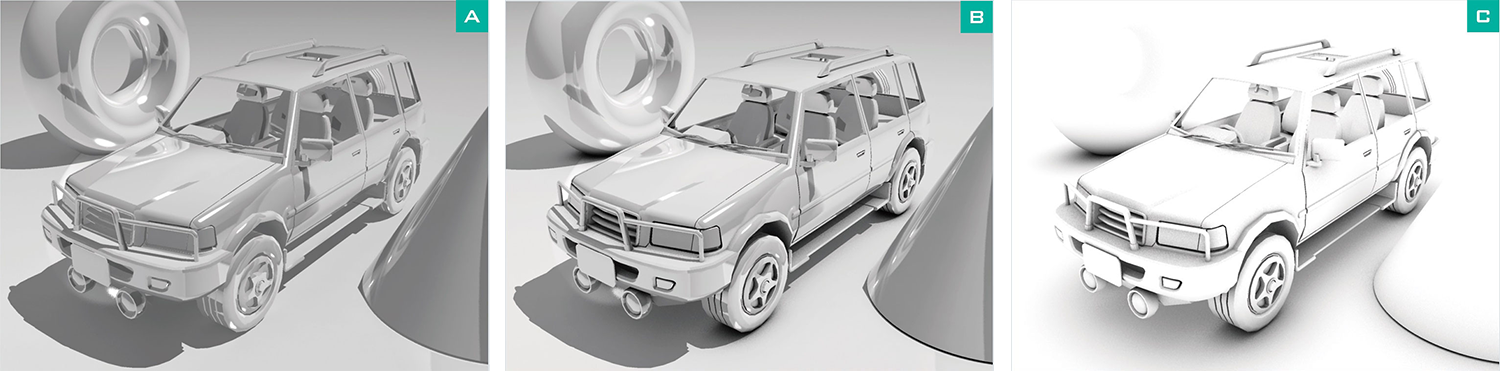

GIの実用化が現実味を帯びてきたとはいえ、依然として計算には多くのリソースを必要とし、長編映画制作などへの導入はためらわれていた。そんな折、従来のシェーディングモデルの中でもひときわ単純化されていたアンビエント(環境光)成分の計算を見直すことで、物体の陰影のリアリティを高めるアンビエントオクルージョンというレンダリング方法が開発された。この技術は、2001年公開の『パール・ハーバー』において、零式艦上戦闘機の3DCGなどに使われた。

サブサーフェススキャタリングによる皮膚表現、イメージベースドライティングによる実写と3DCGの合成

物体の質感表現においては、3DCGは物体表面で光が反射する材質の表現には適しているが、物体内部まで光の一部が透過する材質の表現には適さないとされてきた。しかし、前述のヘンリク・ヤンセン氏らが2001年に提案したサブサーフェススキャタリング(Subsurface Scattering/以降、SSS)の実用化によって状況は一変した。SSSは物体内部に浸透した光の振る舞いを単純化して計算するレンダリングアルゴリズムで、人体の皮膚、大理石、ロウソクなどの光を透過する物体の質感をリアルに表現できるようになった。

『ハリー・ポッターと秘密の部屋』(2002)では、Industrial Light & Magic(以降、ILM)が3DCGキャラクターのドビーの皮膚を表現するためにSSSを使用した。また『ロード・オブ・ザ・リング/二つの塔』(2002)でも、Weta Digitalが3DCGキャラクターのゴラムの皮膚をSSSで表現した。こうしたクリーチャーだけでなく、『レモニー・スニケットの世にも不幸せな物語』(2004)ではILMが実写と見紛うような3DCGの赤ん坊を表現した。

ライティングにおいても、それまでのポイントライト(点光源)やディレクショナルライト(方向性ライト)では表現しきれなかった、より現実世界に近い複雑な照明効果が求められるようになった。特に実写と3DCGを合成する作品においては、実写撮影時の照明条件と、3DCGのライティングを合わせるための技術が強く求められていた。そんな中、2000年前後のポール・デベヴェック(Paul Debevec)氏(現、Google VR シニアエンジニア/南カリフォルニア大学 非常勤教授)らによる研究が、イメージベースドライティング(Image Based Lighting/以降、IBL)として結実した。

IBLは、環境マッピング(金属などの表面に周囲の環境が映り込む様子を、画像を使って擬似的に表現する方法)を拡張し、ライティングに応用する技術だった。ただし、従来の画像形式ではダイナミックレンジが狭すぎたため、広いレンジの明るさ情報を記録できるHDRI(High Dynamic Range Image)という新しい画像形式が開発された。

物理ベースレンダリングを基準とする画づくり、シーンリニアワークフローによる色情報の管理

先に紹介したレンダリングの技術開発は、現実世界の光の性質をより忠実に再現することに注力してきた点では、同じゴールを目指していたと言える。これらの技術の統合に加え、双方向反射率分布関数(BRDF)を用いたより現実に近い反射表現、3DCG空間内の全てのカメラやライトの振る舞いをより現実のそれに近づける計算方法などを積み重ねることで、ようやく物理ベースレンダリング(Physically-Based Rendering/以降、PBR)が制作現場にも浸透しつつある。

PBRは現実世界を模倣した光学的に正確なレンダリング技術で、非常にフォトリアルな画像を生成できる。ただし、単にリアルな画づくりを追求するためだけの技術ではない。今日の長編映画や大作ゲームの3DCGは、大量のマテリアルやオブジェクトと、それを取り巻く複雑な照明環境によって成り立っている。それらのパラメータのひとつひとつを、アーティストが自分の目で確認しながら調整することは不可能になりつつある。

3DCG空間内の光の振る舞いを現実世界のそれに近づけることは、様々な照明環境下の全ての被写体を、常に違和感なく自然に見せる上での基準となり得る。そのため、写実的なリアリティが求められないフル3DCGアニメーションにおいても、最近はPBRを取り入れるケースが増えている。多くの人間は、自分が見慣れた現実の光を「自然な光」だと認識する。そのため、アーティスティックな色使い、非現実的なライティングを用いた作品であっても、現実世界の光をスタート地点にすることが、違和感のない画づくりの近道となるからである。

3DCGにおけるレンダリング計算が前述のように現実世界に近づくと、IBLに使用する画像やテクスチャ画像にも、より正確な色情報をもたせることが求められる。さらに、実写素材と3DCG素材を合成する場合、あるいは3DCG素材同士を合成する場合には、色情報の扱い方を統一する必要がある。一部の工程や機能のみで現実世界の光をシミュレーションするのではなく、制作フロー全体で光(=色)情報の扱いを統一しなければ、せっかく導入した技術が活かされない。このような理由から、シーンリニアワークフローを導入するケースが増えつつある。シーンリニアワークフローでは、実写の撮影データの入出力、3DCGの画像データの入出力、画像の色調整、画像の合成、最終表示デバイスや録画メディアへの出力などの全工程において同じ基準で色情報を扱うことで、現実世界の光を模した効率の良い画づくりを実現している。

2000年代以降の3DCGは、新しいレンダリング技術や方法が開発されると、ただちにリアルタイムCGでの実現方法も研究され、ほとんど時間を置かずしてGPU上での実装方法が発表されるようになった。この状況は、フル3DCGゲームをはじめとするインタラクティブコンテンツの開発においても、現実世界に即した自然な光の表現が求められていることを表している。

※本記事の作例は、『CG&映像しくみ事典 第二版』(ワークスコーポレーション、2009)のCHAPTER5より引用しました。

TEXT_奥居晃二

EDIT_CGWORLD編集部