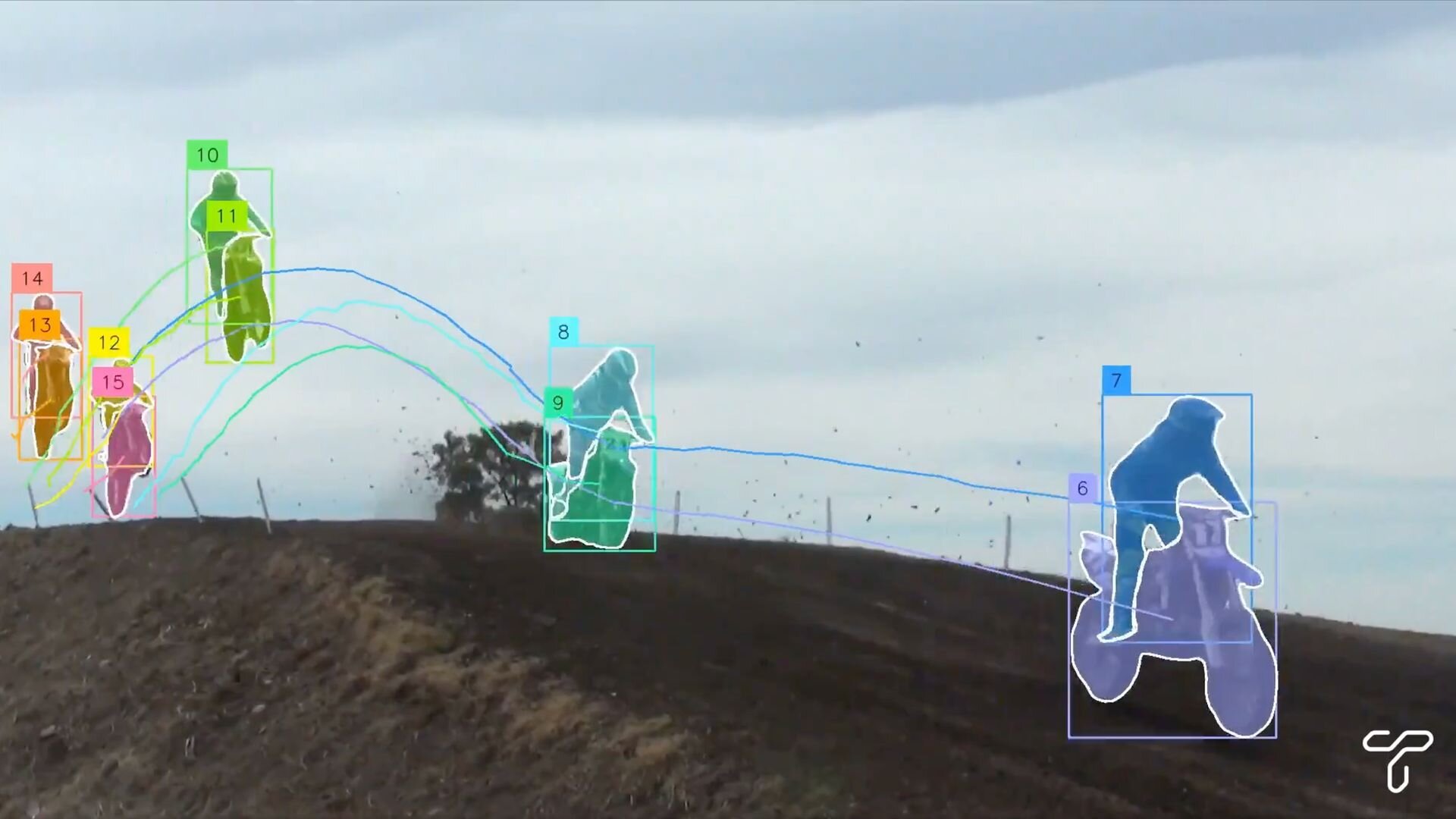

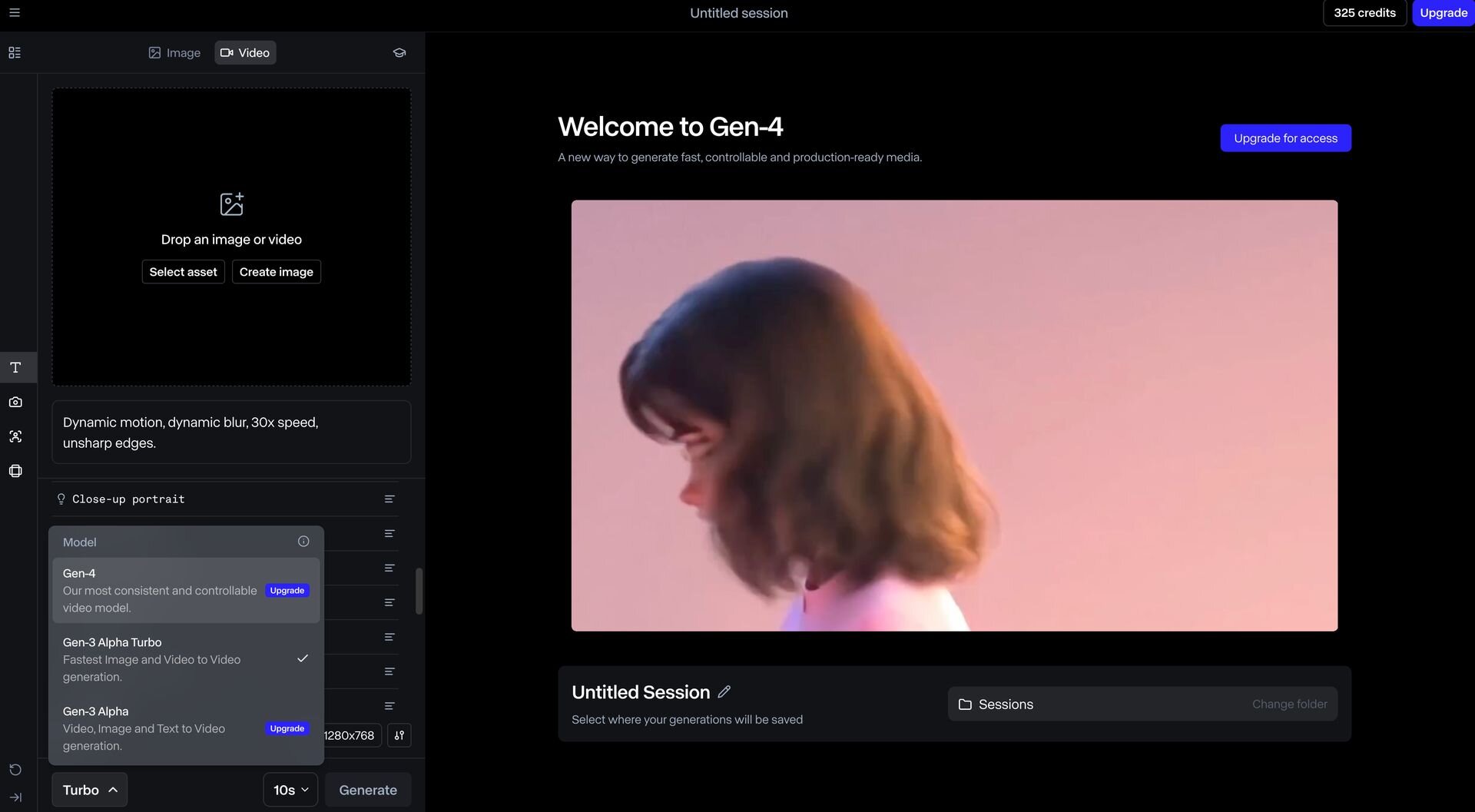

アメリカRunway AI社は3月31日(月)、動画生成AI「Gen-4」をリリースした。Gen-3 Alphaよりもシーン内で一貫性のあるキャラクターやロケーション、オブジェクトを正確に生成できるようになったほか、シーン内の複数の視点や位置から首尾一貫した環境を維持した映像の再生成にも対応する。Gen-4の利用には有料プランのサブスクリプションが必要となる。

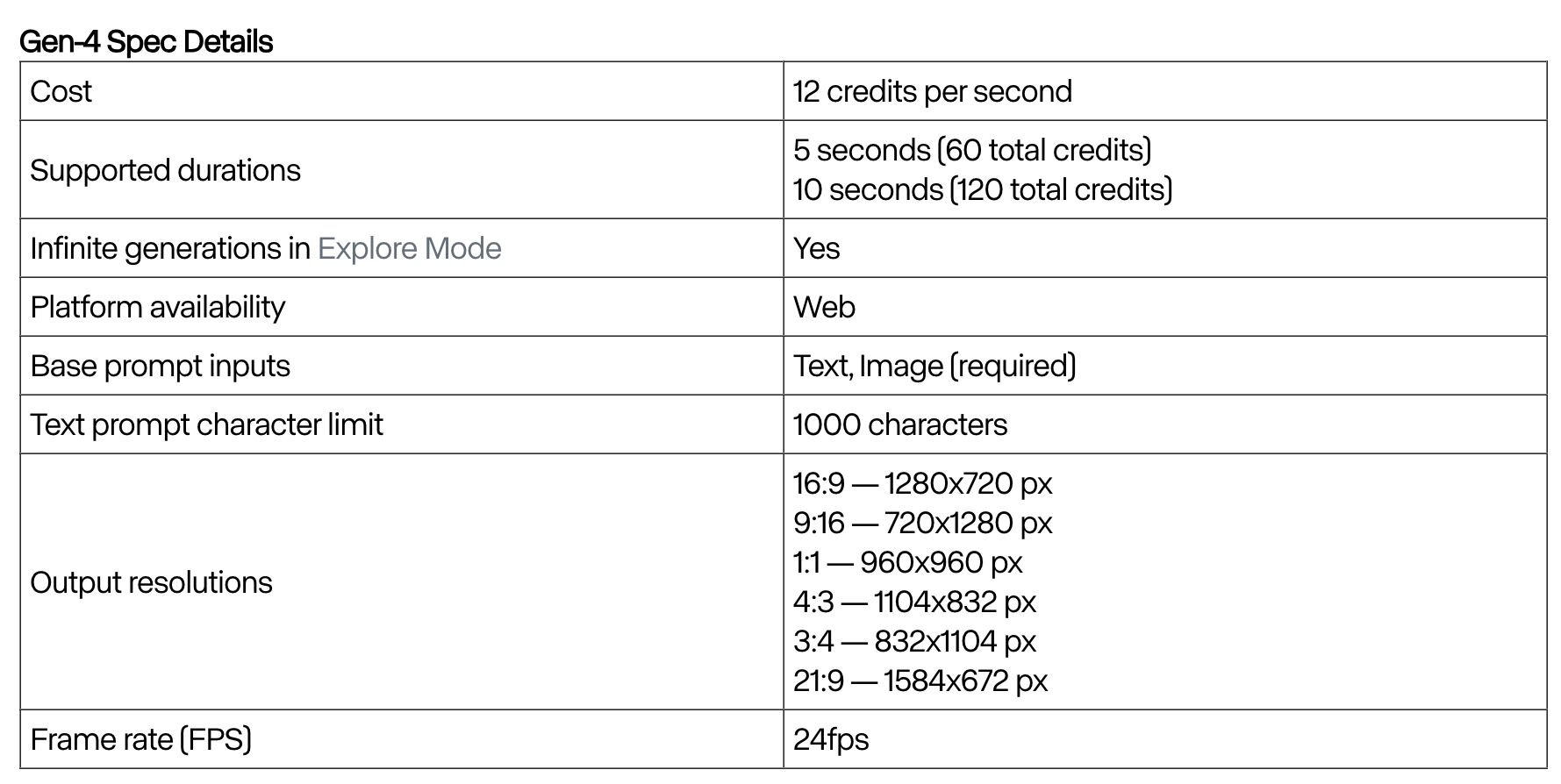

Gen-4では24fps、5秒または10秒の動画を生成できるが、生成にはテキストプロンプトだけでなく入力画像が必要となる。この入力画像は生成動画の最初のフレームにもなるため、生成する動画の視覚的情報のリファレンスとしても機能する。そのため、テキストプロンプトは希望のモーションを説明することにフォーカスする必要がある。

■Introducing Runway Gen-4(Runway Research、英語)

https://runwayml.com/research/introducing-runway-gen-4

■Creating with Gen-4(Runway Help Center、英語)

https://help.runwayml.com/hc/en-us/articles/37327109429011-Creating-with-Gen-4

Gen-4で生成・制作したショートムービー

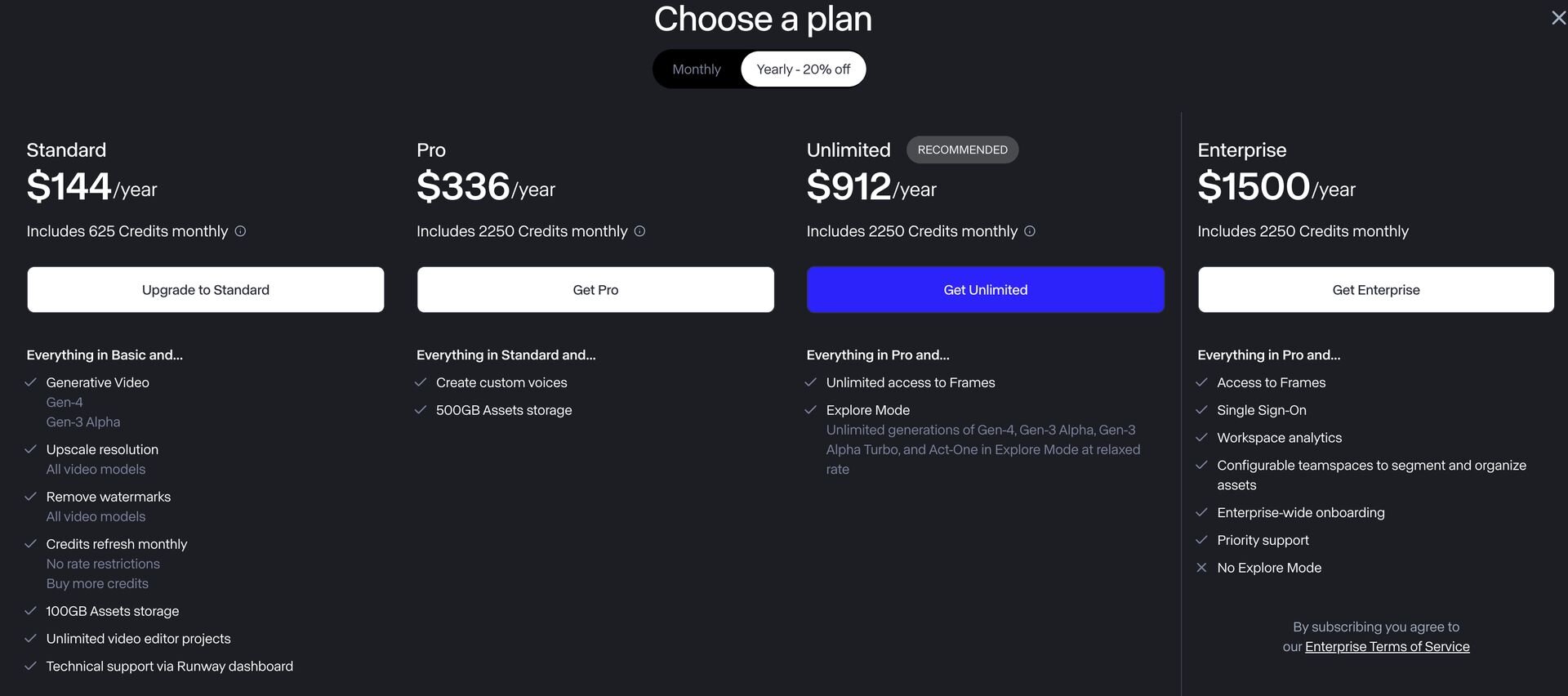

プランと価格、クレジットのシステム

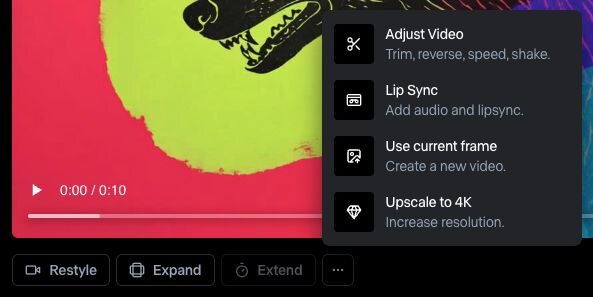

有料サブスクリプションプランは4種類。最もリーズナブルな「Standard」は、月額払いなら月15ドル(約2,190円)、年払いなら月12ドル(約1,750円)相当となる。Standardプランでは月625クレジットが付与され、Gen-4およびGen-3 Alphaが利用可能になるほか、動画のアップスケール、ウォーターマーク除去も利用可能になる。

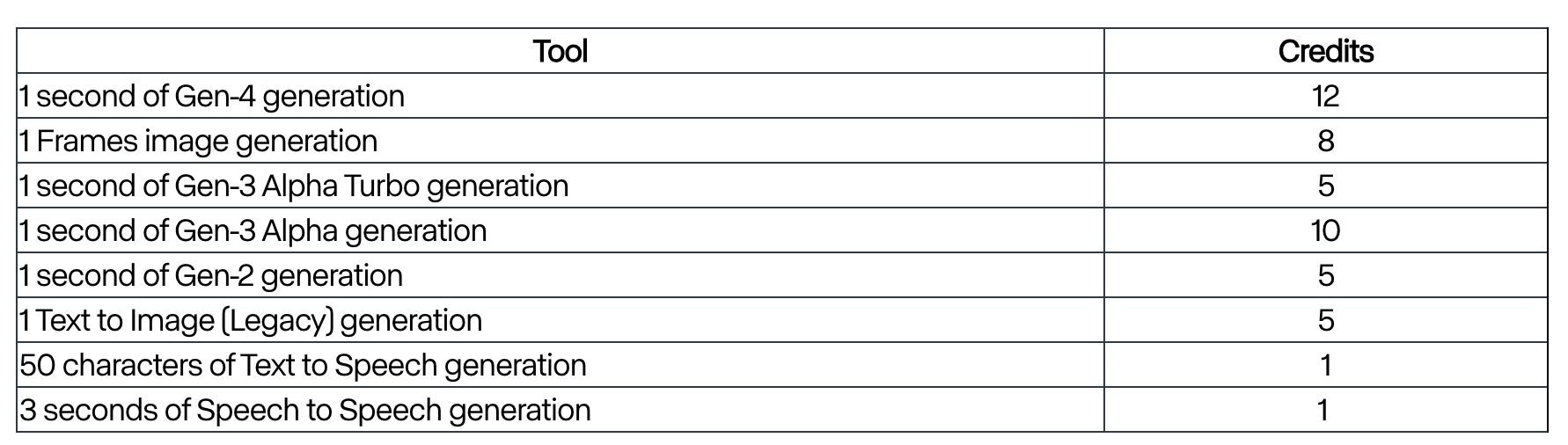

Gen-4での生成は1秒につき12クレジットが必要となるため、Standardプランの月625クレジットで生成できるGen-4動画は約52秒となる。

■How do credits work?(Runway Help Center、英語)

https://help.runwayml.com/hc/en-us/articles/15124877443219-How-do-credits-work

CGWORLD関連情報

●アドビ、Fireflyに加えGoogle Veo 2・Imagen 3、Flux 1.1 Pro、Runway FramesなどサードパーティAIモデルが選択可能に まずはAdobe Project Concept、Adobe Expressから

Adobeは同社製品で利用可能な生成AIモデルをAdobe Fireflyだけに制限せず、サードパーティ製AIモデルを選択可能にするとブログで発表。まずはAdobe Project ConceptとAdobe Expressで利用可能になるという。

https://cgworld.jp/flashnews/01-202504-Adobe-GenAI.html

●Stability AIらがオープンソースの動画生成AI「Stable Virtual Camera」公開! 1枚の画像から多彩なカメラモーションのマルチビュー映像を生成

Stability AI、オックスフォード大学、カリフォルニア大学バークレー校の研究チームが動画生成AIモデル「Stable Virtual Camera」を公開。1枚から32枚までの入力画像から、最大1,000フレームにわたるマルチビュー映像を生成できる。オープンソース(非営利ライセンス)で提供され、Hugging Faceではデモが、GitHubではソースが公開されている。

https://cgworld.jp/flashnews/202503-Stability-Virtual-Camera.html

●Luma AIが生成AI向けの新しい事前学習アルゴリズム「Inductive Moment Matching(IMM)」を発表! 拡散モデルなど既存手法よりも優れたサンプル品質、10倍以上向上したサンプリング効率

Luma AIが生成AI向けの新しい事前学習(Pre-training)アルゴリズム「Inductive Moment Matching(IMM)」を発表。IMMは、従来の手法である自動回帰モデル(Autoregressive model)や拡散モデル(Diffusion model)、一貫性モデル(Consistency model)などと比較して、学習済みの大規模モデルの性能をより引き出せるアルゴリズムだという。オープンソースで公開されている。

https://cgworld.jp/flashnews/202503-Luma-IMM.html