NVIDIA Researchは7月12日(金)、SIGGRAPH 2024で発表するシミュレーションと生成AIに関する研究内容を公開した。研究はビジュアル生成AI用のディフュージョンモデル(Text-to-Image)、物理ベースのシミュレーション、AIを活用したレンダリングに焦点を当てたもので、日本の大学を含む各国の研究者や企業との共同研究による論文は20を超えるという。ここでは、NVIDIAの当該ブログ記事の中からいくつかをピックアップして紹介する。

Text-to-Image AIモデルの進化

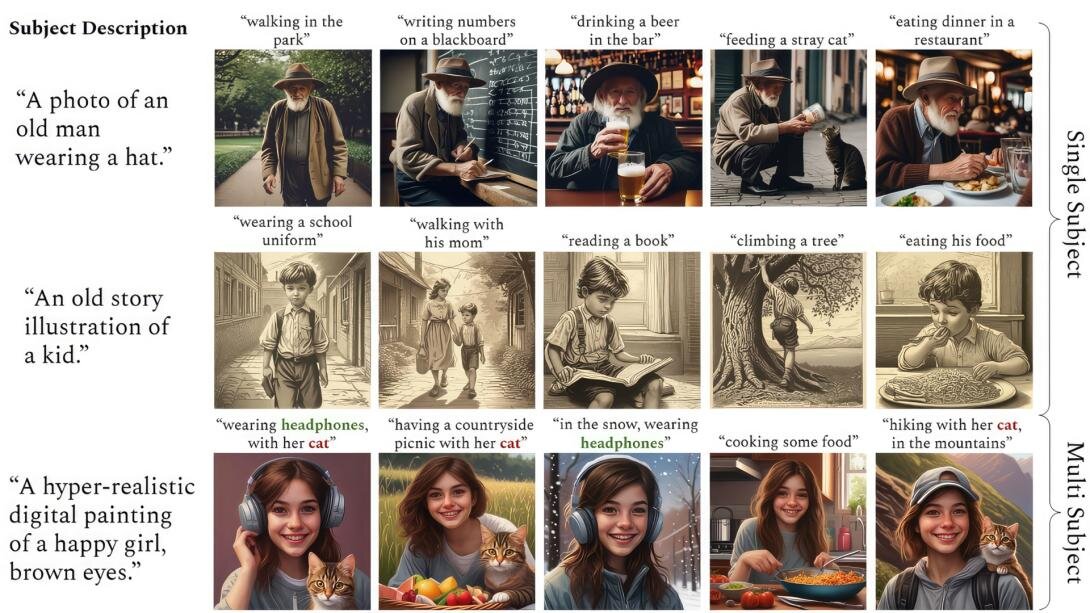

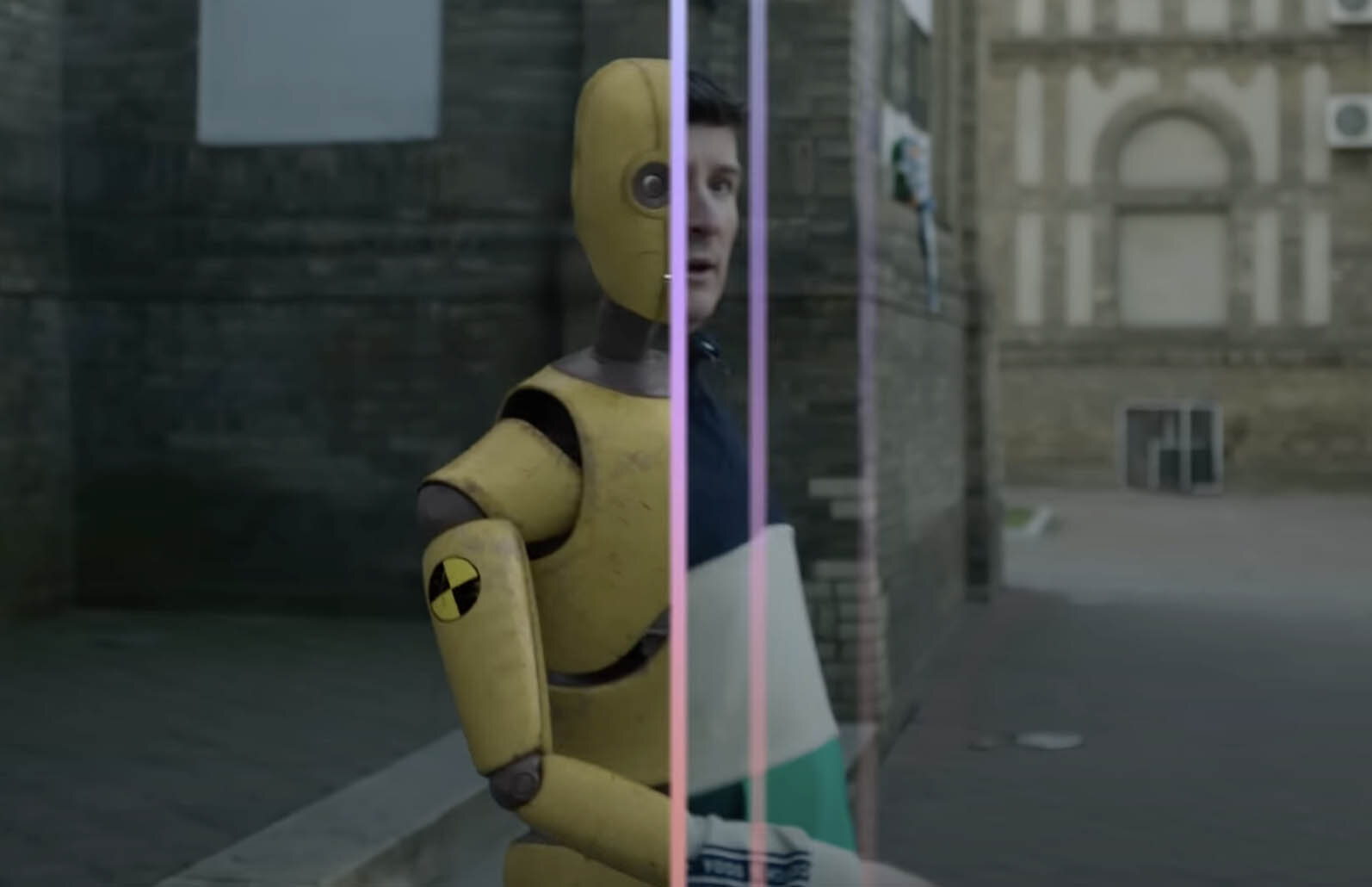

同じキャラクターの登場シーンを複数生成「ConsiStory」

NVIDIAとTel Aviv大学の共同研究「ConsiStory」は、同じキャラクターを使った異なるシーンの画の生成を簡単に行えるもの。「subject-driven shared attention」 という手法の導入により、一連の画像生成に要する時間を13分から約30秒まで短縮できたという。

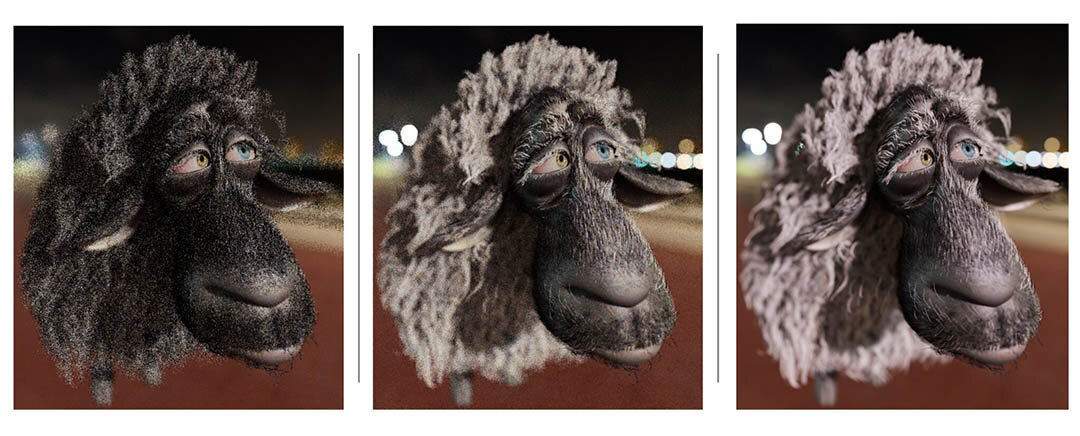

ディフュージョンモデルを活用した3Dペイント「Diffusion Texture Painting」

NVIDIA Researchによる「Diffusion Texture Painting」は、2Dの生成画像(ディフュージョンモデル)を3Dメッシュに対してリアルタイムペイントする技術。一般的な3Dペイントとは異なり、リアルタイムでシームレスなブラシストロークを生成し、異なるテクスチャ間を自然に馴染ませることができるという。

Our method is the first to use DMs for interactive texture painting, and we hope it will inspire work on applying generative models to highly interactive artist-driven workflows.

これはインタラクティブなテクスチャペインティングにディフュージョンモデルを用いる最初のメソッドです。生成AIモデルの適用がアーティスト主導のワークフローにインスピレーションを与えることを期待しています。

論文「Diffusion Texture Painting」

https://research.nvidia.com/labs/toronto-ai/DiffusionTexturePainting/

物理シミュレーションの進化

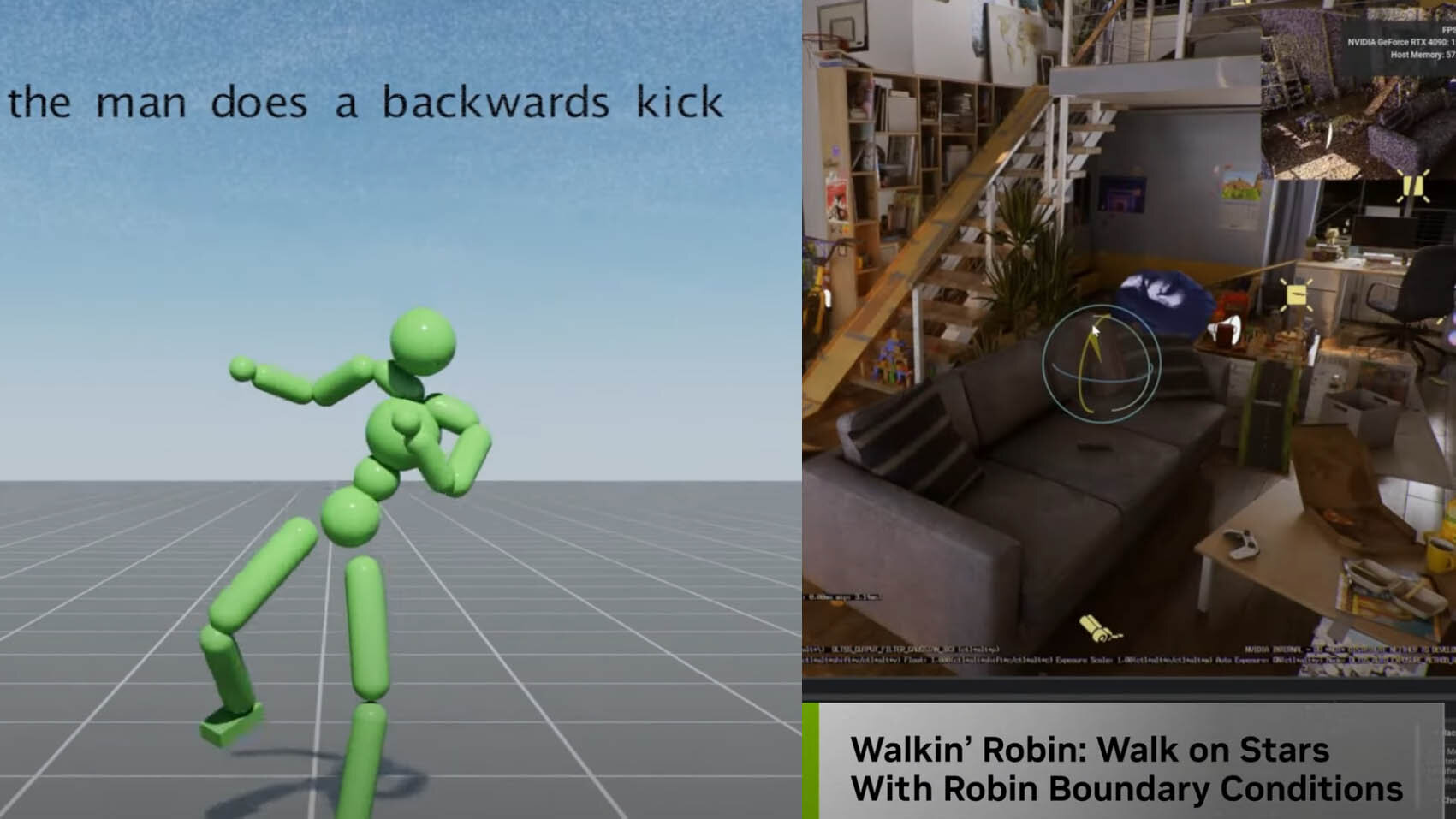

テキストプロンプトで人間の複雑な動作をシミュレートする「SuperPADL」

NVIDIA Researchが今回発表する論文のうち、“ブレイクスルーのひとつ”として挙げるのが、Jordan Juravsky氏らとNVIDIAが共同研究を進める「SuperPADL」。テキストプロンプトから複雑な人間の動作をシミュレートし、アニメーションに落とし込むというものだ。

強化学習(reinforcement learning)と教師あり学習(supervised learning)を併用してフレームワークをトレーニングした結果、5,000以上の動きを再現できたという。なお、本フレームワークはコンシューマー向けのNVIDIA GPUでもリアルタイムで実行可能とのこと。

論文「SuperPADL: Scaling Language-Directed Physics-Based Control with Progressive Supervised Distillation」

https://research.nvidia.com/publication/2024-07_superpadl-scaling-language-directed-physics-based-control-progressive

光ではなく熱解析・静電気学・流体力学によるレンダラ「Walkin’ Robin」

カーネギーメロン大学の研究者と共同開発を進める「Walkin’ Robin」は、物理的な光のモデリングではなく、熱解析や静電気学、流体力学を実行できる新種のレンダラ。並列化が容易で、面倒なモデルのクリーンアップが不要なことから、エンジニアリングの設計サイクルをスピードアップできるとしている。

論文「Walkin’ Robin: Walk on Stars with Robin Boundary Conditions」

https://research.nvidia.com/labs/prl/miller2024wost/WoStRobin.pdf

パストレーシングワークフローの進化

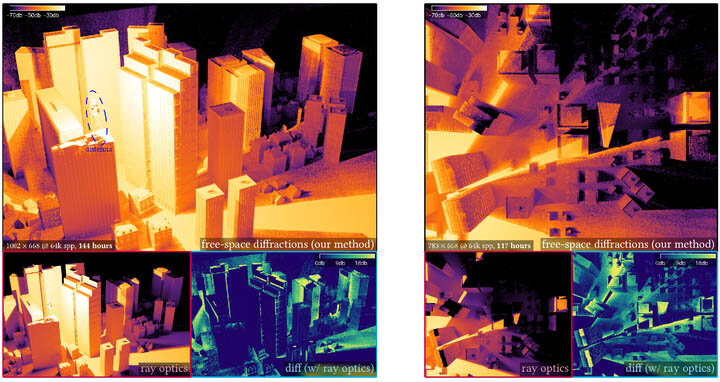

光の回折効果を高速にシミュレートする新しい手法「A Free-Space Diffraction BSDF」

ウォータールー大学の研究者との共同研究「A Free-Space Diffraction BSDF」では、光がオブジェクトのエッジで広がったり曲がったりする光学現象(自由空間における回折)のシミュレーションに取り組んでいる。パストレーシングのワークフローと統合することにより、複雑なシーンでの回折シミュレーション効率が高まり、最大1,000倍の高速化を実現するという。本モデルは可視光のレンダリングはもちろん、レーダーや音、ラジオ波のシミュレーションにも利用できるそうだ。

論文「A Free-Space Diffraction BSDF」

https://research.nvidia.com/labs/rtr/publication/steinberg2024diffraction/

パストレーシングのサンプル数を25倍まで増やす「Area ReSTIR」

SIGGRAPH 2020で初めて登場した、NVIDIAとダートマス大学の研究者の共同開発によるパストレーシングアルゴリズム「ReSTIR」。今回発表されたユタ大学とNVIDIAの共同研究による「Area ReSTIR」は、計算済みパスの再利用によって有効サンプル数を最大25倍に増やす手法で、画像品質を大幅に向上できるという。

論文「Area ReSTIR: Resampling for Real-Time Defocus and Antialiasing」

https://research.nvidia.com/labs/rtr/publication/zhang2024area/

発表内容全文はこちらから(英語)。

Mile-High AI: NVIDIA Research to Present Advancements in Simulation and Gen AI at SIGGRAPH

https://blogs.nvidia.com/blog/siggraph-2024-ai-graphics-research/

SIGGRAPH 2024はカナダ・デンバーで、現地時間7月28日(日)から5日間開催される。

https://s2024.siggraph.org/

CGWORLD関連情報

●Meta、3Dモデル生成AI「Meta 3D Gen」発表! テキストプロンプトから3DモデルとPBRテクスチャを高速生成、テクスチャ再生成による複数モデルのルック統一も

Meta社がテキストto3Dの生成AI技術「Meta 3D Gen」の論文を同社Webサイトに発表。

https://cgworld.jp/flashnews/202407-meta3dgen.html

●【見どころピックアップ】VR空間内でモーションキャプチャ&アニメーション編集! Autodesk×Meta「Project Reframe」プロトタイプ動画公開

オートデスクとメタが共同研究を進める、VR空間内でモーションを記録・編集するシステム「Project Reframe」。公開されたプロトタイプ動画の見どころを紹介。

https://cgworld.jp/flashnews/202406-PrjReframe.html

●オートデスク、Wonder Dynamics社の吸収合併を発表 クラウドベース・AI活用のCG実写合成ソリューション「Wonder Studio」の開発元

AIソリューションによるCG制作環境の変化が期待されるニュース。

https://cgworld.jp/flashnews/202405%E2%88%92Autodesk%E2%88%92WD.html