NVIDIA Research・NVIDIA Toronto AI Lab・トロント大学らは1月30日(木)、インバースレンダリングとフォワードレンダリングの二重の問題に取り組むニューラルアプローチ「DiffusionRenderer」の研究論文を発表した。

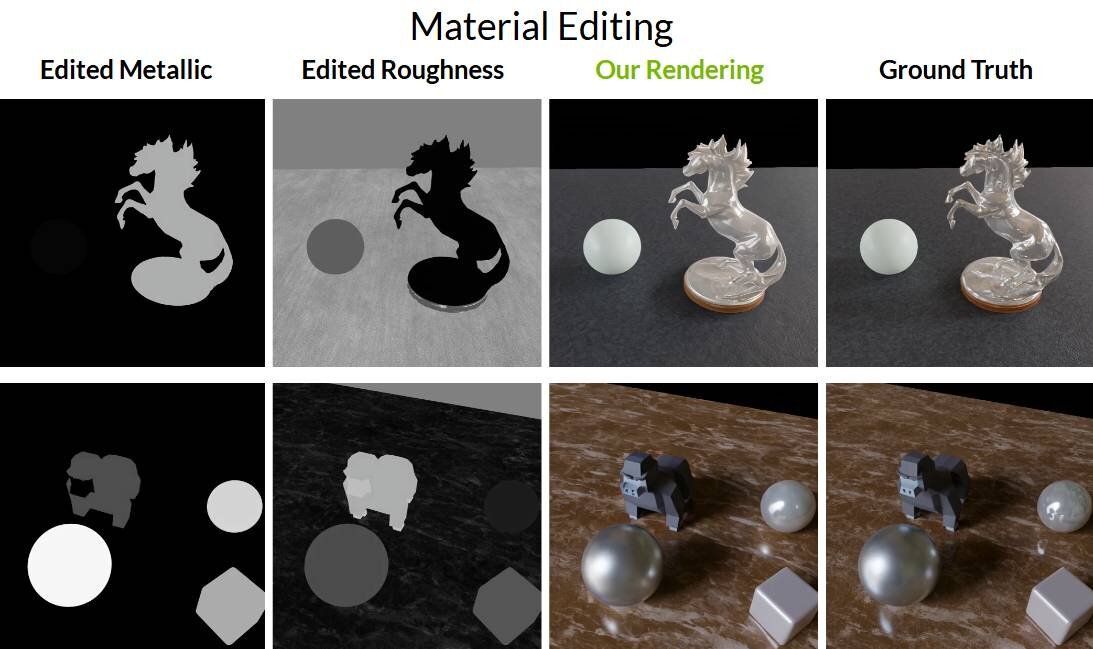

本アプローチでは入力画像・動画からジオメトリとマテリアルバッファを正確に推定できることから、新たに指定する照明条件下でフォトリアルな画像生成が可能になる。

そのため、映像のリライティング、画像内のマテリアル再編集、バーチャルシーンへのオブジェクト挿入/削除などでフォトリアルのアウトプット結果が得られる。

▲バーチャルシーンへのオブジェクト挿入(左:挿入前、右:挿入後)

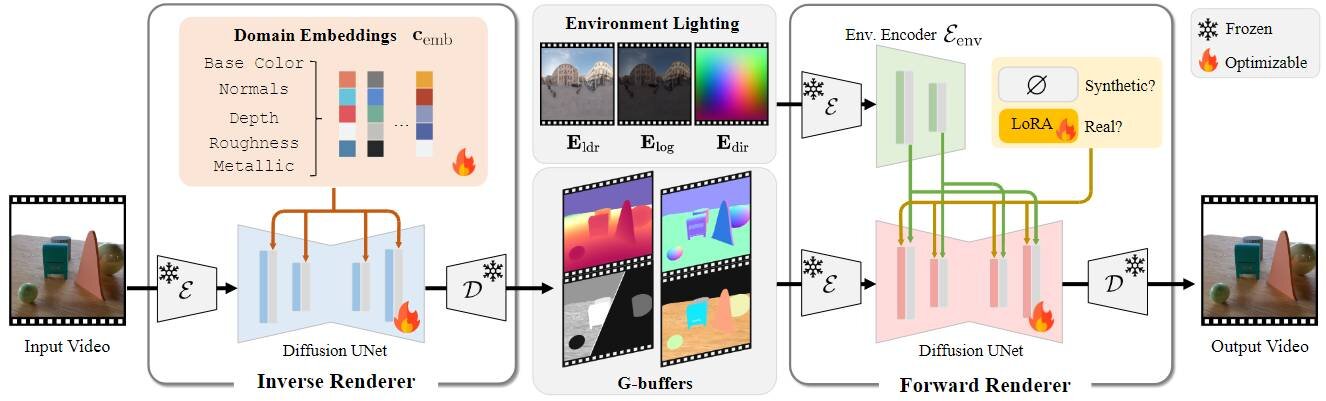

Classic physically-based rendering (PBR) accurately simulates the light transport, but relies on precise scene representations—explicit 3D geometry, high-quality material properties, and lighting conditions—that are often impractical to obtain in real-world scenarios. Therefore, we introduce DiffusionRenderer, a neural approach that addresses the dual problem of inverse and forward rendering within a holistic framework.

古典的な物理ベースレンダリング(PBR)は、光の輸送を正確にシミュレートしますが、明示的な3Dジオメトリ、高品質のマテリアルプロパティ、および照明条件などの正確なシーン表現に依存します。そこでわれわれは、全体的な枠組みの中でインバースレンダリングとフォワードレンダリングの二重の問題に取り組むニューラルアプローチであるDiffusionRendererを紹介します。

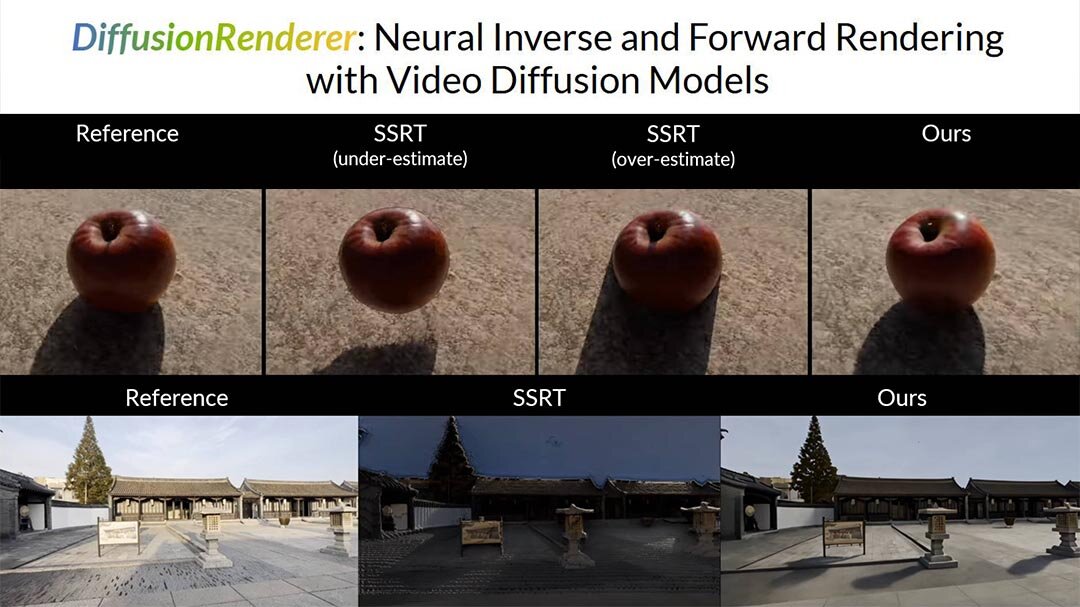

Experiments demonstrate that DiffusionRenderer effectively approximates inverse and forwards rendering, consistently outperforming the state-of-the-art.

実験では、DiffusionRendererがインバースレンダリングとフォワードレンダリングに対して効果的に近似し、常に最先端技術を凌駕することが実証されました。

DiffusionRendererでは、映像が入力されるとニューラル・インバースレンダラがピクセルごとにジオメトリとマテリアルプロパティ(ノーマル・深度・アルベド・メタリック・ラフネス)を推定する。そのため、このニューラル・インバースレンダラは、デライティング(de-lighting、ライティングの影響を除去)のための汎用ソリューションとなる。

ニューラル・インバースレンダラによる処理が完了すると、ニューラル・フォワードレンダラが、ライティング情報・ジオメトリ・マテリアルバッファの入力からフォトリアルな画像を生成する。

■DiffusionRenderer: Neural Inverse and Forward Rendering with Video Diffusion Models(論文、英語)

https://research.nvidia.com/labs/toronto-ai/DiffusionRenderer/

CGWORLD関連情報

●「NVIDIA RTX Kit」発表! GeForce RTX 50シリーズ時代のリアルなゲームキャラ作成を可能にするニューラル・レンダリング技術群

NVIDIAがゲームキャラクター作成用の新しいニューラル・レンダリング技術群「NVIDIA RTX Kit」を発表。本技術群は、ゲームアセットのAIによるレイトレース、パフォーマンスの向上したパストレーシングの利用、フォトリアルなゲームキャラクターのビジュアル生成などに活用できる。

https://cgworld.jp/flashnews/202501-NVIDIA-RTX-Kit.html

●NVIDIA、メッシュ生成モデル「Meshtron」発表! アーティストが制作するような高品質・実用的なトポロジーを生成可能

NVIDIAが機械学習アルゴリズムを用いた3Dモデルのメッシュ生成モデル「Meshtron」を発表。Meshtronは入力されたポイントクラウドデータから、アーティストが制作するような整理されたトポロジーを持つ3Dメッシュを生成する。1,024レベルの座標解像度・最大64K面のメッシュの生成に対応する、新しい自己回帰モデルとなる。

https://cgworld.jp/flashnews/202412-NVIDIA-Meshtron.html

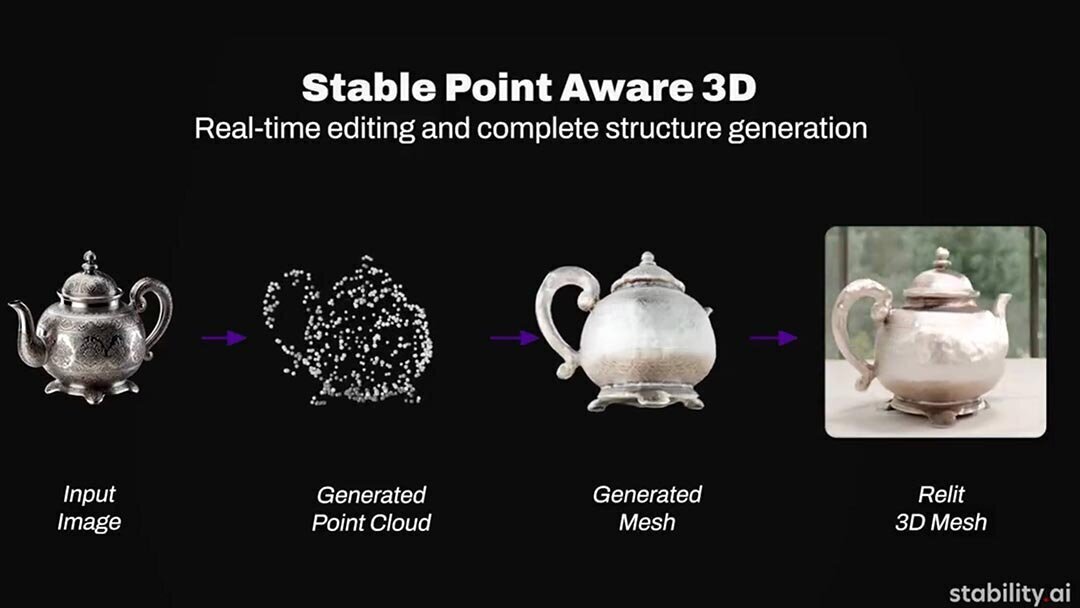

●3D生成AI「Stable Point Aware 3D」発表! Stability AIとNVIDIAとのパートナーシップ、画像から1秒以内に3Dモデルを生成

Stability AIがNVIDIA社とのパートナーシップによる3D生成AI「Stable Point Aware 3D(SPAR3D)」を発表。すでに公開されており、ダウンロード(Hugging Face)とコードへのアクセス(GitHub)、統合(Stability AI Developer Platform API)が行える。Stability AI Community Licenseに基づき、商用・非商用を問わず無料で利用可能。

https://cgworld.jp/flashnews/Stability-SPAR3D.html